[1]

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014: 580-587.

[本文引用: 1]

[2]

ZOU Z, SHI Z, GUO Y, et al. Object detection in 20 years: a survey [EB/OL]. [2022-06-28]. https://arxiv.org/abs/1905.05055.

[本文引用: 1]

[3]

REN S, HE K, GIRSHICK R, et al Faster R-CNN: towards real-time object detection with region proposal networks

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2017 , 39 (6 ): 1137 - 1149

DOI:10.1109/TPAMI.2016.2577031

[本文引用: 1]

[4]

LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector [C]// Proceedings of 14th European Conference on Computer Vision. Amsterdam: Springer, 2016: 21-37.

[本文引用: 1]

[5]

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection [C]// Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2016: 779-788.

[本文引用: 1]

[6]

REDMON J, FARHADI A. YOLO9000: better, faster, stronger [C]// Proceedings of 30th IEEE/CVF Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 6517-6525.

[7]

REDMON J, FARHADI A. YOLOv3: an incremental improvement [EB/OL]. [2022-06-28]. https://arxiv.org/abs/1804.02767.

[本文引用: 1]

[8]

LU Z, HE Q, XIANG X, et al Defect detection of PCB based on bayes feature fusion

[J]. The Journal of Engineering , 2018 , 2018 (16 ): 1741 - 1745

DOI:10.1049/joe.2018.8270

[本文引用: 1]

[9]

ZHANG C, SHI W, LI X, et al An improved bare PCB defect detection approach based on deep feature learning

[J]. The Journal of Engineering , 2018 , 2018 (16 ): 1415 - 1420

DOI:10.1049/joe.2018.8275

[本文引用: 1]

[10]

SHI W, LU Z, WU W, et al Single-shot detector with enriched semantics for PCB tiny defect detection

[J]. The Journal of Engineering , 2020 , 2020 (13 ): 366 - 372

DOI:10.1049/joe.2019.1180

[本文引用: 1]

[11]

HU B, WANG J Detection of PCB surface defects with improved Faster-RCNN and feature pyramid network

[J]. IEEE Access , 2020 , 8 : 108335 - 108345

DOI:10.1109/ACCESS.2020.3001349

[本文引用: 1]

[12]

DING R, DAI L, LI G, et al TDD-Net: a tiny defect detection network for printed circuit boards

[J]. 智能技术学报 , 2019 , 4 (2 ): 110 - 116

DOI:10.1049/trit.2019.0019

[本文引用: 10]

DING R, DAI L, LI G, et al TDD-Net: a tiny defect detection network for printed circuit boards

[J]. CAAI Transactions on Intelligence Technology , 2019 , 4 (2 ): 110 - 116

DOI:10.1049/trit.2019.0019

[本文引用: 10]

[13]

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [C]// Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2016: 770-778.

[本文引用: 1]

[14]

HUANG G, LIU Z, LAURENS V, et al. Densely connected convolutional networks [C]// Proceedings of 30th IEEE/CVF Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 2261-2269.

[本文引用: 1]

[15]

TAN M, LE Q V. EfficientNet: rethinking model scaling for convolutional neural networks [C]// Proceedings of 36th International Conference on Machine Learning. Long Beach: PMLR, 2019: 97.

[本文引用: 1]

[16]

RADOSAVOVIC I, KOSARAJU R P, GIRSHICK R, et al. Designing network design spaces [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 10425-10433.

[本文引用: 1]

[17]

ZHANG H, WU C, ZHANG Z, et al. ResNeSt: split-attention networks [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022: 2736-2746.

[本文引用: 1]

[18]

JIE H, LI S, GANG S, et al. Squeeze-and-excitation networks [C]// Proceedings of the 31st IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132-7141.

[本文引用: 1]

[19]

ZHANG X, ZHOU X, LIN M, et al. ShuffleNet: an extremely efficient convolutional neural network for mobile devices [C]// Proceedings of the 31st IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 6848-6856.

[本文引用: 1]

[20]

HAN K, WANG Y, TIAN Q, et al. GhostNet: more features from cheap operations [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 1577-1586.

[本文引用: 1]

[21]

LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection [C]// Proceedings of the 30th IEEE/CVF Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 936-944.

[本文引用: 1]

[22]

LIU S, QI L, QIN H, et al. Path aggregation network for instance segmentation [C]// Proceedings of the 31st IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 8759-8768.

[本文引用: 1]

[23]

GHIASI G, LIN T Y, LE Q V. NAS-FPN: learning scalable feature pyramid architecture for object detection [C]// Proceedings of the 32nd IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 7029-7038.

[本文引用: 1]

[24]

LIU S, HUANG D, WANG Y. Learning spatial fusion for single-shot object detection [EB/OL]. [2022-06-28]. https://arxiv.org/abs/1911.09516.

[本文引用: 1]

[25]

TAN M, PANG R, LE Q V. EfficientDet: scalable and efficient object detection [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 10781-10790.

[本文引用: 1]

[26]

BOCHKOVSKIY A, WANG C Y, LIAO H. YOLOv4: optimal speed and accuracy of object detection [EB/OL]. [2022-06-28]. https://arxiv.org/abs/2004.10934?.

[本文引用: 1]

[27]

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module [C]// Proceedings of 15th European Conference on Computer Vision. Munich: Springer, 2018: 3-19.

[本文引用: 1]

[28]

WANG Q, WU B, ZHU P, et al. Supplementary material for ECA-Net: efficient channel attention for deep convolutional neural networks [C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 13-19.

[本文引用: 1]

[29]

GLENN J. YOLOv5 release v5.0 [EB/OL]. [2022-06-28]. https://github.com/ultralytics/yolov5/releases/tag/v5.0.

[本文引用: 1]

1

... Girshick等[1 ] 提出区域卷积神经网络(R-CNN),打破了目标检测领域进展缓慢的僵局[2 ] . 随后诞生了Faster R-CNN[3 ] 、SSD[4 ] 、YOLO[5 -7 ] 等基于深度学习的通用目标检测算法. ...

1

... Girshick等[1 ] 提出区域卷积神经网络(R-CNN),打破了目标检测领域进展缓慢的僵局[2 ] . 随后诞生了Faster R-CNN[3 ] 、SSD[4 ] 、YOLO[5 -7 ] 等基于深度学习的通用目标检测算法. ...

Faster R-CNN: towards real-time object detection with region proposal networks

1

2017

... Girshick等[1 ] 提出区域卷积神经网络(R-CNN),打破了目标检测领域进展缓慢的僵局[2 ] . 随后诞生了Faster R-CNN[3 ] 、SSD[4 ] 、YOLO[5 -7 ] 等基于深度学习的通用目标检测算法. ...

1

... Girshick等[1 ] 提出区域卷积神经网络(R-CNN),打破了目标检测领域进展缓慢的僵局[2 ] . 随后诞生了Faster R-CNN[3 ] 、SSD[4 ] 、YOLO[5 -7 ] 等基于深度学习的通用目标检测算法. ...

1

... Girshick等[1 ] 提出区域卷积神经网络(R-CNN),打破了目标检测领域进展缓慢的僵局[2 ] . 随后诞生了Faster R-CNN[3 ] 、SSD[4 ] 、YOLO[5 -7 ] 等基于深度学习的通用目标检测算法. ...

1

... Girshick等[1 ] 提出区域卷积神经网络(R-CNN),打破了目标检测领域进展缓慢的僵局[2 ] . 随后诞生了Faster R-CNN[3 ] 、SSD[4 ] 、YOLO[5 -7 ] 等基于深度学习的通用目标检测算法. ...

Defect detection of PCB based on bayes feature fusion

1

2018

... 针对PCB的缺陷检测,Lu等[8 ] 提出提取PCB板的方向梯度直方图(histogram of oriented gradient,HOG)和局部二值模式特征(local binary pattern,LBP),分别将它们送入支持向量机中,利用贝叶斯特征融合方法,融合2组模型检测特征来识别缺陷. Zhang等[9 ] 通过卷积神经网络来学习缺陷特征,通过滑动窗口的方式来定位缺陷. Shi等[10 ] 通过改进SSD算法,引入注意力机制、多层特征融合来提高检测精度. Hu等[11 ] 通过改进Faster R-CNN算法,使用带FPN结构的ResNet50作为主干网络,用GARPN代替RPN来生成更多更精确的锚框. Ding等[12 ] 提出TDD-Net,在Faster R-CNN的基础上,更换了主干网络,引入在线难例挖掘(online hard example mining,OHEM)技术,将AP0.5 提高到98.90%. 上述PCB缺陷检测算法中,基于深度学习的PCB缺陷检测算法多采用Faster R-CNN作为基础算法进行改进,保证了检测精度,但网络复杂度更高,无法满足实时检测的需求. ...

An improved bare PCB defect detection approach based on deep feature learning

1

2018

... 针对PCB的缺陷检测,Lu等[8 ] 提出提取PCB板的方向梯度直方图(histogram of oriented gradient,HOG)和局部二值模式特征(local binary pattern,LBP),分别将它们送入支持向量机中,利用贝叶斯特征融合方法,融合2组模型检测特征来识别缺陷. Zhang等[9 ] 通过卷积神经网络来学习缺陷特征,通过滑动窗口的方式来定位缺陷. Shi等[10 ] 通过改进SSD算法,引入注意力机制、多层特征融合来提高检测精度. Hu等[11 ] 通过改进Faster R-CNN算法,使用带FPN结构的ResNet50作为主干网络,用GARPN代替RPN来生成更多更精确的锚框. Ding等[12 ] 提出TDD-Net,在Faster R-CNN的基础上,更换了主干网络,引入在线难例挖掘(online hard example mining,OHEM)技术,将AP0.5 提高到98.90%. 上述PCB缺陷检测算法中,基于深度学习的PCB缺陷检测算法多采用Faster R-CNN作为基础算法进行改进,保证了检测精度,但网络复杂度更高,无法满足实时检测的需求. ...

Single-shot detector with enriched semantics for PCB tiny defect detection

1

2020

... 针对PCB的缺陷检测,Lu等[8 ] 提出提取PCB板的方向梯度直方图(histogram of oriented gradient,HOG)和局部二值模式特征(local binary pattern,LBP),分别将它们送入支持向量机中,利用贝叶斯特征融合方法,融合2组模型检测特征来识别缺陷. Zhang等[9 ] 通过卷积神经网络来学习缺陷特征,通过滑动窗口的方式来定位缺陷. Shi等[10 ] 通过改进SSD算法,引入注意力机制、多层特征融合来提高检测精度. Hu等[11 ] 通过改进Faster R-CNN算法,使用带FPN结构的ResNet50作为主干网络,用GARPN代替RPN来生成更多更精确的锚框. Ding等[12 ] 提出TDD-Net,在Faster R-CNN的基础上,更换了主干网络,引入在线难例挖掘(online hard example mining,OHEM)技术,将AP0.5 提高到98.90%. 上述PCB缺陷检测算法中,基于深度学习的PCB缺陷检测算法多采用Faster R-CNN作为基础算法进行改进,保证了检测精度,但网络复杂度更高,无法满足实时检测的需求. ...

Detection of PCB surface defects with improved Faster-RCNN and feature pyramid network

1

2020

... 针对PCB的缺陷检测,Lu等[8 ] 提出提取PCB板的方向梯度直方图(histogram of oriented gradient,HOG)和局部二值模式特征(local binary pattern,LBP),分别将它们送入支持向量机中,利用贝叶斯特征融合方法,融合2组模型检测特征来识别缺陷. Zhang等[9 ] 通过卷积神经网络来学习缺陷特征,通过滑动窗口的方式来定位缺陷. Shi等[10 ] 通过改进SSD算法,引入注意力机制、多层特征融合来提高检测精度. Hu等[11 ] 通过改进Faster R-CNN算法,使用带FPN结构的ResNet50作为主干网络,用GARPN代替RPN来生成更多更精确的锚框. Ding等[12 ] 提出TDD-Net,在Faster R-CNN的基础上,更换了主干网络,引入在线难例挖掘(online hard example mining,OHEM)技术,将AP0.5 提高到98.90%. 上述PCB缺陷检测算法中,基于深度学习的PCB缺陷检测算法多采用Faster R-CNN作为基础算法进行改进,保证了检测精度,但网络复杂度更高,无法满足实时检测的需求. ...

TDD-Net: a tiny defect detection network for printed circuit boards

10

2019

... 针对PCB的缺陷检测,Lu等[8 ] 提出提取PCB板的方向梯度直方图(histogram of oriented gradient,HOG)和局部二值模式特征(local binary pattern,LBP),分别将它们送入支持向量机中,利用贝叶斯特征融合方法,融合2组模型检测特征来识别缺陷. Zhang等[9 ] 通过卷积神经网络来学习缺陷特征,通过滑动窗口的方式来定位缺陷. Shi等[10 ] 通过改进SSD算法,引入注意力机制、多层特征融合来提高检测精度. Hu等[11 ] 通过改进Faster R-CNN算法,使用带FPN结构的ResNet50作为主干网络,用GARPN代替RPN来生成更多更精确的锚框. Ding等[12 ] 提出TDD-Net,在Faster R-CNN的基础上,更换了主干网络,引入在线难例挖掘(online hard example mining,OHEM)技术,将AP0.5 提高到98.90%. 上述PCB缺陷检测算法中,基于深度学习的PCB缺陷检测算法多采用Faster R-CNN作为基础算法进行改进,保证了检测精度,但网络复杂度更高,无法满足实时检测的需求. ...

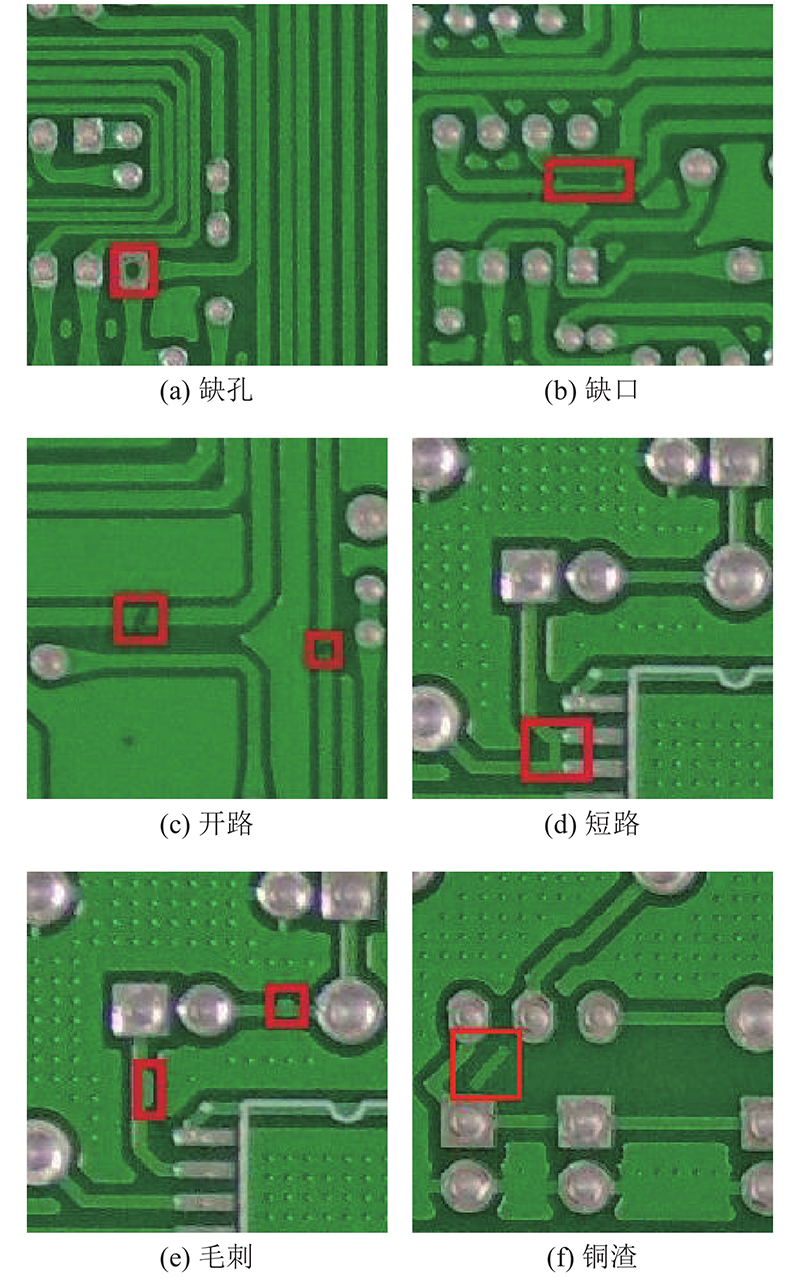

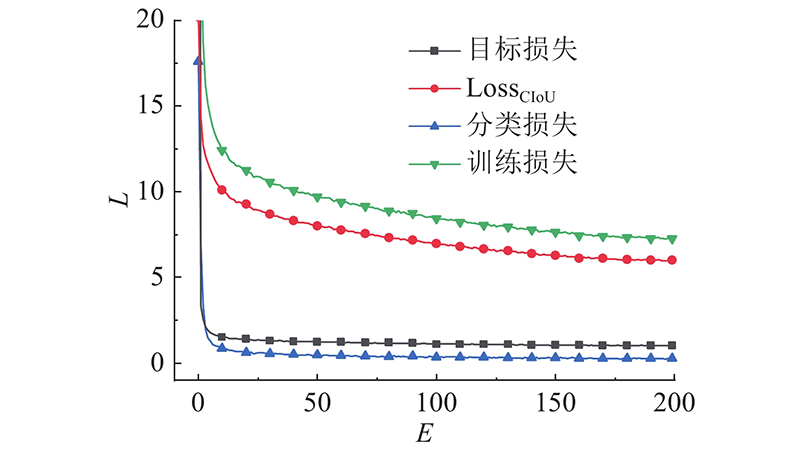

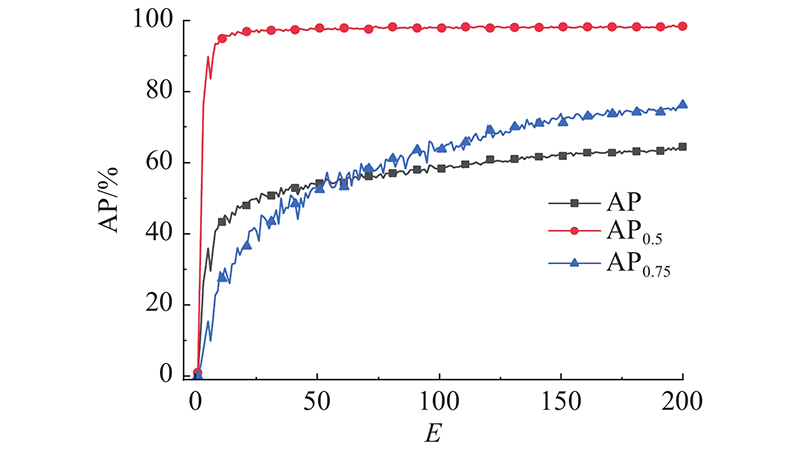

... 算法训练使用的PCB缺陷检测数据集是由Ding等[12 ] 制作. 如表4 所示,该数据集包含缺孔、缺口、开路、短路、毛刺和铜渣共计6种缺陷,每种缺陷的图片数量N g 超过1 700张,每种缺陷数量N d 超过3 500个. 该数据集划分的训练集包含8 534张图片,测试集包含2 134张图片,图片分辨率为600×600像素. 各种缺陷的图片和样本数量是均匀分布的,不用考虑样本不均匀的问题,有利于模型训练. ...

... PCB缺陷数据集[12 ] ...

... PCB defect dataset[12 ] ...

... Parameter comparison and detection accuracy test results of different algorithms on PCB defect dataset

Tab.6 网络模型 主干网络 N P /106 AP,AR/% AP0.5 /% AP0.75 /% GFLOPs Faster R-CNN[12 ] VGG-16 — — 58.57 — — Faster R-CNN[12 ] ResNet-101 — — 94.27 — — FPN[12 ] ResNet-101 — — 92.23 — — Faster R-CNN(fine-tuned)[12 ] ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9

从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 94.27 — — FPN[12 ] ResNet-101 — — 92.23 — — Faster R-CNN(fine-tuned)[12 ] ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 92.23 — — Faster R-CNN(fine-tuned)[12 ] ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

TDD-Net: a tiny defect detection network for printed circuit boards

10

2019

... 针对PCB的缺陷检测,Lu等[8 ] 提出提取PCB板的方向梯度直方图(histogram of oriented gradient,HOG)和局部二值模式特征(local binary pattern,LBP),分别将它们送入支持向量机中,利用贝叶斯特征融合方法,融合2组模型检测特征来识别缺陷. Zhang等[9 ] 通过卷积神经网络来学习缺陷特征,通过滑动窗口的方式来定位缺陷. Shi等[10 ] 通过改进SSD算法,引入注意力机制、多层特征融合来提高检测精度. Hu等[11 ] 通过改进Faster R-CNN算法,使用带FPN结构的ResNet50作为主干网络,用GARPN代替RPN来生成更多更精确的锚框. Ding等[12 ] 提出TDD-Net,在Faster R-CNN的基础上,更换了主干网络,引入在线难例挖掘(online hard example mining,OHEM)技术,将AP0.5 提高到98.90%. 上述PCB缺陷检测算法中,基于深度学习的PCB缺陷检测算法多采用Faster R-CNN作为基础算法进行改进,保证了检测精度,但网络复杂度更高,无法满足实时检测的需求. ...

... 算法训练使用的PCB缺陷检测数据集是由Ding等[12 ] 制作. 如表4 所示,该数据集包含缺孔、缺口、开路、短路、毛刺和铜渣共计6种缺陷,每种缺陷的图片数量N g 超过1 700张,每种缺陷数量N d 超过3 500个. 该数据集划分的训练集包含8 534张图片,测试集包含2 134张图片,图片分辨率为600×600像素. 各种缺陷的图片和样本数量是均匀分布的,不用考虑样本不均匀的问题,有利于模型训练. ...

... PCB缺陷数据集[12 ] ...

... PCB defect dataset[12 ] ...

... Parameter comparison and detection accuracy test results of different algorithms on PCB defect dataset

Tab.6 网络模型 主干网络 N P /106 AP,AR/% AP0.5 /% AP0.75 /% GFLOPs Faster R-CNN[12 ] VGG-16 — — 58.57 — — Faster R-CNN[12 ] ResNet-101 — — 94.27 — — FPN[12 ] ResNet-101 — — 92.23 — — Faster R-CNN(fine-tuned)[12 ] ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9

从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 94.27 — — FPN[12 ] ResNet-101 — — 92.23 — — Faster R-CNN(fine-tuned)[12 ] ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 92.23 — — Faster R-CNN(fine-tuned)[12 ] ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 96.44 — — TDD-Net[12 ] ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

ResNet-101 — — 98.90 — — YOLOv3[12 ] DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

... [

12 ]

DarkNet53 — — 81.42 — — YOLOv3-ultralytics DarkNet53 62.999 58.78,33.05 96.71 64.64 66.5 YOLOv5m CSP-DarkNet53 21.077 61.17,34.27 98.43 68.21 32.3 YOLOv5l CSP-DarkNet53 46.658 64.88,35.77 98.95 75.45 73.2 本文算法 ResNeSt50 35.227 64.53,35.49 98.42 76.23 45.9 从表6 可以看出,AT-YOLO算法在PCB数据集上取得了64.53%的AP、98.42%的AP0.5 和76.23%的AP0.75 . 在AP0.5 上的表现优于采用ResNet101作为主干网络的Faster R-CNN,领先了2%,相较于更精确的TDD-Net,AP0.5 仅落后0.38%. 与单阶段目标检测算法相比,检测精度已经优于YOLOv3系列,以YOLOv3-ultralytics 56%的参数量,AP提高了5.75%. 相较于YOLOv5系列,AT-YOLO网络精度较YOLOv5m高3.36%;与YOLOv5l相比,AT-YOLO在参数量和GFLOPs分别减少了25%和37.3%,同时在AP表现相当,在AP0.75 上比YOLOv5l高约1%. ...

1

... 近年来,密集连接的主干网络已经逐步取代稀疏连接的主干网络. He等[13 ] 推出的ResNet在多项视觉竞赛中取得了第一,提出通过残差学习,以应对深层网络梯度消失的问题,将卷积神经网络的深度推到前所未有的152层. 在ResNet之后,Huang等[14 ] 提出DenseNet,借鉴ResNet的短接操作,启用密集块加强特征重用. 近年来,利用神经网络结构搜索(neural architecture search,NAS)技术来搜索合理的网络配置,诞生了EfficientNet[15 ] 家族,从B0到B7,模型被设计得更宽、更深,输入图像的分辨率更高. Radosavovic等[16 ] 设计新的网络设计方式,综合了手工网络设计和NAS的优点,诞生了RegNet,在类似条件下,成绩优于EfficientNet,并且GPU速度更快. Zhang等[17 ] 提出的ResNeSt通过分散注意力块(split attention),将输入特征图平均分成数个小组,在小组中对每个通道进行权重赋值,减小了模型复杂度,提高了分类精度. ...

1

... 近年来,密集连接的主干网络已经逐步取代稀疏连接的主干网络. He等[13 ] 推出的ResNet在多项视觉竞赛中取得了第一,提出通过残差学习,以应对深层网络梯度消失的问题,将卷积神经网络的深度推到前所未有的152层. 在ResNet之后,Huang等[14 ] 提出DenseNet,借鉴ResNet的短接操作,启用密集块加强特征重用. 近年来,利用神经网络结构搜索(neural architecture search,NAS)技术来搜索合理的网络配置,诞生了EfficientNet[15 ] 家族,从B0到B7,模型被设计得更宽、更深,输入图像的分辨率更高. Radosavovic等[16 ] 设计新的网络设计方式,综合了手工网络设计和NAS的优点,诞生了RegNet,在类似条件下,成绩优于EfficientNet,并且GPU速度更快. Zhang等[17 ] 提出的ResNeSt通过分散注意力块(split attention),将输入特征图平均分成数个小组,在小组中对每个通道进行权重赋值,减小了模型复杂度,提高了分类精度. ...

1

... 近年来,密集连接的主干网络已经逐步取代稀疏连接的主干网络. He等[13 ] 推出的ResNet在多项视觉竞赛中取得了第一,提出通过残差学习,以应对深层网络梯度消失的问题,将卷积神经网络的深度推到前所未有的152层. 在ResNet之后,Huang等[14 ] 提出DenseNet,借鉴ResNet的短接操作,启用密集块加强特征重用. 近年来,利用神经网络结构搜索(neural architecture search,NAS)技术来搜索合理的网络配置,诞生了EfficientNet[15 ] 家族,从B0到B7,模型被设计得更宽、更深,输入图像的分辨率更高. Radosavovic等[16 ] 设计新的网络设计方式,综合了手工网络设计和NAS的优点,诞生了RegNet,在类似条件下,成绩优于EfficientNet,并且GPU速度更快. Zhang等[17 ] 提出的ResNeSt通过分散注意力块(split attention),将输入特征图平均分成数个小组,在小组中对每个通道进行权重赋值,减小了模型复杂度,提高了分类精度. ...

1

... 近年来,密集连接的主干网络已经逐步取代稀疏连接的主干网络. He等[13 ] 推出的ResNet在多项视觉竞赛中取得了第一,提出通过残差学习,以应对深层网络梯度消失的问题,将卷积神经网络的深度推到前所未有的152层. 在ResNet之后,Huang等[14 ] 提出DenseNet,借鉴ResNet的短接操作,启用密集块加强特征重用. 近年来,利用神经网络结构搜索(neural architecture search,NAS)技术来搜索合理的网络配置,诞生了EfficientNet[15 ] 家族,从B0到B7,模型被设计得更宽、更深,输入图像的分辨率更高. Radosavovic等[16 ] 设计新的网络设计方式,综合了手工网络设计和NAS的优点,诞生了RegNet,在类似条件下,成绩优于EfficientNet,并且GPU速度更快. Zhang等[17 ] 提出的ResNeSt通过分散注意力块(split attention),将输入特征图平均分成数个小组,在小组中对每个通道进行权重赋值,减小了模型复杂度,提高了分类精度. ...

1

... 近年来,密集连接的主干网络已经逐步取代稀疏连接的主干网络. He等[13 ] 推出的ResNet在多项视觉竞赛中取得了第一,提出通过残差学习,以应对深层网络梯度消失的问题,将卷积神经网络的深度推到前所未有的152层. 在ResNet之后,Huang等[14 ] 提出DenseNet,借鉴ResNet的短接操作,启用密集块加强特征重用. 近年来,利用神经网络结构搜索(neural architecture search,NAS)技术来搜索合理的网络配置,诞生了EfficientNet[15 ] 家族,从B0到B7,模型被设计得更宽、更深,输入图像的分辨率更高. Radosavovic等[16 ] 设计新的网络设计方式,综合了手工网络设计和NAS的优点,诞生了RegNet,在类似条件下,成绩优于EfficientNet,并且GPU速度更快. Zhang等[17 ] 提出的ResNeSt通过分散注意力块(split attention),将输入特征图平均分成数个小组,在小组中对每个通道进行权重赋值,减小了模型复杂度,提高了分类精度. ...

1

... 为了应对移动端设备的需求,轻量化的主干网络相继被推出. Jie等[18 ] 提出SENet,该网络提出SE(squeeze and excitation)模块,该模块能够自适应地调整通道响应,捕捉图像中的显著特征. Zhang等[19 ] 提出ShuffleNet,利用pointwise group convolution和channel shuffle,在保持精度的同时大大减少了计算量. Han等[20 ] 设计GhostNet,提出了Ghost模块,以更少的计算成本来生成更多的特征图. ...

1

... 为了应对移动端设备的需求,轻量化的主干网络相继被推出. Jie等[18 ] 提出SENet,该网络提出SE(squeeze and excitation)模块,该模块能够自适应地调整通道响应,捕捉图像中的显著特征. Zhang等[19 ] 提出ShuffleNet,利用pointwise group convolution和channel shuffle,在保持精度的同时大大减少了计算量. Han等[20 ] 设计GhostNet,提出了Ghost模块,以更少的计算成本来生成更多的特征图. ...

1

... 为了应对移动端设备的需求,轻量化的主干网络相继被推出. Jie等[18 ] 提出SENet,该网络提出SE(squeeze and excitation)模块,该模块能够自适应地调整通道响应,捕捉图像中的显著特征. Zhang等[19 ] 提出ShuffleNet,利用pointwise group convolution和channel shuffle,在保持精度的同时大大减少了计算量. Han等[20 ] 设计GhostNet,提出了Ghost模块,以更少的计算成本来生成更多的特征图. ...

1

... 目标检测包含2个子任务:图像分类和定位. 图像分类依赖于网络提取图像的高层语义信息,定位依赖于底层特征包含的边缘和轮廓信息. 学习到高层和底层特征信息,对目标检测网络是至关重要的. 近年来,在目标检测领域,特征融合技术在目标检测网络中得到了广泛的应用,常见的特征融合如下. 1)FPN[21 ] (feature pyramid network):1种典型的自上而下的结构. 在主干网络的不同层级之间添加横向连接,使得不同语义强度、不同分辨率的特征相融合,既保证了小物体的目标检测,又可以利用底层细节进行定位. 2)PANet[22 ] :在FPN结构上,再次横向连接了1个自下而上的结构,这一步操作可以利用更加准确的底层定位信息来增强网络特征. 3)NAS-FPN[23 ] (neural architecture search-feature pyramid network):通过神经网络来自动寻找合适的特征融合方式,该方法极其依赖GPU资源且很难重复实施一样的模块. 4)ASFF[24 ] (adaptively spatial feature fusion):不同层级的特征对目标检测的帮助是不同的,ASFF通过加权因子对不同层级特征加权,以更好地融合. 5)BiFPN[25 ] (bi-direction feature pyramid network):该方法移除了仅有单边输入的连接节点,同时使用深度可分离卷积,降低计算成本. 通过增加检测尺度、结构的重复堆叠以及特征间的加权融合,网络学习到更重要的输入特征. ...

1

... 目标检测包含2个子任务:图像分类和定位. 图像分类依赖于网络提取图像的高层语义信息,定位依赖于底层特征包含的边缘和轮廓信息. 学习到高层和底层特征信息,对目标检测网络是至关重要的. 近年来,在目标检测领域,特征融合技术在目标检测网络中得到了广泛的应用,常见的特征融合如下. 1)FPN[21 ] (feature pyramid network):1种典型的自上而下的结构. 在主干网络的不同层级之间添加横向连接,使得不同语义强度、不同分辨率的特征相融合,既保证了小物体的目标检测,又可以利用底层细节进行定位. 2)PANet[22 ] :在FPN结构上,再次横向连接了1个自下而上的结构,这一步操作可以利用更加准确的底层定位信息来增强网络特征. 3)NAS-FPN[23 ] (neural architecture search-feature pyramid network):通过神经网络来自动寻找合适的特征融合方式,该方法极其依赖GPU资源且很难重复实施一样的模块. 4)ASFF[24 ] (adaptively spatial feature fusion):不同层级的特征对目标检测的帮助是不同的,ASFF通过加权因子对不同层级特征加权,以更好地融合. 5)BiFPN[25 ] (bi-direction feature pyramid network):该方法移除了仅有单边输入的连接节点,同时使用深度可分离卷积,降低计算成本. 通过增加检测尺度、结构的重复堆叠以及特征间的加权融合,网络学习到更重要的输入特征. ...

1

... 目标检测包含2个子任务:图像分类和定位. 图像分类依赖于网络提取图像的高层语义信息,定位依赖于底层特征包含的边缘和轮廓信息. 学习到高层和底层特征信息,对目标检测网络是至关重要的. 近年来,在目标检测领域,特征融合技术在目标检测网络中得到了广泛的应用,常见的特征融合如下. 1)FPN[21 ] (feature pyramid network):1种典型的自上而下的结构. 在主干网络的不同层级之间添加横向连接,使得不同语义强度、不同分辨率的特征相融合,既保证了小物体的目标检测,又可以利用底层细节进行定位. 2)PANet[22 ] :在FPN结构上,再次横向连接了1个自下而上的结构,这一步操作可以利用更加准确的底层定位信息来增强网络特征. 3)NAS-FPN[23 ] (neural architecture search-feature pyramid network):通过神经网络来自动寻找合适的特征融合方式,该方法极其依赖GPU资源且很难重复实施一样的模块. 4)ASFF[24 ] (adaptively spatial feature fusion):不同层级的特征对目标检测的帮助是不同的,ASFF通过加权因子对不同层级特征加权,以更好地融合. 5)BiFPN[25 ] (bi-direction feature pyramid network):该方法移除了仅有单边输入的连接节点,同时使用深度可分离卷积,降低计算成本. 通过增加检测尺度、结构的重复堆叠以及特征间的加权融合,网络学习到更重要的输入特征. ...

1

... 目标检测包含2个子任务:图像分类和定位. 图像分类依赖于网络提取图像的高层语义信息,定位依赖于底层特征包含的边缘和轮廓信息. 学习到高层和底层特征信息,对目标检测网络是至关重要的. 近年来,在目标检测领域,特征融合技术在目标检测网络中得到了广泛的应用,常见的特征融合如下. 1)FPN[21 ] (feature pyramid network):1种典型的自上而下的结构. 在主干网络的不同层级之间添加横向连接,使得不同语义强度、不同分辨率的特征相融合,既保证了小物体的目标检测,又可以利用底层细节进行定位. 2)PANet[22 ] :在FPN结构上,再次横向连接了1个自下而上的结构,这一步操作可以利用更加准确的底层定位信息来增强网络特征. 3)NAS-FPN[23 ] (neural architecture search-feature pyramid network):通过神经网络来自动寻找合适的特征融合方式,该方法极其依赖GPU资源且很难重复实施一样的模块. 4)ASFF[24 ] (adaptively spatial feature fusion):不同层级的特征对目标检测的帮助是不同的,ASFF通过加权因子对不同层级特征加权,以更好地融合. 5)BiFPN[25 ] (bi-direction feature pyramid network):该方法移除了仅有单边输入的连接节点,同时使用深度可分离卷积,降低计算成本. 通过增加检测尺度、结构的重复堆叠以及特征间的加权融合,网络学习到更重要的输入特征. ...

1

... 目标检测包含2个子任务:图像分类和定位. 图像分类依赖于网络提取图像的高层语义信息,定位依赖于底层特征包含的边缘和轮廓信息. 学习到高层和底层特征信息,对目标检测网络是至关重要的. 近年来,在目标检测领域,特征融合技术在目标检测网络中得到了广泛的应用,常见的特征融合如下. 1)FPN[21 ] (feature pyramid network):1种典型的自上而下的结构. 在主干网络的不同层级之间添加横向连接,使得不同语义强度、不同分辨率的特征相融合,既保证了小物体的目标检测,又可以利用底层细节进行定位. 2)PANet[22 ] :在FPN结构上,再次横向连接了1个自下而上的结构,这一步操作可以利用更加准确的底层定位信息来增强网络特征. 3)NAS-FPN[23 ] (neural architecture search-feature pyramid network):通过神经网络来自动寻找合适的特征融合方式,该方法极其依赖GPU资源且很难重复实施一样的模块. 4)ASFF[24 ] (adaptively spatial feature fusion):不同层级的特征对目标检测的帮助是不同的,ASFF通过加权因子对不同层级特征加权,以更好地融合. 5)BiFPN[25 ] (bi-direction feature pyramid network):该方法移除了仅有单边输入的连接节点,同时使用深度可分离卷积,降低计算成本. 通过增加检测尺度、结构的重复堆叠以及特征间的加权融合,网络学习到更重要的输入特征. ...

1

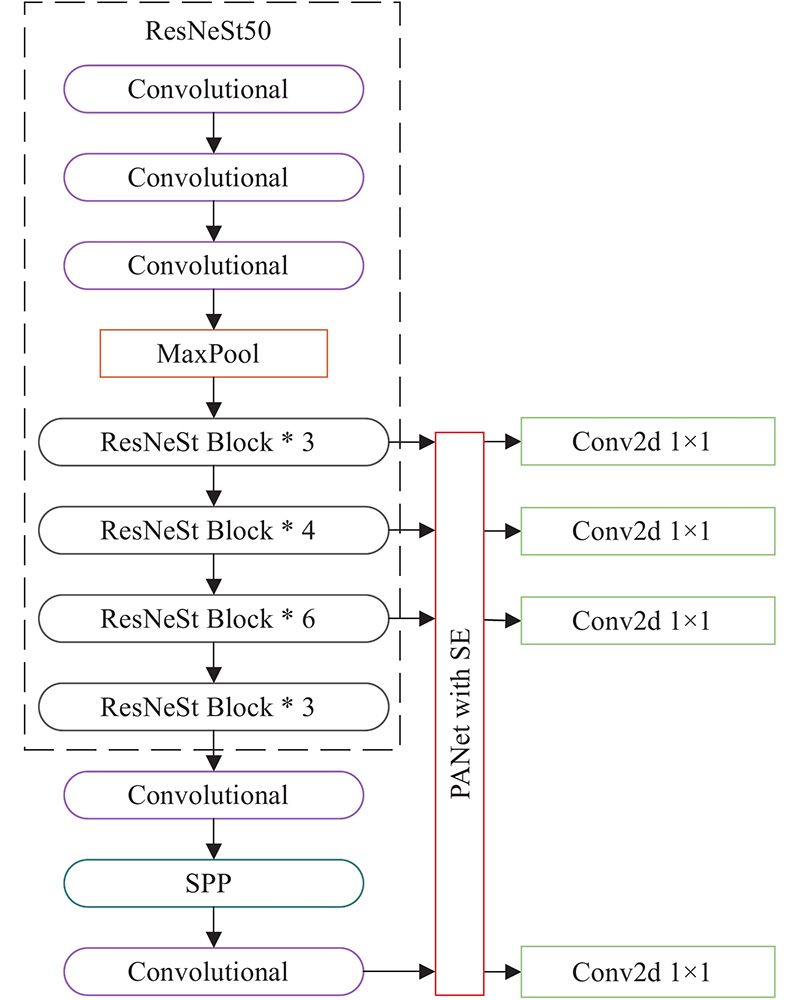

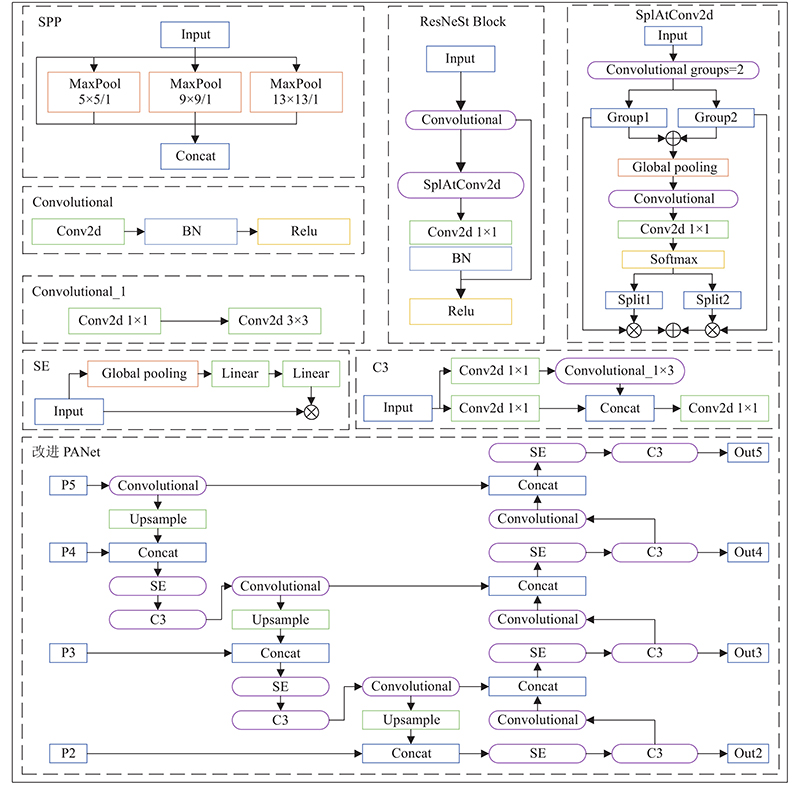

... AT-YOLO算法选用ResNeSt50代替DarkNet53作为主干网络. 表1 中展示了DarkNet53、ResNet50/101、ResNeSt50/101在输入相同图像分辨率时的感受野、参数量N P 、GFLOPs和推理时间t i ,其中ResNet50/101、ResNeSt50/101去除了用于分类的全连接层. ResNeSt作为ResNet的改进,保留了残差结构,提出了分散注意力机制,将输入特征图分成小组,每组增加通道注意力机制,使网络捕捉跨特征间的交互信息,提升网络的表征能力. 注意力机制带来了计算成本的上升,ResNeSt50通过组卷积减少了计算量,1个分散注意力块的参数量和浮点运算次数(FLOPs)和1个标准的残差块相近. 从表1 可以看出,ResNeSt50拥有与原型相似的参数量,相较于DarkNet53参数量和GFLOPs大幅减少. ResNeSt50有19个3×3卷积,感受野为483×483像素,感受野(receptive field)的分辨率大于输入图像,可以增大图像像素点与最后激活之间的联系[26 ] . 在一些下游检测任务中,ResNeSt50的效果已经接近ResNet101. ...

1

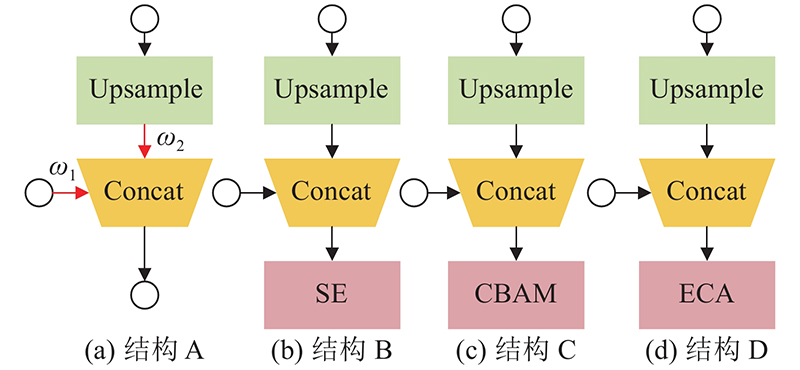

... AT-YOLO算法采用改进PANet代替网络原有的FPN结构. 为了探索对PCB缺陷检测效果最好的特征加权方式,设计了4种结构,如图3 所示. 结构A借鉴了BiFPN的加权方式,对输入特征图整块进行赋值加权,之后将特征图按通道方向拼接. 结构B在PANet中插入SE模块,SE模块将输入特征图进行全局平均池化,经过2次全连接层后,获取输入特征每个通道的权值,再与原输入特征相乘获得输出.SE模块提高了有效特征图的表达能力,抑制无效特征图的输出. 结构C在PANet中插入CBAM[27 ] (convolutional block attention module)模块,CBAM结合通道注意力机制和空间注意力机制,其中空间注意力机制是分别找出输入特征图通道方向的最大值和平均值,之后进行相加操作,通过sigmoid函数将求和值缩限至(0,1.0),最后与输入特征图相乘. 结构D在PANet中插入ECA[28 ] (efficient channel attention)模块,ECA使用1×1卷积代替全连接层,对SE模块进行改进. ...

1

... AT-YOLO算法采用改进PANet代替网络原有的FPN结构. 为了探索对PCB缺陷检测效果最好的特征加权方式,设计了4种结构,如图3 所示. 结构A借鉴了BiFPN的加权方式,对输入特征图整块进行赋值加权,之后将特征图按通道方向拼接. 结构B在PANet中插入SE模块,SE模块将输入特征图进行全局平均池化,经过2次全连接层后,获取输入特征每个通道的权值,再与原输入特征相乘获得输出.SE模块提高了有效特征图的表达能力,抑制无效特征图的输出. 结构C在PANet中插入CBAM[27 ] (convolutional block attention module)模块,CBAM结合通道注意力机制和空间注意力机制,其中空间注意力机制是分别找出输入特征图通道方向的最大值和平均值,之后进行相加操作,通过sigmoid函数将求和值缩限至(0,1.0),最后与输入特征图相乘. 结构D在PANet中插入ECA[28 ] (efficient channel attention)模块,ECA使用1×1卷积代替全连接层,对SE模块进行改进. ...

1

... AT-YOLO算法最终采用的结构为ResNeSt50+SPP+改进PANet(SE). 为了验证算法的有效性,采用对比实验,与两阶段目标检测算法Faster R-CNN(主干网络是VGG-16,ResNet101)、FPN(ResNet101)、TDD-Net(ResNet101)以及与单阶段目标检测算法YOLOv3-ultralytics、YOLOv5[29 ] 系列中参数量相近的YOLOv5m和YOLOv5l进行对比. 对比结果如表6 所示. 表中,AR为召回率均值. 结果证明改进算法提高了缺陷检测的精度,极大地减少了参数量和GFLOPs,证明改进算法是精确、高效的. ...