[1]

DAYAN P, ABBOTT L F. Theoretical neuroscience: computational and mathematical modeling of neural systems [M]. Cambridge: MIT Press, 2005.

[本文引用: 4]

[2]

BOOTH V, BOSE A Neural mechanisms for generating rate and temporal codes in model CA3 pyramidal cells

[J]. Journal of Neurophysiology , 2001 , 85 (6 ): 2432 - 2445

DOI:10.1152/jn.2001.85.6.2432

[3]

SEVERSON K S, XU D, VAN DE LOO M, et al Active touch and self-motion encoding by merkel cell-associated afferents

[J]. Neuron , 2017 , 94 (3 ): 666 - 676

DOI:10.1016/j.neuron.2017.03.045

[4]

DAVIES M, SRINIVASA N, LIN T H, et al Loihi: a neuromorphic manycore processor with on-chip learning

[J]. IEEE Micro , 2018 , 38 (1 ): 82 - 99

DOI:10.1109/MM.2018.112130359

[5]

吴朝晖 类脑研究: 为人类构建超级大脑

[J]. 浙江大学学报: 工学版 , 2020 , 54 (3 ): 425 - 426

[本文引用: 1]

WU Zhao-hui Cybrain: building superbrain for humans

[J]. Journal of Zhejiang University: Engineering Science , 2020 , 54 (3 ): 425 - 426

[本文引用: 1]

[7]

JAMES J W, PESTELL N, LEPORA N F Slip detection with a biomimetic tactile sensor

[J]. IEEE Robotics and Automation Letters , 2018 , 3 (4 ): 3340 - 3346

DOI:10.1109/LRA.2018.2852797

[8]

ZHANG Y, KAN Z, TSE Y A, et al. FingerVision tactile sensor design and slip detection using convolutional LSTM network [EB/OL]. [2022-10-13]. https://arxiv.org/abs/1810.02653.

[本文引用: 2]

[9]

WARD-CHERRIER B, ROJAS N, LEPORA N F Model-free precise in-hand manipulation with a 3D-printed tactile gripper

[J]. IEEE Robotics and Automation Letters , 2017 , 2 (4 ): 2056 - 2063

DOI:10.1109/LRA.2017.2719761

[本文引用: 1]

[11]

CHI C, SUN X, XUE N, et al Recent progress in technologies for tactile sensors

[J]. Sensors , 2018 , 18 (4 ): 948

DOI:10.3390/s18040948

[本文引用: 1]

[12]

YUAN W, DONG S, ADELSON E H Gelsight: high-resolution robot tactile sensors for estimating geometry and force

[J]. Sensors , 2017 , 17 (12 ): 2762

DOI:10.3390/s17122762

[本文引用: 1]

[13]

DONLON E, DONG S, LIU M, et al. GelSlim: a high-resolution, compact, robust, and calibrated tactile-sensing finger [C]// 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems . Madrid: IEEE, 2018: 1927-1934.

[本文引用: 1]

[14]

MA D, DONLON E, DONG S, et al. Dense tactile force estimation using GelSlim and inverse FEM [C]// 2019 International Conference on Robotics and Automation . Montreal: IEEE, 2019: 5418-5424.

[15]

TAYLOR I H, DONG S, RODRIGUEZ A. GelSlim 3.0: high-resolution measurement of shape, force and slip in a compact tactile-sensing finger [C]// 2022 International Conference on Robotics and Automation . Philadelphia: IEEE, 2022: 10781-10787.

[本文引用: 1]

[16]

LEPORA N F Soft biomimetic optical tactile sensing with the TacTip: a review

[J]. IEEE Sensors Journal , 2021 , 21 (19 ): 21131 - 21143

DOI:10.1109/JSEN.2021.3100645

[本文引用: 1]

[17]

YAMAGUCHI A, ATKESON C G. Implementing tactile behaviors using FingerVision [C]// 2017 IEEE-RAS 17th International Conference on Humanoid Robotics. Birmingham: IEEE, 2017: 241-248.

[本文引用: 1]

[18]

CUI S, WANG R, HU J, et al In-hand object localization using a novel high-resolution visuotactile sensor

[J]. IEEE Transactions on Industrial Electronics , 2021 , 69 (6 ): 6015 - 6025

[本文引用: 2]

[19]

CUI S, WANG R, HU J, et al Self-supervised contact geometry learning by GelStereo visuotactile sensing

[J]. IEEE Transactions on Instrumentation and Measurement , 2021 , 71 : 1 - 9

[本文引用: 2]

[20]

ABAD A C, RANASINGHE A Visuotactile sensors with emphasis on gelsight sensor: a review

[J]. IEEE Sensors Journal , 2020 , 20 (14 ): 7628 - 7638

DOI:10.1109/JSEN.2020.2979662

[本文引用: 1]

[21]

LEE W W, TAN Y J, YAO H, et al A neuro-inspired artificial peripheral nervous system for scalable electronic skins

[J]. Science Robotics , 2019 , 4 (32 ): eaax2198

DOI:10.1126/scirobotics.aax2198

[本文引用: 2]

[22]

WARD-CHERRIER B, PESTELL N, LEPORA N F. Neurotac: a neuromorphic optical tactile sensor applied to texture recognition [C]// 2020 IEEE International Conference on Robotics and Automation . Paris: IEEE, 2020: 2654-2660.

[本文引用: 1]

[23]

KUMAGAI K, SHIMONOMURA K. Event-based tactile image sensor for detecting spatio-temporal fast phenomena in contacts [C]// 2019 IEEE World Haptics Conference . Tokyo: IEEE, 2019: 343-348.

[本文引用: 1]

[24]

RUECKAUER B, LUNGU I A, HU Y, et al Conversion of continuous-valued deep networks to efficient event-driven networks for image classification

[J]. Frontiers in Neuroscience , 2017 , 11 : 682

DOI:10.3389/fnins.2017.00682

[本文引用: 1]

[25]

SENGUPTA A, YE Y, WANG R, et al Going deeper in spiking neural networks: VGG and residual architectures

[J]. Frontiers in Neuroscience , 2019 , 13 : 95

DOI:10.3389/fnins.2019.00095

[本文引用: 1]

[26]

NEFTCI E O, MOSTAFA H, ZENKE F Surrogate gradient learning in spiking neural networks: bringing the power of gradient-based optimization to spiking neural networks

[J]. IEEE Signal Processing Magazine , 2019 , 36 (6 ): 51 - 63

DOI:10.1109/MSP.2019.2931595

[本文引用: 1]

[27]

SHRESTHA S B, ORCHARD G. Slayer: spike layer error reassignment in time [EB/OL]. [2022-10-13]. https://proceedings.neurips.cc/paper/2018/hash/82f2b308c3b01637c607ce05f52a2fed-Abstract.html.

[本文引用: 2]

[28]

SEE H H, LIM B, LI S, et al. ST-MNIST: the spiking tactile MNIST neuromorphic dataset [EB/OL]. [2022-10-13]. https://arxiv.org/abs/2005.04319.

[本文引用: 1]

[29]

TAUNYAZOV T, SNG W, SEE H H, et al. Event-driven visual-tactile sensing and learning for robots [EB/OL]. [2022-10-13]. https://arxiv.org/abs/2009.07083.

[本文引用: 1]

[30]

GU F, SNG W, TAUNYAZOV T, et al. Tactilesgnet: a spiking graph neural network for event-based tactile object recognition [C]// 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems . Las Vegas: IEEE, 2020: 9876-9882.

[本文引用: 1]

[31]

BARTOLOZZI C, ROS P M, DIOTALEVI F, et al. Event-driven encoding of off-the-shelf tactile sensors for compression and latency optimisation for robotic skin [C]// 2017 IEEE/RSJ International Conference on Intelligent Robots and Systems . Vancouver: IEEE, 2017: 166-173.

[本文引用: 1]

[32]

YI Z, ZHANG Y, PETERS J Biomimetic tactile sensors and signal processing with spike trains: a review

[J]. Sensors and Actuators A: Physical , 2018 , 269 : 41 - 52

DOI:10.1016/j.sna.2017.09.035

[33]

YI Z, XU T, GUO S, et al Tactile surface roughness categorization with multineuron spike train distance

[J]. IEEE Transactions on Automation Science and Engineering , 2020 , 18 (4 ): 1835 - 1845

[本文引用: 1]

[34]

DABBOUS A, MASTELLA M, NATARAJAN A, et al. Artificial bio-inspired tactile receptive fields for edge orientation classification [C]// 2021 IEEE International Symposium on Circuits and Systems . Daegu: IEEE, 2021: 1-5.

[本文引用: 1]

[35]

TAUNYAZOV T, CHUA Y, GAO R, et al. Fast texture classification using tactile neural coding and spiking neural network [C]// 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems . Las Vegas: IEEE, 2020: 9890-9895.

[本文引用: 1]

[36]

LI J, DONG S, ADELSON E. Slip detection with combined tactile and visual information [C]// 2018 IEEE International Conference on Robotics and Automation . Brisbane: IEEE, 2018: 7772-7777.

[本文引用: 1]

[37]

ZHANG Y, YUAN W, KAN Z, et al. Towards learning to detect and predict contact events on vision-based tactile sensors [C]// Conference on Robot Learning . [S.l.]: MIT, 2020: 1395-1404.

[本文引用: 1]

[38]

BOAHEN K A Point-to-point connectivity between neuromorphic chips using address events

[J]. IEEE Transactions on Circuits and Systems II: Analog and Digital Signal Processing , 2000 , 47 (5 ): 416 - 434

DOI:10.1109/82.842110

[本文引用: 1]

[40]

崔少伟, 魏俊杭, 王睿, 等 基于视触融合的机器人抓取滑动检测

[J]. 华中科技大学学报: 自然科学版 , 2020 , 48 (1 ): 98 - 102

[本文引用: 1]

CUI Shao-wei, WEI Jun-hang, WANG Rui, et al Robotic grasp slip detection based on visual-tactile fusion

[J]. Journal of Huazhong University of Science and Technology: Natural Science Edition , 2020 , 48 (1 ): 98 - 102

[本文引用: 1]

4

... 基于深度学习算法和大数据的驱动,人工智能对多种任务的预测准确率甚至超过了人类,然而与人脑相比,深度学习在能耗比、鲁棒性及自适应性等方面都有明显的不足. 生物智能基于长时间的进化以应对自然环境的各种变化,使用具身感知系统来获取和正确解析外界环境信息,对接下来产生的行为做出合适的决策和规划. 其中,触觉信息特别是指尖触觉信息的获取及高效解析对人类完成各种操作任务具有至关重要的作用. 目前在机器人操作领域,如何让机械臂及机械手拥有有效的触觉感知和反馈能力,依然面临非常艰巨的挑战. 针对此问题,我们借鉴生物智能对变化的感知、编码和检测方式[1 -5 ] ,实现机器人的触觉感知及特征信息提取. ...

... Hodgkin和Huxley在上世纪50年代提出神经元计算模型[1 ] ,由于电路实现过于复杂,研究人员提出更简化、电路实现更友好的神经元模型. 其中,整合发放神经元(integration-and-fire,IF)模型以及基于IF模型带泄漏的整合发放神经元模型(leaky integration-and-fire,LIF)使用最广泛[1 ] . IF模型模拟离子电流调节神经元膜电位的过程,随着时间推移整合多源信息,神经元根据自身内部状态,在膜电位超过阈值的时刻发放电脉冲,将模拟的运算结果传递给后级相连的神经元. ...

... [1 ]. IF模型模拟离子电流调节神经元膜电位的过程,随着时间推移整合多源信息,神经元根据自身内部状态,在膜电位超过阈值的时刻发放电脉冲,将模拟的运算结果传递给后级相连的神经元. ...

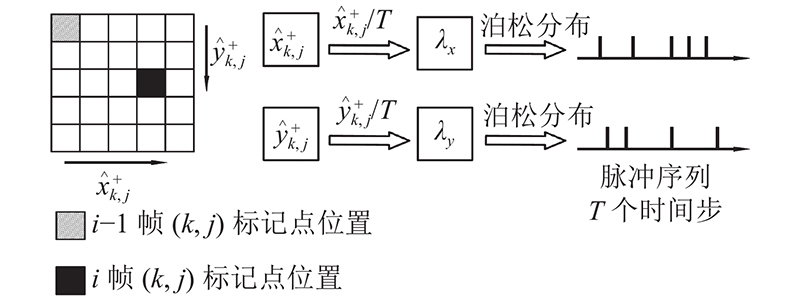

... 地址位移表示将相邻帧之间每个标记点(地址)的位移值(位移)编码为脉冲序列. 泊松编码是比较典型的实值编码方法[1 ] . 泊松分布描述单位时间内随机事件发生的次数,与神经元的脉冲发放频率对应,概率函数表示如下: ...

Neural mechanisms for generating rate and temporal codes in model CA3 pyramidal cells

0

2001

Active touch and self-motion encoding by merkel cell-associated afferents

0

2017

Loihi: a neuromorphic manycore processor with on-chip learning

0

2018

类脑研究: 为人类构建超级大脑

1

2020

... 基于深度学习算法和大数据的驱动,人工智能对多种任务的预测准确率甚至超过了人类,然而与人脑相比,深度学习在能耗比、鲁棒性及自适应性等方面都有明显的不足. 生物智能基于长时间的进化以应对自然环境的各种变化,使用具身感知系统来获取和正确解析外界环境信息,对接下来产生的行为做出合适的决策和规划. 其中,触觉信息特别是指尖触觉信息的获取及高效解析对人类完成各种操作任务具有至关重要的作用. 目前在机器人操作领域,如何让机械臂及机械手拥有有效的触觉感知和反馈能力,依然面临非常艰巨的挑战. 针对此问题,我们借鉴生物智能对变化的感知、编码和检测方式[1 -5 ] ,实现机器人的触觉感知及特征信息提取. ...

类脑研究: 为人类构建超级大脑

1

2020

... 基于深度学习算法和大数据的驱动,人工智能对多种任务的预测准确率甚至超过了人类,然而与人脑相比,深度学习在能耗比、鲁棒性及自适应性等方面都有明显的不足. 生物智能基于长时间的进化以应对自然环境的各种变化,使用具身感知系统来获取和正确解析外界环境信息,对接下来产生的行为做出合适的决策和规划. 其中,触觉信息特别是指尖触觉信息的获取及高效解析对人类完成各种操作任务具有至关重要的作用. 目前在机器人操作领域,如何让机械臂及机械手拥有有效的触觉感知和反馈能力,依然面临非常艰巨的挑战. 针对此问题,我们借鉴生物智能对变化的感知、编码和检测方式[1 -5 ] ,实现机器人的触觉感知及特征信息提取. ...

Generalized visual-tactile transformer network for slip detection

1

2020

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

Slip detection with a biomimetic tactile sensor

0

2018

2

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

... 近年来,基于人工神经网络的滑动检测方法得到了广泛的研究. Li等[36 ] 提出视觉-触觉融合深度神经网络来检测滑动,网络由卷积网络结合长短时记忆网络构建. 实验结果表明,训练好的网络在处理新物体滑动数据时的泛化能力较强. Zhang等[8 ] 使用FingerVision传感器,提出基于卷积长短时记忆网络的滑动分类框架. Zhang等[37 ] 使用基于人工神经网络的方法,对更多的接触事件进行预测和分类. ...

Model-free precise in-hand manipulation with a 3D-printed tactile gripper

1

2017

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

Robotic tactile perception of object properties: a review

1

2017

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

Recent progress in technologies for tactile sensors

1

2018

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

Gelsight: high-resolution robot tactile sensors for estimating geometry and force

1

2017

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

1

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

1

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

Soft biomimetic optical tactile sensing with the TacTip: a review

1

2021

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

1

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

In-hand object localization using a novel high-resolution visuotactile sensor

2

2021

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

... GelStereo触觉传感器的主要原理是将接触产生的触觉信息转化为硅胶的几何形变,利用视觉传感方法捕捉几何形变中包含的各种触觉信息[18 -19 ] . GelStereo触觉传感器如图2 (a)、(b)所示,主要由双目相机模组、带有光源结构的支撑框架和透明硅胶层组成. 硅胶层表面附着有标记点阵列,当硅胶层与物体发生接触时,硅胶形变会导致标记点移动. GelStereo传感器将触觉信息转化为标记点的位移. 图2 (c)中,触觉图像上的圆点表示标记点的位置,箭头表示标记点因接触产生的位移. 将图像平面上的标记点位移作为主要的传感模式,建模预测传感器表面与接触物体之间是否发生滑动. ...

Self-supervised contact geometry learning by GelStereo visuotactile sensing

2

2021

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

... GelStereo触觉传感器的主要原理是将接触产生的触觉信息转化为硅胶的几何形变,利用视觉传感方法捕捉几何形变中包含的各种触觉信息[18 -19 ] . GelStereo触觉传感器如图2 (a)、(b)所示,主要由双目相机模组、带有光源结构的支撑框架和透明硅胶层组成. 硅胶层表面附着有标记点阵列,当硅胶层与物体发生接触时,硅胶形变会导致标记点移动. GelStereo传感器将触觉信息转化为标记点的位移. 图2 (c)中,触觉图像上的圆点表示标记点的位置,箭头表示标记点因接触产生的位移. 将图像平面上的标记点位移作为主要的传感模式,建模预测传感器表面与接触物体之间是否发生滑动. ...

Visuotactile sensors with emphasis on gelsight sensor: a review

1

2020

... 赋予机器人触觉感知能力,可以显著提高机器人在灵巧抓取和接触丰富操作任务中的能力. 触觉传感器已经应用到滑动检测[6 -8 ] 、掌内物体操作[9 ] 、材料属性感知[10 ] 等任务中. 近几十年来,研究人员关注触觉传感器的结构设计与传感信息处理,基于不同的传感原理设计多种触觉传感器,包括电容式、压阻式、光电式、磁场式等[11 ] . 传统的阵列触觉传感器多数由上述原理的多个触觉感知单元根据具体应用场景排列分布组成. 近年来,视触觉传感器引起触觉感知领域的关注,包括GelSight[12 ] 、GelSlim[13 -15 ] 、TacTip[16 ] 、FingerVision[17 ] 、GelStereo[18 -19 ] 等. 视触觉传感器通过相机捕获由接触产生的弹性表面形变信息. 形变信息可以被建模为不同的触觉模态,包括触觉点云、力/力矩、滑动等[20 ] . 相比于传统阵列触觉传感器,视触觉传感器直接捕捉由接触产生的形变信息,更加贴近人类触觉感知机理,具有空间分辨率高、传感信息丰富、成本低等优势. ...

A neuro-inspired artificial peripheral nervous system for scalable electronic skins

2

2019

... 目前,触觉传感器几乎都采用基于时钟的数据产生方式,即以固定的频率产生和发送数据. 触觉感知只在接触事件发生时产生有效数据,基于时钟的方式会产生大量的冗余数据,给数据处理和传输带来困难. 部分工作开始研究基于事件的触觉信息传感方式. Lee等[21 ] 设计神经形态异步编码电子皮肤,即使在大规模部署的情况下,也可以保持低延时特性,为机器人的高动态灵巧操作提供了更多的发展空间. Ward-Cherrier等[22 ] 在TacTip的基础上,将RGB相机替换为DAVIS相机,设计NeuroTac传感器,研究密集编码、时间编码、空间编码、时空编码4种触觉信息编码方式,完成纹理识别任务. Kumagai等[23 ] 将事件相机(dynamic vision sensor,DVS)用于视触觉传感器设计,获得高空间分辨率和时间分辨率的触觉信息,该传感器具有检测接触位置和滑移的能力. ...

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

1

... 目前,触觉传感器几乎都采用基于时钟的数据产生方式,即以固定的频率产生和发送数据. 触觉感知只在接触事件发生时产生有效数据,基于时钟的方式会产生大量的冗余数据,给数据处理和传输带来困难. 部分工作开始研究基于事件的触觉信息传感方式. Lee等[21 ] 设计神经形态异步编码电子皮肤,即使在大规模部署的情况下,也可以保持低延时特性,为机器人的高动态灵巧操作提供了更多的发展空间. Ward-Cherrier等[22 ] 在TacTip的基础上,将RGB相机替换为DAVIS相机,设计NeuroTac传感器,研究密集编码、时间编码、空间编码、时空编码4种触觉信息编码方式,完成纹理识别任务. Kumagai等[23 ] 将事件相机(dynamic vision sensor,DVS)用于视触觉传感器设计,获得高空间分辨率和时间分辨率的触觉信息,该传感器具有检测接触位置和滑移的能力. ...

1

... 目前,触觉传感器几乎都采用基于时钟的数据产生方式,即以固定的频率产生和发送数据. 触觉感知只在接触事件发生时产生有效数据,基于时钟的方式会产生大量的冗余数据,给数据处理和传输带来困难. 部分工作开始研究基于事件的触觉信息传感方式. Lee等[21 ] 设计神经形态异步编码电子皮肤,即使在大规模部署的情况下,也可以保持低延时特性,为机器人的高动态灵巧操作提供了更多的发展空间. Ward-Cherrier等[22 ] 在TacTip的基础上,将RGB相机替换为DAVIS相机,设计NeuroTac传感器,研究密集编码、时间编码、空间编码、时空编码4种触觉信息编码方式,完成纹理识别任务. Kumagai等[23 ] 将事件相机(dynamic vision sensor,DVS)用于视触觉传感器设计,获得高空间分辨率和时间分辨率的触觉信息,该传感器具有检测接触位置和滑移的能力. ...

Conversion of continuous-valued deep networks to efficient event-driven networks for image classification

1

2017

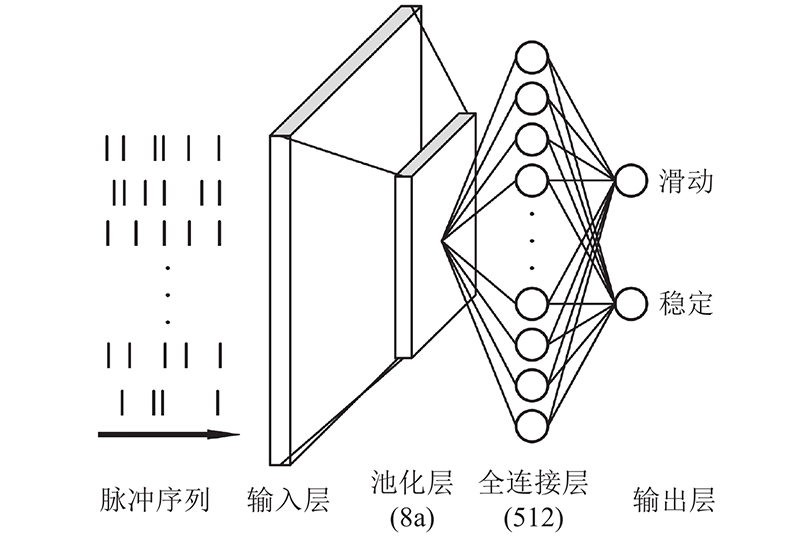

... 脉冲神经网络以神经元为基本计算单元,可以拥有和ANN网络类似的拓扑结构. 由于脉冲函数不同于ANN网络的激活函数,它的不可微性质导致脉冲神经网络在直接训练时面临巨大的障碍和挑战. ANN已有的反向传播算法不能直接用来训练SNN,目前几种代表性的解决方案包括转换法和直接训练法. 转换法是将训练好的ANN模型逐层转换为SNN模型[24 -25 ] ,直接训练法是采用脉冲函数的替代函数解决不可微问题[26 ] . 本文采用SLAYER训练框架[27 ] ,通过输出误差的反向传播进行脉冲神经网络突触权重和时延的学习. ...

Going deeper in spiking neural networks: VGG and residual architectures

1

2019

... 脉冲神经网络以神经元为基本计算单元,可以拥有和ANN网络类似的拓扑结构. 由于脉冲函数不同于ANN网络的激活函数,它的不可微性质导致脉冲神经网络在直接训练时面临巨大的障碍和挑战. ANN已有的反向传播算法不能直接用来训练SNN,目前几种代表性的解决方案包括转换法和直接训练法. 转换法是将训练好的ANN模型逐层转换为SNN模型[24 -25 ] ,直接训练法是采用脉冲函数的替代函数解决不可微问题[26 ] . 本文采用SLAYER训练框架[27 ] ,通过输出误差的反向传播进行脉冲神经网络突触权重和时延的学习. ...

Surrogate gradient learning in spiking neural networks: bringing the power of gradient-based optimization to spiking neural networks

1

2019

... 脉冲神经网络以神经元为基本计算单元,可以拥有和ANN网络类似的拓扑结构. 由于脉冲函数不同于ANN网络的激活函数,它的不可微性质导致脉冲神经网络在直接训练时面临巨大的障碍和挑战. ANN已有的反向传播算法不能直接用来训练SNN,目前几种代表性的解决方案包括转换法和直接训练法. 转换法是将训练好的ANN模型逐层转换为SNN模型[24 -25 ] ,直接训练法是采用脉冲函数的替代函数解决不可微问题[26 ] . 本文采用SLAYER训练框架[27 ] ,通过输出误差的反向传播进行脉冲神经网络突触权重和时延的学习. ...

2

... 脉冲神经网络以神经元为基本计算单元,可以拥有和ANN网络类似的拓扑结构. 由于脉冲函数不同于ANN网络的激活函数,它的不可微性质导致脉冲神经网络在直接训练时面临巨大的障碍和挑战. ANN已有的反向传播算法不能直接用来训练SNN,目前几种代表性的解决方案包括转换法和直接训练法. 转换法是将训练好的ANN模型逐层转换为SNN模型[24 -25 ] ,直接训练法是采用脉冲函数的替代函数解决不可微问题[26 ] . 本文采用SLAYER训练框架[27 ] ,通过输出误差的反向传播进行脉冲神经网络突触权重和时延的学习. ...

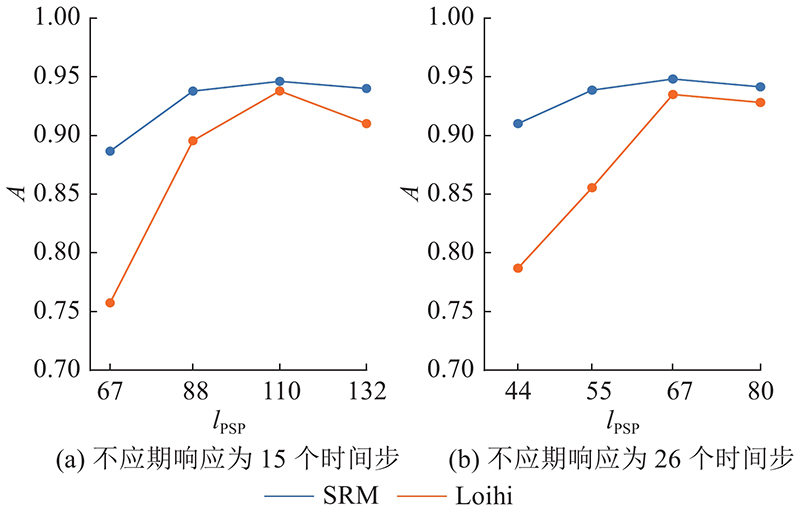

... SLAYER训练框架[27 ] 基于脉冲响应模型SRM实现SNN网络训练,该框架中神经元SRM模型参数包括突触电流、膜电位、衰减常数及突触权重等. 在训练中采用32位浮点数格式,模型的训练采用离线方式在GPU上完成,可以在GPU上进行推理仿真. SLAYER提供了专门的特化SRM模型——Loihi模型,支持英特尔Loihi芯片神经元参数配置及模型突触权重的量化缩放调整,实现实际硬件的部署. ...

1

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

1

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

1

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

1

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

Biomimetic tactile sensors and signal processing with spike trains: a review

0

2018

Tactile surface roughness categorization with multineuron spike train distance

1

2020

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

1

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

1

... 在Lee等[21 ] 基于事件的触觉传感器基础上,See等[28 ] 开源了触觉脉冲手写体数字识别数据集,公布了ANN、从ANN转换的SNN和SNN 3种基准方法的测试结果,促进神经形态触觉感知的研究. Taunyazov等[29 ] 利用异步编码电子皮肤设计NeuTouch事件触觉传感器,结合Prophesee事件相机用于机器人感知,构建视觉-触觉多模态SNN网络,完成物体质量分类和旋转滑动检测任务. Gu等[30 ] 为了增加NeuTouch不规则分布触觉单元之间的局部连接,提出用图结构组织触觉信息,设计脉冲图神经网络TactileSGNet,完成物体分类任务. 总体来看,基于事件的触觉传感器处于初期发展阶段,尚难以普遍应用于机器人领域. 不少工作关注将传统触觉传感器的触觉信号编码为脉冲信号[31 -33 ] ,研究类脑触觉信息处理的方法. Dabbous等[34 ] 通过LIF模型,将iCub机器人电容皮肤的时序读数编码为脉冲序列,再经过2层LIF神经元进行接触物体边缘角度分类. Taunyazov等[35 ] 使用K阈值法,将iCub RoboSkin和BioTac触觉传感器的时序数据转换为脉冲序列,完成了快速纹理分类任务. ...

1

... 近年来,基于人工神经网络的滑动检测方法得到了广泛的研究. Li等[36 ] 提出视觉-触觉融合深度神经网络来检测滑动,网络由卷积网络结合长短时记忆网络构建. 实验结果表明,训练好的网络在处理新物体滑动数据时的泛化能力较强. Zhang等[8 ] 使用FingerVision传感器,提出基于卷积长短时记忆网络的滑动分类框架. Zhang等[37 ] 使用基于人工神经网络的方法,对更多的接触事件进行预测和分类. ...

1

... 近年来,基于人工神经网络的滑动检测方法得到了广泛的研究. Li等[36 ] 提出视觉-触觉融合深度神经网络来检测滑动,网络由卷积网络结合长短时记忆网络构建. 实验结果表明,训练好的网络在处理新物体滑动数据时的泛化能力较强. Zhang等[8 ] 使用FingerVision传感器,提出基于卷积长短时记忆网络的滑动分类框架. Zhang等[37 ] 使用基于人工神经网络的方法,对更多的接触事件进行预测和分类. ...

Point-to-point connectivity between neuromorphic chips using address events

1

2000

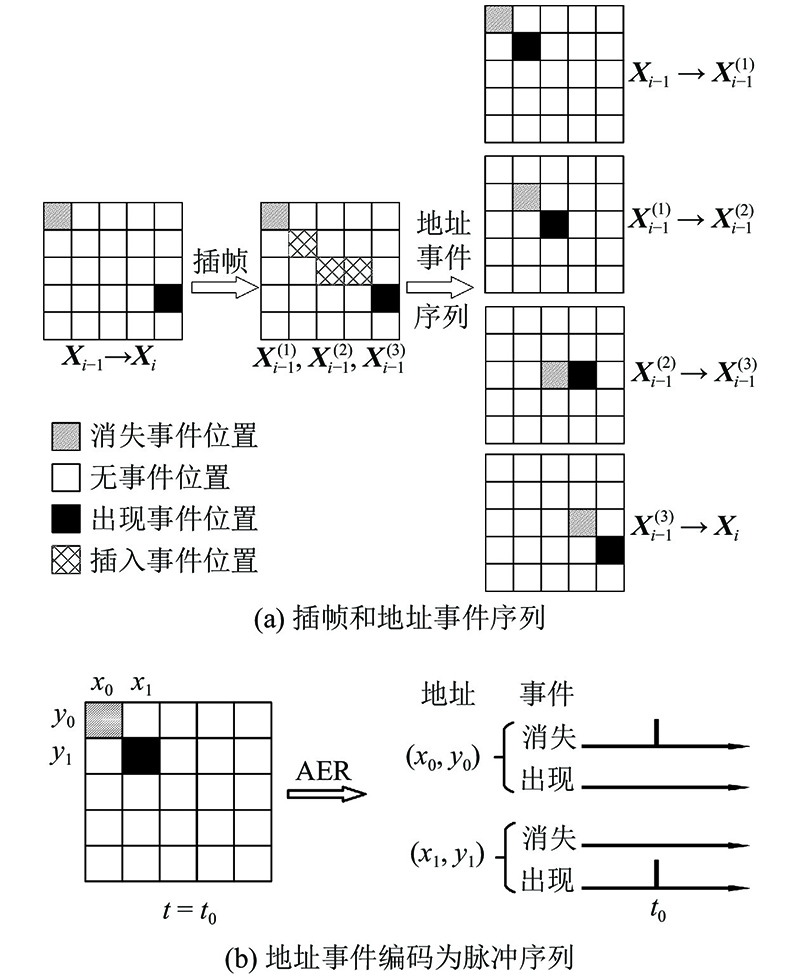

... 与人工神经网络不同,脉冲神经网络的输入数据是0-1脉冲序列. 采用以下2种方式,对GelStereo相邻帧之间标记点的位置变化进行脉冲编码. 1)直接将每个标记点的相对位移值编码为脉冲序列,将其命名为地址位移表示(address-displacement representation,ADR). 2)借鉴事件相机的编码方式,采用地址事件表示方法(address-event representation,AER)[38 ] . ...

Time structure of the activity in neural network models

1

1995

... 使用基于LIF神经元模型的通用阈值模型——脉冲响应模型(spiking response model,SRM)[39 ] . 在SRM模型中,神经元膜电位 $u(t)$

基于视触融合的机器人抓取滑动检测

1

2020

... CNN-LSTM网络 :长短时记忆神经网络(long short-term memory,LSTM)已被验证为学习时间序列较有效的方式. 将3帧标记点位移作为模型输入,用2层卷积神经网络(convolutional neural network,CNN)分别提取每一帧标记点位移场的特征. 将特征向量序列输入到含1个中间层的LSTM网络和全连接层中,完成分类任务[40 ] . ...

基于视触融合的机器人抓取滑动检测

1

2020

... CNN-LSTM网络 :长短时记忆神经网络(long short-term memory,LSTM)已被验证为学习时间序列较有效的方式. 将3帧标记点位移作为模型输入,用2层卷积神经网络(convolutional neural network,CNN)分别提取每一帧标记点位移场的特征. 将特征向量序列输入到含1个中间层的LSTM网络和全连接层中,完成分类任务[40 ] . ...