[1]

TAO Y, WAY K, SUK J B Detection of spatial defect patterns generated in semiconductor fabrication processes

[J]. IEEE Transactions on Semiconductor Manufacturing , 2011 , 24 (3 ): 392 - 403

DOI:10.1109/TSM.2011.2154870

[本文引用: 1]

[2]

KIM B, JEONG Y S, TONG S H, et al Step-down spatial randomness test for detecting abnormalities in DRAM wafers with multiple spatial maps

[J]. IEEE Transactions on Semiconductor Manufacturing , 2016 , 29 (1 ): 57 - 65

DOI:10.1109/TSM.2015.2486383

[3]

YU J, LU X Wafer map defect detection and recognition using joint local and nonlocal linear discriminant analysis

[J]. IEEE Transactions on Semiconductor Manufacturing , 2016 , 29 (1 ): 33 - 42

DOI:10.1109/TSM.2015.2497264

[本文引用: 2]

[4]

SHANKAR N G, ZHONG Z W Defect detection on semiconductor wafer surfaces

[J]. Microelectronic Engineering , 2005 , 77 (3 ): 337 - 346

[本文引用: 1]

[5]

LEE S H, KOO H I, CHO N I New automatic defect classification algorithm based on a classification-after-segmentation framework

[J]. Journal of Electronic Imaging , 2010 , 19 (2 ): 334 - 343

[本文引用: 1]

[6]

HWANG J Y, KUO W Model-based clustering for integrated circuit yield enhancement

[J]. European Journal of Operational Research , 2007 , 178 (1 ): 143 - 153

DOI:10.1016/j.ejor.2005.11.032

[本文引用: 1]

[7]

BALY R, HAJJ H Wafer classification using support vector machines

[J]. IEEE Transactions on Semiconductor Manufacturing , 2012 , 25 (3 ): 373 - 383

DOI:10.1109/TSM.2012.2196058

[本文引用: 1]

[8]

XIE L, HUANG R, GU N, et al A novel defect detection and identification method in optical inspection

[J]. Neural Computing and Applications , 2014 , 24 (7/8 ): 1953 - 1962

DOI:10.1007/s00521-013-1442-7

[本文引用: 1]

[9]

CHAO L C, TONG L I Wafer defect pattern recognition by multi-class support vector machines by using a novel defect cluster index

[J]. Expert Systems with Applications , 2009 , 36 (6 ): 10158 - 10167

DOI:10.1016/j.eswa.2009.01.003

[本文引用: 1]

[10]

ADLY F, ALUSSEIN O, YOO P, et al Simplified subspaced regression network for identification of defect patterns in semiconductor wafer maps

[J]. IEEE Transactions on Semiconductor Manufacturing , 2015 , 11 (6 ): 1267 - 1276

[本文引用: 1]

[11]

KIM B, JEONG Y S, TONG S H, et al A regularized singular value decomposition-based approach for failure pattern classification on fail bit map in a DRAM wafer

[J]. IEEE Transactions on Semiconductor Manufacturing , 2015 , 28 (1 ): 41 - 49

DOI:10.1109/TSM.2014.2388192

[本文引用: 1]

[12]

OOI M P L, SOK H K, KUANG Y C, et al Defect cluster recognition system for fabricated semiconductor wafers

[J]. Engineering Applications of Artificial Intelligence , 2013 , 26 (3 ): 1029 - 1043

DOI:10.1016/j.engappai.2012.03.016

[本文引用: 1]

[13]

余建波, 卢笑蕾, 宗卫周 基于局部与非局部线性判别分析和高斯混合模型动态集成的晶圆表面缺陷探测与识别

[J]. 自动化学报 , 2016 , 42 (1 ): 47 - 59

[本文引用: 1]

YU Jian-bo, LU Xiao-lei, ZONG Wei-zhou Wafer defect detection and recognition based on local and nonlocal linear discriminant analysis and dynamic ensemble of gaussian mixture models

[J]. ACTA Automatica Science , 2016 , 42 (1 ): 47 - 59

[本文引用: 1]

[14]

PIAO M, JIN C H, LEE J Y, et al Decision tree ensemble-based wafer map failure pattern recognition based on radon transform-based features

[J]. IEEE Transactions on Semiconductor Manufacturing , 2018 , 31 (2 ): 250 - 257

DOI:10.1109/TSM.2018.2806931

[本文引用: 3]

[15]

SAQLAIN M, JARGALSAIKHAN B, LEE J Y A voting ensemble classifier for wafer map defect patterns identification in semiconductor Manufacturing

[J]. IEEE Transactions on Semiconductor Manufacturing , 2019 , 32 (2 ): 171 - 182

DOI:10.1109/TSM.2019.2904306

[本文引用: 2]

[17]

杨婧, 耿辰, 王海林, 纪建松, 等 基于DenseNet的低分辨CT影像肺腺癌组织学亚型分类

[J]. 浙江大学学报: 工学版 , 2019 , 53 (6 ): 1164 - 1170

[本文引用: 1]

YANG Jing, GENG Chen, WANG Hai-lin, et al Classification on histological subtypes of lung adenocarcinoma from low-resolution CT images based on DenseNet

[J]. Journal of Zhejiang Unversity: Engineering Science , 2019 , 53 (6 ): 1164 - 1170

[本文引用: 1]

[18]

THIRUKOVALLURU R, DIXIT S, SEVAKULA RK et al. Generating feature sets for fault diagnosis using denoising stacked auto-encoder [C] // IEEE International Conference in Prognostics and Health Management (ICPHM) . Ottawa: IEEE, 2016: 1-7.

[本文引用: 1]

[19]

JIANG G, HE H, XIE P, et al Stacked Multilevel-Denoising Autoencoders: a new representation learning approach for wind turbine gearbox fault diagnosis

[J]. IEEE Transactions on Instrumentation and Measurement , 2017 , 66 : 2391 - 2402

DOI:10.1109/TIM.2017.2698738

[本文引用: 1]

[20]

KRIZHEVSKY A, SUTSKEVER I, HINTON GE. Imagenet classification with deep convolutional neural networks [C] // Advances in Neural Information Processing Systems (NIPS) . Lake Tahoe: [s. n.], 2012: 1097–1105.

[本文引用: 2]

[21]

袁公萍, 汤一平, 韩旺明, 等 基于深度卷积神经网络的车型识别方法

[J]. 浙江大学学报: 工学版 , 2018 , 52 (4 ): 694 - 702

[本文引用: 2]

YUAN Gong-ping, TANG Yi-ping, et al Vehicle category recognition based on deep convolutional neural network

[J]. Journal of Zhejiang University: Engineering Science , 2018 , 52 (4 ): 694 - 702

[本文引用: 2]

[22]

SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions [C] // 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Boston: IEEE, 2015: 1-9.

[本文引用: 6]

[23]

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition [C] // 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Las Vegas: IEEE, 2016: 770-778..

[本文引用: 1]

[24]

HUANG G, LIU Z, MAATEN L V D et al. Densely connected convolutional networks [C] // 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Honolulu IEEE, 2017: 2261-2260.

[本文引用: 1]

[25]

DANIEL W, BERND S R, MOSHE S Design of deep convolutional neural network architectures for automated feature extraction in industrial inspection

[J]. CIRP Annual Manufacturing Technology , 2016 , 65 (1 ): 417 - 420

DOI:10.1016/j.cirp.2016.04.072

[本文引用: 1]

[26]

NAKAZAWA T, KULKARNI D V Wafer map defect pattern classification and image retrieval using convolutional neural network

[J]. IEEE Transactions on Semiconductor Manufacturing , 2018 , 31 (2 ): 309 - 314

DOI:10.1109/TSM.2018.2795466

[本文引用: 1]

[27]

KYEONG K, KIM H Classification of mixed-type defect patterns in wafer bin maps using convolutional neural networks

[J]. IEEE Transactions on Semiconductor Manufacturing , 2018 , 31 (3 ): 395 - 402

DOI:10.1109/TSM.2018.2841416

[本文引用: 1]

[28]

LEE H, KIM Y, KIM C O A deep learning model for robust wafer fault monitoring with sensor measurement noise

[J]. IEEE Transactions on Semiconductor Manufacturing , 2017 , 30 (1 ): 23 - 31

DOI:10.1109/TSM.2016.2628865

[本文引用: 2]

[29]

PAN S J, YANG Q A survey on transfer learning

[J]. IEEE Transactions on Knowledge and Data Engineering , 2010 , 22 (10 ): 1345 - 1359

DOI:10.1109/TKDE.2009.191

[本文引用: 2]

[30]

张雪松, 庄严, 闫飞, 等 基于迁移学习的类别级物体识别与检测研究与进展

[J]. 自动化学报 , 2019 , 45 (7 ): 1224 - 1243

[本文引用: 1]

ZHANG Xue-song, ZHUANG Yan, YAN Fei, et al Status and development of transfer learning based category-Level object recognition and detection

[J]. Acta Automatica Sinica , 2019 , 45 (7 ): 1224 - 1243

[本文引用: 1]

[31]

DONAHUE J, JIA Y, VINYALS O et al. DeCAF: a deep convolutional activation feature for generic visual recognition [C] // International Conference on Machine Learning (ICML) . Bengjin: [s. n.], 2014: 647-655.

[本文引用: 2]

[32]

ZHOU Z H, FENG J. Deep forest: towards an alternative to deep neural networks [C] // International Joint Conference on Artificial Intelligence (IJCAI) . Melbourne: [s. n.], 2017: 3553-3559.

[本文引用: 4]

[33]

UTKIN L V, RYABININ M A. A deep Forest for transductive transfer learning by using a consensus measure [C] // Conference on Artificial Intelligence and Natural Language (AINL) . Petersburg: Springer, 2017: 194-208.

[本文引用: 1]

[34]

SRIVASTAVA R K, GREFF K, SCHMIDHUBER J, et al. Highway networks [EB/OL].(2015-11-03)[2019-04-30], https://arxiv.org/abs/1505.00387

[本文引用: 1]

[35]

LIU F T, TING K M, YU Y, et al Spectrum of variable-random trees

[J]. Journal of Artificial Intelligence Research , 2008 , 32 (1 ): 355 - 384

[本文引用: 2]

[36]

GUO Y C. Knowledge-enabled short-term load forecasting based on pattern-base using classification & regression tree and support vector regression [C] // Fifth International Conference on Natural Computation . Tianjin: IEEE, 2009: 425-429.

[本文引用: 1]

[37]

WU M J, JANG J S R, CHEN J L Wafer map failure pattern recognition and similarity ranking for large-scale data sets

[J]. IEEE Transactions on Semiconductor Manufacturing , 2015 , 28 (1 ): 1 - 12

DOI:10.1109/TSM.2014.2364237

[本文引用: 1]

[38]

LAURENS V D M, GEOFFREY H 2008. Visualizing data using T-SNE

[J]. Journal of Machine Learning Research , 2008 , 9 (11 ): 2578 - 2605

[本文引用: 1]

Detection of spatial defect patterns generated in semiconductor fabrication processes

1

2011

... 半导体制造已然成为现代工业最为重要的行业之一,晶圆制造工艺通常涉及数百个集成电路模块,由于制造过程的复杂性和动态性,半导体晶圆容易出现缺陷[1 -3 ] . 晶圆图上的典型缺陷图案通常是由特定的设备故障或工艺变化引起的. 例如,边缘环形缺陷一般由错误蚀刻所引起,线性类缺陷是由于机器与晶圆片的摩擦,中心类缺陷通常因薄膜沉积产生[3 ] . 由此可见,快速识别产品质量异常,并确定生产过程中的故障原因,可以有效减少半导体制造过程中的返工率和废品率,有助于企业提高生产效率并降低成本. ...

Step-down spatial randomness test for detecting abnormalities in DRAM wafers with multiple spatial maps

0

2016

Wafer map defect detection and recognition using joint local and nonlocal linear discriminant analysis

2

2016

... 半导体制造已然成为现代工业最为重要的行业之一,晶圆制造工艺通常涉及数百个集成电路模块,由于制造过程的复杂性和动态性,半导体晶圆容易出现缺陷[1 -3 ] . 晶圆图上的典型缺陷图案通常是由特定的设备故障或工艺变化引起的. 例如,边缘环形缺陷一般由错误蚀刻所引起,线性类缺陷是由于机器与晶圆片的摩擦,中心类缺陷通常因薄膜沉积产生[3 ] . 由此可见,快速识别产品质量异常,并确定生产过程中的故障原因,可以有效减少半导体制造过程中的返工率和废品率,有助于企业提高生产效率并降低成本. ...

... [3 ]. 由此可见,快速识别产品质量异常,并确定生产过程中的故障原因,可以有效减少半导体制造过程中的返工率和废品率,有助于企业提高生产效率并降低成本. ...

Defect detection on semiconductor wafer surfaces

1

2005

... 晶圆图缺陷识别通常分为缺陷检测和缺陷分类2个步骤. 传统缺陷检测算法通过对比待检测图像和参考图像,选取两者差异区域作为图像缺陷[4 ] ,但精准的参考图像不易得到. 传统的缺陷分类算法先在晶圆图中提取特征,再将该特征作为分类器的输入,从而进行模式识别[5 ] . 上述方法主要存在以下2个问题:1)传统缺陷检测算法提取出的局部特征无法有效表示特定问题中的不同类型缺陷;2)传统缺陷检测分类算法的鲁棒性弱,需要根据新的问题重新设计整个识别模型. ...

New automatic defect classification algorithm based on a classification-after-segmentation framework

1

2010

... 晶圆图缺陷识别通常分为缺陷检测和缺陷分类2个步骤. 传统缺陷检测算法通过对比待检测图像和参考图像,选取两者差异区域作为图像缺陷[4 ] ,但精准的参考图像不易得到. 传统的缺陷分类算法先在晶圆图中提取特征,再将该特征作为分类器的输入,从而进行模式识别[5 ] . 上述方法主要存在以下2个问题:1)传统缺陷检测算法提取出的局部特征无法有效表示特定问题中的不同类型缺陷;2)传统缺陷检测分类算法的鲁棒性弱,需要根据新的问题重新设计整个识别模型. ...

Model-based clustering for integrated circuit yield enhancement

1

2007

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

Wafer classification using support vector machines

1

2012

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

A novel defect detection and identification method in optical inspection

1

2014

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

Wafer defect pattern recognition by multi-class support vector machines by using a novel defect cluster index

1

2009

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

Simplified subspaced regression network for identification of defect patterns in semiconductor wafer maps

1

2015

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

A regularized singular value decomposition-based approach for failure pattern classification on fail bit map in a DRAM wafer

1

2015

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

Defect cluster recognition system for fabricated semiconductor wafers

1

2013

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

基于局部与非局部线性判别分析和高斯混合模型动态集成的晶圆表面缺陷探测与识别

1

2016

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

基于局部与非局部线性判别分析和高斯混合模型动态集成的晶圆表面缺陷探测与识别

1

2016

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

Decision tree ensemble-based wafer map failure pattern recognition based on radon transform-based features

3

2018

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

... 为了验证所提方法的有效性和先进性,实验中将几种经典和最新的晶圆图缺陷模式识别方法作为DenseNet-GCForest的比较对象. 其中,CNN+Softmax分类器(CNN-Softmax)方法的CNN模型选择性能优秀的GoogleNet[15 ] 、ResNet[14 ] 和DenseNet[16 ] . 将决策树C4.5的最大深度设置为25,节点数目为100. 支持向量机分别采用线性核函数和高斯核函数,将惩罚因子设置为C =1.0.将随机森林最大深度设置为50,包含800棵树. 将KNN分类器中的K 值设置为5. 决策树集成算法[14 ] 将4种根据不同特征(最大值、最小值、均值和方差)形成的分类器进行集成投票. 堆叠降噪自编码器(stacked denoising auto encoder,SDAE)[28 ] 深度学习算法共包含2个隐层:第一隐层由100个神经元组成,第二隐层包含50个神经元. ...

... [14 ]将4种根据不同特征(最大值、最小值、均值和方差)形成的分类器进行集成投票. 堆叠降噪自编码器(stacked denoising auto encoder,SDAE)[28 ] 深度学习算法共包含2个隐层:第一隐层由100个神经元组成,第二隐层包含50个神经元. ...

A voting ensemble classifier for wafer map defect patterns identification in semiconductor Manufacturing

2

2019

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

... 为了验证所提方法的有效性和先进性,实验中将几种经典和最新的晶圆图缺陷模式识别方法作为DenseNet-GCForest的比较对象. 其中,CNN+Softmax分类器(CNN-Softmax)方法的CNN模型选择性能优秀的GoogleNet[15 ] 、ResNet[14 ] 和DenseNet[16 ] . 将决策树C4.5的最大深度设置为25,节点数目为100. 支持向量机分别采用线性核函数和高斯核函数,将惩罚因子设置为C =1.0.将随机森林最大深度设置为50,包含800棵树. 将KNN分类器中的K 值设置为5. 决策树集成算法[14 ] 将4种根据不同特征(最大值、最小值、均值和方差)形成的分类器进行集成投票. 堆叠降噪自编码器(stacked denoising auto encoder,SDAE)[28 ] 深度学习算法共包含2个隐层:第一隐层由100个神经元组成,第二隐层包含50个神经元. ...

Deep learning

3

2015

... 随着机器学习技术的发展,各种识别器被广泛用于晶圆图缺陷识别并获得了较好的效果. 监督识别分类方法有反向传播网络(back-propagation network,BPN)[6 ] 、广义回归神经网络(general regression neural network,GRNN)[7 ] 、支持向量机(SVM)[8 -9 ] 、随机化广义回归网络(randomized general regression network) [10 ] 、K-临近算法(K-nearest-neighbor,KNN)[11 ] 、决策树(CART4.5)[12 ] 、高斯混合模型[13 ] 、多特征决策树集成[14 ] 、均值标准集成方法[15 ] 等. 基于机器学习的识别算法在晶圆缺陷识别中取得了一定成果,但晶圆图的特征维度高、噪声多,会严重影响识别器的性能. 因此,该类方法依赖人类的主观特征选择,为识别器提供有效判别信息,这会导致所提取的特征具有一定的主观性和局限性. 此外,该方法依赖人的主观经验去抽取不同类型晶圆图中的缺陷特征,因此如何保证特征的有效性是实际应用中的一大难题. 综上所述,现代智能诊断系统迫切需要能客观且高效地从原始图像信号进行特征学习的方法,从而提高系统的工业可应用性. 基于深度学习的特征提取方法是解决这一问题的有效手段之一[16 ] . ...

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

... 为了验证所提方法的有效性和先进性,实验中将几种经典和最新的晶圆图缺陷模式识别方法作为DenseNet-GCForest的比较对象. 其中,CNN+Softmax分类器(CNN-Softmax)方法的CNN模型选择性能优秀的GoogleNet[15 ] 、ResNet[14 ] 和DenseNet[16 ] . 将决策树C4.5的最大深度设置为25,节点数目为100. 支持向量机分别采用线性核函数和高斯核函数,将惩罚因子设置为C =1.0.将随机森林最大深度设置为50,包含800棵树. 将KNN分类器中的K 值设置为5. 决策树集成算法[14 ] 将4种根据不同特征(最大值、最小值、均值和方差)形成的分类器进行集成投票. 堆叠降噪自编码器(stacked denoising auto encoder,SDAE)[28 ] 深度学习算法共包含2个隐层:第一隐层由100个神经元组成,第二隐层包含50个神经元. ...

基于DenseNet的低分辨CT影像肺腺癌组织学亚型分类

1

2019

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

基于DenseNet的低分辨CT影像肺腺癌组织学亚型分类

1

2019

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

1

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

Stacked Multilevel-Denoising Autoencoders: a new representation learning approach for wind turbine gearbox fault diagnosis

1

2017

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

2

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

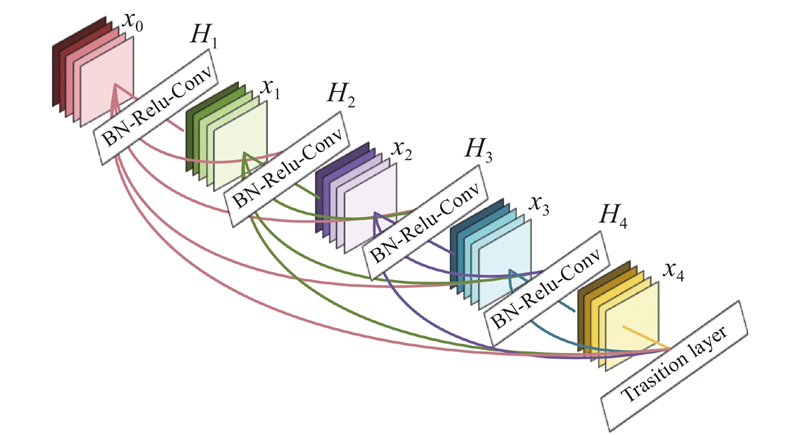

... DenseNet[22 ] 密集连接深度卷积神经网络具有强大的特征学习和特征提取能力. 深度学习网络性能的提升往往伴随着网络深度的提升,但是随着网络深度的逐渐加深和模型的复杂化,深度神经网络在训练过程中的梯度消失问题会愈加严重[22 ] . DenseNet全新设计了深度神经网络模型的特征传导机制,很好地解决了这个问题. DenseNet是在GoogLeNet[20 ] 、ResidualNet [21 ] 以及HighwayNet [34 ] 的基础上被提出来的. DenseNet的核心思想是跨层连接,网络深浅层的特征信息被神经网络直接连接了起来,从而有效减轻了梯度消失的问题[22 ] . 不同于传统神经网络过度依赖网络最后一层特征的类判别性,DenseNet可以综合利用网络中的深浅层特征,加强了特征的传导和利用,减轻了梯度消失的问题,从而得到了具有更好泛化性能的决策函数[22 ] . ...

基于深度卷积神经网络的车型识别方法

2

2018

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

... DenseNet[22 ] 密集连接深度卷积神经网络具有强大的特征学习和特征提取能力. 深度学习网络性能的提升往往伴随着网络深度的提升,但是随着网络深度的逐渐加深和模型的复杂化,深度神经网络在训练过程中的梯度消失问题会愈加严重[22 ] . DenseNet全新设计了深度神经网络模型的特征传导机制,很好地解决了这个问题. DenseNet是在GoogLeNet[20 ] 、ResidualNet [21 ] 以及HighwayNet [34 ] 的基础上被提出来的. DenseNet的核心思想是跨层连接,网络深浅层的特征信息被神经网络直接连接了起来,从而有效减轻了梯度消失的问题[22 ] . 不同于传统神经网络过度依赖网络最后一层特征的类判别性,DenseNet可以综合利用网络中的深浅层特征,加强了特征的传导和利用,减轻了梯度消失的问题,从而得到了具有更好泛化性能的决策函数[22 ] . ...

基于深度卷积神经网络的车型识别方法

2

2018

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

... DenseNet[22 ] 密集连接深度卷积神经网络具有强大的特征学习和特征提取能力. 深度学习网络性能的提升往往伴随着网络深度的提升,但是随着网络深度的逐渐加深和模型的复杂化,深度神经网络在训练过程中的梯度消失问题会愈加严重[22 ] . DenseNet全新设计了深度神经网络模型的特征传导机制,很好地解决了这个问题. DenseNet是在GoogLeNet[20 ] 、ResidualNet [21 ] 以及HighwayNet [34 ] 的基础上被提出来的. DenseNet的核心思想是跨层连接,网络深浅层的特征信息被神经网络直接连接了起来,从而有效减轻了梯度消失的问题[22 ] . 不同于传统神经网络过度依赖网络最后一层特征的类判别性,DenseNet可以综合利用网络中的深浅层特征,加强了特征的传导和利用,减轻了梯度消失的问题,从而得到了具有更好泛化性能的决策函数[22 ] . ...

6

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

... DenseNet[22 ] 密集连接深度卷积神经网络具有强大的特征学习和特征提取能力. 深度学习网络性能的提升往往伴随着网络深度的提升,但是随着网络深度的逐渐加深和模型的复杂化,深度神经网络在训练过程中的梯度消失问题会愈加严重[22 ] . DenseNet全新设计了深度神经网络模型的特征传导机制,很好地解决了这个问题. DenseNet是在GoogLeNet[20 ] 、ResidualNet [21 ] 以及HighwayNet [34 ] 的基础上被提出来的. DenseNet的核心思想是跨层连接,网络深浅层的特征信息被神经网络直接连接了起来,从而有效减轻了梯度消失的问题[22 ] . 不同于传统神经网络过度依赖网络最后一层特征的类判别性,DenseNet可以综合利用网络中的深浅层特征,加强了特征的传导和利用,减轻了梯度消失的问题,从而得到了具有更好泛化性能的决策函数[22 ] . ...

... [22 ]. DenseNet全新设计了深度神经网络模型的特征传导机制,很好地解决了这个问题. DenseNet是在GoogLeNet[20 ] 、ResidualNet [21 ] 以及HighwayNet [34 ] 的基础上被提出来的. DenseNet的核心思想是跨层连接,网络深浅层的特征信息被神经网络直接连接了起来,从而有效减轻了梯度消失的问题[22 ] . 不同于传统神经网络过度依赖网络最后一层特征的类判别性,DenseNet可以综合利用网络中的深浅层特征,加强了特征的传导和利用,减轻了梯度消失的问题,从而得到了具有更好泛化性能的决策函数[22 ] . ...

... [22 ]. 不同于传统神经网络过度依赖网络最后一层特征的类判别性,DenseNet可以综合利用网络中的深浅层特征,加强了特征的传导和利用,减轻了梯度消失的问题,从而得到了具有更好泛化性能的决策函数[22 ] . ...

... [22 ]. ...

... 式中: ${x_l}$ l 层网络的输出, ${{{H}}_l}$ l 层的输出函数表示,每一层网络包含了批标准化化(batch normalization,BN)、Relu函数和卷积操作[22 ] . ...

1

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

1

... 近年来,基于深度学习的特征提取方法在计算机视觉任务中获得了巨大成功[16 ] . 深度学习也称为深度神经网络(deep neural network,DNN),是一种新型特征学习方法,具有多个隐藏层,采用具有多个神经层的分层结构,并逐层学习输入数据中的特征信息. 这种深层结构能够学习复杂原始数据的高级抽象特征,在构造分类器或识别器时更容易提取有用的特征[17 ] . 随着计算机性能的不断加强,深度神经网络实现了高效处理大规模数据并展现出了卓越的高级表征能力,因此被广泛应用在实际工业生产活动中,例如:深度置信网络(deep belief networks,DBN)、自编码器(auto encoder,AE)、降噪自编码器(denoising autoencoder,DAE)、堆叠降噪自编码器(stacked denoising autoencoder,SDAE)在机器健康监测和故障诊断领域的应用引起了学者们的广泛关注[18 -19 ] . 虽然上述方法能够有效处理一维信号,但由于该类方法自身的结构限制,在识别晶圆图像等二维数据时效果不佳. 卷积神经网络(CNN)通过引入卷积核结构,有效解决了不同领域的图像分类和目标识别问题 [20 -21 ] ,例如:GoogleNet[22 ] 、ResNet[23 ] 、DenseNet[24 ] 等深度CNN在ImageNet图像库上的识别准确率已经超越人类. ...

Design of deep convolutional neural network architectures for automated feature extraction in industrial inspection

1

2016

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

Wafer map defect pattern classification and image retrieval using convolutional neural network

1

2018

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

Classification of mixed-type defect patterns in wafer bin maps using convolutional neural networks

1

2018

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

A deep learning model for robust wafer fault monitoring with sensor measurement noise

2

2017

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

... 为了验证所提方法的有效性和先进性,实验中将几种经典和最新的晶圆图缺陷模式识别方法作为DenseNet-GCForest的比较对象. 其中,CNN+Softmax分类器(CNN-Softmax)方法的CNN模型选择性能优秀的GoogleNet[15 ] 、ResNet[14 ] 和DenseNet[16 ] . 将决策树C4.5的最大深度设置为25,节点数目为100. 支持向量机分别采用线性核函数和高斯核函数,将惩罚因子设置为C =1.0.将随机森林最大深度设置为50,包含800棵树. 将KNN分类器中的K 值设置为5. 决策树集成算法[14 ] 将4种根据不同特征(最大值、最小值、均值和方差)形成的分类器进行集成投票. 堆叠降噪自编码器(stacked denoising auto encoder,SDAE)[28 ] 深度学习算法共包含2个隐层:第一隐层由100个神经元组成,第二隐层包含50个神经元. ...

A survey on transfer learning

2

2010

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

... [29 -30 ]可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

基于迁移学习的类别级物体识别与检测研究与进展

1

2019

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

基于迁移学习的类别级物体识别与检测研究与进展

1

2019

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

2

... 在晶圆图缺陷识别领域,一些学者探究了CNN的结构,并将各种类型的晶圆图像直接作为数据输入进行分类识别[25 ] . 也有学者将CNN运用于混合缺陷分类[26 ] 、自动特征提取[27 ] 、晶圆图像检索[28 ] 等研究方向. 但是当采用上述基于CNN的传统深度学习方法识别新的晶圆图缺陷诊断任务时,研究人员通常需要重新设计并训练一个新的深度卷积网络. 整个过程包括复杂的超参数调节和模型参数再训练,这需要耗费大量的时间资源和计算资源[29 ] . 迁移学习(transfer learning)[29 -30 ] 可以认为是在最小人工监督代价下进行机器学习的一种崭新策略. 基于模型参数共享的迁移学习算法通过迁移在大规模数据集中预训练好的网络模型,将该模型嵌入在其他任务模型中作为特征提取器. 大规模图像数据集上的实验结果证明了预训练网络提取到的特征具有良好的判别性[31 ] . 此外,由于具有类别标签的图像不易获得,且人工采集成本较高,晶圆图数据存在着类不平衡的问题. 迁移学习算法通过学习在大规模数据集上表现优异的模型和权重参数,能够有效提取小样本数据的深度特征信息并识别其类型[31 ] . ...

... [31 ]. ...

4

... 深度CNN提取出的特征维度较高、信息较为抽象,深度森林(Deep Forest)[32 -33 ] 这一基于随机森林算法的决策树集成深度模型采用多维度扫描和级联处理的方法,可以有效地识别并处理高维度特征信息. 深度森林在随机森林的基础上,引入了多粒度扫描和级联森林2个阶段,使模型具有上下文感知能力和深度表征能力. 相比于深度神经网络算法,深度森林算法具有更少的超参数,且能够自适应地决定模型的层数大小,减少模型的复杂度. 实验结果表明,即使在面对不同任务时,深度森林的默认超参数设置也能取得有效的识别效果[32 ] . 综上所述,现有晶圆图缺陷模式识别模型主要有以下3个问题. ...

... [32 ]. 综上所述,现有晶圆图缺陷模式识别模型主要有以下3个问题. ...

... 通过DenseNet169提取出的特征维度较高,特征信息抽象,直接使用全连接神经网络并不能有效识别各个晶圆图的类别. 深度森林(Deep forest)这一基于随机森林算法的决策树深度模型采用多维度扫描和级联处理的方法,可以有效地识别和处理高维度特征信息,并在模式识别问题上表现出了良好的性能. 多维度扫描集成森林GCForest是一种新型决策树集成方法[32 ,35 -36 ] ,该方法在随机森林的基础上引入了级联结构和集成学习,从而增强了决策树模型的表征能力. 当输入是高维数据时,GCForest通过多维度扫描生成多尺度特征向量,从而进一步增强算法的表征学习能力. GCForest可以自适应地确定级联层数,自行决定模型复杂程度,用户可以根据可用的计算资源来控制训练成本. GCForest的另一优点在于该模型具有较少的超参数,且超参数具有较强的鲁棒性. ...

... GCForest 由2个部分所组成. 第一部分是多粒度扫描结构,GCForest通过滑动窗口扫描原始数据,生成一组多尺寸特征向量. 第二部分是级联森林结构,其重要思想之一是根据每个输入实例生成对应类分布. 如图3 所示,GCForest通过计算决策树中各叶节点处不同类实例数量占比的平均值,从而预测各实例的类别分布. 图4 展示了深度森林的网络结构,多粒度扫描阶段首先根据输入数据生成多尺度特征向量. 其次,级联森林[32 ] 阶段对生成的多尺度特征向量进行逐层训练,预测其类别分布,并将生成的类别分布向量与原始向量连接,通过级联通道以输入到下级级联层. 在级联森林的训练过程中,当验证集的识别性能收敛时,模型自适应终止训练, 因此,级联森林能够自适应地决定模型复杂度. 在本研究的级联森林中,每一层由2个随机森林和2个完全随机森林组成. 其中,每个随机森林包含500 棵决策树,每个完全随机森林则包含1 000棵决策树,两者的区别主要在于候选特征空间的选择. 完全随机森林在完整的特征空间中随机选择特征作为决策树的分裂节点,然后不断生长, 当决策树中的所有叶节点都无法分裂时,则终止训练; 普通随机森林随机选取 $ \sqrt{d} $ d 为输入特征维度)个候选特征,然后通过Gini指数筛选分裂节点进行生长分裂[35 ] . 基尼指数公式如下: ...

1

... 深度CNN提取出的特征维度较高、信息较为抽象,深度森林(Deep Forest)[32 -33 ] 这一基于随机森林算法的决策树集成深度模型采用多维度扫描和级联处理的方法,可以有效地识别并处理高维度特征信息. 深度森林在随机森林的基础上,引入了多粒度扫描和级联森林2个阶段,使模型具有上下文感知能力和深度表征能力. 相比于深度神经网络算法,深度森林算法具有更少的超参数,且能够自适应地决定模型的层数大小,减少模型的复杂度. 实验结果表明,即使在面对不同任务时,深度森林的默认超参数设置也能取得有效的识别效果[32 ] . 综上所述,现有晶圆图缺陷模式识别模型主要有以下3个问题. ...

1

... DenseNet[22 ] 密集连接深度卷积神经网络具有强大的特征学习和特征提取能力. 深度学习网络性能的提升往往伴随着网络深度的提升,但是随着网络深度的逐渐加深和模型的复杂化,深度神经网络在训练过程中的梯度消失问题会愈加严重[22 ] . DenseNet全新设计了深度神经网络模型的特征传导机制,很好地解决了这个问题. DenseNet是在GoogLeNet[20 ] 、ResidualNet [21 ] 以及HighwayNet [34 ] 的基础上被提出来的. DenseNet的核心思想是跨层连接,网络深浅层的特征信息被神经网络直接连接了起来,从而有效减轻了梯度消失的问题[22 ] . 不同于传统神经网络过度依赖网络最后一层特征的类判别性,DenseNet可以综合利用网络中的深浅层特征,加强了特征的传导和利用,减轻了梯度消失的问题,从而得到了具有更好泛化性能的决策函数[22 ] . ...

Spectrum of variable-random trees

2

2008

... 通过DenseNet169提取出的特征维度较高,特征信息抽象,直接使用全连接神经网络并不能有效识别各个晶圆图的类别. 深度森林(Deep forest)这一基于随机森林算法的决策树深度模型采用多维度扫描和级联处理的方法,可以有效地识别和处理高维度特征信息,并在模式识别问题上表现出了良好的性能. 多维度扫描集成森林GCForest是一种新型决策树集成方法[32 ,35 -36 ] ,该方法在随机森林的基础上引入了级联结构和集成学习,从而增强了决策树模型的表征能力. 当输入是高维数据时,GCForest通过多维度扫描生成多尺度特征向量,从而进一步增强算法的表征学习能力. GCForest可以自适应地确定级联层数,自行决定模型复杂程度,用户可以根据可用的计算资源来控制训练成本. GCForest的另一优点在于该模型具有较少的超参数,且超参数具有较强的鲁棒性. ...

... GCForest 由2个部分所组成. 第一部分是多粒度扫描结构,GCForest通过滑动窗口扫描原始数据,生成一组多尺寸特征向量. 第二部分是级联森林结构,其重要思想之一是根据每个输入实例生成对应类分布. 如图3 所示,GCForest通过计算决策树中各叶节点处不同类实例数量占比的平均值,从而预测各实例的类别分布. 图4 展示了深度森林的网络结构,多粒度扫描阶段首先根据输入数据生成多尺度特征向量. 其次,级联森林[32 ] 阶段对生成的多尺度特征向量进行逐层训练,预测其类别分布,并将生成的类别分布向量与原始向量连接,通过级联通道以输入到下级级联层. 在级联森林的训练过程中,当验证集的识别性能收敛时,模型自适应终止训练, 因此,级联森林能够自适应地决定模型复杂度. 在本研究的级联森林中,每一层由2个随机森林和2个完全随机森林组成. 其中,每个随机森林包含500 棵决策树,每个完全随机森林则包含1 000棵决策树,两者的区别主要在于候选特征空间的选择. 完全随机森林在完整的特征空间中随机选择特征作为决策树的分裂节点,然后不断生长, 当决策树中的所有叶节点都无法分裂时,则终止训练; 普通随机森林随机选取 $ \sqrt{d} $ d 为输入特征维度)个候选特征,然后通过Gini指数筛选分裂节点进行生长分裂[35 ] . 基尼指数公式如下: ...

1

... 通过DenseNet169提取出的特征维度较高,特征信息抽象,直接使用全连接神经网络并不能有效识别各个晶圆图的类别. 深度森林(Deep forest)这一基于随机森林算法的决策树深度模型采用多维度扫描和级联处理的方法,可以有效地识别和处理高维度特征信息,并在模式识别问题上表现出了良好的性能. 多维度扫描集成森林GCForest是一种新型决策树集成方法[32 ,35 -36 ] ,该方法在随机森林的基础上引入了级联结构和集成学习,从而增强了决策树模型的表征能力. 当输入是高维数据时,GCForest通过多维度扫描生成多尺度特征向量,从而进一步增强算法的表征学习能力. GCForest可以自适应地确定级联层数,自行决定模型复杂程度,用户可以根据可用的计算资源来控制训练成本. GCForest的另一优点在于该模型具有较少的超参数,且超参数具有较强的鲁棒性. ...

Wafer map failure pattern recognition and similarity ranking for large-scale data sets

1

2015

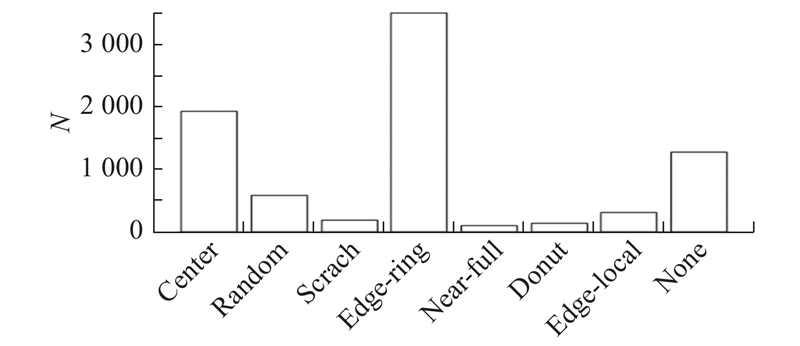

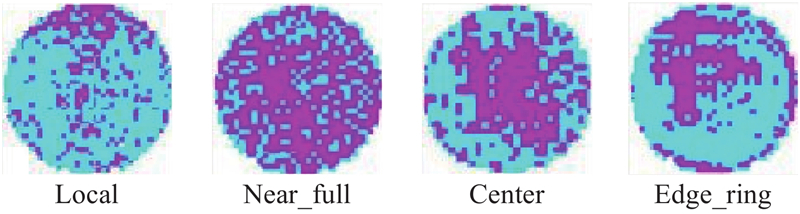

... 利用现场采集的工业数据集WM-811K[37 ] 晶圆图缺陷样本库来检验算法对缺陷的识别能力,该样本库中的图像均来自于实际半导体生产线. 该样本库中浅灰色、深灰色和白色像素分别表示每个晶片图的正常、有缺陷和空元素部分. WM-811K数据集由正常模式和8种缺陷模式组成,图6 展现了中心(Center)、圆环(Donut)、边缘局部(Edge-local)、边缘环(Edge-ring)、局部(Local)、近满(Near-full)、随机(Random),划痕缺陷(Scratch)和正常无缺陷(None-pattern)共9种类型的图案. 图7 列出了WM-811K数据集中的各类缺陷图像的数量N ,由此可见,该样本库存在明显的类不平衡,这对正确识别缺陷模式带来了很大挑战. 每个晶圆图的大小被预处理为128×128像素. 本实验将这些图像随机分成5份,进行五折交叉验证. 每次验证随机选取7 112张晶圆图作为训练数据集,剩余2 000张作为验证数据集. ...

2008. Visualizing data using T-SNE

1

2008

... 为了探究DenseNet网络提取特征的有效性,运用T-SNE[38 ] 数据可视化算法,对原始图像和DenseNet网络的输出特征进行数据降维,将不同类别的高维原始图像和特征信息降维至二维平面,并运用散点图描绘相关数据信息.图10 展示了T-SNE数据可视化的结果,在二维空间(D1D2)中,原始图像的多个类别混合在一起,极难判别,而DenseNet网络提取的特征有效分离了9个晶圆图缺陷类型,该特征具有良好的类判别性,说明DenseNet169具有优秀的特征提取能力. ...