上述3类方法对传感器参数、场景特性及影像数据等均提出了要求,无法在诸如传感器参数未知、环境结构特征不明显、影像数据较少的场合得到应用. 因此,本研究提出基于灰度相似性的3D激光点云与全景影像自动化配准算法.

利用全景图像拼接算法将多张单幅图像拼接形成全景影像,同时通过对激光点云进行柱体坐标变换投影构建2D平面点云深度图,并在水平与垂直方向上进行均匀的等区域划分. 本算法创新性地使用深度图作为激光点云与全景图像的配准媒介,结合灰度相似性原理循环对比各区域间的像素灰度值之和,寻找最佳偏移量,摆脱了须人工对多传感器联合标定才能使异构数据配准的现状. 相关实测结果表明,本研究方法对场景的适应性较好,配准误差较低.

1. 激光点云与全景影像配准方法

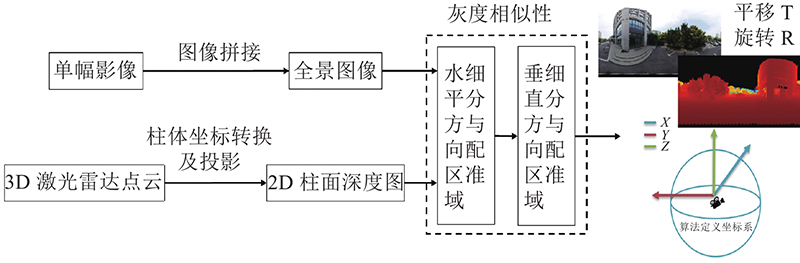

如图1所示为基于灰度相似性的激光点云与全景影像配准的算法结构框架图,将多线程3D激光雷达点云与单幅影像作为数据输入源,从图像拼接和点云变换投影的数据转换、基于灰度相似性的水平配准和基于灰度相似性的垂直配准这3个主要方面进行算法构建,最终实现激光雷达点云与图像异构数据的配准.

图 1

图 1 基于灰度相似性的激光点云与全景影像的算法结构框架图

Fig.1 Algorithm structure frame of lidar point cloud and panoramic image based on gray similarity

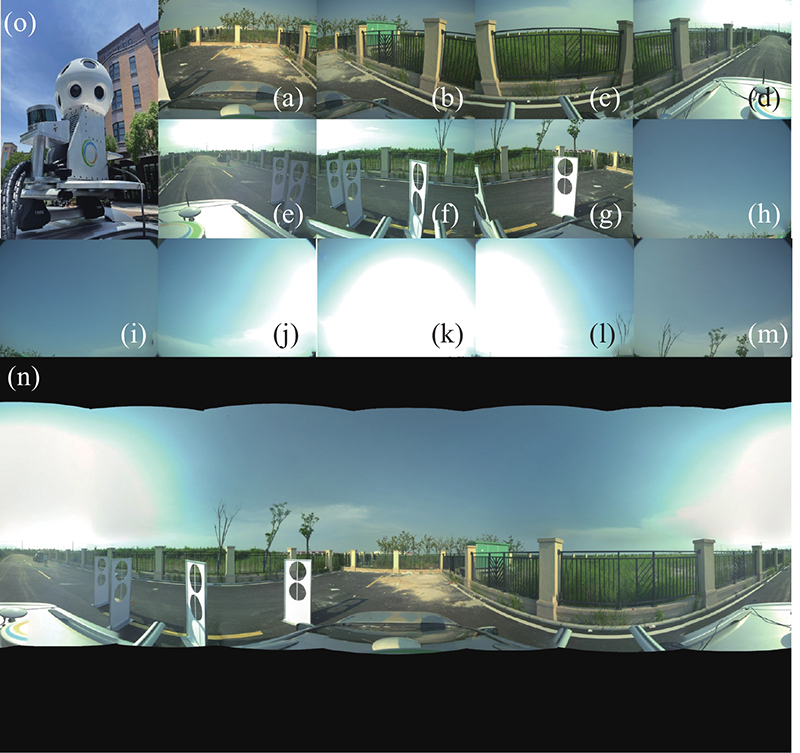

1.1. 数据转换

为了实现全景图片和3D激光点云的匹配,首先将单个相机采集的影像图拼接成全景图像,通过尺度不变特征变换(scale-invariant feature transform,SIFT)得到特征匹配,通过随机抽样一致算法(random sample consensus,RANSAC)筛选正确的特征匹配得到透视矩阵,利用透视变换完成2幅图像的拼接,循环迭代所有图像即可以完成多张图像的全景图拼接[16]. 如图2(o)所示为本研究所采用的由13个工业相机和1个3D激光雷达组成的车载移动测量系统. 如图2(a)~(m)所示为13个工业相机所采集的环境图像,如图2(n)所示为基于SIFT特征点匹配、RANSAC筛选和透视转换的全景拼接算法,将图2(a)~(m)拼接所形成的全景图像.

图 2

图 3

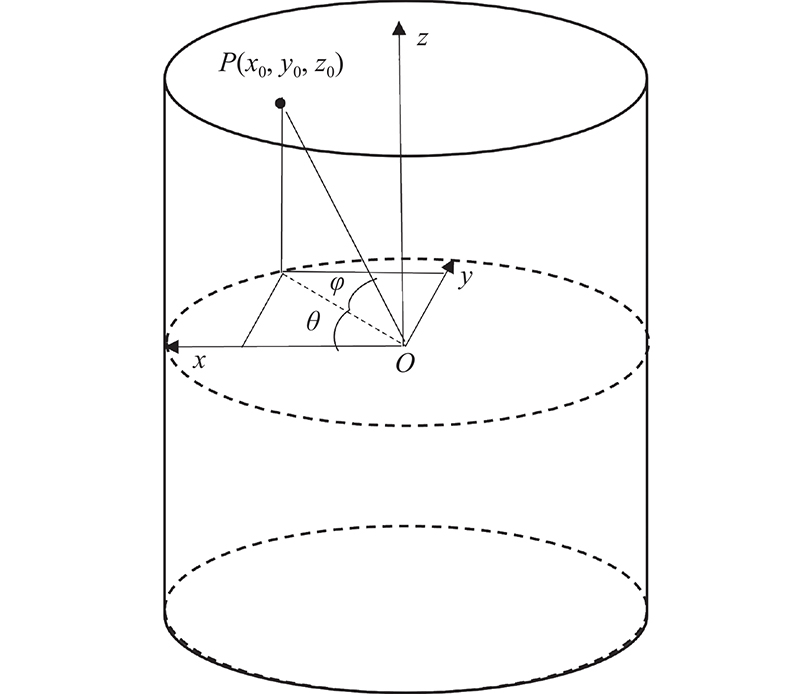

将柱体表面展开形成2D平面图,则其在柱体表面所对应像素点的坐标

式中:

像素点的灰度由P点的深度信息

1.2. 基于灰度相似性的水平配准

由于2D深度图和全景影像所拍摄的场景相同,在理想情况下,2D深度图中的任意一点信息点在全景影像中均有与其对应的像素点. 对于完全配准的全景影像和2D深度图,两者在整幅图片及图片细分区域的灰度分布应具有相似性[18].

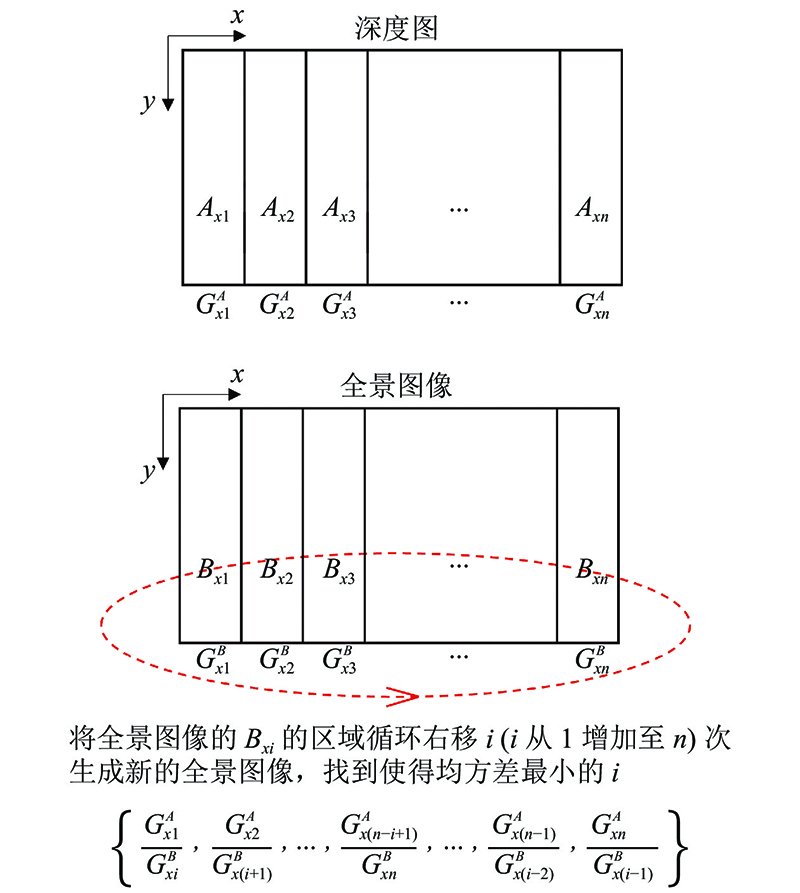

如图4所示为基于灰度相似性的水平配准原理. 将2D深度图沿x方向等间隔分为n块区域记为Ax1, Ax2, Ax3

图 4

图 4 基于灰度相似性的水平配准原理

Fig.4 Principle of horizontal registration based on gray similarity

全景相机和2D深度图在水平方向均包含了360°范围内的数据,当两者完全配准时,

1.3. 基于灰度相似性的垂直配准

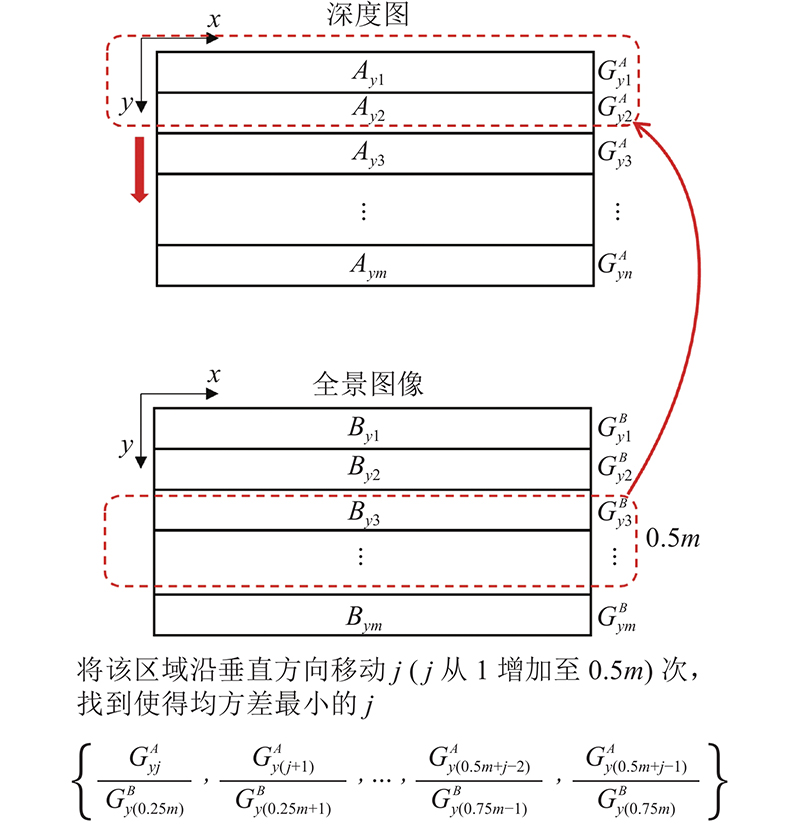

类似的,完全配准的全景影像与2D深度图在垂直方向细分区域的灰度分布同样具有相似性. 如图5所示为基于灰度相似性的垂直配准原理. 将2D深度图沿y方向等间隔的分为m块区域Ay1, Ay2, Ay3

图 5

图 5 基于灰度相似性的垂直配准原理

Fig.5 Principle of vertical registration based on gray similarity

本研究所采用激光雷达的垂直扫描角度范围为60°(−30°~30°),工业相机的垂直成像角度范围为120°(−60°~60°),当两者完全配准时,2D深度图和全景影像在中心区域附近的比例

当激光雷达与工业相机同时进行数据采集时,激光雷达所生成的2D深度图与工业相机所生成的全景影像图的视域范围比为1∶2,即2D深度图约占据全景影像图中50%的区域. 因此,在全景影像中心区域沿y方向上、下各取0.25m块区域共计0.5m片区域,则该片区域的起点和终点分别为

2. 实验效果及评价

图 6

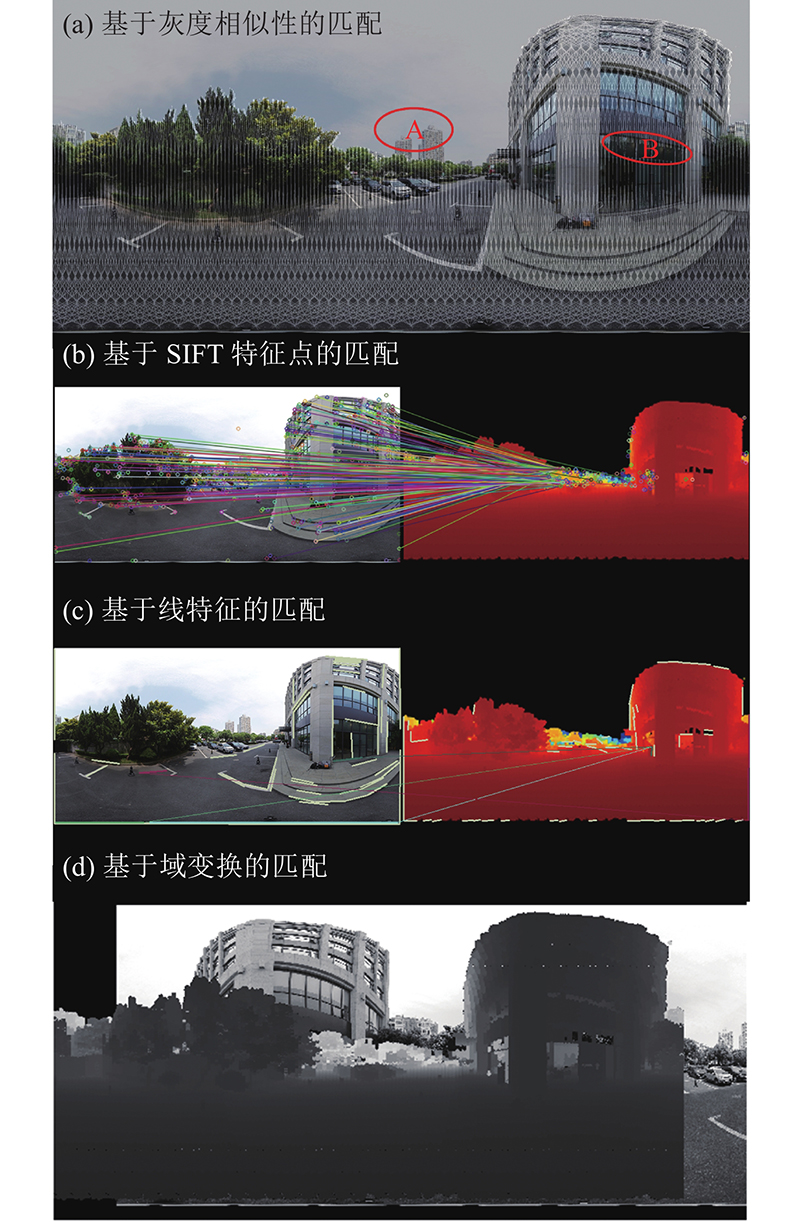

图 6 基于灰度相似性、点线特征和域变换的配准效果对比图

Fig.6 Comparison of registration effect based on gray similarity, point or line features and domain transformation

在图6(a)中存在有A和B这2块未重叠区域. 在A区,由于3D激光雷达的测量距离有限,无法获取全景影像中远景高楼的几何结构信息,导致2D深度图和全景影像在该区域的灰度分布不一致. 在B区,3D激光雷达所发射的红外光会穿透类似玻璃的透明物体,无法获取透明物体的深度信息,而全景影像中透明物体在不同光照下颜色不同,导致2D深度图和全景影像在该区域的灰度分布不一致. 从配准效果来看,即使在场景中存在透明物体和远景,导致2D深度图和全景影像在部分区域出现灰度分布不一致的情况,本研究所提算法仍然能够较好地实现配准. 如图6(b)、(c)所示为分别采用基于SIFT点特征和线特征的匹配. 点线特征提取匹配算法是根据图像像素灰度值与周围像素灰度值的差异性进行特征选取与匹配的,主要用于彩色图片中特征的提取和匹配[19]. 深度信息是几何结构信息,同一深度区域的像素灰度值变化较小,不具有彩色图像像素灰度值变化多样的特点,因此,无论是点特征还是线特征,在深度图中所提取的点线特征大都集中在轮廓区域. 因此,如图6(b)、(c)所示,在将深度图与彩色图进行点线特征匹配时,出现了大量的误匹配,即使采用RANSAC筛选错误匹配,2种异源数据的点线特征匹配误差仍然较大,无法找到正确的异构同名点对及线对以实现有效配准. 基于域变换的图片配准方法,只能计算2幅图片自身相对位置的旋转缩放平移变化,对图片内容的旋转平移变化没有较好的适应性[20]. 如图6(d)所示,使用域变换中的傅里叶梅林变换对2D深度图与全景影像进行配准,会产生较大误差,无法实现有效配准.

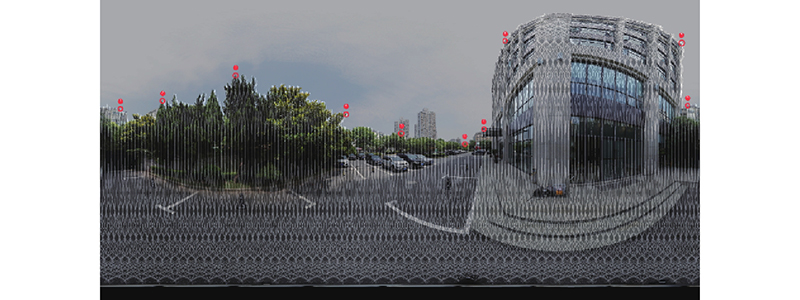

为了定量分析本研究所提算法的配准精度,如图7所示,在全景影像与2D深度图上选择10对同名点对,计算同名点对之间像素差值的绝对值,并取差值平均值作为配准精度的衡量指标. 所选取的同名点均为在环境中具有显著特征的边缘点或轮廓点,且同名点在2D深度图和全景影像中都能够明显体现.

图 7

如表1所示为10对人工标记点对的配准误差统计表. 表中,e、eX、eY、ep分别为误差、X误差、Y误差、平面误差. 可以看出,使用本研究所提方法的平均配准误差为2个像素.

表 1 配准误差统计

Tab.1

| 点号 | 激光点云平面 像素点坐标 | 全景影像像 素点坐标 | e/像素 | ||||||

| X | Y | X | Y | eX | eY | ep | |||

| 1 | 123 | 648 | 122 | 650 | 1 | 2 | 2.23 | ||

| 2 | 1474 | 680 | 1475 | 681 | 1 | 1 | 1.41 | ||

| 3 | 1568 | 755 | 1567 | 757 | 1 | 2 | 2.23 | ||

| 4 | 1748 | 804 | 1749 | 804 | 1 | 0 | 1.00 | ||

| 5 | 2390 | 335 | 2390 | 333 | 0 | 2 | 2.00 | ||

| 6 | 1506 | 779 | 1505 | 780 | 1 | 1 | 1.41 | ||

| 7 | 42 | 623 | 39 | 620 | 3 | 3 | 4.24 | ||

| 8 | 817 | 440 | 815 | 443 | 2 | 3 | 3.60 | ||

| 9 | 2492 | 188 | 2492 | 187 | 0 | 1 | 1.00 | ||

| 10 | 2351 | 756 | 2350 | 756 | 1 | 0 | 1.00 | ||

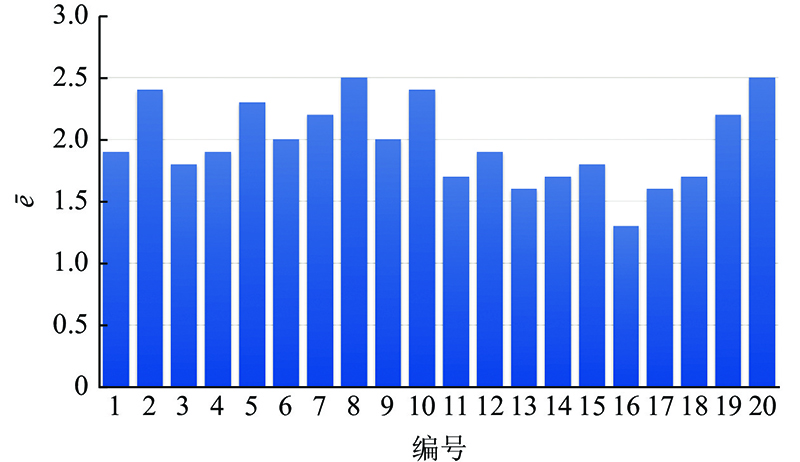

为了验证本研究算法的可靠性并降低人工选取同名点的随机性误差,在街道、楼宇不同场景中采集了20组数据,采用本研究所提出的算法进行配准并使用人工标记同名点的方法进行像素误差计算,结果如图8所示. 图中,

图 8

3. 结 语

本研究提出基于灰度相似性的激光点云与全景影像自动化精细配准方法,能够较好地将激光雷达点云与视觉图像2种异构数据进行高精度配准,实验采用实测数据评估本算法性能并与基于点线特征的配准算法对比,结果表明基于灰度相似性约束的配准算法适应性较好,在存在灰度不一致区域的情况下,仍然可以实现较好的配准效果,配准平均误差为2个像素. 而基于点线特征的配准,由于算法对异构同名点对及线对的匹配误差较大,配准效果不佳. 虽然本研究的2D深度图像与全景图像沿水平方向和垂直方向的配准是分步完成的,但经实验验证,在水平和垂直2个方向同时对2D深度图像与全景图像进行配准时,其配准效果与分步配准的效果完全相同.

由于全景图的灰度代表反射物体颜色的灰度,而2D深度图的灰度代表物体的距离,从匹配角度来看,只能保证有物体,但不能保证灰度一定相同. 如当工业相机在光照不足的场景下进行数据采集或者激光雷达在有玻璃等透明区域较多的场景下进行数据采集时,全景图像和2D深度图会出现灰度分布不一致的区域,所以即使是完全配准的全景图和2D深度图仍存在如图6(a)所示A区和B区这样未匹配的区域. 但在正常光照下的城市场景中,当激光雷达和工业相机对相同的环境进行数据采集且能获取足够多的数据信息时,则可以认为所得到的2D深度图和全景影像图在大部分区域具有相似性,区域的像素灰度分布应具有对应关系. 这种对应关系即意味着2D深度图和全景影像图上具有对应关系的区域,其细分区域的像素灰度值之和的比例是相似的,这亦是本算法有效的主要原因.

本研究所提出的算法适用于各种车载场景,在传感器参数未知、环境结构特征不明显,以及影像数据较少等场景下,仍然可以实现较好的配准效果,能够对城市建模、目标识别、自动驾驶等研究领域的发展起到促进作用. 下一步研究方向将尝试在多传感器融合的SLAM算法中添加本研究所提出的基于灰度相似性的激光点云与全景图像配准方法,实现在线进行自主配准,使得激光雷达点云与视觉图像这2种异构数据能够一一对应,避免人工联合标定所产生的误差,提高多传感器融合的SLAM算法的数据处理性能和鲁棒性.

参考文献

激光点云与光学影像配准: 现状与趋势

[J].

Registration between laser scanning point cloud and optical images: status and trends

[J].

Image alignment and stitching: a tutorial

[J].DOI:10.1561/0600000009 [本文引用: 1]

视觉与激光融合SLAM研究综述

[J].

Survey of SLAM with camera-laser fusion sensor

[J].

Automatic reconstruction of as-built building information models from laser-scanned point clouds: a review of related techniques

[J].DOI:10.1016/j.autcon.2010.06.007 [本文引用: 1]

Validation for 2D/ 3D registration II: the comparison of intensity- and gradient-based merit functions using a new gold standard data set

[J].DOI:10.1118/1.3553403 [本文引用: 1]

激光点云与全景影像配准方法研究

[J].DOI:10.3969/j.issn.1672-4097.2016.01.007 [本文引用: 1]

Research of registration based on panoramic images and laser point cloud

[J].DOI:10.3969/j.issn.1672-4097.2016.01.007 [本文引用: 1]

一种基于线基元的单张影像与点云配准方法

[J].

A registration method of single image and point clouds based on line primitive

[J].

基于线特征的鱼眼图像与地面激光雷达点云配准

[J].

Registration of fisheyes panoramic image and terrestrial LiDAR date based on line feature

[J].

点线特征约束的LiDAR点云与航空影像自动配准

[J].DOI:10.13247/j.cnki.jcumt.001215 [本文引用: 1]

Automatic registration of airborne LiDAR data and aerial images constrained by point and line features

[J].DOI:10.13247/j.cnki.jcumt.001215 [本文引用: 1]

车载全景影像与激光点云数据配准方法研究

[J].

Registration of vehicle-borne panoramic image and LiDAR point cloud

[J].

一种简易的激光雷达点云与光学影像自动配准方法

[J].

A simple automatic registration method for LiDAR point cloud and optical image

[J].

基于罗德里格矩阵的车载激光点云与全景影像配准研究

[J].

Research on registration of vehicle-borne laser point clouds and panoramic images based on lodrigues matrix transformation

[J].

基于建筑物轮廓的地面激光点云与影像匹配点云配准研究

[J].

Research on registration of terrain laser scanning point cloud and image matching point cloud based on building footprint

[J].

Go-ICP: a globally optimal solution to 3D ICP point- set registration

[J].DOI:10.1109/TPAMI.2015.2513405

车载MMS激光点云与序列全景影像自动配准方法

[J].DOI:10.11947/j.AGCS.2018.20170520 [本文引用: 1]

Automatic registration of vehicle-borne mobile mapping laser point cloud and sequent panoramas

[J].DOI:10.11947/j.AGCS.2018.20170520 [本文引用: 1]

面向全景拼接的图像配准技术研究及应用

[J].DOI:10.3969/j.issn.1007-130X.2016.02.018 [本文引用: 1]

Research and application of image registration technology in panoramic stitching

[J].DOI:10.3969/j.issn.1007-130X.2016.02.018 [本文引用: 1]

3D-LIDAR based object detection and tracking on the edge of IoT for railway level crossing

[J].

Classification of image registration techniques and algorithms in digital image processing: a research survey

[J].

LSD: a fast line segment detector with a false detection control

[J].DOI:10.1109/TPAMI.2008.300 [本文引用: 1]