[1]

HOU Y, LIU Z, ZHANG T, et al C-unet: complement unet for remote sensing road extraction

[J]. Sensors , 2021 , 21 (6 ): 2153

DOI:10.3390/s21062153

[本文引用: 2]

[2]

GUNAWAN A, ARIFIANY I, IRWANSYAH E Semantic segmentation of aerial imagery for road and building extraction with deep learning

[J]. ICIC Express Letters , 2020 , 14 (1 ): 43 - 52

[本文引用: 1]

[3]

CHENG G, WANG Y, XU S, et al Automatic road detection and centerline extraction via cascaded end-to-end convolutional neural network

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2017 , 55 (6 ): 3322 - 3337

DOI:10.1109/TGRS.2017.2669341

[本文引用: 1]

[4]

杨栋杰, 高贤君, 冉树浩, 等 基于多重多尺度融合注意力网络的建筑物提取

[J]. 浙江大学学报: 工学版 , 2022 , 56 (10 ): 1924 - 1934

[本文引用: 1]

YANG Dongjie, GAO Xianjun, RAN Shuhao, et al Building extraction based on multiple multiscale-feature fusion attention network

[J]. Journal of Zhejiang University: Engineering Science , 2022 , 56 (10 ): 1924 - 1934

[本文引用: 1]

[5]

SHI W, MIAO Z, DEBAYLE J An integrated method for urban main-road centerline extraction from optical remotely sensed imagery

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2014 , 52 (6 ): 3359 - 3372

DOI:10.1109/TGRS.2013.2272593

[本文引用: 1]

[6]

王小娟, 李云伍, 刘得雄, 等 基于机器视觉的丘陵山区田间道路虚拟中线提取方法

[J]. 西南大学学报:自然科学版 , 2018 , 40 (4 ): 162 - 169

[本文引用: 1]

WANG Xiaojuan, LI Yunwu, LIU Dexiong, et al A machine vision-based method for detecting virtual midline of field roads in the hilly areas

[J]. Journal of Southwest University: Natural Science , 2018 , 40 (4 ): 162 - 169

[本文引用: 1]

[7]

CHANG D, WANG Q, YANG J, et al Research on road extraction method based on sustainable development goals Satellite-1 nighttime light data

[J]. Remote Sensing , 2022 , 14 (23 ): 6015

DOI:10.3390/rs14236015

[本文引用: 1]

[8]

王勇, 曾祥强 集成注意力机制和扩张卷积的道路提取模型

[J]. 中国图象图形学报 , 2022 , 27 (10 ): 3102 - 3115

[本文引用: 1]

WANG Yong, ZENG Xiangqiang Road extraction model derived from integrated attention mechanism and dilated convolution

[J]. Journal of Image and Graphics , 2022 , 27 (10 ): 3102 - 3115

[本文引用: 1]

[9]

张永宏, 何静, 阚希, 等 遥感图像道路提取方法综述

[J]. 计算机工程与应用 , 2018 , 54 (13 ): 1 - 10

[本文引用: 1]

ZHANG Yonghong, HE Jing, KAN Xi, et al Summary of road extraction methods for remote sensing images

[J]. Computer Engineering and Applications , 2018 , 54 (13 ): 1 - 10

[本文引用: 1]

[10]

MNIH V, HINTON G E. Learning to detect roads in high-resolution aerial images [C]// Proceedings of European Conference on Computer Vision . Berlin: Springer, 2010: 210-223.

[本文引用: 1]

[11]

ZHONG Z, LI J, CUI W, et al. Fully convolutional networks for building and road extraction: preliminary results [C]// Proceedings of Geoscience and Remote Sensing Symposium . Beijing: IEEE, 2016: 1591-1594.

[本文引用: 2]

[12]

WANG F, JIANG M J, QIAN C, et al. Residual attention network for image classification [C]// IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 6450-6458.

[本文引用: 1]

[13]

LI P, ZHANG Y, WANG C, et al. Road network extraction via deep learning and line integral convolution [C]// Proceedings of 2016 IEEE International Geoscience and Remote Sensing Symposium . Bejing: IEEE, 2016: 1599-1602.

[本文引用: 2]

[14]

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs [EB/OL]. (2014-12-22)[2023-04-13]. https://arxiv.org/abs/1412.7062.

[本文引用: 1]

[15]

CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation [R/OL]. (2017-12-05)[2023-04-13]. https://arxiv.org/abs/1706.05587.

[16]

CHEN L C, PAPANDREOU G, KOKKINOS I, et al DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2018 , 40 (4 ): 834 - 848

DOI:10.1109/TPAMI.2017.2699184

[17]

CHEN L C, ZHU Y, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation [C]// Proceedings of the European Conference on Computer Vision . Cham: Springer, 2018: 801-818.

[本文引用: 3]

[18]

CHOLLET F. Xception: deep learning with depth wiseseparable convolutions [C]// Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 1800-1807.

[本文引用: 1]

[19]

徐胜军, 邓博文, 史亚, 等 一种编解码结构的车牌图像超分辨率网络

[J]. 西安交通大学学报 , 2022 , 56 (10 ): 101 - 110

[本文引用: 1]

XU Shengjun, DENG Bowen, SHI Ya, et al An encoder-decoder based super resolution network for license plate images

[J]. Journal of Xi'an Jiaotong University , 2022 , 56 (10 ): 101 - 110

[本文引用: 1]

[20]

赵凌虎, 袁希平, 甘淑, 等 改进Deeplabv3 +的高分辨率遥感影像道路提取模型

[J]. 自然资源遥感 , 2023 , 35 (1 ): 107 - 114

[本文引用: 1]

ZHAO Linghu, YUAN Xiping, GAN Shu, et al Road extraction in high resolution remote sensing images based on improved Deeplabv3+model

[J]. Remote Sensing for Natural Resource , 2023 , 35 (1 ): 107 - 114

[本文引用: 1]

[21]

葛小三, 曹伟 一种改进DeepLabV3+网络的高分辨率遥感影像道路提取方法

[J]. 遥感信息 , 2022 , 37 (1 ): 40 - 46

[本文引用: 1]

GE Xiaosan, CAO Wei A road extraction method for high resolution remote sensing imagery based on improved DeepLabV3+ model

[J]. Remote Sensing Information , 2022 , 37 (1 ): 40 - 46

[本文引用: 1]

[22]

孟庆宽, 杨晓霞, 张漫, 等 基于语义分割的非结构化田间道路场景识别

[J]. 农业工程学报 , 2021 , 37 (22 ): 152 - 160

[本文引用: 1]

MENG Qingkuan, YANG Xiaoxia, ZHANG Man, et al Recognition of unstructured field road scene based on semantic segmentation mode

[J]. Transactions of the Chinese Society of Agricultural Engineering , 2021 , 37 (22 ): 152 - 160

[本文引用: 1]

[23]

王振, 杨珺, 邓佳莉, 等 多尺度特征自适应融合的图像语义分割算法

[J]. 小型微型计算机系统 , 2022 , 43 (4 ): 834 - 840

[本文引用: 1]

WANG Zhen, YANG Jun, DENG Jiali, et al Image semantic segmentation algorithm based on adaptive fusion of multi-scale features

[J]. Journal of Chinese Computer Systems , 2022 , 43 (4 ): 834 - 840

[本文引用: 1]

[24]

张文博, 瞿珏, 王崴, 等 融合多尺度特征的改进Deeplab v3+图像语义分割算法

[J]. 电光与控制 , 2022 , 29 (11 ): 12 - 16

[本文引用: 1]

ZANG Wenbo, QU Jue, WANG Wei, et al An improved Deeplab v3+ image semantic segmentation algorithm incorporating multi-scale features

[J]. Electronics Optics and Control , 2022 , 29 (11 ): 12 - 16

[本文引用: 1]

[25]

张小国, 丁立早, 刘亚飞, 等 基于双注意力模块的FDA-DeepLab语义分割网络

[J]. 东南大学学报:自然科学版 , 2022 , 52 (6 ): 1145 - 1151

[本文引用: 2]

ZHANG Xiaoguo, DING Lizao, LIU Yafei, et al FDA-DeepLab semantic segmentation network based on dual attention module

[J]. Journal of Southeast University: Natural Science , 2022 , 52 (6 ): 1145 - 1151

[本文引用: 2]

[26]

许泽宇, 沈占锋, 李杨, 等 增强型DeepLab算法和自适应损失函数的高分辨率遥感影像分类

[J]. 遥感学报 , 2022 , 26 (2 ): 406 - 415

[本文引用: 2]

XU Zeyu, SHEN Zhanfeng, LI Yang, et al Enhanced DeepLab algorithm and adaptive loss function for high-resolution remote sensing image classification

[J]. Journal of Remote Sensing , 2022 , 26 (2 ): 406 - 415

[本文引用: 2]

[27]

SANDLER M, HOWARD A, ZHU M, et al. MobileNetV2: inverted residuals and linear bottlenecks [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 4510-4520.

[本文引用: 1]

[28]

QIN Y Y, CAO J T, JI X F Fire detection method based on depthwise separable convolution and YOLOv3

[J]. International Journal of Automation and Computing , 2021 , 18 (2 ): 300 - 310

DOI:10.1007/s11633-020-1269-5

[本文引用: 1]

[29]

LIU Y C, SHAO Z R, TENG Y Y, et al. NAM: normalization-based attention module [EB/OL]. (2021-11-24)[2023-04-23]. http://arxiv.org/abs/2111.12419.

[本文引用: 1]

[30]

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module [C]// Proceedings of the European Conference on Computer Vision . Munich: [s. n. ], 2018: 3-19.

[本文引用: 1]

[31]

HU J, SHEN L, SUN G. Squeeze-and-excitation networks [C]// Proceedings of Computer Vision and Pattern Recognition . [S. l. ]: IEEE, 2018: 7132-7141.

[本文引用: 1]

C-unet: complement unet for remote sensing road extraction

2

2021

... 随着卫星遥感技术的迅速发展,高分辨率遥感图像的应用日益广泛. 从遥感图像中提取出的道路信息可被应用于车辆导航、智慧交通[1 ] 、应急救援、城市规划[2 ] 、图像注册、地理信息更新[3 ] 等领域. 近年来,遥感图像道路信息的提取逐渐成为研究热点. ...

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

Semantic segmentation of aerial imagery for road and building extraction with deep learning

1

2020

... 随着卫星遥感技术的迅速发展,高分辨率遥感图像的应用日益广泛. 从遥感图像中提取出的道路信息可被应用于车辆导航、智慧交通[1 ] 、应急救援、城市规划[2 ] 、图像注册、地理信息更新[3 ] 等领域. 近年来,遥感图像道路信息的提取逐渐成为研究热点. ...

Automatic road detection and centerline extraction via cascaded end-to-end convolutional neural network

1

2017

... 随着卫星遥感技术的迅速发展,高分辨率遥感图像的应用日益广泛. 从遥感图像中提取出的道路信息可被应用于车辆导航、智慧交通[1 ] 、应急救援、城市规划[2 ] 、图像注册、地理信息更新[3 ] 等领域. 近年来,遥感图像道路信息的提取逐渐成为研究热点. ...

基于多重多尺度融合注意力网络的建筑物提取

1

2022

... 常见的道路提取方法分为传统方法和基于深度学习的提取方法[4 ] . 传统方法需要人工设计道路特征提取方案. Shi等[5 ] 通过分析光谱特征,实现从光学遥感图像中提取道路中心线,但结果存在噪声问题. 王小娟等[6 ] 利用二维Otsu阈值分割法提取道路特征,对质心点进行拟合操作,得到道路图像. Chang等[7 ] 提出BO-MWSA算法,通过改进分水岭分割算法,引入波段运算和标记法,利用NTL图像实现道路提取. 上述传统提取方法设计分类规则的过程较复杂,道路提取效率低下,同时泛化能力较差,存在普遍的误分类现象,导致分割精度较低. ...

基于多重多尺度融合注意力网络的建筑物提取

1

2022

... 常见的道路提取方法分为传统方法和基于深度学习的提取方法[4 ] . 传统方法需要人工设计道路特征提取方案. Shi等[5 ] 通过分析光谱特征,实现从光学遥感图像中提取道路中心线,但结果存在噪声问题. 王小娟等[6 ] 利用二维Otsu阈值分割法提取道路特征,对质心点进行拟合操作,得到道路图像. Chang等[7 ] 提出BO-MWSA算法,通过改进分水岭分割算法,引入波段运算和标记法,利用NTL图像实现道路提取. 上述传统提取方法设计分类规则的过程较复杂,道路提取效率低下,同时泛化能力较差,存在普遍的误分类现象,导致分割精度较低. ...

An integrated method for urban main-road centerline extraction from optical remotely sensed imagery

1

2014

... 常见的道路提取方法分为传统方法和基于深度学习的提取方法[4 ] . 传统方法需要人工设计道路特征提取方案. Shi等[5 ] 通过分析光谱特征,实现从光学遥感图像中提取道路中心线,但结果存在噪声问题. 王小娟等[6 ] 利用二维Otsu阈值分割法提取道路特征,对质心点进行拟合操作,得到道路图像. Chang等[7 ] 提出BO-MWSA算法,通过改进分水岭分割算法,引入波段运算和标记法,利用NTL图像实现道路提取. 上述传统提取方法设计分类规则的过程较复杂,道路提取效率低下,同时泛化能力较差,存在普遍的误分类现象,导致分割精度较低. ...

基于机器视觉的丘陵山区田间道路虚拟中线提取方法

1

2018

... 常见的道路提取方法分为传统方法和基于深度学习的提取方法[4 ] . 传统方法需要人工设计道路特征提取方案. Shi等[5 ] 通过分析光谱特征,实现从光学遥感图像中提取道路中心线,但结果存在噪声问题. 王小娟等[6 ] 利用二维Otsu阈值分割法提取道路特征,对质心点进行拟合操作,得到道路图像. Chang等[7 ] 提出BO-MWSA算法,通过改进分水岭分割算法,引入波段运算和标记法,利用NTL图像实现道路提取. 上述传统提取方法设计分类规则的过程较复杂,道路提取效率低下,同时泛化能力较差,存在普遍的误分类现象,导致分割精度较低. ...

基于机器视觉的丘陵山区田间道路虚拟中线提取方法

1

2018

... 常见的道路提取方法分为传统方法和基于深度学习的提取方法[4 ] . 传统方法需要人工设计道路特征提取方案. Shi等[5 ] 通过分析光谱特征,实现从光学遥感图像中提取道路中心线,但结果存在噪声问题. 王小娟等[6 ] 利用二维Otsu阈值分割法提取道路特征,对质心点进行拟合操作,得到道路图像. Chang等[7 ] 提出BO-MWSA算法,通过改进分水岭分割算法,引入波段运算和标记法,利用NTL图像实现道路提取. 上述传统提取方法设计分类规则的过程较复杂,道路提取效率低下,同时泛化能力较差,存在普遍的误分类现象,导致分割精度较低. ...

Research on road extraction method based on sustainable development goals Satellite-1 nighttime light data

1

2022

... 常见的道路提取方法分为传统方法和基于深度学习的提取方法[4 ] . 传统方法需要人工设计道路特征提取方案. Shi等[5 ] 通过分析光谱特征,实现从光学遥感图像中提取道路中心线,但结果存在噪声问题. 王小娟等[6 ] 利用二维Otsu阈值分割法提取道路特征,对质心点进行拟合操作,得到道路图像. Chang等[7 ] 提出BO-MWSA算法,通过改进分水岭分割算法,引入波段运算和标记法,利用NTL图像实现道路提取. 上述传统提取方法设计分类规则的过程较复杂,道路提取效率低下,同时泛化能力较差,存在普遍的误分类现象,导致分割精度较低. ...

集成注意力机制和扩张卷积的道路提取模型

1

2022

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

集成注意力机制和扩张卷积的道路提取模型

1

2022

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

遥感图像道路提取方法综述

1

2018

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

遥感图像道路提取方法综述

1

2018

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

1

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

2

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

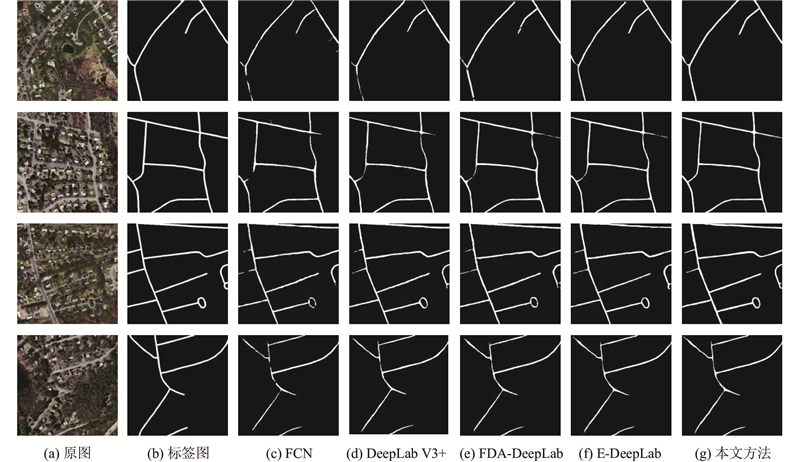

... 为了进一步验证MFL-DeepLab V3+模型的道路提取性能,将该模型与FCN[11 ] 、DeepLab V3+[17 ] 、FDA-DeepLab[25 ] 及E-DeepLab[26 ] 4种网络模型的精确率、召回率和F1进行对比. 以上网络模型均使用统一的环境配置和Massachusetts road数据集进行训练和测试. 不同模型的道路提取结果对比如图9 所示. 根据提取细节可知,各模型在提取道路交界和细小路段方面的表现存在显著差异. FCN网络的提取效果较差,道路边缘存在信息缺失,道路图像出现大量断裂区域,这些问题导致分割结果与真实道路标签之间存在明显的差异. DeepLab V3+网络在局部出现错漏提取的现象,在树木和阴影遮挡状况下的提取结果明显地不连续. FDA-DeepLab和E-DeepLab模型的道路提取效果相较于DeepLab V3+有所提升,但对细小道路和道路交界区域的提取效果不佳,道路局部有断裂现象,道路边缘分割的精确度有待提高. MFL-DeepLab V3+模型的提取效果优于上述4种模型,成功提取到细小狭窄的路段,错漏提取现象得到改善,有效避免了树木与阴影遮挡对道路提取的影响. ...

1

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

2

... 基于深度学习的道路提取方法利用语义分割模型训练遥感图像数据集,利用得到的参数模型提取道路信息,具有更加卓越的特征提取能力[8 ] ,适用于从海量数据中挖掘抽象复杂的深层特征并完成数据的分析与处理[9 ] . Mnih等[10 ] 提出用卷积神经网络CNN提取遥感图像道路信息,采用条件随机场优化分割结果. Zhong等[11 ] 将实现图像像素级别分类的全卷积神经网络FCN用于道路提取,然而FCN网络预测时仅考虑单个像素,忽略了像素之间的关系,造成预测结果细节缺失的现象. Hou等[1 ] 构建基于互补的神经网络C-unet模型,用于道路提取. Wang等[12 ] 结合残差单元和U-Net模型,实验部分选用遥感图像数据集Massachusetts roads[13 ] 训练网络,但仍出现细小路段漏提的现象. ...

... 实验使用的遥感影像道路数据来自于Massachusetts roads数据集[13 ] . 该数据集涵盖美国马萨诸塞州多种地区(如城市、农村和山区等)共1 108张卫星遥感影像,覆盖地理范围超过2 600 km2 ,每张图片及对应的标签图像均为1 500像素×1 500像素. 由于其标签影像存在数据缺失和标注不准确的问题,从Massachusetts roads数据集中选取标签标注较准确的300组图像作为训练样本. 将道路图像及对应的标签图像尺寸裁剪为406像素×406像素. 按7∶2∶1的比例分配实验所需的训练集、测试集和验证集. 由于数据样本过少将导致网络模型的鲁棒性较差,需要扩充数据,将训练集中剪裁后的图像通过旋转、水平或垂直翻转操作,最终数据增强后训练样本扩充至11 340张. ...

1

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs

0

2018

3

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

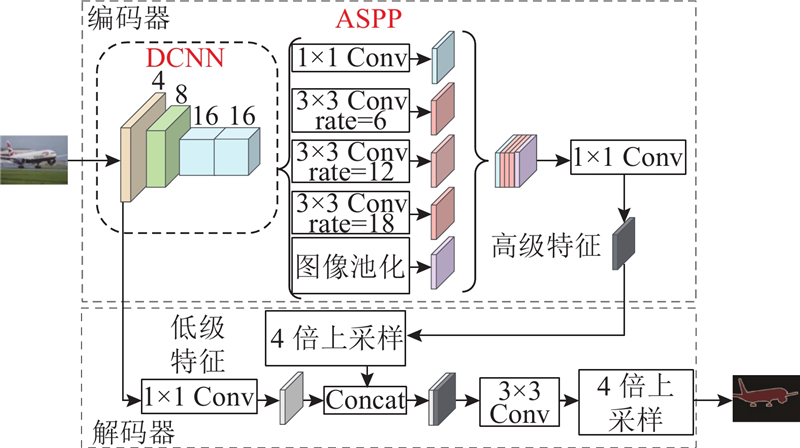

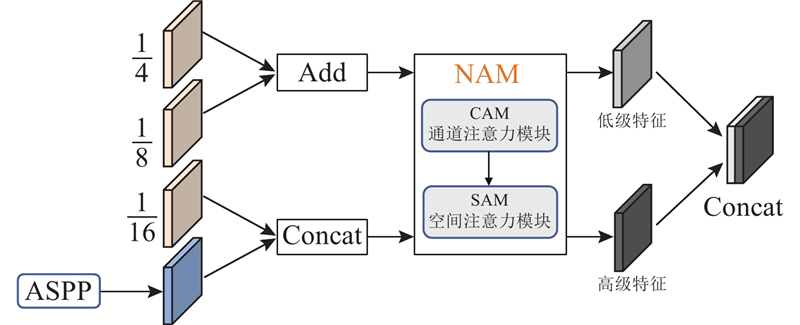

... DeepLab V3+[17 ] 基于全卷积网络,采用编码器-解码器架构,融合多尺度特征和多分支并行结构,网络结构如图1 所示. ...

... 为了进一步验证MFL-DeepLab V3+模型的道路提取性能,将该模型与FCN[11 ] 、DeepLab V3+[17 ] 、FDA-DeepLab[25 ] 及E-DeepLab[26 ] 4种网络模型的精确率、召回率和F1进行对比. 以上网络模型均使用统一的环境配置和Massachusetts road数据集进行训练和测试. 不同模型的道路提取结果对比如图9 所示. 根据提取细节可知,各模型在提取道路交界和细小路段方面的表现存在显著差异. FCN网络的提取效果较差,道路边缘存在信息缺失,道路图像出现大量断裂区域,这些问题导致分割结果与真实道路标签之间存在明显的差异. DeepLab V3+网络在局部出现错漏提取的现象,在树木和阴影遮挡状况下的提取结果明显地不连续. FDA-DeepLab和E-DeepLab模型的道路提取效果相较于DeepLab V3+有所提升,但对细小道路和道路交界区域的提取效果不佳,道路局部有断裂现象,道路边缘分割的精确度有待提高. MFL-DeepLab V3+模型的提取效果优于上述4种模型,成功提取到细小狭窄的路段,错漏提取现象得到改善,有效避免了树木与阴影遮挡对道路提取的影响. ...

1

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

一种编解码结构的车牌图像超分辨率网络

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

一种编解码结构的车牌图像超分辨率网络

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

改进Deeplabv3 +的高分辨率遥感影像道路提取模型

1

2023

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

改进Deeplabv3 +的高分辨率遥感影像道路提取模型

1

2023

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

一种改进DeepLabV3+网络的高分辨率遥感影像道路提取方法

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

一种改进DeepLabV3+网络的高分辨率遥感影像道路提取方法

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

基于语义分割的非结构化田间道路场景识别

1

2021

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

基于语义分割的非结构化田间道路场景识别

1

2021

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

多尺度特征自适应融合的图像语义分割算法

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

多尺度特征自适应融合的图像语义分割算法

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

融合多尺度特征的改进Deeplab v3+图像语义分割算法

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

融合多尺度特征的改进Deeplab v3+图像语义分割算法

1

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

基于双注意力模块的FDA-DeepLab语义分割网络

2

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

... 为了进一步验证MFL-DeepLab V3+模型的道路提取性能,将该模型与FCN[11 ] 、DeepLab V3+[17 ] 、FDA-DeepLab[25 ] 及E-DeepLab[26 ] 4种网络模型的精确率、召回率和F1进行对比. 以上网络模型均使用统一的环境配置和Massachusetts road数据集进行训练和测试. 不同模型的道路提取结果对比如图9 所示. 根据提取细节可知,各模型在提取道路交界和细小路段方面的表现存在显著差异. FCN网络的提取效果较差,道路边缘存在信息缺失,道路图像出现大量断裂区域,这些问题导致分割结果与真实道路标签之间存在明显的差异. DeepLab V3+网络在局部出现错漏提取的现象,在树木和阴影遮挡状况下的提取结果明显地不连续. FDA-DeepLab和E-DeepLab模型的道路提取效果相较于DeepLab V3+有所提升,但对细小道路和道路交界区域的提取效果不佳,道路局部有断裂现象,道路边缘分割的精确度有待提高. MFL-DeepLab V3+模型的提取效果优于上述4种模型,成功提取到细小狭窄的路段,错漏提取现象得到改善,有效避免了树木与阴影遮挡对道路提取的影响. ...

基于双注意力模块的FDA-DeepLab语义分割网络

2

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

... 为了进一步验证MFL-DeepLab V3+模型的道路提取性能,将该模型与FCN[11 ] 、DeepLab V3+[17 ] 、FDA-DeepLab[25 ] 及E-DeepLab[26 ] 4种网络模型的精确率、召回率和F1进行对比. 以上网络模型均使用统一的环境配置和Massachusetts road数据集进行训练和测试. 不同模型的道路提取结果对比如图9 所示. 根据提取细节可知,各模型在提取道路交界和细小路段方面的表现存在显著差异. FCN网络的提取效果较差,道路边缘存在信息缺失,道路图像出现大量断裂区域,这些问题导致分割结果与真实道路标签之间存在明显的差异. DeepLab V3+网络在局部出现错漏提取的现象,在树木和阴影遮挡状况下的提取结果明显地不连续. FDA-DeepLab和E-DeepLab模型的道路提取效果相较于DeepLab V3+有所提升,但对细小道路和道路交界区域的提取效果不佳,道路局部有断裂现象,道路边缘分割的精确度有待提高. MFL-DeepLab V3+模型的提取效果优于上述4种模型,成功提取到细小狭窄的路段,错漏提取现象得到改善,有效避免了树木与阴影遮挡对道路提取的影响. ...

增强型DeepLab算法和自适应损失函数的高分辨率遥感影像分类

2

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

... 为了进一步验证MFL-DeepLab V3+模型的道路提取性能,将该模型与FCN[11 ] 、DeepLab V3+[17 ] 、FDA-DeepLab[25 ] 及E-DeepLab[26 ] 4种网络模型的精确率、召回率和F1进行对比. 以上网络模型均使用统一的环境配置和Massachusetts road数据集进行训练和测试. 不同模型的道路提取结果对比如图9 所示. 根据提取细节可知,各模型在提取道路交界和细小路段方面的表现存在显著差异. FCN网络的提取效果较差,道路边缘存在信息缺失,道路图像出现大量断裂区域,这些问题导致分割结果与真实道路标签之间存在明显的差异. DeepLab V3+网络在局部出现错漏提取的现象,在树木和阴影遮挡状况下的提取结果明显地不连续. FDA-DeepLab和E-DeepLab模型的道路提取效果相较于DeepLab V3+有所提升,但对细小道路和道路交界区域的提取效果不佳,道路局部有断裂现象,道路边缘分割的精确度有待提高. MFL-DeepLab V3+模型的提取效果优于上述4种模型,成功提取到细小狭窄的路段,错漏提取现象得到改善,有效避免了树木与阴影遮挡对道路提取的影响. ...

增强型DeepLab算法和自适应损失函数的高分辨率遥感影像分类

2

2022

... Google团队提出一系列DeepLab模型[14 -17 ] ,其中DeepLab V3+骨干网络采取Xception[18 ] ,通过ASPP模块整合多尺度特征并引入编码-解码[19 ] 结构优化网络,分割性能更具优势. 赵凌虎等[20 ] 基于DeepLab V3+改进主干网络,结合Dice Loss函数[21 ] 提高模型的道路提取精度. 孟庆宽等[22 ] 采用金字塔池化模块,获得多尺度道路信息特征. 基于注意力机制和多尺度特征融合的遥感图像分割网络取得了一系列研究成果[23 ] . 张文博等[24 ] 提出改进DeepLab V3+模型,在主干网络引入多尺度金字塔卷积融合多尺度特征,在解码层引入注意力机制优化分割边缘信息. 张小国等[25 ] 提出FDA- DeepLab模型,引入双注意力机制,融合高级和低级特征,使用样本难度权重调节因子解决样本的非均衡性问题. 许泽宇等[26 ] 提出的E-DeepLab模型通过加成连接的方式将编码器与解码器结合,提出改进的自适应调节损失权重方法. 利用上述模型虽然提高了分割精度,但网络结构较复杂,参数规模较大,对于分割种类较少的道路提取任务不占优势. ...

... 为了进一步验证MFL-DeepLab V3+模型的道路提取性能,将该模型与FCN[11 ] 、DeepLab V3+[17 ] 、FDA-DeepLab[25 ] 及E-DeepLab[26 ] 4种网络模型的精确率、召回率和F1进行对比. 以上网络模型均使用统一的环境配置和Massachusetts road数据集进行训练和测试. 不同模型的道路提取结果对比如图9 所示. 根据提取细节可知,各模型在提取道路交界和细小路段方面的表现存在显著差异. FCN网络的提取效果较差,道路边缘存在信息缺失,道路图像出现大量断裂区域,这些问题导致分割结果与真实道路标签之间存在明显的差异. DeepLab V3+网络在局部出现错漏提取的现象,在树木和阴影遮挡状况下的提取结果明显地不连续. FDA-DeepLab和E-DeepLab模型的道路提取效果相较于DeepLab V3+有所提升,但对细小道路和道路交界区域的提取效果不佳,道路局部有断裂现象,道路边缘分割的精确度有待提高. MFL-DeepLab V3+模型的提取效果优于上述4种模型,成功提取到细小狭窄的路段,错漏提取现象得到改善,有效避免了树木与阴影遮挡对道路提取的影响. ...

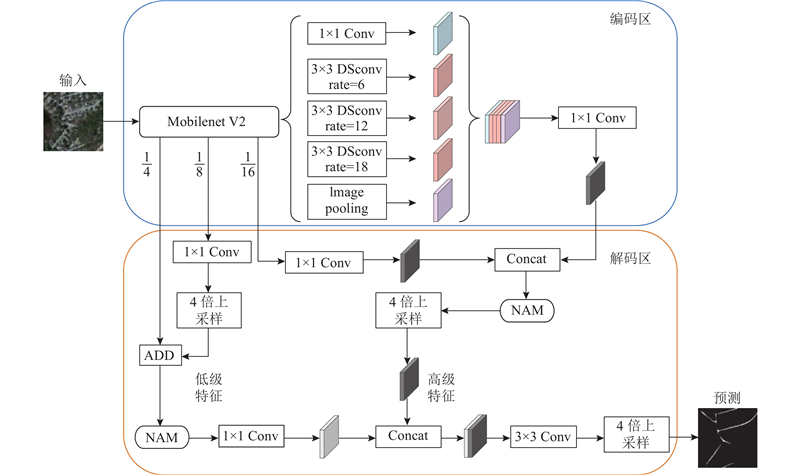

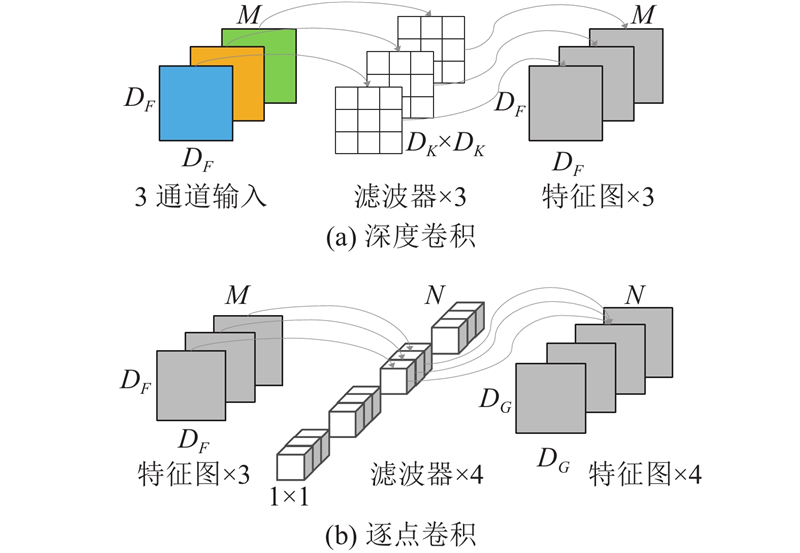

1

... 编码区. 为了解决道路特征提取网络计算复杂度较高的问题,将骨干特征提取网络设计为轻量化的Mobilenet V2[27 ] . 为了使网络精准捕获道路上下文信息,减少网络参数量并提高计算效率,在ASPP模块3个平行的空洞卷积中引入DSConv. ...

Fire detection method based on depthwise separable convolution and YOLOv3

1

2021

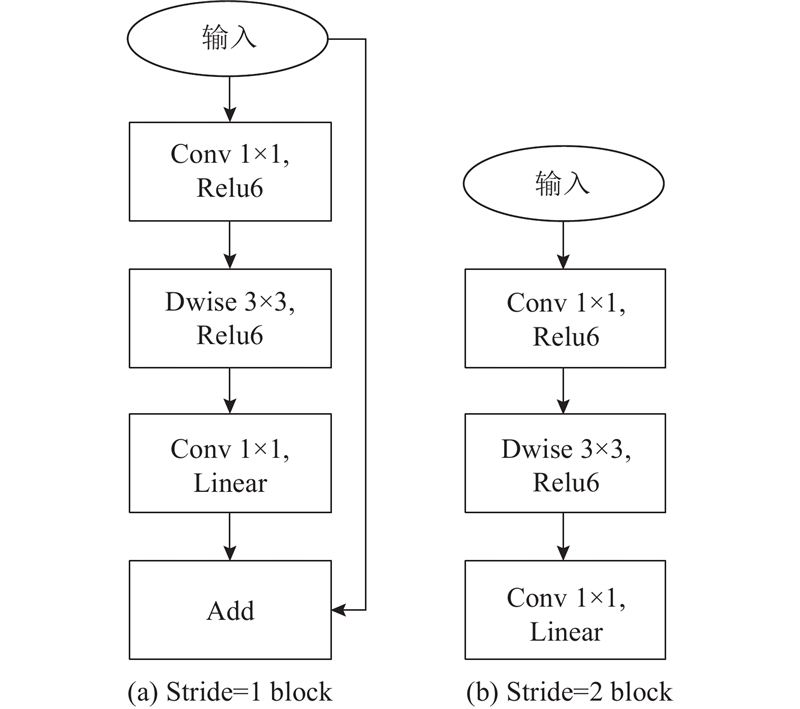

... 由于DeepLab V3+模型的骨干网络Xception参数量较多,将模型应用于遥感图像道路提取领域的总体计算量大且耗时长. 针对上述问题,引入轻量化的Mobilenet V2网络作为MFL-DeepLab V3+的骨干网络. Mobilenet系列网络通过引入深度可分离卷积[28 ] (depthwise separable convolution, DSConv),有效减少了网络的运算量及参数量. 与上一代网络相比,Mobilenet V2网络增加了线性瓶颈结构和倒残差结构. ...

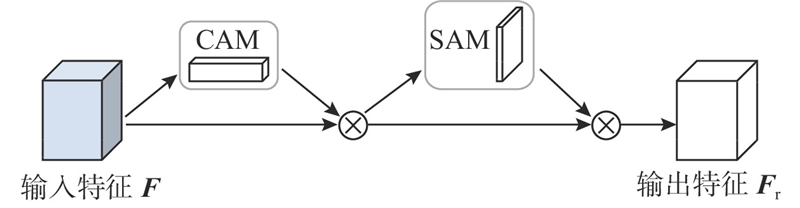

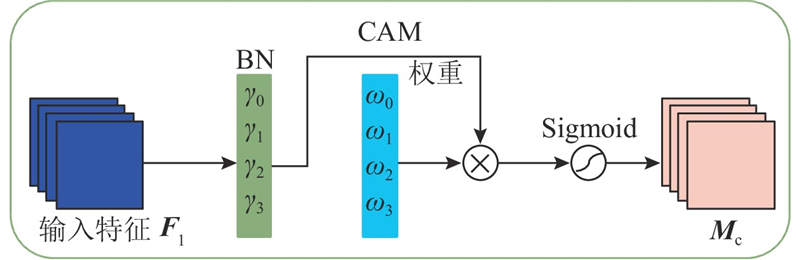

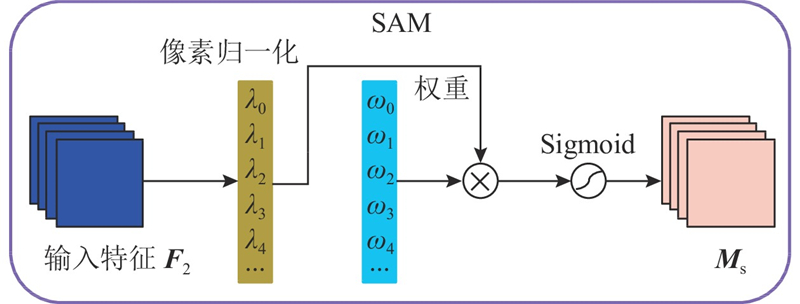

1

... 为了加强网络对遥感图像中道路特征的提取,引入基于归一化的注意力机制[29 ] (normalization-based attention module, NAM),NAM基于CBAM注意力机制[30 ] 重新设计通道和空间子模块. NAM用稀疏的权重惩罚抑制模糊的道路特征,其中批标准化(batch normalization, BN)的比例因子使用标准偏差表示特征权重,具体公式为 ...

1

... 为了加强网络对遥感图像中道路特征的提取,引入基于归一化的注意力机制[29 ] (normalization-based attention module, NAM),NAM基于CBAM注意力机制[30 ] 重新设计通道和空间子模块. NAM用稀疏的权重惩罚抑制模糊的道路特征,其中批标准化(batch normalization, BN)的比例因子使用标准偏差表示特征权重,具体公式为 ...

1

... 相较于常见的ECA、SE[31 ] 、CBAM等注意力机制,NAM注意力机制无需额外的卷积层和全连接层,将NAM同时用于提取网络的深层和浅层特征,可以使模型充分学习道路图像中深层特征与浅层特征的空间相关性,提高模型在遥感图像中的道路提取精度. ...