[1]

CHEN X, YAN B, ZHU J, et al. Transformer tracking[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021: 8122-8131.

[本文引用: 2]

[2]

孙锐, 方林凤, 梁启丽, 等 孪生网络框架下融合显著性和干扰在线学习的航拍目标跟踪算法

[J]. 电子与信息学报 , 2021 , 43 (5 ): 1414 - 1423

DOI:10.11999/JEIT200140

SUN Rui, FANG Lin-feng, LIANG Qi-li, et al Siamese network combined learning saliency and online leaning interference for aerial object tracking algorithm

[J]. Journal of Electronics and Information Technology , 2021 , 43 (5 ): 1414 - 1423

DOI:10.11999/JEIT200140

[3]

王海军, 张圣燕, 杜玉杰 响应和滤波器偏差感知约束的无人机目标跟踪算法

[J]. 浙江大学学报: 工学版 , 2022 , 56 (9 ): 1824 - 1832

WANG Hai-jun, ZHANG Sheng-yan, DU Yu-jie UAV object tracking algorithm based on response and filter deviation-aware regularization

[J]. Journal of Zhejiang University: Engineering Science , 2022 , 56 (9 ): 1824 - 1832

[4]

刘芳, 王洪娟, 黄光伟, 等 基于自适应深度网络的无人机目标跟踪算法

[J]. 航空学报 , 2019 , 40 (3 ): 322332

[本文引用: 1]

LIU Fang, WANG Hong-juan, HUANG Guang-wei, et al UAV target tracking algorithm based on adaptive depth network

[J]. Acta Aeronautica et Astronautica Sinica , 2019 , 40 (3 ): 322332

[本文引用: 1]

[5]

BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters[C]// IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco: IEEE, 2010: 2544-2550.

[本文引用: 1]

[6]

HENRIQUES J F, CASEIRO R, MARTINS P, et al High-speed tracking with kernelized correlation filters

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2015 , 37 (3 ): 583 - 596

DOI:10.1109/TPAMI.2014.2345390

[本文引用: 1]

[7]

HUANG Z, FU C, LI Y, et al. Learning aberrance repressed correlation filters for real-time UAV tracking [C]// IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019: 2891-2900.

[本文引用: 2]

[8]

LI Y, FU C, DING F, et al. Auto track: towards high-performance visual tracking for UAV with automatic spatio-temporal regularization [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 11920-11929.

[本文引用: 2]

[9]

LIN F, FU C, HE Y, et al. BiCF: learning bidirectional incongruity-aware correlation filter for efficient UAV object tracking [C]// IEEE International Conference on Robotics and Automation . Paris: IEEE, 2020: 2365-2371.

[本文引用: 2]

[10]

BERTINETTO L, VALMADRE J, HENRIQUES J, et al. Fully-convolutional siamese networks for object tracking [C]// Computer Vision–ECCV Workshops. Amsterdam: Springer, 2016: 850-865.

[本文引用: 1]

[11]

LI B, YAN J, WU W, et al. High performance visual tracking with siamese region proposal network [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 8971-8980.

[本文引用: 1]

[12]

LI B, WU W, WANG Q, et al. SiamRPN++: evolution of siamese visual tracking with very deep networks [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Long Beach: IEEE, 2019: 4277-4286.

[本文引用: 1]

[13]

XU Y, WANG Z, LI Z, et al. SiamFC++: towards robust and accurate visual tracking with target estimation guidelines [C]// Proceedings of the AAAI Conference on Artificial Intelligence . New York: AAAI, 2020: 12549-12556.

[本文引用: 1]

[14]

WANG Q, WU B, ZHU P, et al. ECA-Net: efficient channel attention for deep convolutional neural networks [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Seattle: IEEE, 2020: 11531-11539.

[本文引用: 1]

[15]

RAHMAN M M, FIAZ M, JUNG S K Efficient visual tracking with stacked channel-spatial attention learning

[J]. IEEE Access , 2020 , 8 : 100857 - 100869

DOI:10.1109/ACCESS.2020.2997917

[本文引用: 1]

[16]

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module [C]// Computer Vision–ECCV . Munich: Springer, 2018: 3-19.

[本文引用: 1]

[17]

FU J, LIU J, LI Y, et al. Dual attention network for scene segmentation [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Long Beach: IEEE, 2019: 3141-3149.

[本文引用: 1]

[18]

LIN T, MAIRE M, BELONGIE S, et al. Microsoft Coco: common objects in context [C]// Computer Vision- ECCV. Zurich: Springer, 2014: 740-755.

[本文引用: 1]

[19]

RUSSAKOVSKY O, DENG J, SU H, et al ImageNet large scale visual recognition challenge

[J]. International Journal of Computer Vision , 2015 , 115 : 211 - 252

DOI:10.1007/s11263-015-0816-y

[本文引用: 1]

[20]

HUANG L, ZHAO X, HUANG K, GOT-10k: a large high-diversity benchmark for generic object tracking in the wild [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2021, 43(5): 1562-1577.

[本文引用: 1]

[21]

REAL E, SHLENS J, MAZZOCCHI S, et al. Youtube -bounding boxes: a large high-precision human-annotated data set for object detection in video [C]// IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 7464-7473.

[本文引用: 1]

[22]

MUELLER M, SMITH N, GHANEM B, et al. A benchmark and simulator for UAV tracking [C]// Computer Vision–ECCV . Amsterdam: Springer, 2016: 445-461.

[本文引用: 2]

[23]

LI, S, YEUNG D. Visual object tracking for unmanned aerial vehicles: a benchmark and new motion models [C]// Proceedings of the AAAI Conference on Artificial Intelligence . San Francisco: AAAI, 2017: 4140-4146.

[本文引用: 1]

[24]

FU C, CAO Z, LI Y, et al. Siamese anchor proposal network for high-speed aerial tracking [C]// IEEE International Conference on Robotics and Automation . Xi’an: IEEE, 2021: 510-516.

[本文引用: 1]

[25]

DANELLJAN M, BHAT G, KHAN F S, et al. ECO: efficient convolution operators for tracking [C]// IEEE Conference on Computer Vision and Pattern Recognition . Hawaii: IEEE, 2017: 6931-6939.

[本文引用: 1]

[26]

WANG N, ZHOU W G, TIAN Q, et al. Multi-cue correlation filters for robust visual tracking [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 4844-4853.

[本文引用: 1]

[27]

LI F, TIAN C, ZUO W M, et al. Learning spatial-temporal regularized correlation filters for visual tracking [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 4904-4913.

[本文引用: 2]

[28]

ZHANG Z, PENG H, FU J, et al. Ocean: object-aware anchor-free tracking [C]// Computer Vision-ECCV . Glasgow: Springer, 2020: 771-787.

[本文引用: 1]

[29]

SOSNOVIK I, MOSKALEV A, SMEULDERS A. Scale equivariance improves siamese tracking [C]// IEEE Winter Conference on Applications of Computer Vision . Waikoloa: IEEE, 2021: 2764-2773.

[本文引用: 1]

[30]

WANG N, ZHOU W, WANG J, et al. Transformer meets tracker: exploiting temporal context for robust visual tracking [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Nashville, TN: IEEE, 2021: 1571-1580.

[本文引用: 1]

[31]

CHEN X, KANG B, WANG D, et al. Efficient visual tracking via hierarchical cross-attention transformer [EB/OL]. [2022-10-29]. https://arxiv.org/abs/ 2203.13537.

[本文引用: 1]

[32]

XING D, EVANGELIOU N, TSOUKALAS A, et al. Siamese transformer pyramid networks for real-time UAV tracking [C]// IEEE/CVF Winter Conference on Applications of Computer Vision . Waikoloa: IEEE, 2022: 1898-1907.

[本文引用: 1]

2

... 近年来,无人机(unmanned aerial vehicle, UAV)由于体积小、操作简单、动作灵活等特点,在军用、民用领域中得到广泛地应用,例如侦查敌情、精准打击、航空摄影、电力巡检、地理测绘、灾害救援、精准农业等. 作为无人机应用的关键技术之一,无人机目标跟踪算法成为计算机视觉领域的研究热点,得到了学者们的广泛关注[1 -4 ] . 相对于地面平台,无人机空中平台获得的视频具有角度多变、分辨率低、严重遮挡、运动模糊、尺度变化等严重干扰目标跟踪的因素,使得设计一种准确鲁棒的无人机目标跟踪算法具有十分重要的意义. ...

... Comparison of tracking performance with transformer based trackers on UAV20L

Tab.4 方法 骨干网络 P S $v$ −1 ) Transt[1 ] RestNet50 0.819 0.631 39.9 TrDiMP[30 ] RestNet50 0.768 0.620 15.7 HCAT[31 ] RestNet18 0.676 0.510 104.1 SiamTPN[32 ] ShuffleNetV2 0.793 0.607 32.9 AASAF AlexNet 0.744 0.571 147.9

4. 结 论 (1) 在传统AlexNet主干网络输出的2个模板分支中引入高效通道注意力机制,能够显著提升模型的特征提取能力和判别能力. ...

孪生网络框架下融合显著性和干扰在线学习的航拍目标跟踪算法

0

2021

孪生网络框架下融合显著性和干扰在线学习的航拍目标跟踪算法

0

2021

响应和滤波器偏差感知约束的无人机目标跟踪算法

0

2022

响应和滤波器偏差感知约束的无人机目标跟踪算法

0

2022

基于自适应深度网络的无人机目标跟踪算法

1

2019

... 近年来,无人机(unmanned aerial vehicle, UAV)由于体积小、操作简单、动作灵活等特点,在军用、民用领域中得到广泛地应用,例如侦查敌情、精准打击、航空摄影、电力巡检、地理测绘、灾害救援、精准农业等. 作为无人机应用的关键技术之一,无人机目标跟踪算法成为计算机视觉领域的研究热点,得到了学者们的广泛关注[1 -4 ] . 相对于地面平台,无人机空中平台获得的视频具有角度多变、分辨率低、严重遮挡、运动模糊、尺度变化等严重干扰目标跟踪的因素,使得设计一种准确鲁棒的无人机目标跟踪算法具有十分重要的意义. ...

基于自适应深度网络的无人机目标跟踪算法

1

2019

... 近年来,无人机(unmanned aerial vehicle, UAV)由于体积小、操作简单、动作灵活等特点,在军用、民用领域中得到广泛地应用,例如侦查敌情、精准打击、航空摄影、电力巡检、地理测绘、灾害救援、精准农业等. 作为无人机应用的关键技术之一,无人机目标跟踪算法成为计算机视觉领域的研究热点,得到了学者们的广泛关注[1 -4 ] . 相对于地面平台,无人机空中平台获得的视频具有角度多变、分辨率低、严重遮挡、运动模糊、尺度变化等严重干扰目标跟踪的因素,使得设计一种准确鲁棒的无人机目标跟踪算法具有十分重要的意义. ...

1

... 目前目标跟踪技术主要分为2大类:相关滤波法和深度学习法. 相关滤波方法将时域的卷积运算变换到频域进行点积运算,大大提高了跟踪速度. Bolme等[5 ] 将相关滤波引入到目标跟踪领域,提出误差最小平方和(minimum output sum of squared error, MOSSE)跟踪方法,跟踪速度超过了600 帧/s. Henriques等[6 ] 将多通道特征引入到核相关滤波(kernel correlation filter, KCF)中,在保证跟踪速度的同时,改善了跟踪性能. Huang等[7 ] 提出抑制畸变相关滤波(aberrance repressed correlation filters, ARCF)的无人机跟踪方法,对相关滤波响应图中的畸变或异常进行抑制,实现对目标的准确定位. Li等[8 ] 提出自动时空正则化(automatic spatio-temporal regularization tracker, AutoTrack)无人机跟踪算法,对空间权值和时间权值同时进行动态调整,有效提高了算法的稳定性. Lin等[9 ] 提出双向不一致感知相关滤波器(bidirectional incongruity-aware correlation filter, BiCF),将基于响应双向不一致的误差融合到相关滤波中,学习跟踪目标的外观变化,解决了跟踪过程中由于目标和背景变化导致的失败现象. 虽然相关滤波方法取得较好的跟踪性能,但是该类方法大多采用灰度、颜色、纹理等手工特征,只适用于像素级目标定位,对旋转变形的鲁棒性很差,导致跟踪准确性和跟踪成功率的性能不高. 部分相关滤波类方法采用卷积特征,改善了跟踪效果. 在采用边缘计算设备(如英伟达Jetson AGX Orin 32GB)作为无人机平台计算资源时,跟踪速度大多小于30 帧/s,难以满足无人机平台实时的跟踪需求. ...

High-speed tracking with kernelized correlation filters

1

2015

... 目前目标跟踪技术主要分为2大类:相关滤波法和深度学习法. 相关滤波方法将时域的卷积运算变换到频域进行点积运算,大大提高了跟踪速度. Bolme等[5 ] 将相关滤波引入到目标跟踪领域,提出误差最小平方和(minimum output sum of squared error, MOSSE)跟踪方法,跟踪速度超过了600 帧/s. Henriques等[6 ] 将多通道特征引入到核相关滤波(kernel correlation filter, KCF)中,在保证跟踪速度的同时,改善了跟踪性能. Huang等[7 ] 提出抑制畸变相关滤波(aberrance repressed correlation filters, ARCF)的无人机跟踪方法,对相关滤波响应图中的畸变或异常进行抑制,实现对目标的准确定位. Li等[8 ] 提出自动时空正则化(automatic spatio-temporal regularization tracker, AutoTrack)无人机跟踪算法,对空间权值和时间权值同时进行动态调整,有效提高了算法的稳定性. Lin等[9 ] 提出双向不一致感知相关滤波器(bidirectional incongruity-aware correlation filter, BiCF),将基于响应双向不一致的误差融合到相关滤波中,学习跟踪目标的外观变化,解决了跟踪过程中由于目标和背景变化导致的失败现象. 虽然相关滤波方法取得较好的跟踪性能,但是该类方法大多采用灰度、颜色、纹理等手工特征,只适用于像素级目标定位,对旋转变形的鲁棒性很差,导致跟踪准确性和跟踪成功率的性能不高. 部分相关滤波类方法采用卷积特征,改善了跟踪效果. 在采用边缘计算设备(如英伟达Jetson AGX Orin 32GB)作为无人机平台计算资源时,跟踪速度大多小于30 帧/s,难以满足无人机平台实时的跟踪需求. ...

2

... 目前目标跟踪技术主要分为2大类:相关滤波法和深度学习法. 相关滤波方法将时域的卷积运算变换到频域进行点积运算,大大提高了跟踪速度. Bolme等[5 ] 将相关滤波引入到目标跟踪领域,提出误差最小平方和(minimum output sum of squared error, MOSSE)跟踪方法,跟踪速度超过了600 帧/s. Henriques等[6 ] 将多通道特征引入到核相关滤波(kernel correlation filter, KCF)中,在保证跟踪速度的同时,改善了跟踪性能. Huang等[7 ] 提出抑制畸变相关滤波(aberrance repressed correlation filters, ARCF)的无人机跟踪方法,对相关滤波响应图中的畸变或异常进行抑制,实现对目标的准确定位. Li等[8 ] 提出自动时空正则化(automatic spatio-temporal regularization tracker, AutoTrack)无人机跟踪算法,对空间权值和时间权值同时进行动态调整,有效提高了算法的稳定性. Lin等[9 ] 提出双向不一致感知相关滤波器(bidirectional incongruity-aware correlation filter, BiCF),将基于响应双向不一致的误差融合到相关滤波中,学习跟踪目标的外观变化,解决了跟踪过程中由于目标和背景变化导致的失败现象. 虽然相关滤波方法取得较好的跟踪性能,但是该类方法大多采用灰度、颜色、纹理等手工特征,只适用于像素级目标定位,对旋转变形的鲁棒性很差,导致跟踪准确性和跟踪成功率的性能不高. 部分相关滤波类方法采用卷积特征,改善了跟踪效果. 在采用边缘计算设备(如英伟达Jetson AGX Orin 32GB)作为无人机平台计算资源时,跟踪速度大多小于30 帧/s,难以满足无人机平台实时的跟踪需求. ...

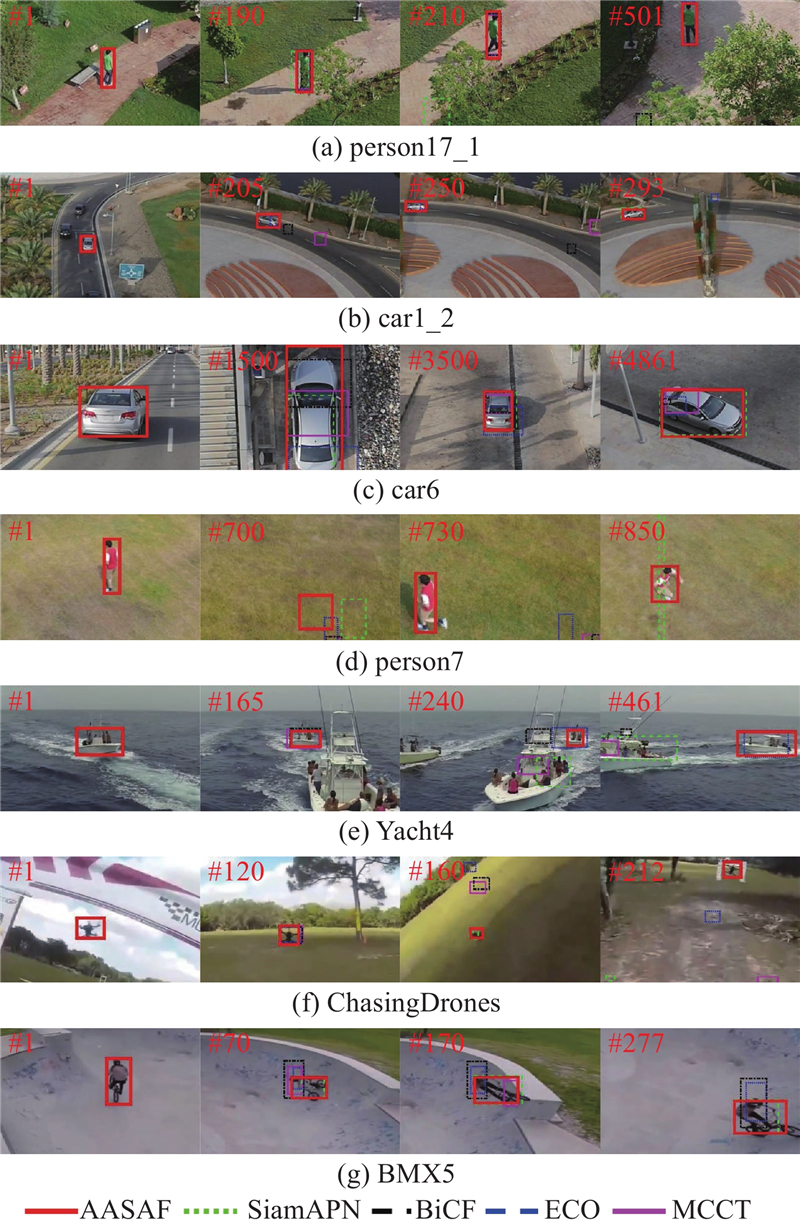

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

2

... 目前目标跟踪技术主要分为2大类:相关滤波法和深度学习法. 相关滤波方法将时域的卷积运算变换到频域进行点积运算,大大提高了跟踪速度. Bolme等[5 ] 将相关滤波引入到目标跟踪领域,提出误差最小平方和(minimum output sum of squared error, MOSSE)跟踪方法,跟踪速度超过了600 帧/s. Henriques等[6 ] 将多通道特征引入到核相关滤波(kernel correlation filter, KCF)中,在保证跟踪速度的同时,改善了跟踪性能. Huang等[7 ] 提出抑制畸变相关滤波(aberrance repressed correlation filters, ARCF)的无人机跟踪方法,对相关滤波响应图中的畸变或异常进行抑制,实现对目标的准确定位. Li等[8 ] 提出自动时空正则化(automatic spatio-temporal regularization tracker, AutoTrack)无人机跟踪算法,对空间权值和时间权值同时进行动态调整,有效提高了算法的稳定性. Lin等[9 ] 提出双向不一致感知相关滤波器(bidirectional incongruity-aware correlation filter, BiCF),将基于响应双向不一致的误差融合到相关滤波中,学习跟踪目标的外观变化,解决了跟踪过程中由于目标和背景变化导致的失败现象. 虽然相关滤波方法取得较好的跟踪性能,但是该类方法大多采用灰度、颜色、纹理等手工特征,只适用于像素级目标定位,对旋转变形的鲁棒性很差,导致跟踪准确性和跟踪成功率的性能不高. 部分相关滤波类方法采用卷积特征,改善了跟踪效果. 在采用边缘计算设备(如英伟达Jetson AGX Orin 32GB)作为无人机平台计算资源时,跟踪速度大多小于30 帧/s,难以满足无人机平台实时的跟踪需求. ...

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

2

... 目前目标跟踪技术主要分为2大类:相关滤波法和深度学习法. 相关滤波方法将时域的卷积运算变换到频域进行点积运算,大大提高了跟踪速度. Bolme等[5 ] 将相关滤波引入到目标跟踪领域,提出误差最小平方和(minimum output sum of squared error, MOSSE)跟踪方法,跟踪速度超过了600 帧/s. Henriques等[6 ] 将多通道特征引入到核相关滤波(kernel correlation filter, KCF)中,在保证跟踪速度的同时,改善了跟踪性能. Huang等[7 ] 提出抑制畸变相关滤波(aberrance repressed correlation filters, ARCF)的无人机跟踪方法,对相关滤波响应图中的畸变或异常进行抑制,实现对目标的准确定位. Li等[8 ] 提出自动时空正则化(automatic spatio-temporal regularization tracker, AutoTrack)无人机跟踪算法,对空间权值和时间权值同时进行动态调整,有效提高了算法的稳定性. Lin等[9 ] 提出双向不一致感知相关滤波器(bidirectional incongruity-aware correlation filter, BiCF),将基于响应双向不一致的误差融合到相关滤波中,学习跟踪目标的外观变化,解决了跟踪过程中由于目标和背景变化导致的失败现象. 虽然相关滤波方法取得较好的跟踪性能,但是该类方法大多采用灰度、颜色、纹理等手工特征,只适用于像素级目标定位,对旋转变形的鲁棒性很差,导致跟踪准确性和跟踪成功率的性能不高. 部分相关滤波类方法采用卷积特征,改善了跟踪效果. 在采用边缘计算设备(如英伟达Jetson AGX Orin 32GB)作为无人机平台计算资源时,跟踪速度大多小于30 帧/s,难以满足无人机平台实时的跟踪需求. ...

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

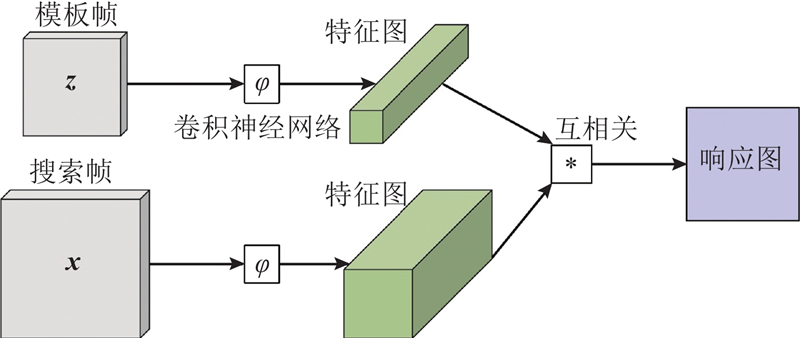

1

... 深度学习类跟踪方法采用离线训练网络模型提取跟踪目标的深度特征,能够有效地进行目标表征,在保证跟踪速度的同时,大大提升了跟踪性能. Bertinetto等[10 ] 将全卷积孪生神经网络(fully-convolutional siamese networks, SiamFC)应用到目标跟踪领域,通过学习搜索区域与目标模板的相似度响应图来确定目标位置,该方法显著提升了基于深度学习目标跟踪的速度. Li等[11 ] 在SiamFC基础上提出孪生候选区域生成网络(siamese region proposal network, SiamRPN),将目标跟踪看成局部单目标检测任务,在保证较快跟踪速度的同时,有效提升了跟踪性能. SiamFC和SiamRPN都是采用浅层神经网络提取出目标特征,限制了目标的深层表征能力. Li等[12 ] 突破深层神经网络不能应用到目标跟踪领域的限制,结合目标浅层和深层特征,在多个跟踪数据集上取得较好的跟踪性能. Xu等[13 ] 提出改进版全卷积孪生神经网络(fully convolutional siamese tracker++, SiamFC++)算法,同时引入分类和状态估计分支,进一步提高了跟踪准确度. 目前深度学习类目标跟踪算法取得突破性进展,大部分采用深度神经网络提取目标特征,加大计算复杂度,难以适应无人机平台的硬件配置. 本研究提出注意力聚集无锚框的孪生网络无人机目标跟踪算法,在3个无人机数据集上进行测试仿真,实现对目标位置和所占区域的准确估计. ...

1

... 深度学习类跟踪方法采用离线训练网络模型提取跟踪目标的深度特征,能够有效地进行目标表征,在保证跟踪速度的同时,大大提升了跟踪性能. Bertinetto等[10 ] 将全卷积孪生神经网络(fully-convolutional siamese networks, SiamFC)应用到目标跟踪领域,通过学习搜索区域与目标模板的相似度响应图来确定目标位置,该方法显著提升了基于深度学习目标跟踪的速度. Li等[11 ] 在SiamFC基础上提出孪生候选区域生成网络(siamese region proposal network, SiamRPN),将目标跟踪看成局部单目标检测任务,在保证较快跟踪速度的同时,有效提升了跟踪性能. SiamFC和SiamRPN都是采用浅层神经网络提取出目标特征,限制了目标的深层表征能力. Li等[12 ] 突破深层神经网络不能应用到目标跟踪领域的限制,结合目标浅层和深层特征,在多个跟踪数据集上取得较好的跟踪性能. Xu等[13 ] 提出改进版全卷积孪生神经网络(fully convolutional siamese tracker++, SiamFC++)算法,同时引入分类和状态估计分支,进一步提高了跟踪准确度. 目前深度学习类目标跟踪算法取得突破性进展,大部分采用深度神经网络提取目标特征,加大计算复杂度,难以适应无人机平台的硬件配置. 本研究提出注意力聚集无锚框的孪生网络无人机目标跟踪算法,在3个无人机数据集上进行测试仿真,实现对目标位置和所占区域的准确估计. ...

1

... 深度学习类跟踪方法采用离线训练网络模型提取跟踪目标的深度特征,能够有效地进行目标表征,在保证跟踪速度的同时,大大提升了跟踪性能. Bertinetto等[10 ] 将全卷积孪生神经网络(fully-convolutional siamese networks, SiamFC)应用到目标跟踪领域,通过学习搜索区域与目标模板的相似度响应图来确定目标位置,该方法显著提升了基于深度学习目标跟踪的速度. Li等[11 ] 在SiamFC基础上提出孪生候选区域生成网络(siamese region proposal network, SiamRPN),将目标跟踪看成局部单目标检测任务,在保证较快跟踪速度的同时,有效提升了跟踪性能. SiamFC和SiamRPN都是采用浅层神经网络提取出目标特征,限制了目标的深层表征能力. Li等[12 ] 突破深层神经网络不能应用到目标跟踪领域的限制,结合目标浅层和深层特征,在多个跟踪数据集上取得较好的跟踪性能. Xu等[13 ] 提出改进版全卷积孪生神经网络(fully convolutional siamese tracker++, SiamFC++)算法,同时引入分类和状态估计分支,进一步提高了跟踪准确度. 目前深度学习类目标跟踪算法取得突破性进展,大部分采用深度神经网络提取目标特征,加大计算复杂度,难以适应无人机平台的硬件配置. 本研究提出注意力聚集无锚框的孪生网络无人机目标跟踪算法,在3个无人机数据集上进行测试仿真,实现对目标位置和所占区域的准确估计. ...

1

... 深度学习类跟踪方法采用离线训练网络模型提取跟踪目标的深度特征,能够有效地进行目标表征,在保证跟踪速度的同时,大大提升了跟踪性能. Bertinetto等[10 ] 将全卷积孪生神经网络(fully-convolutional siamese networks, SiamFC)应用到目标跟踪领域,通过学习搜索区域与目标模板的相似度响应图来确定目标位置,该方法显著提升了基于深度学习目标跟踪的速度. Li等[11 ] 在SiamFC基础上提出孪生候选区域生成网络(siamese region proposal network, SiamRPN),将目标跟踪看成局部单目标检测任务,在保证较快跟踪速度的同时,有效提升了跟踪性能. SiamFC和SiamRPN都是采用浅层神经网络提取出目标特征,限制了目标的深层表征能力. Li等[12 ] 突破深层神经网络不能应用到目标跟踪领域的限制,结合目标浅层和深层特征,在多个跟踪数据集上取得较好的跟踪性能. Xu等[13 ] 提出改进版全卷积孪生神经网络(fully convolutional siamese tracker++, SiamFC++)算法,同时引入分类和状态估计分支,进一步提高了跟踪准确度. 目前深度学习类目标跟踪算法取得突破性进展,大部分采用深度神经网络提取目标特征,加大计算复杂度,难以适应无人机平台的硬件配置. 本研究提出注意力聚集无锚框的孪生网络无人机目标跟踪算法,在3个无人机数据集上进行测试仿真,实现对目标位置和所占区域的准确估计. ...

1

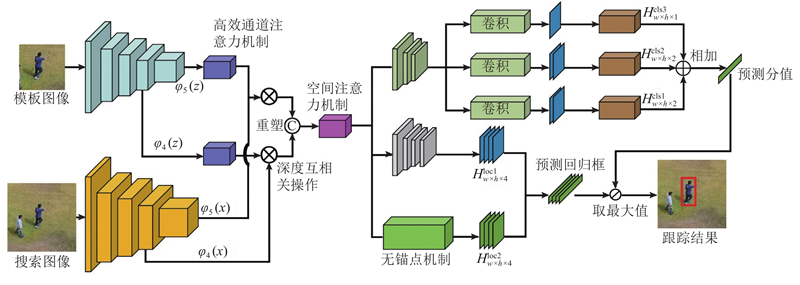

... 使用AlexNet浅层网络提取模板图像和搜索图像特征, $ {\varphi _4}\left( {\boldsymbol{z}} \right) $ $ {\varphi _5}\left( {\boldsymbol{z}} \right) $ $ {\varphi _4}\left( {\boldsymbol{x}} \right) $ $ {\varphi _5}\left( {\boldsymbol{x}} \right) $ $ {\varphi _4}\left( {\boldsymbol{z}} \right) $ $ {\varphi _5}\left( {\boldsymbol{z}} \right) $ [14 ] (efficient channel attention, ECA),提高模板特征的网络表达能力,对应新的模板特征分别为 $ \varphi _4^{'}\left( {\boldsymbol{z}} \right) $ $ \varphi _5^{'}\left( {\boldsymbol{z}} \right) $

Efficient visual tracking with stacked channel-spatial attention learning

1

2020

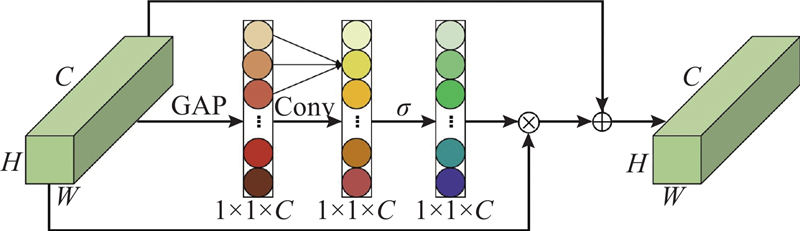

... 传统SiamFC算法使用AlexNet网络提取图像特征,由于没有考虑通道信息,导致当跟踪场景比较复杂以及目标发生较大变化时容易跟丢目标. 为了增强模板的表征能力,Rahman等[15 ] 直接将通道和空间注意力机制[16 ] (convolutional block attention module, CBAM)加到传统SiamFC算法的模板分支中,虽然改善了跟踪效果,但是由于CBAM模块的引入,增加了模型的复杂度,降低了算法的跟踪速度. 为了有效地提升图像的表征能力,使得算法在提高跟踪性能的同时具有较高的跟踪速度,所提算法在AlexNet网络模板分支的第4层和第5层分别引入高效的通道注意力模块,考虑到每个通道及其邻域通道,通过一维卷积快速完成通道权重的计算,实现对不同通道赋予不同的权值,有选择地加强有用通道信息,抑制无用通道信息. 通道注意力模块的结构如图3 所示. ...

1

... 传统SiamFC算法使用AlexNet网络提取图像特征,由于没有考虑通道信息,导致当跟踪场景比较复杂以及目标发生较大变化时容易跟丢目标. 为了增强模板的表征能力,Rahman等[15 ] 直接将通道和空间注意力机制[16 ] (convolutional block attention module, CBAM)加到传统SiamFC算法的模板分支中,虽然改善了跟踪效果,但是由于CBAM模块的引入,增加了模型的复杂度,降低了算法的跟踪速度. 为了有效地提升图像的表征能力,使得算法在提高跟踪性能的同时具有较高的跟踪速度,所提算法在AlexNet网络模板分支的第4层和第5层分别引入高效的通道注意力模块,考虑到每个通道及其邻域通道,通过一维卷积快速完成通道权重的计算,实现对不同通道赋予不同的权值,有选择地加强有用通道信息,抑制无用通道信息. 通道注意力模块的结构如图3 所示. ...

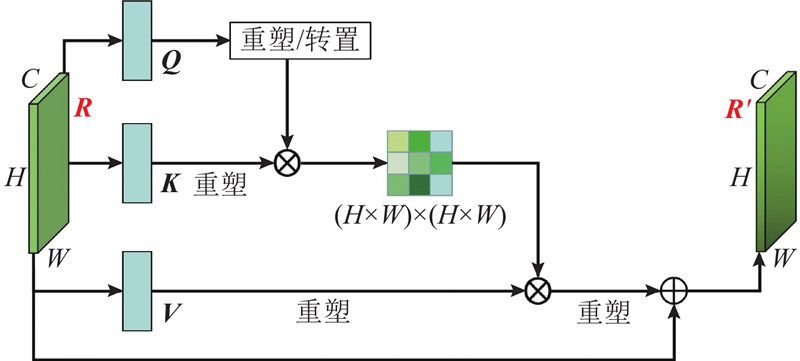

1

... 以往大部分孪生类跟踪方法都是将得到的响应图直接用于跟踪目标位置的确定和目标框的回归,忽略响应图中的特征依赖关系,导致算法在复杂场景下跟踪效果不佳. 为了更好地提升响应图的特征聚合能力以及提高算法的鲁棒性,受Fu等[17 ] 的启发,在响应图中引入空间注意力模块,学习响应图中相似特征的依赖关系,以便更加准确地确定目标位置以及回归目标框的大小,其中空间注意力模块结构如图4 所示. ...

1

... 训练数据如下:包含91类目标、32.8万个影像、250万个标签的COCO数据集[18 ] ;含有30个基本类别、200个子集的Image VID数据集[19 ] ;含有563个目标类别、87种运动模式、超过1万条视频的GOT-10K数据集[20 ] ;含有38万个视频片段、23个类别、560万个手动标注边界框的Youtube-BB数据集[21 ] . ...

ImageNet large scale visual recognition challenge

1

2015

... 训练数据如下:包含91类目标、32.8万个影像、250万个标签的COCO数据集[18 ] ;含有30个基本类别、200个子集的Image VID数据集[19 ] ;含有563个目标类别、87种运动模式、超过1万条视频的GOT-10K数据集[20 ] ;含有38万个视频片段、23个类别、560万个手动标注边界框的Youtube-BB数据集[21 ] . ...

1

... 训练数据如下:包含91类目标、32.8万个影像、250万个标签的COCO数据集[18 ] ;含有30个基本类别、200个子集的Image VID数据集[19 ] ;含有563个目标类别、87种运动模式、超过1万条视频的GOT-10K数据集[20 ] ;含有38万个视频片段、23个类别、560万个手动标注边界框的Youtube-BB数据集[21 ] . ...

1

... 训练数据如下:包含91类目标、32.8万个影像、250万个标签的COCO数据集[18 ] ;含有30个基本类别、200个子集的Image VID数据集[19 ] ;含有563个目标类别、87种运动模式、超过1万条视频的GOT-10K数据集[20 ] ;含有38万个视频片段、23个类别、560万个手动标注边界框的Youtube-BB数据集[21 ] . ...

2

... 为了验证所提算法的跟踪性能,在UAV123@10fps[22 ] 、UAV20L[22 ] 和DTB70[23 ] 这3个广泛应用的无人机数据集进行仿真实验. ...

... [22 ]和DTB70[23 ] 这3个广泛应用的无人机数据集进行仿真实验. ...

1

... 为了验证所提算法的跟踪性能,在UAV123@10fps[22 ] 、UAV20L[22 ] 和DTB70[23 ] 这3个广泛应用的无人机数据集进行仿真实验. ...

1

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

1

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

1

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

2

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

... [27 ]、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

1

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

1

... 表1 给出所提算法分别在UAV123@10fps、UAV20L和DTB70数据集上与SiamAPN[24 ] 、ECO[25 ] 、MCCT[26 ] 、DeepSTRCF[27 ] 、AutoTrack[8 ] 、ARCF[7 ] 、Ocean[28 ] 、BiCF[9 ] 、STRCF[27 ] 、SESiam_FC[29 ] 等算法的对比实验结果. 对于数据集UAV123@10fps,所提算法在跟踪准确度P 和跟踪成功率S 这2个指标上分别取得了0.755和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%. 对于UAV20L数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744和0.571,相比SiamAPN分别提高了3.2%和5.9%. 对于DTB70数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势. 从表1 可以看出,所提算法在3个无人机数据集上以及2个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能. ...

1

... Comparison of tracking performance with transformer based trackers on UAV20L

Tab.4 方法 骨干网络 P S $v$ −1 ) Transt[1 ] RestNet50 0.819 0.631 39.9 TrDiMP[30 ] RestNet50 0.768 0.620 15.7 HCAT[31 ] RestNet18 0.676 0.510 104.1 SiamTPN[32 ] ShuffleNetV2 0.793 0.607 32.9 AASAF AlexNet 0.744 0.571 147.9

4. 结 论 (1) 在传统AlexNet主干网络输出的2个模板分支中引入高效通道注意力机制,能够显著提升模型的特征提取能力和判别能力. ...

1

... Comparison of tracking performance with transformer based trackers on UAV20L

Tab.4 方法 骨干网络 P S $v$ −1 ) Transt[1 ] RestNet50 0.819 0.631 39.9 TrDiMP[30 ] RestNet50 0.768 0.620 15.7 HCAT[31 ] RestNet18 0.676 0.510 104.1 SiamTPN[32 ] ShuffleNetV2 0.793 0.607 32.9 AASAF AlexNet 0.744 0.571 147.9

4. 结 论 (1) 在传统AlexNet主干网络输出的2个模板分支中引入高效通道注意力机制,能够显著提升模型的特征提取能力和判别能力. ...

1

... Comparison of tracking performance with transformer based trackers on UAV20L

Tab.4 方法 骨干网络 P S $v$ −1 ) Transt[1 ] RestNet50 0.819 0.631 39.9 TrDiMP[30 ] RestNet50 0.768 0.620 15.7 HCAT[31 ] RestNet18 0.676 0.510 104.1 SiamTPN[32 ] ShuffleNetV2 0.793 0.607 32.9 AASAF AlexNet 0.744 0.571 147.9

4. 结 论 (1) 在传统AlexNet主干网络输出的2个模板分支中引入高效通道注意力机制,能够显著提升模型的特征提取能力和判别能力. ...