[1]

USENKO V, ENGEL J, STÜCKLER J, et al. Direct visual-inertial odometry with stereo cameras [C]// 2016 IEEE International Conference on Robotics and Automation . Stockholm: IEEE, 2016: 1885-1892.

[本文引用: 1]

[2]

MUR-ARTAL R, TARDÓS J D Visual-inertial monocular SLAM with map reuse

[J]. IEEE Robotics and Automation Letters , 2017 , 2 (2 ): 796 - 803

DOI:10.1109/LRA.2017.2653359

[本文引用: 1]

[3]

MUR-ARTAL R, MONTIEL J M M, TARDOS J D ORB-SLAM: a versatile and accurate monocular SLAM system

[J]. IEEE Transactions on Robotics , 2015 , 31 (5 ): 1147 - 1163

DOI:10.1109/TRO.2015.2463671

[本文引用: 1]

[4]

MUR-ARTAL R, TARDÓS J D Orb-slam2: an open-source slam system for monocular, stereo, and RGB-D cameras

[J]. IEEE Transactions on Robotics , 2017 , 33 (5 ): 1255 - 1262

DOI:10.1109/TRO.2017.2705103

[本文引用: 1]

[6]

MOURIKIS A I, ROUMELIOTIS S I. A multi-state constraint Kalman filter for vision-aided inertial navigation [C]// Proceedings of 2007 IEEE International Conference on Robotics and Automation . Roma: IEEE, 2007: 3565-3572.

[本文引用: 1]

[7]

SUN K, MOHTA K, PFROMMER B, et al Robust stereo visual inertial odometry for fast autonomous flight

[J]. IEEE Robotics and Automation Letters , 2018 , 3 (2 ): 965 - 972

DOI:10.1109/LRA.2018.2793349

[本文引用: 1]

[8]

GENEVA P, ECKENHOFF K, LEE W, et al. Openvins: a research platform for visual-inertial estimation [C]// 2020 IEEE International Conference on Robotics and Automation . Paris: IEEE, 2020: 4666-4672.

[本文引用: 2]

[9]

QIU X, ZHANG H, FU W Lightweight hybrid visual-inertial odometry with closed-form zero velocity update

[J]. Chinese Journal of Aeronautics , 2020 , 33 (12 ): 3344 - 3359

DOI:10.1016/j.cja.2020.03.008

[本文引用: 2]

[10]

HUAI Z, HUANG G. Robocentric visual-inertial odometry [C]// 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems . Madrid: IEEE, 2018: 6319-6326.

[11]

MA F, SHI J, YANG Y, et al ACK-MSCKF: tightly-coupled Ackermann multi-state constraint Kalman filter for autonomous vehicle localization

[J]. Sensors , 2019 , 19 (21 ): 4816

DOI:10.3390/s19214816

[12]

ZHENG F, TSAI G, ZHANG Z, et al. Trifo-VIO: robust and efficient stereo visual inertial odometry using points and lines [C]// 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems . Madrid: IEEE, 2018: 3686-3693.

[本文引用: 1]

[13]

BAVLE H, MANTHE S, DE L P P, et al. Stereo visual odometry and semantics based localization of aerial robots in indoor environments [C]// 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems . Madrid: IEEE, 2018: 1018-1023.

[本文引用: 4]

[14]

LEVINSON J, MONTEMERLO M, THRUN S. Map-based precision vehicle localization in urban environments [C]// Robotics: Science and Systems . Atlanta: [s. n.], 2007: 1.

[本文引用: 1]

[15]

LEVINSON J, THRUN S. Robust vehicle localization in urban environments using probabilistic maps [C]// 2010 IEEE International Conference on Robotics and Automation . Anchorage: IEEE, 2010: 4372-4378.

[本文引用: 1]

[16]

QIN T, LI P, SHEN S Vins-mono: a robust and versatile monocular visual-inertial state estimator

[J]. IEEE Transactions on Robotics , 2018 , 34 (4 ): 1004 - 1020

DOI:10.1109/TRO.2018.2853729

[本文引用: 1]

[17]

QIN T, SHEN S. Online temporal calibration for monocular visual-inertial systems [C]// 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems . Madrid: IEEE, 2018: 3662-3669.

[本文引用: 1]

[18]

徐晓苏, 代维, 杨博, 等 室内环境下基于图优化的视觉惯性SLAM方法

[J]. 中国惯性技术学报 , 2017 , 25 (3 ): 313 - 319

[本文引用: 1]

XU Xiao-su, DAI Wei, YANG Bo, et al Visual-aid inertial SLAM method based on graph optimization in indoor

[J]. Journal of Chinese Inertial Technology , 2017 , 25 (3 ): 313 - 319

[本文引用: 1]

[19]

HARRIS C G, STEPHENS M. A combined corner and edge detector [C]// Alvey Vision Conference . Manchester: [s. n.], 1988: 10-5244.

[本文引用: 1]

[20]

KOENIG N, HOWARD A. Design and use paradigms for gazebo, an open-source multi-robot simulator [C]// 2004 IEEE/RSJ International Conference on Intelligent Robots and Systems . Sendai: IEEE, 2004: 2149-2154.

[本文引用: 1]

1

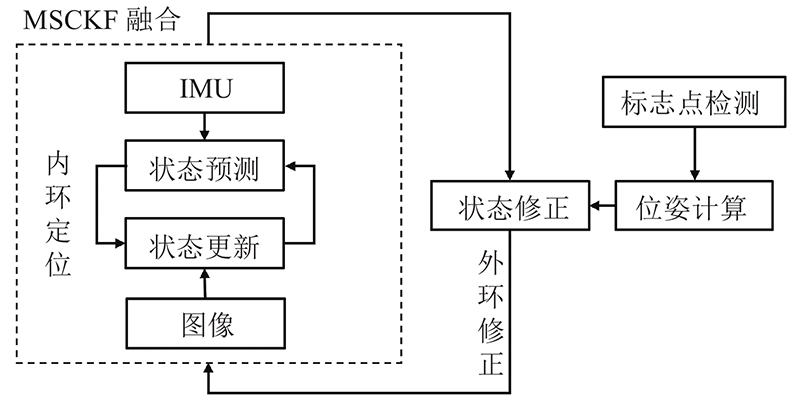

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

Visual-inertial monocular SLAM with map reuse

1

2017

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

ORB-SLAM: a versatile and accurate monocular SLAM system

1

2015

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

Orb-slam2: an open-source slam system for monocular, stereo, and RGB-D cameras

1

2017

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

Limits to the consistency of EKF-based SLAM

1

2004

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

1

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

Robust stereo visual inertial odometry for fast autonomous flight

1

2018

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

2

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

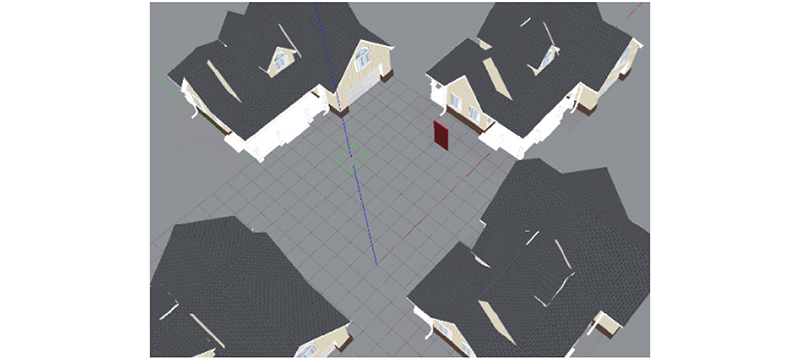

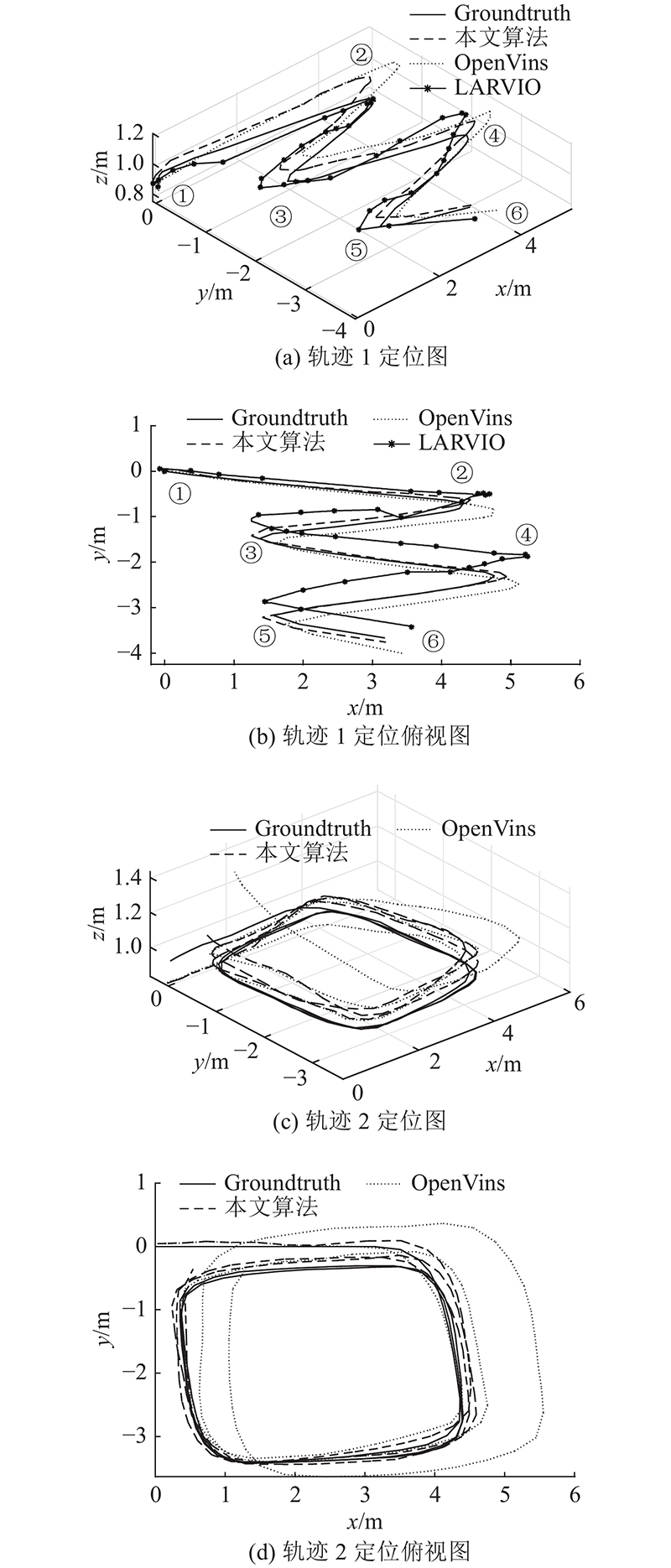

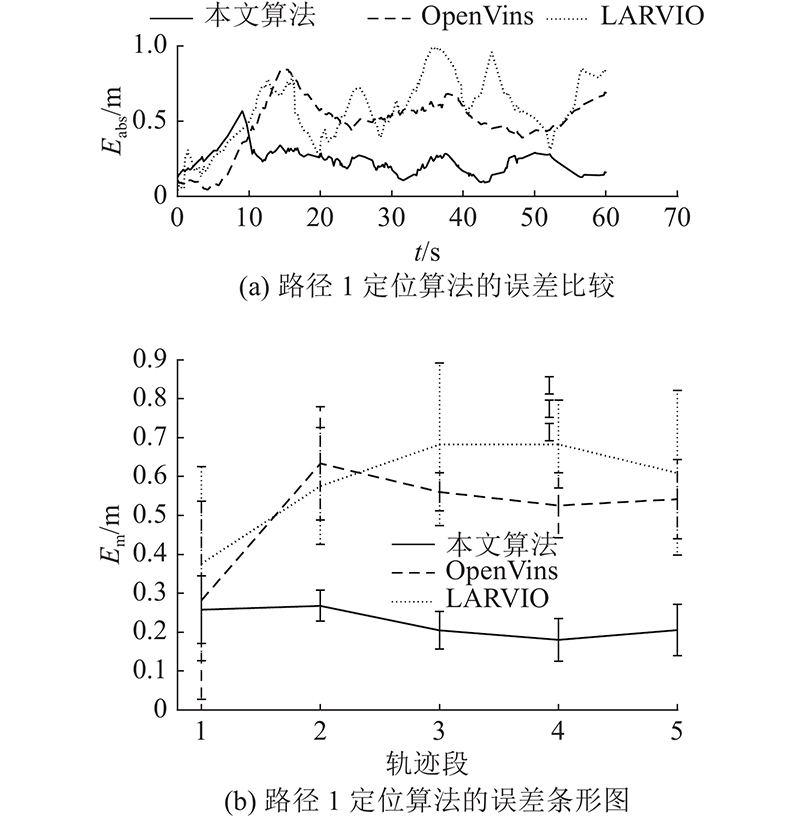

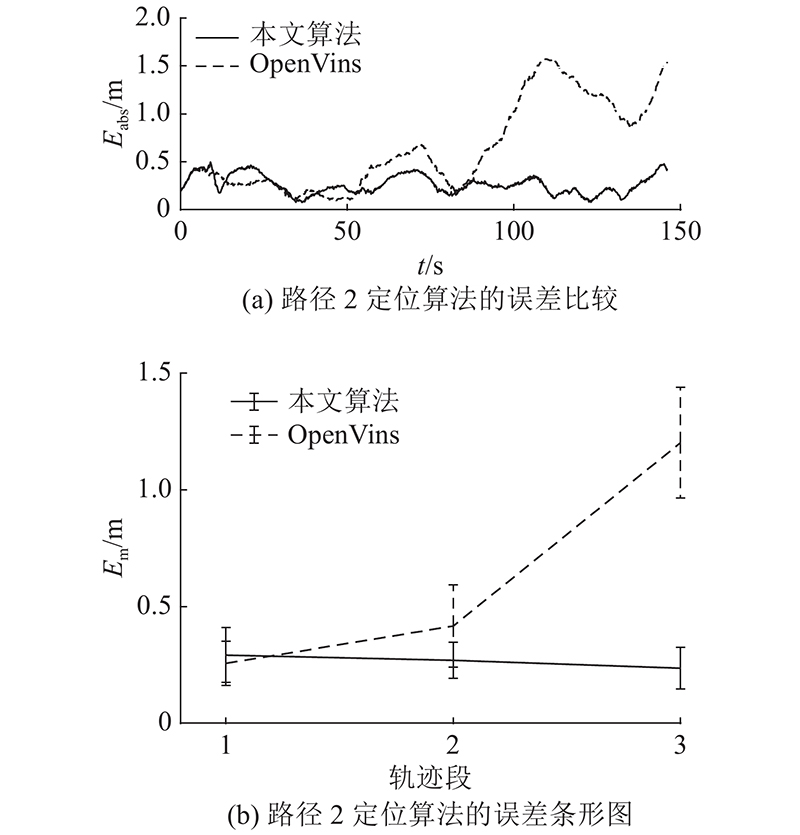

... 为了验证提出算法的有效性与稳定性,将提出的算法与OpenVins[8 ] 与LARVIO[9 ] 2种开源VIO算法进行对比,采用Gazebo仿真引擎[20 ] 搭建仿真测试环境. 采用单目摄像头进行环境感知,所采集的RGB图像分辨率为 $500 \times 320$ 图3 所示. 测试环境周围的楼房主要为算法前端提供丰富的纹理信息. 环境中的矩形为本文设置的标志物,提供外环位姿修正信息. 在仿真环境下,共设置2种飞行轨迹,对3种算法进行比较与评估. ...

Lightweight hybrid visual-inertial odometry with closed-form zero velocity update

2

2020

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

... 为了验证提出算法的有效性与稳定性,将提出的算法与OpenVins[8 ] 与LARVIO[9 ] 2种开源VIO算法进行对比,采用Gazebo仿真引擎[20 ] 搭建仿真测试环境. 采用单目摄像头进行环境感知,所采集的RGB图像分辨率为 $500 \times 320$ 图3 所示. 测试环境周围的楼房主要为算法前端提供丰富的纹理信息. 环境中的矩形为本文设置的标志物,提供外环位姿修正信息. 在仿真环境下,共设置2种飞行轨迹,对3种算法进行比较与评估. ...

ACK-MSCKF: tightly-coupled Ackermann multi-state constraint Kalman filter for autonomous vehicle localization

0

2019

1

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

4

... 针对室内环境定位的问题,在过去的几十年中,Usenko等[1 -2 ] 开发出了多种算法,以提高室内定位的精度. Mur-Artal等[3 -4 ] 提出基于视觉的机器人室内定位方法,该方法只需要单目相机即可进行定位,对传感器的要求较低,但无法恢复尺度信息. 研究人员提出融合相机信息与IMU信息的视觉惯性里程计方法(visual-inertial odometry, VIO),主要分为基于滤波与基于优化的方法. 基于滤波的方法中,Castellanos等[5 ] 提出基于EKF的室内定位方法,但将图像中的每个特征点都加入滤波器状态量中,计算负荷较大,定位精度较低. Mourikis等[6 ] 提出基于MSCKF框架的定位方法,维护了相机位姿的滑动窗口,减小了滤波器状态量的维度. Sun等[7 ] 提出MSCKF框架下基于双目视觉的定位方法,提高了定位的鲁棒性. Geneva等[8 ] 在MSCKF的基础上提出通用框架,提供多种算法接口,便于算法选择与参数调优. 此外还有文献[9 ~12 ]的改进算法. 这些方法的计算速度快,定位精度较高,但在受到扰动时容易产生误差累积与漂移. Bavle等[13 ] 提出基于粒子滤波与语义的定位方法,通过对环境中位置已知的物体的检测进行无人机定位的外环修正. ...

... 算法的实时性分析如表2 所示. 表中,t d 为时延.所选择的3种算法分别为本文算法、OpenVins及文献[13 ]算法. 可以看出,与没有外环校正的OpenVins算法相比,本文算法在牺牲了一定的实时性基础上提高了定位的精度,且算法实时性符合无人机的计算要求. 与使用基于YOLO网络的目标检测进行外环校正[13 ] 相比,本文算法使用了传统的图像处理算法,因此算法的实时性大幅提升. ...

... [13 ]相比,本文算法使用了传统的图像处理算法,因此算法的实时性大幅提升. ...

... Real-time analysis of positioning algorithms

Tab.2 算法 t d /ms 本文算法 7.92 OpenVins 2.67 文献[13 ]算法 >22.22

4. 结 语 针对基于MSCKF的室内定位方法存在的容易产生漂移的问题,本文提出基于改进MSCKF的室内定位方法. 在友好的室内环境中设定位置已知的标志点,在MSCKF框架下得到无人机内环位姿. 通过前端图像处理进行标志点检测,得到无人机自身的位姿,对内环位姿估计进行修正. 实验结果表明,利用本文算法有效地抑制了定位漂移情况,提高了定位精度. 在未来工作中,将在真实环境中测试提出方法的定位效果. ...

1

... 另一种定位方式为基于优化的定位方法. Levinson等[14 -15 ] 提出基于因子图优化的方法,建立高精度地图并进行多传感器融合与定位. Qin等[16 -17 ] 提出基于优化的定位方法,将IMU与视觉感知图像通过非线性优化方法进行融合. 徐晓苏等[18 ] 采用聚类的方法对ORB特征点进行跟踪,提高了定位精度. 这些基于优化的方法能够利用历史信息进行全局优化,但对计算储存的能力要求较高. ...

1

... 另一种定位方式为基于优化的定位方法. Levinson等[14 -15 ] 提出基于因子图优化的方法,建立高精度地图并进行多传感器融合与定位. Qin等[16 -17 ] 提出基于优化的定位方法,将IMU与视觉感知图像通过非线性优化方法进行融合. 徐晓苏等[18 ] 采用聚类的方法对ORB特征点进行跟踪,提高了定位精度. 这些基于优化的方法能够利用历史信息进行全局优化,但对计算储存的能力要求较高. ...

Vins-mono: a robust and versatile monocular visual-inertial state estimator

1

2018

... 另一种定位方式为基于优化的定位方法. Levinson等[14 -15 ] 提出基于因子图优化的方法,建立高精度地图并进行多传感器融合与定位. Qin等[16 -17 ] 提出基于优化的定位方法,将IMU与视觉感知图像通过非线性优化方法进行融合. 徐晓苏等[18 ] 采用聚类的方法对ORB特征点进行跟踪,提高了定位精度. 这些基于优化的方法能够利用历史信息进行全局优化,但对计算储存的能力要求较高. ...

1

... 另一种定位方式为基于优化的定位方法. Levinson等[14 -15 ] 提出基于因子图优化的方法,建立高精度地图并进行多传感器融合与定位. Qin等[16 -17 ] 提出基于优化的定位方法,将IMU与视觉感知图像通过非线性优化方法进行融合. 徐晓苏等[18 ] 采用聚类的方法对ORB特征点进行跟踪,提高了定位精度. 这些基于优化的方法能够利用历史信息进行全局优化,但对计算储存的能力要求较高. ...

室内环境下基于图优化的视觉惯性SLAM方法

1

2017

... 另一种定位方式为基于优化的定位方法. Levinson等[14 -15 ] 提出基于因子图优化的方法,建立高精度地图并进行多传感器融合与定位. Qin等[16 -17 ] 提出基于优化的定位方法,将IMU与视觉感知图像通过非线性优化方法进行融合. 徐晓苏等[18 ] 采用聚类的方法对ORB特征点进行跟踪,提高了定位精度. 这些基于优化的方法能够利用历史信息进行全局优化,但对计算储存的能力要求较高. ...

室内环境下基于图优化的视觉惯性SLAM方法

1

2017

... 另一种定位方式为基于优化的定位方法. Levinson等[14 -15 ] 提出基于因子图优化的方法,建立高精度地图并进行多传感器融合与定位. Qin等[16 -17 ] 提出基于优化的定位方法,将IMU与视觉感知图像通过非线性优化方法进行融合. 徐晓苏等[18 ] 采用聚类的方法对ORB特征点进行跟踪,提高了定位精度. 这些基于优化的方法能够利用历史信息进行全局优化,但对计算储存的能力要求较高. ...

1

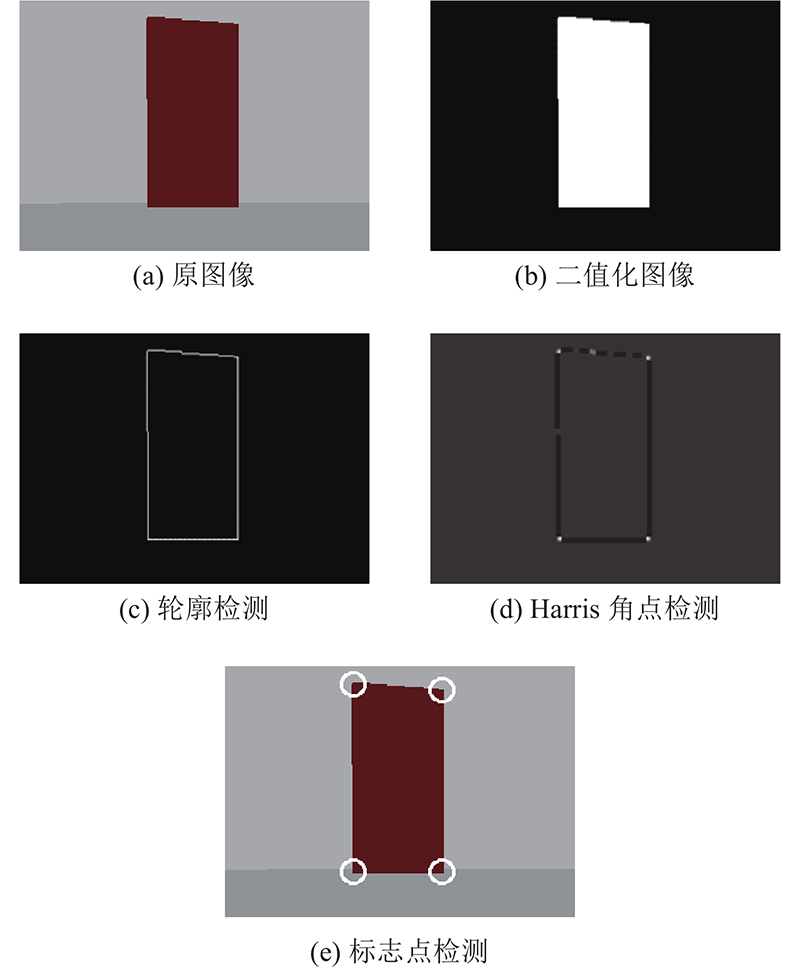

... 为了降低对处理器计算能力的要求,提高算法的鲁棒性,标志区域采用矩形区域,如图2 (a)所示,将矩形区域的4个角点作为需要提取的目标标志点. 处理器得到相机采集的图像后,通过颜色域的差别,将标志物与背景区分,对标志物与背景进行二值化处理,如图2 (b)所示. 提取二值化后图像中矩形区域的轮廓,得到轮廓最小外接矩形的角点信息,如图2 (c)所示. 在无人机运动过程中,标志物在相平面上会产生仿射变换,因此最小外接矩形的角点通常不是标志物的角点. 采用Harris角点检测法[19 ] ,对二值化图像进行角点检测,得到角点信息,如图2 (d)所示. 由于角点通常出现聚集的情况,采用非极大值抑制的方法. 选取所有Harris角点中,距离图2 (c)的外接轮廓的4个角点最近的4个Harris角点,如图2 (d)所示. 将得到的4个角点作为标志物的4个特征点,如图2 (e)所示. ...

1

... 为了验证提出算法的有效性与稳定性,将提出的算法与OpenVins[8 ] 与LARVIO[9 ] 2种开源VIO算法进行对比,采用Gazebo仿真引擎[20 ] 搭建仿真测试环境. 采用单目摄像头进行环境感知,所采集的RGB图像分辨率为 $500 \times 320$ 图3 所示. 测试环境周围的楼房主要为算法前端提供丰富的纹理信息. 环境中的矩形为本文设置的标志物,提供外环位姿修正信息. 在仿真环境下,共设置2种飞行轨迹,对3种算法进行比较与评估. ...