本文链接 :https://www.zjujournals.com/gcsjxb/CN/10.3785/j.issn.1006-754X.2025.04.111

煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] 。煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] 。现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] 。

目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用。然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题。因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] 。针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长。视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势。Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理。Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度。Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复。Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限。

上述研究为掘进装备视觉定位系统的移站自主标定提供了新思路。针对现有单目视觉定位系统合作标靶移站后标定过程烦琐以及无法实现自动连续测量的问题,本文提出了一种基于双目视觉的移站自主标定方法。该方法以双目相机作为数据采集装置,使用图像处理技术提取合作标靶图像中的点线特征,并采用移站标定解算模型来实现巷道坐标系下合作标靶空间参数的计算。

1 掘进装备视觉定位系统及标定原理

1.1 视觉定位系统

掘进装备视觉定位系统[8 ] 通过在开拓巷道上方安装3个矿用激光指向仪来形成视觉测量的合作标靶。在煤矿井下的复杂环境中,合作标靶的红色特征可作为与周围环境区分的主要特征,这在很大程度上降低了特征提取难度。该视觉定位系统采用机载防爆工业相机采集合作标靶图像,通过颜色分割和点线特征提取技术来获取图像的特征信息,并利用基于三点(perspective three-point, P3P)和三点三线(three-point-three-line, 3P3L)的视觉定位模型来解算掘进装备机身的位姿。

目前,掘进装备视觉定位技术在煤矿井下已得到广泛应用。然而,在掘进装备视觉定位过程中,合作标靶作为基准不动,随着掘进装备向前掘进,相机与合作标靶的距离逐渐增大并超出视觉测量系统的有效范围,加上巷道大幅度起伏的影响,易出现合作标靶图像特征丢失现象。为实现掘进装备的长距离连续定位,需要将合作标靶移站并重新标定标靶的空间参数。现有标定方法需人工利用全站仪进行测量标定,较为耗时。为解决上述问题,本文提出了一种基于双目视觉的掘进装备定位系统移站自主标定方法。视觉定位系统的移站过程如图1 所示。

图1

图1

掘进装备视觉定位系统移站过程示意

Fig.1

Schematic of station transfer process of visual positioning system for tunneling equipment

1.2 视觉定位系统移站自主标定原理

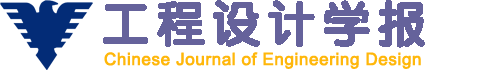

图1 所示掘进装备视觉定位系统的移站自主标定方法利用双目视觉技术测量合作标靶的3个激光光斑和3条激光束的空间参数,并将相机坐标系下合作标靶的空间参数转换至机身坐标系下后代入视觉定位系统,以完成移站自主标定。如图2 所示,设相机1坐标系与机身坐标系之间的齐次变换矩阵为M C 1 T M C 2 T C 2 C 1 T

图2

图2

掘进装备视觉定位系统移站自主标定原理

Fig.2

Automatic calibration principle for station transfer in visual positioning system of tunneling equipment

1.3 视觉定位系统移站自主标定方案

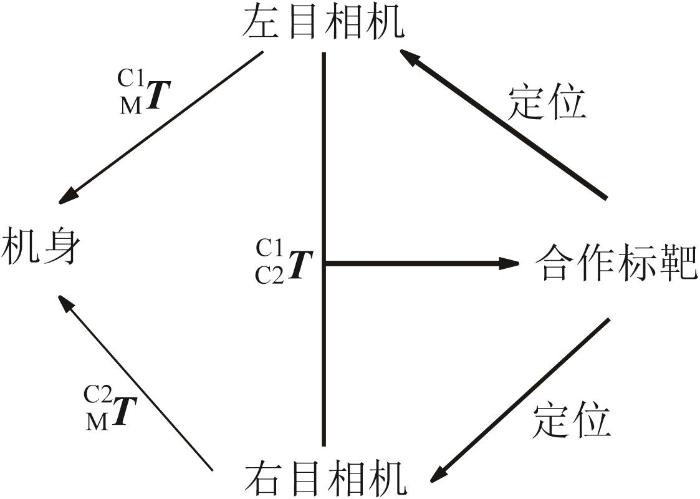

本文掘进装备视觉定位系统的移站自主标定方案如图3 所示,主要分为3个部分:机身位姿测量部分、图像处理部分和移站标定模型解算部分。

图3

图3

掘进装备视觉定位系统移站自主标定流程

Fig.3

Automatic calibration flow for station transfer in visual positioning system of tunneling equipment

首先,利用2台相机采集合作标靶图像,并对采集图像进行双边滤波、颜色空间转换、形态学膨胀和掩膜过滤等预处理,以减少杂光对图像的影响。然后,通过点线特征提取分别得到激光光斑和激光束特征,并分别计算图像坐标系下激光光斑中心的坐标与激光束中心直线的方程。最后,采用移站标定解算模型计算得到激光光斑中心的空间位置和激光束中心直线的空间方向向量,并基于L-M(Levenberg-Marquardt)算法得到合作标靶空间参数的最优解。为了验证视觉定位系统移站自主标定方法的性能,将基于该方法得到的合作标靶空间参数代入视觉定位系统,获得掘进装备机身的位姿,并以使用全站仪和惯性导航系统的测量值作为对照组真实值进行比较。基于双目视觉的移站自主标定方法采用双目视觉技术直接获取合作标靶的空间参数,避免了人工标定,有效地提高了掘进装备机身位姿的测量精度并减少了工作量。

2 合作标靶图像处理方法

在机器视觉测量领域[15 ] ,特征提取是关键环节。煤矿井下掘进巷道环境中存在杂光、粉尘、振动和水雾等影响因素,且这些因素随着环境的变化会产生较大差异,导致掘进装备视觉定位系统难以有效地提取激光光斑和激光束特征。为适应煤矿井下的复杂环境,实现合作标靶图像中激光光斑和激光束特征的精确提取,本文提出了一种基于颜色分割的点线特征提取方法,包括图像预处理、点特征提取和线特征提取三部分,如图4 所示。

图4

图4

合作标靶图像点线特征提取流程

Fig.4

Point and line feature extraction process of cooperative target image

2.1 图像预处理

为有效提取合作标靶图像中的激光光斑和激光束特征,本文采用图5 所示的预处理策略[16 ] :采用双边滤波算法去除图像中的噪声,并保留图像的边缘信息;考虑到RGB(red, green, blue,红色、绿色、蓝色)色彩空间在区分某些颜色方面的局限性,采用颜色空间转换方法将图像从RGB色彩空间转换到HSV(hue, saturation, value,色调、饱和度、明度)色彩空间。在HSV色彩空间中,色调提供了一个直观的方式来区分目标特征色(即红色),通过设置特定的色调阈值范围,形成原始图像的二值化图像,其中红色对应白色像素,其他颜色对应黑色像素。由于在实际应用中,激光束可能存在断裂,因此本文采用形态学膨胀来处理这些断裂的特征,使其更加完整和连续。通过上述图像预处理操作,可为后续的点、线特征提取提供高质量、清晰和一致的图像基础。

图5

图5

合作标靶图像预处理流程

Fig.5

Preprocessing process of cooperative target image

2.2 激光光斑中心提取

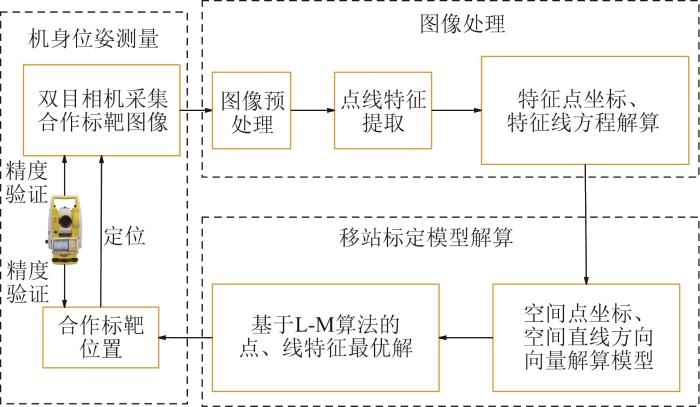

为了提取合作标靶图像中的3个激光光斑特征,采用基于椭圆拟合的提取方法[17 ] 。在完成图像预处理后,使用轮廓检测算法来定位图像中的红色区域。若检测到的红色区域数量不小于3,则进一步检查边界点的数量是否在设定范围(a , b )内。若在设定范围内,则计算这些区域内3个激光光斑所形成的最小外接矩形的高度和宽度,并根据最小外接矩形的高宽比去除噪音。随后,利用椭圆拟合法对激光光斑区域进行拟合,获取激光光斑中心的坐标。最后,求解各激光光斑中心之间的距离D 1 并与给定的范围(e , f )进行比较。若满足条件,则保留该激光光斑,最终保留3个激光光斑。将激光光斑中心的坐标代入掘进装备视觉定位系统的外参标定模型,计算得到其空间位置。激光光斑中心提取结果如图6 所示。

图6

图6

激光光斑中心提取结果

Fig.6

Laser spot center extraction result

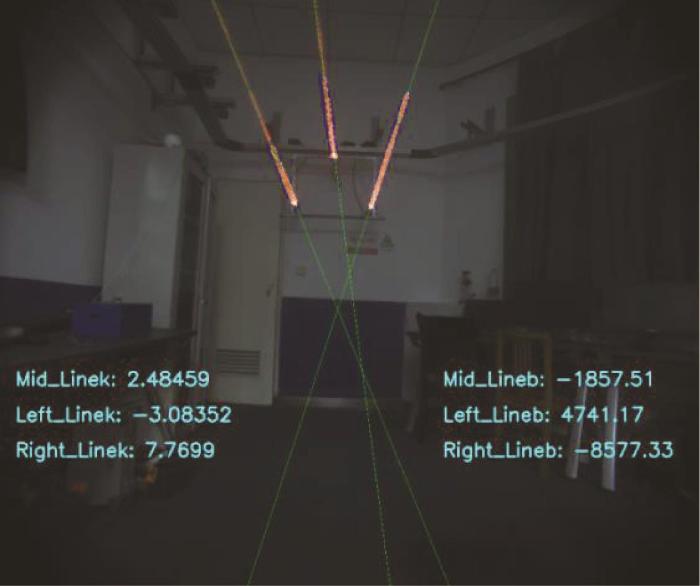

2.3 激光束中心直线提取

为了提取合作标靶图像中的激光束中心直线,使用Hough变换方法进行提取[18 -19 ] 。在提取过程中,为了提高激光束中心直线的检测精度,提出了一种基于特征点分析关联直线的方法。该方法的优势在于大大缩小了搜索范围,提高了激光束中心直线提取的准确性和效率。

首先,基于点特征提取结果确定合作标靶图像中可能存在线特征的区域,并采用Hough变换方法检测潜在的激光束中心直线。当检测到的激光束中心直线数量达到或超过3条时,进一步对这些激光束中心直线与已知的激光光斑进行分析。为了确保所检测到的激光束中心直线与激光光斑具有实际关联性,计算激光束中心直线与激光光斑中心之间的距离D 2 ,只有当D 2 满足给定范围(0, g )时,才认为所检测的激光束中心直线有效,最终保留3条激光束。激光束中心直线提取结果如图7 所示。

图7

图7

激光束中心直线提取结果

Fig.7

Laser beam center line extraction result

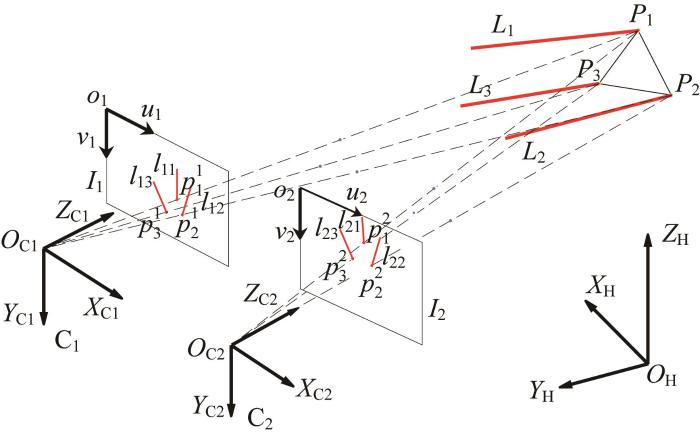

3 移站标定解算模型

本文基于P3P和3P3L视觉定位方法提出了移站自主标定方法,主要包括标定和定位两部分。在标定过程中,已知相机位置,解算合作标靶位置;在定位过程中,已知合作标靶位置,解算相机位置。借助2台相机所采集的合作标靶图像,构建基于双目立体几何的空间投影模型[20 ] 。图8 所示为合作标靶上激光光斑与激光束的投影示意。图8 中:Li (i =1, 2, 3)为3条朝巷道掘进方向的激光束中心直线,Pi (i =1, 2, 3)为3个激光光斑中心;O H -X H Y H Z H 为巷道坐标系,O C -X C Y C Z C 为相机坐标系;激光束中心直线Li 在相机C1 采集图像上的投影为l 1 i 2 采集图像上的投影为l 2 i

图8

图8

激光光斑和激光束投影示意图

Fig.8

Schematic diagram of laser spot and laser beam projection

3.1 激光光斑中心空间位置解算模型

如图8 所示,在相机坐标系下,给定激光光斑中心Pi (i =1, 2, 3)在相机C1 采集图像上的投影点为p i 1 2 采集图像上的投影点为p i 2 1 和相机C2 坐标系下的Z 坐标分别为Z c 1 Z c 2 1 采集图像上的投影点p i 1 ( u 1 i , v 1 i , 1 ) 2 采集图像上的投影点p i 2 ( u 2 i , v 2 i , 1 ) 1 和C2 的投影矩阵分别为M 1 M 2 Pi 在相机坐标系下的齐次坐标( X i , Y i , Z i , 1 )

Z c 1 u 1 i v 1 i 1 = M 1 X i Y i Z i 1 (1)

Z c 2 u 2 i v 2 i 1 = M 2 X i Y i Z i 1 (2)

M 1 = m 11 , 1 m 12 , 1 m 13 , 1 m 14 , 1 m 21 , 1 m 22 , 1 m 23 , 1 m 24 , 1 m 31 , 1 m 32 , 1 m 33 , 1 m 34 , 1

M 2 = m 11 , 2 m 12 , 2 m 13 , 2 m 14 , 2 m 21 , 2 m 22 , 2 m 23 , 2 m 24 , 2 m 31 , 2 m 32 , 2 m 33 , 2 m 34 , 2

式中:m k j , 1 m k j , 2 1 和C2 的内外参数计算得到的投影矩阵参数,可直接通过相机参数标定获得。

分别展开式(1)与式(2)并消去Z c 1 Z c 2

( u 1 i m 31 , 1 - m 11 , 1 ) X i + ( u 1 i m 32 , 1 - m 12 , 1 ) Y i + ( u 1 i m 33 , 1 - m 13 , 1 ) Z i = m 14 , 1 - u 1 i m 34 , 1 (3)

( v 1 i m 31 , 1 - m 21 , 1 ) X i + ( v 1 i m 32 , 1 - m 22 , 1 ) Y i + ( v 1 i m 33 , 1 - m 23 , 1 ) Z i = m 24 , 1 - v 1 i m 34 , 1 (4)

( u 2 i m 31 , 2 - m 11 , 2 ) X i + ( u 2 i m 32 , 2 - m 12 , 2 ) Y i + ( u 2 i m 33 , 2 - m 13 , 2 ) Z i = m 14 , 2 - u 2 i m 34 , 2 (5)

( v 2 i m 31 , 2 - m 21 , 2 ) X i + ( v 2 i m 32 , 2 - m 22 , 2 ) Y i + ( v 2 i m 33 , 2 - m 23 , 2 ) Z i = m 24 , 2 - v 2 i m 34 , 2 (6)

u 1 i m 31 , 1 - m 11 , 1 u 1 i m 32 , 1 - m 12 , 1 u 1 i m 33 , 1 - m 13 , 1 v 1 i m 31 , 1 - m 21 , 1 v 1 i m 32 , 1 - m 22 , 1 v 1 i m 33 , 1 - m 23 , 1 u 2 i m 31 , 2 - m 11 , 2 u 2 i m 32 , 2 - m 12 , 2 u 2 i m 33 , 2 - m 13 , 2 v 2 i m 31 , 2 - m 21 , 2 v 2 i m 32 , 2 - m 22 , 2 v 2 i m 33 , 2 - m 23 , 2 X i Y i Z i = m 14 , 1 - u 1 i m 34 , 1 m 24 , 1 - v 1 i m 34 , 1 m 14 , 2 - u 2 i m 34 , 2 m 24 , 2 - v 2 i m 34 , 2 (7)

利用式(7)可求得3个激光光斑中心在相机坐标系下的齐次坐标P i = X i , Y i , Z i , 1

2个相机坐标系与巷道坐标系的转换可通过旋转、平移或两者组合来实现。已知机身坐标系与相机坐标系之间的齐次变换矩阵为M C T H M T H C T

H C T = T H M T M C (8)

利用式(8)将相机坐标系中的激光光斑中心坐标转换到巷道坐标系中,可得:

P i H = T H C P i (9)

通过上述方法可得到对应激光光斑中心的空间位置,为实现合作标靶上激光光斑的标定提供了依据。

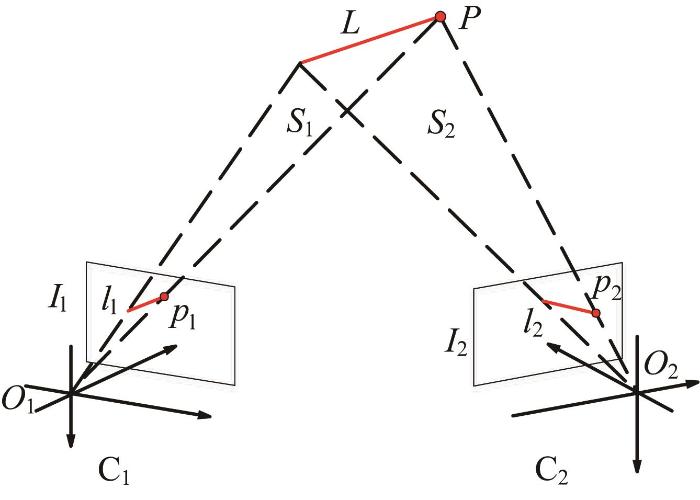

3.2 激光束中心直线空间方向向量解算模型

3条激光束为非平行激光束。因3条激光束中心直线方程的解算过程一致,本文以其中1条激光束为例进行解算推导。如图9 所示,激光束中心直线L 在2个相机所采集图像上的投影直线分别记为l 1 、l 2 。

图9

图9

激光束中心直线空间方向向量解算模型

Fig.9

Solution model of space direction vector of laser beam center line

已知2台相机的投影矩阵为 M 1 与 M 2 ,可得投影直线l 1 l 2

l 1 T u 1 = 0 l 2 T u 2 = 0 (10)

式中: u 1 、 u 2 分别为投影直线l 1 、l 2 上任意点的齐次坐标; l 1 、 l 2 分别为投影直线的方向向量,l 1 = l 11 , 1 , l 11 , 2 , l 11 , 3 T l 2 = l 21 , 1 , l 21 , 2 , l 21 , 3 T

分别在式(1)和式(2)两边左乘l 1 T

l 1 T Z c 1 u 1 = l 1 T M 1 x l 2 T Z c 2 u 2 = l 2 T M 2 x (11)

式(11)对于激光束中心直线上的任意点均成立,但若激光光斑中心P S 1 1 采集图像上的投影点必然在直线l 1 l 1 T Z c 1 u 1 = 0 l 2 T Z c 2 u 2 = 0

l 1 T M 1 x = 0 l 2 T M 2 x = 0 (12)

根据式(12),可分别推导得到3条激光束中心直线的空间方程:

l 1 i T M 1 x = 0 l 2 i T M 2 x = 0 (13)

利用式(13)可计算得到激光束中心直线在相机坐标系下的方向向量L i C = ( a c i , b c i , c c i ) 式(8)将相机坐标系下激光束中心直线的方向向量转换到巷道坐标系中,可得:

L i H = T H C L i C (14)

通过上述方法可获得对应的激光束中心直线空间方向向量,为实现合作标靶上激光束的标定提供了依据。

3.3 基于L-M 算法的特征最优解计算

在视觉定位系统移站标定过程中,2台相机与合作标靶的位置相对固定及两者均为静止状态,且双目相机提供了丰富的三维信息。但从同一视角拍摄的多张图像常因相机噪声、场景微小变化及计算误差等而导致双目视觉测量结果产生差异。为了提高测量结果的准确性,提出了一种基于L-M算法[21 ] 的数据融合方法。L-M算法兼具高斯-牛顿迭代法[22 ] 与梯度下降法的优点。在双目视觉测量过程中,L-M算法可以优化融合多个估计,使其与真实结果的差异最小化。L-M算法流程如图10 所示。

图10

图10

L-M 算法流程

Fig.10

L-M algorithm flow

首先,对于每个独立的位置数据,计算模型预测值与实际观测值之间的残差:

r t = p t - p (15)

式中:r t ( t = 1 , 2 , ⋯ , m ) p t t 个模型预测值,p

为了优化残差,计算相对于迭代模型参数的雅可比矩阵,从而确定模型参数对残差的影响。雅可比矩阵 J

J = ∂ r 1 ∂ t x ∂ r 1 ∂ t y ∂ r 1 ∂ t z ⋮ ⋮ ⋮ ∂ r m ∂ t x ∂ r m ∂ t y ∂ r m ∂ t z (16)

利用L-M算法的核心更新公式,迭代更新模型参数。其中,阻尼因子λ 的作用至关重要,其决定了L-M算法在高斯-牛顿迭代法和梯度下降法之间的平衡。更新公式如下:

J T J + λ I Δ p = - J T r (17)

式中: I Δ p r r = r 1 r 2 ⋯ r m T

通过调节阻尼因子λ ,可实现L-M算法在高斯-牛顿迭代法与梯度下降法之间的灵活切换。利用L-M算法对合作标靶空间参数进行优化,能够有效提高双目视觉测量的稳定性和精度。

4 实验验证

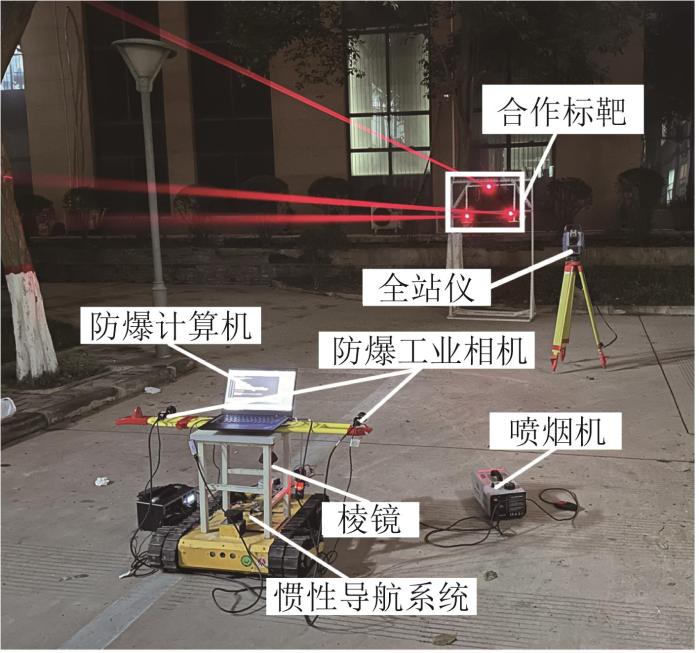

4.1 移站标定实验

为了验证基于双目视觉的掘进装备定位系统移站自主标定方法的精度,搭建相应的实验平台,如图11 所示。主要的实验设备包括掘进装备(用移动机器人模拟)、防爆计算机、2台MV-EMV510防爆工业相机、喷烟机、全站仪以及3个YHJ-800激光指向仪。其中,全站仪具有3个功能:一是通过建立巷道坐标系引入全局坐标,二是配合固定安装在机身上的棱镜获取机身实时位置,三是直接测量激光指向仪的位置。以平直路面模拟巷道,利用喷烟机模拟井下粉尘环境;由3个激光指向仪组成的合作标靶与相机的位置相对静止且距离约为3 m;双目相机用于采集合作标靶图像;防爆计算机作为系统处理和显示终端,用于处理相机传输的图像。

图11

图11

掘进装备视觉定位系统移站自主标定实验平台

Fig.11

Automatic calibration experiment platform for station transfer in visual positioning system of tunneling equipment

为了完成移站自主标定,开展标定实验。具体步骤如下:利用防爆计算机编写相机触发程序,以实时静态触发固定在掘进装备机身上的相机采集合作标靶的图像,设置采集时间间隔为150 ms;随后,在防爆计算机上完成对合作标靶图像的预处理、激光光斑中心和激光束中心直线的提取,并计算得到巷道坐标系下的激光光斑中心坐标与激光束中心直线方向向量。

在进行单次移站标定实验时,先对全站仪进行建站并将其位置作为巷道已知点来建立巷道坐标系,以掘进装备机身的结构中心为原点构建机身坐标系。随后,利用全站仪获取棱镜位置,以得到掘进装备的当前位置并保持不变,改变合作标靶位置,通过标定好的双目相机计算合作标靶的激光光斑中心坐标和激光束中心直线方向向量,并与全站仪直接获取的合作标靶空间参数进行对比,以验证基于双目视觉的移站自主标定方法的精度。为了避免偶然性,采用10个观测点的平均误差来评估移站自主标定结果的精度。

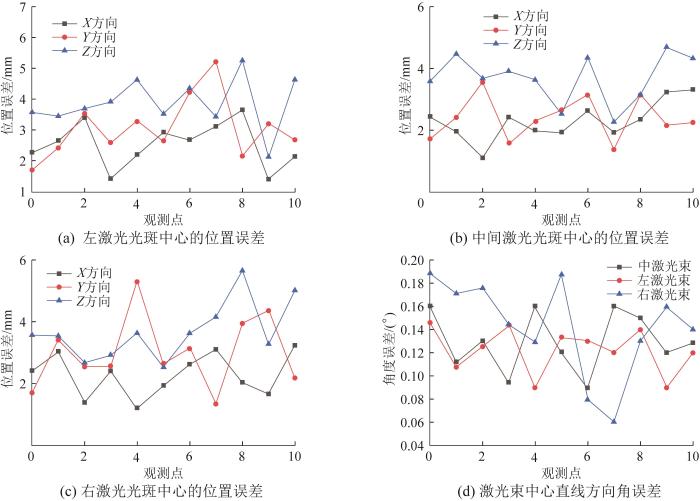

图12 所示为移站自主标定实验结果。其中,图12 (a)、图12 (b)、图12 (c)为3个激光光斑中心位置误差的测量结果。由图可得,3个激光光斑中心在X 方向上的平均位置误差为2.03,2.38,2.29 mm;在Y 方向上的平均位置误差为2.35,2.43,3.37 mm;在Z 方向上的平均位置误差为3.96,4.01,3.86 mm。图12 (d)所示为3条激光束中心直线方向向量角度误差的测量结果。由图可得,3条激光束中心直线方向向量的平均角度误差分别为0.13°,0.12°,0.14°。结果表明,本文所提出的移站自主标定方法的精度较高。

图12

图12

移站自主标定实验结果

Fig.12

Calibration experimental results for station transfer

4.2 移站标定方法性能测试

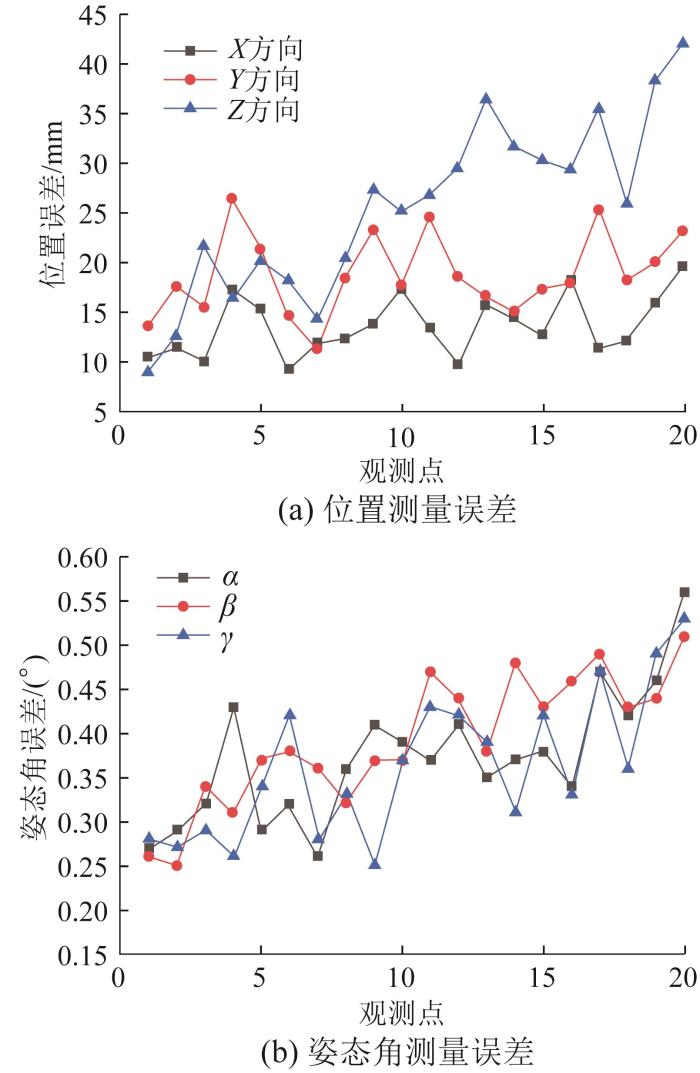

为了进一步验证基于双目视觉的掘进装备定位系统移站自主标定方法的合理性和实用性,在完成单次移站标定实验后,固定合作标靶,将上文标定得到的激光光斑中心坐标和激光束中心直线方向向量代入视觉定位系统,作为掘进装备机身位姿测量基准。为了模拟掘进装备真实的工作状态,控制机器人向前运动30 m,同步采集数据并进行处理。在机器人运动过程中寻找20个观测点,并以全站仪和棱镜获取的机身位置、以惯性导航系统获取的机身姿态角作为真实值进行对比,从而验证本文移站自主标定方法的性能。部分掘进装备机身位姿测量结果如表1 所示(表中α 、β 、γ 分别为俯仰角、偏航角和横滚角),机身位姿测量误差如图13 所示。

图13

图13

掘进装备机身位姿测量误差

Fig.13

Posture measurement error of tunneling equipment body

由表1 和图13 可知,在测量距离范围内,掘进装备机身位置和姿态角的测量值与真实值接近;机身位置在X 、Y 、Z 方向上的平均误差分别为19.59,23.13,41.98 mm,俯仰角α 、偏航角β 、横滚角γ 的平均误差分别为0.56°,0.51°,0.53°。实验结果表明,基于双目视觉的移站自主标定方法可满足掘进装备视觉定位系统的精度要求。

5 结 论

针对掘进装备单目视觉定位系统合作标靶移站后标定过程烦琐以及无法实现自动连续测量的问题,提出了一种基于双目视觉的移站自主标定方法。该方法通过双目视觉技术直接获取合作标靶的空间参数来实现移站自主标定,有效地提高了视觉定位效率与精度。主要结论如下:

1)基于工业相机采集的合作标靶图像,采用HSV颜色分割与点线特征提取技术有效地提取了图像中的激光光斑中心及激光束中心直线。

2)利用双目视觉技术实现了视觉定位系统移站自主标定。标定实验结果表明,3个激光光斑中心的位置误差在5 mm以内,3条激光束中心直线的角度误差在0.14°以内,说明所提出的标定方法具有较高精度。

3)在视觉定位系统完成移站标定后,在30 m的运动范围内,掘进装备机身的位置误差在50 mm以内,姿态角误差保持在0.6°以内。结果表明,所提出的移站自主标定方法可满足掘进装备视觉定位系统的精度要求。

参考文献

View Option

[1]

王国法 , 杜毅博 , 陈晓晶 , 等 从煤矿机械化到自动化和智能化的发展与创新实践: 纪念《工矿自动化》创刊50周年

[J]. 工矿自动化 , 2023 , 49 (6 ): 1 -18 .

[本文引用: 1]

WANG G F DU Y B CHEN X J et al Development and innovative practice from coal mine mechanization to automation and intelligence: commemorating the 50th anniversary of the founding of Journal of Mine Automation

[J]. Journal of Mine Automation , 2023 , 49 (6 ): 1 -18 .

[本文引用: 1]

[2]

杜雨馨 , 张贺 , 王树臣 , 等 综掘系统视觉处理技术研究现状及发展趋势

[J]. 工矿自动化 , 2023 , 49 (11 ): 22 -38 , 75 .

[本文引用: 1]

DU Y X ZHANG H WANG S C et al Research status and development trend of visual processing technology for fully mechanized excavation systems

[J]. Journal of Mine Automation , 2023 , 49 (11 ): 22 -38 , 75 .

[本文引用: 1]

[3]

田臣 , 覃杰 , 王强 , 等 煤矿智能掘进装备发展现状与关键技术探讨

[J]. 中国煤炭 , 2023 , 49 (7 ): 102 -108 .

[本文引用: 1]

TIAN C QIN J WANG Q et al Discussion on the development status and key technologies of intelligent excavation equipment in coal mines

[J]. China Coal , 2023 , 49 (7 ): 102 -108 .

[本文引用: 1]

[4]

田伟琴 , 田原 , 贾曲 , 等 悬臂式掘进机导航技术研究现状及发展趋势

[J]. 煤炭科学技术 , 2022 , 50 (3 ): 267 -274 .

[本文引用: 1]

TIAN W Q TIAN Y JIA Q et al Research status and development trend of cantilever roadheader navigation technology

[J]. Coal Science and Technology , 2022 , 50 (3 ): 267 -274 .

[本文引用: 1]

[6]

张旭辉 , 沈奇峰 , 杨文娟 , 等 基于三激光点标靶的掘进机机身视觉定位技术研究

[J]. 电子测量与仪器学报 , 2022 , 36 (6 ): 178 -186 .

[本文引用: 1]

ZHANG X H SHEN Q F YANG W J et al Research on visual positioning technology of roadheader body based on three laser point target

[J]. Journal of Electronic Measurement and Instrumentation , 2022 , 36 (6 ): 178 -186 .

[本文引用: 1]

[7]

杨文娟 , 张旭辉 , 马宏伟 , 等 悬臂式掘进机机身及截割头位姿视觉测量系统研究

[J]. 煤炭科学技术 , 2019 , 47 (6 ): 50 -57 .

YANG W J ZHANG X H MA H W et al Research on position and posture measurement system of body and cutting head for boom-type roadheader based on machine vision

[J]. Coal Science and Technology , 2019 , 47 (6 ): 50 -57 .

[8]

杨文娟 , 张旭辉 , 张超 , 等 基于三激光束标靶的煤矿井下长距离视觉定位方法

[J]. 煤炭学报 , 2022 , 47 (2 ): 986 -1001 .

[本文引用: 2]

YANG W J ZHANG X H ZHANG C et al Long distance vision localization method based on triple laser beams target in coal mine

[J]. Journal of China Coal Society , 2022 , 47 (2 ): 986 -1001 .

[本文引用: 2]

[9]

杨健健 , 张强 , 吴淼 , 等 巷道智能化掘进的自主感知及调控技术研究进展

[J]. 煤炭学报 , 2020 , 45 (6 ): 2045 -2055 .

[本文引用: 1]

YANG J J ZHANG Q WU M et al Research progress of autonomous perception and control technology for intelligent heading

[J]. Journal of China Coal Society , 2020 , 45 (6 ): 2045 -2055 .

[本文引用: 1]

[10]

张旭辉 , 张楷鑫 , 张超 , 等 悬臂式掘进机视觉位姿检测系统外参标定方法

[J]. 机械科学与技术 , 2022 , 41 (12 ): 1928 -1935 .

[本文引用: 1]

ZHANG X H ZHANG K X ZHANG C et al Calibrating external parameters of visual position detection system of cantilever roadheader

[J]. Mechanical Science and Technology for Aerospace Engineering , 2022 , 41 (12 ): 1928 -1935 .

[本文引用: 1]

[11]

ZOU X J ZOU H X LU J Virtual manipulator-based binocular stereo vision positioning system and errors modelling

[J]. Machine Vision and Applications , 2012 , 23 (1 ): 43 -63 .

[本文引用: 1]

[12]

MA W P LI W X CAO P X Binocular vision object positioning method for robots based on coarse-fine stereo matching

[J]. International Journal of Automation and Computing , 2020 , 17 (4 ): 562 -571 .

[本文引用: 1]

[13]

LU K WANG X Y WANG Z et al Binocular stereo vision based on OpenCV

[C]//IET International Conference on Smart and Sustainable City . Shanghai, Jul . 6 -8 , 2011 .

[本文引用: 1]

[14]

LAI X B WANG H S XU Y H A real-time range finding system with binocular stereo vision

[J]. International Journal of Advanced Robotic Systems , 2012 , 9 (1 ): 26 .

[本文引用: 1]

[15]

刘勇 基于机器视觉的掘进机截割头姿态检测系统

[J]. 煤矿机械 , 2020 , 41 (3 ): 187 -189 .

[本文引用: 1]

LIU Y Attitude detection system of cutting head of roadheader based on machine vision

[J]. Coal Mine Machinery , 2020 , 41 (3 ): 187 -189 .

[本文引用: 1]

[16]

张杜娟 基于肤色模型与颜色空间的目标识别算法

[J]. 国外电子测量技术 , 2019 , 38 (10 ): 54 -58 .

[本文引用: 1]

ZHANG D J Target recognition algorithm based on skin color model and color space

[J]. Foreign Electronic Measurement Technology , 2019 , 38 (10 ): 54 -58 .

[本文引用: 1]

[17]

[本文引用: 1]

WANG N SONG H H ZHANG K H Accurate object tracking algorithm based on distance weighting overlap prediction and ellipse fitting optimization

[J]. Journal of Computer Applications , 2021 , 41 (4 ): 1100 -1105 .

DOI:10.11772/j.issn.1001-9081.2020060869

[本文引用: 1]

[18]

刘爱胤 , 熊根良 , 姚健康 , 等 基于霍夫圆检测的标志物多图像特征定位方法

[J]. 计算机仿真 , 2021 , 38 (3 ): 341 -345 .

[本文引用: 1]

LIU A Y XIONG G L YAO J K et al Marker localization method on multiple image features based on Hough circle detection

[J]. Computer Simulation , 2021 , 38 (3 ): 341 -345 .

[本文引用: 1]

[19]

王学敏 , 于洪波 , 张翔宇 , 等 基于Hough变换检测前跟踪的水下多目标被动检测方法

[J]. 兵工学报 , 2023 , 44 (7 ): 2114 -2121 .

[本文引用: 1]

WANG X M YU H B ZHANG X Y et al Underwater multi-target detection method based on Hough transform track-before-detect technique

[J]. Acta Armamentarii , 2023 , 44 (7 ): 2114 -2121 .

[本文引用: 1]

[20]

马颂德 , 张正友 计算机视觉: 计算理论与算法基础 [M]. 北京 : 科学出版社 , 1998 : 52 -73 .

[本文引用: 1]

MA S D ZHANG Z Y Computer vision: fundamentals of computational theory and algorithms [M]. Beijing : Science Press , 1998 : 52 -73 .

[本文引用: 1]

[21]

[本文引用: 1]

ZHOU A G YU J Y PU J K et al Positioning algorithm of homonymous object points in multi-vision system based on weighted Levenberg-Marquardt

[J]. Laser & Optoelectronics Progress , 2021 , 58 (24 ): 351 -359 .

DOI:10.3788/lop202158.2415006

[本文引用: 1]

[22]

孔瑞金 , 胡祥云 , 蔡红柱 基于Gramian约束与高斯-牛顿算法的重磁三维联合反演

[J]. 地球物理学报 , 2023 , 66 (8 ): 3493 -3513 .

[本文引用: 1]

KONG R J HU X Y CAI H Z Three-dimensional joint inversion of gravity and magnetic data using Gramian constraints and Gauss-Newton method

[J]. Chinese Journal of Geophysics , 2023 , 66 (8 ): 3493 -3513 .

[本文引用: 1]

从煤矿机械化到自动化和智能化的发展与创新实践: 纪念《工矿自动化》创刊50周年

1

2023

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

从煤矿机械化到自动化和智能化的发展与创新实践: 纪念《工矿自动化》创刊50周年

1

2023

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

综掘系统视觉处理技术研究现状及发展趋势

1

2023

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

综掘系统视觉处理技术研究现状及发展趋势

1

2023

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

煤矿智能掘进装备发展现状与关键技术探讨

1

2023

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

煤矿智能掘进装备发展现状与关键技术探讨

1

2023

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

悬臂式掘进机导航技术研究现状及发展趋势

1

2022

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

悬臂式掘进机导航技术研究现状及发展趋势

1

2022

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

煤矿巷道智能化掘进感知关键技术

1

2021

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

煤矿巷道智能化掘进感知关键技术

1

2021

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

基于三激光点标靶的掘进机机身视觉定位技术研究

1

2022

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

基于三激光点标靶的掘进机机身视觉定位技术研究

1

2022

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

悬臂式掘进机机身及截割头位姿视觉测量系统研究

0

2019

悬臂式掘进机机身及截割头位姿视觉测量系统研究

0

2019

基于三激光束标靶的煤矿井下长距离视觉定位方法

2

2022

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

... 掘进装备视觉定位系统[8 ] 通过在开拓巷道上方安装3个矿用激光指向仪来形成视觉测量的合作标靶.在煤矿井下的复杂环境中,合作标靶的红色特征可作为与周围环境区分的主要特征,这在很大程度上降低了特征提取难度.该视觉定位系统采用机载防爆工业相机采集合作标靶图像,通过颜色分割和点线特征提取技术来获取图像的特征信息,并利用基于三点(perspective three-point, P3P)和三点三线(three-point-three-line, 3P3L)的视觉定位模型来解算掘进装备机身的位姿. ...

基于三激光束标靶的煤矿井下长距离视觉定位方法

2

2022

... 煤矿智能化对现代工矿领域的发展具有重要意义[1 -2 ] .煤矿掘进装备作为煤炭开采行业不可或缺的采掘装置[3 ] ,其机身的自动定位是实现煤矿井下智能化和少人化的关键,已成为煤炭领域的研究热点之一[4 -5 ] .现阶段,单目视觉定位技术是煤矿掘进装备机身位姿测量的重要手段之一[6 -8 ] . ...

... 掘进装备视觉定位系统[8 ] 通过在开拓巷道上方安装3个矿用激光指向仪来形成视觉测量的合作标靶.在煤矿井下的复杂环境中,合作标靶的红色特征可作为与周围环境区分的主要特征,这在很大程度上降低了特征提取难度.该视觉定位系统采用机载防爆工业相机采集合作标靶图像,通过颜色分割和点线特征提取技术来获取图像的特征信息,并利用基于三点(perspective three-point, P3P)和三点三线(three-point-three-line, 3P3L)的视觉定位模型来解算掘进装备机身的位姿. ...

巷道智能化掘进的自主感知及调控技术研究进展

1

2020

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

巷道智能化掘进的自主感知及调控技术研究进展

1

2020

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

悬臂式掘进机视觉位姿检测系统外参标定方法

1

2022

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

悬臂式掘进机视觉位姿检测系统外参标定方法

1

2022

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

Virtual manipulator-based binocular stereo vision positioning system and errors modelling

1

2012

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

Binocular vision object positioning method for robots based on coarse-fine stereo matching

1

2020

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

Binocular stereo vision based on OpenCV

1

2011

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

A real-time range finding system with binocular stereo vision

1

2012

... 目前,煤矿掘进装备视觉定位技术在煤矿智能定位领域得到了广泛应用.然而,由于现场环境恶劣,单目视觉定位系统在实际应用中存在合作标靶移站后标定过程烦琐、无法自动连续测量的问题.因此,研究复杂工况下煤矿掘进装备视觉定位系统的移站自主标定方法,对于提高掘进工作面智能化水平和掘进安全性具有重要意义[9 ] .针对单目视觉定位系统的移站自主标定问题,张旭辉等[10 ] 采用全站仪进行移站标定,该方法受环境因素影响较小且具有较高的测量精度,但需要人工使用全站仪测量合作标靶的参数来进行标定,耗时较长.视觉测量系统利用光学成像原理和位姿解算模型来求解被测目标的相对位置和姿态角,具有结构简单、性价比高等优势.Zou等[11 ] 针对复杂环境下移动机器人的定位问题,提出了一种基于虚拟机械臂的双目立体视觉定位系统并阐述了其定位原理.Ma等[12 ] 提出了一种基于粗-精立体匹配的双目视觉定位方法,该方法利用双目视觉模型的相似三角形原理来计算中心点的三维坐标,可通过周围环境或目标物对机器人进行实时位姿测量,具有较高的定位精度.Lu等[13 ] 提出了一种基于OpenCV的双目立体视觉技术,实现了对物体深度信息的恢复.Lai等[14 ] 提出了一种基于TMS320DM642 DSP(digital signal processor,数字信号处理器)的双目立体视觉测距系统,该系统采用基于特征的局部立体匹配算法来确定机器人的空间位置,具有较高的测量精度,但由于双目相机的基线较短,系统的有效测量范围受限. ...

基于机器视觉的掘进机截割头姿态检测系统

1

2020

... 在机器视觉测量领域[15 ] ,特征提取是关键环节.煤矿井下掘进巷道环境中存在杂光、粉尘、振动和水雾等影响因素,且这些因素随着环境的变化会产生较大差异,导致掘进装备视觉定位系统难以有效地提取激光光斑和激光束特征.为适应煤矿井下的复杂环境,实现合作标靶图像中激光光斑和激光束特征的精确提取,本文提出了一种基于颜色分割的点线特征提取方法,包括图像预处理、点特征提取和线特征提取三部分,如图4 所示. ...

基于机器视觉的掘进机截割头姿态检测系统

1

2020

... 在机器视觉测量领域[15 ] ,特征提取是关键环节.煤矿井下掘进巷道环境中存在杂光、粉尘、振动和水雾等影响因素,且这些因素随着环境的变化会产生较大差异,导致掘进装备视觉定位系统难以有效地提取激光光斑和激光束特征.为适应煤矿井下的复杂环境,实现合作标靶图像中激光光斑和激光束特征的精确提取,本文提出了一种基于颜色分割的点线特征提取方法,包括图像预处理、点特征提取和线特征提取三部分,如图4 所示. ...

基于肤色模型与颜色空间的目标识别算法

1

2019

... 为有效提取合作标靶图像中的激光光斑和激光束特征,本文采用图5 所示的预处理策略[16 ] :采用双边滤波算法去除图像中的噪声,并保留图像的边缘信息;考虑到RGB(red, green, blue,红色、绿色、蓝色)色彩空间在区分某些颜色方面的局限性,采用颜色空间转换方法将图像从RGB色彩空间转换到HSV(hue, saturation, value,色调、饱和度、明度)色彩空间.在HSV色彩空间中,色调提供了一个直观的方式来区分目标特征色(即红色),通过设置特定的色调阈值范围,形成原始图像的二值化图像,其中红色对应白色像素,其他颜色对应黑色像素.由于在实际应用中,激光束可能存在断裂,因此本文采用形态学膨胀来处理这些断裂的特征,使其更加完整和连续.通过上述图像预处理操作,可为后续的点、线特征提取提供高质量、清晰和一致的图像基础. ...

基于肤色模型与颜色空间的目标识别算法

1

2019

... 为有效提取合作标靶图像中的激光光斑和激光束特征,本文采用图5 所示的预处理策略[16 ] :采用双边滤波算法去除图像中的噪声,并保留图像的边缘信息;考虑到RGB(red, green, blue,红色、绿色、蓝色)色彩空间在区分某些颜色方面的局限性,采用颜色空间转换方法将图像从RGB色彩空间转换到HSV(hue, saturation, value,色调、饱和度、明度)色彩空间.在HSV色彩空间中,色调提供了一个直观的方式来区分目标特征色(即红色),通过设置特定的色调阈值范围,形成原始图像的二值化图像,其中红色对应白色像素,其他颜色对应黑色像素.由于在实际应用中,激光束可能存在断裂,因此本文采用形态学膨胀来处理这些断裂的特征,使其更加完整和连续.通过上述图像预处理操作,可为后续的点、线特征提取提供高质量、清晰和一致的图像基础. ...

基于距离加权重叠度估计与椭圆拟合优化的精确目标跟踪算法

1

2021

... 为了提取合作标靶图像中的3个激光光斑特征,采用基于椭圆拟合的提取方法[17 ] .在完成图像预处理后,使用轮廓检测算法来定位图像中的红色区域.若检测到的红色区域数量不小于3,则进一步检查边界点的数量是否在设定范围(a , b )内.若在设定范围内,则计算这些区域内3个激光光斑所形成的最小外接矩形的高度和宽度,并根据最小外接矩形的高宽比去除噪音.随后,利用椭圆拟合法对激光光斑区域进行拟合,获取激光光斑中心的坐标.最后,求解各激光光斑中心之间的距离D 1 并与给定的范围(e , f )进行比较.若满足条件,则保留该激光光斑,最终保留3个激光光斑.将激光光斑中心的坐标代入掘进装备视觉定位系统的外参标定模型,计算得到其空间位置.激光光斑中心提取结果如图6 所示. ...

基于距离加权重叠度估计与椭圆拟合优化的精确目标跟踪算法

1

2021

... 为了提取合作标靶图像中的3个激光光斑特征,采用基于椭圆拟合的提取方法[17 ] .在完成图像预处理后,使用轮廓检测算法来定位图像中的红色区域.若检测到的红色区域数量不小于3,则进一步检查边界点的数量是否在设定范围(a , b )内.若在设定范围内,则计算这些区域内3个激光光斑所形成的最小外接矩形的高度和宽度,并根据最小外接矩形的高宽比去除噪音.随后,利用椭圆拟合法对激光光斑区域进行拟合,获取激光光斑中心的坐标.最后,求解各激光光斑中心之间的距离D 1 并与给定的范围(e , f )进行比较.若满足条件,则保留该激光光斑,最终保留3个激光光斑.将激光光斑中心的坐标代入掘进装备视觉定位系统的外参标定模型,计算得到其空间位置.激光光斑中心提取结果如图6 所示. ...

基于霍夫圆检测的标志物多图像特征定位方法

1

2021

... 为了提取合作标靶图像中的激光束中心直线,使用Hough变换方法进行提取[18 -19 ] .在提取过程中,为了提高激光束中心直线的检测精度,提出了一种基于特征点分析关联直线的方法.该方法的优势在于大大缩小了搜索范围,提高了激光束中心直线提取的准确性和效率. ...

基于霍夫圆检测的标志物多图像特征定位方法

1

2021

... 为了提取合作标靶图像中的激光束中心直线,使用Hough变换方法进行提取[18 -19 ] .在提取过程中,为了提高激光束中心直线的检测精度,提出了一种基于特征点分析关联直线的方法.该方法的优势在于大大缩小了搜索范围,提高了激光束中心直线提取的准确性和效率. ...

基于Hough变换检测前跟踪的水下多目标被动检测方法

1

2023

... 为了提取合作标靶图像中的激光束中心直线,使用Hough变换方法进行提取[18 -19 ] .在提取过程中,为了提高激光束中心直线的检测精度,提出了一种基于特征点分析关联直线的方法.该方法的优势在于大大缩小了搜索范围,提高了激光束中心直线提取的准确性和效率. ...

基于Hough变换检测前跟踪的水下多目标被动检测方法

1

2023

... 为了提取合作标靶图像中的激光束中心直线,使用Hough变换方法进行提取[18 -19 ] .在提取过程中,为了提高激光束中心直线的检测精度,提出了一种基于特征点分析关联直线的方法.该方法的优势在于大大缩小了搜索范围,提高了激光束中心直线提取的准确性和效率. ...

1

1998

... 本文基于P3P和3P3L视觉定位方法提出了移站自主标定方法,主要包括标定和定位两部分.在标定过程中,已知相机位置,解算合作标靶位置;在定位过程中,已知合作标靶位置,解算相机位置.借助2台相机所采集的合作标靶图像,构建基于双目立体几何的空间投影模型[20 ] .图8 所示为合作标靶上激光光斑与激光束的投影示意.图8 中:Li (i =1, 2, 3)为3条朝巷道掘进方向的激光束中心直线,Pi (i =1, 2, 3)为3个激光光斑中心;O H -X H Y H Z H 为巷道坐标系,O C -X C Y C Z C 为相机坐标系;激光束中心直线Li 在相机C1 采集图像上的投影为l 1 i 2 采集图像上的投影为l 2 i

1

1998

... 本文基于P3P和3P3L视觉定位方法提出了移站自主标定方法,主要包括标定和定位两部分.在标定过程中,已知相机位置,解算合作标靶位置;在定位过程中,已知合作标靶位置,解算相机位置.借助2台相机所采集的合作标靶图像,构建基于双目立体几何的空间投影模型[20 ] .图8 所示为合作标靶上激光光斑与激光束的投影示意.图8 中:Li (i =1, 2, 3)为3条朝巷道掘进方向的激光束中心直线,Pi (i =1, 2, 3)为3个激光光斑中心;O H -X H Y H Z H 为巷道坐标系,O C -X C Y C Z C 为相机坐标系;激光束中心直线Li 在相机C1 采集图像上的投影为l 1 i 2 采集图像上的投影为l 2 i

基于加权Levenberg-Marquardt的多目视觉同名物点定位算法

1

2021

... 在视觉定位系统移站标定过程中,2台相机与合作标靶的位置相对固定及两者均为静止状态,且双目相机提供了丰富的三维信息.但从同一视角拍摄的多张图像常因相机噪声、场景微小变化及计算误差等而导致双目视觉测量结果产生差异.为了提高测量结果的准确性,提出了一种基于L-M算法[21 ] 的数据融合方法.L-M算法兼具高斯-牛顿迭代法[22 ] 与梯度下降法的优点.在双目视觉测量过程中,L-M算法可以优化融合多个估计,使其与真实结果的差异最小化.L-M算法流程如图10 所示. ...

基于加权Levenberg-Marquardt的多目视觉同名物点定位算法

1

2021

... 在视觉定位系统移站标定过程中,2台相机与合作标靶的位置相对固定及两者均为静止状态,且双目相机提供了丰富的三维信息.但从同一视角拍摄的多张图像常因相机噪声、场景微小变化及计算误差等而导致双目视觉测量结果产生差异.为了提高测量结果的准确性,提出了一种基于L-M算法[21 ] 的数据融合方法.L-M算法兼具高斯-牛顿迭代法[22 ] 与梯度下降法的优点.在双目视觉测量过程中,L-M算法可以优化融合多个估计,使其与真实结果的差异最小化.L-M算法流程如图10 所示. ...

基于Gramian约束与高斯-牛顿算法的重磁三维联合反演

1

2023

... 在视觉定位系统移站标定过程中,2台相机与合作标靶的位置相对固定及两者均为静止状态,且双目相机提供了丰富的三维信息.但从同一视角拍摄的多张图像常因相机噪声、场景微小变化及计算误差等而导致双目视觉测量结果产生差异.为了提高测量结果的准确性,提出了一种基于L-M算法[21 ] 的数据融合方法.L-M算法兼具高斯-牛顿迭代法[22 ] 与梯度下降法的优点.在双目视觉测量过程中,L-M算法可以优化融合多个估计,使其与真实结果的差异最小化.L-M算法流程如图10 所示. ...

基于Gramian约束与高斯-牛顿算法的重磁三维联合反演

1

2023

... 在视觉定位系统移站标定过程中,2台相机与合作标靶的位置相对固定及两者均为静止状态,且双目相机提供了丰富的三维信息.但从同一视角拍摄的多张图像常因相机噪声、场景微小变化及计算误差等而导致双目视觉测量结果产生差异.为了提高测量结果的准确性,提出了一种基于L-M算法[21 ] 的数据融合方法.L-M算法兼具高斯-牛顿迭代法[22 ] 与梯度下降法的优点.在双目视觉测量过程中,L-M算法可以优化融合多个估计,使其与真实结果的差异最小化.L-M算法流程如图10 所示. ...