[1]

邵丽青, 易钶 我国电动重卡市场发展现状

[J]. 专用汽车 , 2022 , (10 ): 1 - 3

[本文引用: 1]

SHAO Liqing, YI Ke Development status of electric heavy truck market in China

[J]. Special Purpose Vehicle , 2022 , (10 ): 1 - 3

[本文引用: 1]

[2]

杨卢强, 韩通新, 王志良 高速动车组受电弓安全检测的研究

[J]. 铁道运输与经济 , 2017 , 39 (8 ): 66 - 71

[本文引用: 1]

YANG Luqiang, HAN Tongxin, WANG Zhiliang Study on safety detection of high-speed emu pantograph

[J]. Railway Transport and Economy , 2017 , 39 (8 ): 66 - 71

[本文引用: 1]

[3]

零碳排放!我国首款双源智能重卡成功下线[EB/OL]. (2023-03-14) [2023-08-01]. https://news.bjd.com.cn/2023/03/14/10364351.shtml.

[本文引用: 2]

[4]

周宁, 杨文杰, 刘久锐, 等 基于受电弓状态感知的弓网安全监测系统研究与探讨

[J]. 中国科学: 技术科学 , 2021 , 51 (1 ): 23 - 34

DOI:10.1360/SST-2019-0282

[本文引用: 1]

ZHOU Ning, YANG Wenjie, LlU Jiurui, et al Investigation of a pantograph-catenary monitoring system using condition-based pantograph recognition

[J]. Scientia Sinica: Technologica , 2021 , 51 (1 ): 23 - 34

DOI:10.1360/SST-2019-0282

[本文引用: 1]

[5]

KARAKOSE E, GENCOGLU M T, KARAKOSE M, et al A new experimental approach using image processing-based tracking for an efficient fault diagnosis in pantograph-catenary systems

[J]. IEEE Transactions on Industrial Informatics , 2017 , 13 (2 ): 635 - 643

DOI:10.1109/TII.2016.2628042

[本文引用: 1]

[6]

AYDIN I, KARAKOSE M, AKIN E A new contactless fault diagnosis approach for pantograph-catenary system using pattern recognition and image processing methods

[J]. Advances in Electrical and Computer Engineering , 2014 , 14 (3 ): 79 - 88

DOI:10.4316/AECE.2014.03010

[本文引用: 1]

[7]

范虎伟, 卞春华, 朱挺, 等 非接触式接触网定位器坡度自动检测技术

[J]. 计算机应用 , 2010 , 30 (Suppl.2 ): 102 - 103

[本文引用: 1]

FAN Huwei, BIAN Chunhua, ZHU Ting, et al Automatic detection of positioning line in contactless overhead contact system

[J]. Journal of Computer Applications , 2010 , 30 (Suppl.2 ): 102 - 103

[本文引用: 1]

[8]

张桂南, 刘志刚. 基于角点匹配与谱聚类的接触网绝缘子破损/夹杂异物故障检测[J]. 仪器仪表学报, 2014, 35(6): 1370−1377.

[本文引用: 1]

ZHANG Guinan, LIU Zhigang. Fault detection of catenary insulator damage/foreign material based on corner matching and spectral clustering [J]. Chinese Journal of Scientific Instrument , 2014, 35(6): 1370−1376.

[本文引用: 1]

[9]

ZHANG D, GAO S, YU L, et al A robust pantograph-catenary interaction condition monitoring method based on deep convolutional network

[J]. IEEE Transactions on Instrumentation and Measurement , 2019 , 69 (5 ): 1920 - 1929

[本文引用: 2]

[10]

CHEN R, LIN Y, JIN T High-speed railway pantograph-catenary anomaly detection method based on depth vision neural network

[J]. IEEE Transactions on Instrumentation and Measurement , 2022 , 71 : 1 - 10

[本文引用: 2]

[11]

YANG X, ZHOU N, LIU Y, et al Online pantograph-catenary contact point detection in complicated background based on multiple strategies

[J]. IEEE Access , 2020 , 8 : 220394 - 220407

DOI:10.1109/ACCESS.2020.3042535

[本文引用: 2]

[12]

张乔木, 钟倩文, 孙明, 等 复杂环境下弓网接触位置动态监测方法研究

[J]. 电子科技 , 2022 , 35 (8 ): 66 - 72

[本文引用: 1]

ZHANG Qiaomu, ZHONG Qianwan, SUN Ming, et al Research on dynamic monitoring method of pantograph net contact position in complex environment

[J]. Electronic Science and Technology , 2022 , 35 (8 ): 66 - 72

[本文引用: 1]

[13]

王恩鸿, 柴晓冬, 钟倩文, 等 基于视频图像的弓网接触位置动态监测方法

[J]. 城市轨道交通研究 , 2021 , 24 (7 ): 198 - 203

[本文引用: 2]

WANG Enhong, CHAI Xiaodong, ZHONG Qianwen, et al Dynamic monitoring method of pantograph-caternary contact position based on video image

[J]. Urban Mass Transit , 2021 , 24 (7 ): 198 - 203

[本文引用: 2]

[14]

LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Boston: IEEE, 2015: 3431−3440.

[本文引用: 3]

[15]

RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation [C]// Medical Image Computing and Computer-Assisted Intervention MICCAI 2015: 18th International Conference . Munich: Springer, 2015: 234−241.

[本文引用: 1]

[16]

HOWARD A, SANDLER M, CHU G, et al. Searching for mobilenetv3 [C]// International Conference on Computer Vision . Seoul: IEEE, 2019: 1314−1324.

[本文引用: 2]

[17]

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs [EB/OL]. (2014−12-22) [2023-08-01]. https://arxiv.org/abs/ 1412.7062.

[本文引用: 1]

[18]

CHEN L C, PAPANDREOU G, KOKKINOS I, et al Deeplab semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2017 , 40 (4 ): 834 - 848

[19]

CHEN L C, ZHU Y, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation [C]// Proceedings of the European Conference on Computer Vision . Munich: Springer, 2018: 801−818.

[本文引用: 3]

[20]

ZHAO H, SHI J, QI X, et al. Pyramid scene parsing network [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 2881−2890.

[本文引用: 4]

[21]

YANG M, YU K, ZHANG C, et al. DenseASPP for semantic segmentation in street scenes [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018, 3684−3692.

[本文引用: 2]

[22]

YU C, WANG J, PENG C, et al. BiSeNet: bilateral seg-mentation network for real-time semantic segmentation [C]// Proceedings of the European Conference on Computer Vision . Munich : Springer, 2018: 325−341.

[本文引用: 3]

[23]

YU C, GAO C, WANG J, et al BiSeNet v2: bilateral network with guided aggregation for real-time semantic segmentation

[J]. International Journal of Computer Vision , 2021 , 129 : 3051 - 3068

DOI:10.1007/s11263-021-01515-2

[本文引用: 5]

[24]

HU J, SHEN L, SUN G. Squeeze-and-excitation networks [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 7132−7141.

[本文引用: 2]

[25]

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [EB/OL]. (2015-04-10) [2023-08-01] . http://arxiv.org/abs/1409.1556.

[本文引用: 2]

[26]

任凤雷, 杨璐, 周海波, 等. 基于改进BiSeNet的实时图像语义分割[J]. 光学精密工程, 2023, 31(8): 1217−1227.

[本文引用: 1]

REN Fenglei, YANG Lu, ZHOU Haibo, et al. Real-time semantic segmentation based on improved BiSeNet[J] Optics and Precision Engineering, 2023, 31(8): 1217−1227.

[本文引用: 1]

[27]

XU Q, MA Y, WU J, et al. Faster BiSeNet: a faster bilateral segmentation network for real-time semantic segmentation [C]// 2021 International Joint Conference on Neural Networks . Shenzhen: IEEE, 2021: 1−8.

[本文引用: 1]

[28]

陈智超, 焦海宁, 杨杰, 等 基于改进MobileNet v2的垃圾图像分类算法

[J]. 浙江大学学报: 工学版 , 2021 , 55 (8 ): 1490 - 1499

[本文引用: 1]

CHEN Zhichao, JIAO Haining, YANG Jie, et al Garbage image classification algorithm based on improved MobileNet v2

[J]. Journal of Zhejiang University: Engineering Science , 2021 , 55 (8 ): 1490 - 1499

[本文引用: 1]

[29]

ZHANG H, DANA K, SHI J, et al. Context encoding for semantic segmentation [C]// Proceedings of the IEEE conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 7151−7160.

[本文引用: 1]

我国电动重卡市场发展现状

1

2022

... 随着我国“双碳”技术战略的实施,重型卡车的电动化成为了交通运输业减碳的核心[1 ] . 然而直接使用蓄电池效率低消耗大,因此许多学者将列车中的受电弓-接触网(弓网)[2 ] 系统引入到重型卡车中[3 ] ,通过弓网系统直接对车辆进行供电. 弓网系统作为车辆电力传输的重要组成部分,其运行的稳定性和可靠性对车辆的安全运行有着至关重要的影响. 弓网接触点的位置信息能够反映弓网系统的运行状态. 因此,快速准确地检测接触点成为了电气化公路的状态监测的重要课题之一[4 ] . ...

我国电动重卡市场发展现状

1

2022

... 随着我国“双碳”技术战略的实施,重型卡车的电动化成为了交通运输业减碳的核心[1 ] . 然而直接使用蓄电池效率低消耗大,因此许多学者将列车中的受电弓-接触网(弓网)[2 ] 系统引入到重型卡车中[3 ] ,通过弓网系统直接对车辆进行供电. 弓网系统作为车辆电力传输的重要组成部分,其运行的稳定性和可靠性对车辆的安全运行有着至关重要的影响. 弓网接触点的位置信息能够反映弓网系统的运行状态. 因此,快速准确地检测接触点成为了电气化公路的状态监测的重要课题之一[4 ] . ...

高速动车组受电弓安全检测的研究

1

2017

... 随着我国“双碳”技术战略的实施,重型卡车的电动化成为了交通运输业减碳的核心[1 ] . 然而直接使用蓄电池效率低消耗大,因此许多学者将列车中的受电弓-接触网(弓网)[2 ] 系统引入到重型卡车中[3 ] ,通过弓网系统直接对车辆进行供电. 弓网系统作为车辆电力传输的重要组成部分,其运行的稳定性和可靠性对车辆的安全运行有着至关重要的影响. 弓网接触点的位置信息能够反映弓网系统的运行状态. 因此,快速准确地检测接触点成为了电气化公路的状态监测的重要课题之一[4 ] . ...

高速动车组受电弓安全检测的研究

1

2017

... 随着我国“双碳”技术战略的实施,重型卡车的电动化成为了交通运输业减碳的核心[1 ] . 然而直接使用蓄电池效率低消耗大,因此许多学者将列车中的受电弓-接触网(弓网)[2 ] 系统引入到重型卡车中[3 ] ,通过弓网系统直接对车辆进行供电. 弓网系统作为车辆电力传输的重要组成部分,其运行的稳定性和可靠性对车辆的安全运行有着至关重要的影响. 弓网接触点的位置信息能够反映弓网系统的运行状态. 因此,快速准确地检测接触点成为了电气化公路的状态监测的重要课题之一[4 ] . ...

2

... 随着我国“双碳”技术战略的实施,重型卡车的电动化成为了交通运输业减碳的核心[1 ] . 然而直接使用蓄电池效率低消耗大,因此许多学者将列车中的受电弓-接触网(弓网)[2 ] 系统引入到重型卡车中[3 ] ,通过弓网系统直接对车辆进行供电. 弓网系统作为车辆电力传输的重要组成部分,其运行的稳定性和可靠性对车辆的安全运行有着至关重要的影响. 弓网接触点的位置信息能够反映弓网系统的运行状态. 因此,快速准确地检测接触点成为了电气化公路的状态监测的重要课题之一[4 ] . ...

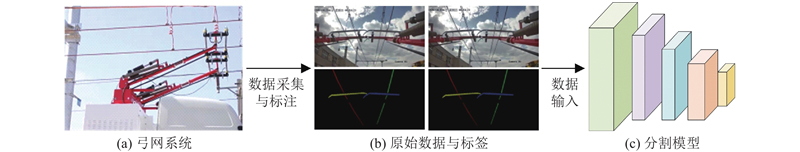

... 将所提算法应用在国内首台新型双源智能重卡的受电弓-接触网系统中[3 ] . 首先从双源重卡的弓网系统获取图像数据,共1000 张,分辨率为640×320,然后对图像数据进行标注. 将原始图像分为5类,并依次进行标注,分别为左接触线、右接触线、左受电弓、右受电弓和背景. 智能重卡弓网系统如图11 (a)所示,原始数据与标签如图11 (b)所示,红色区域为左接触线,绿色区域为右接触线,黄色区域为左受电弓,蓝色为右受电弓,黑色区域为背景. 其次使用该图像数据对PMSE-BiSeNet语义分割模型进行训练,如图11 (c)所示. ...

基于受电弓状态感知的弓网安全监测系统研究与探讨

1

2021

... 随着我国“双碳”技术战略的实施,重型卡车的电动化成为了交通运输业减碳的核心[1 ] . 然而直接使用蓄电池效率低消耗大,因此许多学者将列车中的受电弓-接触网(弓网)[2 ] 系统引入到重型卡车中[3 ] ,通过弓网系统直接对车辆进行供电. 弓网系统作为车辆电力传输的重要组成部分,其运行的稳定性和可靠性对车辆的安全运行有着至关重要的影响. 弓网接触点的位置信息能够反映弓网系统的运行状态. 因此,快速准确地检测接触点成为了电气化公路的状态监测的重要课题之一[4 ] . ...

基于受电弓状态感知的弓网安全监测系统研究与探讨

1

2021

... 随着我国“双碳”技术战略的实施,重型卡车的电动化成为了交通运输业减碳的核心[1 ] . 然而直接使用蓄电池效率低消耗大,因此许多学者将列车中的受电弓-接触网(弓网)[2 ] 系统引入到重型卡车中[3 ] ,通过弓网系统直接对车辆进行供电. 弓网系统作为车辆电力传输的重要组成部分,其运行的稳定性和可靠性对车辆的安全运行有着至关重要的影响. 弓网接触点的位置信息能够反映弓网系统的运行状态. 因此,快速准确地检测接触点成为了电气化公路的状态监测的重要课题之一[4 ] . ...

A new experimental approach using image processing-based tracking for an efficient fault diagnosis in pantograph-catenary systems

1

2017

... 传统的弓网接触点检测方法通常使用Hough变换[5 ] 和Radon变换[6 ] 方法,在水平和竖直方向上分别对受电弓表面和接触网进行检测,并计算2条直线的交点来确定弓网接触点. 此外,一些传统方法采用模板匹配[7 ] 、角点检测[8 ] 方法来识别弓网参数,从而获取接触点的位置. 尽管这些方法计算量较小,但依赖于手工特征,精度较低. ...

A new contactless fault diagnosis approach for pantograph-catenary system using pattern recognition and image processing methods

1

2014

... 传统的弓网接触点检测方法通常使用Hough变换[5 ] 和Radon变换[6 ] 方法,在水平和竖直方向上分别对受电弓表面和接触网进行检测,并计算2条直线的交点来确定弓网接触点. 此外,一些传统方法采用模板匹配[7 ] 、角点检测[8 ] 方法来识别弓网参数,从而获取接触点的位置. 尽管这些方法计算量较小,但依赖于手工特征,精度较低. ...

非接触式接触网定位器坡度自动检测技术

1

2010

... 传统的弓网接触点检测方法通常使用Hough变换[5 ] 和Radon变换[6 ] 方法,在水平和竖直方向上分别对受电弓表面和接触网进行检测,并计算2条直线的交点来确定弓网接触点. 此外,一些传统方法采用模板匹配[7 ] 、角点检测[8 ] 方法来识别弓网参数,从而获取接触点的位置. 尽管这些方法计算量较小,但依赖于手工特征,精度较低. ...

非接触式接触网定位器坡度自动检测技术

1

2010

... 传统的弓网接触点检测方法通常使用Hough变换[5 ] 和Radon变换[6 ] 方法,在水平和竖直方向上分别对受电弓表面和接触网进行检测,并计算2条直线的交点来确定弓网接触点. 此外,一些传统方法采用模板匹配[7 ] 、角点检测[8 ] 方法来识别弓网参数,从而获取接触点的位置. 尽管这些方法计算量较小,但依赖于手工特征,精度较低. ...

1

... 传统的弓网接触点检测方法通常使用Hough变换[5 ] 和Radon变换[6 ] 方法,在水平和竖直方向上分别对受电弓表面和接触网进行检测,并计算2条直线的交点来确定弓网接触点. 此外,一些传统方法采用模板匹配[7 ] 、角点检测[8 ] 方法来识别弓网参数,从而获取接触点的位置. 尽管这些方法计算量较小,但依赖于手工特征,精度较低. ...

1

... 传统的弓网接触点检测方法通常使用Hough变换[5 ] 和Radon变换[6 ] 方法,在水平和竖直方向上分别对受电弓表面和接触网进行检测,并计算2条直线的交点来确定弓网接触点. 此外,一些传统方法采用模板匹配[7 ] 、角点检测[8 ] 方法来识别弓网参数,从而获取接触点的位置. 尽管这些方法计算量较小,但依赖于手工特征,精度较低. ...

A robust pantograph-catenary interaction condition monitoring method based on deep convolutional network

2

2019

... 近年来,基于深度学习的目标检测或语义分割方法被广泛应用到弓网系统的监测中. Zhang等[9 ] 使用Faster RCNN网络提取受电弓区域和Hough变换检测接触网,最后将受电弓带和接触网的交点作为弓网接触点. Chen等[10 ] 使用目标检测网络定位受电弓区域,采用阈值分割算法分割受电弓和Canny边缘检测算法检测接触网,最后计算其交点作为弓网接触点. Yang等[11 ] 提出多策略的检测方法. 使用跟踪网络对接触区域进行跟踪,在接触区域内进行接触点检测,最后对接触点位置进行滤波校正. 张乔木等[12 -13 ] 利用语义分割网络分割弓网图像,构建具有明显特征的弓网接触点数据,最后使用改进的目标检测网络进行训练和检测,获取接触点位置. 以上方法采用基于深度学习的图像处理方法,取得了令人满意的检测性能,但存在以下局限性. 1) Zhang等[9 -10 ] 的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

... [9 -10 ]的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

High-speed railway pantograph-catenary anomaly detection method based on depth vision neural network

2

2022

... 近年来,基于深度学习的目标检测或语义分割方法被广泛应用到弓网系统的监测中. Zhang等[9 ] 使用Faster RCNN网络提取受电弓区域和Hough变换检测接触网,最后将受电弓带和接触网的交点作为弓网接触点. Chen等[10 ] 使用目标检测网络定位受电弓区域,采用阈值分割算法分割受电弓和Canny边缘检测算法检测接触网,最后计算其交点作为弓网接触点. Yang等[11 ] 提出多策略的检测方法. 使用跟踪网络对接触区域进行跟踪,在接触区域内进行接触点检测,最后对接触点位置进行滤波校正. 张乔木等[12 -13 ] 利用语义分割网络分割弓网图像,构建具有明显特征的弓网接触点数据,最后使用改进的目标检测网络进行训练和检测,获取接触点位置. 以上方法采用基于深度学习的图像处理方法,取得了令人满意的检测性能,但存在以下局限性. 1) Zhang等[9 -10 ] 的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

... -10 ]的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

Online pantograph-catenary contact point detection in complicated background based on multiple strategies

2

2020

... 近年来,基于深度学习的目标检测或语义分割方法被广泛应用到弓网系统的监测中. Zhang等[9 ] 使用Faster RCNN网络提取受电弓区域和Hough变换检测接触网,最后将受电弓带和接触网的交点作为弓网接触点. Chen等[10 ] 使用目标检测网络定位受电弓区域,采用阈值分割算法分割受电弓和Canny边缘检测算法检测接触网,最后计算其交点作为弓网接触点. Yang等[11 ] 提出多策略的检测方法. 使用跟踪网络对接触区域进行跟踪,在接触区域内进行接触点检测,最后对接触点位置进行滤波校正. 张乔木等[12 -13 ] 利用语义分割网络分割弓网图像,构建具有明显特征的弓网接触点数据,最后使用改进的目标检测网络进行训练和检测,获取接触点位置. 以上方法采用基于深度学习的图像处理方法,取得了令人满意的检测性能,但存在以下局限性. 1) Zhang等[9 -10 ] 的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

... [11 -13 ]的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

复杂环境下弓网接触位置动态监测方法研究

1

2022

... 近年来,基于深度学习的目标检测或语义分割方法被广泛应用到弓网系统的监测中. Zhang等[9 ] 使用Faster RCNN网络提取受电弓区域和Hough变换检测接触网,最后将受电弓带和接触网的交点作为弓网接触点. Chen等[10 ] 使用目标检测网络定位受电弓区域,采用阈值分割算法分割受电弓和Canny边缘检测算法检测接触网,最后计算其交点作为弓网接触点. Yang等[11 ] 提出多策略的检测方法. 使用跟踪网络对接触区域进行跟踪,在接触区域内进行接触点检测,最后对接触点位置进行滤波校正. 张乔木等[12 -13 ] 利用语义分割网络分割弓网图像,构建具有明显特征的弓网接触点数据,最后使用改进的目标检测网络进行训练和检测,获取接触点位置. 以上方法采用基于深度学习的图像处理方法,取得了令人满意的检测性能,但存在以下局限性. 1) Zhang等[9 -10 ] 的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

复杂环境下弓网接触位置动态监测方法研究

1

2022

... 近年来,基于深度学习的目标检测或语义分割方法被广泛应用到弓网系统的监测中. Zhang等[9 ] 使用Faster RCNN网络提取受电弓区域和Hough变换检测接触网,最后将受电弓带和接触网的交点作为弓网接触点. Chen等[10 ] 使用目标检测网络定位受电弓区域,采用阈值分割算法分割受电弓和Canny边缘检测算法检测接触网,最后计算其交点作为弓网接触点. Yang等[11 ] 提出多策略的检测方法. 使用跟踪网络对接触区域进行跟踪,在接触区域内进行接触点检测,最后对接触点位置进行滤波校正. 张乔木等[12 -13 ] 利用语义分割网络分割弓网图像,构建具有明显特征的弓网接触点数据,最后使用改进的目标检测网络进行训练和检测,获取接触点位置. 以上方法采用基于深度学习的图像处理方法,取得了令人满意的检测性能,但存在以下局限性. 1) Zhang等[9 -10 ] 的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

基于视频图像的弓网接触位置动态监测方法

2

2021

... 近年来,基于深度学习的目标检测或语义分割方法被广泛应用到弓网系统的监测中. Zhang等[9 ] 使用Faster RCNN网络提取受电弓区域和Hough变换检测接触网,最后将受电弓带和接触网的交点作为弓网接触点. Chen等[10 ] 使用目标检测网络定位受电弓区域,采用阈值分割算法分割受电弓和Canny边缘检测算法检测接触网,最后计算其交点作为弓网接触点. Yang等[11 ] 提出多策略的检测方法. 使用跟踪网络对接触区域进行跟踪,在接触区域内进行接触点检测,最后对接触点位置进行滤波校正. 张乔木等[12 -13 ] 利用语义分割网络分割弓网图像,构建具有明显特征的弓网接触点数据,最后使用改进的目标检测网络进行训练和检测,获取接触点位置. 以上方法采用基于深度学习的图像处理方法,取得了令人满意的检测性能,但存在以下局限性. 1) Zhang等[9 -10 ] 的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

... -13 ]的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

基于视频图像的弓网接触位置动态监测方法

2

2021

... 近年来,基于深度学习的目标检测或语义分割方法被广泛应用到弓网系统的监测中. Zhang等[9 ] 使用Faster RCNN网络提取受电弓区域和Hough变换检测接触网,最后将受电弓带和接触网的交点作为弓网接触点. Chen等[10 ] 使用目标检测网络定位受电弓区域,采用阈值分割算法分割受电弓和Canny边缘检测算法检测接触网,最后计算其交点作为弓网接触点. Yang等[11 ] 提出多策略的检测方法. 使用跟踪网络对接触区域进行跟踪,在接触区域内进行接触点检测,最后对接触点位置进行滤波校正. 张乔木等[12 -13 ] 利用语义分割网络分割弓网图像,构建具有明显特征的弓网接触点数据,最后使用改进的目标检测网络进行训练和检测,获取接触点位置. 以上方法采用基于深度学习的图像处理方法,取得了令人满意的检测性能,但存在以下局限性. 1) Zhang等[9 -10 ] 的方法仅将受电弓作为检测或分割目标,而接触网检测采用传统方法(Hough变换、Canny边缘检测),导致其仍在一定程度上依赖于手工特征. 2)在实际运行中,车载设备的计算能力有限,Yang等[11 -13 ] 的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

... -13 ]的方法使用了2种网络,计算量较大,不适合车辆的实时检测. ...

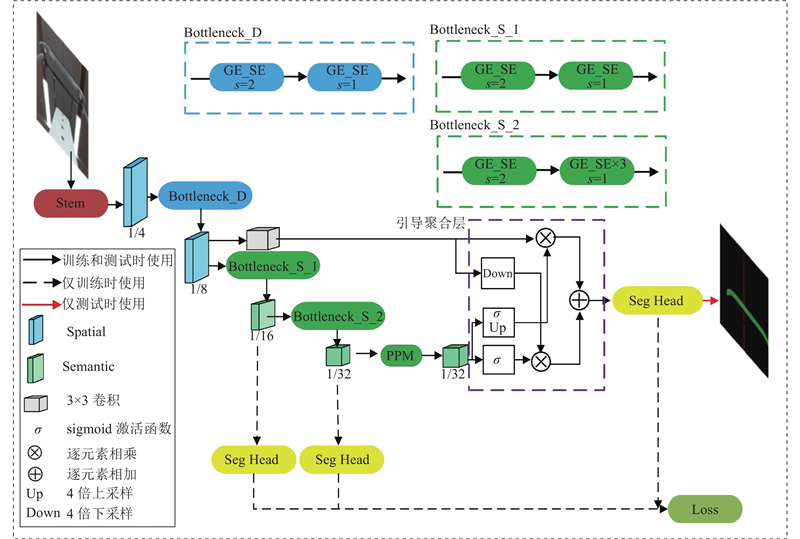

3

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

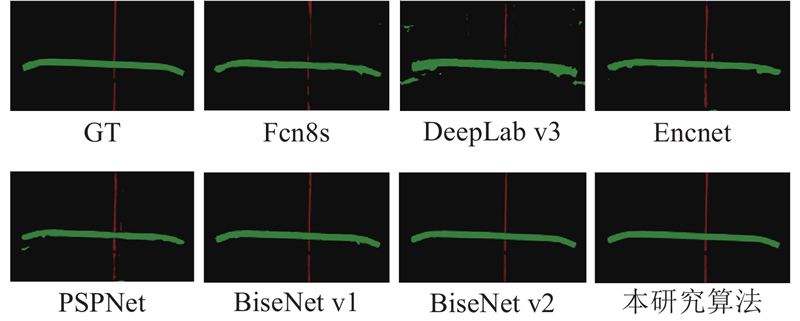

... 将所提PMSE-BiSeNet与Fcn8s[14 ] 、DeepLab v3[19 ] 和BiSeNet v2[23 ] 等分割网络在验证集上的预测结果进行对比,对比结果如图9 所示. 图中,红色区域为接触网区域,绿色区域为受电弓区域. 可以看出,Fcn8s和DeepLab v3网络针对接触网区域的分割效果不佳,轮廓不连贯,且DeepLab v3易将正常区域分割为受电弓区域,从而致使分割结果不完整,导致欠分割的情况. PSPNet网络易将正常区域分割为接触网区域,将会导致过分割的情况. 此外,由图9 可知,BiSeNet v1、BiSeNet v2和PMSE-BiSeNet(本研究)网络的分割效果较好,受电弓区域边缘轮廓清晰,接触网区域边缘轮廓完整,接近真实标签. ...

... Comparison of results between PMSE-BiSeNet and mainstream models in proposed pantograph-catenary data set

Tab.3 模型 基础网络结构 mIOU/% P /MFLOPs/G FPS/帧 I9-12900 (CPU) JETSON TX2 DeepLab v3[19 ] ResNet50 67.47 41.81 171.09 2.68 — PSPNet[20 ] ResNet50 80.31 46.71 184.74 2.69 — DenseAspp[21 ] Densenet121 80.93 9.17 43.09 8.39 — EncNet[29 ] ResNet50 80.40 33.60 147.08 2.30 — Fcn8s[14 ] Vgg16 80.16 30.02 320.87 5.85 — BiSeNet v1[22 ] ResNet18 85.45 12.80 13.03 23.05 6.68 BiSeNet v2[23 ] — 87.52 3.34 12.35 33.28 10.50 PMSE-BiSeNet — 87.50 4.57 6.73 49.80 12.60

为了进一步验证所提弓网接触点检测算法的实时性. 将部分计算量较小的分割模型导出为ONNX模型,并结合第2阶段的直线拟合算法和位置校正,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2中进行接触点检测的测试. 测试结果如表4 所示. 可以看出,在加入第2阶段算法后,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2上的FPS仅下降1.44和2.35,接触点检测的推理速度相比于单一分割模型没有明显下降,所提方法能够以较低的计算成本完成对接触点的检测. ...

1

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

2

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

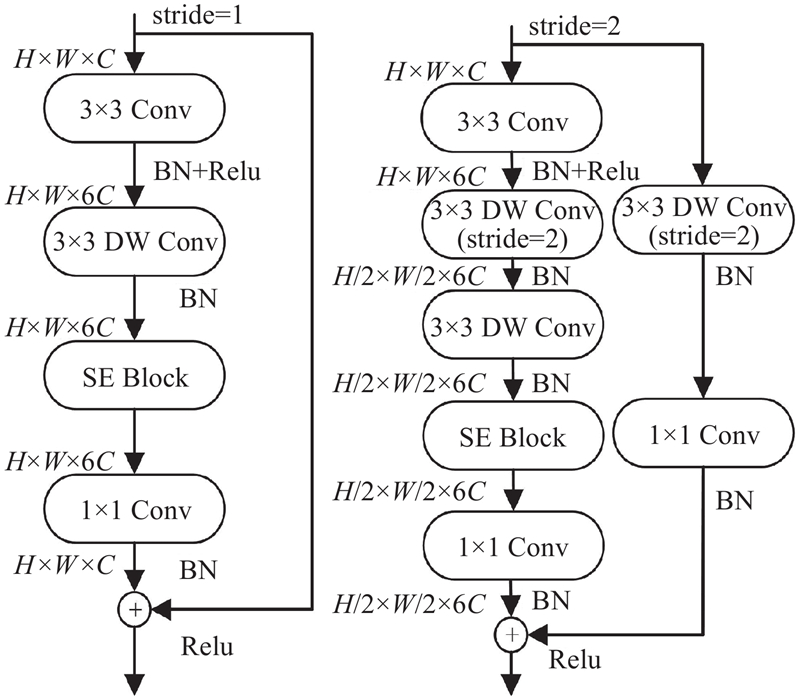

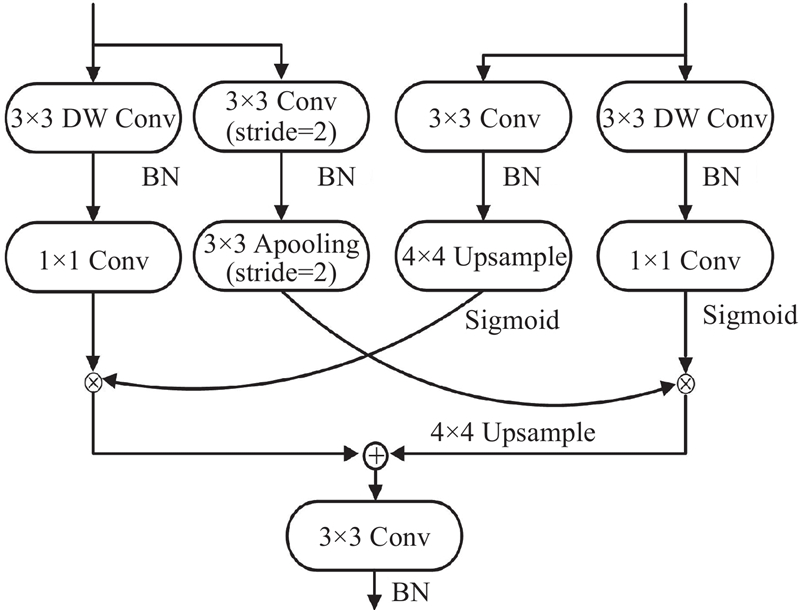

... 借鉴MobileNet v3[16 ] 的设计思想,将SE注意力模块插入到网络瓶颈块中. 通过将SE注意力机制模块嵌入到BiSeNet v2的聚合扩展层中,仅仅加入相对较少的参数,就可以让网络更加关注对最终像素级分类任务更重要的特征而抑制无用特征[28 ] ,达到提高分割精度的效果. 模块命名为GE_SE,其在聚合扩展层中的位置如图4 所示. ...

1

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

Deeplab semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs

0

2017

3

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

... 将所提PMSE-BiSeNet与Fcn8s[14 ] 、DeepLab v3[19 ] 和BiSeNet v2[23 ] 等分割网络在验证集上的预测结果进行对比,对比结果如图9 所示. 图中,红色区域为接触网区域,绿色区域为受电弓区域. 可以看出,Fcn8s和DeepLab v3网络针对接触网区域的分割效果不佳,轮廓不连贯,且DeepLab v3易将正常区域分割为受电弓区域,从而致使分割结果不完整,导致欠分割的情况. PSPNet网络易将正常区域分割为接触网区域,将会导致过分割的情况. 此外,由图9 可知,BiSeNet v1、BiSeNet v2和PMSE-BiSeNet(本研究)网络的分割效果较好,受电弓区域边缘轮廓清晰,接触网区域边缘轮廓完整,接近真实标签. ...

... Comparison of results between PMSE-BiSeNet and mainstream models in proposed pantograph-catenary data set

Tab.3 模型 基础网络结构 mIOU/% P /MFLOPs/G FPS/帧 I9-12900 (CPU) JETSON TX2 DeepLab v3[19 ] ResNet50 67.47 41.81 171.09 2.68 — PSPNet[20 ] ResNet50 80.31 46.71 184.74 2.69 — DenseAspp[21 ] Densenet121 80.93 9.17 43.09 8.39 — EncNet[29 ] ResNet50 80.40 33.60 147.08 2.30 — Fcn8s[14 ] Vgg16 80.16 30.02 320.87 5.85 — BiSeNet v1[22 ] ResNet18 85.45 12.80 13.03 23.05 6.68 BiSeNet v2[23 ] — 87.52 3.34 12.35 33.28 10.50 PMSE-BiSeNet — 87.50 4.57 6.73 49.80 12.60

为了进一步验证所提弓网接触点检测算法的实时性. 将部分计算量较小的分割模型导出为ONNX模型,并结合第2阶段的直线拟合算法和位置校正,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2中进行接触点检测的测试. 测试结果如表4 所示. 可以看出,在加入第2阶段算法后,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2上的FPS仅下降1.44和2.35,接触点检测的推理速度相比于单一分割模型没有明显下降,所提方法能够以较低的计算成本完成对接触点的检测. ...

4

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

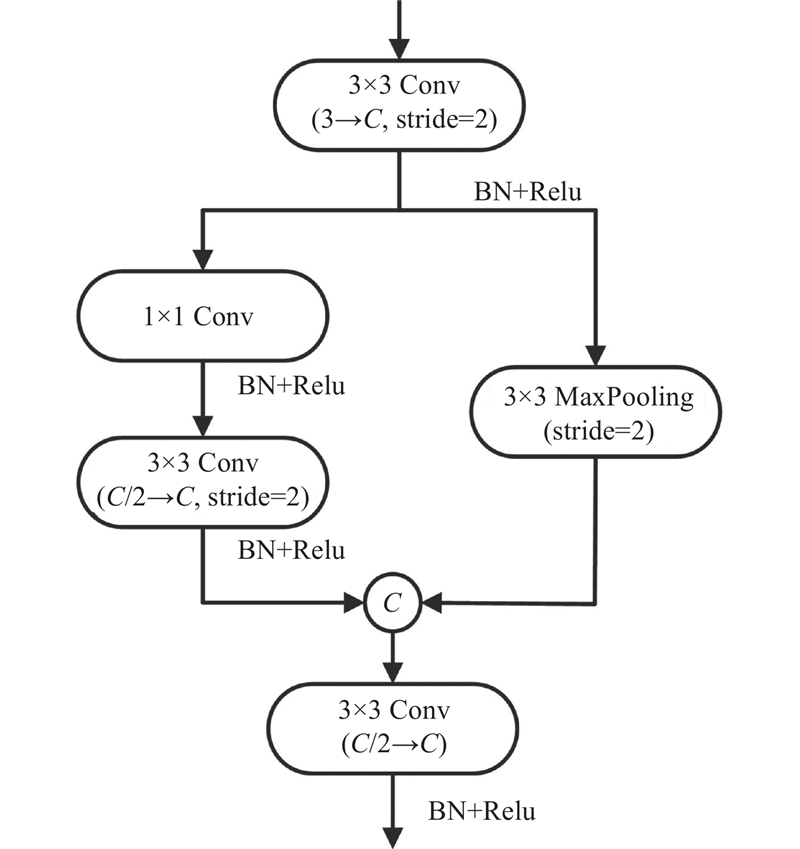

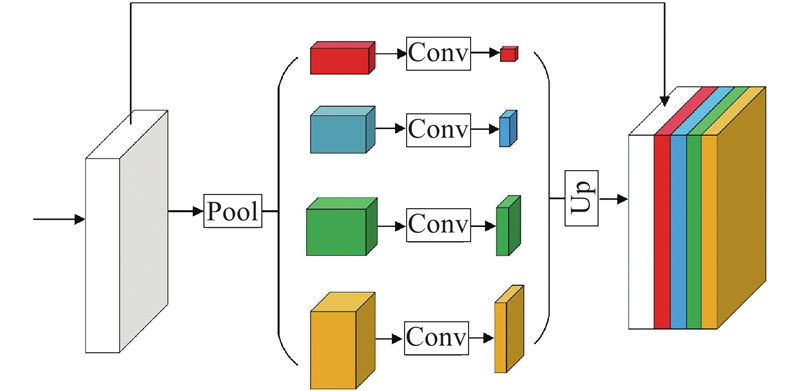

... 综上,本研究提出基于改进BiSeNet v2的PMSE-BiSeNet语义分割网络,主要从4个方面进行设计:1)使用计算成本较小的细节提取模块替换原来的细节分支;2)采用浅层特征共享机制,将细节分支生成的浅层特征送入语义分支中提取所需的高层语义信息,同时使用计算成本较低的卷积操作对浅层特征进行通道映射获取浅层细节信息;3)将挤压与激励注意力机制[24 ] (squeeze-and-excitation,SE)嵌入到网络瓶颈块中,增强重要通道信息,抑制无用信息,通过堆叠瓶颈块构建高效的编码器,获取丰富的高层语义信息;4)加入PPM[20 ] 模块获取更多的空间上下文和多尺度信息. ...

... PPM[20 ] 模块是一种金字塔池化模块. 采用不同大小的池化核对特征图进行池化操作,将池化结果上采样,再进行拼接,得到最终含有多尺度信息的特征图,使模型能够更好地理解图像的整体语义. 此外,通过上采样和拼接操作,保留局部细节信息,提高分割结果的精度. 结构如图6 所示. ...

... Comparison of results between PMSE-BiSeNet and mainstream models in proposed pantograph-catenary data set

Tab.3 模型 基础网络结构 mIOU/% P /MFLOPs/G FPS/帧 I9-12900 (CPU) JETSON TX2 DeepLab v3[19 ] ResNet50 67.47 41.81 171.09 2.68 — PSPNet[20 ] ResNet50 80.31 46.71 184.74 2.69 — DenseAspp[21 ] Densenet121 80.93 9.17 43.09 8.39 — EncNet[29 ] ResNet50 80.40 33.60 147.08 2.30 — Fcn8s[14 ] Vgg16 80.16 30.02 320.87 5.85 — BiSeNet v1[22 ] ResNet18 85.45 12.80 13.03 23.05 6.68 BiSeNet v2[23 ] — 87.52 3.34 12.35 33.28 10.50 PMSE-BiSeNet — 87.50 4.57 6.73 49.80 12.60

为了进一步验证所提弓网接触点检测算法的实时性. 将部分计算量较小的分割模型导出为ONNX模型,并结合第2阶段的直线拟合算法和位置校正,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2中进行接触点检测的测试. 测试结果如表4 所示. 可以看出,在加入第2阶段算法后,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2上的FPS仅下降1.44和2.35,接触点检测的推理速度相比于单一分割模型没有明显下降,所提方法能够以较低的计算成本完成对接触点的检测. ...

2

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

... Comparison of results between PMSE-BiSeNet and mainstream models in proposed pantograph-catenary data set

Tab.3 模型 基础网络结构 mIOU/% P /MFLOPs/G FPS/帧 I9-12900 (CPU) JETSON TX2 DeepLab v3[19 ] ResNet50 67.47 41.81 171.09 2.68 — PSPNet[20 ] ResNet50 80.31 46.71 184.74 2.69 — DenseAspp[21 ] Densenet121 80.93 9.17 43.09 8.39 — EncNet[29 ] ResNet50 80.40 33.60 147.08 2.30 — Fcn8s[14 ] Vgg16 80.16 30.02 320.87 5.85 — BiSeNet v1[22 ] ResNet18 85.45 12.80 13.03 23.05 6.68 BiSeNet v2[23 ] — 87.52 3.34 12.35 33.28 10.50 PMSE-BiSeNet — 87.50 4.57 6.73 49.80 12.60

为了进一步验证所提弓网接触点检测算法的实时性. 将部分计算量较小的分割模型导出为ONNX模型,并结合第2阶段的直线拟合算法和位置校正,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2中进行接触点检测的测试. 测试结果如表4 所示. 可以看出,在加入第2阶段算法后,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2上的FPS仅下降1.44和2.35,接触点检测的推理速度相比于单一分割模型没有明显下降,所提方法能够以较低的计算成本完成对接触点的检测. ...

3

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

... Comparison of results between PMSE-BiSeNet and mainstream models in proposed pantograph-catenary data set

Tab.3 模型 基础网络结构 mIOU/% P /MFLOPs/G FPS/帧 I9-12900 (CPU) JETSON TX2 DeepLab v3[19 ] ResNet50 67.47 41.81 171.09 2.68 — PSPNet[20 ] ResNet50 80.31 46.71 184.74 2.69 — DenseAspp[21 ] Densenet121 80.93 9.17 43.09 8.39 — EncNet[29 ] ResNet50 80.40 33.60 147.08 2.30 — Fcn8s[14 ] Vgg16 80.16 30.02 320.87 5.85 — BiSeNet v1[22 ] ResNet18 85.45 12.80 13.03 23.05 6.68 BiSeNet v2[23 ] — 87.52 3.34 12.35 33.28 10.50 PMSE-BiSeNet — 87.50 4.57 6.73 49.80 12.60

为了进一步验证所提弓网接触点检测算法的实时性. 将部分计算量较小的分割模型导出为ONNX模型,并结合第2阶段的直线拟合算法和位置校正,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2中进行接触点检测的测试. 测试结果如表4 所示. 可以看出,在加入第2阶段算法后,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2上的FPS仅下降1.44和2.35,接触点检测的推理速度相比于单一分割模型没有明显下降,所提方法能够以较低的计算成本完成对接触点的检测. ...

... Real-time test results of partial detection algorithms

Tab.4 模型 基础网络结构 第2阶段算法 FPS/帧 I9-12900 (CPU) BiSeNet v1[22 ] ResNet18 √ 20.47 4.50 BiSeNet v2[23 ] — √ 29.75 7.20 PMSE-BiSeNet — √ 48.36 10.25

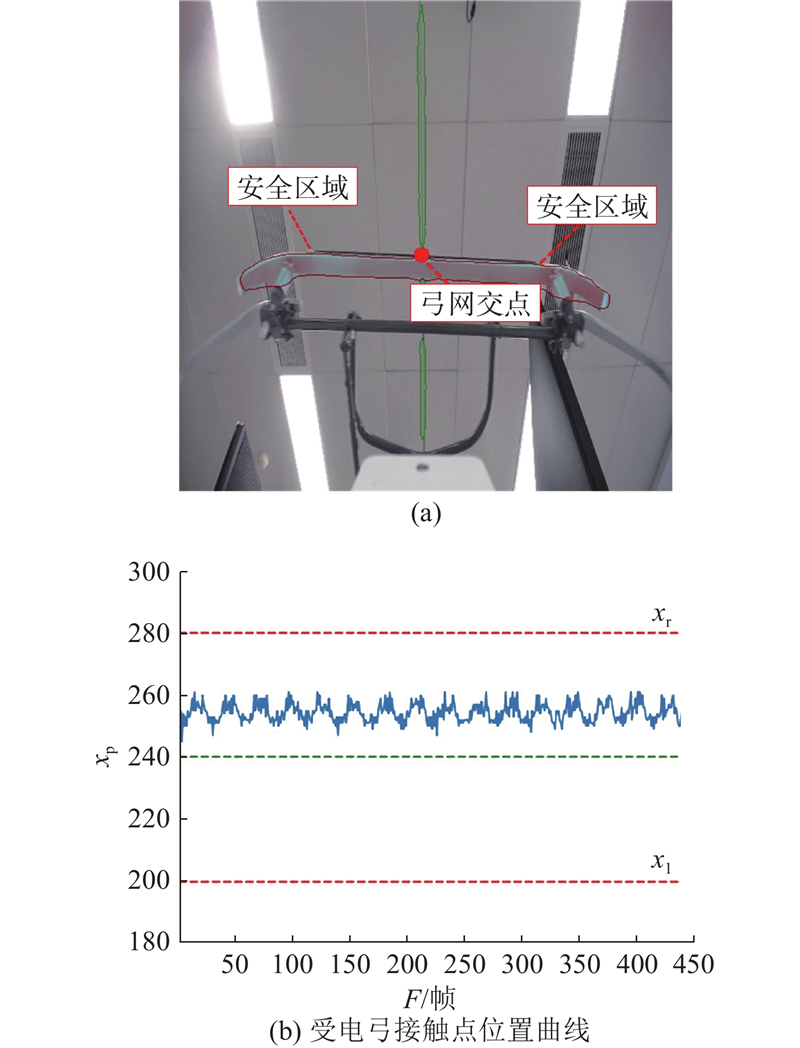

2.2. 检测结果与分析 在实验室的弓网实验平台中进行算法有效性的测试. 摄像头采集的图像分辨率为1920×1080 ,测试时将其缩放为512×512,采样频率为30帧/s,受电弓左右摆动的速度为40 mm/s,使用人工光源模拟正常日光照射. ...

BiSeNet v2: bilateral network with guided aggregation for real-time semantic segmentation

5

2021

... 随着深度学习技术的快速发展,基于深度学习的语义分割方法在图像处理领域中得到了广泛应用. FCN[14 ] 、U-Net[15 ] 、LRASPP[16 ] 等通过构建高效的编码器-解码器结构来完成语义分割任务. 为了引入更多的空间上下文和多尺度信息,DeepLab[17 -19 ] 采用空洞空间卷积金字塔池化模块增加编码器的接受域;PSPNet[20 ] 使用金字塔池化模块(pyramid pooling module,PPM)提取多尺度上下文信息;DenseASPP[21 ] 将扩张卷积以密集连接的方式进行连接,获取范围更广的多尺度特征. 但是以上方法所需计算量仍然较大. 为了平衡分割精度和速度,BiSeNet[22 -23 ] 提出双路径并行的轻量级语义分割结构,2条路径分别对浅层细节和高层语义进行提取,最后使用高效的特征融合模块融合细节信息和语义信息. ...

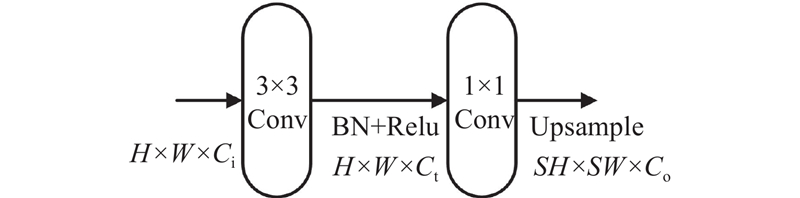

... 卷积神经网络从图像中获取的浅层特征大多是边缘、纹理、颜色、亮度等信息,BiSeNet v2[23 ] 中的细节分支和语义分支之间存在相似的浅层特征,这带来了冗余的计算量[26 -27 ] . 为了加快推理速度同时保持较高的准确度,采用浅层信息共享的思想,将细节分支生成的浅层特征送入语义分支中提取所需的高层语义信息,同时使用计算成本较低的普通卷积对浅层特征进行通道映射获取浅层细节信息. 该方法能够在保证模型推理速度的同时,尽可能地保持模型的分割准确度. ...

... 将所提PMSE-BiSeNet与Fcn8s[14 ] 、DeepLab v3[19 ] 和BiSeNet v2[23 ] 等分割网络在验证集上的预测结果进行对比,对比结果如图9 所示. 图中,红色区域为接触网区域,绿色区域为受电弓区域. 可以看出,Fcn8s和DeepLab v3网络针对接触网区域的分割效果不佳,轮廓不连贯,且DeepLab v3易将正常区域分割为受电弓区域,从而致使分割结果不完整,导致欠分割的情况. PSPNet网络易将正常区域分割为接触网区域,将会导致过分割的情况. 此外,由图9 可知,BiSeNet v1、BiSeNet v2和PMSE-BiSeNet(本研究)网络的分割效果较好,受电弓区域边缘轮廓清晰,接触网区域边缘轮廓完整,接近真实标签. ...

... Comparison of results between PMSE-BiSeNet and mainstream models in proposed pantograph-catenary data set

Tab.3 模型 基础网络结构 mIOU/% P /MFLOPs/G FPS/帧 I9-12900 (CPU) JETSON TX2 DeepLab v3[19 ] ResNet50 67.47 41.81 171.09 2.68 — PSPNet[20 ] ResNet50 80.31 46.71 184.74 2.69 — DenseAspp[21 ] Densenet121 80.93 9.17 43.09 8.39 — EncNet[29 ] ResNet50 80.40 33.60 147.08 2.30 — Fcn8s[14 ] Vgg16 80.16 30.02 320.87 5.85 — BiSeNet v1[22 ] ResNet18 85.45 12.80 13.03 23.05 6.68 BiSeNet v2[23 ] — 87.52 3.34 12.35 33.28 10.50 PMSE-BiSeNet — 87.50 4.57 6.73 49.80 12.60

为了进一步验证所提弓网接触点检测算法的实时性. 将部分计算量较小的分割模型导出为ONNX模型,并结合第2阶段的直线拟合算法和位置校正,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2中进行接触点检测的测试. 测试结果如表4 所示. 可以看出,在加入第2阶段算法后,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2上的FPS仅下降1.44和2.35,接触点检测的推理速度相比于单一分割模型没有明显下降,所提方法能够以较低的计算成本完成对接触点的检测. ...

... Real-time test results of partial detection algorithms

Tab.4 模型 基础网络结构 第2阶段算法 FPS/帧 I9-12900 (CPU) BiSeNet v1[22 ] ResNet18 √ 20.47 4.50 BiSeNet v2[23 ] — √ 29.75 7.20 PMSE-BiSeNet — √ 48.36 10.25

2.2. 检测结果与分析 在实验室的弓网实验平台中进行算法有效性的测试. 摄像头采集的图像分辨率为1920×1080 ,测试时将其缩放为512×512,采样频率为30帧/s,受电弓左右摆动的速度为40 mm/s,使用人工光源模拟正常日光照射. ...

2

... 综上,本研究提出基于改进BiSeNet v2的PMSE-BiSeNet语义分割网络,主要从4个方面进行设计:1)使用计算成本较小的细节提取模块替换原来的细节分支;2)采用浅层特征共享机制,将细节分支生成的浅层特征送入语义分支中提取所需的高层语义信息,同时使用计算成本较低的卷积操作对浅层特征进行通道映射获取浅层细节信息;3)将挤压与激励注意力机制[24 ] (squeeze-and-excitation,SE)嵌入到网络瓶颈块中,增强重要通道信息,抑制无用信息,通过堆叠瓶颈块构建高效的编码器,获取丰富的高层语义信息;4)加入PPM[20 ] 模块获取更多的空间上下文和多尺度信息. ...

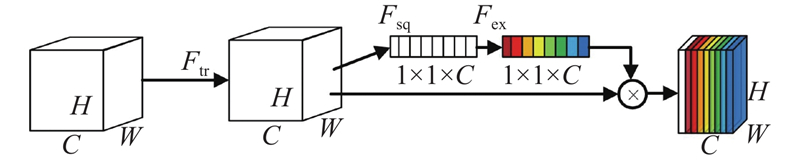

... SE注意力机制[24 ] 是一种通道注意力机制,可以嵌入到网络模型中,通过模型的训练可以自动地学习每个通道的重要性,增强重要通道信息,抑制无用信息,从而提高模型的表现. ...

2

... 虽然BiSeNet v2有着较快的速度和较高的精度,但是使用类似Vgg[25 ] 的结构获取浅层的细节信息将会额外引入较大的计算量和冗余的参数. 因此,使用计算成本较小的倒残差结构替换原来计算量较大的Vgg[25 ] 结构. ...

... [25 ]结构. ...

1

... 卷积神经网络从图像中获取的浅层特征大多是边缘、纹理、颜色、亮度等信息,BiSeNet v2[23 ] 中的细节分支和语义分支之间存在相似的浅层特征,这带来了冗余的计算量[26 -27 ] . 为了加快推理速度同时保持较高的准确度,采用浅层信息共享的思想,将细节分支生成的浅层特征送入语义分支中提取所需的高层语义信息,同时使用计算成本较低的普通卷积对浅层特征进行通道映射获取浅层细节信息. 该方法能够在保证模型推理速度的同时,尽可能地保持模型的分割准确度. ...

1

... 卷积神经网络从图像中获取的浅层特征大多是边缘、纹理、颜色、亮度等信息,BiSeNet v2[23 ] 中的细节分支和语义分支之间存在相似的浅层特征,这带来了冗余的计算量[26 -27 ] . 为了加快推理速度同时保持较高的准确度,采用浅层信息共享的思想,将细节分支生成的浅层特征送入语义分支中提取所需的高层语义信息,同时使用计算成本较低的普通卷积对浅层特征进行通道映射获取浅层细节信息. 该方法能够在保证模型推理速度的同时,尽可能地保持模型的分割准确度. ...

1

... 卷积神经网络从图像中获取的浅层特征大多是边缘、纹理、颜色、亮度等信息,BiSeNet v2[23 ] 中的细节分支和语义分支之间存在相似的浅层特征,这带来了冗余的计算量[26 -27 ] . 为了加快推理速度同时保持较高的准确度,采用浅层信息共享的思想,将细节分支生成的浅层特征送入语义分支中提取所需的高层语义信息,同时使用计算成本较低的普通卷积对浅层特征进行通道映射获取浅层细节信息. 该方法能够在保证模型推理速度的同时,尽可能地保持模型的分割准确度. ...

基于改进MobileNet v2的垃圾图像分类算法

1

2021

... 借鉴MobileNet v3[16 ] 的设计思想,将SE注意力模块插入到网络瓶颈块中. 通过将SE注意力机制模块嵌入到BiSeNet v2的聚合扩展层中,仅仅加入相对较少的参数,就可以让网络更加关注对最终像素级分类任务更重要的特征而抑制无用特征[28 ] ,达到提高分割精度的效果. 模块命名为GE_SE,其在聚合扩展层中的位置如图4 所示. ...

基于改进MobileNet v2的垃圾图像分类算法

1

2021

... 借鉴MobileNet v3[16 ] 的设计思想,将SE注意力模块插入到网络瓶颈块中. 通过将SE注意力机制模块嵌入到BiSeNet v2的聚合扩展层中,仅仅加入相对较少的参数,就可以让网络更加关注对最终像素级分类任务更重要的特征而抑制无用特征[28 ] ,达到提高分割精度的效果. 模块命名为GE_SE,其在聚合扩展层中的位置如图4 所示. ...

1

... Comparison of results between PMSE-BiSeNet and mainstream models in proposed pantograph-catenary data set

Tab.3 模型 基础网络结构 mIOU/% P /MFLOPs/G FPS/帧 I9-12900 (CPU) JETSON TX2 DeepLab v3[19 ] ResNet50 67.47 41.81 171.09 2.68 — PSPNet[20 ] ResNet50 80.31 46.71 184.74 2.69 — DenseAspp[21 ] Densenet121 80.93 9.17 43.09 8.39 — EncNet[29 ] ResNet50 80.40 33.60 147.08 2.30 — Fcn8s[14 ] Vgg16 80.16 30.02 320.87 5.85 — BiSeNet v1[22 ] ResNet18 85.45 12.80 13.03 23.05 6.68 BiSeNet v2[23 ] — 87.52 3.34 12.35 33.28 10.50 PMSE-BiSeNet — 87.50 4.57 6.73 49.80 12.60

为了进一步验证所提弓网接触点检测算法的实时性. 将部分计算量较小的分割模型导出为ONNX模型,并结合第2阶段的直线拟合算法和位置校正,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2中进行接触点检测的测试. 测试结果如表4 所示. 可以看出,在加入第2阶段算法后,在CPU为Intel Core I9-12900 的台式电脑和边缘计算设备JETSON TX2上的FPS仅下降1.44和2.35,接触点检测的推理速度相比于单一分割模型没有明显下降,所提方法能够以较低的计算成本完成对接触点的检测. ...