如果可以从微分方程自身的特征出发,将表现方程特征的先验物理信息,以数据驱动的方式融合进求解微分方程的神经网络的训练中,促使神经网络逼近相应的方程特征,从而得到能够描述这些先验物理信息的微分方程解. 这种求解微分方程的思路更加简单和直接,避免了模型简化和复杂构造带来的理论和误差问题,也提供了对方程物理信息的量化与认知.

近年来,由于PINN具有计算速度快,精度高,仅从数据角度出发就可以利用神经网络直接拟合物理问题的优点,发展非常迅速,也为微分方程的数值求解开辟了一条新的途径. 很多学者利用PINN对一些偏微分方程(partial differential equation,PDE)进行了研究,Lu等[5]描述了PINN求解PDE的一般性步骤. Lin等[6]设计了两阶段PINN,在第2阶段将守恒量测量引入均方差损失中,结合第1阶段的PINN来训练神经网络,从而模拟Sawada-Kotera和Boussinesq-Burgers可积方程的局域波解. Lin等[7]还研究了基于非线性PDE解的初始和边界数据,利用Miura变换和PINN获得演化方程的数据驱动解,从而克服了基于隐式表达式求解的困难,并在KdV-mKdV方程的实验中发现了新的局部化波解:散焦mKdV方程的kink-bell类型解. Miao等[8]将PINN应用于高维系统,以解决具有2N+1个超平面边界的N+1维初始边界问题,并应用在2+1维可积Kadomtsev-Petviashvili(KP)方程和3+1维约化KP方程中,再现了这些可积系统的经典解. Pu等[9]从神经元局部自适应激活函数和L2范数的参数正则化2个角度来改进PINN,并在Yajima-Oikawa(YO)系统的正向问题中恢复了3种不同初始边值条件下的矢量流氓波(RW),还利用不同噪声强度的训练数据研究了YO系统的反向问题.

目前,PINN的研究多关注将数学特性和数学方法加持到求解PDE的过程中,对PINN中物理信息如何影响神经网络训练的分析较少,对求解PDE时PINN的微观表现,以及影响PINN工程化应用的神经网络规模在迭代次数和时间上对求解效果影响的讨论也较少. 本研究通过将方程的物理信息分为规律信息和数值信息2类,来分析从“physics-informed, PI”到“neural networks , NN”的数据驱动过程,给出PINN求解PDE的可解释性,并探索这2种信息对PINN求解PDE的影响. 同时,利用PINN求解Burgers-Fisher方程,在数值实验中分析PINN求解方程的微观和宏观误差与求解稳定性,以及2类信息对刻画方程的神经网络训练的影响,讨论神经网络规模在迭代次数和时间上对求解方程效果的影响.

1. 数学方程模型

式中:x为空间变量,

式(1)概括了方程描述的物理量

式中:

2. 求解Burgers-Fisher方程相关方法

除了从理论上得到广义Burgers-Fisher方程的解析解(式(2))外,很多文献也都给出了各种数值求解方法,例如传统求解PDE的各种谱方法,包括Javidi[14]提出的谱配置法、Zhao等[15]提出的伪谱法、Golbabai等[16]提出的谱域分解法等. 近年来,也有很多学者提出各种求解方程的数值方法,Alotaibi等[17]利用改进的Adomian分解法(Adomian decomposition method,ADM)和同伦摄动法(Homotopy perturbation method,HPM)结合Yang变换来研究和分析广义Burgers-Fisher方程. 潘悦悦等[10]基于交替分段技术,将古典显式格式与隐式格式和Crank-Nicolson(C-N)格式恰当组合,提出求解Burgers-Fisher方程的改进交替分段Crank-Nicolson(improved alternate segment C-N,IASC-N)并行差分方法,并从理论上分析了IASC-N并行差分解的存在唯一性、稳定性和收敛性. 赵国忠等[18]构造了一类局部间断Petrov-Galerkin方法求解Burgers-Fisher方程,并针对2个特殊的案例进行包括稳定性在内的数值分析. Singa等[19]将四阶B样条配置方法应用在Burgers-Fisher方程的数值求解中,并证明了这种方法的收敛性,以及利用傅里叶级数分析了这种数值求解方法的稳定性.

传统的谱方法和有限差分方法都须对方程进行离散化和区域剖分,其他的数值求解方法也都要利用数学理论和设计特殊的结构来拟合微分方程,求解过程相对较复杂. PINN目前虽然在计算精度方面还不如一些传统的算法,但是可以直接从方程的特征入手,将物理信息通过采样的方式数据化,来驱动训练神经网络,从而有效地避免方程中的各类数学构造带来的复杂性,对解决高维问题和反问题有较大的优势,而且求解效率相对于传统算法也具有一定的优势. 因此,本研究以Burgers-Fisher方程为例,采用PINN建立数值化求解方程的神经网络,通过采样方程的物理信息数据来训练该神经网络逼近方程的解,并进一步探索不同的方程物理信息对神经网络训练的影响,以及神经网络规模对方程求解的影响.

3. 基于物理信息的神经网络求解方法

3.1. PINN求解过程及解释性

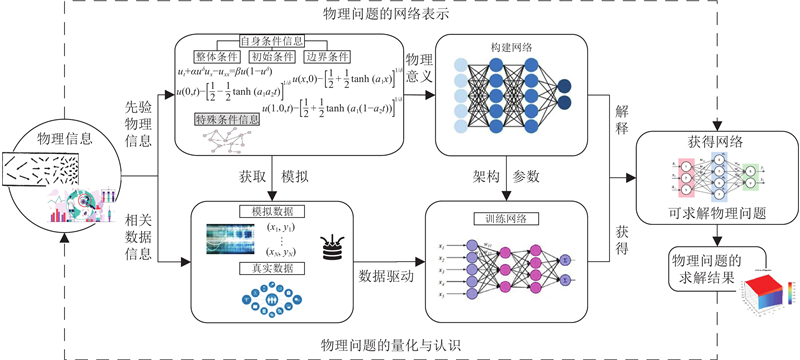

图 1

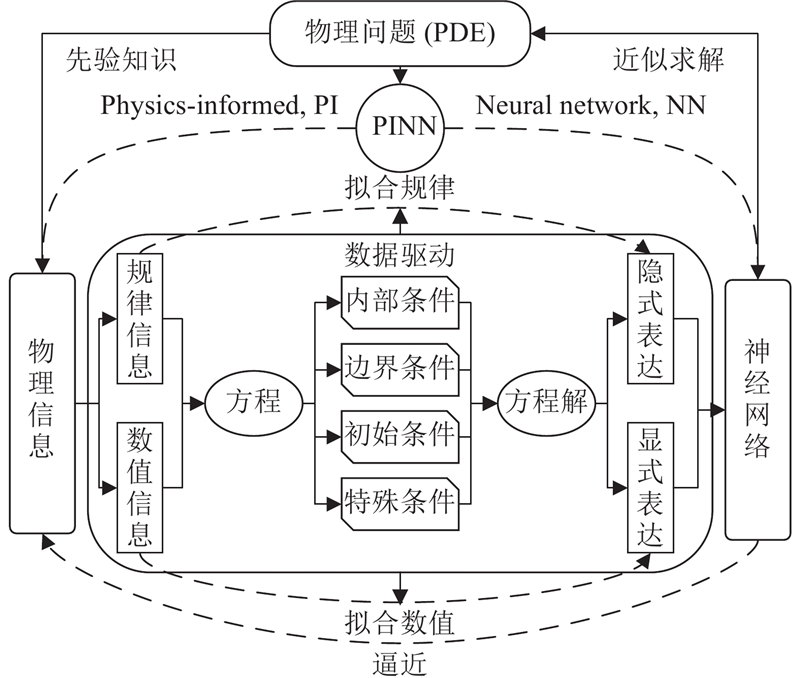

本研究认为PINN包含了物理信息“PI”和神经网络“NN”,体现了可认知和可测量2个方面. 可认知表现为方程的物理信息提供了神经网络需要逼近的目标,从而为神经网络提供了可解释性;可测量则是指对物理信息的数值化测度,即通过模拟、计算和实验等方式获得体现方程物理信息的数据,最终以数据驱动方式训练神经网络实现从“NN”向“PI”的逼近. 具体逻辑关系如图2所示.

图 2

PDE的物理信息可以分为规律信息和数值信息2类,具体表现为描述微分方程特征的内部条件、初始条件和边界条件,以及方程的某些特殊条件. 规律信息是方程解的隐式表达,如由式(1)表示的方程内部条件或者其他体现方程规律的特殊条件,数值信息是方程解的显式表达,如由式(3)~(5)表示的方程初始条件、边界条件或者实验观测结果体现的特殊数值条件. 通过在这些规律信息和数值信息上的采样获得带有这些信息的数据,以拟合方程解的规律和数值为目标,进行数据驱动训练神经网络,使得神经网络逼近PDE的这些物理信息,从而获得体现PDE解的神经网络,最终利用这个神经网络来近似计算PDE的所有数值解.

方程的规律信息和数值信息是实现神经网络逼近方程物理信息的依据,可以通过设置不同的训练采样平衡度和训练强度平衡度,来控制这2种信息对神经网络训练的影响. 数据采样平衡度体现为在这2类信息上的不同采样规模,训练强度平衡度体现为这2类信息对训练神经网络的影响权重之比.

3.2. PINN求解Burgers-Fisher方程

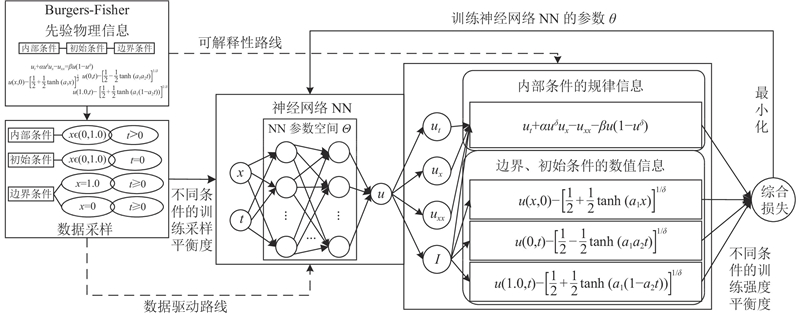

根据以上论述,基于Lu等[5]提出的一般性PINN求解PDE的步骤,Burgers-Fisher方程求解过程可以表现为如图3所示. 将方程的物理信息分为由式(1)体现的方程内部条件规律信息,以及由式(3)~(5)体现的方程初始条件和边界条件数值信息. 构建一个在参数空间

图 3

图 3 PINN求解Burgers-Fisher方程过程示意图

Fig.3 Schematic of PINN solving Burgers-Fisher equation

整个过程具体表现如下. 创建2阶段的神经网络,在第1阶段设计由方程的2个变量

其中,

式中:

在物理信息上采样获得的训练数据

综上所述,PINN求解Burgers-Fisher方程的具体步骤如下.

1)设置各类参数创建一个在参数空间

2)综合方程的内部条件规律信息,初始条件和边界条件数值信息,依据训练强度平衡度,设置不同条件信息损失的影响权重,构建神经网络的综合信息损失函数

3)依据训练采样平衡度,在方程内部条件、初始条件和边界条件上进行数据采样,获得相应训练数据

4)利用步骤3)的采样数据训练神经网络,获得实现步骤2)中综合信息损失函数最小化的参数

4. 数值实验

在Windows 11系统下,基于PyTorch深度学习框架编写实验代码脚本,在处理器为Core i7-10700K,16 G内存的硬件条件下的Visual Studio Code 1.77.1上运行以下实验.

4.1. 不同方程参数的求解测试

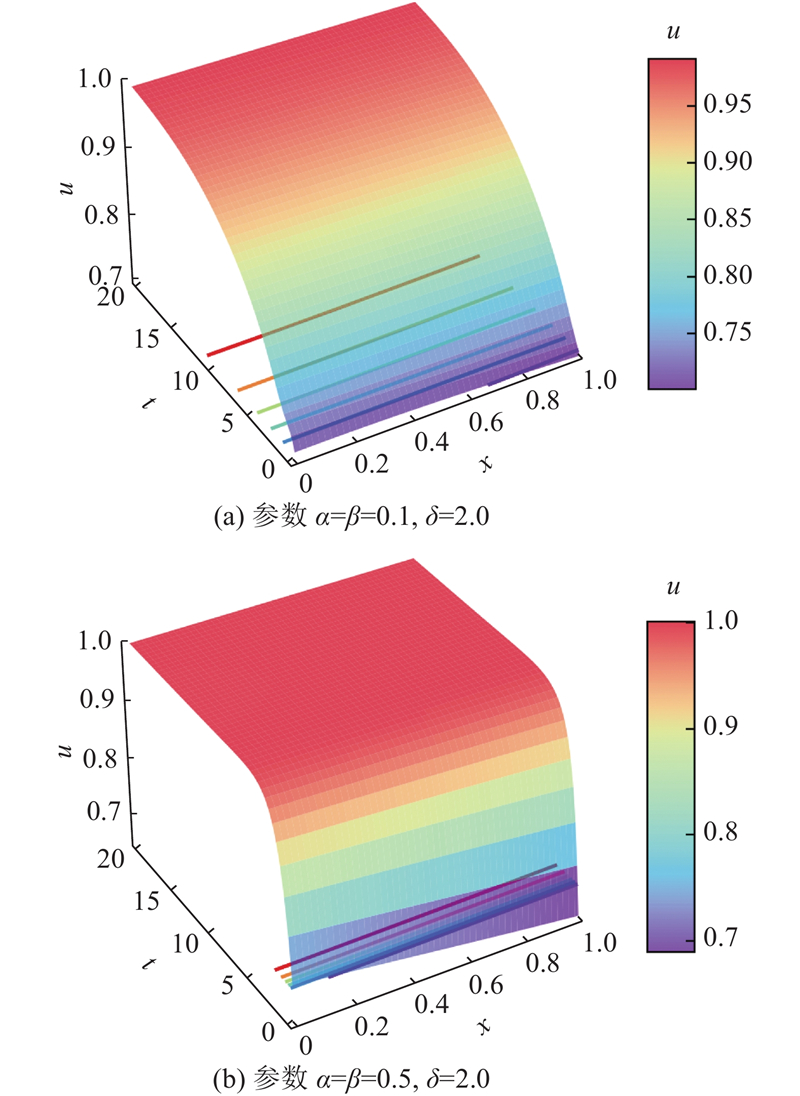

在神经网络训练阶段,在方程内部条件(

在神经网络测试阶段,进行网格化采样(分别在

表 1 网格采样中对角线数据坐标的预测结果

Tab.1

| | | 参数情况1 | 参数情况2 | |||||

| | | | | | | |||

| 0.0 | 0.0 | 4.9957 | 5.0000 | 0.4296 | 7.0735 | 7.0711 | 2.4521 | |

| 0.1 | 1.0 | 5.2330 | 5.2436 | 1.0540 | 8.5860 | 8.5756 | 10.3780 | |

| 0.2 | 2.0 | 5.4697 | 5.4860 | 1.6249 | 9.4012 | 9.4095 | 8.2731 | |

| 0.3 | 3.0 | 5.7092 | 5.7261 | 1.6925 | 9.7709 | 9.7750 | 4.0752 | |

| 0.4 | 4.0 | 5.9568 | 5.9628 | 0.6045 | 9.9170 | 9.9172 | 0.2986 | |

| 0.5 | 5.0 | 6.2043 | 6.1952 | 0.9111 | 9.9715 | 9.9700 | 1.5283 | |

| 0.6 | 6.0 | 6.4406 | 6.4222 | 1.8459 | 9.9921 | 9.9892 | 2.9022 | |

| 0.7 | 7.0 | 6.6602 | 6.6430 | 1.7280 | 10.0000 | 9.9961 | 3.8970 | |

| 0.8 | 8.0 | 6.8613 | 6.8568 | 0.4469 | 10.0030 | 9.9986 | 3.9810 | |

| 0.9 | 9.0 | 7.0435 | 7.0630 | 1.9533 | 10.0020 | 9.9995 | 2.7907 | |

| 1.0 | 10.0 | 7.2075 | 7.2611 | 5.3639 | 10.0000 | 9.9998 | 0.2772 | |

图 4

图 4 2种参数情况下的方程解的三维曲面图

Fig.4 Three-dimensional surface of equation solution on two cases

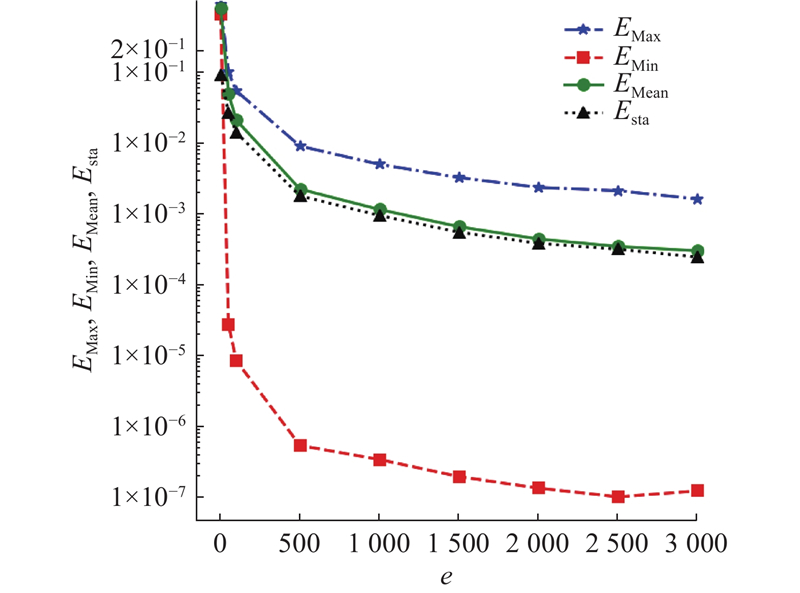

4.2. 不同迭代次数的求解测试

为了考察神经网络训练迭代次数对PINN求解方程的影响. 设置方程参数为

图 5

图 5 绝对误差随神经网络训练迭代次数的变化

Fig.5 Change of absolute error with number of epochs of neural network training

4.3. 不同神经网络规模的求解测试

为了考察神经网络规模对PINN求解方程的影响,采用与4.2节相同的方程参数,以及训练和测试数据生成策略. 网络规模

表 2 固定迭代次数下预测值绝对误差随神经网络规模变化的描述性统计

Tab.2

| | | | | | |

| L2N10 | 1.7252 | 1.5875 | 5.0858 | 3.6818 | 0.8563 |

| L2N20 | 1.1476 | 0.5662 | 2.6179 | 2.1679 | 1.0698 |

| L2N40 | 0.9774 | 0.5504 | 1.8555 | 1.6741 | 1.2882 |

| L4N10 | 0.7521 | 0.5027 | 2.2651 | 1.6853 | 1.2023 |

| L4N20 | 0.6586 | 0.3417 | 1.5532 | 1.2726 | 1.5605 |

| L4N40 | 0.4815 | 0.3338 | 1.1123 | 0.9160 | 2.2252 |

| L6N10 | 0.4890 | 0.3775 | 1.3585 | 1.0056 | 1.6617 |

| L6N20 | 0.3286 | 0.1570 | 0.7378 | 0.6244 | 2.1818 |

| L6N40 | 0.3082 | 0.1371 | 0.6828 | 0.5584 | 3.0004 |

从神经网络的训练时间来看,网络复杂度的增加虽然可以提升方程的求解精度和稳定性,但是也增加了训练时间. 在一些工程应用领域,神经网络的训练时间是重要的考虑指标. 因此,本研究固定神经网络训练时间为10 s,来对比不同网络规模下的求解效果和网络训练次数

表 3 固定训练时间下预测值绝对误差随神经网络规模变化的描述性统计

Tab.3

| | | | | | |

| L2N10 | 1.3816 | 1.5199 | 4.0196 | 2.9153 | 11.7200 |

| L2N20 | 1.3958 | 1.1166 | 3.0385 | 2.5699 | 9.3000 |

| L2N40 | 1.2500 | 0.9080 | 2.9150 | 2.3720 | 6.6600 |

| L4N10 | 1.0755 | 0.8524 | 3.3827 | 2.4212 | 8.4700 |

| L4N20 | 0.8338 | 0.8027 | 2.3934 | 1.7815 | 6.7100 |

| L4N40 | 0.9156 | 0.6179 | 2.4211 | 1.8794 | 5.0600 |

| L6N10 | 0.8874 | 1.3987 | 2.8323 | 2.0030 | 6.2000 |

| L6N20 | 0.6949 | 0.5106 | 2.2007 | 1.5836 | 4.8400 |

| L6N40 | 0.8039 | 0.7987 | 2.1866 | 1.6607 | 3.5000 |

总结来说,神经网络规模的增加可以提高求解效果,但在须考虑训练时间的工程应用中,神经网络规模的提升又会减少训练次数,从而降低求解效果. 因此,在确定的训练时间下,如何选择合适的神经网络规模来提高方程求解效果,就存在需要优化博弈的选择,这是一个值得探索的方向.

4.4. 不同规律信息与数值信息平衡度的求解测试

为了考察不同的规律信息与数值信息平衡度对PINN求解方程的影响,设置具有4个隐藏层、每层20个神经元的神经网络,并采用与4.2节相同的方程参数,固定每次神经网络的训练迭代的次数为1000次.

根据3.1节的论述,方程的物理信息分为规律信息和数值信息,而这2种信息对神经网络训练的控制,又是通过训练采样平衡度和训练强度平衡度来体现的.

对于训练采样平衡度

为了全面分析2种信息对求解方程的影响,对体现规律信息的方程内部(

表 4 不同训练采样平衡度下预测值绝对误差的描述性统计

Tab.4

| | 方程内部 | 方程边缘 | 方程整体 | |||||

| | | | | | | |||

| 3-0 | 907.00 | 82.20 | 838.00 | 118.00 | 872.00 | 107.00 | ||

| 0-1 | 2.63 | 2.30 | 1.75 | 1.54 | 2.19 | 2.04 | ||

| 3-1 | 1.59 | 1.22 | 1.56 | 1.36 | 1.57 | 1.30 | ||

| 6-0 | 907.00 | 82.90 | 839.00 | 118.00 | 873.00 | 108.00 | ||

| 0-2 | 2.50 | 2.07 | 1.65 | 1.47 | 2.08 | 1.88 | ||

| 6-2 | 1.55 | 1.19 | 1.56 | 1.35 | 1.55 | 1.28 | ||

| 9-0 | 904.00 | 82.20 | 836.00 | 118.00 | 870.00 | 107.00 | ||

| 0-3 | 2.35 | 1.98 | 1.50 | 1.19 | 1.92 | 1.72 | ||

| 9-3 | 1.41 | 1.09 | 1.47 | 1.25 | 1.44 | 1.18 | ||

对于训练强度平衡度

表 5 不同训练强度平衡度下预测值绝对误差的描述性统计

Tab.5

| | 方程内部 | 方程边缘 | 方程整体 | |||||

| | | | | | | |||

| 1∶1 | 8.44 | 3.78 | 7.12 | 4.10 | 7.78 | 4.01 | ||

| 10∶1 | 7.73 | 3.43 | 8.11 | 4.43 | 7.92 | 5.14 | ||

| 1∶10 | 8.67 | 5.33 | 6.81 | 4.74 | 7.74 | 5.14 | ||

| 50∶1 | 7.27 | 2.42 | 6.41 | 3.20 | 6.84 | 2.93 | ||

| 1∶50 | 5.45 | 1.63 | 4.66 | 1.68 | 5.05 | 1.77 | ||

| 100∶1 | 13.00 | 4.06 | 11.10 | 5.45 | 1.20 | 4.95 | ||

| 1∶100 | 7.97 | 2.57 | 5.92 | 2.12 | 6.95 | 2.69 | ||

由于Burgers-Fisher方程的内部较为平整,没有复杂的规律变化,因此方程初始条件和边界条件的数值信息会对神经网络的训练起到更大的促进作用,但如果是求解方程内部有更多变化的微分方程时,规律信息则会起到更大的作用.

综上,在采用PINN求解微分方程时,要使用适当的微分方程规律信息和数值信息平衡度来训练神经网络,这种平衡度可以从训练采样和训练强度2种角度来实现,并根据所要求解的方程类型,进行具体设置.

5. 结 论

(1)从偏微分方程的物理信息数据驱动和神经网络可解释性的角度,阐释了PINN从“PI”到“NN”的求解过程.

(2)将PDE的物理信息分为微分方程的隐式规律信息和显示数值信息2类,并从训练采样平衡度和训练强度平衡度2个方面,设计神经网络的训练采样方式,以及构建神经网络的综合信息损失函数,从而控制2类信息对神经网络训练的影响.

(3)提供了Burgers-Fisher方程利用PINN进行数值求解方法,通过数值实验发现, PINN不论在微观上的方程解的最大误差和最小误差,还是宏观上的方程解的误差均值和标准差上都体现了较好的求解精度和稳定性;随着迭代次数的增加,PINN求解方程的效果会越来越好;虽然神经网络规模的增加可以提高方程解的求解效果,但是也增加了每次训练的时间,因此固定训练时间下的神经网络规模存在最优博弈选择. 只用规律信息训练神经网络无法实现对Burgers-Fisher方程的求解,而加入数值信息训练的神经网络可以较好地求解方程. 规律信息和数值信息可以通过训练采样和设置训练强度进行平衡. 当这2种信息达到一定的平衡度时,训练得到的神经网络求解方程的效果最好.

有待进一步研究的问题如下:

(1)依据微分方程的不同类型物理信息以及求解位置来设置规律信息和数值信息的平衡度,以达到更好的神经网络训练.

(2)在一些工程应用领域,在确定的神经网络训练时间下,如何设置PINN的神经网络规模,以权衡由网络复杂度提升带来的求解精度提高和由训练次数减少带来的求解精度降低.

(3)由于微分方程的复杂性,很多方程存在多解或者零解,如何利用PINN求解多解问题和避免零解带来的干扰.

(4)由于现实中很多物理问题可以通过实验之类的方法获得测量数据,如何将这些特殊条件下的数值信息融入神经网络的训练.

(5)由于现实中的工程问题往往规模较大,而PINN方法的主要限制之一是其高维优化的高计算成本,虽然该问题可以通过采用域分解方法[22]进行处理,但是如何提高PINN对大型问题的求解效率也是值得研究的.

参考文献

基于物理信息神经网络的燃烧化学微分方程求解

[J].

Solving combustion chemical differential equations via physics-informed neural network

[J].

Physics-informed neural networks: a deep learning framework for solving forward and inverse problems involving nonlinear partial differential equations

[J].DOI:10.1016/j.jcp.2018.10.045 [本文引用: 3]

基于物理信息的神经网络: 最新进展与展望

[J].DOI:10.11896/jsjkx.210500158 [本文引用: 1]

Physics-informed neural networks: recent advances and prospects

[J].DOI:10.11896/jsjkx.210500158 [本文引用: 1]

DeepXDE: a deep learning library for solving differential equations

[J].DOI:10.1137/19M1274067 [本文引用: 2]

A two-stage physics-informed neural network method based on conserved quantities and applications in localized wave solutions

[J].DOI:10.1016/j.jcp.2022.111053 [本文引用: 1]

Physics-informed neural network methods based on Miura transformations and discovery of new localized wave solutions

[J].DOI:10.1016/j.physd.2022.133629 [本文引用: 1]

Physics-informed neural networks method in high-dimensional integrable systems

[J].DOI:10.1142/S021798492150531X [本文引用: 1]

Data-driven forward-inverse problems for Yajima–Oikawa system using deep learning with parameter regularization

[J].DOI:10.1016/j.cnsns.2022.107051 [本文引用: 1]

Burgers-Fisher方程改进的交替分段Crank-Nicolson并行差分方法

[J].DOI:10.13299/j.cnki.amjcu.002168 [本文引用: 2]

The improved alternating segment Crank-Nicolson parallel difference method for Burgers-Fisher equation

[J].DOI:10.13299/j.cnki.amjcu.002168 [本文引用: 2]

Numerical treatment for Burgers-Fisher and generalized Burgers-Fisher equations

[J].DOI:10.1007/s40096-020-00356-3 [本文引用: 3]

Adomian decomposition method for Burger’s-Huxley and Burger’s-Fisher equations

[J].DOI:10.1016/j.amc.2003.10.050 [本文引用: 1]

Explicit analytical solutions of the generalized Burger and Burger-Fisher equations by homotopy perturbation method

[J].DOI:10.1002/num.20350 [本文引用: 1]

Spectral collocation method for the solution of the generalized Burger-Fisher equation

[J].DOI:10.1016/j.amc.2005.04.084 [本文引用: 1]

Chebyshev-Legendre pseudo-spectral method for the generalised Burgers-Fisher equation

[J].DOI:10.1016/j.apm.2011.07.059 [本文引用: 1]

A spectral domain decomposition approach for the generalized Burger's-Fisher equation

[J].DOI:10.1016/j.chaos.2007.04.013 [本文引用: 1]

Investigation of the time-fractional generalized Burgers-Fisher equation via novel techniques

[J].

求解广义Burgers-Huxley方程和广义Burgers-Fisher方程的一类局部间断Petrov-Galerkin方法研究(英文)

[J].

A local discontinuous Petrov-Galerkin method for the generalized Burgers-Huxley equation and Burgers-Fisher equation

[J].

A fourth-order B-spline collocation method for nonlinear Burgers-Fisher equation

[J].DOI:10.1007/s40096-019-00317-5 [本文引用: 1]

Locally adaptive activation functions with slope recovery for deep and physics-informed neural networks

[J].DOI:10.1098/rspa.2020.0334 [本文引用: 1]

Informed machine learning: a taxonomy and survey of integrating prior knowledge into learning systems

[J].

Conservative physics-informed neural networks on discrete domains for conservation laws: applications to forward and inverse problems

[J].DOI:10.1016/j.cma.2020.113028 [本文引用: 1]