随着智能交通系统和5G通讯的发展,无人驾驶车辆定位的研究方向由车载传感器定位逐渐演变为车路协同定位,如Vehicle to Infrastructure(V2I)技术. 在校园、社区等非结构化场景中,一般有树木遮挡、环境特征少及缺乏道路信息等特点,持续横向运动时,定位存在累积误差大、精度低等问题. 研究人员从不同方向探索以实现高精度定位.

本文提出双层融合协同定位算法,采用激光雷达作为车载传感器,双目相机作为路侧摄像头. 下层为2个并行的子滤波器,分别为自适应蒙特卡洛定位(adaptive Monte Carlo localization,AMCL)和基于概率数据关联(probability data association,PDA)的KF,相应地处理激光雷达与路侧摄像头获取的位姿. 上层为全局融合估计,实现了位姿融合和结果的反馈. 该算法融合基于双地图切换机制的AMCL和基于PDA的KF滤波器,建立反馈机制,以低成本实现了车辆在非结构化场景中的高精度定位;利用多种定位算法进行横向对比,结合摄像头数量进行纵向对比,验证了双层融合协同定位算法的定位精度. 该算法对车路协同在路径规划、避障等无人驾驶领域中的应用具有重大意义.

1. 协同定位系统

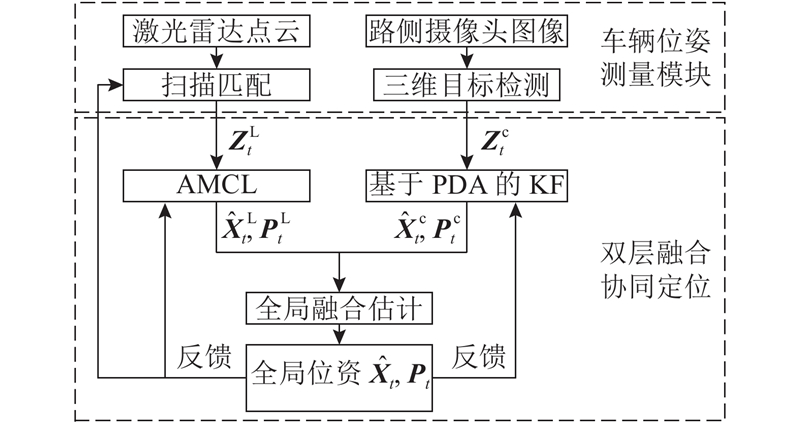

协同定位系统如图1所示,由车辆位姿(位置和航向角)测量模块和双层融合协同定位算法组成.

图 1

车辆位姿测量模块包含激光雷达和路侧摄像头. 其中,车载激光雷达利用点到线距离的迭代最近点(point to line iterative closest point,PLICP)算法,实时计算车辆位姿;路侧摄像头通过三维目标检测算法获取车辆位姿,将目标检测与阿克曼转向运动模型结合,周期性地发布车辆位姿.

在双层融合协同定位中,下层包含2个并行位姿估计. AMCL位姿估计结合双地图切换机制,利用短期和长期估计,实现静态全局地图和动态局部地图的切换,修正PLICP的累积误差;基于PDA的KF位姿估计消除虚假目标干扰,实现路侧摄像头的目标跟踪. 上层为全局融合估计,将位姿和协方差反馈至AMCL、KF及PLICP,以实现自主调节.

图 2

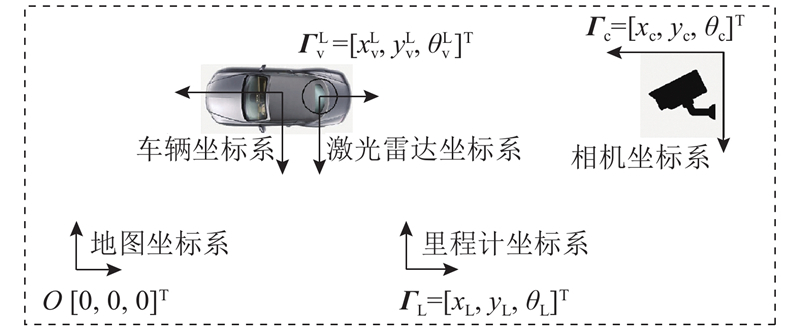

1)地图坐标系视为世界坐标系,位姿估计结果

2)里程计坐标系原点为运动起始时刻激光雷达在地图坐标系下的绝对位姿

3)相机坐标系原点为路侧摄像头在地图坐标系中的位姿

4)车辆坐标系原点为车辆质心,激光雷达坐标系原点为激光雷达质心,激光雷达在车辆坐标系中的相对位姿为

2. 车辆位姿测量模块

2.1. 基于车载激光雷达的扫描匹配

激光雷达利用PLICP算法[20],计算一组平移和旋转变换,使得前、后两帧点云达到最大重叠.

根据已知的位姿变换

式中:

根据欧式距离,在参考帧里匹配2个离映射点

目标函数为当前扫描帧的点

根据Censi[20]的证明可知,必有闭环解. 当

将位姿变换

式中:

2.2. 基于路侧摄像头的三维目标检测

相比于单目和RGBD相机,双目相机具有可间接获取深度信息、室外适应性好等特点,适合作为路侧摄像头. 双目相机利用Stereo R-CNN神经网络模型[12],实现三维目标检测,获取车辆航向角和尺度信息. 根据像素坐标系和相机坐标系的投影变换关系,求解车辆位置. 左目二维检测框的左边界

同理可得左目二维检测框的右边界

式中:

神经网络算法的实时性较差,为了提升算法的实时性,将三维目标检测与阿克曼转向运动模型结合. 已知目标检测的位姿发布周期为T,t时刻路侧摄像头位姿观测量见式(6),在t+1~t+T时刻,路侧摄像头位姿观测量如下:

式中:v为车辆纵向线速度,w为车辆角速度,d为车辆轴距.

3. 双层融合协同定位

3.1. 基于双地图的AMCL位姿估计

设t时刻AMCL位姿估计的系统状态量为

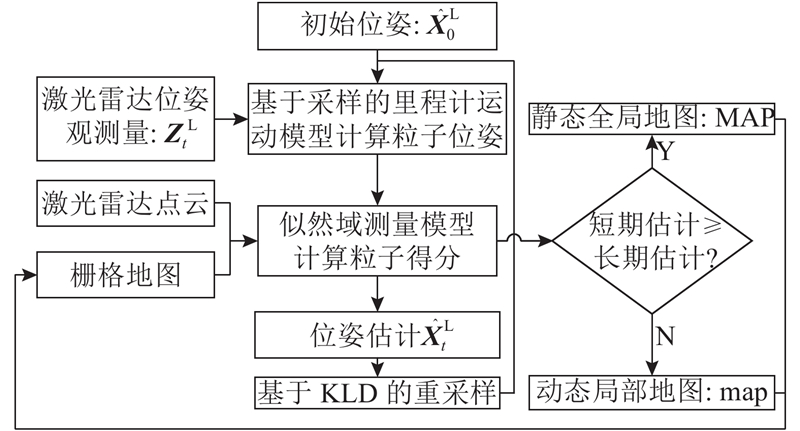

图 3

初始位姿为

3.1.1. 基于采样的里程计运动模型

车辆模型为阿克曼模型,根据激光雷达位姿观测量

根据采样算法建立运动误差模型,以经验值取误差参数

3.1.2. 似然域测量模型

利用谷歌Cartographer建图算法[21]构建静态全局地图

式中:

假设第

设

式中:

3.1.3. 基于短期和长期估计的双地图切换机制

根据式(14)可得粒子平均得分

对于t=

式中:

3.2. 基于PDA的KF位姿估计

设t时刻KF的系统状态量为

式中:

基于PDA的KF位姿估计可以消除路侧摄像头目标检测中的干扰信号,利用PDA算法[25]将上一帧与下一帧图像中的目标进行关联,实现目标跟踪.

根据贝叶斯公式和乘法定理,可得t时刻第i个观测量为正确观测量的概率

式中:

3.2.1. ${{{Z}}_t}$

假设干扰信号服从均匀分布,正确观测量服从正态分布,如下:

式中:

可得

3.2.2. ${{z}}_{t,i}^{\rm{c}}$

若目标被检测到且正确观测量落入到椭球跟踪门内,则干扰信号观测量的个数为

可得

式中:

综上所述,根据式(19)、(22)及(24),可得t时刻第i个观测量为正确观测量的概率

式中:

根据KF滤波原理,可得t时刻目标状态的位姿估计和协方差:

式中:

3.3. 全局融合估计

通过式(28)可知,位姿估计对应的协方差越小,置信度越高,其位姿估计在全局估计中的比重越大. 将全局最优估计

根据激光雷达与路侧摄像头的累积误差,可以求出协方差矩阵:

由协方差的数学性质可知,

式(29)、(31)体现了全局融合估计对下一时刻迭代初值的影响,将全局最优估计作为下一时刻下层的2个位姿估计的初值,并校准激光雷达的位姿观测量,减小扫描匹配累积误差;利用矩阵加权性质,合理反馈协方差. 全局融合估计通过位姿和协方差的反馈实现动态融合和自主调节,最大限度地降低各种动态干扰对定位的影响.

4. 实验分析

实验车辆为无人驾驶平台308S,如图4所示. 16线激光雷达置于车辆前端,IMU置于车辆质心,路侧摄像头置于路侧,通过ROS搭建通信框架,利用局域网实现车与路侧的通讯. 标定上述传感器,可得起点处激光雷达位姿

图 4

图 5

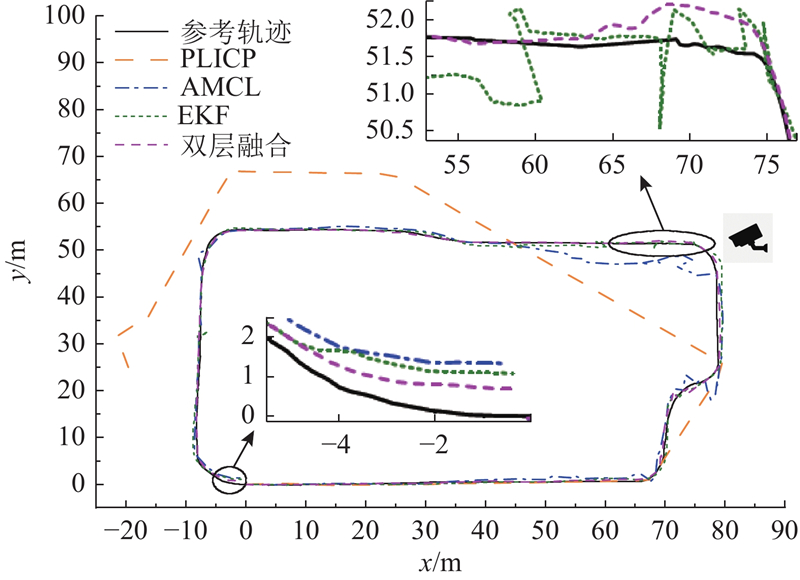

图5(b)中黑色曲线为参考轨迹,由项目数据和实地测绘获得. 起点为左下角五角星,以逆时针方向经多次转向,回到起点,总里程为500 m. 车辆以20 km/h的速度匀速行驶实现纵向运动,以10 km/h的线速度、5°转向角实现横向运动,标记纵向运动与横向运动的分界点,以实现2类运动的切换;位姿发布频率为10 Hz. 假设相同运动时间车辆到达相同地点,则位姿发布频率一致的前提下可视车辆位姿、运动时间和位姿采集点一一对应.

4.1. 定位精度分析

分析下述4种定位算法的定位精度如下. 1)PLICP:以PLICP实现激光雷达的扫描匹配定位,无滤波和车路协同;2)AMCL:仅利用针对激光雷达的AMCL位姿估计,无车路协同;3)EKF:在摄像头覆盖区域将激光雷达与摄像头观测量进行EKF融合,其余区域为AMCL;4)双层融合:在摄像头覆盖区域的定位为提出的双层融合协同定位,其余区域为AMCL.

该部分实验中路侧摄像头位于图6所示的转向区域,每次试验均在同一个转向区域放置一个路侧摄像头,并且摄像头位姿不变. 每次车辆转向时,纵向定位误差会以累积纵向误差的形式转化为横向定位误差,因此定位精度主要分析横向定位精度、航向角精度和终点处的累积纵向误差.

图 6

表 1 3种算法终点处的累积纵向误差

Tab.1

| 定位算法 | |

| AMCL | 1.402 |

| EKF | 1.146 |

| 双层融合 | 0.755 |

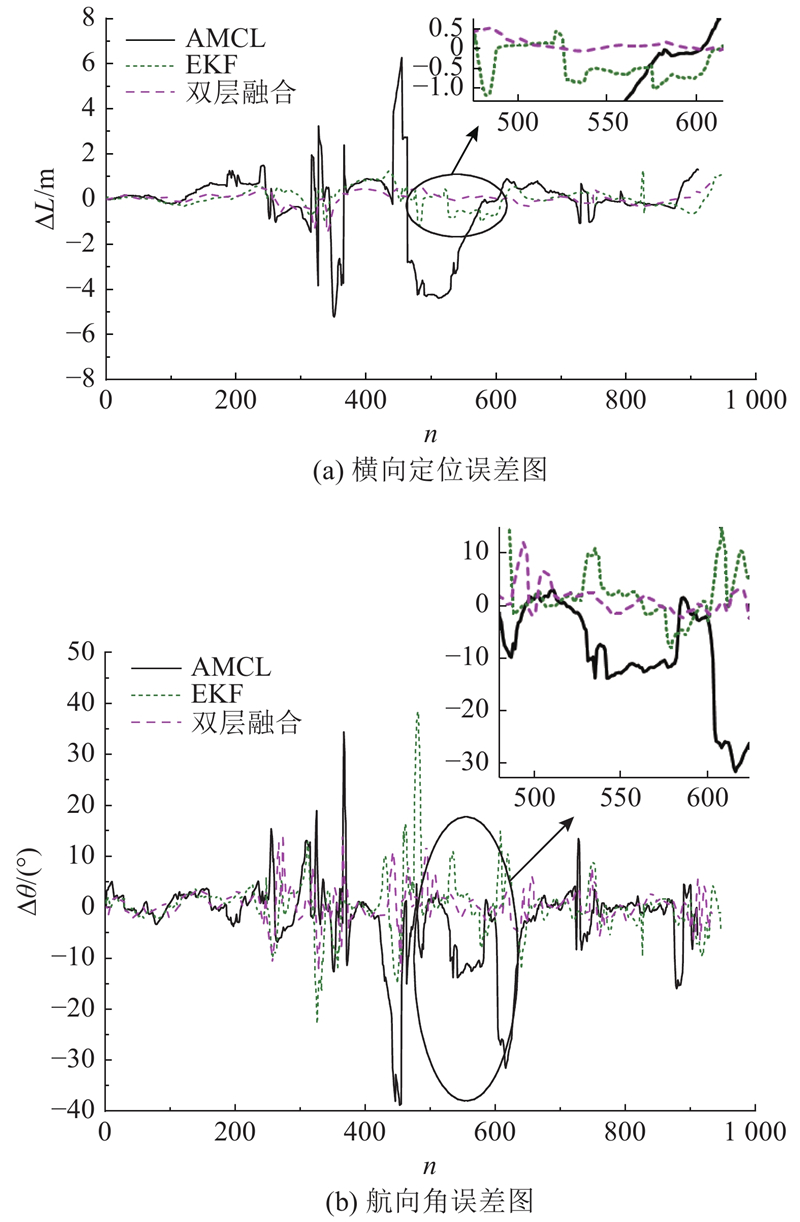

图 7

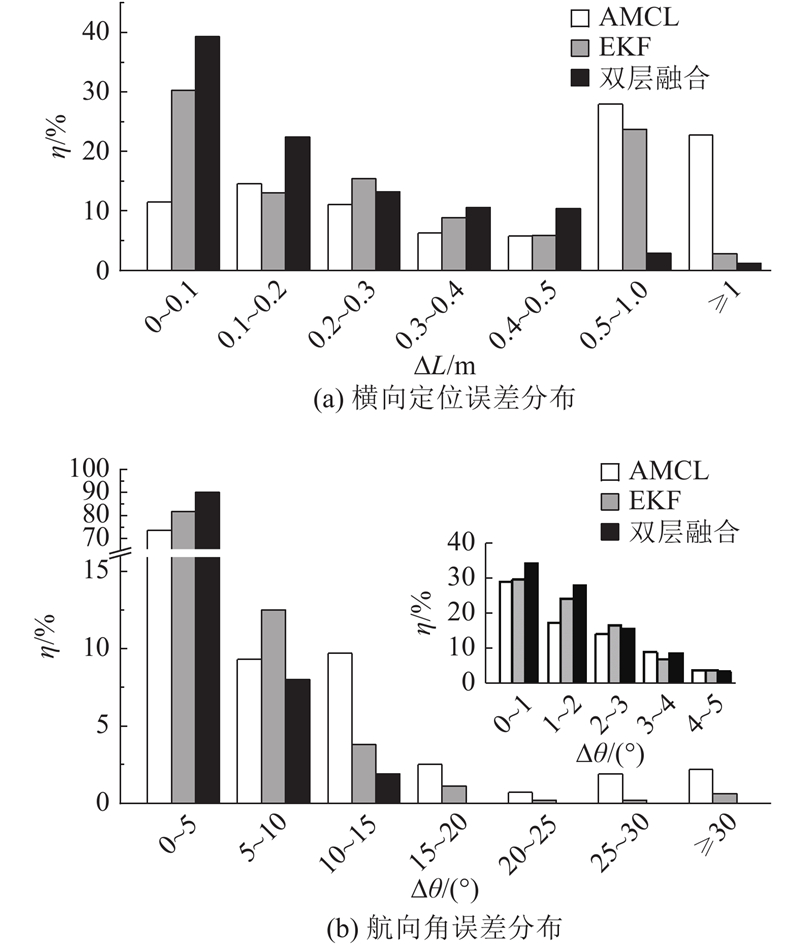

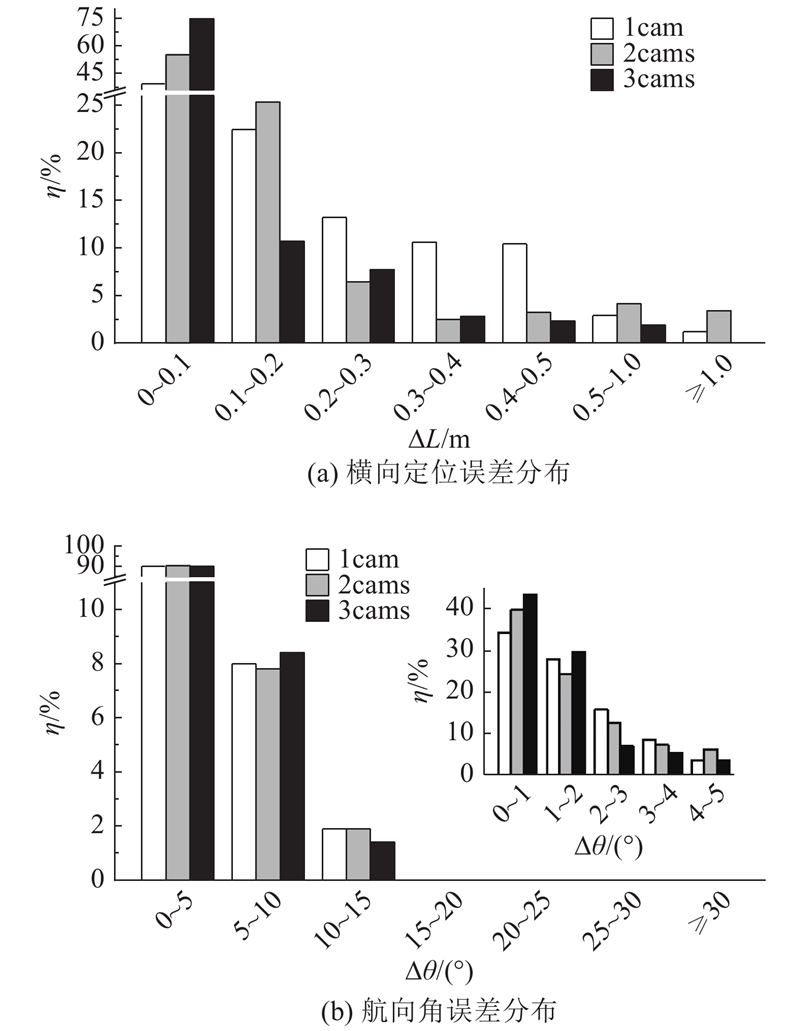

为了分析上述3种定位算法的定位精度与稳定性,计算相关统计学指标. 如图8所示为3种算法的定位误差分布,图8(a)所示为横向定位误差分布,图8(b)所示为航向角误差分布. 图中,

表 2 3种算法的定位误差统计学指标

Tab.2

| 定位算法 | | | | | | |

| AMCL | 0.956 | 1.567 | 6.273 | 4.877 | 8.149 | 38.809 |

| EKF | 0.325 | 0.435 | 1.483 | 3.260 | 5.508 | 38.478 |

| 双层融合 | 0.199 | 0.276 | 1.272 | 2.179 | 3.085 | 14.759 |

图 8

针对航向角误差,双向融合的航向角精度比EKF提升33.2%,比AMCL提升55.3%. 虽然3种定位的航向角精度均小于5°,但是结合

综上可知,双层融合的定位精度为0.199 m,航向角精度为2.179°,相比于AMCL和EKF,定位精度和稳定性有大幅度提升,说明双层融合协同定位消除了激光雷达扫描匹配的累积误差,体现了较好的自我调节能力.

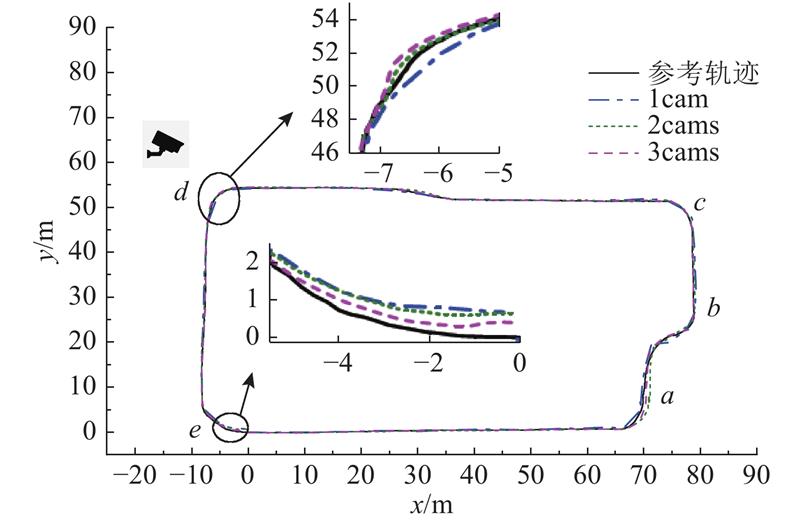

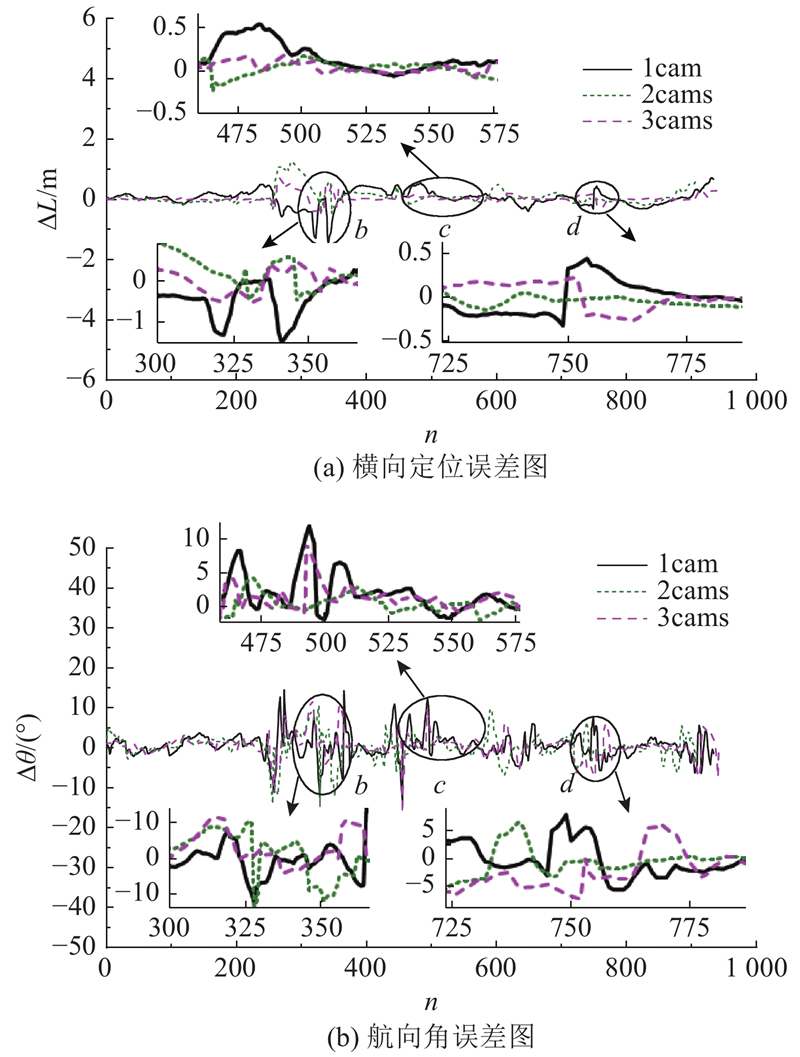

4.2. 路侧摄像头数量对定位精度的影响

图 9

图 10

图 11

图 11 3种类型在各区域的横向定位误差标准差

Fig.11 Standard deviation of lateral localization error for 3 kinds in regions

表 4 3种类型的定位误差统计学指标

Tab.4

| 类型 | | | | | | |

| 1cam | 0.199 | 0.276 | 1.272 | 2.179 | 3.120 | 14.759 |

| 2cams | 0.166 | 0.272 | 1.245 | 2.113 | 3.085 | 13.291 |

| 3cams | 0.078 | 0.143 | 0.717 | 1.848 | 2.821 | 11.778 |

图 12

综上可知,随着路侧摄像头数量的增加,可以提升横向定位稳定性,在一定程度上提升定位精度. 在该实验场景中设置3个路侧摄像头,可以实现cm级定位,精度为7.8 cm. 路侧摄像头数量增加对航向角精度的影响不大,航向角精度均约为2°.

5. 结 论

(1)双层融合协同定位以低成本实现了高精度定位,稳定性好. 相比车载激光雷达定位,如AMCL和PLICP,协同定位可以很好地消除累积误差,定位精度提升79.2%,航向角精度提升55.3%;相比无反馈的紧融合定位,如EKF,分布式结构具有更好的抗干扰能力,利用反馈实现自主调节,定位精度提升38.8%,航向角精度提升33.2%.

(2)路侧摄像头数量的增加有益于定位稳定性的提升,定位精度可以实现cm级定位. 对航向角精度的影响不大,均约为2°. 相比于GPS、惯性传感器等,摄像头成本很低,工程应用广,增加摄像头数量以提升定位精度的可行性高.

(3)横向运动的定位误差大于纵向运动,必须提升横向运动区域的定位精度,消除过大的累积误差. 航向角误差虽然小,但具有重要意义.

本文提出的双层融合协同定位算法将AMCL与KF滤波器相融合并实现反馈,极大提升了在校园、社区等非结构化场景中的定位精度,给无人驾驶在封闭园区内落地提供辅助,说明车路协同技术是未来智能交通中的关键环节. 后续将进一步解决定位算法的实时性问题,包括摄像头覆盖区域与未覆盖区域间的良好自主衔接,同时开展协同定位在车路协同系统中更深层次的应用.

参考文献

Robust navigational system for a transporter using GPS/INS fusion

[J].DOI:10.1109/TIE.2017.2752137 [本文引用: 1]

Tight fusion of a monocular camera, MEMS-IMU, and single-frequency multi-GNSS RTK for precise navigation in GNSS-challenged environments

[J].

INS/GPS/LiDAR integrated navigation system for urban and indoor environments using hybrid scan matching algorithm

[J].

A hybrid dead reckoning error correction scheme based on extended Kalman filter and map matching for vehicle self-localization

[J].DOI:10.1080/15472450.2018.1527693 [本文引用: 1]

An enhanced weight-based real-time map matching algorithm for complex urban networks

[J].

基于车路协同的车辆定位算法研究

[J].DOI:10.3969/j.issn.0258-2724.2018.05.026 [本文引用: 1]

Algorithm based on cooperative vehicle infrastructure systems

[J].DOI:10.3969/j.issn.0258-2724.2018.05.026 [本文引用: 1]

RIALS: RSU/INS-aided localization system for GPS-challenged road segments

[J].DOI:10.1002/wcm.2604 [本文引用: 1]

Vehicles on RFID: error-cognitive vehicle localization in GPS-Less environments

[J].DOI:10.1109/TVT.2017.2739123 [本文引用: 1]

A tightly-coupled GPS/INS/UWB cooperative positioning sensors system supported by V2I communication

[J].DOI:10.3390/s16070944 [本文引用: 1]

Angle of arrival-based cooperative positioning for smart vehicles

[J].DOI:10.1109/TITS.2017.2769488 [本文引用: 1]

Data fusion for a GPS/INS tightly coupled positioning system with equality and inequality constraints using an aggregate constraint unscented Kalman filter

[J].

Bayesian fusion of GNSS, ITS-G5 and IR–UWB data for robust cooperative vehicular localization

[J].DOI:10.1016/j.crhy.2019.03.004 [本文引用: 1]

A cooperative vehicle-infrastructure based urban driving environment perception method using a D-S theory-based credibility map

[J].

基于GNSS/DSRC融合的协同车辆定位方法

[J].

Cooperative vehicle positioning method based on GNSS/DSRC fusion

[J].

一种卡尔曼滤波与粒子滤波相结合的非线性滤波算法

[J].DOI:10.3969/j.issn.0372-2112.2013.01.026 [本文引用: 2]

A nonlinear filtering algorithm combining the Kalman filter and the particle filter

[J].DOI:10.3969/j.issn.0372-2112.2013.01.026 [本文引用: 2]

KLD sampling with Gmapping proposal for Monte Carlo localization of mobile robots

[J].

Improved techniques for grid mapping with Rao-Blackwellized particle filters

[J].DOI:10.1109/TRO.2006.889486 [本文引用: 1]

车路协同系统中的车辆精确定位方法研究

[J].

Study on vehicle accurate position method in cooperative vehicle infrastructure system

[J].

Modified federated Kalman filter for INS/GNSS/CNS integration

[J].

Distributed federated Kalman filter fusion over multi-sensor unreliable networked systems

[J].DOI:10.1109/TCSI.2016.2587728 [本文引用: 1]

Multi-sensor distributed fusion estimation with applications in networked systems: a review paper

[J].

Matrix weighted multisensor data fusion for INS/GNSS/CNS integration

[J].