[1]

吕承侃, 沈飞, 张正涛, 等 图像异常检测研究现状综述

[J]. 自动化学报 , 2022 , 48 (6 ): 1402 - 1428

[本文引用: 1]

LV Chengkan, SHEN Fei, ZHANG Zhengtao, et al Review of image anomaly detection

[J]. Acta Automatica Sinica , 2022 , 48 (6 ): 1402 - 1428

[本文引用: 1]

[2]

LIU J, XIE G, WANG J, et al Deep industrial image anomaly detection: a survey

[J]. Machine Intelligence Research , 2024 , 21 (1 ): 104 - 135

DOI:10.1007/s11633-023-1459-z

[本文引用: 1]

[3]

KIRILLOV A, MINTUN E, RAVI N, et al. Segment anything [C]// IEEE/CVF International Conference on Computer Vision . Paris: IEEE, 2023: 3992–4003.

[本文引用: 1]

[4]

HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks [C]// IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 2261–2269.

[本文引用: 1]

[5]

SHI W, CABALLERO J, HUSZÁR F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network [C]// IEEE Conference on Computer Vision and Pattern Recognition . Las Vegas: IEEE, 2016: 1874–1883.

[本文引用: 1]

[6]

BERGMANN P, FAUSER M, SATTLEGGER D, et al. MVTec AD: a comprehensive real-world dataset for unsupervised anomaly detection [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Long Beach: IEEE, 2019: 9584–9592.

[本文引用: 2]

[7]

ZHOU W, WANG T, HE Y, et al Contrast U-Net driven by sufficient texture extraction for carotid plaque detection

[J]. Mathematical Biosciences and Engineering , 2023 , 20 (9 ): 15623 - 15640

DOI:10.3934/mbe.2023697

[本文引用: 1]

[8]

HU J, SHEN L, SUN G. Squeeze-and-excitation networks [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 7132–7141.

[本文引用: 1]

[9]

HE Y, XIANG S, ZHOU W, et al. A novel contrast operator for robust object searching [C]// 17th International Conference on Computational Intelligence and Security . Chengdu: IEEE, 2021: 309–313.

[本文引用: 2]

[10]

LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection [C]// IEEE International Conference on Computer Vision . Venice: IEEE, 2017: 2999–3007.

[本文引用: 1]

[11]

BERMAN M, TRIKI A R, BLASCHKO M B. The lovasz-softmax loss: a tractable surrogate for the optimization of the intersection-over-union measure in neural networks [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 4413–4421.

[本文引用: 1]

[12]

DEFARD T, SETKOV A, LOESCH A, et al. PaDiM: a patch distribution modeling framework for anomaly detection and localization [C]// International conference on pattern recognition . Cham: Springer International Publishing, 2021: 475–489.

[本文引用: 2]

[13]

BERGMANN P, FAUSER M, SATTLEGGER D, et al. Uninformed students: student-teacher anomaly detection with discriminative latent embeddings [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Seattle: IEEE, 2020: 4182−4191.

[本文引用: 1]

[14]

BERGMANN P, LOWS S, FAUSER M, et al. Improving unsupervised defect segmentation by applying structural similarity to autoencoders.

[本文引用: 2]

[16]

LI C L, SOHN K, YOON J, et al. CutPaste: self-supervised learning for anomaly detection and localization [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . Nashville: IEEE, 2021: 9659-9669.

[本文引用: 1]

[17]

张玥, 陈锡伟, 陈梦丹, 等 基于对比学习生成对抗网络的无监督工业品表面异常检测

[J]. 电子测量与仪器学报 , 2023 , 37 (10 ): 193 - 201

[本文引用: 2]

ZHANG Yue, CHEN Xiwei, CHEN Mengdan, et al Unsupervised surface anomaly detection of industrial products based on contrastive learning generative adversarial network

[J]. Journal of Electronic Measurement and Instrumentation , 2023 , 37 (10 ): 193 - 201

[本文引用: 2]

[18]

WAN Q, GAO L, LI X, et al Unsupervised image anomaly detection and segmentation based on pretrained feature mapping

[J]. IEEE Transactions on Industrial Informatics , 2023 , 19 (3 ): 2330 - 2339

DOI:10.1109/TII.2022.3182385

[本文引用: 1]

[19]

孔森林, 张辉, 黄镇南, 等 面向工业图像异常检测的非对称师生网络模型

[J]. 计算机科学 , 2024 , 51 (Suppl.2 ): 331 - 337

[本文引用: 2]

KONG Senlin, ZHANG Hui, HUANG Zhennan, et al Asymmetric teacher-student network model for industrial image anomaly detection

[J]. Computer Science , 2024 , 51 (Suppl.2 ): 331 - 337

[本文引用: 2]

图像异常检测研究现状综述

1

2022

... 在制造业中,工业图像异常检测技术常用于检测工业制品的表面异常,其以独特的优势与功能,在提升产品质量、优化成本结构方面发挥着不可替代的作用. 然而,目前大部分的传统方法仅在特定场景下有效[1 ] ,不具有普适性,比如Reed等提出的RX (Reed-xiao)算法就利用高斯分布函数来描述高光谱图像中像素点内信息的分布情况[2 ] . 仅仅依靠一个高斯分布模型很难描述更为复杂多变的场景,在现实环境中的适用性受限. 监督学习方法又面临带准确标注的样本量不足的问题. 因此,学界目前采用无监督方式进行训练. 仅使用正常数据训练的深度网络理论上无法准确重建异常区域,在某些情况下,网络可能过于泛化,以至于可以将异常输入重建为正常信息,从而导致误检. 总的来说,图像异常检测领域目前的问题在于无监督方法对于图像异常检测的准确度不够,而监督学习虽然可以得到较高的准确度,但在实际生产中没有足够数据集来支撑监督学习. ...

图像异常检测研究现状综述

1

2022

... 在制造业中,工业图像异常检测技术常用于检测工业制品的表面异常,其以独特的优势与功能,在提升产品质量、优化成本结构方面发挥着不可替代的作用. 然而,目前大部分的传统方法仅在特定场景下有效[1 ] ,不具有普适性,比如Reed等提出的RX (Reed-xiao)算法就利用高斯分布函数来描述高光谱图像中像素点内信息的分布情况[2 ] . 仅仅依靠一个高斯分布模型很难描述更为复杂多变的场景,在现实环境中的适用性受限. 监督学习方法又面临带准确标注的样本量不足的问题. 因此,学界目前采用无监督方式进行训练. 仅使用正常数据训练的深度网络理论上无法准确重建异常区域,在某些情况下,网络可能过于泛化,以至于可以将异常输入重建为正常信息,从而导致误检. 总的来说,图像异常检测领域目前的问题在于无监督方法对于图像异常检测的准确度不够,而监督学习虽然可以得到较高的准确度,但在实际生产中没有足够数据集来支撑监督学习. ...

Deep industrial image anomaly detection: a survey

1

2024

... 在制造业中,工业图像异常检测技术常用于检测工业制品的表面异常,其以独特的优势与功能,在提升产品质量、优化成本结构方面发挥着不可替代的作用. 然而,目前大部分的传统方法仅在特定场景下有效[1 ] ,不具有普适性,比如Reed等提出的RX (Reed-xiao)算法就利用高斯分布函数来描述高光谱图像中像素点内信息的分布情况[2 ] . 仅仅依靠一个高斯分布模型很难描述更为复杂多变的场景,在现实环境中的适用性受限. 监督学习方法又面临带准确标注的样本量不足的问题. 因此,学界目前采用无监督方式进行训练. 仅使用正常数据训练的深度网络理论上无法准确重建异常区域,在某些情况下,网络可能过于泛化,以至于可以将异常输入重建为正常信息,从而导致误检. 总的来说,图像异常检测领域目前的问题在于无监督方法对于图像异常检测的准确度不够,而监督学习虽然可以得到较高的准确度,但在实际生产中没有足够数据集来支撑监督学习. ...

1

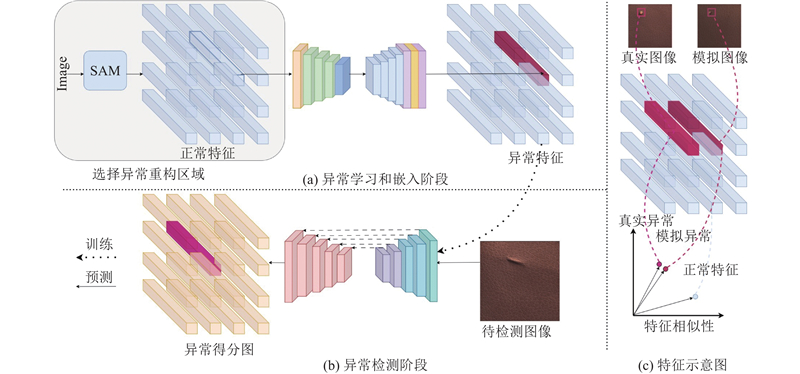

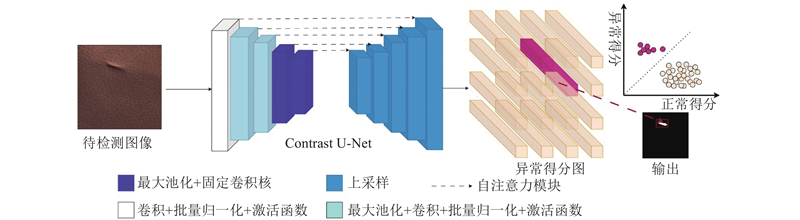

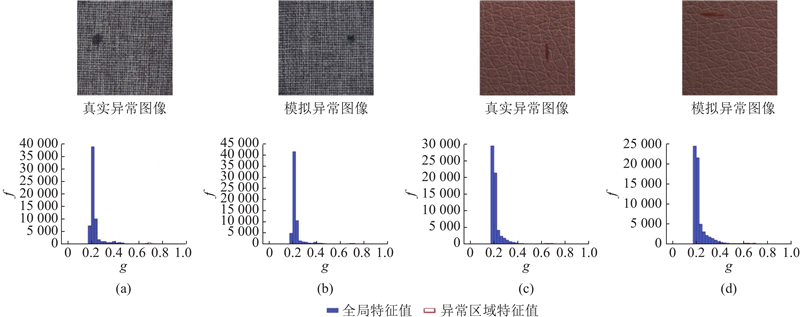

... 本研究提出新的检测框架,即通过利用少量的异常图像,来学习并理解异常区域在纹理、色彩、亮度等多个特征上的分布特性,进而运用这些异常特征,扩充带有标注的异常图像数据集,使其样本量足以支撑监督训练. 如图1 所示,EDA主要分为异常学习和嵌入阶段与异常检测阶段,其中图1(a) 表示异常学习和嵌入阶段,使用少量真实异常图像及其掩码进行训练,仅学习异常区域的特征. 在预测模块中,输入大量正常图像,随机选择一块区域并使用SAM (segment anything)[3 ] 进行细分,将其输入到模型中将正常特征转化为异常特征,得到大量模拟异常图像及相应掩码;图1(b) 表示异常检测阶段,输入的异常图像经过网络得到异常分值图和正常分值图,当异常得分大于正常得分时判定为异常从而得到二值化输出;图1(c) 表示图像在网络中的特征图,模拟异常和真实异常具有相似的特征,并且与正常区域有着显著差别. ...

1

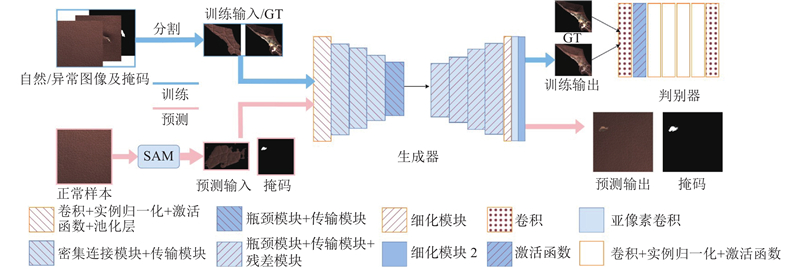

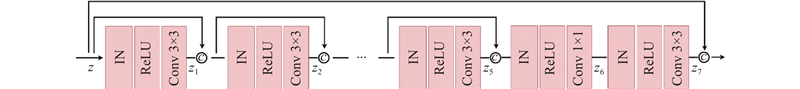

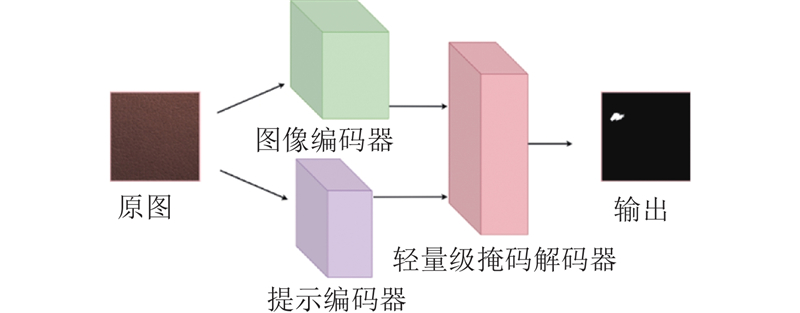

... 此阶段经多轮迭代,重构正常区域以模拟异常区域的特征分布. 随后,利用学习到的异常表征,结合SAM在大量正常图像中选取特定区域将其重构为异常形态,从而有效扩增异常数据集的规模. 首先,利用少量带注释的异常图像分割异常区域作为GT,同时分割正常图像相应区域作为输入. 异常区域占比小,模型输入数据较小,因此减少了模型中的参数数量,降低了计算资源. 为了获得更好的结果,对生成对抗网络进行了一些修改,以更好地适应实际需求. 网络结构如图2 所示. 在生成器的编码器部分,为了保留更多的空间特征信息,增加了瓶颈模块和传输模块[4 ] . 瓶颈模块结构图如图3 所示,采用实例归一化,使网络具有更好的训练稳定性,避免梯度爆炸. 传输模块放置在最后一层,以增强从瓶颈模块获得的特征. 鉴于异常区域仅占正常图像很小的比例且分辨率较低,为了增强异常信息并捕捉更多细节,在网络中融入了亚像素卷积[5 ] ,以显著提升图像处理敏锐度,确保精准捕捉并放大异常特征. 当真实摄像机捕捉图像时,物理世界中的连续图像被离散化. 成像平面上的每个像素只表示它周围的颜色. 在微观层面上,它们之间存在着无限小的实体. 将这些较小的实体称为“亚像素”. 本研究在解码器中加入了亚像素卷积,其表达式如下: ...

1

... 此阶段经多轮迭代,重构正常区域以模拟异常区域的特征分布. 随后,利用学习到的异常表征,结合SAM在大量正常图像中选取特定区域将其重构为异常形态,从而有效扩增异常数据集的规模. 首先,利用少量带注释的异常图像分割异常区域作为GT,同时分割正常图像相应区域作为输入. 异常区域占比小,模型输入数据较小,因此减少了模型中的参数数量,降低了计算资源. 为了获得更好的结果,对生成对抗网络进行了一些修改,以更好地适应实际需求. 网络结构如图2 所示. 在生成器的编码器部分,为了保留更多的空间特征信息,增加了瓶颈模块和传输模块[4 ] . 瓶颈模块结构图如图3 所示,采用实例归一化,使网络具有更好的训练稳定性,避免梯度爆炸. 传输模块放置在最后一层,以增强从瓶颈模块获得的特征. 鉴于异常区域仅占正常图像很小的比例且分辨率较低,为了增强异常信息并捕捉更多细节,在网络中融入了亚像素卷积[5 ] ,以显著提升图像处理敏锐度,确保精准捕捉并放大异常特征. 当真实摄像机捕捉图像时,物理世界中的连续图像被离散化. 成像平面上的每个像素只表示它周围的颜色. 在微观层面上,它们之间存在着无限小的实体. 将这些较小的实体称为“亚像素”. 本研究在解码器中加入了亚像素卷积,其表达式如下: ...

2

... MVTec数据集[6 ] 中的异常图像数量有限,每种异常类型只有16张图像,因此选择使用实例规范化(IN)而不是批处理规范化. IN对每个样本的每个特征通道进行独立归一化,能更好地保留图像细节,适合小批量训练. ...

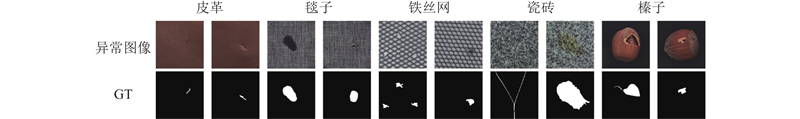

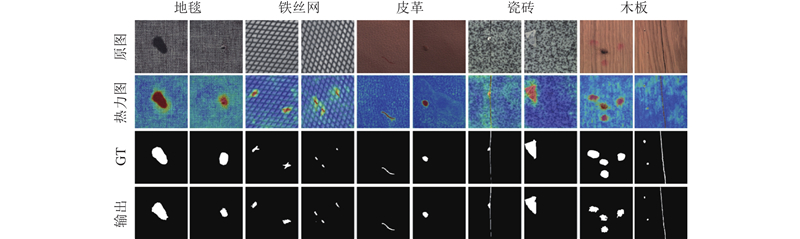

... 使用的实验数据集为MVTec AD[6 ] . 该数据集涵盖了工业检测领域的多种场景,包含15个不同的对象或纹理类别(例如铁丝网、皮革、大理石等),每个类别都有一组无异常的训练图像和一组带有各种异常或无异常的测试图像. 总共有5354 张高分辨率图像,其中1258 张为异常图像,并且提供了所有异常区域的像素级精确标注. 这些异常图像反映了70多种不同类型的异常现象,如划痕、凹痕、污染和各种结构变化等. 如图7 所示展示了MVTec数据集中部分类别的异常图像及Ground Truth. ...

Contrast U-Net driven by sufficient texture extraction for carotid plaque detection

1

2023

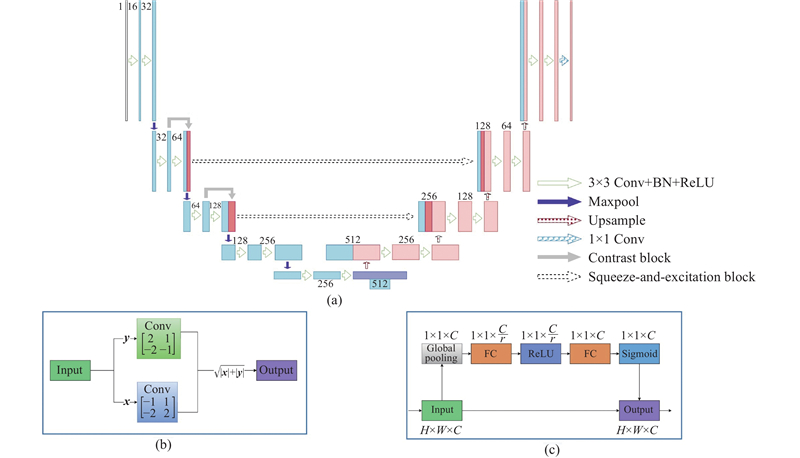

... 在异常检测阶段,针对于一些特定场合中异常区域的颜色、锐度及色调特征可能与正常区域并无显著区别的情况,聚焦于纹理特征的显著差异,引入Contrast U-Net作为异常检测主干网络,该网络能对于图像浅层纹理信息充分提取和利用,准确学习到目标区域的纹理特性,从而达到较好的分割效果. 这在笔者之前的工作[7 ] 得到了验证,在颈动脉超声图像斑块检测任务中,该网络实现了对颈动脉斑块的高精度分割,展现了其处理纹理复杂数据的卓越性能. 针对工业图像异常检测任务,异常区域的纹理信息通常与正常区域具有明显偏差,基于Contrast U-Net在纹理特征处理方面的优势,本研究将其作为异常检测主干网络. 考虑到工业图像包含更丰富的浅层信息,将Contrast U-Net进行细微优化调整,取消第1层的挤压和激励(SE)模块[8 ] ,保留第2层与第3层,在保证关键纹理特征提取的前提下,有效减少了模型的参数量. 该网络架构如图5 所示,将对比度算子$ {\mathrm{cvo}} $ [9 ] 作为固定卷积核,嵌入至U-Net原有架构之上. 通过多次实验验证,对比度算子$ {\mathrm{cvo}} $ $ {\mathrm{cvo}} $ 图6 所示. 其中,图6(a) 为网络的整体结构;图6 (b)表示Contrast Block,分别使用x 和y 方向的对比度算子cvo对输入图像进行卷积,以获得图像的梯度信息和纹理特征;图6 (c)表示挤压和激励模块. ...

1

... 在异常检测阶段,针对于一些特定场合中异常区域的颜色、锐度及色调特征可能与正常区域并无显著区别的情况,聚焦于纹理特征的显著差异,引入Contrast U-Net作为异常检测主干网络,该网络能对于图像浅层纹理信息充分提取和利用,准确学习到目标区域的纹理特性,从而达到较好的分割效果. 这在笔者之前的工作[7 ] 得到了验证,在颈动脉超声图像斑块检测任务中,该网络实现了对颈动脉斑块的高精度分割,展现了其处理纹理复杂数据的卓越性能. 针对工业图像异常检测任务,异常区域的纹理信息通常与正常区域具有明显偏差,基于Contrast U-Net在纹理特征处理方面的优势,本研究将其作为异常检测主干网络. 考虑到工业图像包含更丰富的浅层信息,将Contrast U-Net进行细微优化调整,取消第1层的挤压和激励(SE)模块[8 ] ,保留第2层与第3层,在保证关键纹理特征提取的前提下,有效减少了模型的参数量. 该网络架构如图5 所示,将对比度算子$ {\mathrm{cvo}} $ [9 ] 作为固定卷积核,嵌入至U-Net原有架构之上. 通过多次实验验证,对比度算子$ {\mathrm{cvo}} $ $ {\mathrm{cvo}} $ 图6 所示. 其中,图6(a) 为网络的整体结构;图6 (b)表示Contrast Block,分别使用x 和y 方向的对比度算子cvo对输入图像进行卷积,以获得图像的梯度信息和纹理特征;图6 (c)表示挤压和激励模块. ...

2

... 在异常检测阶段,针对于一些特定场合中异常区域的颜色、锐度及色调特征可能与正常区域并无显著区别的情况,聚焦于纹理特征的显著差异,引入Contrast U-Net作为异常检测主干网络,该网络能对于图像浅层纹理信息充分提取和利用,准确学习到目标区域的纹理特性,从而达到较好的分割效果. 这在笔者之前的工作[7 ] 得到了验证,在颈动脉超声图像斑块检测任务中,该网络实现了对颈动脉斑块的高精度分割,展现了其处理纹理复杂数据的卓越性能. 针对工业图像异常检测任务,异常区域的纹理信息通常与正常区域具有明显偏差,基于Contrast U-Net在纹理特征处理方面的优势,本研究将其作为异常检测主干网络. 考虑到工业图像包含更丰富的浅层信息,将Contrast U-Net进行细微优化调整,取消第1层的挤压和激励(SE)模块[8 ] ,保留第2层与第3层,在保证关键纹理特征提取的前提下,有效减少了模型的参数量. 该网络架构如图5 所示,将对比度算子$ {\mathrm{cvo}} $ [9 ] 作为固定卷积核,嵌入至U-Net原有架构之上. 通过多次实验验证,对比度算子$ {\mathrm{cvo}} $ $ {\mathrm{cvo}} $ 图6 所示. 其中,图6(a) 为网络的整体结构;图6 (b)表示Contrast Block,分别使用x 和y 方向的对比度算子cvo对输入图像进行卷积,以获得图像的梯度信息和纹理特征;图6 (c)表示挤压和激励模块. ...

... Pixel-level AU-PR comparison results for different models

Tab.3 类别 US[9 ] AE-SSIM RIAD PaDim CutPaste CLGAN MB-PFM ATSNM 本研究算法 bottle 74.2 — 76.4 73.0 77.9 79.6 76.7 78.7 86.6 capsule 25.9 — 38.2 33.4 32.3 69.6 46.2 52.7 72.8 grid 10.1 — 36.4 58.0 42.6 64.9 45.3 45.1 68.5 leather 40.9 — 49.1 45.2 54.6 75.4 46.8 57.4 76.3 pill 62.0 — 51.6 60.2 51.8 76.3 78.6 66.4 72.5 tile 65.3 — 52.6 51.7 67.2 87.6 80.3 89.1 95.6 transistor 27.1 — 39.2 71.3 70.8 67.7 56.8 70.3 77.5 zipper 36.1 — 63.4 16.6 68.5 68.7 55.6 72.6 86.3 cable 48.2 — 24.4 34.3 55.6 73.8 67.7 69.4 75.3 carpet 52.2 — 61.4 49.7 57.3 87.6 58.3 80.2 90.7 hazelnut 57.8 — 33.8 37.4 53.7 68.4 60.7 76.3 96.3 metalnut 83.5 — 64.3 39.4 62.5 67.7 78.1 77.6 75.6 screw 17.8 — 43.9 51.7 58.6 69.3 52.6 69.4 74.2 toothbrush 37.7 — 50.6 40.6 46.8 59.6 53.4 54.9 67.4 wood 53.3 — 38.2 42.3 79.3 77.3 46.7 78.7 76.8 平均 46.14 — 48.2 47.0 58.6 67.5 61.1 68.92 81.1

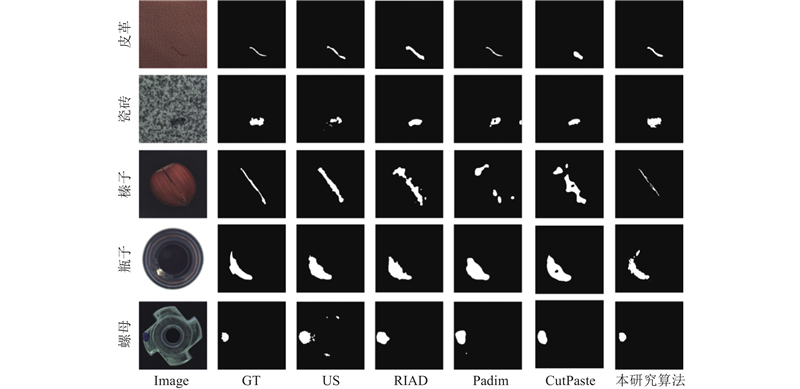

图 8 不同方法的定性结果对比 ...

1

... 在图像的异常检测中,由于异常图像中正常区域的比例较大,正常区域和异常区域的分布会不平衡. 为了解决这种不平衡并改善网络的效果,采用2个损失函数的组合:Focal loss (FL)[10 ] 和Lovasz loss (LL)[11 ] . ...

1

... 在图像的异常检测中,由于异常图像中正常区域的比例较大,正常区域和异常区域的分布会不平衡. 为了解决这种不平衡并改善网络的效果,采用2个损失函数的组合:Focal loss (FL)[10 ] 和Lovasz loss (LL)[11 ] . ...

2

... 采用异常检测的标准度量AUROC (area under the ROC curve)[12 ] 以及平均精度AP (average precision)进行检测效果评价,ROC曲线是一种图形表示,其横轴为假阳率(FPR),纵轴为真阳率(TPR). AP为PR曲线下方的面积,其中PR曲线是一个二维坐标系,其中横轴表示召回率(Recall),纵轴表示精度(Precision). 指标相关计算公式如下: ...

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

1

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

2

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

... [14 ,17 -19 ]. 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

Reconstruction by inpainting for visual anomaly detection

1

2021

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

1

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

基于对比学习生成对抗网络的无监督工业品表面异常检测

2

2023

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

... ,17 -19 ]. 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

基于对比学习生成对抗网络的无监督工业品表面异常检测

2

2023

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

... ,17 -19 ]. 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

Unsupervised image anomaly detection and segmentation based on pretrained feature mapping

1

2023

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

面向工业图像异常检测的非对称师生网络模型

2

2024

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

... -19 ]. 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

面向工业图像异常检测的非对称师生网络模型

2

2024

... 挑选8种近期在异常检测领域表现突出的算法进行比较,分别为US[13 ] 、AESSIM[14 ] 、RIAD[15 ] 、PaDim[12 ] 、CutPaste[16 ] 、CLGAN[17 ] 、MB-PFM[18 ] 和ATSNM[19 ] . 与本研究实验设置相同,最大迭代轮数为150,初始学习率为0.0001 ,批处理大小为16. 其中US、AESSIM、RIAD均基于重建的核心理念,它们通过重构输入数据并对比重构误差来识别异常. PaDim及MB-PFM通过多层网络提取特征后进行多尺度融合,通过判断测试图像的特征与高斯分布的偏离程度来检测异常. CutPaste对正常图像进行裁剪和黏贴之类的数据增强操作,然而简单的裁剪黏贴操作后的增强数据不具备原本的异常特征,从而在训练过程对于异常信息的学习出现偏差. 本研究方法采用深度学习准确地学习异常特征,纠正了这种偏差并取得了更为优异的表现. CLGAN在生成对抗网络的基础上采用对比学习加强潜在特征空间正负例样本约束,使得输入与输出图像对应Patch之间的互信息最大化,使模型识别异常样本图像能力得到提升. ATSNM基于非对称师生网络,为师生网络添加结构差异性,阻止学生网络过模仿教师网络的映射,提升了蒸馏的稳定性. 如表2 所示显示了不同方法在图像级和像素级上的AUROC性能,在多个类中获取最佳表现并且在均值上表现优异. 如表3 所示显示了不同方法在像素级上的AP性能具有显著优势,表明本研究方法较先进,对于异常区域的分割较精准. 为了直观地展示EDA的优越性能,如图8 所示展示了与其他方法的定性比较结果. 由于AESSIM、MB-PFM、CLGAN以及ATSNM模型未公开代码,这4种方法的指标结果取自其论文[14 ,17 -19 ] . 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...

... -19 ]. 从结果可以看出,EDA的分割结果更为精细和准确. 如图10 所示展示了本研究方法对于不同类别的一些异常图像的检测结果. 可以看出,EDA对不同种类工业品图像中的不同类型的异常均进行了有效的定位和分割. ...