情感是人与人交流中非常重要的部分. 情感的外在表现易受人的主观意识控制[1],人的生理信号更能够客观地反映人的情感状态. 已有研究发现,情感是大脑皮层和皮层下神经协同活动的结果,常用的与大脑神经活动相关的生理信号主要有脑电(electroencephalogram, EEG)、功能近红外(functional near-infrared spectroscopy, fNIRS)、功能性磁共振成像 (functional magnetic resonance imaging, fMRI)等. 其中,EEG的时间分辨率高,fNIRS的空间分辨率高,两者都可以反映大脑的情感认知过程,具有无创采集、使用便捷、成本较低的优点[2].

基于EEG信号进行情感识别的研究方法有多种,许多学者分别构建基于支持向量机(support vector machine, SVM)、卷积神经网络(convolutional neural network, CNN)、图卷积网络(graph convolutional network, GCN)、Transformer、Deep Forest等网络的分类识别模型. Majid等[3]使用SVM模型进行EEG信号分类. Li等[4]提出STC-CNN网络模型,从EEG中提取时间、空间和连接特征. Du等[5]提出MD-GCN模型,整合EEG的时空间特征. Li等[6]结合CNN和Transformer进行EEG分类. Cheng等[7]使用深林进行基于多通道EEG的情绪识别的方法,在DEAP数据集上的情感识别率分别达到97.69%和97.53%. 利用fNIRS信号进行情感识别的研究主要基于自建的非公开的数据集,Bandara等[8]使用与DEAP数据集相同的刺激材料构建fNIRS情感数据库,在跨被试实验中分别取得了73.9%和66.0%的情感识别率. Hu等[9]建立包含10种离散积极情感的fNIRS数据库,对该数据库进行两两分类,证明fNIRS信号可以区分细分的积极情绪.

尽管基于深度学习的情感识别已经取得一些成果,但仍存在以下挑战. 1)深度学习的识别效果需要海量的数据作为支撑,若样本数量不足,则模型受到过拟合因素的影响,识别准确率下降[15]. 因为当前没有公开的EEG-fNIRS情感数据集,本文自主采集50名被试的EEG和fNIRS数据进行研究,样本有限. 2)在传统的卷积神经网络算法中,神经元的输入输出都是标量形式,丢失了大量有价值的空间信息,无法保留完整特征间的空间关系,影响识别效果[16-17]. 本文采用胶囊网络(capsule network, CapsNet)[18]作为情感识别网络,它的神经元输入输出为向量形式,可以保留确切的空间位置信息;舍弃池化层结构,只需较小的数据集就能训练出比较优秀的网络.

为了提取质量更高的初级胶囊,常用方法是在胶囊网络上加入时间、通道、空间注意力机制. 这些方法没有考虑大脑在情绪表达过程中,不同情感状态下大脑不同功能区情感表达的差异性. 输入数据是EEG和fNIRS双模态信号,会生成更多的胶囊,模型的参数量和计算量都会增大.

针对上述问题,本文提出基于多脑区注意力机制胶囊融合的EEG-fNIRS情感识别模型——多脑区注意力机制和胶囊融合模块的胶囊网络 (multi brain attention-capsule fusion-conv CapsNet, MBA-CF-cCapsNet),创新点如下. 1)提出多脑区注意力机制. 在胶囊网络的卷积层之前,不同情感状态下不同脑区赋予不同的权重,有利于提取不同情感状态下最具有鉴别力的特征,生成质量更高的初级胶囊. 2)设计胶囊融合模块. 该模块位于胶囊网络动态路由机制之前,相同像素位置的胶囊进行融合,一方面可以减少进入动态路由机制的胶囊的数量,减少模型的计算量,另一方面可以减少多余的背景信息,提高识别性能.

1. 方法介绍

如图1所示为EEG和fNIRS情感识别框架,主要包括EEG和fNIRS数据库构建及预处理、特征提取以及MBA-CF-cCapsNet情感识别框架.

图 1

1.1. EEG和fNIRS情感数据库

筛选4种情感类型的60段视频片段,采集50名被试的EEG和fNIRS信号,构建情感数据集TYUT3.0.

图 2

图 3

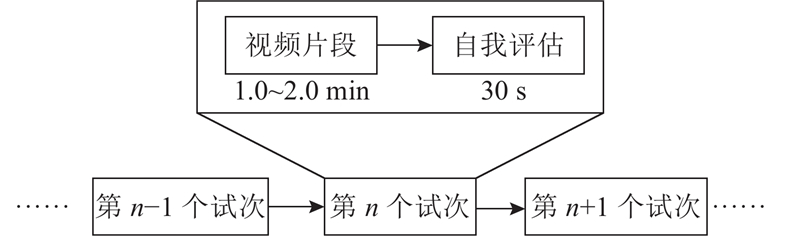

图 3 EEG-fNIRS情感识别的实验范式

Fig.3 Experimental paradigm for EEG-fNIRS emotion recognition

对于EEG信号,经过滤波、重参考、降采样、去除伪迹等操作,对于fNIRS信号,经过滤波和基线校正操作.

1.2. 特征提取

对于EEG信号,将预处理后的EEG信号采用窗长为3 s、步长为1.5 s的方式进行分段,分成长度为3 s的数据,通过傅里叶变化提取δ(0.5~4.0 Hz)、θ(4~8 Hz)、α(8~12 Hz)、β(13~30 Hz)、γ(30~45 Hz)5个频段的EEG信号. 相较于其他EEG信号情感特征,微分熵(differential entropy,DE)特征在情感识别领域有着更广泛的应用和更好的性能[23],计算每段EEG信号每个频段上的DE特征,获得3 132×62×5(样本数×通道数×特征数)的矩阵. 设x是EEG信号,p(x)表示概率密度函数,公式如下:

EEG信号经过预处理后符合高斯分布[24],则EEG信号的概率密度函数p(x)为

将式(2)代入DE的计算公式,可得

对于fNIRS信号,为了获得和EEG特征相同的数据格式,采用和EEG信号相同的分段方式,提取相同数量的特征. 提取每段fNIRS信号的方差、平均值、偏度、DE、功率谱密度(power spectrum density, PSD)特征,获得3 132×18×5(样本数×通道数×特征数)的矩阵. 基本计算公式如下.

式中:y为每段fNIRS信号,N为每段fNIRS信号所包含的样本点数.

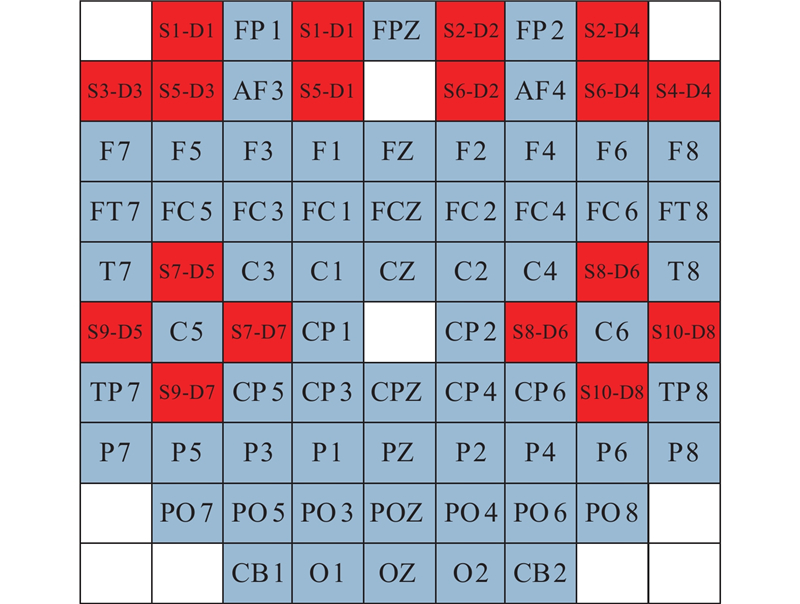

如图4所示,按照EEG和fNIRS的脑区分布,将EEG和fNIRS信号映射到二维矩阵中的通道分布图,对于没有值的位置填充为0,得到

图 4

1.3. MBA-CF-cCapsNet模型

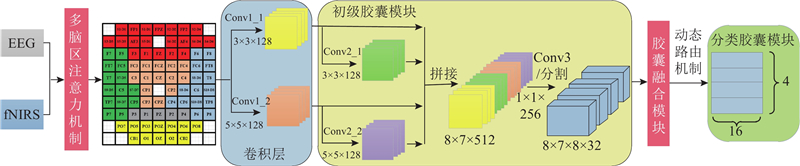

多脑区注意力机制和胶囊融合模块的胶囊网络 (multi brain attention-capsule fusion-conv CapsNet, MBA-CF-cCapsNet)模型主要包括多脑区注意力机制模块、卷积层、初级胶囊模块、胶囊融合模块、分类胶囊模块,具体的模型结构如图5所示.

图 5

1.3.1. 多脑区注意力机制

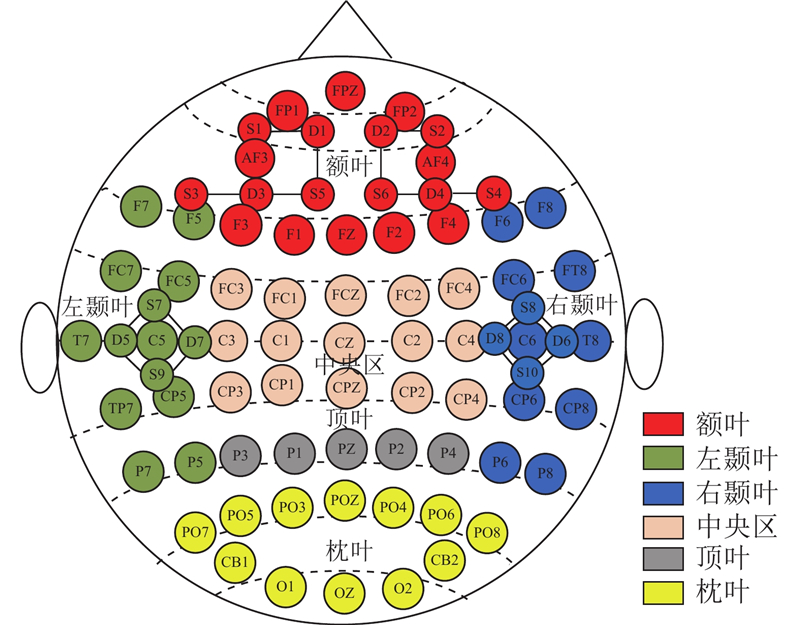

图 6

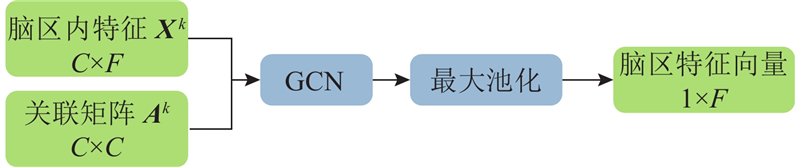

多脑区注意力机制包括2个阶段:融合阶段和转换阶段. 融合阶段的作用是各个脑区中的EEG和fNIRS电极通道相互融合,获得脑区的代表性通道. 融合阶段主要采用图卷积(GCN)和最大池化,如图7所示为多脑区注意力机制融合阶段的具体实现.

图 7

GCN通过节点迭代聚合学习节点特征,在网络隐藏层中计算新的节点特征向量[26]. GCN的输入是图数据,图的定义为G = (V,E),其中V为节点的集合,E为边的集合. 对于每一个节点i,具有D维的节点特征,则V可用矩阵XN×D表示,其中N为节点数;集合E中,元素eij表示节点i和j之间的边.

将EEG和fNIRS的特征转换为图结构,以额叶脑区为例,在EEG和fNIRS数据构建的特征矩阵中,将额叶脑区的电极数据作为节点特征,C为额叶脑区电极通道数,F为每个电极通道的特征向量的维度,节点特征Xk的数据大小是C×F. Guang等[27]发现,利用皮尔森相关系数构建邻接矩阵,在EEG情感识别中获得较好的结果,所以用额叶脑区两两电极之间的皮尔森系数来构建边,即邻接矩阵,大小为C×C,用来描述额叶电极之间的相关性. 采用Hamilton等[28]提出的具有聚合特征的Graph SAGE图卷积模块,对于给定的节点,将第k+1层的节点v表示为:k层的节点v特征与第k层节点v的所有邻接节点特征聚合的拼接,求平均值,经过非线性变换后得到. 使用一次图卷积运算,输出数据大小是C×F.

式中:

采用图卷积将脑区内的EEG和fNIRS特征进行融合后,使用最大池化消除数据的电极通道维,生成脑区内的特征向量:

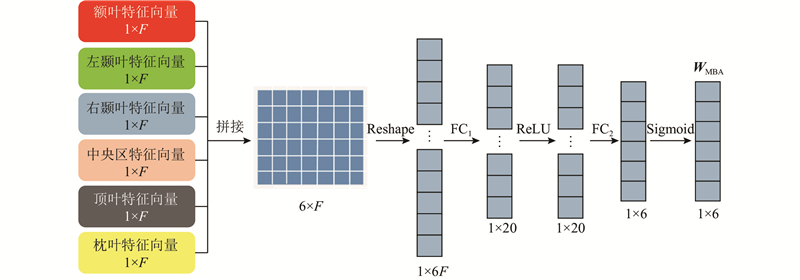

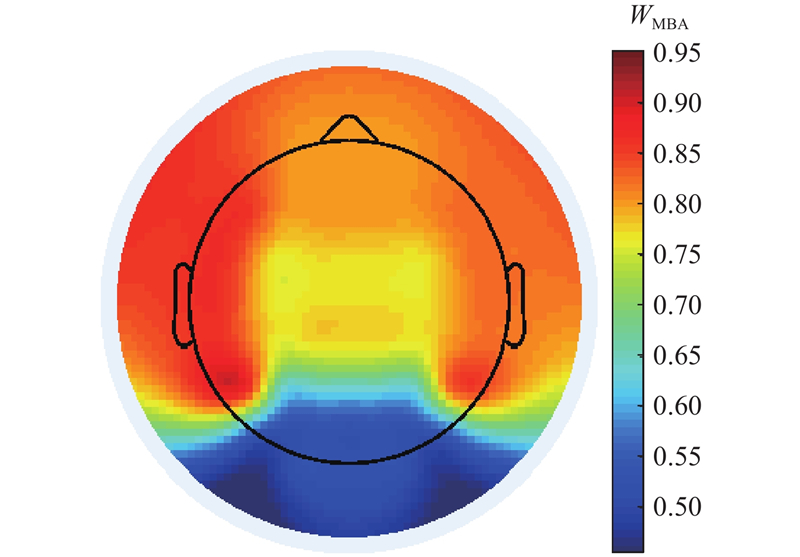

转换阶段的主要作用是将每个脑区生成的特征向量转换成概率,作为每个脑区分配得到的权重;再乘以原始数据,作为脑区注意力机制的输出. 具体的实现过程如图8所示. 通过2层全连接层和ReLu函数、Sigmoid函数实现转换阶段,得到6个脑区的权重系数WMBA.

图 8

图 8 多脑区注意力机制的转换阶段

Fig.8 Transition stage of multibrain region attention mechanism

式中:f1和f2分别表示2个全连接层,FRelu为Relu激活函数,FSigmoid为Sigmoid激活函数.

1.3.2. 卷积层和初级胶囊模块

卷积层包含Conv1_1和Conv1_2这2部分卷积,分别采用不同卷积核尺寸,提取不同视野的特征. Conv1_1卷积核的尺寸是3×3×128,步长是1;Conv1_2卷积核的尺寸是5×5×128,步长是1. 为了使这2部分卷积输出相同尺寸的特征图,Conv1_1和Conv1_2的padding分别设置为0和1.

初级胶囊模块的目的是生成初级胶囊. 在本模块中,在生成初级胶囊的过程中结合了不同视野的特征和不同深度的特征. 从卷积层的输出提取更深层次的特征. Conv2_1的输入是卷积层中Conv1_1的输出,Conv2_1采用和Conv1_1相同的卷积核尺寸,将参数stride和padding设置为1,确保生成的特征图和上层特征图有相同尺寸. Conv2_2的输入是卷积层中Conv1_2的输出,Conv2_2采用和Conv1_2相同的卷积核尺寸,将步长和填充分别设为1和2,确保和上层特征图有相同的尺寸. 将Conv1_1、Conv2_1、Conv1_2、Conv2_2的输出拼接在一起得到512个特征图,融合不同深度和不同视野的特征. 为了减少计算量,在Conv3中通过采用大小为1×1的256个卷积核,将特征通道数从512减少到256.

1.3.3. 胶囊融合模块

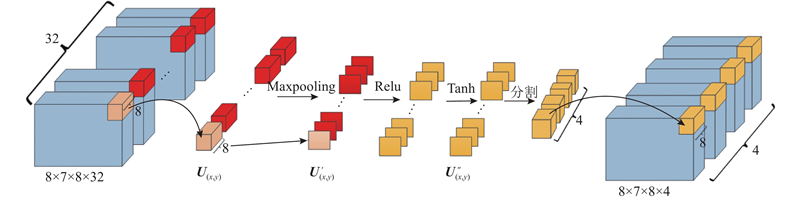

将EEG和fNIRS信号映射到矩阵中,没有电极的位置填0,所以经过卷积之后得到的特征图中包含许多背景信息. 由于胶囊网络中动态路由机制采用向量进行运算,经过多次迭代产生分类胶囊,计算量较大. 针对上述2方面问题,设计胶囊融合模块. 胶囊模块可以减少生成胶囊中的背景信息和生成的胶囊数量,进而减少计算量,具体的实现过程如图9所示.

图 9

胶囊融合模块位于初级胶囊模块之后,将相同位置的多个胶囊融合到一起. 初级胶囊模块的输出特征图的大小是8×7,特征图的输出通道数C=256,胶囊的维度Dc = 8,则输出的特征图被切分成K份,K = C/Dc=32,共有M=H×W×K = 1 792个胶囊. 胶囊在每个像素点(x, y)的集合可以表示为

式中:

将每个胶囊的最大值进行拼接,则将同一个元素位置(x, y)的胶囊融合在一起得到

将融合得到的

胶囊融合模块减少了输入动态路由机制的胶囊数量和计算量,但是初级胶囊模块的每一个元素位置都经过胶囊融合模块,保留了位置信息.

1.3.4. 分类胶囊模块

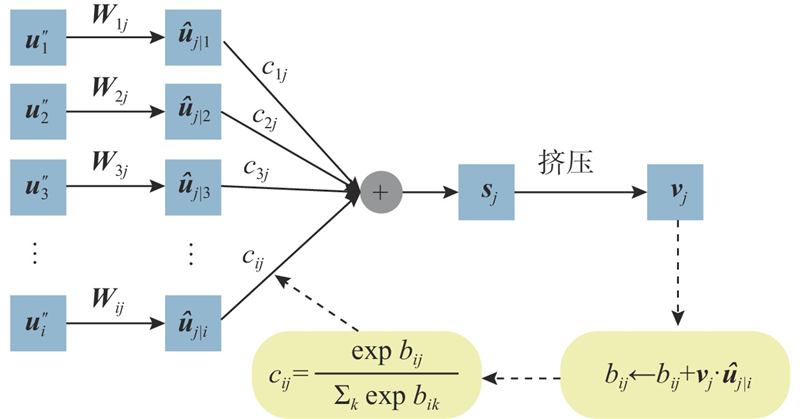

在胶囊融合模块后,相同元素位置产生的胶囊数变为原来的1/4,生成的胶囊数是1 792/4=224,胶囊的维度是8,作为分类胶囊的输入. 分类胶囊模块的作用是进行四分类任务,区分悲伤、高兴、平静、恐惧这4类情感. 如图10所示,将8D的初级胶囊通过动态路由机制生成4个16D的分类胶囊,分类胶囊的长度表示每种情绪存在的程度,用于后续损失函数的计算.

图 10

具体的计算过程如下. 将输入的胶囊

式中:Wij为初级胶囊

将预测向量分别乘以耦合系数cij,然后相加求和,计算公式如下:

式中:cij为低层(l层)的第i个胶囊和高层l+1层的第j个胶囊之间的耦合系数,且cij相加之和为1, cij = 0表示第l层的胶囊i和第l+1层的胶囊j之间没有任何信息传递,cij = 1表示第l层的胶囊i的所有信息都传递给了第l+1层的胶囊j. cij的计算公式如下所示:

式中:

为了保证分类胶囊的长度为0~1.0,且方向不变,使用激活函数Squash得到vj,使得短向量被压缩更加接近0,长向量被压缩更加接近1. 公式如下:

将得到的vj与预测向量

可以看出,当较低级别的胶囊和较高级别的胶囊预测一致时,bij变大,从而导致cij上升. 当预测不一致时,cij下降,通过调整耦合系数,确保较低级别的胶囊将其信息发送到与它预测一致的分类胶囊.

该模型对每一个分类胶囊使用单独的边际损失,边际损失Lk公式如下:

式中:Tk为第k个目标标签;

2. 实验结果分析

2.1. 实验参数的设置

实验采用相同的数据集、软硬件条件、模型参数和评价指标. 搭建基于pytorch3.7的运行框架,采用5折交叉验证,取5折平均值作为每个被试的测试结果. 使用TYUT3.0数据集中50个被试的平均识别率和每种情感的识别率、标准差及F1分数作为评测指标,对模型的计算量和运行时间进行对比分析.

如表1所示为MBA-CF-cCapsNet模型的参数,分为多脑区注意力机制模块、卷积层模块、初级胶囊模块、胶囊融合模块和分类胶囊模块5部分. 将多脑区注意力机制中的Graph SAGE和max pooling模块应用于每个单独的脑区,额叶、左颞叶、右颞叶、中央区、顶叶、枕叶的电极通道数分别为20、14、14、15、5、12.

表 1 MBA-CF-cCapsNet模型的实验参数

Tab.1

| 模型 | 层 | 参数 | 尺寸 |

| 多脑区注意力机制 | Graph SAGE | in_channels | 5 |

| Graph SAGE | out_channels | 5 | |

| Maxpooling | Kernel | C | |

| FC1 | in_features | 30 | |

| FC1 | out_features | 20 | |

| FC2 | in_features | 20 | |

| FC2 | out_features | 6 | |

| ReLu | — | — | |

| Sigmoid | — | — | |

| 卷积层 | Conv1_1 | Kernel | 3×3×128 |

| Conv1_2 | Kernel | 5×5×128 | |

| 初级胶囊模块 | Conv2_1 | Kernel | 3×3×128 |

| Conv2_2 | Kernel | 5×5×128 | |

| Conv3 | Kernel | 1×1×256 | |

| 胶囊融合模块 | Maxpooling | Kernel | 8 |

| ReLu | — | — | |

| Tanh | — | — | |

| 分类胶囊模块 | 动态路由机制 | Wij | 8×16 |

表 2 不同分段长度下的情感识别结果

Tab.2

| t/s | Acc/% | ||||

| 平均值 | Sad | Happy | Calm | Fear | |

| 1 | 96.41 | 96.39 | 96.84 | 94.97 | 97.44 |

| 3 | 96.67 | 96.57 | 97.31 | 95.02 | 97.76 |

| 5 | 96.32 | 96.35 | 96.79 | 94.88 | 97.26 |

| 7 | 95.89 | 95.96 | 96.16 | 94.71 | 96.71 |

2.2. 消融实验

为了验证提出的MBA-CF-cCapsNet模型的有效性,分别验证多脑区注意力机制模块和胶囊融合模块的作用效果,开展对比实验. 分别测试CapsNet模型、cCapsNet模型、MBA-cCapsNet模型及MBA-CF-cCapsNet模型,如表3所示为不同分类模型情感识别的性能. 表中,Np为参数量,te为平均每一个被试每一折实验所需要的时间. 原始的CapsNet模型加入了多尺度和多层次卷积层后,即为cCapsNet模型,平均识别率上升了3.26%. 在cCapsNet的基础上,加入多脑区注意力机制,对大脑不同脑区的特征给予不同的权重,即MBA-cCapsNet模型,识别率上升了1.36%,说明加入多脑区注意力机制后,提取了质量更高的初级胶囊. 在上述模型的基础上加入胶囊融合模块,将特征图中相同元素位置生成的胶囊进行融合,即MBA-CF-cCapsNet模型,不同情感的识别率有了小幅提升;由于减少了进入动态路由机制的胶囊的数量,只有原本初级胶囊数量的1/8,模型的参数量和时间减少.

表 3 MBA-CF-cCapsNet模型的消融实验

Tab.3

| 模型 | Acc/% | Np | te/s | ||||

| 平均值(标准差) | Sad | Happy | Calm | Fear | |||

| CapsNet | 91.69(5.45) | 91.27 | 92.71 | 90.34 | 92.42 | 1814 | |

| cCapsNet | 94.95(5.3) | 95.96 | 94.28 | 94.27 | 95.27 | ||

| MBA-cCapsNet | 96.30(3.04) | 96.48 | 96.26 | 94.95 | 97.52 | ||

| MBA-CF-cCapsNet | 96.67(2.68) | 96.57 | 97.31 | 95.02 | 97.76 | ||

因为数据库中每种情感的样本数量不一致,采用F1分数(F1-score)这个评价指标衡量模型的有效性. F1分数是精确率P和召回率R的调和平均数,最大为1,最小为0,F1分数越高,说明模型的质量越好. F1分数的计算公式如下:

表 4 不同模型的F1分数

Tab.4

| 模型 | F1 | ||||

| Macro-F1 | Sad | Happy | Calm | Fear | |

| CapsNet | 0.92 | 0.93 | 0.92 | 0.91 | 0.92 |

| cCapsNet | 0.95 | 0.96 | 0.94 | 0.95 | 0.96 |

| MBA-cCapsNet | 0.96 | 0.97 | 0.96 | 0.96 | 0.97 |

| MBA-CF-cCapsNet | 0.97 | 0.97 | 0.97 | 0.96 | 0.98 |

图 11

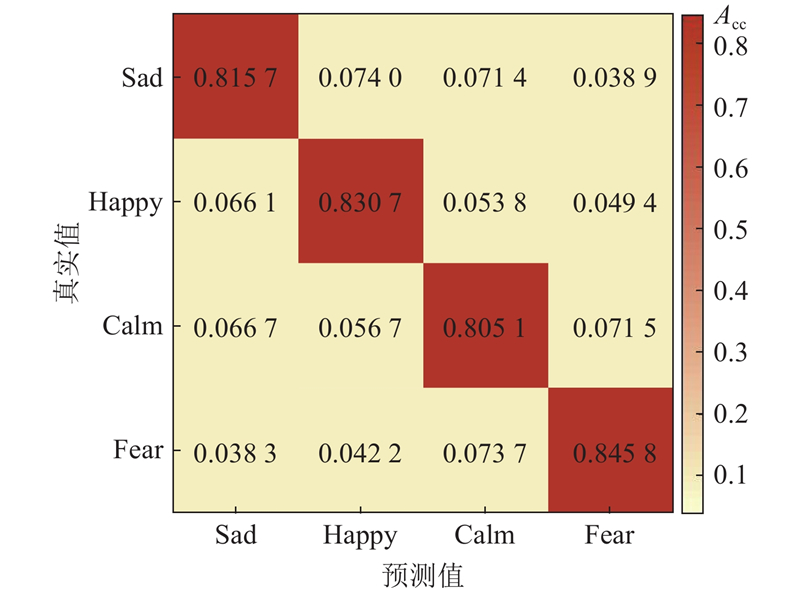

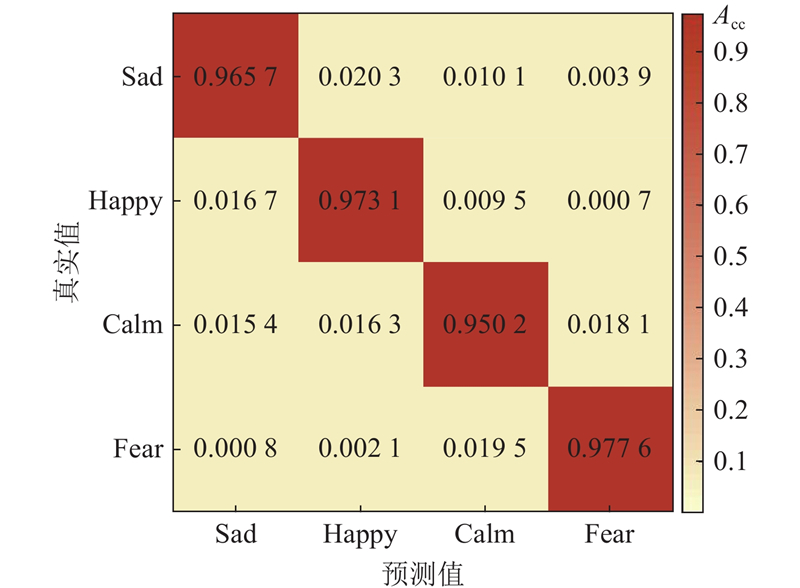

2.3. 不同模态数据的识别性能

采用EEG和fNIRS数据构建的特征作为输入,结合EEG和fNIRS 2种模态的数据进行情感识别. 为了验证2种模态数据结合的必要性和有效性,分别将单独的EEG数据和fNIRS数据作为输入数据,利用MBA-CF-cCapsNet模型进行情感识别.

从表5可以看出,结合EEG和fNIRS数据进行情感识别,识别效果最好,与使用单独的EEG信号进行情感识别的结果相比,平均识别率提升了1.52%,Happy、Sad、Calm、Fear 4种情感识别率分别提升了1.79%、0.97%、1.85%、1.48%. 与单独使用fNIRS信号进行情感识别的结果相比,平均识别率提高了14.35%. 可见,结合EEG和fNIRS 2种模态信号进行情感识别,两者在时空形成互补,较大地提升了情感识别性能.

表 5 不同模态数据的情感分类性能

Tab.5

| 模型 | Acc/% | ||||

| 平均值(标准差) | Sad | Happy | Calm | Fear | |

| MBA-CF-cCapsNet(EEG) | 95.14(3.95) | 95.60 | 95.52 | 93.17 | 96.28 |

| MBA-CF-cCapsNet(fNIRS) | 82.32(7.53) | 81.57 | 83.07 | 80.05 | 84.58 |

| MBA-CF-cCapsNet (EEG-fNIRS) | 96.67(2.68) | 96.57 | 97.31 | 95.02 | 97.76 |

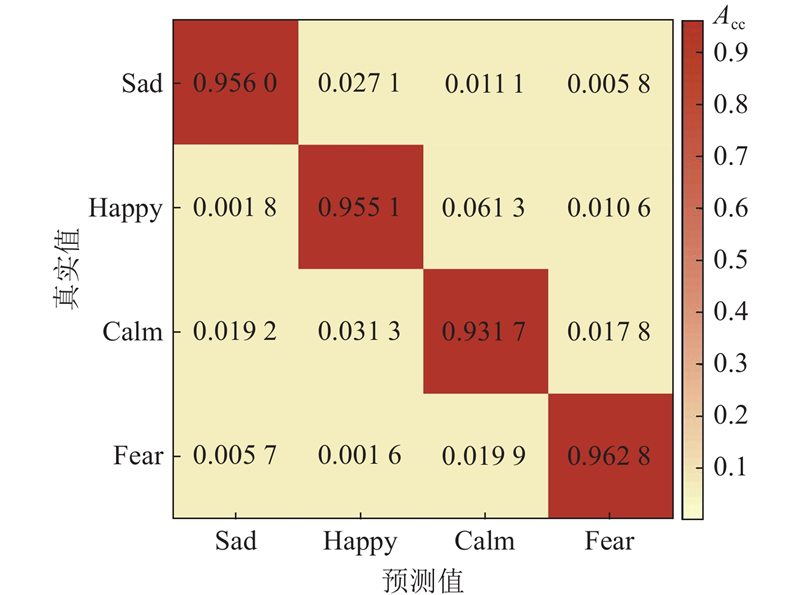

图 12

图 13

图 14

图 14 EEG-fNIRS情感分类混淆矩阵

Fig.14 EEG-fNIRS sentiment classification confusion matrix

2.4. 不同情感识别模型的情感识别性能对比

为了验证提出模型的有效性,分别将该模型与传统的情感识别模型和其他用于情感识别的CapsNet模型比较,每种模型的识别率和标准差如表6所示. 为了保证实验具有可对比性,所有模型输入相同的EEG和fNIRS特征,每个模型都采用5折交叉验证,保证最终结果的可靠性. SVM、CNN、GCN、Transformer、和gcForest是常见的用于情感识别的方法,MFM-CapsNet、MLF- CapsNet和ST-CapsNet模型是在原始CapsNet模型上进行改进后的模型,用于情感识别.

表 6 与其他情感识别模型对比

Tab.6

| 模型 | Acc/% | ||||

| 平均值(标准差) | Sad | Happy | Calm | Fear | |

| SVM | 89.60(6.59) | 90.98 | 89.13 | 88.96 | 89.31 |

| 2DCNN | 90.56(4.96) | 90.48 | 90.20 | 89.63 | 91.93 |

| gcForest | 81.91(8.63) | 82.76 | 80.27 | 82.43 | 82.17 |

| Transformer | 86.84(9.25) | 85.62 | 89.35 | 83.84 | 88.54 |

| GCN | 90.16(5.10) | 90.15 | 90.71 | 88.45 | 91.33 |

| MFM-CapsNet[10] | 92.74(3.14) | 92.1 | 93.52 | 91.61 | 93.73 |

| MLF-CapsNet[11] | 94.65(3.80) | 94.48 | 94.79 | 93.46 | 95.86 |

| ST-CapsNet[12] | 94.01(2.95) | 93.57 | 95.02 | 93.04 | 94.42 |

| MBA-CF-cCapsNet | 96.67(2.68) | 96.57 | 97.31 | 95.02 | 97.76 |

从表6可以看出,与传统识别模型相比,提出模型的平均识别率上升了6.0%~7.0%. 与传统模型中平均识别率最高的2DCNN模型相比,Sad、Happy、Calm、Fear 4种情感的识别率分别上升了6.09%、7.11%、5.39%、5.83%,标准差更小. 这表明提出的MBA-CF-cCapsNet模型的识别效果和稳定性都优于其他模型.

为了验证提出的多脑区注意力机制的有效性,将MBA-CF-cCapsNet模型与ST-CapsNet模型进行比较,ST-CapsNet模型在原始CapsNet模型的基础上加入了时间和空间注意力机制. 实验结果表明,MBA-CF-cCapsNet的平均识别率比ST-CapsNet上升了约2.66%,4种情感的识别率分别上升了3%、2.29%、1.98%、3.34%. 多脑区注意力机制可以关注不同情感状态下不同脑区情感表达的差异性,提升整体的识别性能.

与MFM-CapsNet和MLF- CapsNet模型相比,提出的MBA-CF-cCapsNet模型在情感识别上的平均识别率分别上升了3.93%、2.02%,四类情感的识别率提升了2%~5%,验证了所提出的情感识别模型的有效性.

2.5. 结果分析

分析实验结果得出,在EEG和fNIRS情感识别领域,本文模型优于其他情感识别模型,利用本文模型获得较优的情感识别性能的原因如下.

(2) EEG和fNIRS双模态的信号内部包含更丰富的、与情绪有关的信息,使用多级和多尺度的卷积框架,结合不同层次的信息,增强了特征所包含的信息.

(3) 双模态信号的数据量通常比较大,为了减少参数量和计算量,设计胶囊融合模块. 胶囊融合模块一方面可以减少进入动态路由机制的胶囊的数量,另一方面可以减少特征映射到矩阵的过程中产生的背景信息.

3. 结 语

本文提出基于多脑区注意力机制胶囊融合网络MBA-CF-cCapsNet模型,用于EEG和fNIRS的情感识别. 考虑不同脑区与不同的情绪有关,设计多脑区注意力机制,给予不同脑区不同的权重. 为了尽可能地提取EEG和fNIRS的特征,使用不同尺度和不同深度的卷积. 提出胶囊融合模块,减少了进入动态路由机制的胶囊的数量以及模型的参数量和运行时间. 利用提出的模型,在TYUT3.0数据库上进行实验. 实验结果表明,4类情感的平均识别率可以达到96.67%,与用于情感识别的其他CapsNet模型相比,提出的模型拥有更好的识别性能. 在未来工作中,可以考虑EEG和fNIRS不同频率的特征,提高情感识别性能.

参考文献

类脑研究: 为人类构建超级大脑

[J].

Cybrain: building superbrain for humans

[J].

Multi-modal integration of EEG-fNIRS for characterization of brain activity evoked by preferred music

[J].DOI:10.3389/fnbot.2022.823435 [本文引用: 1]

EEG based emotion recognition from human brain using Hjorth parameters and SVM

[J].DOI:10.14257/ijbsbt.2015.7.3.03 [本文引用: 1]

EEG-based emotion recognition using spatial-temporal-connective features via multi-scale CNN

[J].DOI:10.1109/ACCESS.2023.3270317 [本文引用: 1]

A multi-dimensional graph convolution network for EEG emotion recognition

[J].

EEG-based seizure prediction via Transformer guided CNN

[J].DOI:10.1016/j.measurement.2022.111948 [本文引用: 1]

Emotion recognition from multi-channel EEG via deep forest

[J].

Building predictive models of emotion with functional near-infrared spectroscopy

[J].DOI:10.1016/j.ijhcs.2017.10.001 [本文引用: 1]

fNIRS evidence for recognizably different positive emotions

[J].DOI:10.3389/fnhum.2019.00120 [本文引用: 1]

Multimodal affective state assessment using fNIRS+EEG and spontaneous facial expression

[J].DOI:10.3390/brainsci10020085 [本文引用: 2]

Emotion recognition based on high-resolution EEG recordings and reconstructed brain sources

[J].DOI:10.1109/TAFFC.2017.2768030 [本文引用: 2]

A novel multimodal approach for hybrid brain–computer interface

[J].DOI:10.1109/ACCESS.2020.2994226 [本文引用: 2]

Multimodal fusion of EEG-fNIRS: a mutual information-based hybrid classification framework

[J].

FGANet: fNIRS-guided attention network for hybrid EEG-fNIRS brain-computer interfaces

[J].DOI:10.1109/TNSRE.2022.3149899 [本文引用: 1]

轻量型胶囊网络语音情感识别方法

[J].DOI:10.12178/1001-0548.2022086 [本文引用: 1]

A speech emotion recognition method based on lightweight capsule network

[J].DOI:10.12178/1001-0548.2022086 [本文引用: 1]

胶囊网络模型综述

[J].

Review of capsule network

[J].

A fast-learning algorithm for deep belief nets

[J].

Multimodal emotion recognition using a hierarchical fusion convolutional neural network

[J].DOI:10.1109/ACCESS.2021.3049516 [本文引用: 1]

集成胶囊网络的脑电情绪识别

[J].DOI:10.3778/j.issn.1002-8331.2010-0263 [本文引用: 1]

Emotion recognition of EEG based on ensemble CapsNet

[J].DOI:10.3778/j.issn.1002-8331.2010-0263 [本文引用: 1]

Multi-channel EEG-based emotion recognition via a multi-level features guided capsule network

[J].DOI:10.1016/j.compbiomed.2020.103927 [本文引用: 1]

ST-CapsNet: linking spatial and temporal attention with capsule network for P300 detection improvement

[J].DOI:10.1109/TNSRE.2023.3237319 [本文引用: 1]

Emotion recognition from EEG based on multi-task learning with capsule network and attention mechanism

[J].DOI:10.1016/j.compbiomed.2022.105303 [本文引用: 1]

结合3D-CNN和频-空注意力机制的EEG情感识别

[J].

EEG emotion recognition based on the 3D-CNN and spatial-frequency attention mechanism

[J].

Mathematical relations between measures of brain connectivity estimated from electrophysiological recordings for gaussian distributed data

[J].DOI:10.3389/fnins.2020.577574 [本文引用: 1]

Attention mechanisms in computer vision: a survey

[J].DOI:10.1007/s41095-022-0271-y [本文引用: 1]

基于细胞图卷积的组织病理图像分类研究

[J].DOI:10.3778/j.issn.1002-8331.2009-0364 [本文引用: 1]

Research on classification of histopathological image based on cell graph convolutional network

[J].DOI:10.3778/j.issn.1002-8331.2009-0364 [本文引用: 1]

Linking multi-layer dynamical GCN with style-based recalibration CNN for EEG-based emotion recognition

[J].DOI:10.3389/fnbot.2022.834952 [本文引用: 1]

From regional to global brain: a novel hierarchical spatial-temporal neural network model for EEG emotion recognition

[J].

Classifying different emotional states by means of EEG-based functional connectivity patterns

[J].DOI:10.1371/journal.pone.0095415 [本文引用: 1]