眼底结构复杂、病变类型多样,如脉络膜新生血管(choroidal neovascularization, CNV)、糖尿病性黄斑水肿(diabetic macular edema, DME)、玻璃膜疣(drusen)、老年性黄斑病变(age-related macular degeneration, AMD)等. 眼底病变多出现在黄斑区,它位于视网膜的中央,是视力最敏感的区域. 黄斑区视网膜病变研究已成为重要课题[1]. 黄斑区病变是造成不可逆视力丧失的主要原因之一,DME常引起不可逆的视力损害[2]. 光学相干断层扫描技术(optical coherence tomography, OCT)是无创高分辨率光学成像技术,它能够实时生成物体的横截面图像[3-4],被广泛应用于眼病诊断.

CNV病变特征复杂多样,病变区域边界模糊;DME病变特征明显,病变区域较大;玻璃膜疣病变区域小,病变边界模糊,病变特征不明显;AMD特征复杂,且不同病变程度可能会出现不同的病变特征,玻璃膜疣是早期AMD的临床表现之一. 繁杂的OCT图像信息诊断需要医生人工处理和分析,工作量大,耗时长. 自动分析OCT图像的模型有助于医生筛查工作的进行. 由于深度学习在图像领域出色的表现,学者们利用卷积神经网络提出了许多眼底OCT图像分类模型,实现了不同数量、不同类型的病变识别. Fang等[5-8]研究3种病变的识别,对CNV、DME、玻璃膜疣和正常眼底进行了四分类. Fang等[5]使用病变感知卷积网络(lesion-aware convolutional neural network, LACNN),在OCT图像中生成软注意力图,并将注意力图并入分类网络,以提高分类精度. Liu等[6]提出基于onestage注意力的视网膜OCT图像分类和分割模型,该模型克服分类任务学习的信息无法传递给分割任务的问题,实现分类和分割任务的同步进行. Mishra等[7]提出基于扰动复合注意力的深度网络,提取上下文感知诊断特征来提高分类精度. Das等[8]使用深度多尺度卷积神经网络(deep multi-scale fusion convolutional neural network, DMF-CNN),对多尺度疾病特征进行编码,对编码后的疾病特征进行组合并分类,同时使用联合多损失优化策略来加强网络的学习能力. 注意力机制的加入虽能加强提取现有特征的能力,但仍无法有效提取病变纹理信息,也无法解决特征提取过程中特征信息丢失的问题.

Thomas等[9-10]实现对AMD、DME和正常眼底图像的三分类. Thomas等[9]利用多尺度卷积层生成具有各种尺寸的局部结构,提出多尺度卷积网络. Toğaçar等[10]使用9个迁移学习模型对同一数据集中的病变种类进行分类,使用黏菌算法(slime mold algorithm, SMA)从模型中选取针对单一目标分类准确度最高的网络进行结果输出. 多尺度卷积层生成的局部结构丰富了病变特征,但无法解决因网络逐渐加深带来的有用信息丢失的问题. 现有模型组合的迁移学习模型参数量过大,对硬件要求过高. Sotoudeh-Paima等[11]实现对CNV、玻璃膜疣和正常眼底图像的三分类,提出多尺度卷积神经网络,通过捕获尺度间的变化并使用快卷积块的特征融合策略,提高了对AMD、DME和正常眼底图像的三分类性能. 融合策略虽然加强了卷积块间的信息交流,但是不能有效提取不同尺度的病变特征.

本研究面向眼底的多种病变类型,致力于设计轻量化的高效分类模型,实现眼底病变类型的自动识别. 主要工作包括:1)设计多尺度卷积模块,强化对不同病变特征特有的小目标特征的提取能力,实现对不同大小病变特征的全面提取;2)构建特征融合模块,通过充分利用病变特征的显著信息,加强浅层细节信息和深层语义信息的融合;3)设计轻量化主干网络,从减少卷积核的使用数量和引入深度可分离卷积两个方面,降低参数量,实现模型轻量化.

1. 轻量化分类模型MB-CNN的网络结构

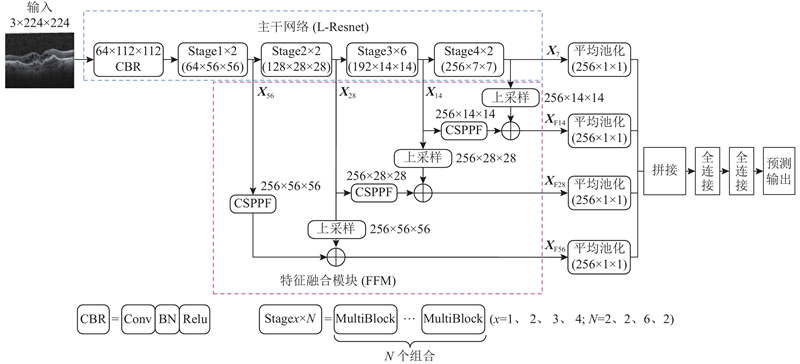

为了准确识别多种病变,助力医疗诊断,必须紧扣病灶区域小、病变特征模糊的特性设计识别模型,同时降低模型参数量. 针对眼底OCT图像设计如图1所示的轻量化分类模型MB-CNN,主要创新点如下:1)设计轻量化主干网络L-Resnet,它通过减少卷积核使用、加深网络深度,在有效降低网络模型参数的同时减少对网络精度的影响;2)设计多尺度卷积块MultiBlock,它使用多尺度卷积核提取不同特征,加强特征提取的能力,引入深度可分离卷积大幅降低网络模型参数;3)设计特征融合模块(feature fusion module, FFM),它通过融合浅层细节信息和深层语义信息加强网络对小目标和模糊特征的识别能力.

图 1

图 1 轻量化分类模型MB-CNN的整体结构图

Fig.1 Overall structure diagram of lightweight classification model MB-CNN

1.1. 主干网络L-Resnet设计

网络深度和卷积核的使用数量直接影响网络精度[14-15]. 通过控制变量法,逐步对卷积核的使用个数和每个阶段卷积块的使用个数进行实验,得到L-Resnet. L-Resnet是由1个CBR模块和4个

降低卷积核的使用数量能有效降低网络模型参数量,增加网络深度,加强了对病变特征的提取.

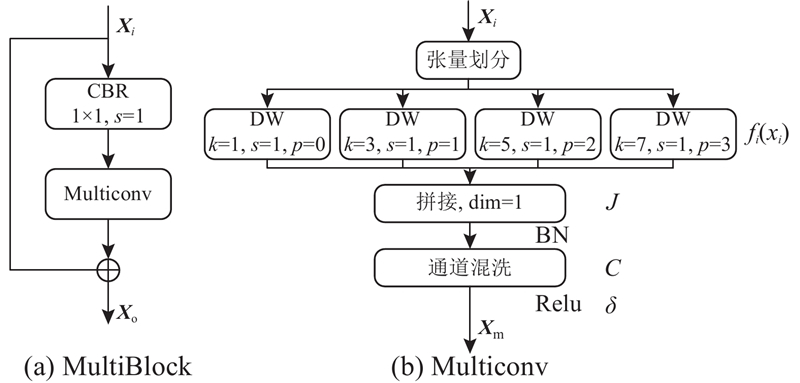

1.2. 多尺度卷积模块MultiBlock

眼底视网膜病变具有局部性,在OCT图像上往往占据较小的位置,且不同的病变之间的特征差异较大,CNV的病变种类在OCT图像上表现为视网膜层间的脱离,DME的病变种类在OCT图像上表现为视网膜的撕拉变形. CNV和DME的病变种类病灶明显,且病灶区域较大,而玻璃膜疣的病变种类在OCT图像上表现为视网膜层上的局部凸起,病灶较小,但较为集中. 病灶特征大小不一致,使用单一卷积核难以有效提取不同尺寸的病变特征. 为了更加充分、有效地提取OCT图像中不同尺寸的病变特征信息,设计如图2所示的多尺度卷积模块MultiBlock,它由1个

图 2

式中:

深度可分离卷积由深度卷积和逐点卷积共同构成,其中逐点卷积可以视为1个

式中:

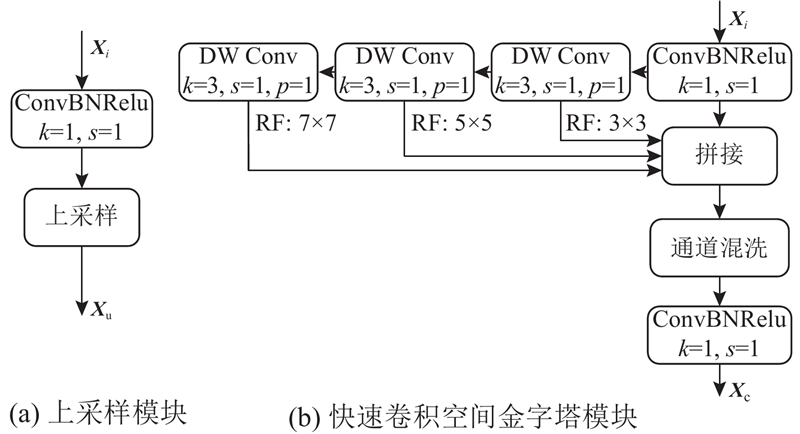

1.3. 特征融合模块FFM

在OCT图像中,病灶大小、病变位置和病变特征都不同,因此较小的病变特征往往难以提取. 由于玻璃膜疣的病变种类病灶小、边界模糊,在网络浅层的提取中,病变特征容易被忽略,无法有效提取. 随着网络的加深,浅层局部细节信息逐步转化为全局语义信息,病变特征细节信息无法表达,在特征提取中会造成有用特征信息的丢失,导致整体分类精度的下降. 为此,构建如图3所示的特征融合模块FFM,它由上采样模块和快速卷积空间金字塔模块(convolution spatial pyramid polling-fast, CSPPF)组合而成. FFM将主干网络中的特征张量

图 3

上采样模块先通过1个

FFM通过上采样模块对深层特征进行上采样,通过CSPPF再次进行不同尺寸特征的提取,丰富了网络中OCT图像中病变几何信息和病变空间信息的表达,能够将浅层提取到的OCT图像中特异度不同的特征传递到深层,实现浅层纹理信息和深层语义信息的融合. 强化对OCT病变特征的提取和表达能力,实现精度的提升.

1.4. 分类输出

将主干网络输出的特征张量

2. 实验结果与分析

2.1. 实验环境

实验在CPU型号为Inter Core i9-10900K @3.70 GHz,GPU型号为NVIDIA GeForce RTX 3080Ti, 12G显存,32G内存的个人计算机上开展. 使用Pytorch搭建网络框架,使用Cuda11.6和Cudnn11.2加速GPU. 相关实验参数配置如下:批尺寸为32,图片尺寸为224,训练周期为150,动量因子为0.9,权重衰减为0.000 5,学习率为0.000 1~0.100 0.

2.2. 数据集和评价指标

实验采用3个数据集,其中数据集UCSD[19]由CNV、DME、玻璃膜疣、正常眼底4类共84484张OCT图像组成;杜克数据集(Duke)[20]由AMD、DME、正常眼底3类共3 231张OCT图像组成;德黑兰努尔眼科医院(NEH)[11]收集的匿名OCT图像数据集由CNV、玻璃膜疣、正常眼底3类共12649张图片组成. 如图4所示为3种眼底病变和正常眼底的OCT图例,图中箭头所指的为病变位置.使用混淆矩阵对网络模型进行评估. 通过网络模型对样本数据进行分类,判断样本数据的正(positive),负(negative),并根据样本的正负得到4个一级指标:真实值为正,模型预测为正TP;真实值为正,模型预测值为负FN;真实值为负,模型预测为正FP;真实值为负,模型预测为负TN. 根据这4个一级指标得到4种评价指标:准确率Acc、精确率P、召回率R、特异度Spe.

图 4

2.3. 消融实验

为了验证MB-CNN设计的合理性,在数据集UCSD上,基于Resnet18展开6个实验,分别为Resnet18、深度可分离卷积和MultiBlock的对比实验以及依次引入的3种策略:1)使用L-Resnet轻量化主干,2)将普通卷积替换成MultiBlock,3)加入特征融合模块FFM. 实验结果如表1所示,其中√表示采用对应策略,记录实验中的模型参数NP和准确率. 数据集中训练集、验证集、测试集的比例为7∶2∶1. 实验1为Resnet18的分类结果. 实验2在实验1的基础上将主干网络换成L-Resnet,没有更换卷积操作. 由实验2的结果可知,在更换完主干网络后,模型参数降低了38.81%,精度降低了0.17个百分点. 实验3、4在实验1的基础上将卷积分别更换为深度可分离卷积和MultiBlock. 由实验结果可知,使用深度可分离卷积使模型参数降低了97.21%,精度降低了1.38个百分点;当卷积核换为MultiBlock时,相较于实验3,模型参数量增加了0.044×106,精度增加了0.44个百分点. 实验5在实验2的基础上添加MultiBlock卷积模块. 相较于实验2,模型参数量降低了92.8%,精度降低了0.13个百分点. 实验6在实验5的基础上加入特征融合模块,在加入特征融合模块后模型参数量增加了0.829×106,精度增加了0.46个百分点.

表 1 MB-CNN组成部分的消融实验

Tab.1

| 实验 | L-Resnet | DW Conv | MultiBlock | FFM | NP/106 | Acc/% |

| 1 | — | — | — | — | 11.180 | 94.41 |

| 2 | √ | — | — | — | 6.840 | 94.24 |

| 3 | — | √ | — | — | 0.312 | 93.03 |

| 4 | — | — | √ | — | 0.344 | 93.47 |

| 5 | √ | — | √ | — | 0.521 | 94.11 |

| 6 | √ | — | √ | √ | 1.350 | 94.57 |

L-Resnet主干网络通过减少个卷积阶段卷积核的使用减少了模型参数量,加深网络模型能加强模型对深层语义信息的提取,能够在模型降低参数量的同时减少对识别精度的影响. 实验3、4的结果显示,MultiBlock卷积模块能够通过能够使用不同尺寸的卷积核来提取不同的特征信息,丰富模型的特征表达,提高分类精度. 实验5使用L-Resnet主干网络,减少卷积核的使用、加深网络深度,同时使用MultiBlock替换普通卷积,相较于实验1,参数量下降了95.34%,精度下降了0.3个百分点. 相较于实验1,加入L-Resnet、MultiBlock能够更好地平衡模型的参数和精度. 加入FFM模块的实验6,通过融合深层语义信息和浅层细节信息,提高了对OCT图像中小目标特征的信息提取能力,提高了分类精度. 由表1可知,在MB-CNN中提出的3种改进策略设计合理,有助于降低模型参数量、提高精度. 还可看出,MB-CNN模型具有较好的分类效果.

2.4. 轻量化分类模型MB-CNN的性能验证

表 2 不同模型在UCSD数据集上的性能对比实验结果

Tab.2

| 模型 | 图片类别 | P/% | R/% | Spe/% | Acc/% | NP/106 | OAcc/% |

| LACNN[5] | CNV | 93.5 | 89.8 | 95.1 | 92.7 | — | 90.1±1.2 |

| DME | 86.4 | 87.5 | 98.0 | 96.6 | |||

| 玻璃膜疣 | 70.0 | 72.5 | 95.9 | 93.6 | |||

| 正常眼底 | 94.8 | 97.3 | 97.4 | 97.4 | |||

| Multi-Label CNN[6] | CNV | 93.5 | 88.1 | 96.0 | 93.8 | — | 90.4±1.2 |

| DME | 83.1 | 86.0 | 95.8 | 96.5 | |||

| 玻璃膜疣 | 69.8 | 72.1 | 96.8 | 93.3 | |||

| 正常眼底 | 95.1 | 96.1 | 97.9 | 96.8 | |||

| PCAM[7] | — | 91.52 | 91.22 | — | — | 11.09 | 94.15±1.15 |

| Resnet18[12] | CNV | 97.83 | 97.63 | 98.27 | 97.97 | 11.18 | 96.52±0.5 |

| DME | 95.30 | 95.17 | 99.27 | 98.70 | |||

| 玻璃膜疣 | 89.87 | 90.70 | 98.80 | 97.97 | |||

| 正常眼底 | 97.43 | 97.43 | 98.83 | 98.4 | |||

| DMF-CNN[8] | CNV | 97.05 | 97.33 | — | — | — | 94.37 |

| DME | 96.26 | 93.22 | 94.64 | ||||

| 玻璃膜疣 | 87.73 | 98.29 | 94.43 | ||||

| 正常眼底 | 97.49 | 97.62 | 96.03 | ||||

| MB-CNN | CNV | 98.39 | 98.49 | 98.60 | 98.51 | 1.35 | 97.22±0.6 |

| DME | 97.30 | 96.27 | 99.49 | 99.07 | |||

| 玻璃膜疣 | 92.24 | 90.84 | 99.12 | 98.33 | |||

| 正常眼底 | 97.77 | 98.20 | 98.63 | 98.75 |

表 3 不同模型在Duke数据集上的对比实验结果

Tab.3

| 模型 | 图片类别 | P/% | R/% | Spe/% | Acc/% | NP/106 | OAcc/% |

| Multiscale CNN[9] | AMD | 93.75 | 100 | — | 100 | 1.35 | 96.66 |

| DME | — | — | — | — | |||

| 正常眼底 | 100 | 93.33 | — | 93.33 | |||

| Transfer Learning+SMA[10] | AMD | 100 | 100 | 100 | 100 | — | 99.89 |

| DME | 99.69 | 100 | 99.84 | 99.89 | |||

| 正常眼底 | 100 | 99.76 | 100 | 99.89 | |||

| Resnet18[12] | AMD | 99.72 | 99.58 | 99.92 | 99.84 | 11.18 | 99.75 |

| DME | 99.80 | 99.72 | 99.92 | 99.84 | |||

| 正常眼底 | 99.70 | 99.84 | 99.78 | 99.80 | |||

| MB-CNN | AMD | 100 | 99.7 | 100 | 99.2 | 1.35 | 99.92 |

| DME | 99.8 | 100 | 99.2 | 99.2 | |||

| 正常眼底 | 100 | 100 | 100 | 100 |

表 4 不同模型在NEH数据集上的实验对比结果

Tab.4

由表2可知,MB-CNN在参与对比的模型中获得了最高的总体准确率,比位居第二的Resnet18提高了0.72个百分点,同时参数量降低了87.92%. LACNN通过将生成的软注意力图并入网络以加权局部卷积,并利用病变局部信息来改善分类,但专注于局部细节信息会导致全局语义信息的丢失进而影响分类精度. Liu等[6]通过添加注意力强化对病灶的定位,放大病灶区域,提取放大后的病灶区域的病变特征,但病灶定位及放大会造成病灶边缘信息的丢失,难以有效提取特征信息(如病变形状、纹理),影响分类效果. PCAM添加2种不同的注意力机制,加强了模型在空间和通道维度对病变特征的提取,同时将提取到的特征传递到深层,加强了对网络深浅层信息的交流,虽参数量比Resnet18低了0.1×106,但单一尺寸的卷积核的使用没有提高模型的病变分类能力. DMF-CNN通过组合多个不同感受野大小的卷积来有效提取不同大小的病变特征,使用联合多损失优化策略加强了模型对病变特征的识别能力,但没有解决显著特征在特征提取过程中丢失的问题. 可以看出,在UCSD数据集中,MB-CNN的改进达到预期的效果,相比Resnet18,对比模型的表现均不够出色.

Resnet18网络使用单一大小卷积核难以提取不同尺度的病变特征,但通过使用残差连接实现特征信息跨卷积块的传递,在保证网络能够充分利用原有特征的同时学习新的有用的病变特征,有效地解决了病变特征丢失的问题,因而在3个数据集上都有相对较好的表现. MB-CNN保留了残差连接,同时使用多尺度卷积模块来提取不同尺度的病变特征,使用特征融合模块融合浅层细节信息和深层语义信息,加强病变特征提取的同时,将浅层细节信息传递到网络深层,使得信息得到充分的利用. 因而在3个数据集上的表现最好.

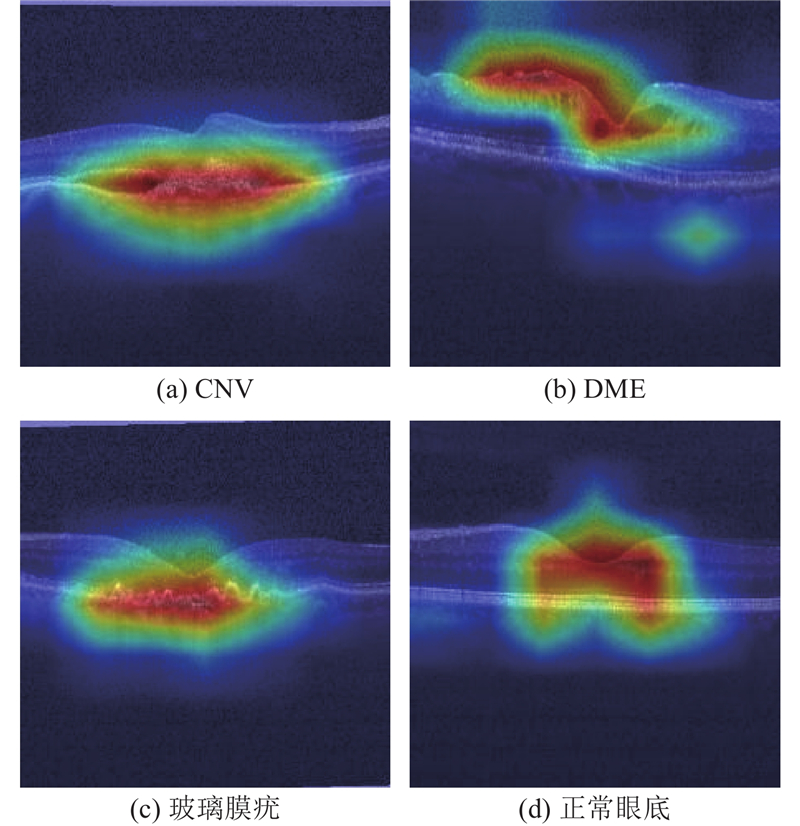

为了进一步论证的MB-CNN的分类能力,展示MB-CNN在UCSD数据集上识别的病灶区域的热力图如图5所示. 可以看出,MB-CNN能够准确关注不同疾病的病灶区域,通过病灶区域几何拓扑结构的准确提取,实现对OCT图像中病灶位置的有效识别. 对于正常的眼底,MB-CNN主要关注中心凹区域.

图 5

3. 结 语

为了实现不同眼底病变类型的自动识别,提出轻量化眼底OCT图像分类网络MB-CNN. 主干网络L-Resnet中使用更少的卷积核,MultiBlock模块引入深度卷积能够有效地降低模型参数. 在MultiBlock中使用不同尺寸的卷积核有效学习不同尺寸的特征信息,丰富了特征表达. 通过特征融合模块将浅层细节信息和深层语义信息相融合,使网络既保留了前期的病变细节信息又能够丰富后期病变的语义信息,提高了网络对较小病变种类的分类能力. MB-CNN的分类准确率较主流模型提升0.36~7.10个百分点,获得了更好的分类效果. 未来计划将MB-CNN模型部署到嵌入式设备中,以实现眼底疾病的快速分类.

参考文献

Clinical classification of age-related macular degeneration

[J].DOI:10.1016/j.ophtha.2012.10.036 [本文引用: 1]

糖尿病性黄斑水肿的药物治疗研究进展

[J].

Research progress on pharmacotherapy for diabetic macular edema

[J].

Optical coherence tomography

[J].DOI:10.1126/science.1957169 [本文引用: 1]

Optical coherence tomography

[J].DOI:10.1111/j.1365-2818.2012.03619.x [本文引用: 1]

Attention to lesion: lesion-aware convolutional neural network for retinal optical coherence tomography image classification

[J].DOI:10.1109/TMI.2019.2898414 [本文引用: 4]

Joint disease classification and lesion segmentation via one-stage attention-based convolutional neural network in OCT images

[J].DOI:10.1016/j.bspc.2021.103087 [本文引用: 3]

Perturbed composite attention model for macular optical coherence tomography image classification

[J].DOI:10.1109/TAI.2021.3135797 [本文引用: 3]

Automated classification of retinal OCT images using a deep multi-scale fusion CNN

[J].DOI:10.1109/JSEN.2021.3108642 [本文引用: 4]

A novel multiscale convolutional neural network based age-related macular degeneration detection using OCT images

[J].DOI:10.1016/j.bspc.2021.102538 [本文引用: 4]

Use of dominant activations obtained by processing OCT images with the CNNs and slime mold method in retinal disease detection

[J].DOI:10.1016/j.bbe.2022.05.005 [本文引用: 5]

Multi-scale convolutional neural network for automated AMD classification using retinal OCT images

[J].DOI:10.1016/j.compbiomed.2022.105368 [本文引用: 6]

Identifying medical diagnoses and treatable diseases by image-based deep learning

[J].DOI:10.1016/j.cell.2018.02.010 [本文引用: 1]

Fully automated detection of diabetic macular edema and dry age-related macular degeneration from optical coherence tomography images

[J].DOI:10.1364/BOE.5.003568 [本文引用: 1]