[1]

GAO X, ZHANG G, YANG Y, et al Two-stage domain adaptation based on image and feature levels for cloud detection in cross-spatiotemporal domain

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2024 , 62 : 5610517

[本文引用: 1]

[2]

CHANG J, GAO X, YANG Y, et al Object-oriented building contour optimization methodology for image classification results via generalized gradient vector flow snake model

[J]. Remote Sensing , 2021 , 13 (12 ): 2406

DOI:10.3390/rs13122406

[3]

宦海, 盛宇, 顾晨曦 基于遥感图像道路提取的全局指导多特征融合网络

[J]. 浙江大学学报: 工学版 , 2024 , 58 (4 ): 696 - 707

[本文引用: 1]

HUAN Hai, SHENG Yu, GU Chenxi Global guidance multi-feature fusion network based on remote sensing image road extraction

[J]. Journal of Zhejiang University: Engineering Science , 2024 , 58 (4 ): 696 - 707

[本文引用: 1]

[4]

ZHANG G, GAO X, YANG Y, et al Controllably deep supervision and multi-scale feature fusion network for cloud and snow detection based on medium- and high-resolution imagery dataset

[J]. Remote Sensing , 2021 , 13 (23 ): 4805

DOI:10.3390/rs13234805

[本文引用: 1]

[5]

HAN S, WANG J, ZHANG S Former-CR: a transformer-based thick cloud removal method with optical and SAR imagery

[J]. Remote Sensing , 2023 , 15 (5 ): 1196

DOI:10.3390/rs15051196

[本文引用: 3]

[6]

KING M D, PLATNICK S, MENZEL W P, et al Spatial and temporal distribution of clouds observed by MODIS onboard the terra and aqua satellites

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2013 , 51 (7 ): 3826 - 3852

DOI:10.1109/TGRS.2012.2227333

[本文引用: 1]

[7]

陈津乐, 张锦水, 段雅鸣, 等 中分辨率遥感影像云检测与厚云去除研究综述

[J]. 遥感技术与应用 , 2023 , 38 (1 ): 143 - 155

[本文引用: 1]

CHEN Jinle, ZHANG Jinshui, DUAN Yaming, et al A review of cloud detection and thick cloud removal in medium resolution remote sensing images.

[J]. Remote Sensing Technology and Application , 2023 , 38 (1 ): 143 - 155

[本文引用: 1]

[8]

MAO R, LI H, REN G, et al Cloud removal based on SAR-optical remote sensing data fusion via a two-flow network

[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing , 2022 , 15 : 7677 - 7686

DOI:10.1109/JSTARS.2022.3203508

[本文引用: 1]

[9]

CHEN Y, TANG L, YANG X, et al Thick clouds removal from multitemporal ZY-3 satellite images using deep learning

[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing , 2020 , 13 : 143 - 153

DOI:10.1109/JSTARS.2019.2954130

[本文引用: 1]

[10]

LI W, LI Y, CHAN J Thick cloud removal with optical and SAR imagery via convolutional-mapping-deconvolutional network

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2020 , 58 (4 ): 2865 - 2879

DOI:10.1109/TGRS.2019.2956959

[本文引用: 1]

[11]

SHEN H, LI X, CHENG Q, et al Missing information reconstruction of remote sensing data: a technical review

[J]. IEEE Geoscience and Remote Sensing Magazine , 2015 , 3 (3 ): 61 - 85

DOI:10.1109/MGRS.2015.2441912

[本文引用: 1]

[12]

MERANER A, EBEL P, ZHU X, et al Cloud removal in Sentinel-2 imagery using a deep residual neural network and SAR-optical data fusion

[J]. ISPRS Journal of Photogrammetry and Remote Sensing , 2020 , 166 : 333 - 346

DOI:10.1016/j.isprsjprs.2020.05.013

[本文引用: 2]

[13]

HOAN N, TATEISHI R Cloud removal of optical image using SAR data for ALOS applications: experimenting on simulated ALOS data

[J]. Journal of The Remote Sensing Society of Japan , 2009 , 29 (2 ): 410 - 417

[本文引用: 1]

[14]

LEE S, CHO M, LEE C An effective gap filtering method for Landsat ETM plus SLC-off data

[J]. Terrestrial Atmospheric and Oceanic Sciences , 2016 , 27 (6 ): 921 - 932

DOI:10.3319/TAO.2016.07.18.02

[本文引用: 1]

[15]

LIN C, TSAI P, LAI K, et al Cloud removal from multitemporal satellite images using information cloning

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2013 , 51 (1 ): 232 - 241

DOI:10.1109/TGRS.2012.2197682

[本文引用: 1]

[16]

KALKAN K, MAKTAV M D A cloud removal algorithm to generate cloud and cloud shadow free images using information cloning

[J]. Journal of the Indian Society of Remote Sensing , 2018 , 46 (8 ): 1255 - 1264

DOI:10.1007/s12524-018-0806-y

[本文引用: 1]

[17]

MELGANI F Contextual reconstruction of cloud-contaminated multitemporal multispectral images

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2006 , 44 (2 ): 442 - 455

DOI:10.1109/TGRS.2005.861929

[本文引用: 1]

[18]

ZHU X, GAO F, LIU D, et al A modified neighborhood similar pixel interpolator approach for removing thick clouds in Landsat images

[J]. IEEE Geoscience and Remote Sensing Letters , 2012 , 9 (3 ): 521 - 525

DOI:10.1109/LGRS.2011.2173290

[本文引用: 1]

[19]

MENG Q, BORDERS B E, CIESZEWSKI C J, et al Closest spectral fit for removing clouds and cloud shadows

[J]. Photogrammetric Engineering and Remote Sensing , 2009 , 75 (5 ): 569 - 576

DOI:10.14358/PERS.75.5.569

[本文引用: 1]

[20]

ZHANG Q, YUAN Q, ZENG C, et al Missing data reconstruction in remote sensing image with a unified spatial-temporal-spectral deep convolutional neural network

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2018 , 56 (8 ): 4274 - 4288

DOI:10.1109/TGRS.2018.2810208

[本文引用: 1]

[21]

ZHANG Q, YUAN Q, LI J, et al Thick cloud and cloud shadow removal in multitemporal imagery using progressively spatio-temporal patch group deep learning

[J]. ISPRS Journal of Photogrammetry and Remote Sensing , 2020 , 162 : 148 - 160

DOI:10.1016/j.isprsjprs.2020.02.008

[本文引用: 1]

[22]

ZHANG L, ZHANG M, SUN X, et al Cloud removal for hyperspectral remotely sensed images based on hyperspectral information fusion

[J]. International Journal of Remote Sensing , 2018 , 39 (20 ): 6646 - 6656

DOI:10.1080/01431161.2018.1466068

[本文引用: 2]

[23]

XU T, GAO X, YANG Y, et al Construction of a semantic segmentation network for the overhead catenary system point cloud based on multi-scale feature fusion

[J]. Remote Sensing , 2022 , 14 (12 ): 2768

DOI:10.3390/rs14122768

[本文引用: 1]

[24]

郭承乾, 马刚, 梅江洲, 等 基于InSAR与多源数据融合的堆石坝外观变形重构

[J]. 浙江大学学报: 工学版 , 2022 , 56 (2 ): 347 - 355

[本文引用: 1]

GUO Chengqian, MA Gang, MEI Jiangzhou, et al Exterior deformation reconstruction of rockfill dam based on InSAR and multi-source data fusion

[J]. Journal of Zhejiang University: Engineering Science , 2022 , 56 (2 ): 347 - 355

[本文引用: 1]

[25]

GROHNFELDT C, SCHMITT M, ZHU X. A conditional generative adversarial network to fuse SAR and multispectral optical data for cloud removal from Sentinel-2 images [C]// IEEE International Geoscience and Remote Sensing Symposium . Valencia: IEEE, 2018: 1726–1729.

[本文引用: 2]

[26]

WANG Y, ZHANG B, ZHANG W, et al Cloud removal with SAR-optical data fusion using a unified spatial-spectral residual network

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2024 , 62 : 5600820

[本文引用: 2]

[27]

LIU Y, WANG X, WANG L, et al A modified leaky ReLU scheme (MLRS) for topology optimization with multiple materials

[J]. Applied Mathematics and Computation , 2019 , 352 : 188 - 204

DOI:10.1016/j.amc.2019.01.038

[本文引用: 1]

[28]

CHEN L, CHU X, ZHANG X, et al. Simple baselines for image restoration [C]// European Conference on Computer Vision . Tel Aviv: Springer, 2022: 17–33.

[本文引用: 1]

[29]

EBEL P, XU Y, SCHMITT M, et al SEN12MS-CR-TS: a remote sensing data set for multi-modal multi-temporal cloud removal

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2022 , 60 : 1 - 14

[本文引用: 1]

[30]

LI Z, SHEN H, LI H, et al Multi-feature combined cloud and cloud shadow detection in GaoFen-1 wide field of view imagery

[J]. Remote Sensing of Environment , 2017 , 191 : 342 - 358

DOI:10.1016/j.rse.2017.01.026

[本文引用: 1]

[31]

CHEN L, ZHU Y, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation [C]// European Conference on Computer Vision . Munich: Springer, 2018: 801–818.

[本文引用: 2]

[32]

LOSHCHILOV I, HUTTER F. SGDR: stochastic gradient descent with warm restarts [EB/OL]. (2017–05–03)[2025–03–13]. https://arxiv.org/abs/1608.03983.

[本文引用: 1]

[33]

ENOMOTO K, SAKURADA K, WANG W, et al. Filmy cloud removal on satellite imagery with multispectral conditional generative adversarial nets [C]// IEEE Conference on Computer Vision and Pattern Recognition Workshops . Honolulu: IEEE, 2017: 48–56.

[本文引用: 1]

Two-stage domain adaptation based on image and feature levels for cloud detection in cross-spatiotemporal domain

1

2024

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

Object-oriented building contour optimization methodology for image classification results via generalized gradient vector flow snake model

0

2021

基于遥感图像道路提取的全局指导多特征融合网络

1

2024

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

基于遥感图像道路提取的全局指导多特征融合网络

1

2024

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

Controllably deep supervision and multi-scale feature fusion network for cloud and snow detection based on medium- and high-resolution imagery dataset

1

2021

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

Former-CR: a transformer-based thick cloud removal method with optical and SAR imagery

3

2023

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

... 现有的遥感影像厚云去除方法大致可以分为3类[5 ,10 ] :基于单源的方法、基于多时相的方法和基于多源的方法. 1) 基于单源的厚云去除方法可以在不借助其他辅助信息的情况下,利用无云区域的信息来恢复云遮挡区域的像素. 然而,在面对影像分辨率较高、含云量较多的情况下,此类方法并不适用. 2) 基于多时相的厚云去除方法将传感器在同一地区、不同时间段获取的2幅或多幅无云影像插值拼接后替换掉云遮挡区域像素. 此类方法受限于传感器重访周期及观测区域的季节性变化. 如果卫星对同一区域的重访周期较长,获取的影像则无法保证补偿后的云覆盖区域地面物体变化的时效性. 3) 基于多源的厚云去除方法利用不同类型多源传感器数据进行云区信息恢复. 主要目的是解决基于单源和基于多时相的厚云去除方法因过度依赖同类传感器所获取的影像,且易受单个传感器影像数据源的空间或时间信息质量的限制而导致的去云效果降低甚至去云失败的缺陷[11 ] . 合成孔径雷达(SAR)可直接穿透云层获取真实地物信息,利用卷积神经网络(CNN)将SAR数据与光学数据融合便可得到较好的遥感影像去云效果[12 -13 ] . 两者结合不仅提高了遥感影像的去云效率和效果,而且提高了多时相数据的利用率. 然而,这些方法仅能去除影像中的薄云或覆盖面积比重较小的云,若云遮挡范围过大,此类方法的去云效果便明显降低. ...

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

Spatial and temporal distribution of clouds observed by MODIS onboard the terra and aqua satellites

1

2013

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

中分辨率遥感影像云检测与厚云去除研究综述

1

2023

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

中分辨率遥感影像云检测与厚云去除研究综述

1

2023

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

Cloud removal based on SAR-optical remote sensing data fusion via a two-flow network

1

2022

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

Thick clouds removal from multitemporal ZY-3 satellite images using deep learning

1

2020

... 光学遥感影像是地表资源常规检测、灾害评估等诸多地球观测任务的重要数据源[1 -3 ] . 然而,受大气层的影响,地球表面约有67%的区域被云层覆盖. 这导致光学遥感影像在成像过程中几乎不可避免地会受到不同程度的云覆盖[4 -5 ] . 这些云的遮挡使得光学遥感影像获取的地物信息衰减甚至损失,进而降低了地表观测影像的时间和空间信息可用性[6 -7 ] . 一般情况下,可将云分为薄云和厚云,两者对影像利用率的影响程度是不一致的[8 ] . 相比之下,厚云的遮挡能力更强,会导致影像中云下信息的严重缺失. 因此,有效去除影像中的厚云对于提高遥感影像利用率具有非常重要的研究意义[9 ] . ...

Thick cloud removal with optical and SAR imagery via convolutional-mapping-deconvolutional network

1

2020

... 现有的遥感影像厚云去除方法大致可以分为3类[5 ,10 ] :基于单源的方法、基于多时相的方法和基于多源的方法. 1) 基于单源的厚云去除方法可以在不借助其他辅助信息的情况下,利用无云区域的信息来恢复云遮挡区域的像素. 然而,在面对影像分辨率较高、含云量较多的情况下,此类方法并不适用. 2) 基于多时相的厚云去除方法将传感器在同一地区、不同时间段获取的2幅或多幅无云影像插值拼接后替换掉云遮挡区域像素. 此类方法受限于传感器重访周期及观测区域的季节性变化. 如果卫星对同一区域的重访周期较长,获取的影像则无法保证补偿后的云覆盖区域地面物体变化的时效性. 3) 基于多源的厚云去除方法利用不同类型多源传感器数据进行云区信息恢复. 主要目的是解决基于单源和基于多时相的厚云去除方法因过度依赖同类传感器所获取的影像,且易受单个传感器影像数据源的空间或时间信息质量的限制而导致的去云效果降低甚至去云失败的缺陷[11 ] . 合成孔径雷达(SAR)可直接穿透云层获取真实地物信息,利用卷积神经网络(CNN)将SAR数据与光学数据融合便可得到较好的遥感影像去云效果[12 -13 ] . 两者结合不仅提高了遥感影像的去云效率和效果,而且提高了多时相数据的利用率. 然而,这些方法仅能去除影像中的薄云或覆盖面积比重较小的云,若云遮挡范围过大,此类方法的去云效果便明显降低. ...

Missing information reconstruction of remote sensing data: a technical review

1

2015

... 现有的遥感影像厚云去除方法大致可以分为3类[5 ,10 ] :基于单源的方法、基于多时相的方法和基于多源的方法. 1) 基于单源的厚云去除方法可以在不借助其他辅助信息的情况下,利用无云区域的信息来恢复云遮挡区域的像素. 然而,在面对影像分辨率较高、含云量较多的情况下,此类方法并不适用. 2) 基于多时相的厚云去除方法将传感器在同一地区、不同时间段获取的2幅或多幅无云影像插值拼接后替换掉云遮挡区域像素. 此类方法受限于传感器重访周期及观测区域的季节性变化. 如果卫星对同一区域的重访周期较长,获取的影像则无法保证补偿后的云覆盖区域地面物体变化的时效性. 3) 基于多源的厚云去除方法利用不同类型多源传感器数据进行云区信息恢复. 主要目的是解决基于单源和基于多时相的厚云去除方法因过度依赖同类传感器所获取的影像,且易受单个传感器影像数据源的空间或时间信息质量的限制而导致的去云效果降低甚至去云失败的缺陷[11 ] . 合成孔径雷达(SAR)可直接穿透云层获取真实地物信息,利用卷积神经网络(CNN)将SAR数据与光学数据融合便可得到较好的遥感影像去云效果[12 -13 ] . 两者结合不仅提高了遥感影像的去云效率和效果,而且提高了多时相数据的利用率. 然而,这些方法仅能去除影像中的薄云或覆盖面积比重较小的云,若云遮挡范围过大,此类方法的去云效果便明显降低. ...

Cloud removal in Sentinel-2 imagery using a deep residual neural network and SAR-optical data fusion

2

2020

... 现有的遥感影像厚云去除方法大致可以分为3类[5 ,10 ] :基于单源的方法、基于多时相的方法和基于多源的方法. 1) 基于单源的厚云去除方法可以在不借助其他辅助信息的情况下,利用无云区域的信息来恢复云遮挡区域的像素. 然而,在面对影像分辨率较高、含云量较多的情况下,此类方法并不适用. 2) 基于多时相的厚云去除方法将传感器在同一地区、不同时间段获取的2幅或多幅无云影像插值拼接后替换掉云遮挡区域像素. 此类方法受限于传感器重访周期及观测区域的季节性变化. 如果卫星对同一区域的重访周期较长,获取的影像则无法保证补偿后的云覆盖区域地面物体变化的时效性. 3) 基于多源的厚云去除方法利用不同类型多源传感器数据进行云区信息恢复. 主要目的是解决基于单源和基于多时相的厚云去除方法因过度依赖同类传感器所获取的影像,且易受单个传感器影像数据源的空间或时间信息质量的限制而导致的去云效果降低甚至去云失败的缺陷[11 ] . 合成孔径雷达(SAR)可直接穿透云层获取真实地物信息,利用卷积神经网络(CNN)将SAR数据与光学数据融合便可得到较好的遥感影像去云效果[12 -13 ] . 两者结合不仅提高了遥感影像的去云效率和效果,而且提高了多时相数据的利用率. 然而,这些方法仅能去除影像中的薄云或覆盖面积比重较小的云,若云遮挡范围过大,此类方法的去云效果便明显降低. ...

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

Cloud removal of optical image using SAR data for ALOS applications: experimenting on simulated ALOS data

1

2009

... 现有的遥感影像厚云去除方法大致可以分为3类[5 ,10 ] :基于单源的方法、基于多时相的方法和基于多源的方法. 1) 基于单源的厚云去除方法可以在不借助其他辅助信息的情况下,利用无云区域的信息来恢复云遮挡区域的像素. 然而,在面对影像分辨率较高、含云量较多的情况下,此类方法并不适用. 2) 基于多时相的厚云去除方法将传感器在同一地区、不同时间段获取的2幅或多幅无云影像插值拼接后替换掉云遮挡区域像素. 此类方法受限于传感器重访周期及观测区域的季节性变化. 如果卫星对同一区域的重访周期较长,获取的影像则无法保证补偿后的云覆盖区域地面物体变化的时效性. 3) 基于多源的厚云去除方法利用不同类型多源传感器数据进行云区信息恢复. 主要目的是解决基于单源和基于多时相的厚云去除方法因过度依赖同类传感器所获取的影像,且易受单个传感器影像数据源的空间或时间信息质量的限制而导致的去云效果降低甚至去云失败的缺陷[11 ] . 合成孔径雷达(SAR)可直接穿透云层获取真实地物信息,利用卷积神经网络(CNN)将SAR数据与光学数据融合便可得到较好的遥感影像去云效果[12 -13 ] . 两者结合不仅提高了遥感影像的去云效率和效果,而且提高了多时相数据的利用率. 然而,这些方法仅能去除影像中的薄云或覆盖面积比重较小的云,若云遮挡范围过大,此类方法的去云效果便明显降低. ...

An effective gap filtering method for Landsat ETM plus SLC-off data

1

2016

... 此类方法仅基于单一影像进行去云处理,不依赖于其他辅助影像或数据源. 空间插值法是此类方法的典型代表. 由于无其他影像信息参考,此类方法利用遥感影像中云区域周围的光谱信息进行插值计算,将插值后的结果填补到信息缺失区域. 例如,将广泛应用于地质统计学的克里金插值法稍作修改后引入云去除任务中,便可得到较好的去云效果. 这种方法在云覆盖区域的插值结果与非云区域有细微差异,但整体去云效果较好. Lee等[14 ] 针对Landsat 7卫星提出一种利用一维插值和滤波技术修复图像的方法,该方法的精度比美国地质勘探局提出的直方图匹配方法更高. 然而,插值去云算法是在云遮挡区域内计算的,因此在去云前需要检测出影像中云的具体位置和覆盖范围. 综合来看,基于单源的厚云去除方法在处理低分辨率、低含云量的影像时,可以最大限度地利用云区周围的特征信息,并利用插值原理有效恢复云遮挡区域的云下信息. 但随着影像分辨率的提升和含云量的增加,云区周围的特征信息大量缺失,此类方法的去云性能会直线下降. ...

Cloud removal from multitemporal satellite images using information cloning

1

2013

... 利用同一地区、不同时间获取的多幅遥感影像填补云遮挡区域是此类方法的主要工作流程. Lin等[15 ] 和Kalkan等[16 ] 使用信息克隆方法从多时相图像中提取辅助信息用于重建云遮挡区域. Melgani[17 ] 利用Landsat 7 ETM+传感器获取的不同时相的影像数据实现了多时相多光谱图像序列中云遮挡区域的信息恢复,还提出上下文多重线性预测(contextual multiple linear prediction, CMLP)去云方法,并通过实验证明该方法能取得很好的去云效果. 除此之外,Zhu等[18 ] 提出基于改进的邻域相似像素插值器(neighborhood similar pixel interpolator, NSPI)的厚云去除方法. 该方法的去云效果明显优于CMLP方法,但仍受影像中云尺寸和辅助影像数量两方面的限制,存在一定的局限性. Meng等[19 ] 为了达到影像去云的目的,提出利用同一地区不同时间拍摄的有云影像和无云影像进行像元替换的思路,并以此提出了最近邻光谱拟合(closest spectral fit, CSF)法. CSF在卫星影像Landsat系列和QuickBird系列上的去云效果显著,且去云精度不会受到云的大小、厚薄以及密度的影响,但该方法依然没有摆脱无云辅助影像的限制. 近年来,深度卷积神经网络(DNN)在遥感领域取得了很好的成绩. Zhang等[20 ] 利用DNN从不同时相的影像中提取多尺度特征用以辅助恢复目标影像云遮挡区域的缺失数据,并取得了优于传统方法的补偿效果. 紧接着,Zhang等[21 ] 又提出利用不同时态影像填充云覆盖区域的深度学习框架. 此类方法使用前应考虑所需影像的采集时间与无云参考影像采集时间的间隔. 若两者间隔较短且地物几乎没有变化,这些方法可以取得相对可靠的补偿结果;若两者间隔较长或观测地面物体变化较快,则无法保证补偿后的云覆盖区域地物特征信息的有效性和可靠性. 因此,该类方法对辅助影像的时间分辨率要求较高. ...

A cloud removal algorithm to generate cloud and cloud shadow free images using information cloning

1

2018

... 利用同一地区、不同时间获取的多幅遥感影像填补云遮挡区域是此类方法的主要工作流程. Lin等[15 ] 和Kalkan等[16 ] 使用信息克隆方法从多时相图像中提取辅助信息用于重建云遮挡区域. Melgani[17 ] 利用Landsat 7 ETM+传感器获取的不同时相的影像数据实现了多时相多光谱图像序列中云遮挡区域的信息恢复,还提出上下文多重线性预测(contextual multiple linear prediction, CMLP)去云方法,并通过实验证明该方法能取得很好的去云效果. 除此之外,Zhu等[18 ] 提出基于改进的邻域相似像素插值器(neighborhood similar pixel interpolator, NSPI)的厚云去除方法. 该方法的去云效果明显优于CMLP方法,但仍受影像中云尺寸和辅助影像数量两方面的限制,存在一定的局限性. Meng等[19 ] 为了达到影像去云的目的,提出利用同一地区不同时间拍摄的有云影像和无云影像进行像元替换的思路,并以此提出了最近邻光谱拟合(closest spectral fit, CSF)法. CSF在卫星影像Landsat系列和QuickBird系列上的去云效果显著,且去云精度不会受到云的大小、厚薄以及密度的影响,但该方法依然没有摆脱无云辅助影像的限制. 近年来,深度卷积神经网络(DNN)在遥感领域取得了很好的成绩. Zhang等[20 ] 利用DNN从不同时相的影像中提取多尺度特征用以辅助恢复目标影像云遮挡区域的缺失数据,并取得了优于传统方法的补偿效果. 紧接着,Zhang等[21 ] 又提出利用不同时态影像填充云覆盖区域的深度学习框架. 此类方法使用前应考虑所需影像的采集时间与无云参考影像采集时间的间隔. 若两者间隔较短且地物几乎没有变化,这些方法可以取得相对可靠的补偿结果;若两者间隔较长或观测地面物体变化较快,则无法保证补偿后的云覆盖区域地物特征信息的有效性和可靠性. 因此,该类方法对辅助影像的时间分辨率要求较高. ...

Contextual reconstruction of cloud-contaminated multitemporal multispectral images

1

2006

... 利用同一地区、不同时间获取的多幅遥感影像填补云遮挡区域是此类方法的主要工作流程. Lin等[15 ] 和Kalkan等[16 ] 使用信息克隆方法从多时相图像中提取辅助信息用于重建云遮挡区域. Melgani[17 ] 利用Landsat 7 ETM+传感器获取的不同时相的影像数据实现了多时相多光谱图像序列中云遮挡区域的信息恢复,还提出上下文多重线性预测(contextual multiple linear prediction, CMLP)去云方法,并通过实验证明该方法能取得很好的去云效果. 除此之外,Zhu等[18 ] 提出基于改进的邻域相似像素插值器(neighborhood similar pixel interpolator, NSPI)的厚云去除方法. 该方法的去云效果明显优于CMLP方法,但仍受影像中云尺寸和辅助影像数量两方面的限制,存在一定的局限性. Meng等[19 ] 为了达到影像去云的目的,提出利用同一地区不同时间拍摄的有云影像和无云影像进行像元替换的思路,并以此提出了最近邻光谱拟合(closest spectral fit, CSF)法. CSF在卫星影像Landsat系列和QuickBird系列上的去云效果显著,且去云精度不会受到云的大小、厚薄以及密度的影响,但该方法依然没有摆脱无云辅助影像的限制. 近年来,深度卷积神经网络(DNN)在遥感领域取得了很好的成绩. Zhang等[20 ] 利用DNN从不同时相的影像中提取多尺度特征用以辅助恢复目标影像云遮挡区域的缺失数据,并取得了优于传统方法的补偿效果. 紧接着,Zhang等[21 ] 又提出利用不同时态影像填充云覆盖区域的深度学习框架. 此类方法使用前应考虑所需影像的采集时间与无云参考影像采集时间的间隔. 若两者间隔较短且地物几乎没有变化,这些方法可以取得相对可靠的补偿结果;若两者间隔较长或观测地面物体变化较快,则无法保证补偿后的云覆盖区域地物特征信息的有效性和可靠性. 因此,该类方法对辅助影像的时间分辨率要求较高. ...

A modified neighborhood similar pixel interpolator approach for removing thick clouds in Landsat images

1

2012

... 利用同一地区、不同时间获取的多幅遥感影像填补云遮挡区域是此类方法的主要工作流程. Lin等[15 ] 和Kalkan等[16 ] 使用信息克隆方法从多时相图像中提取辅助信息用于重建云遮挡区域. Melgani[17 ] 利用Landsat 7 ETM+传感器获取的不同时相的影像数据实现了多时相多光谱图像序列中云遮挡区域的信息恢复,还提出上下文多重线性预测(contextual multiple linear prediction, CMLP)去云方法,并通过实验证明该方法能取得很好的去云效果. 除此之外,Zhu等[18 ] 提出基于改进的邻域相似像素插值器(neighborhood similar pixel interpolator, NSPI)的厚云去除方法. 该方法的去云效果明显优于CMLP方法,但仍受影像中云尺寸和辅助影像数量两方面的限制,存在一定的局限性. Meng等[19 ] 为了达到影像去云的目的,提出利用同一地区不同时间拍摄的有云影像和无云影像进行像元替换的思路,并以此提出了最近邻光谱拟合(closest spectral fit, CSF)法. CSF在卫星影像Landsat系列和QuickBird系列上的去云效果显著,且去云精度不会受到云的大小、厚薄以及密度的影响,但该方法依然没有摆脱无云辅助影像的限制. 近年来,深度卷积神经网络(DNN)在遥感领域取得了很好的成绩. Zhang等[20 ] 利用DNN从不同时相的影像中提取多尺度特征用以辅助恢复目标影像云遮挡区域的缺失数据,并取得了优于传统方法的补偿效果. 紧接着,Zhang等[21 ] 又提出利用不同时态影像填充云覆盖区域的深度学习框架. 此类方法使用前应考虑所需影像的采集时间与无云参考影像采集时间的间隔. 若两者间隔较短且地物几乎没有变化,这些方法可以取得相对可靠的补偿结果;若两者间隔较长或观测地面物体变化较快,则无法保证补偿后的云覆盖区域地物特征信息的有效性和可靠性. 因此,该类方法对辅助影像的时间分辨率要求较高. ...

Closest spectral fit for removing clouds and cloud shadows

1

2009

... 利用同一地区、不同时间获取的多幅遥感影像填补云遮挡区域是此类方法的主要工作流程. Lin等[15 ] 和Kalkan等[16 ] 使用信息克隆方法从多时相图像中提取辅助信息用于重建云遮挡区域. Melgani[17 ] 利用Landsat 7 ETM+传感器获取的不同时相的影像数据实现了多时相多光谱图像序列中云遮挡区域的信息恢复,还提出上下文多重线性预测(contextual multiple linear prediction, CMLP)去云方法,并通过实验证明该方法能取得很好的去云效果. 除此之外,Zhu等[18 ] 提出基于改进的邻域相似像素插值器(neighborhood similar pixel interpolator, NSPI)的厚云去除方法. 该方法的去云效果明显优于CMLP方法,但仍受影像中云尺寸和辅助影像数量两方面的限制,存在一定的局限性. Meng等[19 ] 为了达到影像去云的目的,提出利用同一地区不同时间拍摄的有云影像和无云影像进行像元替换的思路,并以此提出了最近邻光谱拟合(closest spectral fit, CSF)法. CSF在卫星影像Landsat系列和QuickBird系列上的去云效果显著,且去云精度不会受到云的大小、厚薄以及密度的影响,但该方法依然没有摆脱无云辅助影像的限制. 近年来,深度卷积神经网络(DNN)在遥感领域取得了很好的成绩. Zhang等[20 ] 利用DNN从不同时相的影像中提取多尺度特征用以辅助恢复目标影像云遮挡区域的缺失数据,并取得了优于传统方法的补偿效果. 紧接着,Zhang等[21 ] 又提出利用不同时态影像填充云覆盖区域的深度学习框架. 此类方法使用前应考虑所需影像的采集时间与无云参考影像采集时间的间隔. 若两者间隔较短且地物几乎没有变化,这些方法可以取得相对可靠的补偿结果;若两者间隔较长或观测地面物体变化较快,则无法保证补偿后的云覆盖区域地物特征信息的有效性和可靠性. 因此,该类方法对辅助影像的时间分辨率要求较高. ...

Missing data reconstruction in remote sensing image with a unified spatial-temporal-spectral deep convolutional neural network

1

2018

... 利用同一地区、不同时间获取的多幅遥感影像填补云遮挡区域是此类方法的主要工作流程. Lin等[15 ] 和Kalkan等[16 ] 使用信息克隆方法从多时相图像中提取辅助信息用于重建云遮挡区域. Melgani[17 ] 利用Landsat 7 ETM+传感器获取的不同时相的影像数据实现了多时相多光谱图像序列中云遮挡区域的信息恢复,还提出上下文多重线性预测(contextual multiple linear prediction, CMLP)去云方法,并通过实验证明该方法能取得很好的去云效果. 除此之外,Zhu等[18 ] 提出基于改进的邻域相似像素插值器(neighborhood similar pixel interpolator, NSPI)的厚云去除方法. 该方法的去云效果明显优于CMLP方法,但仍受影像中云尺寸和辅助影像数量两方面的限制,存在一定的局限性. Meng等[19 ] 为了达到影像去云的目的,提出利用同一地区不同时间拍摄的有云影像和无云影像进行像元替换的思路,并以此提出了最近邻光谱拟合(closest spectral fit, CSF)法. CSF在卫星影像Landsat系列和QuickBird系列上的去云效果显著,且去云精度不会受到云的大小、厚薄以及密度的影响,但该方法依然没有摆脱无云辅助影像的限制. 近年来,深度卷积神经网络(DNN)在遥感领域取得了很好的成绩. Zhang等[20 ] 利用DNN从不同时相的影像中提取多尺度特征用以辅助恢复目标影像云遮挡区域的缺失数据,并取得了优于传统方法的补偿效果. 紧接着,Zhang等[21 ] 又提出利用不同时态影像填充云覆盖区域的深度学习框架. 此类方法使用前应考虑所需影像的采集时间与无云参考影像采集时间的间隔. 若两者间隔较短且地物几乎没有变化,这些方法可以取得相对可靠的补偿结果;若两者间隔较长或观测地面物体变化较快,则无法保证补偿后的云覆盖区域地物特征信息的有效性和可靠性. 因此,该类方法对辅助影像的时间分辨率要求较高. ...

Thick cloud and cloud shadow removal in multitemporal imagery using progressively spatio-temporal patch group deep learning

1

2020

... 利用同一地区、不同时间获取的多幅遥感影像填补云遮挡区域是此类方法的主要工作流程. Lin等[15 ] 和Kalkan等[16 ] 使用信息克隆方法从多时相图像中提取辅助信息用于重建云遮挡区域. Melgani[17 ] 利用Landsat 7 ETM+传感器获取的不同时相的影像数据实现了多时相多光谱图像序列中云遮挡区域的信息恢复,还提出上下文多重线性预测(contextual multiple linear prediction, CMLP)去云方法,并通过实验证明该方法能取得很好的去云效果. 除此之外,Zhu等[18 ] 提出基于改进的邻域相似像素插值器(neighborhood similar pixel interpolator, NSPI)的厚云去除方法. 该方法的去云效果明显优于CMLP方法,但仍受影像中云尺寸和辅助影像数量两方面的限制,存在一定的局限性. Meng等[19 ] 为了达到影像去云的目的,提出利用同一地区不同时间拍摄的有云影像和无云影像进行像元替换的思路,并以此提出了最近邻光谱拟合(closest spectral fit, CSF)法. CSF在卫星影像Landsat系列和QuickBird系列上的去云效果显著,且去云精度不会受到云的大小、厚薄以及密度的影响,但该方法依然没有摆脱无云辅助影像的限制. 近年来,深度卷积神经网络(DNN)在遥感领域取得了很好的成绩. Zhang等[20 ] 利用DNN从不同时相的影像中提取多尺度特征用以辅助恢复目标影像云遮挡区域的缺失数据,并取得了优于传统方法的补偿效果. 紧接着,Zhang等[21 ] 又提出利用不同时态影像填充云覆盖区域的深度学习框架. 此类方法使用前应考虑所需影像的采集时间与无云参考影像采集时间的间隔. 若两者间隔较短且地物几乎没有变化,这些方法可以取得相对可靠的补偿结果;若两者间隔较长或观测地面物体变化较快,则无法保证补偿后的云覆盖区域地物特征信息的有效性和可靠性. 因此,该类方法对辅助影像的时间分辨率要求较高. ...

Cloud removal for hyperspectral remotely sensed images based on hyperspectral information fusion

2

2018

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

... 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

Construction of a semantic segmentation network for the overhead catenary system point cloud based on multi-scale feature fusion

1

2022

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

基于InSAR与多源数据融合的堆石坝外观变形重构

1

2022

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

基于InSAR与多源数据融合的堆石坝外观变形重构

1

2022

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

2

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

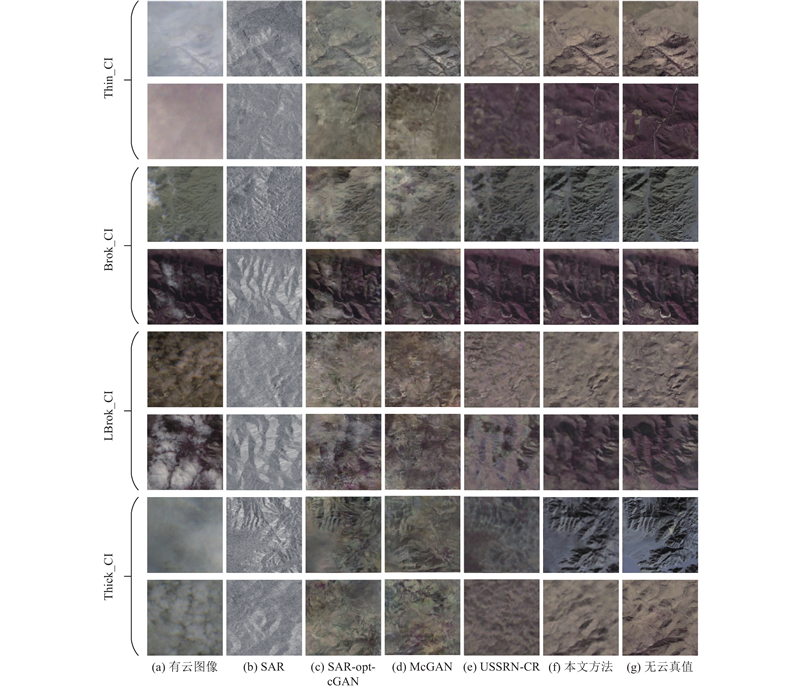

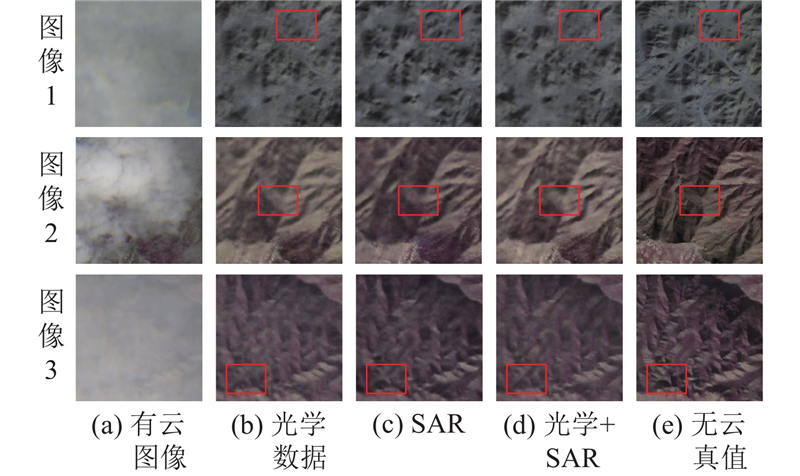

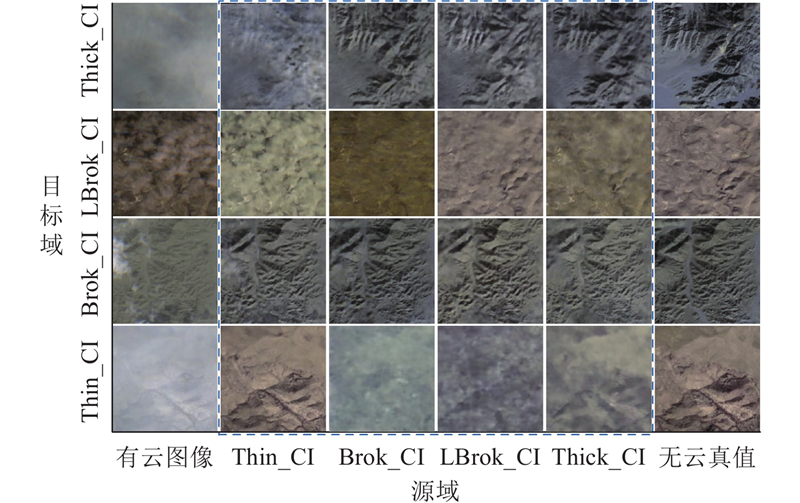

... 为了验证方法性能,选取了3种基于深度学习的去云算法与本文方法进行对比分析,分别为McGAN[33 ] 、SAR-opt-cGAN[25 ] 和USSRN-CR[26 ] . McGAN利用光学图像中的近红外波段和可见光波段完成去云. SAR-opt-cGAN是第一个将SAR和光学多光谱图像应用到去云任务的条件生成式对抗网络,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的光学影像. USSRN-CR是一种新型的基于统一空间光谱特征的残差去云网络,将SAR图像作为辅助参考数据应用到光学遥感图像的云去除任务. 为便于对比分析,上述算法和本研究所提算法均在相同环境和数据集上进行训练. 将4个子数据集分别输入到对比方法和本文方法中进行训练,并将无云光学图像作为真值来计算损失. 如图3 所示,为了对比分析不同方法的去云效果,在不同场景数据集中分别随机挑选了2张图片进行展示. 此外,由表2 展示不同方法在不同子数据集上的定量评价结果. 由图3 可知,在Thin_CI数据集中,这些方法在目视解译分析上均能取得一定的去云恢复效果. 相比之下,SAR-opt-cGAN和McGAN方法在某些图像上整体色调风格的校正能力稍差,但仍能完成基本的薄云去除任务. 由表2 可以看出,4种方法在定量评价结果上相对接近. ...

Cloud removal with SAR-optical data fusion using a unified spatial-spectral residual network

2

2024

... 基于多源的遥感影像厚云去除方法利用不同类型传感器获取的数据来完成去云任务. Zhang等[22 ] 将不同光学传感器获取的高时间分辨率低空间分辨率的影像作为补充数据来填充云覆盖区域. 然而,低时间分辨率图像难以被有效地引入到高空间分辨率图像的重建任务中[5 ] . 除此之外,在任何波段下光学成像均会受到云的干扰,光学传感器不可能完全消除密集云遮挡区域中的数据丢失问题. 因此,只使用光学传感器作为辅助信息源难以满足云遮挡区域信息恢复的实际需求. 相比于光学成像技术,SAR可以在大多数天气条件下获取高分辨率的地面图像,因此在遥感、军事、侦察、地质勘探等领域得到了广泛应用[23 -24 ] . 然而,SAR和光学成像机制不同,给基于SAR的去云方法研究带来了极大的困难. Meraner等[12 ] 在文献[22 ]所提框架结构的基础上进行改进,在神经网络中融合SAR数据,以此达到对哨兵2号影像去云的目的. 随着生成式网络性能的不断开发,Grohnfeldt等[25 ] 提出第一个融合SAR和光学多光谱图像、用于去云任务的条件生成式对抗网络(conditional generative adversarial network, cGAN)架构,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的干净的光学图像. 当然,仍有人在传统架构的基础上实现了技术上的突破,Wang等[26 ] 提出新型的统一空间光谱残差网络,将SAR图像作为辅助参考数据来完成光学遥感图像的去云任务,分别利用门控卷积和空谱注意力机制来实现云像素和非云像素的区分以及全局空间光谱信息的重建. SAR以其独特的透云性能和高可靠性,已成为光学图像缺失信息重建的重要参考数据源. 以SAR作为细节特征来指导光学图像云遮挡区域信息重建已成为当下遥感影像预处理研究最有潜力的方向之一. 然而,不同的传感器获取的数据组织形式和分辨率不尽相同,多模态数据融合相对困难. 为了应对挑战,本研究将SAR数据和光学数据相互融合并应用到光学遥感影像厚云去除任务. ...

... 为了验证方法性能,选取了3种基于深度学习的去云算法与本文方法进行对比分析,分别为McGAN[33 ] 、SAR-opt-cGAN[25 ] 和USSRN-CR[26 ] . McGAN利用光学图像中的近红外波段和可见光波段完成去云. SAR-opt-cGAN是第一个将SAR和光学多光谱图像应用到去云任务的条件生成式对抗网络,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的光学影像. USSRN-CR是一种新型的基于统一空间光谱特征的残差去云网络,将SAR图像作为辅助参考数据应用到光学遥感图像的云去除任务. 为便于对比分析,上述算法和本研究所提算法均在相同环境和数据集上进行训练. 将4个子数据集分别输入到对比方法和本文方法中进行训练,并将无云光学图像作为真值来计算损失. 如图3 所示,为了对比分析不同方法的去云效果,在不同场景数据集中分别随机挑选了2张图片进行展示. 此外,由表2 展示不同方法在不同子数据集上的定量评价结果. 由图3 可知,在Thin_CI数据集中,这些方法在目视解译分析上均能取得一定的去云恢复效果. 相比之下,SAR-opt-cGAN和McGAN方法在某些图像上整体色调风格的校正能力稍差,但仍能完成基本的薄云去除任务. 由表2 可以看出,4种方法在定量评价结果上相对接近. ...

A modified leaky ReLU scheme (MLRS) for topology optimization with multiple materials

1

2019

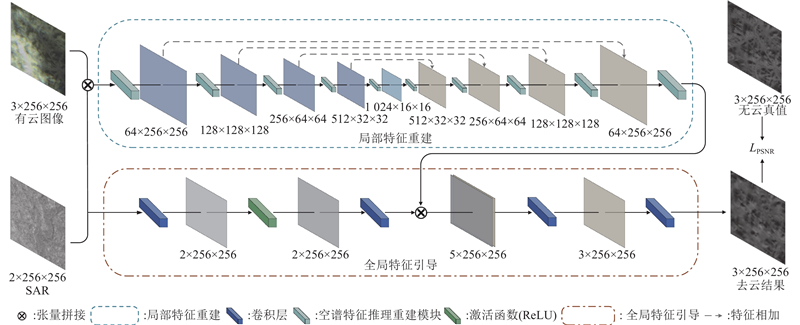

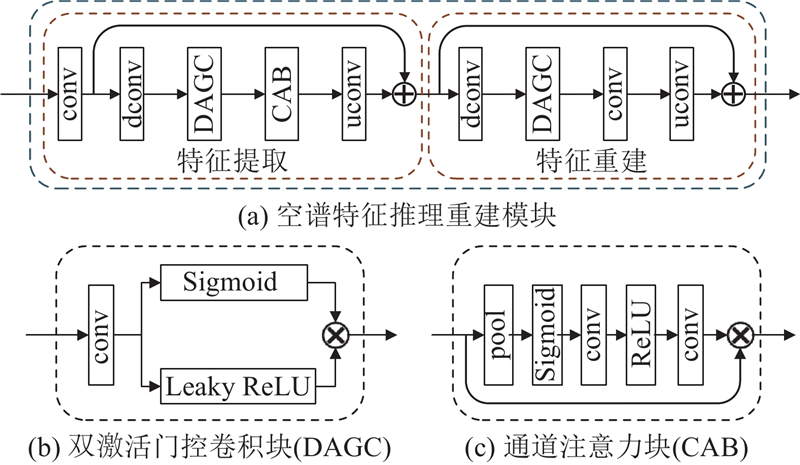

... 在去云任务中,云覆盖区域存在大量的无效像素. 因此,需要对有效像素和无效像素加以区分. 本研究提出双激活门控卷积DAGC,在传统门控卷积(GC)的基础上加以改进,采用激活函数来引导卷积层学习区分有云区域和无云区域. DAGC在所有层的每个空间位置为每个通道均提供可学习的动态特征来解决传统卷积将所有像素视为有效像素问题的不合理性. 将Sigmoid和Leaky ReLU[27 ] 这2种激活函数分别引入GC的2个分支中,如图2 (b)所示. Sigmoid函数对每个神经元的输出进行归一化,这有利于特征层信息的高效提取. 此外,Sigmoid函数具有平滑的梯度,可以有效规避不合理输出值. Leaky ReLU函数保留有负轴的值,缓解了激活值过小而导致神经元参数无法更新的问题. 具体地,DAGC的推理过程可表述为 ...

1

... 遥感影像厚云去除任务可以被看作图像重建任务,即重建缺失的空间和光谱信息,以期达到影像去云的效果. 本文方法训练过程中使用的损失函数是在峰值信噪比(PSNR)的基础上改进得来的. PSNR通常用于比较原始图像与经过处理后的图像的质量差异,反映了方法的图像特征生成或重建能力. Chen等[28 ] 直接将PSNR作为损失函数应用到图像去噪网络的训练中,并取得了较好的降噪效果. ...

SEN12MS-CR-TS: a remote sensing data set for multi-modal multi-temporal cloud removal

1

2022

... 以公共数据集SEN12MS-CR-TS[29 ] 为基础数据集,该数据集将不同程度的云覆盖影像混淆在一起. 为了更好地验证本文方法在不同云覆盖场景下的去云效果,根据云的形态、云量占比将SEN12MS-CR-TS拆分成了4个不同的子集. 由于该数据集未提供云标签,本研究利用在GF1_WHU数据集[30 ] 训练好的DeepLabV3+模型[31 ] 对该数据集上的所有影像进行云量检测,并根据表1 所示对影像进行粗略的场景划分. 经实验证明,DeepLabV3+模型在GF1_WHU数据集上的准确率、精确率、召回率均达到88%以上,可用于本研究数据集的粗略云量检测. 接着,综合考虑云覆盖占比、云的形态等因素,通过人工判读,对影像逐张筛选,将数据集细分为薄云场景数据集(Thin_CI)、小碎云场景数据集(Brok_CI)、片状碎云场景数据集(LBrok_CI)和厚云场景数据集(Thick_CI). 表1 展示了4个子数据集的分类信息、云占比(x )和样本数量(N ). ...

Multi-feature combined cloud and cloud shadow detection in GaoFen-1 wide field of view imagery

1

2017

... 以公共数据集SEN12MS-CR-TS[29 ] 为基础数据集,该数据集将不同程度的云覆盖影像混淆在一起. 为了更好地验证本文方法在不同云覆盖场景下的去云效果,根据云的形态、云量占比将SEN12MS-CR-TS拆分成了4个不同的子集. 由于该数据集未提供云标签,本研究利用在GF1_WHU数据集[30 ] 训练好的DeepLabV3+模型[31 ] 对该数据集上的所有影像进行云量检测,并根据表1 所示对影像进行粗略的场景划分. 经实验证明,DeepLabV3+模型在GF1_WHU数据集上的准确率、精确率、召回率均达到88%以上,可用于本研究数据集的粗略云量检测. 接着,综合考虑云覆盖占比、云的形态等因素,通过人工判读,对影像逐张筛选,将数据集细分为薄云场景数据集(Thin_CI)、小碎云场景数据集(Brok_CI)、片状碎云场景数据集(LBrok_CI)和厚云场景数据集(Thick_CI). 表1 展示了4个子数据集的分类信息、云占比(x )和样本数量(N ). ...

2

... 以公共数据集SEN12MS-CR-TS[29 ] 为基础数据集,该数据集将不同程度的云覆盖影像混淆在一起. 为了更好地验证本文方法在不同云覆盖场景下的去云效果,根据云的形态、云量占比将SEN12MS-CR-TS拆分成了4个不同的子集. 由于该数据集未提供云标签,本研究利用在GF1_WHU数据集[30 ] 训练好的DeepLabV3+模型[31 ] 对该数据集上的所有影像进行云量检测,并根据表1 所示对影像进行粗略的场景划分. 经实验证明,DeepLabV3+模型在GF1_WHU数据集上的准确率、精确率、召回率均达到88%以上,可用于本研究数据集的粗略云量检测. 接着,综合考虑云覆盖占比、云的形态等因素,通过人工判读,对影像逐张筛选,将数据集细分为薄云场景数据集(Thin_CI)、小碎云场景数据集(Brok_CI)、片状碎云场景数据集(LBrok_CI)和厚云场景数据集(Thick_CI). 表1 展示了4个子数据集的分类信息、云占比(x )和样本数量(N ). ...

... 分别用传统门控卷积和双激活门控卷积替换DeepLabV3+模型[31 ] 中的卷积层,以此来构建不同的模型. 对构建的3种模型在GF1_WHU数据集上的云提取效果进行对比分析,如表6 所示,分析指标包括平均交并比(MIoU)、准确率(A )、精确率(P )和召回率(R ). 可以看出,DAGC比普通卷积和传统门控卷积有更好的云提取效果,说明本研究所提双激活门控卷积(DAGC)对影像中的云和非云像素的区分效果优于传统卷积和普通门控卷积. ...

1

... 网络使用Adam优化器进行训练,并利用上文提到的改进后的峰值信噪比指数作为损失函数. 输入网络的影像数据被裁剪成256×256像素大小. 训练过程中使用余弦退火策略[32 ] 控制学习率,默认学习率设置为10−4 ,最小学习率为10−7 . 网络训练批量设置为8,迭代次数为200. 所有训练过程均在1张GeForce RTX 3090显卡上完成,环境配置为Pytorch v1.8.0+cu111、CUDA v11.1. ...

1

... 为了验证方法性能,选取了3种基于深度学习的去云算法与本文方法进行对比分析,分别为McGAN[33 ] 、SAR-opt-cGAN[25 ] 和USSRN-CR[26 ] . McGAN利用光学图像中的近红外波段和可见光波段完成去云. SAR-opt-cGAN是第一个将SAR和光学多光谱图像应用到去云任务的条件生成式对抗网络,利用被云污染的光学图像和SAR辅助图像生成无云和无雾的光学影像. USSRN-CR是一种新型的基于统一空间光谱特征的残差去云网络,将SAR图像作为辅助参考数据应用到光学遥感图像的云去除任务. 为便于对比分析,上述算法和本研究所提算法均在相同环境和数据集上进行训练. 将4个子数据集分别输入到对比方法和本文方法中进行训练,并将无云光学图像作为真值来计算损失. 如图3 所示,为了对比分析不同方法的去云效果,在不同场景数据集中分别随机挑选了2张图片进行展示. 此外,由表2 展示不同方法在不同子数据集上的定量评价结果. 由图3 可知,在Thin_CI数据集中,这些方法在目视解译分析上均能取得一定的去云恢复效果. 相比之下,SAR-opt-cGAN和McGAN方法在某些图像上整体色调风格的校正能力稍差,但仍能完成基本的薄云去除任务. 由表2 可以看出,4种方法在定量评价结果上相对接近. ...