人体运动行为识别的关键步骤为特征提取和行为识别. 传统行为识别方法主要依赖于人工的设计特征,例如支持向量机、K近邻分类器、决策树分类器和隐马尔科夫模型等[5-8]. Tang等[9]使用支持向量机(SVM)算法分类识别30名志愿者的日常行为,从智能手机中提取不同信号特征,验证其对人体活动识别准确率的影响. 然而,传统的机器学习算法严重依赖于启发式手工特征提取. 随着智能设备的普及和深度学习技术的发展,国内外利用深度学习进行人体运动行为识别的研究越来越多,如卷积神经网络[10-13]或长短期记忆网络[14-16](long-short term memory,LSTM),以自动识别日常活动. Xing等[17]提出卷积神经网络模型,在UCI数据集上取得了95.99%的识别准确率. Shi等[18]提出基于一维卷积神经网络(CNN)(convolutional neural network)的深度学习方法检测人体运动行为,在PAMAP2数据集取得94.8%的识别准确率. vsman Sarwar等[19]提出基于注意力的双向门控循环单元(gate recurrent unit,GRU)来增强递归神经网络,实现人体运动行为的分类与识别. Arshad等[20]提出由卷积神经网络和双向长短期记忆网络构成的分层深度学习模型,在MobiAct数据集取得了96.61%的准确率.

综合以上研究发现,单一的神经网络模型在处理时间序列数据时往往无法充分捕获关键信息. 相比之下,使用多模型结合的方法可以更全面地提取运动行为的特征,进而提高识别准确性. 其次,为了获得良好的行为识别效果,基于深度学习的研究方法要融合不同种类的传感器数据样本进行模型训练,然而,这通常需要大量数据和计算资源,限制了在数据有限的情况下达到理想识别效果的可能性. 因此,为了解决深度神经网络在小样本行为识别上准确度不高的问题,将深度可分离卷积、双向门控循环单元和注意力机制相结合,提出多损失孪生网络模型,即DCS-BiGRU-Att多损失孪生网络. 主要创新点如下:在小样本数据情况下,基于孪生网络的模型结构能确保行为识别的准确性;深度可分离卷积能够减少模型的参数量,提升模型的泛化能力,而注意力机制能够自适应学习信号中的关键特征,提高模型对重要时间步的关注度,帮助模型更好地理解时间序列数据中的动态变化;引入多损失函数融合,能进一步优化模型分类的准确率.

1. 孪生网络

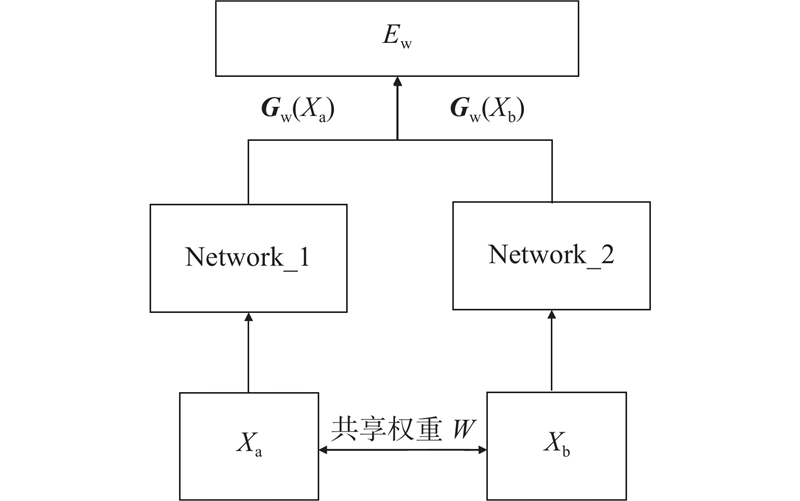

在健康监测领域,对于行动不便的老人或进行康复训练的患者来说,收集大量传感器数据以用于人体运动行为识别是一项挑战. 当前研究亟待解决的问题是如何有效利用单一传感器所采集的小样本数据来进行准确的行为识别. 孪生网络[21]是用于度量学习的神经网络结构,在小样本问题上具有一定的优势. 孪生网络由2个共享权重的子网络组成,它们被称为孪生分支. 这种结构使得网络能够同时处理2个输入,然后将2个输入样本映射到一个相同维度的特征空间中,通过比较特征空间内的样本距离来判断它们的相似度或差异性.

孪生网络的共享权值和结构可以减少模型的参数数量,提高模型的鲁棒性. 此外,基于孪生网络的深度学习框架可以构建多个样本组合,对于n个训练样本,可以创建n(n−1)个样本组合,其中每个样本组合由2个样本构成,这样做可以在数据有限的情况下增加训练样本,减轻因数据样本数量不足而产生的过拟合问题,同时提高模型的泛化能力和稳定性. 孪生网络训练过程通常采用对比损失函数,使得同一类样本在目标空间中的距离尽可能近,不同类样本在目标空间中的距离尽可能远. 最终,孪生神经网络能够学习到用于衡量2个输入之间相似性的映射函数,从而在各种任务中获得更好的性能.

孪生网络基本结构如图1所示.图中,

图 1

式中:

2. 算法设计

2.1. 骨干网络框架

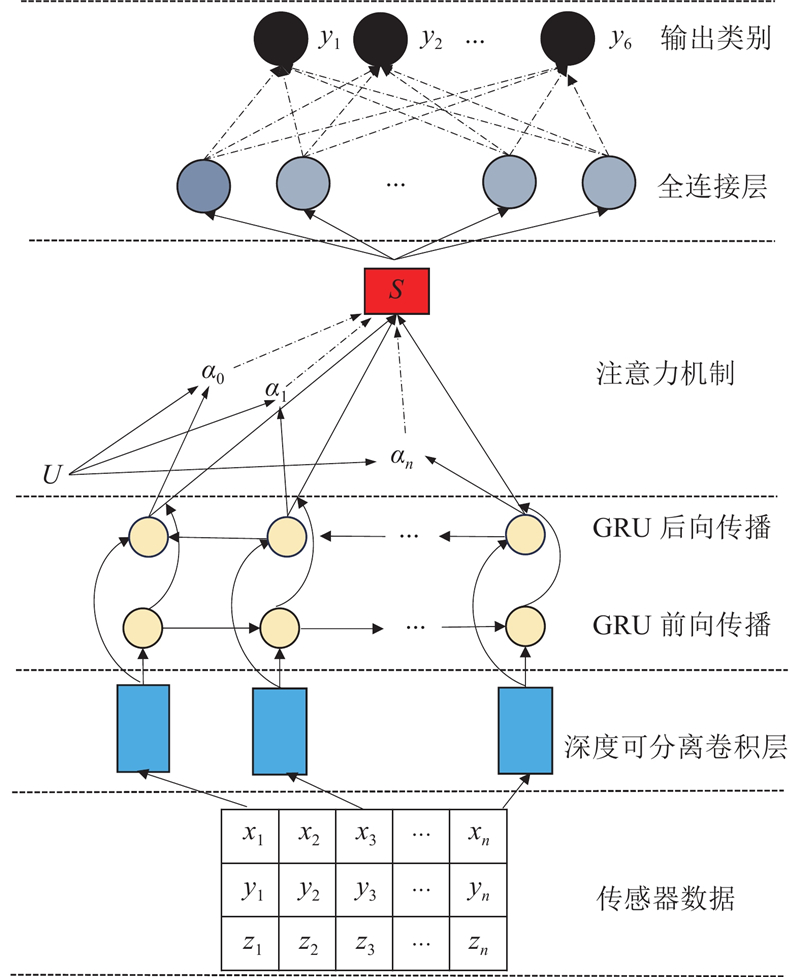

所提出的行为识别骨干网络结构如图2所示. 为了减少模型的参数量,加快模型运行速度,将常用的卷积神经网络替换为深度可分离卷积. 三轴加速度传感器数据经过DSC层提取空域特征;然后,将得到的特征集合输入双向GRU层进行时域特征提取;在双向GRU层后连接注意力层,以更好地学习时间序列中重要的信息,并在模型训练时分配更多的权重给关键的时间步,同时,加入注意力机制以有效提高模型的准确性和鲁棒性;经过层层筛选之后,将人体运动行为特征集合输入全连接层,利用权重矩阵将其映射到样本标记空间中. 最后使用softmax函数进行分类计算,预测每种类别的概率分布,并选择概率最大的类别作为输入数据样本的预测类别. 通过这种方式,模型能够有效地对输入数据进行分类,并为每个输入样本输出一个预测结果,以帮助用户更好地理解人体运动行为的类型和特征.

图 2

2.2. 深度可分离卷积模块

深度可分离卷积[22]是卷积神经网络中的一种卷积方式,标准卷积会在卷积深度增加过程中加大模型的参数量和计算量,而深度可分离卷积将一个标准的卷积过程分为2个步骤,分别是深度卷积(depthwise convolution)和逐点卷积(pointwise convolution). 深度卷积指将输入数据分成多个通道,每个通道分别进行卷积操作,得到一个深度特征图. 逐点卷积是指将深度特征图上的每个像素与对应的权重相乘并求和,得到一个输出特征图. 这种方式可以减少模型的参数量,提高模型的计算效率. 同时,使用深度可分离卷积能够在训练过程中降低过拟合现象的产生,有助于提高模型的泛化能力. 因此,提出使用DSC代替传统卷积神经网络的模块,获取传感器数据中的空间特征.

将处理后的三轴加速度数据输入深度可分离卷积层. 首先,输入三轴加速度数据

式中:

通过逐点卷积将3个特征图进行相加,得到最终的特征图,表达式如下:

式中:

表 1 DSC模块主要结构参数

Tab.1

| 层名称 | 核数量 | 核大小 | 输出维度 |

| 卷积1 | 64 | 4 | 125 |

| 池化1 | 0 | 0 | 62 |

| BN | 0 | 0 | 62 |

| 卷积2 | 32 | 2 | 61 |

| 池化2 | 0 | 0 | 30 |

表 2 DSC模块结构下不同卷积方式参数量对比

Tab.2

| 层名称 | M | |

| CNN | DSC | |

| 卷积1 | 832 | 268 |

| 池化1 | 0 | 0 |

| BN1 | 256 | 256 |

| 卷积2 | ||

| 池化2 | 0 | 0 |

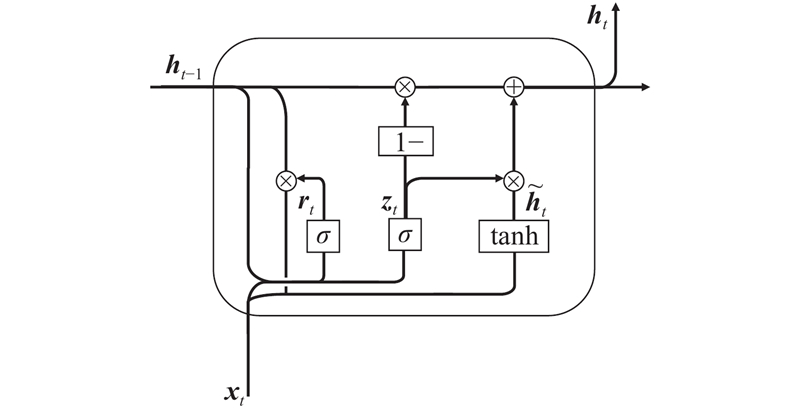

2.3. 双向门控循环单元模块

图 3

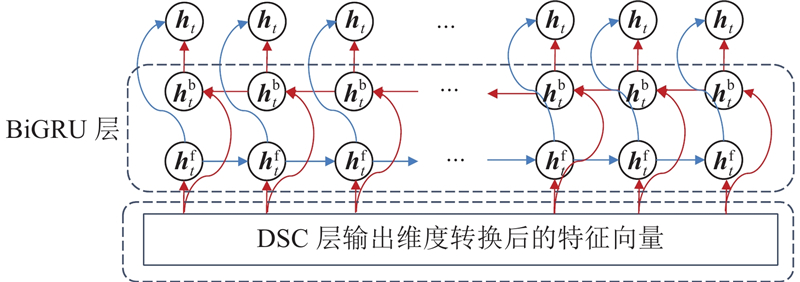

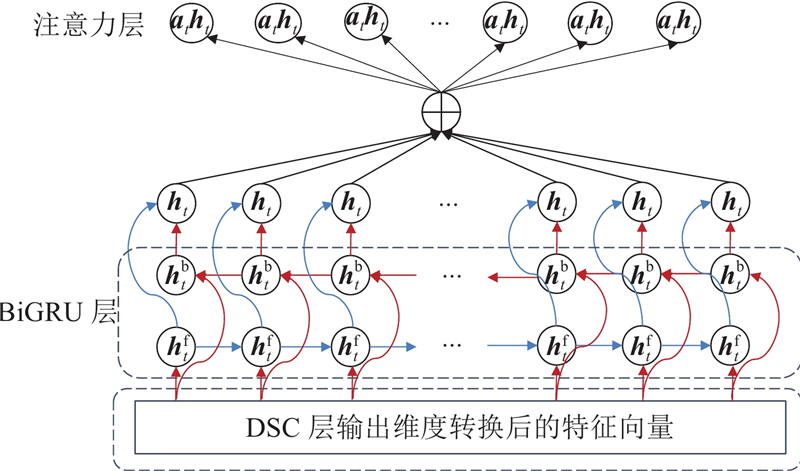

人体当前的运动状态输出与前后的运动状态信息有关. 针对上述问题,使用双向门控循环单元模块提取数据的时间特征. BiGRU模块结构如图4所示. BiGRU模块同时考虑过去和未来的数据点,能够更好地捕捉时序上下文关系.

图 4

调整深度可分离卷积得到特征图

式中: GRU函数为非线性变换函数,用于处理和转换输入的时间序列数据;

将前向GRU和后向GRU的输出隐状态

式中:

经过所有时间步的处理后,得到最终的双向GRU输出:

式中:

2.4. 注意力机制模块

BiGRU模块可能会忽略时间序列数据中不同时间步之间的重要关系,导致模型对某些特定时间步的关注度较低. 为了解决这个问题,提出在BiGRU模块后连接注意力机制模块. 注意力机制[24]是对输入数据分配不同权重的机制. 它通过计算每个时间步的注意力权重,将重要的时间步与不重要的时间步进行区分. 在模型中嵌入注意力机制模块,使其能够自适应地学习到信号中的关键特征,从而提高模型的精度和可解释性.

在传统的“查询-键-值”注意力机制中,模型须学习额外的权重参数来生成注意力分数. 这意味着对于每个传感器数据点,模型都须维护一组参数,导致模型的参数量增加,从而增加模型的复杂性和计算成本. 本研究对象为小样本数据,因此使用一个简化的注意力机制. 对于每个时间步

式中:

注意分数可以反映特征的重要性或注意度. 然后,通过对注意分数进行softmax归一化,得到注意权重

注意力机制结构如图5所示,通过引入注意力机制模块,提高了模型对重要时间步的关注度,并且帮助模型更好地理解时间序列数据中的动态变化,捕捉关键的运动模式和行为特征.

图 5

2.5. 多损失融合

现有大多数基于孪生网络模型的损失函数为对比损失函数,然而行为识别模型的主要任务是识别并分类不同的运动类型,因此,提出多损失融合的方法改进孪生网络,改进后的网络采用多任务学习方法,包括运动行为分类和输入样本对相似性判别.

基于DSC-BiGRU-Att多损失孪生网络的人体行为识别模型整体结构如图6所示. 在孪生网络的基础上,引入DSC-BiGRU-Att作为子网络提取传感器信号特征,网络包含3个输出分支,分别为2个交叉熵损失函数和1个对比损失函数. 交叉熵损失函数对应的输出分支在人体运动行为识别任务中用于运动行为的分类. 对比损失函数对应的输出分支用于判别输入样本对的相似性. 通过使用3个输出分支,网络可以同时进行多个任务的学习,每个分支都有对应的损失函数来指导网络的优化. 这种多任务学习的方法可以增强网络的泛化能力和鲁棒性,并且可以通过共享底层特征提取层来提高模型的效率和参数利用率.

图 6

图 6 基于DSC-BiGRU-Att多损失孪生网络的人体行为识别模型整体结构

Fig.6 Structure of human behavior recognition model based on DSC-BiGRU-Att multi-loss Siamese networks

模型输入的2个传感器数据序列为1和2,对应的特征表示为

式中:

式中:

将孪生神经网络中每个分支视为一个多分类模型. 具体而言,将从传感器数据中提取的特征输入到一个具有

式中:

交叉熵损失函数通过衡量真实标签与模型预测之间的差异来指导网络的训练. 在本研究中,所提出的网络可以同时最小化3个损失函数,其中包括2个交叉熵损失和1个对比损失函数. 具体来说,网络的损失函数表达式如下:

式中:

通过同时最小化这3个损失函数,网络可以综合考虑分类任务和样本特征之间的距离关系. 经过实验验证,选取

3. 实验结果与分析

3.1. 数据介绍

表 3 6种动作具体描述

Tab.3

| 编号 | 动作类别 | 动作描述 |

| 1 | 行走 | 在平坦的路面上以不同的速度行走和转弯 |

| 2 | 慢跑 | 以不同的速度跑步 |

| 3 | 跳跃 | 以不同的高度原地跳跃 |

| 4 | 上楼 | 以不同的速度在不同的地方爬楼梯 |

| 5 | 下楼 | 以不同的速度下楼梯 |

| 6 | 站 | 保持下肢静态站在固体表面上 (上肢可以有其他动作行为) |

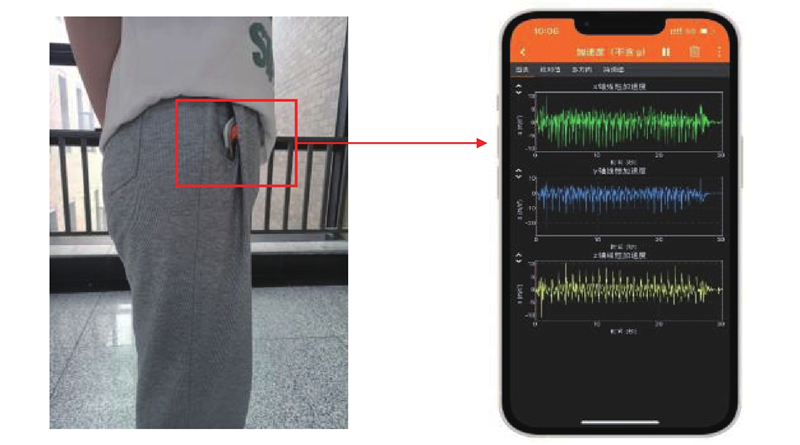

图 7

原始信号常常包含噪声和干扰,可能会降低模型识别的准确率. 因此,根据现有的研究结果及实验验证,使用5阶中值滤波和截止频率为20 Hz的三阶巴特沃斯滤波,去除原始加速度数据中的噪声. 此外,由于传感器信号采集数据量过长,不适合直接输入分类模型,因此,采用滑动窗口分割传感器数据. 将数据分割为2.56 s,即滑动窗口包含128个数据点,重叠率为50%,对传感器序列采样得到

3.2. 实验环境及行为识别性能评价指标

本算法在Windows 10系统Tensorflow 2.0框架下实现. 软件环境配置为CUDA11.2,Python3.7.2,处理器为AMD Ryzen 9 5900HX with Radeon Graphics 3.30 GHz,内存为16 G. GPU为NVIDIA GeForce RTX 3060. 训练时随机挑选样本对,迭代次数为100次,初始学习率为0.001,批大小为64.

行为识别属于多分类问题,因此在人体运动行为识别领域,常用的评价指标有:准确率A,精确率P,召回率R,F1值F1. 表达式分别如下:

式中:

3.3. 训练样本数量对识别结果的影响

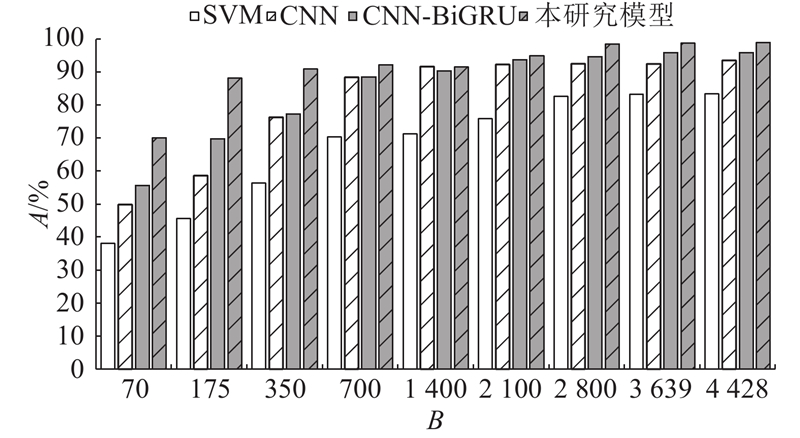

为了全面比较所提出的行为识别算法的性能,从自采集数据集的训练集中随机选取70、175、350、700、

行为识别结果如图8所示. 可以看到,随着训练样本数量B的增加, SVM、CNN、CNN-BiGRU和DSC-BiGRU-Att孪生网络的分类准确率都随之提高,表明训练数据的增多能够帮助模型学习到更加泛化的特征表示. 然而,当训练样本数量有限时,模型的泛化能力受到挑战,此时,DSC-BiGRU-Att孪生网络展现出其优越性. 在训练样本数量为 70~350的小样本条件下,DSC-BiGRU-Att孪生网络的准确率最高. 尤其当训练样本数量为175时,DSC-BiGRU-Att多损失孪生网络分类准确率明显高于其他模型的,说明DSC-BiGRU-Att孪生网络对于小样本有更好的处理能力. 当训练数据为全部样本时,DSC-BiGRU-Att孪生网络达到98.89%的准确率,仍高于CNN和CNN-BiGRU的.

图 8

图 8 训练样本数量对行为识别结果的影响

Fig.8 Effect of number of training samples on behavioral recognition results

3.4. 不同主干网络模型对比分析

为了深入分析不同主干网络对孪生网络性能的影响,在样本数量为350的条件下,对比不同深度和复杂度的网络结构,主干网络分别为:(a) 2层CNN网络、(b) 2层DSC网络、(c) 3层CNN网络、(d) 3层DSC网络、(e)单层LSTM、(f)单层GRU和(g)单层BiGRU,同(h)本研究提出的主干网络进行比较,每个主干网络后面均连接全连接层和输出层.

行为识别实验结果如表4所示. 由实验结果可以看出,卷积网络的层数增加可以增强模型的特征提取能力,能够在一定程度上提升识别准确率. 例如:3层DSC网络的准确率比2层DSC网络的准确率提高了约2个百分点. 但是,网络层数的增加会增加模型的复杂性,较少层数的网络通常会有更少的参数和计算量,考虑到实际应用中计算资源的有限性,选择2层DSC网络提取传感器数据的空间特征. 此外,单一使用卷积神经网络(CNN)或循环神经网络(RNN)的孪生网络,其识别精度为80%~88%,而本研究提出的DSC-BiGRU-Att多损失孪生网络模型识别准确率为91.85%,说明基于混合模型的孪生网络能够从数据中捕获更丰富的特征,从而提高整体的识别精度.

表 4 不同主干网络的实验结果

Tab.4

| Plan | A/% | P/% | R/% | F1 |

| (a) | 88.25 | 88.46 | 88.36 | |

| (b) | 89.02 | 89.21 | 89.32 | |

| (c) | 90.88 | 90.25 | 90.56 | |

| (d) | 90.86 | 90.56 | 90.49 | |

| (e) | 80.56 | 80.59 | 80.74 | |

| (f) | 81.36 | 81.32 | 81.35 | |

| (g) | 85.69 | 85.48 | 85.39 | |

| (h) | 91.85 | 91.84 | 91.68 |

3.5. 消融实验

为了验证所提出算法的有效性,在数据集上进行消融实验以验证BiGRU模块、注意力机制和孪生网络结构对网络的有效性.

首先构建一个基线baseline,主要包括2个卷积层、1个池化层、1个BN层. 接下来在基线网络中添加不同的模块,具体方案如下:1) baseline+DSC,基线卷积层替换为DSC;2) baseline+DSC+ BiGRU,在方案1)的基础上加入BiGRU模块;3) baseline+DSC+BiGRU+Att,在方案2)的基础上加入注意力机制模块;4) baseline+DSC+BiGRU+Att孪生网络,在方案3)的基础上加入孪生网络结构,即本研究所提算法.

实验结果如表5所示. 可以看出,在网络加入 BiGRU模块和注意力机制后,模型的准确率、精确率和召回率均有所提升,注意力机制模块的加入对网络的性能有较大的提升,准确率、精确率和召回率分别提升了4.83、4.97和5.35个百分点. 在融合孪生网络后,准确率和精确率进一步提升了1.25和1.08个百分点. 由此可以看出,上述模块都能有效提高行为识别的准确性和鲁棒性.

表 5 消融实验结果对比

Tab.5

| 方案 | A/% | P/% | R/% | F1 |

| 1) | 92.81 | 92.75 | 92.31 | |

| 2) | 94.88 | 94.82 | 94.80 | |

| 3) | 97.64 | 97.72 | 97.66 | |

| 4) | 98.89 | 98.80 | 98.89 |

4. 结 语

针对单个传感器获得数据量有限,且传统深度学习模型精度不够的问题,提出基于DSC-BiGRU-Att多损失孪生网络用于人体运动行为识别. 该网络结合了特征提取、注意力机制和多任务学习,能够更好地处理传感器信号数据并完成人体运动行为识别任务. DSC模块可以捕捉到输入数据中的空间关系,BiGRU模块可以建模时间序列数据的依赖性,同时注意力机制模块能够自适应地关注关键的时空特征. 模型使用多个损失函数进行训练,包括分类损失和对比损失. 分类损失用于优化网络对行为类别的预测,对比损失用于增强网络对不同样本之间的差异性学习. 这种多损失的训练策略可以提高模型的鲁棒性和泛化能力. 不同训练样本数量的行为识别试验结果和不同主干网络的行为识别结果表明,孪生网络处理小样本数据有一定的优越性. 在自采集小样本数据集上的消融实验结果表明,本研究设计的网络结构具有较好的性能和灵活性,在人体运动行为识别任务中具有潜力和应用前景. 不过,本研究提出的算法未在公开数据集上检验其泛化性,之后的研究重点为继续对于难以区分的复杂人体运动行为进行分类识别,并在公开数据集上与现有的模型进行对比,以证明所提出算法的有效性.

参考文献

Human activity analysis: a review

[J].

Human activity recognition based on multienvironment sensor data

[J].DOI:10.1016/j.inffus.2022.10.015

Device-free human activity recognition using commercial WiFi devices

[J].DOI:10.1109/JSAC.2017.2679658 [本文引用: 1]

Prediction of human gait activities using wearable sensors

[J].

Fusion of smartphone sensor data for classification of daily user activities

[J].DOI:10.1007/s11042-021-11105-6

Human activity classification using Decision Tree and Naïve Bayes classifiers

[J].DOI:10.1007/s11042-020-10447-x

Recognizing human concurrent activities using wearable sensors: a statistical modeling approach based on parallel HMM

[J].DOI:10.1108/SR-01-2017-0003 [本文引用: 1]

TSE-CNN: a two-stage end-to-end CNN for human activity recognition

[J].

Human activity recognition from multiple sensors data using multi-fusion representations and CNNs

[J].

Human activity recognition from multiple sensors data using deep CNNs

[J].

Human activity recognition by the image type encoding method of 3-axial sensor data

[J].DOI:10.3390/app13084961 [本文引用: 1]

Bi-LSTM network for multimodal continuous human activity recognition and fall detection

[J].

Human activity recognition by combining external features with accelerometer sensor data using deep learning network model

[J].DOI:10.1007/s11042-021-11313-0

Investigating classification performance of hybrid deep learning and machine learning architectures on activity recognition

[J].DOI:10.1111/coin.12517 [本文引用: 1]

An improved spatial temporal graph convolutional network for robust skeleton-based action recognition

[J].DOI:10.1007/s10489-022-03589-y [本文引用: 1]

Real-time human activity recognition system based on capsule and LoRa

[J].

PARCIV: recognizing physical activities having complex interclass variations using semantic data of smartphone

[J].DOI:10.1002/spe.2846 [本文引用: 1]

Multi-level features fusion and selection for human gait recognition: an optimized framework of Bayesian model and binomial distribution

[J].DOI:10.1007/s13042-019-00947-0 [本文引用: 1]

Csi-based joint location and activity monitoring for COVID-19 quarantine environments

[J].

用于行为识别的通道可分离卷积神经网络

[J].

Channel separable convolutional neural network for behavior recognition

[J].