[1]

XING X W, CHEN Z L, ZOU H X, et al. A fast algorithm based on two-stage CFAR for detecting ships in SAR images [C]// Asian-Pacific Conference on Synthetic Aperture Radar . Xi'an: IEEE, 2009: 506-509.

[本文引用: 1]

[2]

范晋祥, 刘益吉, 李宁, 等 精确打击体系智能化的发展

[J]. 空天防御 , 2023 , 6 (4 ): 1 - 11

DOI:10.3969/j.issn.2096-4641.2023.04.001

[本文引用: 1]

FAN Jinxiang, LIU Yiji, LI Ning, et al Development of the intelligentization of precision strike system of systems

[J]. Air and Space Defense , 2023 , 6 (4 ): 1 - 11

DOI:10.3969/j.issn.2096-4641.2023.04.001

[本文引用: 1]

[3]

张天文. 基于深度学习的SAR图像舰船检测及识别技术研究[D]. 成都: 电子科技大学, 2022.

[本文引用: 1]

ZHANG Tianwen. Research on deep learning-based SAR ship detection and recognition technology [D]. Chengdu: University of Electronic Science and Technology of China, 2022.

[本文引用: 1]

[4]

田东. 基于卷积神经网络的深度学习算法研究与实现[D]. 上海: 上海交通大学, 2017.

[本文引用: 1]

TIAN Dong. Design and implementation of deep learning algorithm based on convolutional neural network [D]. Shanghai: Shanghai Jiao Tong University, 2017.

[本文引用: 1]

[5]

王昌安. 遥感影像中的近岸舰船目标检测和细粒度识别方法研究[D]. 武汉: 华中科技大学, 2019.

[本文引用: 1]

WANG Changan. Detection and fine-grained recognition of inshore ships on optical remote sensing images [D]. Wuhan: Huazhong University of Science and Technology, 2019.

[本文引用: 1]

[6]

KRIZHEVSKY A, SUTSKEVER I, HINTON G E Imagenet classification with deep convolutional neural networks

[J]. Advances in Neural Information Processing Systems , 2017 , 60 (6 ): 84 - 90

[本文引用: 1]

[7]

高云龙, 任明, 吴川, 等. 基于注意力机制改进的无锚框SAR图像舰船检测模型[EB/OL]. [2024-10-10]. https://doi.org/10.13229/ j.cnki.jdxbgxb20221367.

[本文引用: 1]

[8]

YASIR M, LIU Shanwei, XU Mingming, et al. Multi scale ship target detection using SAR images based on improved Yolov5

[J]. Frontiers in Marine Science , 2023 , 9 : 2296 - 7745

[本文引用: 1]

[9]

富强, 杨威, 陈杰, 等 基于YOLOv5的近岸SAR舰船目标检测方法

[J]. 上海航天(中英文) , 2022 , 39 (3 ): 67 - 76

[本文引用: 1]

FU Qiang, YANG Wei, CHEN Jie, et al Detection method for nearshore SAR ship images based on YOLOv5

[J]. Aerospace Shanghai (Chinese and English) , 2022 , 39 (3 ): 67 - 76

[本文引用: 1]

[10]

HU J, SHEN L, SUN G. Squeeze-and-excitation networks [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132-7141.

[本文引用: 1]

[11]

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module [C]// European Conference on Computer Vision . Munich: Springer, 2018: 3-19.

[本文引用: 1]

[12]

HE Yishan, GAO Fei, WANG Jun, et al Learning polar encodings for arbitrary-oriented ship detection in SAR images

[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing , 2021 , 14 : 3846 - 3859

DOI:10.1109/JSTARS.2021.3068530

[本文引用: 1]

[13]

SUN Yuanrui, SUN Xian, WANG Zhirui, et al Oriented ship detection based on strong scattering points network in large-scale SAR images

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2022 , 60 : 1 - 18

[本文引用: 1]

[14]

徐丰, 王海鹏, 金亚秋. 合成孔径雷达图像智能解译[M]. 北京: 科学出版社, 2020: 143-167.

[本文引用: 1]

[15]

OUYANG Daliang, HE Su, ZHANG Guozhong, et al. Efficient multi-scale attention module with cross-spatial learning [C]// International Conference on Acoustics . Rhodes Island: IEEE, 2023: 1-5.

[本文引用: 1]

[16]

YANG Xue, YAN Junchi On the arbitrary-oriented object detection: classification based approaches revisited

[J]. International Journal of Computer Vision , 2022 , 130 (5 ): 1340 - 1365

DOI:10.1007/s11263-022-01593-w

[本文引用: 1]

[17]

徐从安, 苏航, 李健伟, 等 RSDD-SAR: SAR舰船斜框检测数据集

[J]. 雷达学报 , 2022 , 11 (4 ): 581 - 599

DOI:10.12000/JR22007

[本文引用: 1]

XU Congan, SU Hang, LI Jianwei, et al RSDD-SAR: rotated ship detection dataset in SAR images

[J]. Journal of Radars , 2022 , 11 (4 ): 581 - 599

DOI:10.12000/JR22007

[本文引用: 1]

[18]

ZHANG Tianwen, ZHANG Xiaoling, LI Jianwei, et al SAR ship detection dataset (SSDD): official release and comprehensive data analysis

[J]. Remote Sensing , 2021 , 13 (18 ): 3690

DOI:10.3390/rs13183690

[本文引用: 2]

[19]

TIAN Zhi, SHEN Chunhua, CHEN Hao, et al. FCOS: fully convolutional one-stage object detection [C]// IEEE/CVF International Conference on Computer Vision . Seoul: IEEE, 2019: 9626-9635.

[本文引用: 1]

[20]

YI Jingru, WU Pengxiang, LIU Bo, et al. Oriented object detection in aerial images with box boundary-aware vectors [C]// IEEE Winter Conference on Applications of Computer Vision . Waikoloa: IEEE, 2021: 2149-2158.

[本文引用: 1]

[21]

XIE Xingxing, CHENG Gong, WANG Jiabao, et al. Oriented R-CNN for object detection [C]// IEEE/CVF International Conference on Computer Vision . Montreal: IEEE, 2021: 3520-3529.

[本文引用: 1]

[22]

WAN Huiyao, CHEN Jie, HUANG Zhixiang, et al. Orientation detector for ship targets in SAR images based on semantic flow feature alignment and Gaussian label matching [J] IEEE Transactions on Geoscience and Remote Sensing , 2023, 61: 1-16.

[本文引用: 1]

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

精确打击体系智能化的发展

1

2023

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

精确打击体系智能化的发展

1

2023

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

Imagenet classification with deep convolutional neural networks

1

2017

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

Multi scale ship target detection using SAR images based on improved Yolov5

1

2023

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

基于YOLOv5的近岸SAR舰船目标检测方法

1

2022

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

基于YOLOv5的近岸SAR舰船目标检测方法

1

2022

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

Learning polar encodings for arbitrary-oriented ship detection in SAR images

1

2021

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

Oriented ship detection based on strong scattering points network in large-scale SAR images

1

2022

... SAR图像传统检测方法主要基于图像处理和手工提取特征进行浅层学习来实现[1 ] ,在处理大规模数据量时效率较低. 在复杂战场环境中,将智能算法应用于目标检测,能够有效地对各类目标进行精准打击[2 ] . 为了避免图像预处理、目标鉴别的中间步骤[3 ] ,直接通过逐层学习和自主提取特征[4 ] 的方法从原始图像中获取更多的目标信息,使得目标检测算法应对复杂场景问题时具有良好的鲁棒性[5 ] ,深度学习[6 ] 中的卷积神经网络开始得到重视. 高云龙等[7 ] 在YOLO模型中添加空洞注意力模块来强化特征表示能力,取得了检测精度和检测速度的平衡. Yasir等[8 ] 在YOLOv5的基础上增加C3架构和注意力机制,在多种数据集上均取得了较好的检测结果. 由于SAR图像的舰船方向任意且多为细长型目标,水平框在近岸场景下易引入背景杂波,导致目标漏检、误检. 为了应对这一难题,研究人员开始采用基于定向边界框的方法描述舰船的轮廓. 富强等[9 ] 在YOLOv5网络的各层增加了SENet[10 ] 和CBAM[11 ] 注意力模块,改进SAR近岸目标检测的精度. He等[12 ] 使用极坐标编码检测SAR船舶,解决斜框回归的边界不连续问题. Sun等[13 ] 提取SAR图像中的强散射点并聚合为船舶的旋转框,设计嵌入向量模块有效捕获目标多尺度信息,以提高定位精度. ...

1

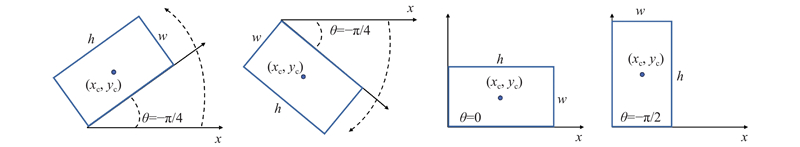

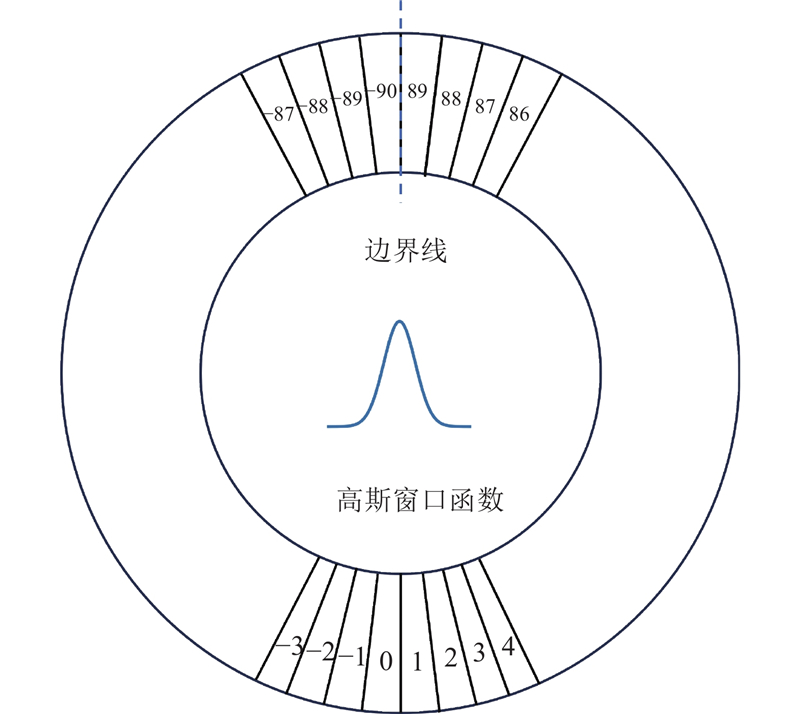

... 在SAR图像大视场下,小目标边缘模糊使得模型难以获得目标区域的有效特征表征[14 ] ,现有的大多算法对小尺寸目标信息利用不充分,任意方向舰船旋转角度的预测仍有一定的误差,小目标仍有一些漏检情况,在融合多层级特征方面仍有提升空间. 针对常规特征提取方法无法准确学习SAR图像舰船小目标特征这一实际问题,本文从便于推广部署通用化研究出发,以技术较成熟、应用广泛的YOLOv5模型为基础进行改进,在网络颈部添加小目标检测层,引入EMA注意力机制[15 ] . 基于定向框的有向检测部分将角度预测转化为角度分类,采用圆平滑标签方法[16 ] 对角度进行平滑处理,使得角度预测更准确. 实验结果表明,本文提出的ES-YOLOv5算法在RSDD-SAR数据集[17 ] 上相较于原始模型,检测精度有较明显的提升. ...

1

... 在SAR图像大视场下,小目标边缘模糊使得模型难以获得目标区域的有效特征表征[14 ] ,现有的大多算法对小尺寸目标信息利用不充分,任意方向舰船旋转角度的预测仍有一定的误差,小目标仍有一些漏检情况,在融合多层级特征方面仍有提升空间. 针对常规特征提取方法无法准确学习SAR图像舰船小目标特征这一实际问题,本文从便于推广部署通用化研究出发,以技术较成熟、应用广泛的YOLOv5模型为基础进行改进,在网络颈部添加小目标检测层,引入EMA注意力机制[15 ] . 基于定向框的有向检测部分将角度预测转化为角度分类,采用圆平滑标签方法[16 ] 对角度进行平滑处理,使得角度预测更准确. 实验结果表明,本文提出的ES-YOLOv5算法在RSDD-SAR数据集[17 ] 上相较于原始模型,检测精度有较明显的提升. ...

On the arbitrary-oriented object detection: classification based approaches revisited

1

2022

... 在SAR图像大视场下,小目标边缘模糊使得模型难以获得目标区域的有效特征表征[14 ] ,现有的大多算法对小尺寸目标信息利用不充分,任意方向舰船旋转角度的预测仍有一定的误差,小目标仍有一些漏检情况,在融合多层级特征方面仍有提升空间. 针对常规特征提取方法无法准确学习SAR图像舰船小目标特征这一实际问题,本文从便于推广部署通用化研究出发,以技术较成熟、应用广泛的YOLOv5模型为基础进行改进,在网络颈部添加小目标检测层,引入EMA注意力机制[15 ] . 基于定向框的有向检测部分将角度预测转化为角度分类,采用圆平滑标签方法[16 ] 对角度进行平滑处理,使得角度预测更准确. 实验结果表明,本文提出的ES-YOLOv5算法在RSDD-SAR数据集[17 ] 上相较于原始模型,检测精度有较明显的提升. ...

RSDD-SAR: SAR舰船斜框检测数据集

1

2022

... 在SAR图像大视场下,小目标边缘模糊使得模型难以获得目标区域的有效特征表征[14 ] ,现有的大多算法对小尺寸目标信息利用不充分,任意方向舰船旋转角度的预测仍有一定的误差,小目标仍有一些漏检情况,在融合多层级特征方面仍有提升空间. 针对常规特征提取方法无法准确学习SAR图像舰船小目标特征这一实际问题,本文从便于推广部署通用化研究出发,以技术较成熟、应用广泛的YOLOv5模型为基础进行改进,在网络颈部添加小目标检测层,引入EMA注意力机制[15 ] . 基于定向框的有向检测部分将角度预测转化为角度分类,采用圆平滑标签方法[16 ] 对角度进行平滑处理,使得角度预测更准确. 实验结果表明,本文提出的ES-YOLOv5算法在RSDD-SAR数据集[17 ] 上相较于原始模型,检测精度有较明显的提升. ...

RSDD-SAR: SAR舰船斜框检测数据集

1

2022

... 在SAR图像大视场下,小目标边缘模糊使得模型难以获得目标区域的有效特征表征[14 ] ,现有的大多算法对小尺寸目标信息利用不充分,任意方向舰船旋转角度的预测仍有一定的误差,小目标仍有一些漏检情况,在融合多层级特征方面仍有提升空间. 针对常规特征提取方法无法准确学习SAR图像舰船小目标特征这一实际问题,本文从便于推广部署通用化研究出发,以技术较成熟、应用广泛的YOLOv5模型为基础进行改进,在网络颈部添加小目标检测层,引入EMA注意力机制[15 ] . 基于定向框的有向检测部分将角度预测转化为角度分类,采用圆平滑标签方法[16 ] 对角度进行平滑处理,使得角度预测更准确. 实验结果表明,本文提出的ES-YOLOv5算法在RSDD-SAR数据集[17 ] 上相较于原始模型,检测精度有较明显的提升. ...

SAR ship detection dataset (SSDD): official release and comprehensive data analysis

2

2021

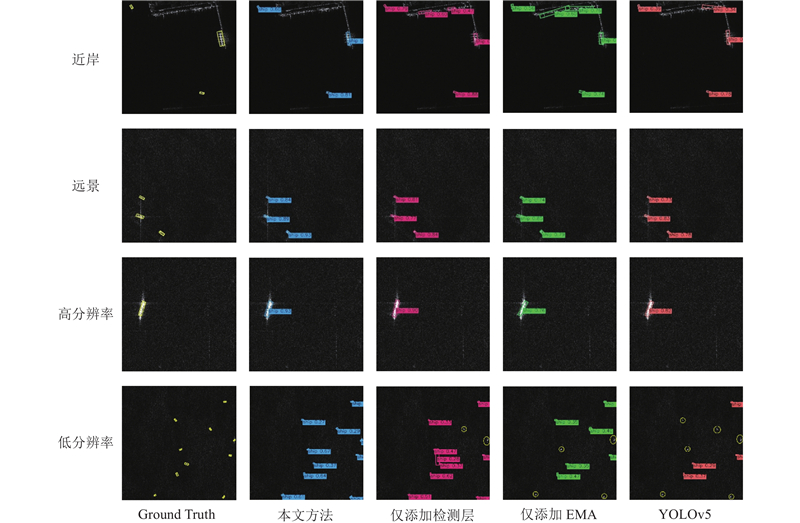

... 根据文献[18 ],采用针对RSDD-SAR数据集的目标划分方法:尺寸小于625的舰船目标被归为小目标,目标面积为625~7 500的视为中目标,其余被看作大目标. 在SAR图像中,大部分舰船目标都属于小目标范畴,特征较模糊复杂,对模型准确学习和识别目标带来一定的挑战. 通过给网络添加小目标检测层,网络结构得到了优化. 引入的注意力机制增强了模型对重要信息的关注程度,提升了检测性能. 通过将两者融合,新网络改善了SAR图像小目标检测的准确性和鲁棒性. ...

... RSDD-SAR数据集包含不同的成像方式和多种极化方式,分辨率为3~25 m. 图像切片尺寸为$512 \times 512$ 18 ]的划分范围可知,RSDD-SAR数据集的小目标所占比例为59.88%,中目标所占比例为40.04%,几乎没有大目标. 由于小目标的比例显著,该数据集较适合用于提出的算法进行实验. ...

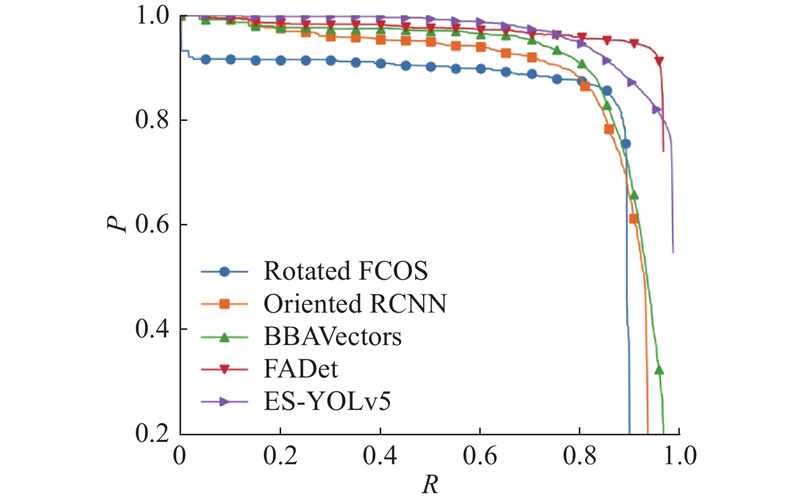

1

... 为了验证提出算法的检测效果,在保证算法训练数据集相同的条件下,与表4 的先进方法进行比较,对应的P-R 曲线如图5 所示. 其中,Rotated FCOS[19 ] 和BBAVectors[20 ] 均采用无锚框方法,Oriented RCNN[21 ] 、FADet[22 ] 和本文方法均采用预设锚框. 表4 中,加粗部分表示最优结果. 从表4 可知,本文方法的准确率和召回率虽然没有FADet方法高,但${\mathrm{A}}{{\mathrm{P}}_{50}}$

1

... 为了验证提出算法的检测效果,在保证算法训练数据集相同的条件下,与表4 的先进方法进行比较,对应的P-R 曲线如图5 所示. 其中,Rotated FCOS[19 ] 和BBAVectors[20 ] 均采用无锚框方法,Oriented RCNN[21 ] 、FADet[22 ] 和本文方法均采用预设锚框. 表4 中,加粗部分表示最优结果. 从表4 可知,本文方法的准确率和召回率虽然没有FADet方法高,但${\mathrm{A}}{{\mathrm{P}}_{50}}$

1

... 为了验证提出算法的检测效果,在保证算法训练数据集相同的条件下,与表4 的先进方法进行比较,对应的P-R 曲线如图5 所示. 其中,Rotated FCOS[19 ] 和BBAVectors[20 ] 均采用无锚框方法,Oriented RCNN[21 ] 、FADet[22 ] 和本文方法均采用预设锚框. 表4 中,加粗部分表示最优结果. 从表4 可知,本文方法的准确率和召回率虽然没有FADet方法高,但${\mathrm{A}}{{\mathrm{P}}_{50}}$

1

... 为了验证提出算法的检测效果,在保证算法训练数据集相同的条件下,与表4 的先进方法进行比较,对应的P-R 曲线如图5 所示. 其中,Rotated FCOS[19 ] 和BBAVectors[20 ] 均采用无锚框方法,Oriented RCNN[21 ] 、FADet[22 ] 和本文方法均采用预设锚框. 表4 中,加粗部分表示最优结果. 从表4 可知,本文方法的准确率和召回率虽然没有FADet方法高,但${\mathrm{A}}{{\mathrm{P}}_{50}}$