[1]

CHEN H, PANG Y, HU Q, et al Solar cell surface defect inspection based on multispectral convolutional neural network

[J]. Journal of Intelligent Manufacturing , 2020 , 31 (2 ): 453 - 468

DOI:10.1007/s10845-018-1458-z

[本文引用: 1]

[2]

SU B, CHEN H, LIU K, et al RCAG-Net: residual channel-wise attention gate network for hot spot defect detection of photovoltaic farms

[J]. IEEE Transactions on Instrumentation and Measurement , 2021 , 70 : 1 - 14

[本文引用: 1]

[3]

YU J, ZHENG X, LIU J Stacked convolutional sparse denoising auto-encoder for identification of defect patterns in semiconductor wafer map

[J]. Computers in Industry , 2019 , 109 : 121 - 133

DOI:10.1016/j.compind.2019.04.015

[本文引用: 1]

[4]

MIAO R, GAO Y, GE L, et al Online defect recognition of narrow overlap weld based on two-stage recognition model combining continuous wavelet transform and convolutional neural network

[J]. Computers in Industry , 2019 , 112 : 103115 - 103125

DOI:10.1016/j.compind.2019.07.005

[本文引用: 1]

[5]

LI D, XIE Q, GONG X, et al Automatic defect detection of metro tunnel surfaces using a vision-based inspection system

[J]. Advanced Engineering Informatics , 2021 , 47 : 101206 - 101217

DOI:10.1016/j.aei.2020.101206

[本文引用: 1]

[6]

LI L, GAO K, CAO J, et al. Progressive domain expansion network for single domain generalization [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . [s. l.]: IEEE, 2021: 224−233.

[本文引用: 1]

[7]

RAHMAN M M, FOOKES C, BAKTASHMOTLAGH M, et al. Multi-component image translation for deep domain generalization [C]// 2019 IEEE Winter Conference on Applications of Computer Vision . Waikoloa: IEEE, 2019: 579−588.

[8]

WANG Z, LUO Y, QIU R, et al. Learning to diversify for single domain generalization [C]// IEEE/CVF International Conference on Computer Vision . [s. l.]: IEEE, 2021: 834-843.

[9]

ZHOU K, YANG Y, HOSPEDALES T, et al. Learning to generate novel domains for domain generalization [C]// European conference on computer vision . Glasgow: Springer, 2020: 561−578.

[10]

FAN X, WANG Q, KE J, et al. Adversarially adaptive normalization for single domain generalization [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . [s. l.]: IEEE, 2021: 8208−8217.

[本文引用: 1]

[11]

WANG H, LI Z, WANG H Few-shot steel surface defect detection

[J]. IEEE Transactions on Instrumentation and Measurement , 2021 , 71 : 1 - 12

[本文引用: 1]

[12]

DUAN G, SONG Y, LIU Z, et al Cross-domain few-shot defect recognition for metal surfaces

[J]. Measurement Science and Technology , 2022 , 34 (1 ): 015202

[本文引用: 1]

[13]

CHEN C, LI J, HAN X, et al. Compound domain generalization via meta-knowledge encoding [C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition . New Orleans: IEEE, 2022: 7119−7129.

[本文引用: 8]

[14]

SHIAU Z Y, LIN W W, LIN C S, et al. Meta-learned feature critics for domain generalized semantic segmentation [C]// IEEE International Conference on Image Processing . Anchorage: IEEE, 2021: 2244-2248.

[15]

PAN X, LUO P, SHI J, et al. Two at once: enhancing learning and generalization capacities via ibn-net [C]// European Conference on Computer Vision . Munich: Springer, 2018: 464−479.

[16]

ZHOU K, YANG Y, CAVALLARO A, et al. Omni-scale feature learning for person re-identification [C]// IEEE/CVF International Conference on Computer Vision . Seoul: IEEE, 2019: 3702−3712.

[本文引用: 8]

[17]

XIE T, HUANG X, CHOI S K Metric-based meta-learning for cross-domain few-shot identification of welding defect

[J]. Journal of Computing and Information Science in Engineering , 2023 , 23 (3 ): 030902

DOI:10.1115/1.4056219

[本文引用: 8]

[18]

ZHOW Z, LAN C, GAO Z. Cross-domain defect detection network [C]// 2022 Asia Conference on Algorithms, Computing and Machine Learning . Hangzhou: IEEE, 2022: 272−279.

[本文引用: 1]

[19]

MA S, SONG K, NIU M, et al Cross-scale fusion and domain adversarial network for generalizable rail surface defect segmentation on unseen datasets

[J]. Journal of Intelligent Manufacturing , 2022 , 27 : 1 - 20

[本文引用: 1]

[20]

NAM H, KIM H E. Batch-instance normalization for adaptively style-invariant neural networks [C]// Proceedings of the 32nd International Conference on Neural Information Processing Systems . Montréal: IEEE, 2018: 2563−2572.

[本文引用: 2]

[21]

JIN X, LAN C, ZENG W, et al Style normalization and restitution for domain generalization and adaptation

[J]. IEEE Transactions on Multimedia , 2021 , 24 : 3636 - 3651

[本文引用: 1]

[22]

TANG Z, GAO Y, ZHU Y, et al. CrossNorm and SelfNorm for generalization under distribution shifts [C]// IEEE/CVF International Conference on Computer Vision . [s. l.]: IEEE, 2021: 52−61.

[本文引用: 1]

[23]

HUANG X, BELONGIE S. Arbitrary style transfer in real-time with adaptive instance normalization [C]// IEEE International Conference on Computer Vision . Venice: IEEE, 2017: 1501−1510.

[本文引用: 1]

[24]

WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition . Vancouver: IEEE, 2023: 7464−7475.

[本文引用: 4]

[25]

REN S, HE K, GIRSHICK R, et al Faster R-CNN: towards real-time object detection with region proposal networks

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2017 , 39 (6 ): 1137 - 1149

DOI:10.1109/TPAMI.2016.2577031

[本文引用: 4]

Solar cell surface defect inspection based on multispectral convolutional neural network

1

2020

... 近年来,基于深度学习的工业缺陷识别方法被不断提出. Chen等[1 ] 提出用于光伏电池表面缺陷分类的多光谱深度卷积神经网络. Su等[2 ] 提出RCAG-Net模型,通过注意力机制提高光伏电池缺陷分类的性能. Yu等[3 ] 提出用于晶圆表面缺陷识别的堆叠卷积稀疏降噪自动编码器. Miao等[4 ] 提出将连续小波变换与卷积神经网络相结合的焊缝缺陷检测模型. Li等[5 ] 提出多层特征融合模块,提升深度检测模型对地铁隧道面缺陷的检测能力. ...

RCAG-Net: residual channel-wise attention gate network for hot spot defect detection of photovoltaic farms

1

2021

... 近年来,基于深度学习的工业缺陷识别方法被不断提出. Chen等[1 ] 提出用于光伏电池表面缺陷分类的多光谱深度卷积神经网络. Su等[2 ] 提出RCAG-Net模型,通过注意力机制提高光伏电池缺陷分类的性能. Yu等[3 ] 提出用于晶圆表面缺陷识别的堆叠卷积稀疏降噪自动编码器. Miao等[4 ] 提出将连续小波变换与卷积神经网络相结合的焊缝缺陷检测模型. Li等[5 ] 提出多层特征融合模块,提升深度检测模型对地铁隧道面缺陷的检测能力. ...

Stacked convolutional sparse denoising auto-encoder for identification of defect patterns in semiconductor wafer map

1

2019

... 近年来,基于深度学习的工业缺陷识别方法被不断提出. Chen等[1 ] 提出用于光伏电池表面缺陷分类的多光谱深度卷积神经网络. Su等[2 ] 提出RCAG-Net模型,通过注意力机制提高光伏电池缺陷分类的性能. Yu等[3 ] 提出用于晶圆表面缺陷识别的堆叠卷积稀疏降噪自动编码器. Miao等[4 ] 提出将连续小波变换与卷积神经网络相结合的焊缝缺陷检测模型. Li等[5 ] 提出多层特征融合模块,提升深度检测模型对地铁隧道面缺陷的检测能力. ...

Online defect recognition of narrow overlap weld based on two-stage recognition model combining continuous wavelet transform and convolutional neural network

1

2019

... 近年来,基于深度学习的工业缺陷识别方法被不断提出. Chen等[1 ] 提出用于光伏电池表面缺陷分类的多光谱深度卷积神经网络. Su等[2 ] 提出RCAG-Net模型,通过注意力机制提高光伏电池缺陷分类的性能. Yu等[3 ] 提出用于晶圆表面缺陷识别的堆叠卷积稀疏降噪自动编码器. Miao等[4 ] 提出将连续小波变换与卷积神经网络相结合的焊缝缺陷检测模型. Li等[5 ] 提出多层特征融合模块,提升深度检测模型对地铁隧道面缺陷的检测能力. ...

Automatic defect detection of metro tunnel surfaces using a vision-based inspection system

1

2021

... 近年来,基于深度学习的工业缺陷识别方法被不断提出. Chen等[1 ] 提出用于光伏电池表面缺陷分类的多光谱深度卷积神经网络. Su等[2 ] 提出RCAG-Net模型,通过注意力机制提高光伏电池缺陷分类的性能. Yu等[3 ] 提出用于晶圆表面缺陷识别的堆叠卷积稀疏降噪自动编码器. Miao等[4 ] 提出将连续小波变换与卷积神经网络相结合的焊缝缺陷检测模型. Li等[5 ] 提出多层特征融合模块,提升深度检测模型对地铁隧道面缺陷的检测能力. ...

1

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

1

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

Few-shot steel surface defect detection

1

2021

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

Cross-domain few-shot defect recognition for metal surfaces

1

2022

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

8

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

... 为了验证所提出方法的有效性,分别以YOLOv7和Faster-RCNN这2个检测框架为基线1和基线2,利用不同场景的光伏电池缺陷数据集进行实验,并将所提方法与域泛化方法(实例级归一化(IN)[13 ] 、SNR[16 ] 和CNSN[17 ] )做比较. 在每个检测框架下设计6组实验,分别为SEL_1$ \Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $ \Rightarrow $ 表1 、2 所示. 定义后文中的跨场景平均mAP为该方法在6组跨场景实验情况下的mAP均值. ...

... Statistical performance results for different scenarios and different detectors on YOLOv7

% Tab.1 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 72.63 77.65 86.32 62.16 74.69 18.02 56.59 71.00 30.97 44.14 IN[13 ] 79.25 75.86 84.19 71.22 77.63 47.08 67.83 71.46 41.25 56.91 SNR[16 ] 88.84 88.36 87.02 60.06 81.07 37.17 70.74 77.42 50.68 59.00 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 73.10 83.49 62.63 47.62 66.71 FF-FDDG 91.20 89.54 87.34 78.03 86.53 78.72 90.32 71.69 56.69 74.36 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 86.22 76.66 81.62 74.74 79.81 84.70 81.90 87.33 66.63 80.14 IN[13 ] 95.04 82.55 85.50 69.18 83.07 93.23 79.32 90.31 72.38 83.81 SNR[16 ] 93.52 79.90 82.53 72.86 82.20 91.50 85.79 91.79 73.87 85.74 CNSN[17 ] 80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57

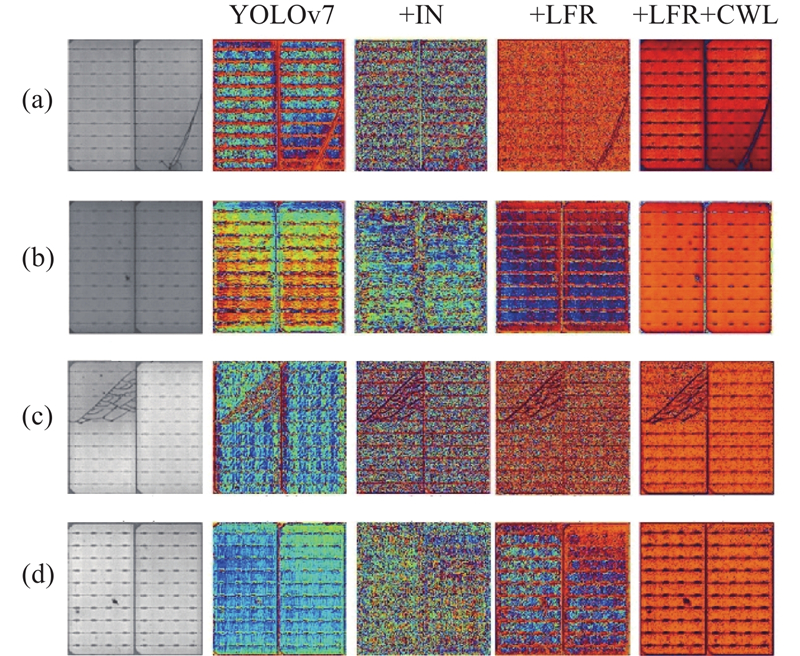

由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

13 ]

95.04 82.55 85.50 69.18 83.07 93.23 79.32 90.31 72.38 83.81 SNR[16 ] 93.52 79.90 82.53 72.86 82.20 91.50 85.79 91.79 73.87 85.74 CNSN[17 ] 80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

13 ]

92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... Statistical performance results for different scenarios and different detectors on Faster-RCNN

% Tab.2 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 84.92 86.23 61.37 12.25 61.19 49.95 82.75 74.94 18.72 55.59 IN[13 ] 86.03 86.35 64.19 15.12 62.92 85.19 85.49 63.96 16.42 62.77 SNR[16 ] 89.73 86.18 65.85 18.03 64.95 93.32 81.03 63.72 15.16 63.31 CNSN[17 ] 79.66 85.46 63.61 18.63 61.84 78.90 81.22 62.78 19.28 60.55 FF-FDDG 89.93 87.54 69.56 18.22 66.31 91.88 80.53 69.11 20.15 65.42 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 87.97 76.44 63.13 15.12 60.67 86.63 76.75 64.92 12.12 60.11 IN[13 ] 87.52 82.04 59.78 15.46 61.20 91.52 79.12 67.51 16.59 63.69 SNR[16 ] 90.10 84.04 61.56 14.39 62.52 91.19 72.64 66.42 13.59 60.96 CNSN[17 ] 82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54

2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

13 ]

87.52 82.04 59.78 15.46 61.20 91.52 79.12 67.51 16.59 63.69 SNR[16 ] 90.10 84.04 61.56 14.39 62.52 91.19 72.64 66.42 13.59 60.96 CNSN[17 ] 82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

13 ]

91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

8

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

... 为了验证所提出方法的有效性,分别以YOLOv7和Faster-RCNN这2个检测框架为基线1和基线2,利用不同场景的光伏电池缺陷数据集进行实验,并将所提方法与域泛化方法(实例级归一化(IN)[13 ] 、SNR[16 ] 和CNSN[17 ] )做比较. 在每个检测框架下设计6组实验,分别为SEL_1$ \Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $ \Rightarrow $ 表1 、2 所示. 定义后文中的跨场景平均mAP为该方法在6组跨场景实验情况下的mAP均值. ...

... Statistical performance results for different scenarios and different detectors on YOLOv7

% Tab.1 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 72.63 77.65 86.32 62.16 74.69 18.02 56.59 71.00 30.97 44.14 IN[13 ] 79.25 75.86 84.19 71.22 77.63 47.08 67.83 71.46 41.25 56.91 SNR[16 ] 88.84 88.36 87.02 60.06 81.07 37.17 70.74 77.42 50.68 59.00 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 73.10 83.49 62.63 47.62 66.71 FF-FDDG 91.20 89.54 87.34 78.03 86.53 78.72 90.32 71.69 56.69 74.36 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 86.22 76.66 81.62 74.74 79.81 84.70 81.90 87.33 66.63 80.14 IN[13 ] 95.04 82.55 85.50 69.18 83.07 93.23 79.32 90.31 72.38 83.81 SNR[16 ] 93.52 79.90 82.53 72.86 82.20 91.50 85.79 91.79 73.87 85.74 CNSN[17 ] 80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57

由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

16 ]

93.52 79.90 82.53 72.86 82.20 91.50 85.79 91.79 73.87 85.74 CNSN[17 ] 80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

16 ]

92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... Statistical performance results for different scenarios and different detectors on Faster-RCNN

% Tab.2 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 84.92 86.23 61.37 12.25 61.19 49.95 82.75 74.94 18.72 55.59 IN[13 ] 86.03 86.35 64.19 15.12 62.92 85.19 85.49 63.96 16.42 62.77 SNR[16 ] 89.73 86.18 65.85 18.03 64.95 93.32 81.03 63.72 15.16 63.31 CNSN[17 ] 79.66 85.46 63.61 18.63 61.84 78.90 81.22 62.78 19.28 60.55 FF-FDDG 89.93 87.54 69.56 18.22 66.31 91.88 80.53 69.11 20.15 65.42 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 87.97 76.44 63.13 15.12 60.67 86.63 76.75 64.92 12.12 60.11 IN[13 ] 87.52 82.04 59.78 15.46 61.20 91.52 79.12 67.51 16.59 63.69 SNR[16 ] 90.10 84.04 61.56 14.39 62.52 91.19 72.64 66.42 13.59 60.96 CNSN[17 ] 82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54

2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

16 ]

90.10 84.04 61.56 14.39 62.52 91.19 72.64 66.42 13.59 60.96 CNSN[17 ] 82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

16 ]

90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

Metric-based meta-learning for cross-domain few-shot identification of welding defect

8

2023

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

... 为了验证所提出方法的有效性,分别以YOLOv7和Faster-RCNN这2个检测框架为基线1和基线2,利用不同场景的光伏电池缺陷数据集进行实验,并将所提方法与域泛化方法(实例级归一化(IN)[13 ] 、SNR[16 ] 和CNSN[17 ] )做比较. 在每个检测框架下设计6组实验,分别为SEL_1$ \Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $\Rightarrow $ $ \Rightarrow $ 表1 、2 所示. 定义后文中的跨场景平均mAP为该方法在6组跨场景实验情况下的mAP均值. ...

... Statistical performance results for different scenarios and different detectors on YOLOv7

% Tab.1 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 72.63 77.65 86.32 62.16 74.69 18.02 56.59 71.00 30.97 44.14 IN[13 ] 79.25 75.86 84.19 71.22 77.63 47.08 67.83 71.46 41.25 56.91 SNR[16 ] 88.84 88.36 87.02 60.06 81.07 37.17 70.74 77.42 50.68 59.00 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 73.10 83.49 62.63 47.62 66.71 FF-FDDG 91.20 89.54 87.34 78.03 86.53 78.72 90.32 71.69 56.69 74.36 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 86.22 76.66 81.62 74.74 79.81 84.70 81.90 87.33 66.63 80.14 IN[13 ] 95.04 82.55 85.50 69.18 83.07 93.23 79.32 90.31 72.38 83.81 SNR[16 ] 93.52 79.90 82.53 72.86 82.20 91.50 85.79 91.79 73.87 85.74 CNSN[17 ] 80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57

由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

17 ]

80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

17 ]

70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... Statistical performance results for different scenarios and different detectors on Faster-RCNN

% Tab.2 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 84.92 86.23 61.37 12.25 61.19 49.95 82.75 74.94 18.72 55.59 IN[13 ] 86.03 86.35 64.19 15.12 62.92 85.19 85.49 63.96 16.42 62.77 SNR[16 ] 89.73 86.18 65.85 18.03 64.95 93.32 81.03 63.72 15.16 63.31 CNSN[17 ] 79.66 85.46 63.61 18.63 61.84 78.90 81.22 62.78 19.28 60.55 FF-FDDG 89.93 87.54 69.56 18.22 66.31 91.88 80.53 69.11 20.15 65.42 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 87.97 76.44 63.13 15.12 60.67 86.63 76.75 64.92 12.12 60.11 IN[13 ] 87.52 82.04 59.78 15.46 61.20 91.52 79.12 67.51 16.59 63.69 SNR[16 ] 90.10 84.04 61.56 14.39 62.52 91.19 72.64 66.42 13.59 60.96 CNSN[17 ] 82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54

2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

17 ]

82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

17 ]

51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

1

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

Cross-scale fusion and domain adversarial network for generalizable rail surface defect segmentation on unseen datasets

1

2022

... 目前,高度依赖大规模高质量标注数据的深度缺陷识别方法在封闭场景下取得了良好的效果,但在跨场景情况下,某一场景数据训练的深度模型无法应用在其他场景. 域泛化方法通过提升模型的泛化能力,使某一场景数据训练的深度模型广泛应用到多种场景中. 基于数据操作的域泛化方法[6 -10 ] 旨在生成多种不同风格样式的数据,使训练阶段的数据多样化和丰富化,从而提升模型的泛化能力. 在基于数据操作的域泛化缺陷识别方法中,Wang等[11 ] 通过使用与目标任务相关的数据对模型进行预训练,并在微调阶段设计噪声正则化策略从而提升缺陷检测的泛化性能. Duan等[12 ] 在数据层面通过原始域和增强域联合更新参数,并在特征层面增加扰动,来提高每个元任务中缺陷识别的泛化能力. 基于特征学习的域泛化方法[13 -16 ] 则是通过减少不同样式数据间的差异,使学习到的模型能够对看不见的域具有泛化的能力. 在特征学习的域泛化缺陷识别方法中, Xie等[17 ] 通过减少由不同材料引起的域偏移的影响,提高模型对射焊接缺陷识别的性能. Zhou等[18 ] 通过集成分割网络和分类网络的2阶段跨域缺陷检测网络挖掘跨域数据中隐藏的价值,从而提升模型对工业产品表面缺陷识别的性能. Ma等[19 ] 设计双编码器从不同分辨率的图像中提取多尺度特征并将这些特征通过跨尺度融合模块进行自适应融合,缓解由跨场景轨道外观不一致引起的域偏移问题. ...

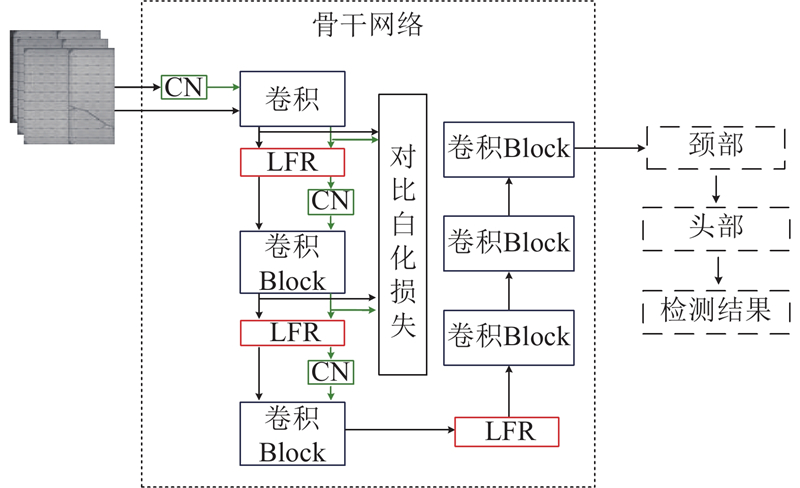

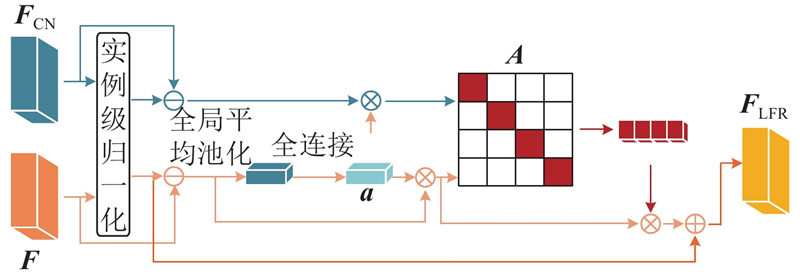

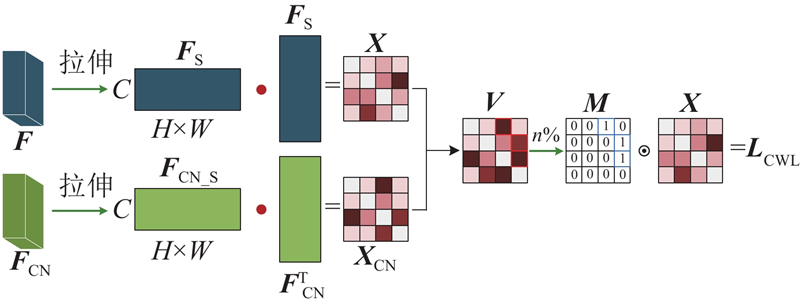

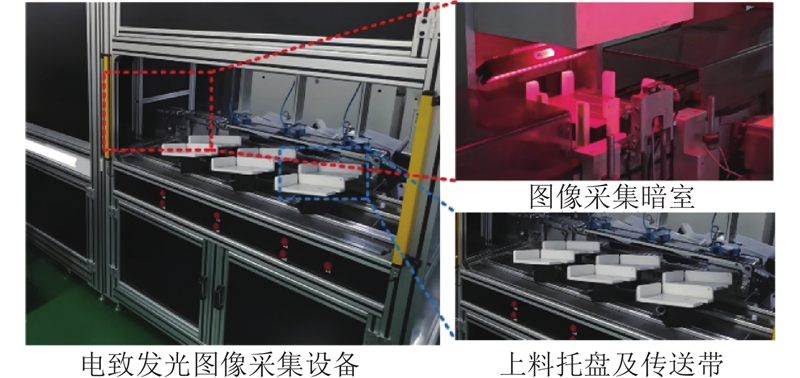

2

... 在以实例级归一化(instance normalization, IN) 为代表的基于特征学习的域泛化方法中,Nam等[20 ] 在保证模型泛化能力的同时,通过选择性地使用批归一化和实例级归一化来提升模型对任务特征的把握. Jin等[21 ] 提出风格归一化和恢复模块,利用通道注意力从残差中提取与任务相关的鉴别特征,确保网络对行人重识别任务的识别性. Tang等[22 ] 先进行特征级风格扩充,而后重新校准统计数据来弥合训练分布和测试分布之间的差距,提升模型泛化能力. ...

... 特征级风格调换模块[20 ] 的表达式如下: ...

Style normalization and restitution for domain generalization and adaptation

1

2021

... 在以实例级归一化(instance normalization, IN) 为代表的基于特征学习的域泛化方法中,Nam等[20 ] 在保证模型泛化能力的同时,通过选择性地使用批归一化和实例级归一化来提升模型对任务特征的把握. Jin等[21 ] 提出风格归一化和恢复模块,利用通道注意力从残差中提取与任务相关的鉴别特征,确保网络对行人重识别任务的识别性. Tang等[22 ] 先进行特征级风格扩充,而后重新校准统计数据来弥合训练分布和测试分布之间的差距,提升模型泛化能力. ...

1

... 在以实例级归一化(instance normalization, IN) 为代表的基于特征学习的域泛化方法中,Nam等[20 ] 在保证模型泛化能力的同时,通过选择性地使用批归一化和实例级归一化来提升模型对任务特征的把握. Jin等[21 ] 提出风格归一化和恢复模块,利用通道注意力从残差中提取与任务相关的鉴别特征,确保网络对行人重识别任务的识别性. Tang等[22 ] 先进行特征级风格扩充,而后重新校准统计数据来弥合训练分布和测试分布之间的差距,提升模型泛化能力. ...

1

... 对于所提出的亮度过滤-残差模块,输入特征F F CN $ \left(\boldsymbol{F},\;{\boldsymbol{F}}_{\mathrm{C}\mathrm{N}}\in {\bf{R}}^{{C}\times{H}\times {W}}\right) $ [23 ] 初步剔除亮度带来的影响. 经过实例级归一化的结果如下: ...

4

... 实验使用的CPU为I7-11700K,GPU为NVIDIA GeForce RTX 3090O24G,操作系统为Win10,网络模型使用PyTorch框架搭建. 当检测框架为YOLOv7[24 ] 时,batch size=4,epoch=200, 根据经验设置损失函数中的λ =0.2,对比白化损失所添加到的层数N =3. 当检测框架为Faster-RCNN[25 ] 时,batch size=4,epoch=100,考虑到检测框架中骨干网络的改变, 根据经验设置损失函数中的λ =0.3,对比白化损失所添加到的层数N =2. ...

... Statistical performance results for different scenarios and different detectors on YOLOv7

% Tab.1 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 72.63 77.65 86.32 62.16 74.69 18.02 56.59 71.00 30.97 44.14 IN[13 ] 79.25 75.86 84.19 71.22 77.63 47.08 67.83 71.46 41.25 56.91 SNR[16 ] 88.84 88.36 87.02 60.06 81.07 37.17 70.74 77.42 50.68 59.00 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 73.10 83.49 62.63 47.62 66.71 FF-FDDG 91.20 89.54 87.34 78.03 86.53 78.72 90.32 71.69 56.69 74.36 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 86.22 76.66 81.62 74.74 79.81 84.70 81.90 87.33 66.63 80.14 IN[13 ] 95.04 82.55 85.50 69.18 83.07 93.23 79.32 90.31 72.38 83.81 SNR[16 ] 93.52 79.90 82.53 72.86 82.20 91.50 85.79 91.79 73.87 85.74 CNSN[17 ] 80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57

由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

24 ]

86.22 76.66 81.62 74.74 79.81 84.70 81.90 87.33 66.63 80.14 IN[13 ] 95.04 82.55 85.50 69.18 83.07 93.23 79.32 90.31 72.38 83.81 SNR[16 ] 93.52 79.90 82.53 72.86 82.20 91.50 85.79 91.79 73.87 85.74 CNSN[17 ] 80.07 72.73 62.94 56.61 68.09 77.79 74.50 85.84 65.56 75.92 FF-FDDG 94.40 86.09 89.35 80.90 87.71 92.03 95.56 90.94 81.46 90.00 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 YOLOv7[24 ] 90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

... [

24 ]

90.77 88.21 75.84 80.74 83.89 57.80 61.02 74.60 70.75 66.04 IN[13 ] 92.47 87.33 76.90 82.34 84.76 81.56 75.40 69.60 70.39 74.24 SNR[16 ] 92.85 87.32 85.11 81.14 86.61 84.73 74.94 71.07 71.37 75.53 CNSN[17 ] 70.66 76.37 77.28 80.23 76.14 78.45 68.78 58.92 52.73 64.72 FF-FDDG 92.60 89.73 82.31 83.29 86.98 88.08 78.89 75.16 72.15 78.57 由表1 可以看出,以YOLOv7为基线1的方法在跨场景情况下的平均mAP为71.45%,在基线1的基础上,实例级归一化(IN)通过降低图像亮度变化带来的影响,将跨场景情况下的平均mAP提升到76.73%;针对实例级归一化无任务性做出改进的SNR通过通道注意力从被实例级归一化滤除的特征信息中选择性地返还缺陷相关特征,在跨场景情况下的平均mAP为78.36%,相较于IN提升了1.51%;CNSN的跨场景平均mAP仅为71.29%,相较于YOLOv7下降了0.16%,可以看出,在跨场景缺陷检测任务中, 对同一实例不同特征层间的风格对调不仅不能较好地扩充特征信息,还会破坏缺陷的特征表示. FF-FDDG不仅通过亮度过滤-残差模块解决了实例级归一化无任务性对缺陷特征提取的影响,并通过改进的白化损失引导模型提取亮度不变信息,使得跨场景情况下的平均mAP提升到84.02%,相较于基线1提升了12.57%. ...

Faster R-CNN: towards real-time object detection with region proposal networks

4

2017

... 实验使用的CPU为I7-11700K,GPU为NVIDIA GeForce RTX 3090O24G,操作系统为Win10,网络模型使用PyTorch框架搭建. 当检测框架为YOLOv7[24 ] 时,batch size=4,epoch=200, 根据经验设置损失函数中的λ =0.2,对比白化损失所添加到的层数N =3. 当检测框架为Faster-RCNN[25 ] 时,batch size=4,epoch=100,考虑到检测框架中骨干网络的改变, 根据经验设置损失函数中的λ =0.3,对比白化损失所添加到的层数N =2. ...

... Statistical performance results for different scenarios and different detectors on Faster-RCNN

% Tab.2 方法 SEL_1$\Rightarrow $ SEL_1$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 84.92 86.23 61.37 12.25 61.19 49.95 82.75 74.94 18.72 55.59 IN[13 ] 86.03 86.35 64.19 15.12 62.92 85.19 85.49 63.96 16.42 62.77 SNR[16 ] 89.73 86.18 65.85 18.03 64.95 93.32 81.03 63.72 15.16 63.31 CNSN[17 ] 79.66 85.46 63.61 18.63 61.84 78.90 81.22 62.78 19.28 60.55 FF-FDDG 89.93 87.54 69.56 18.22 66.31 91.88 80.53 69.11 20.15 65.42 方法 SEL_2$\Rightarrow $ SEL_2$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 87.97 76.44 63.13 15.12 60.67 86.63 76.75 64.92 12.12 60.11 IN[13 ] 87.52 82.04 59.78 15.46 61.20 91.52 79.12 67.51 16.59 63.69 SNR[16 ] 90.10 84.04 61.56 14.39 62.52 91.19 72.64 66.42 13.59 60.96 CNSN[17 ] 82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54

2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

25 ]

87.97 76.44 63.13 15.12 60.67 86.63 76.75 64.92 12.12 60.11 IN[13 ] 87.52 82.04 59.78 15.46 61.20 91.52 79.12 67.51 16.59 63.69 SNR[16 ] 90.10 84.04 61.56 14.39 62.52 91.19 72.64 66.42 13.59 60.96 CNSN[17 ] 82.75 83.16 43.36 10.38 54.91 83.65 77.16 58.50 9.72 57.26 FF-FDDG 91.52 86.39 60.25 23.14 65.33 92.12 90.96 68.28 17.47 67.21 方法 SEL_3$\Rightarrow $ SEL_3$\Rightarrow $ AP mAP AP mAP 开焊 漏焊 碎片 隐裂 开焊 漏焊 碎片 隐裂 Faster-RCNN[25 ] 90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...

... [

25 ]

90.39 89.79 63.86 19.08 65.78 90.97 87.39 56.83 14.02 62.30 IN[13 ] 91.41 87.92 69.78 18.49 66.90 83.42 89.13 57.52 14.42 61.12 SNR[16 ] 90.55 89.24 46.63 15.72 60.54 89.00 83.97 49.95 11.41 58.58 CNSN[17 ] 51.03 72.51 58.05 13.25 48.71 76.80 71.51 50.16 10.83 52.32 FF-FDDG 92.79 90.55 68.45 20.91 68.18 88.51 81.32 62.55 25.79 64.54 2.5. 消融实验 为了验证所提出的亮度过滤-残差模块和对比白化损失的有效性,分别以YOLOv7和Faster-RCNN为基线1和基线2对所提出亮度过滤-残差模块和对比白化损失进行消融实验,实验结果如表3 、4 所示. 表中,数据均为跨场景平均mAP. ...