随着机器学习的发展,支持向量机、随机森林、决策树等[4-6]方法不断突破,也逐渐被学者们应用于遥感影像中. 由于传统的地面像素分类往往会导致椒盐效应,变化检测的基本单位已经从像素变成了对象,许多考虑到相邻像素之间关系的方法也被引入到对象级的变化检测中. Gu等[7]设计了线性权重对差分图像中的不变像素和不确定像素进行分类,提出改进的马尔科夫随机场方法用于变化检测. 随着深度学习在视觉领域的成功应用,具有强大特征提取能力的卷积神经网络(convolutional neural network,CNN)在遥感图像中的应用实现了质的飞跃. Daudt等[8]针对CD任务提出FC-EF、FC-Siam-conc和FC-Siam-diff这3个全卷积网络,以实现端到端的训练,其中FC-Siam-conc和FC-Siam-diff是FC-EF的孪生扩展,更加适用于CD的任务.

基于全卷积网络的CD检测方法大致可以分为预融合和后融合2类. 其中,预融合方法主要是将时序图像串联作为单分支网络的输入,然后直接生成二进制变化图. Peng等[9]将配准好的图像级联为一个整体,输入到改进后的Unet++网络中. 该方法利用全局和细粒度信息生成具有较高空间精度的预测图,然后对不同层次的预测图进行融合,从而生成高精度的最终变化图,并且在高分辨率(very high resolution, VHR)卫星图像上验证了该方法的有效性和可靠性. Peng等[10]提出了可以在不同程度上关注空间背景信息和高低层特征之间联系的密集卷积神经网络,解决了传统算法无法满足大面积变化检测需求的问题. 与预融合的方法相比,后融合是由具有共享权重的双分支网络[11]同时对图像进行特征提取,然后将其映射到高维空间的特征图进行融合,最后通过上采样得到变化图. Zhang等[12]提出密集跳跃连接网络,首先将双时序图像进行特征提取和差值运算,并将得到的显示差分金字塔特征图通过跳跃连接输入编解码网络. 该网络还采用了上采样学习策略进一步细化变化检测的边缘. 郭海涛等[13]利用孪生残差网络作为编码器分别提取时序图像的特征图,接着将特征图输入经典的多尺度提取模块即空洞空间卷积池化金字塔(atrous spatial pyramid pooling,ASPP)来进一步提取双分支中影像的多尺度特征并做差值,最后将特征差值图与多尺度特征图融合后输入解码器获得检测结果. Fang等[14]提出基于Unet++的孪生网络,在特征提取部分使用普通卷积块加残差连接的方式充分提取影像特征,网络整体使用密集连接和集成通道注意力模块,以提高网络变化检测的性能.

1. 深度监督算法

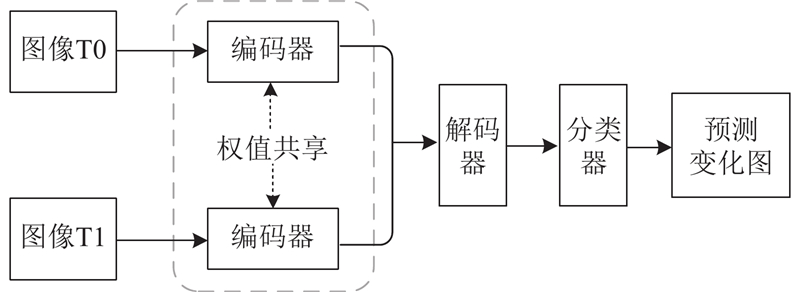

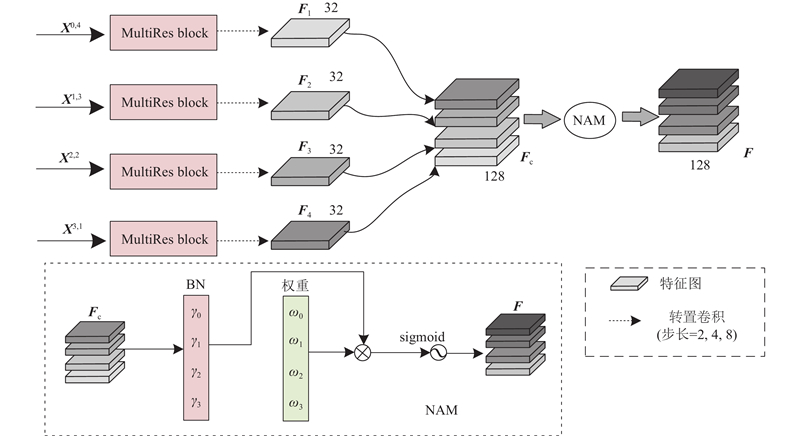

遥感图像通常具有场景复杂、信息丰富的特点. 现有的大多数网络在对遥感图像进行特征提取时,没有充分提取原始图像信息并且忽略了不同层次间的语义关联性,仅凭借单一模型的训练去匹配单个输出,从而造成图像的空间和光谱特征无法充分利用,导致变化检测能力无法进一步提升. 针对以上问题,基于Unet++模型设计了新的端到端的编解码网络DSNet,其主要包括编码器、解码器和分类器,如图1所示,主要内容如下.

图 1

1)编码器部分. 引入多尺度残差模块(MultiRes block)替代原始Unet++的普通卷积块,将小卷积核映射的特征进行级联, 不仅可以丰富特征语义信息,还降低了实验的内存需求.

2)引入横向输出层完成输出端由低级特征向高级特征聚合的深度监督过程. 通过目标函数监督不同上采样分支的训练过程,并融合来自不同监督层的学习信息的方式,将结果集成到高度融合分支上,减小编码器和解码器间的特征差异,提升遥感图像的检测效果.

3)高度融合分支部分. 该部分重用来自上采样过程中的特征图,并与深度监督的分支共享相同的隐藏层. 内部引入基于归一化的注意力模块(normalization-based attention module,NAM),通过批量标准化中的比例因子衡量通道信息重要性,进一步抑制遥感图像中的噪声信息. 在不引入任何参数量的前提下,完成知识提炼,并提高分割的精度.

2. 相关工作

2.1. 编码器

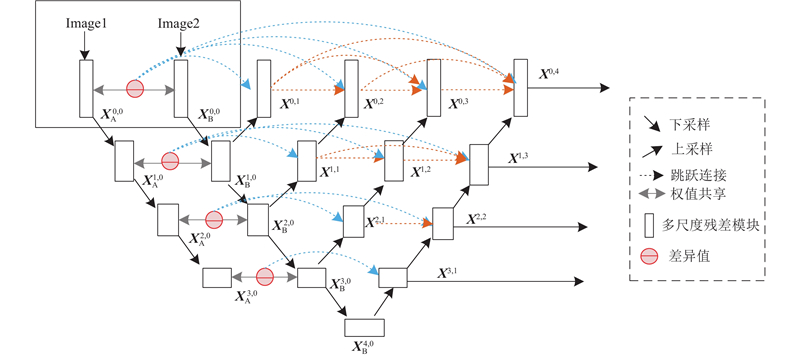

编码器部分由权值共享的孪生结构与Unet++结合而成,其中Unet++的所有普通卷积块均用设计的多尺度残差模块替代,如图2所示. 双时图像Image1和Image2为孪生网络的输入,通过多尺度残差模块对输入进行连续的特征提取和下采样,并将每层获取的双时相图像的特征差异信息及前序节点的输出串联后作为后序所有节点的输入.

图 2

从水平结构上看,编码器共包含5条路径,从上到下依次命名为L1~L5. 同一路径中的卷积单元具有相同的特征输出映射,不同路径包含不同数量的卷积单元,L1~L5通过卷积单元后的输出通道数分别为32、64、128、256、512. 卷积单元的输出映射由

式中:

编码器部分作为网络的主干被用于提取双时相图像的差异信息. 浅层路径获取的特征图包含丰富的纹理、颜色、边缘等信息,而深层路径获取的特征图更具有全局性,可以得到遥感图像中的一些整体性信息. 该编码器通过密集的跳跃连接增加浅层和深层之间的特征流动性,减少特征融合时的语义鸿沟.

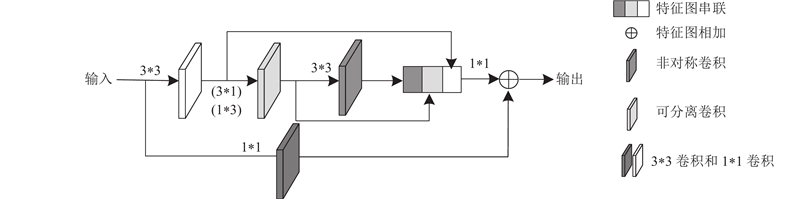

2.1.1. 多尺度残差模块

图像特征提取的质量对模型最终的分割效果起着决定性作用. 在原始Unet++网络中,每次下采样都是通过简单的3*3卷积层提取特征,这往往会带来以下几个问题:遥感图像的变化区域通常存在不规则并且大小不一的现象,使用单一大小的卷积核容易忽略建筑物中细节和位置信息,进而出现分割边界模糊的情况. 高分辨率图像中的建筑物相对较小, 目标位置存在较大的差异,采用较大的卷积核提取容易造成图像局部信息丢失,采用较小的卷积核提取则容易忽视全局信息分布,进而出现目标漏检的情况. 对建筑物的变化提取容易受到背景信息的干扰,充分提取遥感图像中的光谱和边界信息才能有效地区分建筑物和其他地物,进而缓解目标错检的情况. 尽可能从原始图像中提取足够多的信息,才能从根本上解决网络无法稳定地从双时序图像中区分出建筑物的变化区域的问题.

结合单尺度卷积无法满足对高分辨率遥感图像进行复杂语义信息提取的问题,借鉴Inception系列网络的思想,设计非对称的多尺度残差模块,来代替传统堆叠固定卷积层的方式,如图3所示,具体实现如下. 1)通过标准3

图 3

图 3 多尺度残差特征提取模块的结构图

Fig.3 Structure diagram of MultiRes feature extraction module

在整个多尺度残差模块中,在设置滤波器数量时采用的是逐渐递增的方式,以此来控制网络的计算量和参数量,达到轻量化的效果. 通过在指定位置上级联3

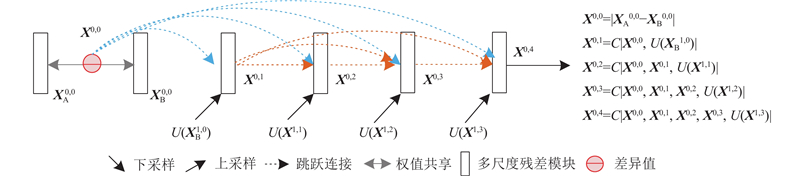

2.1.2. 横向输出层

编码器的深层路径提取到的高层次语义信息通过多次上采样依次传递到浅层,而跳跃连接将双时相图像的差异信息直接传输至同一路径的后序节点中. 为了融合和监督这2部分信息,模型使用横向输出层,聚合来自不同路径的低级和高级语义信息. 编码器部分对应了4个横向输出分支,分别通过每一层的最后一个输出的特征节点X0,4、X1,3、X2,2、X3,1引出. 如图4所示,以L1路径的输出节点X0,4分支为例,孪生网络经过第1次下采样之后获得特征

图 4

2.2. 解码器

通过横向输出层,编码器分别构建4个不同尺度的特征图X0,4、X1,3、X2,2、X3,1. 对于上层路径的输出特征图X0,4、X1,3,可以通过跳跃连接直接获取双时相差异图的浅层细节信息如变化目标的边界,但是无法获得充分的深层语义信息. 深层的特征经过逐层上采样后语义信息容易衰减. 双时相图像经过多次下采样之后,感受野逐渐增大,感受野之间重叠的区域增加,图像信息被压缩. 对于下层路径的输出特征图X2,2、X3,1,可以通过跳跃连接获得差异图的整体性信息如变化目标在图中的位置,但是无法获得充分的细节特征. 经过多次下采样后,上层路径的特征图损失很多遥感图像底层的细节特征并且无法恢复. 融合和重用特征图对于复杂变化场景来说尤为重要,为了有效提取小目标和复杂目标的变化区域,解码器部分将不同尺度的特征图进行融合.

解码器如图5所示,特征图X0,4、X1,3、X2,2、X3,1经过多尺度残差模块和转置卷积操作后,分别映射至通道数均为32的特征图F1、F2、F3、F4. 为了保证输出的特征图可以恢复至原图大小,每条路径均使用不同的上采样率,即在转置卷积中利用不同的步长实现输出的特征图F1、F2、F3、F4维度均为256×256. 多级语义特征融合有利于变化区域的提取,但是容易产生大量的冗余信息,因此直接对特征差异图进行融合将会带来严重的信息干扰,须通过自动选出权重比更大的信息来抑制语义差异、突出显著特征.

图 5

在解码器部分引入基于训练模型的归一化注意力方法[18],利用权重的方差度量来抑制噪声信息并突出显著特征. 主要实现方法如下:将不同路径且大小相同的特征图串联成通道数为128的融合特征图Fc,先经过批量归一化BN,然后与权重系数Wγ相乘,最后经过激活函数得到特征输出F:

式中:γ和β分别为可学习的参数;

2.3. 分类器

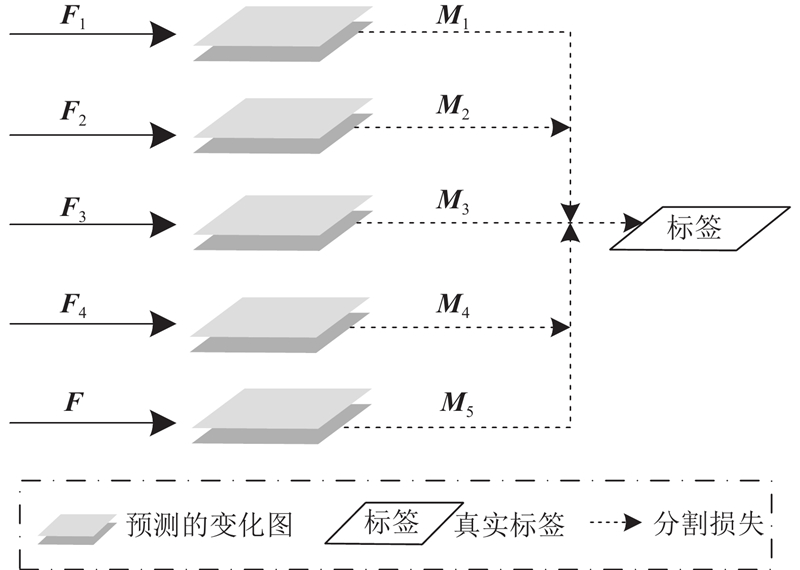

经过解码器,在所有尺度上都构建了具有精确位置或细节信息的特征图F1、F2、F3、F4及融合后且通过注意力机制的特征图F. 特征图F1、F2包含更多的细节变化特征的检出,有利于遥感图像中的小建筑物变化区域的检出;特征图F3、F4纹理细节信息丢失严重,但是可以有效地抑制变化目标区域的空洞现象,适用于建筑变化区域较大的目标. 为了提高网络的鲁棒性,在分类器部分借助深度监督的思想,设计了多尺度预测方法来提高网络的分割精度,增强网络对伪变化的检测能力,进而提高模型对变化区域的学习能力. 深度监督网络可以对隐藏层和输出层进行早期监督,以解决深度学习过程中网络学习能力下降的问题. 深度监督主要是通过计算出真实标签和隐藏层分类器损失来实现对隐藏层的监控与回传.

如图6所示为深度监督结构图. 可以看出,整个网络不仅对融合后的特征图F进行损失的计算,还对解码器部分获得的不同层次的特征图F1、F2、F3、F4都进行损失的计算和回传. 即F1、F2、F3、F4、F通过1

图 6

式中:N为横向输出层的输出数量,

3. 实验方法和结果

3.1. 数据集

为了验证提出的变化检测模型算法的有效性,实验选取LEVIR-CD数据集. LEVIR-CD是带注释的数据集,图像对由专业人员进行注释,其中包含谷歌地球在不同季节拍摄的分辨率为0.5 m/像素的高光谱图像. 图像时间跨度从2002年—2018年,来自美国德克萨斯州几个城市的20个不同地区,主要用于识别5~14 a重大城市变化,包含因季节和光线产生的大量变化信息,有助于训练变化检测模型.

3.2. 图像预处理

图像预处理的主要目的是消除图像中无关的信息,恢复有用真实的信息,增强有关信息的可检测性和最大限度地简化数据,使之更适合于模型的输入. 原始数据集共包含637对1 024×1 024像素的图片,通过裁剪和旋转操作从原始图像生成了10 192对大小为256×256像素的图像,如图7所示. 实验将数据集随机分为3个部分:70%的样本用于训练、20%的样本用于验证和10%的样本用于测试.

图 7

图 7 LEVIR_CD数据集图像裁剪示意图

Fig.7 Schematic diagram of LEVIR_CD dataset image clipping

3.3. 评价指标和参数设置

为了评估模型的性能,采用以下指标:召回率RE、精度PR、F1及Kappa系数. 表达式分别如下:

式中:TP、FP、TN、FN分别为每个像素被预测为正样本但预测是假的、被预测为正样本且预测是真的、被预测为负样本但预测是假的和被预测为负样本但预测是真的. n为总像素点;P为在给定类别分布下,真实值和预测值之间的比例;OA为总体分类精度.

在变化检测任务中,召回率越高表示模型发现更多变化像素的能力越强,精度越高表示检测到的变化像素越准确. F1综合精度与召回率的结果,可以看作是模型精确率和召回率的一种调和平均,最大值为1.0,最小值为0. Kappa系数越高表示模型变化检测能力越强. 在DSNet网络中,训练周期为100轮,批量大小设置为16,学习率采用间隔调整(StepLR),初始学习率为0.001,每10轮衰减为原来的0.5倍.

3.4. 实验数据对比

将所提出的方法与现有的基于深度学习的变化检测方法进行比较,不同方法的各种评价指标的量化结果如表1所示. 表中,par为参数量. FC-EF、FC-Siam-conc和FC-Siam-diff是变化检测领域的基础模型,后两者是Unet的孪生拓展网络. 由表1可以看出,FC-EF方法获得的 F1和Kappa在所有对比方法中数值最低,分别为0.7650和0.7478. 主要原因可能是FC-EF网络使用的卷积核深度相对较小,无法充分提取图像的高级语义信息. 与FC-EF相比,FC-Siam-conc和FC-Siam-diff使用的基于孪生网络的方法在F1数值中分别增加了7.37%和7.81%,Kappa分别增加了7.23%和8.65%,共享权重的孪生编码器是带来改进的主要因素. 基于差分连接的双分支网络性能FC-Siam-diff要优于直接融合的FC-Siam-conc网络,因为连接操作可能会增加冗余信息. DASNet网络与FC-Siam-diff相比,F1和Kappa均提升了2.2%. 在基于对比损失的孪生网络中,DASNet利用双重注意力机制提升了特征的辨识度,能更好地用于变化检测. IFN方法使用vgg16作为编码器,并且提出多层次深度监督和注意力机制来提高CD的准确率. SNUNet-C32通过编码器和解码器之间紧密的信息传输和用于深度监控的集成通道注意力模块细化不同语义层次的代表性特征,最终实现更加准确的分类效果.

表 1 LEVIR数据集上不同网络的变化检测结果

Tab.1

| 方法 | PR | RE | F1 | Kappa | par |

| FC-EF[8] | 0.784 3 | 0.746 7 | 0.765 0 | 0.747 8 | 1.35 |

| FC-Siam-conc[8] | 0.841 2 | 0.836 4 | 0.838 7 | 0.820 1 | 1.55 |

| FC-Siam-diff[8] | 0.864 6 | 0.824 7 | 0.843 1 | 0.834 3 | 1.35 |

| DASNet[19] | 0.873 7 | 0.857 5 | 0.865 4 | 0.857 2 | 16.25 |

| IFN[20] | 0.903 5 | 0.881 3 | 0.892 1 | 0.877 8 | 35.72 |

| SNUNet-C32[14] | 0.910 1 | 0.890 1 | 0.899 9 | 0.894 5 | 12.03 |

| DSNet(本研究) | 0.920 4 | 0.903 9 | 0.912 0 | 0.891 3 | 6.38 |

提出的CD方法借鉴上述方法的优点,在复杂场景的变化检测中获得了优异的性能. 与性能最优的SNUNet-C32方法相比,除了Kappa略低,其他指标均优于SNUNet-C32的. 所提模型利用多分辨率模块提取多尺度的语义信息,并将提取到的细粒度差异和定位信息传输给深度监督层,改进变化目标的边缘和小目标的检测. 高度融合部分结合不同尺度的特征图并利用通道注意力进一步提高网络对目标尺度变化的鲁棒性. 由表1可以看出所提网络的参数量低于大部分的检测网络的.

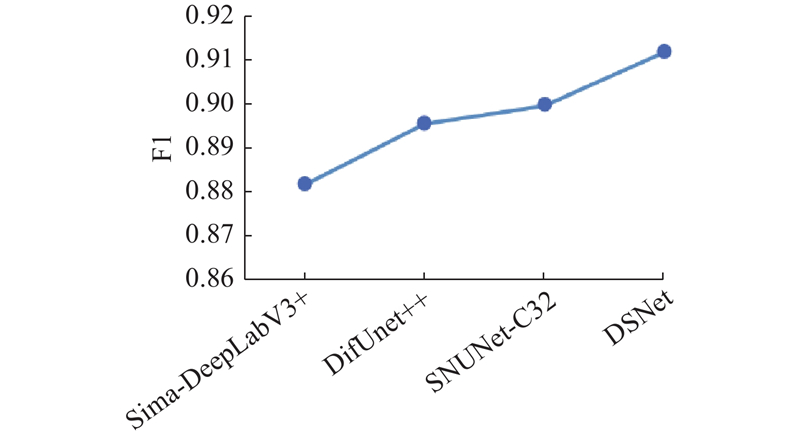

对与本研究特征提取部分有着类似改进的经典网络进行对比分析. 如图8所示为DifUnet++[12]、Sima-DeepLabV3+[13]、SNUNet-C32[14]及所提DSNet网络的F1结果,实验表明所提算法的性能最好. Sima-DeepLabV3+的网络利用不同采样率的空洞卷积进行特征提取,可以较好地获得原始图像的多尺度信息,但是只对某一个深度的时序特征图进行差值运算,无法较好的突出变化目标在特征图中的信息. DifUnet++和SNUNet-C32没有使用多尺度特征提取模块,但通过密集跳跃连接同时构建了浅层和深层的特征差异图,增强了网络对大小不同目标的鲁棒性,可以较好地检测出大、中、小及复杂场景中的建筑物变化图,进而提升检测精度. 本研究算法结合了上述网络的优点,利用多尺度残差模块和密集跳跃连接,在充分提取原始图像信息的同时针对每层路径的特点构建了相应的特征差异图且利用跳跃连接传输给解码器部分,实现了更好的检测结果.

图 8

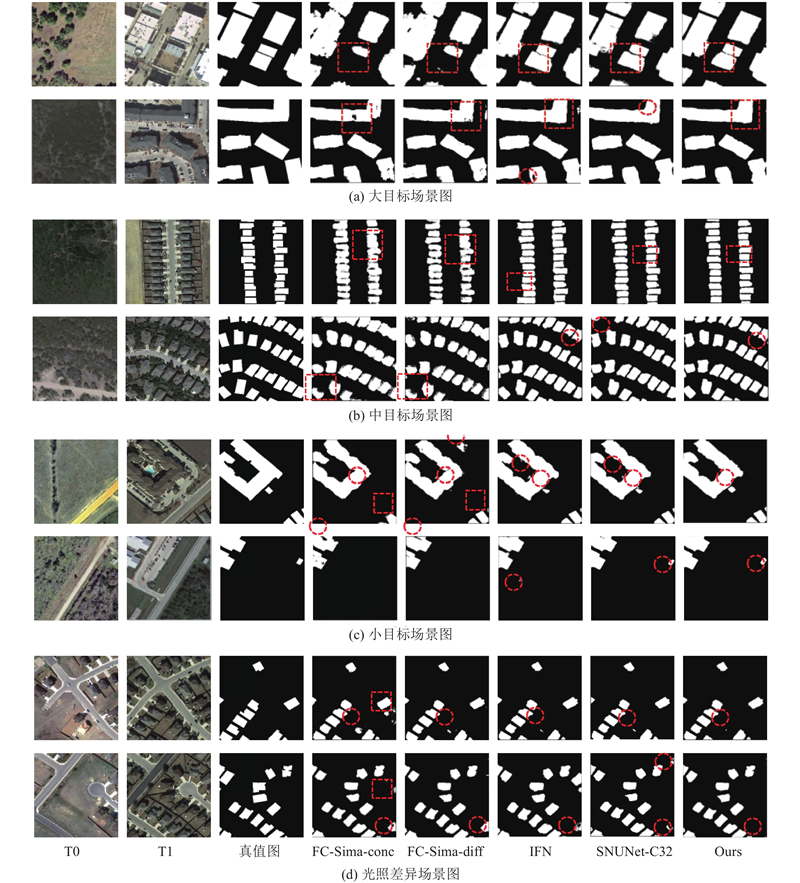

图 9

图 9 不同方法在LEVIR数据集上的建筑物提取结果

Fig.9 Building extraction results of different methods on LEVIR dataset

如图9(a)和(b)所示,对于大目标和中目标场景,所提方法相较于其他模型,没有出现漏检、错检和边缘模糊的情况,主要是由于所提的多尺度残差模块充分提取原始图像的纹理和光谱信息,结合编码器部分的差值运算和跳跃连接,直接获取了双时相图像之间的差异信息,可以较好地识别变化不明显的区域,尤其是建筑物颜色和土地颜色相近的情况. 如图9(c)所示,对于大目标和小目标共存的复杂场景,其他模型可以较好地提取大目标,但是无法完整地检测出小目标,原因是模型没有从多层次上构建和融合上下文信息,而所提算法在分类器部分通过深度监督的思想促使解码器生成更具辨识性的浅层和深层特征,还利用特征融合进一步获取具有精确定位和丰富语义的特征图,提高模型对不同大小目标变化检测的鲁棒性. 如图9(d)所示,前后时期的图像光照差异较大,在变化检测时须特别关注一些伪变化,对比其他模型,所提算法通过引入注意力机制对融合后的特征图重新进行权重分配,消除部分冗余的噪声信息,强调目标对象的重要信息,进而使得网络可以最大程度地克服不同光照或者气候的无关变化对模型的影响. 综上,所提方法可以捕捉到细微的变化区域,更精确和更平滑出地检测出建筑物的轮廓和位置.

表 2 MultiRes block和深度融合监督对变化检测指标的影响

Tab.2

| 基线方法 | Unet++ block | 深度融合监督 | PR | RE | F1 |

| Unet++ | × | × | 0.874 6 | 0.864 7 | 0.869 6 |

| Unet++ | √ | × | 0.889 1 | 0.878 9 | 0.883 9 |

| Unet++ | × | √ | 0.903 5 | 0.889 4 | 0.896 3 |

| Unet++ | √ | √ | 0.920 4 | 0.903 9 | 0.912 0 |

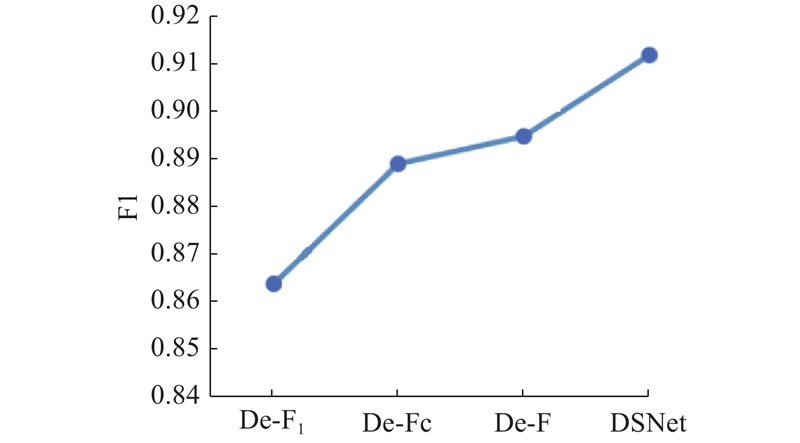

深度监督网络结合5个不同层次的检测结果,包含从低到高维度的不同差异信息和通道注意力的融合特征. 为了清晰和直观地展示深度监督部分的功能,对深度监督部分进行相关的测试,测试结果如图10所示,De-F1、De-Fc、De-F和DSNet分别表示网络训练对象为特征图F1输出的变化图、特征图F1~F4特征融合后的Fc生成的变化图、经过NAM后F生成的变化图以及加入各层深度监督及最终网络的变化图. 深度监督的网络是由每个输出分支输出的检测结果共同决定的,由数据可知,网络中添加的深度融合监督策略能逐步提高检测的性能.

图 10

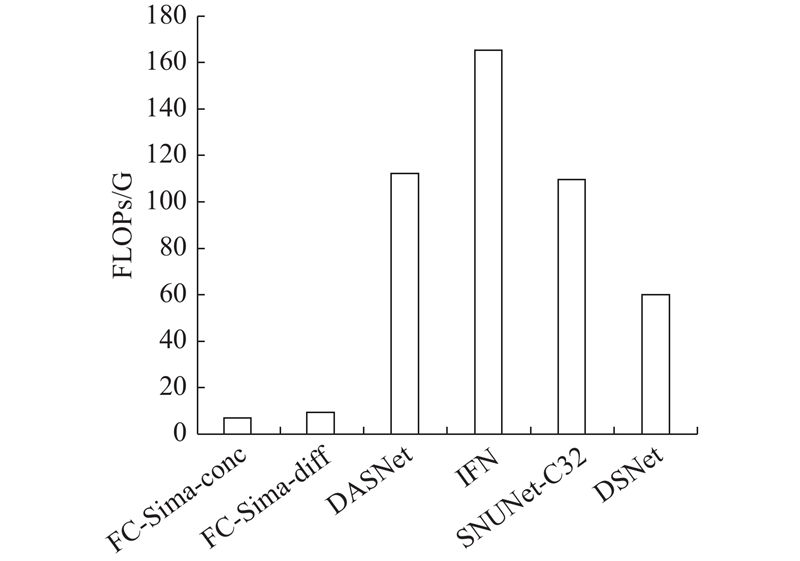

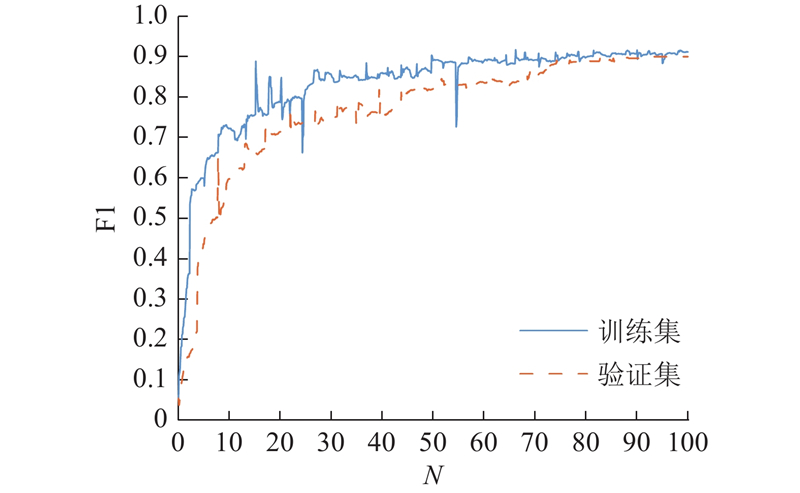

如图11所示为所提方法和对比方法的浮巨运算(floating point operations, FLOPs). FLOPs可以理解为计算量,最早是由Molchanov等[21]提出的,其后被众多深度学习模型引入用来衡量算法的复杂度,如经典的Ghostnet模型[22]. 由图中数值可以看出,FC-EF、FC-Siam-conc和FC-Siam-diff的参数量最少,不过性能会较差. 与前3种模型相比DASNet、IFN和SNUNet-C32的FLOPs均提高很多,大于100 G,不过相应的性能也得到提高. 所提方法的FLOPs只有60 G并且模型性能优于其他方法. 综上,本研究所提方法可以实现网络性能和计算量之间的平衡. 为了更方便地观察模型的训练过程,在LEVIR数据集上绘制训练集和验证集的F1指标变化曲线图,如图12所示.

图 11

图 11 不同算法的计算量对比结果

Fig.11 Comparison results of calculation amount of different algorithms

图 12

图 12 在LEVIR上训练集和验证集的F1

Fig.12 F1 of training and verification set on LEVIR dataset

4. 结 语

本研究提出深度监督网络DSNet,用于高分辨率遥感图像的变化检测. 为了学习不同尺度的特征和语义信息,在采样过程中引入设计好的多尺度残差模块来替代普通卷积层,产生更具分辨率的特征表示. 将下采样过程中获得的双时序特征差异图通过跳跃连接传输给深度监督部分,利用横向输出层实现对差异图的直接监督. 最后利用通道注意模块,强调不同尺度的特征融合后重要的变化特征并且抑制无关特征,以生成更精确的变化图. DSNet在LEVIR数据集上的实验结果表明,相比较于Unet++网络,本研究提出的多尺度残差模块和深度融合监督部分将会使F1提升了4.2%.在复杂场景的变化检测中,DSNet优于现有的深度学习模型,可以有效地提升网络变化检测的能力且参数量低于大部分的检测网络,实现了网络性能和计算量之间的平衡.在实际应用中,带标签的样本要耗费大量的人工成本,引入无监督、半监督或者弱监督的分割方法是未来的研究方向.

参考文献

Change detection of multitemporal SAR data in urban areas combining feature-based and pixel-based techniques

[J].DOI:10.1109/TGRS.2006.879498 [本文引用: 1]

Change detection from remotely sensed images: from pixel-based to object-based approaches

[J].DOI:10.1016/j.isprsjprs.2013.03.006

Global land cover mapping at 30 m resolution: a POK-based operational approach

[J].DOI:10.1016/j.isprsjprs.2014.09.002 [本文引用: 1]

Supervised change detection in VHR images using contextual information and support vector machines

[J].DOI:10.1016/j.jag.2011.10.013 [本文引用: 1]

A novel change detection approach based on visual saliency and random forest from multi-temporal high-resolution remote-sensing images

[J].DOI:10.1080/01431161.2018.1479794

A time-series classification approach based on change detection for rapid land cover mapping

[J].DOI:10.1016/j.isprsjprs.2019.10.003 [本文引用: 1]

Change detection method for remote sensing images based on an improved Markov random field

[J].DOI:10.1007/s11042-015-2960-3 [本文引用: 1]

End-to-end change detection for high resolution satellite images using improved UNet++

[J].DOI:10.3390/rs11111382 [本文引用: 1]

Optical remote sensing image change detection based on attention mechanism and image difference

[J].

Siam-DeepLabv3+网络遥感影像语义变化检测方法

[J].DOI:10.3969/j.issn.1673-6338.2021.06.008 [本文引用: 2]

Semantic change detection method for remote sensing images with Siam-DeepLabv3+ network

[J].DOI:10.3969/j.issn.1673-6338.2021.06.008 [本文引用: 2]

A deeply supervised attention metric-based network and an open aerial image dataset for remote sensing change detection

[J].

Analysis on change detection techniques for remote sensing applications: a review

[J].DOI:10.1016/j.ecoinf.2021.101310 [本文引用: 1]

DASNet: dual attentive fully convolutional siamese networks for change detection in high-resolution satellite images

[J].

A deeply supervised image fusion network for change detection in high resolution bi-temporal remote sensing images

[J].DOI:10.1016/j.isprsjprs.2020.06.003 [本文引用: 1]