[1]

IQBAL K, ODETAYO M, JAMES A, et al. Enhancing the low quality images using unsupervised colour correction method [C]// Proceedings of IEEE International Conference on Systems, Man and Cybernetics: IEEE, 2010: 1703-1709.

[本文引用: 1]

[2]

ANCUTI C, ANCUTI C O, HABER T. Enhancing underwater images and videos by fusion [C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . Providence RI: IEEE, 2012: 81-88.

[3]

HITAM M S, KUALA T, YUSSOF W, et al. Mixture contrast limited adaptive histogram equalization for underwater image enhancement [C]// Proceedings of International Conference on Computer Applications Technology. Sousse, Tunisia, 2013: 1-5.

[本文引用: 1]

[4]

DREWSJR P, NASCIMENTO E R, BOTELHO S S C, et al Underwater depth estimation and image restoration based on singleimages

[J]. IEEE Computer Graphics and Applications , 2016 , 36 (2 ): 24 - 35

DOI:10.1109/MCG.2016.26

[本文引用: 1]

[5]

LI C, GUO J, CHEN S, et al. Underwater image restoration based on minimum information loss principle and optical properties of underwater imaging [C]// IEEE International Conference on Image Processing (ICIP). Phoenix: IEEE, 2016: 1993-1997.

[本文引用: 1]

[6]

LI C, GUO J, CONG R, et al Underwater image enhancement by dehazing with minimum information loss and histogram distribution prior

[J]. IEEE Transactions on Image Processing , 2016 , 25 (12 ): 5664 - 5677

DOI:10.1109/TIP.2016.2612882

[本文引用: 1]

[7]

AKKAYNAK D, TREIBITZ T. A revised underwater image formation model [C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City: IEEE, 2018: 6723-6732.

[本文引用: 1]

[8]

AKKAYNAK D, TREIBITZ T. Sea-Thru: a method for removing water from underwater images [C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach: IEEE, 2019: 1682-1691.

[本文引用: 1]

[9]

LI J, SKINNER K A, EUSTICE M, et al WaterGAN: unsupervised generative networkto enable real-time color correction of monocular underwater images

[J]. IEEE Robotics and Automation Letters , 2018 , 3 (1 ): 387 - 394

[本文引用: 1]

[10]

FABBRI C, ISLAM M J, SATTAR J. Enhancing underwater imagery using generative adversarial networks [C]// IEEE International Conference on Robotics and Automation (ICRA). Brisbane: IEEE, 2018: 7159-7165.

[本文引用: 3]

[11]

ANWAR S, LI C, PORIKLI F. Deep underwater image enhancemen [EB/OL]. [2018-07-10]. https://arxiv.org/abs/1807.03528.

[本文引用: 1]

[12]

LI C, ANWAR S, PORIKLI F Underwater scene prior inspired deep underwater image and video enhancement

[J]. Pattern Recognition , 2019 , 98 (1 ): 107038

[本文引用: 4]

[13]

LI C, GUO C, REN W, et al An underwater image enhancement benchmark dataset and beyond

[J]. IEEE Transactions on Image Processing , 2020 , 29 : 4376 - 4389

DOI:10.1109/TIP.2019.2955241

[本文引用: 4]

[14]

LIU Y C, CHAN W H, CHEN Y Q Automatic white balance for digital still camera

[J]. IEEE Transactions on Consumer Electronics , 1995 , 41 (3 ): 460 - 466

DOI:10.1109/30.468045

[本文引用: 3]

[16]

WANG Y, GUO J, GAO H UIEC^2-Net: CNN-based underwater image enhancement using two color space

[J]. Signal Processing: Image Communication , 2021 , 96 : 116250

DOI:10.1016/j.image.2021.116250

[本文引用: 1]

[17]

LI C, ANWAR S, HOU J, et al Underwater image enhancement via medium transmission-guided multi-color space embedding

[J]. IEEE Transactions on Image Processing , 2021 , 30 : 4985 - 5000

DOI:10.1109/TIP.2021.3076367

[本文引用: 3]

[18]

LU H, LI Y, ZHANG L Contrast enhancement for images in turbid water

[J]. Journal of the Optical Society of America A , 2015 , 32 (5 ): 886 - 893

DOI:10.1364/JOSAA.32.000886

[本文引用: 1]

[19]

PENG Y T, K CAO, P C COSMAN Generalization of the dark channel prior for single image restoration

[J]. IEEE Transactions on Image Processing , 2018 , 27 (6 ): 2856 - 2868

DOI:10.1109/TIP.2018.2813092

[本文引用: 1]

[20]

LI C, CONG R, PIAO Y, et al. RGB-D salient object detection with cross-modality modulation and selection [C]// European Conference on Computer Vision (ECCV). Cham: Springer, 2020: 225-241.

[本文引用: 1]

[21]

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 770-778.

[本文引用: 1]

[22]

ZHAO H, GALLO O, FROSIO I, et al Loss functions for image restoration with neural networks

[J]. IEEE Transactions on Computational Imaging , 2016 , 3 (1 ): 47 - 57

[本文引用: 1]

[23]

JOHNSON J, ALAHI A, LI F F. Perceptual losses for real-timestyle transfer and super-resolution [C]// European Conference on Computer Vision (ECCV). Cham: Springer, 2016: 694-711.

[本文引用: 1]

[24]

LIU W, RABINOVICH A, BERG A C, Parsenet: looking wider to see better [EB/OL]. [2015-06-15]. https://arxiv.org/abs/1506.04579.

[本文引用: 1]

[25]

PANETTA K, GAO C, AGAIAN S Human-visual-system inspired underwater image quality measures

[J]. IEEE Journal of Oceanic Engineering , 2016 , 41 (3 ): 541 - 551

DOI:10.1109/JOE.2015.2469915

[本文引用: 1]

[26]

YANG M, SOWMYA A An underwater color image quality evaluation metric

[J]. IEEE Transactions on Image Processing , 2015 , 24 (12 ): 6062 - 6071

DOI:10.1109/TIP.2015.2491020

[本文引用: 1]

1

... 水下图像增强可以分为传统的方法和基于深度学习的方法2类. 传统方法在一定程度上能够提高水下图像质量,但是鲁棒性较差,不能得到稳定可靠的结果. 例如,Iqbal等[1 -3 ] 提出的方法能够提升水下图像的视觉质量,却会出现不同程度的失真; Drews等[4 ] 提出一种基于水下暗通道先验的方法,该方法对不同水下场景的适应能力较差;Li等[5 -6 ] 提出一种基于最小化信息损失和直方图先验分布的水下图像增强方法,该方法对于低亮度的水下图像处理效果不佳;Akkaynak等[7 ] 提出修正的水下光学成像模型,之后又改进该模型,引入RGB-D图像有效地去除水下图像的蓝绿色偏差问题[8 ] ,但是RGB-D水下图像数据集较难获取,该方法较难迁移到其他的水下场景中. ...

1

... 水下图像增强可以分为传统的方法和基于深度学习的方法2类. 传统方法在一定程度上能够提高水下图像质量,但是鲁棒性较差,不能得到稳定可靠的结果. 例如,Iqbal等[1 -3 ] 提出的方法能够提升水下图像的视觉质量,却会出现不同程度的失真; Drews等[4 ] 提出一种基于水下暗通道先验的方法,该方法对不同水下场景的适应能力较差;Li等[5 -6 ] 提出一种基于最小化信息损失和直方图先验分布的水下图像增强方法,该方法对于低亮度的水下图像处理效果不佳;Akkaynak等[7 ] 提出修正的水下光学成像模型,之后又改进该模型,引入RGB-D图像有效地去除水下图像的蓝绿色偏差问题[8 ] ,但是RGB-D水下图像数据集较难获取,该方法较难迁移到其他的水下场景中. ...

Underwater depth estimation and image restoration based on singleimages

1

2016

... 水下图像增强可以分为传统的方法和基于深度学习的方法2类. 传统方法在一定程度上能够提高水下图像质量,但是鲁棒性较差,不能得到稳定可靠的结果. 例如,Iqbal等[1 -3 ] 提出的方法能够提升水下图像的视觉质量,却会出现不同程度的失真; Drews等[4 ] 提出一种基于水下暗通道先验的方法,该方法对不同水下场景的适应能力较差;Li等[5 -6 ] 提出一种基于最小化信息损失和直方图先验分布的水下图像增强方法,该方法对于低亮度的水下图像处理效果不佳;Akkaynak等[7 ] 提出修正的水下光学成像模型,之后又改进该模型,引入RGB-D图像有效地去除水下图像的蓝绿色偏差问题[8 ] ,但是RGB-D水下图像数据集较难获取,该方法较难迁移到其他的水下场景中. ...

1

... 水下图像增强可以分为传统的方法和基于深度学习的方法2类. 传统方法在一定程度上能够提高水下图像质量,但是鲁棒性较差,不能得到稳定可靠的结果. 例如,Iqbal等[1 -3 ] 提出的方法能够提升水下图像的视觉质量,却会出现不同程度的失真; Drews等[4 ] 提出一种基于水下暗通道先验的方法,该方法对不同水下场景的适应能力较差;Li等[5 -6 ] 提出一种基于最小化信息损失和直方图先验分布的水下图像增强方法,该方法对于低亮度的水下图像处理效果不佳;Akkaynak等[7 ] 提出修正的水下光学成像模型,之后又改进该模型,引入RGB-D图像有效地去除水下图像的蓝绿色偏差问题[8 ] ,但是RGB-D水下图像数据集较难获取,该方法较难迁移到其他的水下场景中. ...

Underwater image enhancement by dehazing with minimum information loss and histogram distribution prior

1

2016

... 水下图像增强可以分为传统的方法和基于深度学习的方法2类. 传统方法在一定程度上能够提高水下图像质量,但是鲁棒性较差,不能得到稳定可靠的结果. 例如,Iqbal等[1 -3 ] 提出的方法能够提升水下图像的视觉质量,却会出现不同程度的失真; Drews等[4 ] 提出一种基于水下暗通道先验的方法,该方法对不同水下场景的适应能力较差;Li等[5 -6 ] 提出一种基于最小化信息损失和直方图先验分布的水下图像增强方法,该方法对于低亮度的水下图像处理效果不佳;Akkaynak等[7 ] 提出修正的水下光学成像模型,之后又改进该模型,引入RGB-D图像有效地去除水下图像的蓝绿色偏差问题[8 ] ,但是RGB-D水下图像数据集较难获取,该方法较难迁移到其他的水下场景中. ...

1

... 水下图像增强可以分为传统的方法和基于深度学习的方法2类. 传统方法在一定程度上能够提高水下图像质量,但是鲁棒性较差,不能得到稳定可靠的结果. 例如,Iqbal等[1 -3 ] 提出的方法能够提升水下图像的视觉质量,却会出现不同程度的失真; Drews等[4 ] 提出一种基于水下暗通道先验的方法,该方法对不同水下场景的适应能力较差;Li等[5 -6 ] 提出一种基于最小化信息损失和直方图先验分布的水下图像增强方法,该方法对于低亮度的水下图像处理效果不佳;Akkaynak等[7 ] 提出修正的水下光学成像模型,之后又改进该模型,引入RGB-D图像有效地去除水下图像的蓝绿色偏差问题[8 ] ,但是RGB-D水下图像数据集较难获取,该方法较难迁移到其他的水下场景中. ...

1

... 水下图像增强可以分为传统的方法和基于深度学习的方法2类. 传统方法在一定程度上能够提高水下图像质量,但是鲁棒性较差,不能得到稳定可靠的结果. 例如,Iqbal等[1 -3 ] 提出的方法能够提升水下图像的视觉质量,却会出现不同程度的失真; Drews等[4 ] 提出一种基于水下暗通道先验的方法,该方法对不同水下场景的适应能力较差;Li等[5 -6 ] 提出一种基于最小化信息损失和直方图先验分布的水下图像增强方法,该方法对于低亮度的水下图像处理效果不佳;Akkaynak等[7 ] 提出修正的水下光学成像模型,之后又改进该模型,引入RGB-D图像有效地去除水下图像的蓝绿色偏差问题[8 ] ,但是RGB-D水下图像数据集较难获取,该方法较难迁移到其他的水下场景中. ...

WaterGAN: unsupervised generative networkto enable real-time color correction of monocular underwater images

1

2018

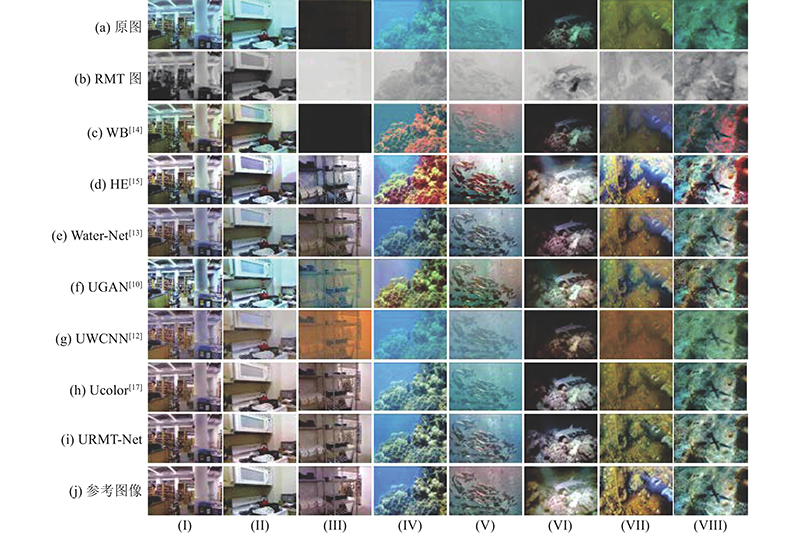

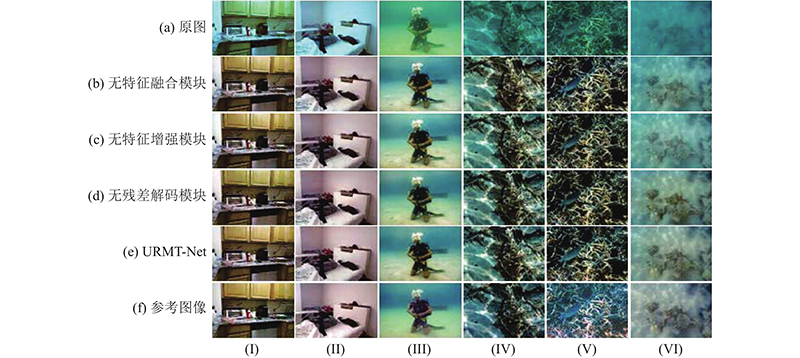

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

3

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

... Objective evaluation indexes of each algorithm on synthesized datasets

Tab.1 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 4 144.966 6 14.494 5 0.695 4 6.090 0 0.494 2 1.882 9 WB[14 ] 4 246.773 4 14.517 4 0.686 2 5.981 7 0.477 4 1.860 5 HE[15 ] 3 885.061 3 14.303 6 0.737 2 7.141 3 0.604 4 2.461 3 Water-Net[13 ] 3 417.155 3 15.761 2 0.768 7 6.787 9 0.540 5 2.409 3 UGAN[10 ] 2 266.487 8 16.263 6 0.662 5 7.121 4 0.559 7 3.020 2 UWCNN[12 ] 2 159.017 0 17.045 3 0.767 0 6.530 7 0.549 4 4.125 1 Ucolor[17 ] 723.786 5 23.239 3 0.871 8 7.260 6 0.513 2 2.575 7 URMT-Net 636.919 4 22.933 8 0.886 2 7.355 7 0.564 0 2.868 5

表 2 真实数据集上各算法的客观评价指标 ...

... Objective evaluation indexes of each algorithm on real datasets

Tab.2 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 1 324.763 9 18.258 0 0.815 0 6.745 0 0.504 4 2.840 7 WB[14 ] 1 455.735 0 17.926 1 0.804 1 6.761 9 0.542 9 2.873 1 HE[15 ] 1 164.861 4 18.863 8 0.874 9 7.817 3 0.664 0 3.620 7 Water-Net[13 ] 838.973 3 21.394 8 0.894 8 7.151 8 0.580 7 3.587 2 UGAN[10 ] 558.296 5 21.303 1 0.769 1 7.466 8 0.616 2 4.015 7 UWCNN[12 ] 2 804.303 1 15.089 1 0.710 8 6.309 1 0.483 7 2.983 2 Ucolor[17 ] 519.691 7 22.752 8 0.906 7 7.242 1 0.569 3 4.563 4 URMT-Net 489.336 1 22.305 0 0.902 1 7.484 7 0.599 0 3.786 2

表1 中“↑”为越大越好,“↓”为越小越好,在所有的表格中,最优值均使用加粗表示,次优值用下划线标注. 从表1 可以看出,在合成的水下图像数据集中,URMT-Net在MSE、SSIM、Entropy上表现最好,在PSNR中表现次优,说明URMT-Net输出的增强图像在质量和结构上比较接近于参考图像,Entropy值高还说明URMT-Net信息损失最少,细节保留得最好,所含信息最为丰富. 在所对比的方法中,UCIQE和UIQM中表现一般,分别排在第2位和第3位. 结合对图像的主观评价分析,URMT-Net的增强图像在色彩和对比度上表现一般,却显得更加真实自然,而在这2个指标上获得最优表现的HE、UWCNN却存在局部对比度过高、色彩过于饱和、图像失真等问题,由此说明2个指标确实会出现与人眼视觉感受不一致的情况. 综合来看,与所对比的算法相比,URMT-Net在合成水下图像数据集中表现最佳,在保持水下图像细节良好的情况下提高了水下图像的视觉质量. ...

1

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

Underwater scene prior inspired deep underwater image and video enhancement

4

2019

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

... UIEB[13 ] 数据集包含890幅真实水下图像,对应的参考图像是由50名志愿者从12种增强方法中选出的视觉质量最佳的图像. 该数据集的数量还不足以训练本研究的URMT-Net,因此除了从UIEB数据集中选择800张真实水下图像外,还从合成水下图像数据集[12 ] 中加入1 250张合成的水下图像,总共2 050张图像作为训练数据集. 合成水下图像数据集通过不同的衰减系数,将清晰的RGB-D陆地图像合成具有不同退化程度的水下图像,共含有10种不同类型. 测试数据集选择额外的900张合成的水下图像,再加上UIEB数据集中剩余的90张真实水下图像,共990张图像. ...

... Objective evaluation indexes of each algorithm on synthesized datasets

Tab.1 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 4 144.966 6 14.494 5 0.695 4 6.090 0 0.494 2 1.882 9 WB[14 ] 4 246.773 4 14.517 4 0.686 2 5.981 7 0.477 4 1.860 5 HE[15 ] 3 885.061 3 14.303 6 0.737 2 7.141 3 0.604 4 2.461 3 Water-Net[13 ] 3 417.155 3 15.761 2 0.768 7 6.787 9 0.540 5 2.409 3 UGAN[10 ] 2 266.487 8 16.263 6 0.662 5 7.121 4 0.559 7 3.020 2 UWCNN[12 ] 2 159.017 0 17.045 3 0.767 0 6.530 7 0.549 4 4.125 1 Ucolor[17 ] 723.786 5 23.239 3 0.871 8 7.260 6 0.513 2 2.575 7 URMT-Net 636.919 4 22.933 8 0.886 2 7.355 7 0.564 0 2.868 5

表 2 真实数据集上各算法的客观评价指标 ...

... Objective evaluation indexes of each algorithm on real datasets

Tab.2 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 1 324.763 9 18.258 0 0.815 0 6.745 0 0.504 4 2.840 7 WB[14 ] 1 455.735 0 17.926 1 0.804 1 6.761 9 0.542 9 2.873 1 HE[15 ] 1 164.861 4 18.863 8 0.874 9 7.817 3 0.664 0 3.620 7 Water-Net[13 ] 838.973 3 21.394 8 0.894 8 7.151 8 0.580 7 3.587 2 UGAN[10 ] 558.296 5 21.303 1 0.769 1 7.466 8 0.616 2 4.015 7 UWCNN[12 ] 2 804.303 1 15.089 1 0.710 8 6.309 1 0.483 7 2.983 2 Ucolor[17 ] 519.691 7 22.752 8 0.906 7 7.242 1 0.569 3 4.563 4 URMT-Net 489.336 1 22.305 0 0.902 1 7.484 7 0.599 0 3.786 2

表1 中“↑”为越大越好,“↓”为越小越好,在所有的表格中,最优值均使用加粗表示,次优值用下划线标注. 从表1 可以看出,在合成的水下图像数据集中,URMT-Net在MSE、SSIM、Entropy上表现最好,在PSNR中表现次优,说明URMT-Net输出的增强图像在质量和结构上比较接近于参考图像,Entropy值高还说明URMT-Net信息损失最少,细节保留得最好,所含信息最为丰富. 在所对比的方法中,UCIQE和UIQM中表现一般,分别排在第2位和第3位. 结合对图像的主观评价分析,URMT-Net的增强图像在色彩和对比度上表现一般,却显得更加真实自然,而在这2个指标上获得最优表现的HE、UWCNN却存在局部对比度过高、色彩过于饱和、图像失真等问题,由此说明2个指标确实会出现与人眼视觉感受不一致的情况. 综合来看,与所对比的算法相比,URMT-Net在合成水下图像数据集中表现最佳,在保持水下图像细节良好的情况下提高了水下图像的视觉质量. ...

An underwater image enhancement benchmark dataset and beyond

4

2020

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

... UIEB[13 ] 数据集包含890幅真实水下图像,对应的参考图像是由50名志愿者从12种增强方法中选出的视觉质量最佳的图像. 该数据集的数量还不足以训练本研究的URMT-Net,因此除了从UIEB数据集中选择800张真实水下图像外,还从合成水下图像数据集[12 ] 中加入1 250张合成的水下图像,总共2 050张图像作为训练数据集. 合成水下图像数据集通过不同的衰减系数,将清晰的RGB-D陆地图像合成具有不同退化程度的水下图像,共含有10种不同类型. 测试数据集选择额外的900张合成的水下图像,再加上UIEB数据集中剩余的90张真实水下图像,共990张图像. ...

... Objective evaluation indexes of each algorithm on synthesized datasets

Tab.1 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 4 144.966 6 14.494 5 0.695 4 6.090 0 0.494 2 1.882 9 WB[14 ] 4 246.773 4 14.517 4 0.686 2 5.981 7 0.477 4 1.860 5 HE[15 ] 3 885.061 3 14.303 6 0.737 2 7.141 3 0.604 4 2.461 3 Water-Net[13 ] 3 417.155 3 15.761 2 0.768 7 6.787 9 0.540 5 2.409 3 UGAN[10 ] 2 266.487 8 16.263 6 0.662 5 7.121 4 0.559 7 3.020 2 UWCNN[12 ] 2 159.017 0 17.045 3 0.767 0 6.530 7 0.549 4 4.125 1 Ucolor[17 ] 723.786 5 23.239 3 0.871 8 7.260 6 0.513 2 2.575 7 URMT-Net 636.919 4 22.933 8 0.886 2 7.355 7 0.564 0 2.868 5

表 2 真实数据集上各算法的客观评价指标 ...

... Objective evaluation indexes of each algorithm on real datasets

Tab.2 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 1 324.763 9 18.258 0 0.815 0 6.745 0 0.504 4 2.840 7 WB[14 ] 1 455.735 0 17.926 1 0.804 1 6.761 9 0.542 9 2.873 1 HE[15 ] 1 164.861 4 18.863 8 0.874 9 7.817 3 0.664 0 3.620 7 Water-Net[13 ] 838.973 3 21.394 8 0.894 8 7.151 8 0.580 7 3.587 2 UGAN[10 ] 558.296 5 21.303 1 0.769 1 7.466 8 0.616 2 4.015 7 UWCNN[12 ] 2 804.303 1 15.089 1 0.710 8 6.309 1 0.483 7 2.983 2 Ucolor[17 ] 519.691 7 22.752 8 0.906 7 7.242 1 0.569 3 4.563 4 URMT-Net 489.336 1 22.305 0 0.902 1 7.484 7 0.599 0 3.786 2

表1 中“↑”为越大越好,“↓”为越小越好,在所有的表格中,最优值均使用加粗表示,次优值用下划线标注. 从表1 可以看出,在合成的水下图像数据集中,URMT-Net在MSE、SSIM、Entropy上表现最好,在PSNR中表现次优,说明URMT-Net输出的增强图像在质量和结构上比较接近于参考图像,Entropy值高还说明URMT-Net信息损失最少,细节保留得最好,所含信息最为丰富. 在所对比的方法中,UCIQE和UIQM中表现一般,分别排在第2位和第3位. 结合对图像的主观评价分析,URMT-Net的增强图像在色彩和对比度上表现一般,却显得更加真实自然,而在这2个指标上获得最优表现的HE、UWCNN却存在局部对比度过高、色彩过于饱和、图像失真等问题,由此说明2个指标确实会出现与人眼视觉感受不一致的情况. 综合来看,与所对比的算法相比,URMT-Net在合成水下图像数据集中表现最佳,在保持水下图像细节良好的情况下提高了水下图像的视觉质量. ...

Automatic white balance for digital still camera

3

1995

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

... Objective evaluation indexes of each algorithm on synthesized datasets

Tab.1 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 4 144.966 6 14.494 5 0.695 4 6.090 0 0.494 2 1.882 9 WB[14 ] 4 246.773 4 14.517 4 0.686 2 5.981 7 0.477 4 1.860 5 HE[15 ] 3 885.061 3 14.303 6 0.737 2 7.141 3 0.604 4 2.461 3 Water-Net[13 ] 3 417.155 3 15.761 2 0.768 7 6.787 9 0.540 5 2.409 3 UGAN[10 ] 2 266.487 8 16.263 6 0.662 5 7.121 4 0.559 7 3.020 2 UWCNN[12 ] 2 159.017 0 17.045 3 0.767 0 6.530 7 0.549 4 4.125 1 Ucolor[17 ] 723.786 5 23.239 3 0.871 8 7.260 6 0.513 2 2.575 7 URMT-Net 636.919 4 22.933 8 0.886 2 7.355 7 0.564 0 2.868 5

表 2 真实数据集上各算法的客观评价指标 ...

... Objective evaluation indexes of each algorithm on real datasets

Tab.2 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 1 324.763 9 18.258 0 0.815 0 6.745 0 0.504 4 2.840 7 WB[14 ] 1 455.735 0 17.926 1 0.804 1 6.761 9 0.542 9 2.873 1 HE[15 ] 1 164.861 4 18.863 8 0.874 9 7.817 3 0.664 0 3.620 7 Water-Net[13 ] 838.973 3 21.394 8 0.894 8 7.151 8 0.580 7 3.587 2 UGAN[10 ] 558.296 5 21.303 1 0.769 1 7.466 8 0.616 2 4.015 7 UWCNN[12 ] 2 804.303 1 15.089 1 0.710 8 6.309 1 0.483 7 2.983 2 Ucolor[17 ] 519.691 7 22.752 8 0.906 7 7.242 1 0.569 3 4.563 4 URMT-Net 489.336 1 22.305 0 0.902 1 7.484 7 0.599 0 3.786 2

表1 中“↑”为越大越好,“↓”为越小越好,在所有的表格中,最优值均使用加粗表示,次优值用下划线标注. 从表1 可以看出,在合成的水下图像数据集中,URMT-Net在MSE、SSIM、Entropy上表现最好,在PSNR中表现次优,说明URMT-Net输出的增强图像在质量和结构上比较接近于参考图像,Entropy值高还说明URMT-Net信息损失最少,细节保留得最好,所含信息最为丰富. 在所对比的方法中,UCIQE和UIQM中表现一般,分别排在第2位和第3位. 结合对图像的主观评价分析,URMT-Net的增强图像在色彩和对比度上表现一般,却显得更加真实自然,而在这2个指标上获得最优表现的HE、UWCNN却存在局部对比度过高、色彩过于饱和、图像失真等问题,由此说明2个指标确实会出现与人眼视觉感受不一致的情况. 综合来看,与所对比的算法相比,URMT-Net在合成水下图像数据集中表现最佳,在保持水下图像细节良好的情况下提高了水下图像的视觉质量. ...

Image enhancement by histogram transformation

3

1977

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

... Objective evaluation indexes of each algorithm on synthesized datasets

Tab.1 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 4 144.966 6 14.494 5 0.695 4 6.090 0 0.494 2 1.882 9 WB[14 ] 4 246.773 4 14.517 4 0.686 2 5.981 7 0.477 4 1.860 5 HE[15 ] 3 885.061 3 14.303 6 0.737 2 7.141 3 0.604 4 2.461 3 Water-Net[13 ] 3 417.155 3 15.761 2 0.768 7 6.787 9 0.540 5 2.409 3 UGAN[10 ] 2 266.487 8 16.263 6 0.662 5 7.121 4 0.559 7 3.020 2 UWCNN[12 ] 2 159.017 0 17.045 3 0.767 0 6.530 7 0.549 4 4.125 1 Ucolor[17 ] 723.786 5 23.239 3 0.871 8 7.260 6 0.513 2 2.575 7 URMT-Net 636.919 4 22.933 8 0.886 2 7.355 7 0.564 0 2.868 5

表 2 真实数据集上各算法的客观评价指标 ...

... Objective evaluation indexes of each algorithm on real datasets

Tab.2 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 1 324.763 9 18.258 0 0.815 0 6.745 0 0.504 4 2.840 7 WB[14 ] 1 455.735 0 17.926 1 0.804 1 6.761 9 0.542 9 2.873 1 HE[15 ] 1 164.861 4 18.863 8 0.874 9 7.817 3 0.664 0 3.620 7 Water-Net[13 ] 838.973 3 21.394 8 0.894 8 7.151 8 0.580 7 3.587 2 UGAN[10 ] 558.296 5 21.303 1 0.769 1 7.466 8 0.616 2 4.015 7 UWCNN[12 ] 2 804.303 1 15.089 1 0.710 8 6.309 1 0.483 7 2.983 2 Ucolor[17 ] 519.691 7 22.752 8 0.906 7 7.242 1 0.569 3 4.563 4 URMT-Net 489.336 1 22.305 0 0.902 1 7.484 7 0.599 0 3.786 2

表1 中“↑”为越大越好,“↓”为越小越好,在所有的表格中,最优值均使用加粗表示,次优值用下划线标注. 从表1 可以看出,在合成的水下图像数据集中,URMT-Net在MSE、SSIM、Entropy上表现最好,在PSNR中表现次优,说明URMT-Net输出的增强图像在质量和结构上比较接近于参考图像,Entropy值高还说明URMT-Net信息损失最少,细节保留得最好,所含信息最为丰富. 在所对比的方法中,UCIQE和UIQM中表现一般,分别排在第2位和第3位. 结合对图像的主观评价分析,URMT-Net的增强图像在色彩和对比度上表现一般,却显得更加真实自然,而在这2个指标上获得最优表现的HE、UWCNN却存在局部对比度过高、色彩过于饱和、图像失真等问题,由此说明2个指标确实会出现与人眼视觉感受不一致的情况. 综合来看,与所对比的算法相比,URMT-Net在合成水下图像数据集中表现最佳,在保持水下图像细节良好的情况下提高了水下图像的视觉质量. ...

UIEC^2-Net: CNN-based underwater image enhancement using two color space

1

2021

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

Underwater image enhancement via medium transmission-guided multi-color space embedding

3

2021

... 随着深度学习的发展,卷积神经网络能够自适应地调整卷积核的参数,学习原始水下图像和增强图像之间的非线性映射关系,从而更可靠地处理各种复杂的水下场景. Li等[9 ] 通过生成对抗网络将RGB-D图像合成为水下图像,并利用合成的水下图像训练神经网络;FABBRI等[10 ] 通过循环生成对抗网络生成了成对的水下图像数据集用于训练;Li等[11 -12 ] 提出的UWCNN模型,针对不同的水下图像类型训练不同的神经网络模型;Li等[13 ] 通过融合白平衡(white balance, WB)[14 ] 、直方图均衡化[15 ] (histogram equalization, HE)和伽马校正(gamma correction,GC)3种传统方法来进行水下图像增强,WB能够校正水下图像的色偏,而HE和GC则提高水下图像的对比度和亮度. Wang等[16 ] 提出UIEC^2-Net,结合RGB、HSV空间以及注意力模块对水下图像进行增强;Li等[17 ] 提出基于多颜色空间的Ucolor网络,并在网络中引入逆透射率(reverse medium transmission,RMT)图像,将其作为权重信息用来引导水下RGB图像增强. 这些方法可以在一定程度上提高水下图像的视觉质量,但是单纯依靠神经网络学习参数再通过非线性映射得到增强图像的方式,在复杂的水下成像环境中很难有效地学习到水下光学成像的特点及规律,导致结果缺乏可靠性,因此解决不同场景中水下图像的质量退化问题仍然具有挑战性. ...

... Objective evaluation indexes of each algorithm on synthesized datasets

Tab.1 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 4 144.966 6 14.494 5 0.695 4 6.090 0 0.494 2 1.882 9 WB[14 ] 4 246.773 4 14.517 4 0.686 2 5.981 7 0.477 4 1.860 5 HE[15 ] 3 885.061 3 14.303 6 0.737 2 7.141 3 0.604 4 2.461 3 Water-Net[13 ] 3 417.155 3 15.761 2 0.768 7 6.787 9 0.540 5 2.409 3 UGAN[10 ] 2 266.487 8 16.263 6 0.662 5 7.121 4 0.559 7 3.020 2 UWCNN[12 ] 2 159.017 0 17.045 3 0.767 0 6.530 7 0.549 4 4.125 1 Ucolor[17 ] 723.786 5 23.239 3 0.871 8 7.260 6 0.513 2 2.575 7 URMT-Net 636.919 4 22.933 8 0.886 2 7.355 7 0.564 0 2.868 5

表 2 真实数据集上各算法的客观评价指标 ...

... Objective evaluation indexes of each algorithm on real datasets

Tab.2 算法 MSE ↓ PSNR↑ SSIM↑ Entropy↑ UCIQE↑ UIQM↑ 原图 1 324.763 9 18.258 0 0.815 0 6.745 0 0.504 4 2.840 7 WB[14 ] 1 455.735 0 17.926 1 0.804 1 6.761 9 0.542 9 2.873 1 HE[15 ] 1 164.861 4 18.863 8 0.874 9 7.817 3 0.664 0 3.620 7 Water-Net[13 ] 838.973 3 21.394 8 0.894 8 7.151 8 0.580 7 3.587 2 UGAN[10 ] 558.296 5 21.303 1 0.769 1 7.466 8 0.616 2 4.015 7 UWCNN[12 ] 2 804.303 1 15.089 1 0.710 8 6.309 1 0.483 7 2.983 2 Ucolor[17 ] 519.691 7 22.752 8 0.906 7 7.242 1 0.569 3 4.563 4 URMT-Net 489.336 1 22.305 0 0.902 1 7.484 7 0.599 0 3.786 2

表1 中“↑”为越大越好,“↓”为越小越好,在所有的表格中,最优值均使用加粗表示,次优值用下划线标注. 从表1 可以看出,在合成的水下图像数据集中,URMT-Net在MSE、SSIM、Entropy上表现最好,在PSNR中表现次优,说明URMT-Net输出的增强图像在质量和结构上比较接近于参考图像,Entropy值高还说明URMT-Net信息损失最少,细节保留得最好,所含信息最为丰富. 在所对比的方法中,UCIQE和UIQM中表现一般,分别排在第2位和第3位. 结合对图像的主观评价分析,URMT-Net的增强图像在色彩和对比度上表现一般,却显得更加真实自然,而在这2个指标上获得最优表现的HE、UWCNN却存在局部对比度过高、色彩过于饱和、图像失真等问题,由此说明2个指标确实会出现与人眼视觉感受不一致的情况. 综合来看,与所对比的算法相比,URMT-Net在合成水下图像数据集中表现最佳,在保持水下图像细节良好的情况下提高了水下图像的视觉质量. ...

Contrast enhancement for images in turbid water

1

2015

... 目前在水下光学成像中,应用最为广泛的模型为扩展的大气散射模型[18 ] : ...

Generalization of the dark channel prior for single image restoration

1

2018

... 式(1)中的媒介透射率可以使用文献[19 ]的方法获得较精确的结果: ...

1

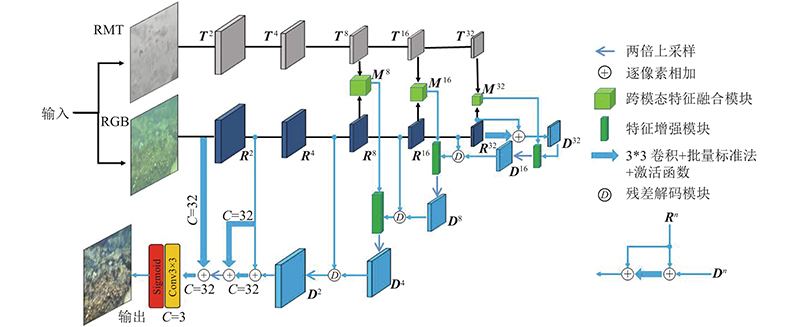

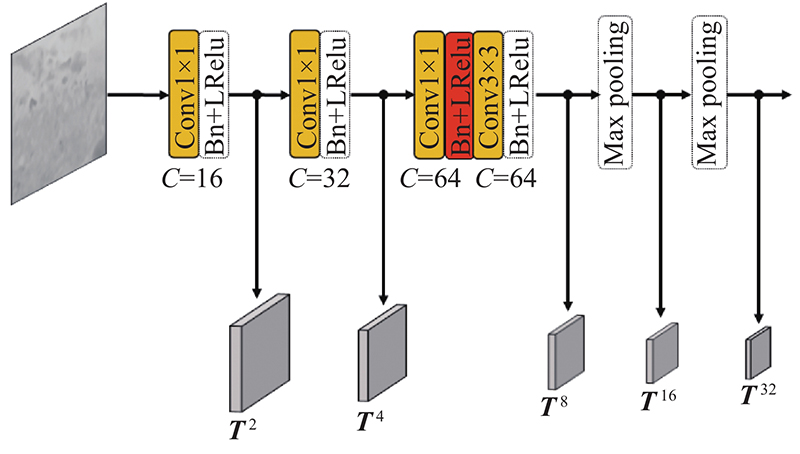

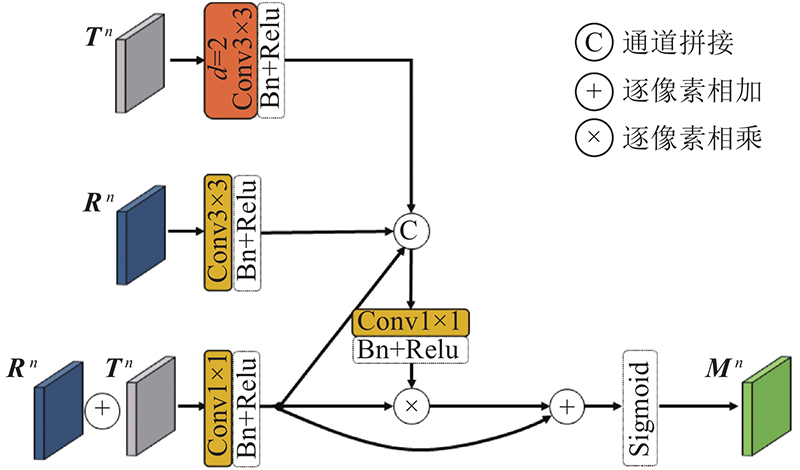

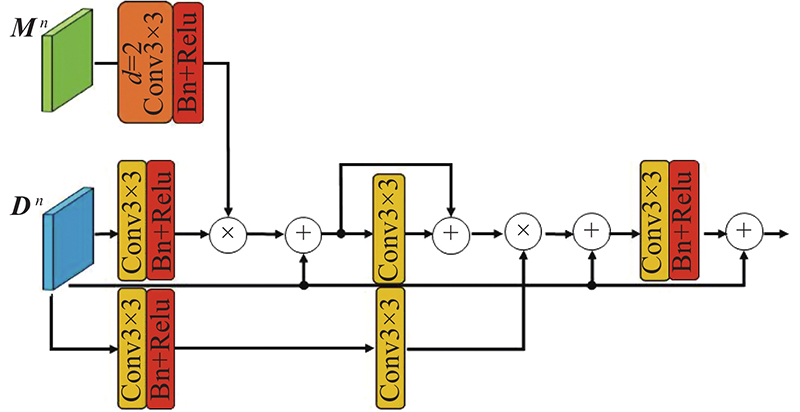

... 双流卷积神经网络被广泛应用于RGB-D显著性检测[20 ] 中,通过双分支信息流能够有效地提取多模态特征. 为了更高效地利用RGB和RMT信息,使用双流卷积神经网络做特征提取器,如图1 所示. 网络的2个输入(RGB图像和RMT图像)分别输入到网络的2个独立信息流(RGB流和RMT流)之中. RGB流使用ImageNet数据集预训练的ResNet-50[21 ] 作为基础网络结构,去除最后一层池化层仅保留卷积层. 为了减少信息损失,将其中的ReLU激活函数均换成参数值为0.25的Leaky ReLU激活函数. ResNet-50共有5层卷积层,将每一层的输出独立取出,并分别通过5个独立的1*1卷积,将通道数降维到64. 每个卷积层均连接着批量标准化层(batch normalization layer)以及Leaky ReLU激活函数,可以提取得到RGB信息的5种不同尺度的特征(R 2 、R 4 、R 8 、R 16 、R 32 ). ...

1

... 双流卷积神经网络被广泛应用于RGB-D显著性检测[20 ] 中,通过双分支信息流能够有效地提取多模态特征. 为了更高效地利用RGB和RMT信息,使用双流卷积神经网络做特征提取器,如图1 所示. 网络的2个输入(RGB图像和RMT图像)分别输入到网络的2个独立信息流(RGB流和RMT流)之中. RGB流使用ImageNet数据集预训练的ResNet-50[21 ] 作为基础网络结构,去除最后一层池化层仅保留卷积层. 为了减少信息损失,将其中的ReLU激活函数均换成参数值为0.25的Leaky ReLU激活函数. ResNet-50共有5层卷积层,将每一层的输出独立取出,并分别通过5个独立的1*1卷积,将通道数降维到64. 每个卷积层均连接着批量标准化层(batch normalization layer)以及Leaky ReLU激活函数,可以提取得到RGB信息的5种不同尺度的特征(R 2 、R 4 、R 8 、R 16 、R 32 ). ...

Loss functions for image restoration with neural networks

1

2016

... 为了能够有效训练URMT-Net,选取3个损失函数分别为均方误差损失(mean square error loss) $ {L_{\rm{m}}} $ [22 ] $ {L_{\rm{s}}} $ [23 ] $ {L_{\rm{p}}} $ . 其中均方误差损失函数能够保持图像内容的稳定性,结构相似性损失能够保持图像整体结构的稳定性,感知损失能够保持图像语义信息的稳定性. 衡量三者的重要性赋予它们不同的权重,通过加权求和的方式得到网络的总损失函数: ...

1

... 为了能够有效训练URMT-Net,选取3个损失函数分别为均方误差损失(mean square error loss) $ {L_{\rm{m}}} $ [22 ] $ {L_{\rm{s}}} $ [23 ] $ {L_{\rm{p}}} $ . 其中均方误差损失函数能够保持图像内容的稳定性,结构相似性损失能够保持图像整体结构的稳定性,感知损失能够保持图像语义信息的稳定性. 衡量三者的重要性赋予它们不同的权重,通过加权求和的方式得到网络的总损失函数: ...

1

... 采用随机梯度下降法(stochastic gradient descent,SGD),以“poly”策略[24 ] 训练网络,初始学习率设置为0.1,批量处理大小为16 ,学习衰减率、动量、权重衰减系数分别设置为0.450 0、0.900 0和0.000 5. 为了增加训练样本,对所有训练图像进行数据增广. 将训练图像随机裁剪到320×320大小、并进行随机水平翻转和参数值为0.05的随机颜色抖动处理,初步训练125个回合(epoch). 之后为了获得更好的鲁棒性,在不使用数据增广的情况下,以0.02的学习率,设置批量处理大小为6并采用梯度累加的方式,再训练50个回合,一共训练175个回合. 使用的机器配置为NVIDA 1080Ti GPU. ...

Human-visual-system inspired underwater image quality measures

1

2016

... 图像质量的客观评价具有可描述性和严谨性等优势,选取常在水下图像评价中使用的6种客观评价指标,包括3种全参考方法:均方误差(mean square error, MSE)、峰值信噪比(peak signal to noise ratio,PSNR)、结构相似性(structural similarity,SSIM),以及3种无参考方法:信息熵(entropy)、水下图像质量评估度量指标[25 ] (underwater color image quality evaluation,UCIQE)、水下图像质量指标[26 ] (underwater image quality measure,UIQM). ...

An underwater color image quality evaluation metric

1

2015

... 图像质量的客观评价具有可描述性和严谨性等优势,选取常在水下图像评价中使用的6种客观评价指标,包括3种全参考方法:均方误差(mean square error, MSE)、峰值信噪比(peak signal to noise ratio,PSNR)、结构相似性(structural similarity,SSIM),以及3种无参考方法:信息熵(entropy)、水下图像质量评估度量指标[25 ] (underwater color image quality evaluation,UCIQE)、水下图像质量指标[26 ] (underwater image quality measure,UIQM). ...