本研究将使用佩戴在手指上的惯性测量单元(inertial measurement unit,IMU)以感知手指与平面的触碰活动. IMU通常由3个自由度的加速度计与3个自由度的角速度计构成,部分IMU集成了3个自由度的地磁传感器. 由于IMU提供的丰富信息(加速度、速度、姿态定位[5-6]等)以及消费级IMU低廉的价格,该传感器被广泛地部署在各类智能设备中;由于IMU具有强大的感知能力,还被广泛地应用于如感知人体姿态、人的行为[7]的人机交互领域任务中. Gu等[8]低延迟且高准确率地识别了手指在表面的点击手势;HulaMove[9]通过配置在腰部的智能设备,感知人腰部的运动并以此建立新交互方式;Ott等[10-11]使用配置了包括IMU在内的多传感器笔,完成了对手写内容的识别;Xu等[12]通过智能手表中的IMU,完成了对定制手势的识别;TapID[13]使用配置在手上的IMU阵列,成功地区分了不同手指的点击活动.

本研究使用单个高频率采样的消费级IMU同时采集动作信息与表面声波信息,采用不同特征提取方法对这2种信息进行分别处理;使用基于神经网络的分类算法同时完成手部状态与手部具体活动的分类;以分类算法为基础,搭建基于接触手势的实时控制原型系统.

1. 硬件配置与数据预处理

1.1. 输入设备的硬件配置

图 1

图 2

1.2. 加速度与角速度的数据处理

原始加速度数据中包含重力加速度分量,保留重力加速度分量将使手势识别算法对方位敏感. 客户端获得数据后先通过Madgwick滤波器[17]获得IMU姿态四元数,并以此为依据移除重力分量. 为了减少加速度与角速度的数值差距,使模型训练顺利进行,数据处理过程还包含数据标准化、标准化后的数据将会被送入程序,实现手势模式识别.

2. 数据分析

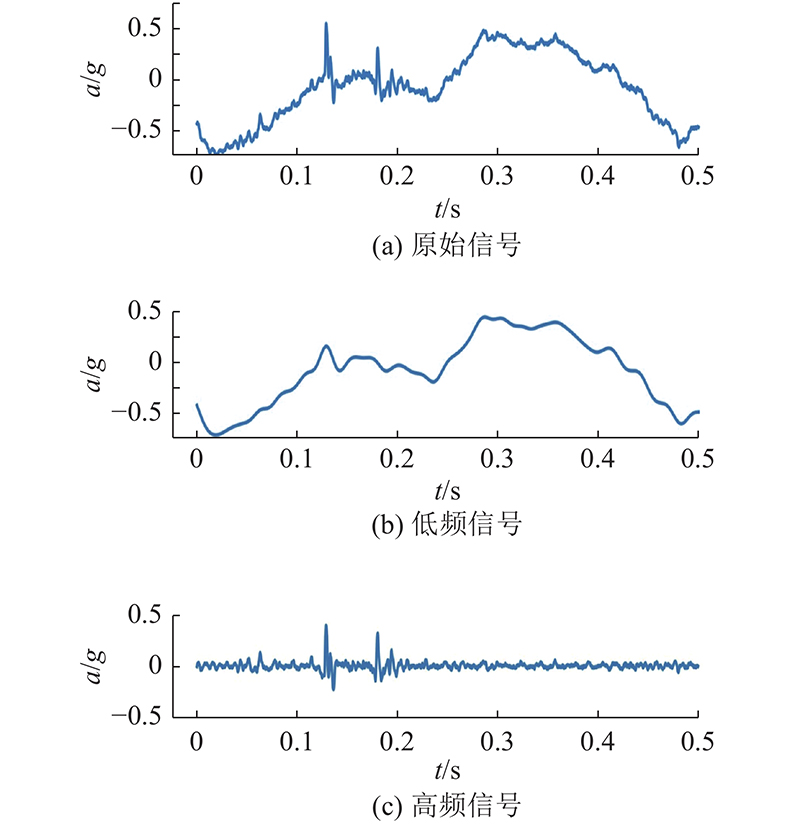

以采样频率100 Hz为例,高采样率IMU数据比传统IMU数据复杂. 为了展示2种IMU数据的差别,根据频率将数据分为2个信道:低频信号(0~50 Hz)、高频信号(50~2 000 Hz).

2.1. 高频信道特征提取方法

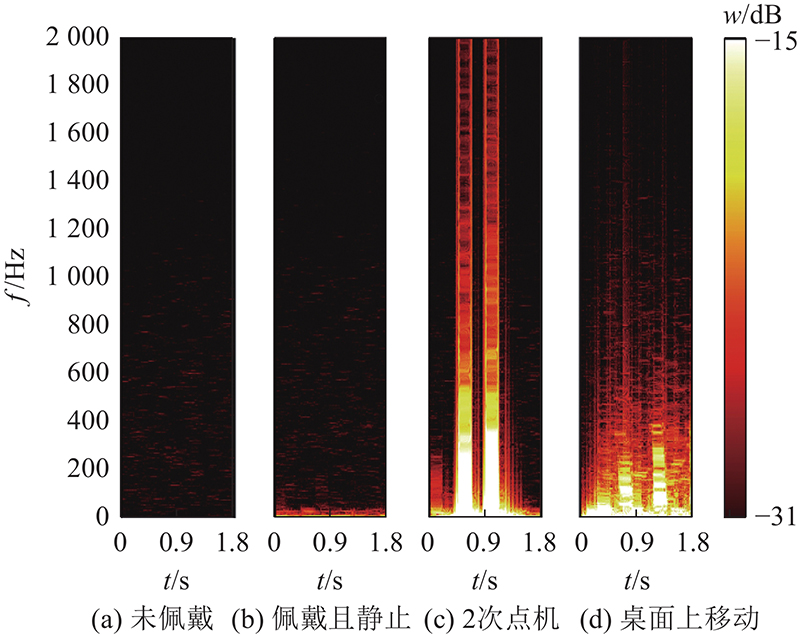

人体活动属于低频运动,主动运动信息集中于低频信号. 高频信号包含人体运动时被动产生的表面声波信息,与人体所处状态与环境密切相关. 如图3所示为手指在桌面上移动时,IMU采集的单轴加速度数据. 图中,a为加速度,t为时间. 高频信号包含频繁震荡且数值比低频信号的小,这使时域上特征分析变得复杂烦琐. 如图4所示为设备未佩戴、设备佩戴且手部处于静止状态、手指点击2次桌面、手指在桌面上运动这4种情况的时频图. 图中,f为频率,w为信号强度. 与声音信号类似,高频信道各频段能量分布很大程度上体现了点击、手指在桌面上运动这2种手势的差别. 未佩戴状态与佩戴状态差别来源于人体微小颤动,时域上由于数据接近零且设备噪声不可忽视,两者差别难以区分. 频域数据可以分离部分噪声以此增加信噪比,弥补了时域数据的不足,因此在研究高频信道数据时使用频域特征能够有效地进行特征提取.

图 3

图 3 单轴加速度在时域上的原始信号、低频信号与高频信号

Fig.3 Raw signals, low-frequency signals and high-frequency signals of single-axis acceleration in time domain

图 4

图 4 不同情况下的频段能量分布图

Fig.4 Frequency band energy distribution for different scenarios

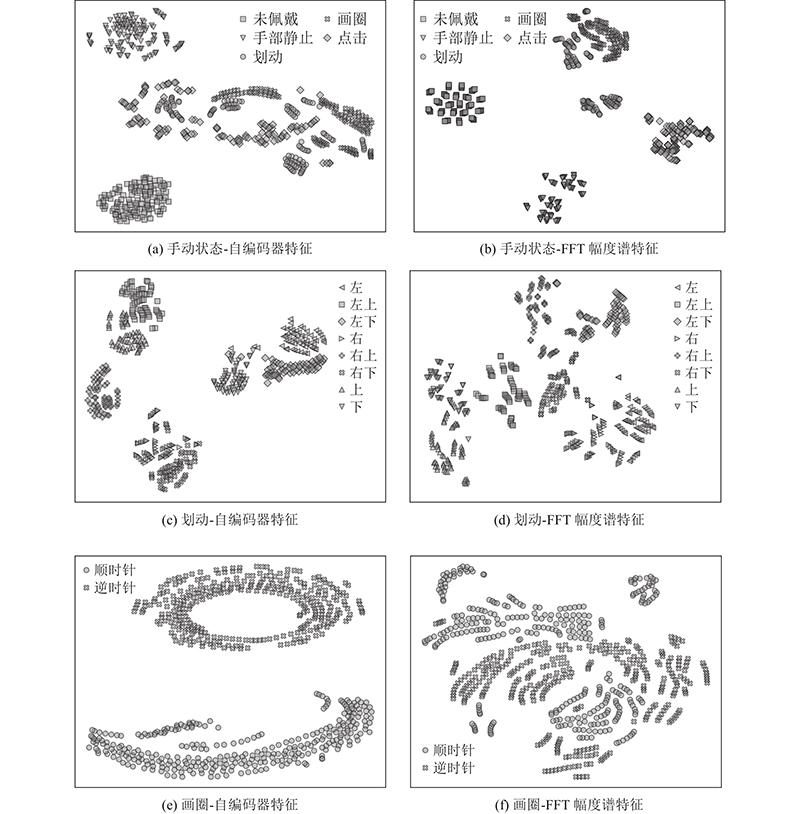

2.2. 手部状态与手势数据可视化分析

采集不同手部状态与手势共3组数据,供可视化分析使用:1)600条手部状态分类数据,包含5种状态类别;2)480条划动手势分类数据,包含8种方向类别;3)620条画圈手势分类数据,包含2种方向类别. 在各组数据中,每个类别数据量均相同. 分别提取3组数据的低频信号特征与高频信号特征,使用t-SNE方法降维可视化,使用预训练低频特征自编码器提取低频信号特征,使用快速傅里叶变换(fast Fourier transform, FFT)幅度谱提取高频信号特征,可视化结果如图5所示. 结果显示,手部状态分类在FFT幅度谱中更具有区分度,划动与画圈手势分类在自编码器特征中更具有区分度.

图 5

图 5 不同特征上各分类数据的t-SNE可视化图

Fig.5 Visualization of t-SNE for each classification data on different features

3. 数据采集

3.1. 无标签的数据采集

采集21组长度为4.8×106的无标签数据,每组约20 min,共计约7 h. 采集数据期间,使用者不受任何限制. 数据经过窗口大小为800、步长为100的滑动窗口截取后,获得1 007 853条无标签数据. 数据采集完成后,计算数据各通道均值与标准差.

3.2. 有标签的数据采集

采集6组长度为800,共计51 840条有标签数据(每组8 640条). 数据分别对应6种手部状态或手势类别:1)未佩戴设备、2)佩戴时静止、3)点击、4)划动、5)画圈、6)空中手部移动. 其中第4组数据分为左、左上、左下、右、右上、右下、上、下共8种划动手势类别,第5组可分为顺时针、逆时针2种画圈手势类别. 为了提高模型在不同表面泛化能力,除第6组数据外,每组数据均在布料材质、硬纸板材质、木材质3种表面上采集. 在实际训练中,所有表面数据同时训练. 共有3位采集人员参与采集,采集人员惯用手均为右手. 在第4组数据采集过程中,采集人员均反映使用斜向划动手势(如向左上划动)时感到困难.

4. 模型结构、训练与评估

4.1. 模型任务与拆分

4.1.1. 模型任务

模型须完成2个任务:1)对使用者的手部状态进行分类,类别包括未佩戴设备、佩戴设备时手部静止、手指点击、手指划动(移动轨迹为直线)、手指画圈(移动轨迹近似为圆圈);2)对个别手势类别分类,类别包括手指划动中的8个方向与手指画圈中的2个方向.

4.1.2. 任务与模型拆分

根据各类别中隐含的包含关系,将任务1)拆分为4个子任务;将任务2)中划动手势任务沿水平与垂直方向拆分为2个子任务; 根据拆分子任务,将模型结构拆分为7个部分,每个部分均为1个二分类或三分类子模型,拆分结果如表1所示. 实际使用中,子模型之间通过简单逻辑判断相连,形成针对任务1)、2)的整合模型. 具体而言,模型A、B、D、G通过逻辑判断连接共同完成任务1);模型C单独完成任务2)中画圈手势部分,模型E、F连接共同完成划动手势部分.

表 1 模型的任务拆分

Tab.1

| 模型名称 | 分类数量 | 模型分类类别 |

| A | 2 | 未佩戴、佩戴时手部静止 |

| B | 2 | 划动、画圈 |

| C | 2 | 顺时针、逆时针 |

| D | 3 | 静止(包括未佩戴和手部静止)、点击、 手部移动(包括划动与画圈与空中运动) |

| E | 3 | (划动)左、居中、右 |

| F | 3 | (划动)上、居中、下 |

| G | 2 | 表面上移动、非表面上移动 |

模型拆分的优势如下. 1)在实际训练中观察到的现象与Gu等[8]观察到的相似:在数据量少的情况下,将复杂任务拆分为简单分类任务并将各个小模型耦合为大模型会提升识别正确率,降低训练难度;2)由小模型耦合而来的大模型在实际运用中,更易于维护与实现功能拓展(维护与功能更新过程只需更新相关小模型).

4.2. 模型基本结构

4.2.1. 分类模型基本结构

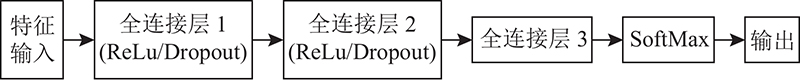

将分类模型基本结构分为2个部分:特征提取器、特征分类器. 其中特征提取器根据各任务数据信道不同,分为低频特征提取器、高频特征提取器. 高频特征提取器为FFT计算模块,该模块输入原始数据并输出一定频段范围的幅度谱. 高频特征提取器频段范围由超参数f0控制:当f0被设定时,仅f0至2 kHz频段的能量分布会作为特征传递至特征分类器,且f0必须大于0,即特征提取器必须去除频谱直流分量. 低频特征提取器使用预训练自编码器. 如图6所示,特征分类器层次结构统一为3层全连接神经网络层与1层SoftMax输出层. 每个分类模型均由1个特征提取器与1个特征分类器连接构成. 其中模型A、B、D、G使用高频特征提取器,模型C、E、F使用低频特征提取器.

图 6

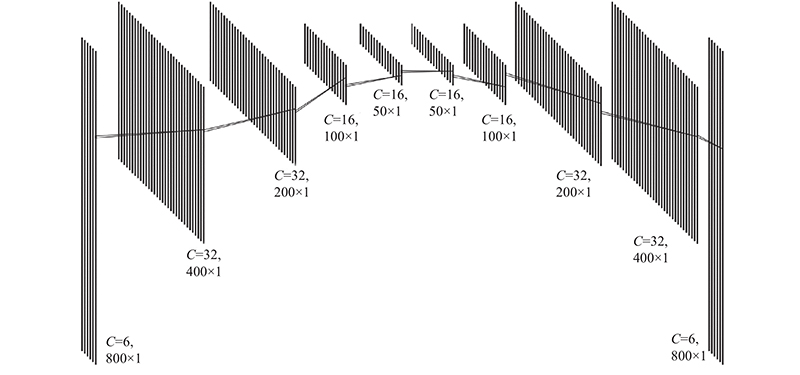

4.2.2. 自编码器模型结构

图 7

4.3. 模型训练

4.3.1. 自编码器训练

使用无标签数据作为自编码器训练数据. 在训练前,使用均值与标准差对数据分布进行标准化变换. 训练过程中使用原始数据作为模型输入,使用经过零相位数字低通滤波(截止频率为50 Hz)处理的数据作为模型重建目标,计算重建目标与模型输出的均方根误差作为模型损失函数. 训练完成后,保留自编码器权重作为后续模型训练的预训练权重.

4.3.2. 分类模型训练

使用有标签数据作为训练数据:根据各模型须解决任务差异,组合不同类型数据,构造各模型训练所需训练集. 在训练模型E、F时,8个方向只考虑当前模型分类维度并将方向种类合并至3个. 如训练模型E时,左、左上、左下3个类别合并为左类别;右、右上、右下3个类别合并为右类别;上、下2个类别合并为居中类别.

对7种分类模型表现情况进行单独评估. 对二分类模型,计算模型准确率、精确率、召回率及F1分数作为评估指标;对三分类模型,计算模型准确率、宏精确率、宏召回率及宏F1分数作为评估指标. 评估使用的测试集来自小型数据集. 模型B测试集使用第2组全部480条数据和第3组中480条数据,模型G测试集使用模型B测试集以及额外采集获得的960条在空中移动的类别数据. 对每种分类模型训练10个模型并计算评估指标. 各项指标均值与标准差如表2所示. 表中,N为测试集大小,A为正确率,P为准确率或宏准确率,R为召回率或宏召回率,F为F1分数或宏F1分数,括号外数字为参数均值,括号内数字为标准差.

表 2 分类模型评估指标均值与标准差

Tab.2

| 模型名称 | N | A/% | P/% | R/% | F/% |

| A | 240 | 97.92 (0.92) | 100.00 (0.00) | 95.83 (1.84) | 97.86 (0.95) |

| B | 960 | 90.63 (0.78) | 90.63 (1.76) | 90.67 (0.95) | 90.63 (0.69) |

| C | 620 | 98.63 (1.32) | 99.29 (1.61) | 97.97 (1.03) | 98.62 (1.31) |

| D | 600 | 99.22 (0.14) | 99.30 (0.22) | 98.75 (0.19) | 99.01 (0.17) |

| E | 480 | 99.77 (0.18) | 99.73 (0.23) | 99.76 (0.19) | 99.75 (0.20) |

| F | 480 | 94.23 (3.51) | 93.94 (3.09) | 94.64 (3.18) | 93.77 (3.72) |

| G | 1920 | 98.42 (0.23) | 99.21 (0.37) | 97.63 (0.53) | 98.41 (0.23) |

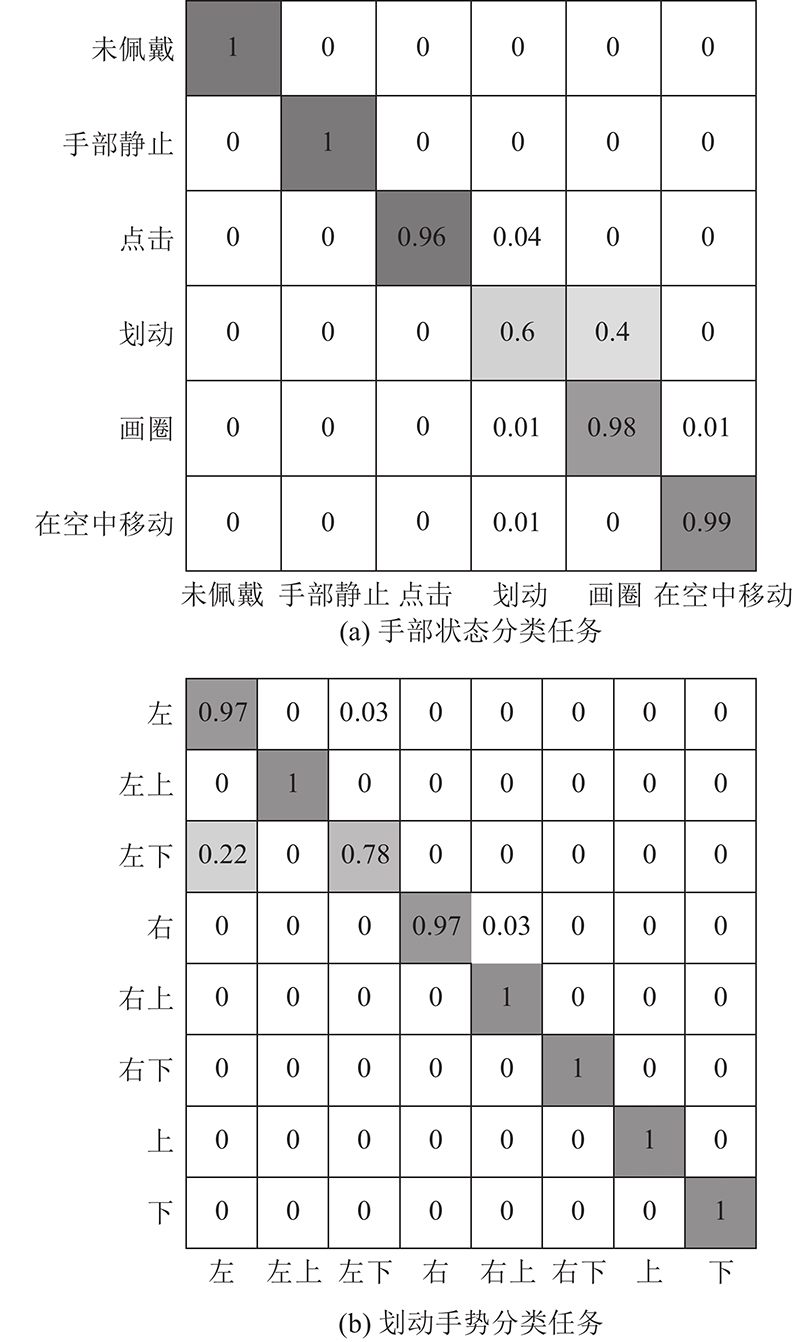

对任务1)、2)中划动手势分类任务的2种综合分类任务进行评估. 手部状态分类任务由模型A、B、D、G共同完成,测试集由手部状态与手势采集的第2组数据、120条空中移动类别数据组合而成. 划动手势分类任务由模型E、F共同完成. 数据集由手部状态与手势采集的第2组数据组成,若模型E与F同时识别为居中类别将被额外分类为未知类别.

如图8所示,绘制2种综合任务的混淆矩阵. 图中,竖列为真实类别,横行为预测类别. 虽然模型B的整体正确率达到90.63%,但在手部状态分类数据集上表现不佳(手部状态与手势采集的第1组数据没有限制划动方向和画圈方式,仅限制了移动轨迹样式),在实际观察中,模型B出现了严重的过拟合现象. 因此实际程序中不包含模型B,程序将从另外角度区分划动与画圈手势. 划动手势分类任务中模型整体识别准确率达到96.5%;当仅考虑上、下、左、右4种方向时,整体识别准确率达到98.5%,并且没有数据出现识别成未知类别的情况. 模型分类错误集中在模型F上且集中在斜向方向上(如左下). 原因是手关节弯曲结构使得使用人在做出向左划动手势时不自觉地向下偏移,这使得训练数据与测试数据在左和左下类别中充满噪声. 考虑到数据采集人员对手势舒适度意见反馈,实际使用中将忽略斜向的4种方向.

图 8

5. 控制程序结构与功能

5.1. 程序算法的实现目标

为了使识别程序有能力与智能设备对接,实现智能设备中部分单点手势控制(如阅读器划动翻页、单击确认、图片放大缩小等),将算法分为2个部分:手部状态识别、手部具体运动识别.

5.1.1. 手部状态识别

手部状态指导识别程序状态转移,使程序在不同状态下实现不同功能. 将待识别手部状态分为5类:1)静止且设备未佩戴、2)静止且设备已佩戴、3)点击、4)使用者手部在表面上移动、5)使用者手部在空中移动.

5.1.2. 手部具体运动识别

手部具体运动是指对各个手部状态的细分. 对状态3)、4)进行分类,其中状态3)中确定具体点击次数,状态4)中确定移动为直线轨迹或圆圈轨迹并得到具体移动方向.

5.2. 实时程序的数据流处理

实时程序设置大小为6×800的数据缓冲区,程序每次接收大小为6×40的数据帧以先进先出方式进入数据缓冲区. 数据帧缓冲完成后,程序使用模型A、D、G组合完成分类,获得当前数据状态类别. 程序根据分类结果进行状态转移并根据当前状态与上个状态选择执行功能.

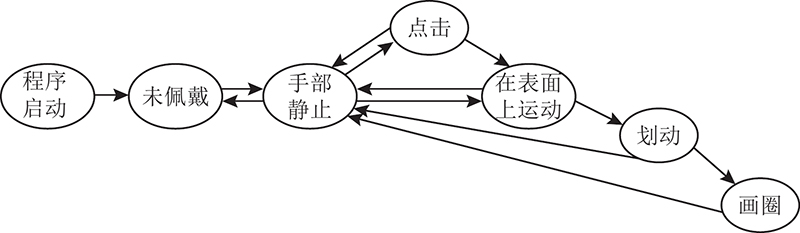

5.3. 状态转移条件

为了减少误识别可能性,设计控制程序状态转移规则,状态转移图如图9所示. 除划动与画圈状态、开机启动与未佩戴状态之间转移条件(开机启动时,状态将自动转移到未佩戴状态)以外,其他状态间转换均由模型A、D、G耦合而成的大模型决定. 状态转移开始时,程序获取模型对当前数据帧识别结果. 若识别状态可达,则转移至下一状态,否则保持原状态不变. 可以观察到,划动属于短时间手势,约持续6~12帧长;画圈属于长时间手势,持续大于20帧长,因此程序根据状态持续时间决定是否向画圈状态转移. 对于点击与在表面上运动状态转移,手与表面刚接触时可能产生小幅度碰撞从而触发点击状态,因此程序增加从“点击”向“在表面上运动”转移的判断,以减少误判情况:若当前分类判断为在表面运动且点击次数为0,则向在表面运动状态转移. 另外,未知类别不会对状态产生影响.

图 9

5.4. 未知类别的判断方法

模型训练中缺乏实际应用中的非目标类别数据(即未知类别数据),因此程序在实际应用中须另外执行未知类别判断以保证自身正常运行.

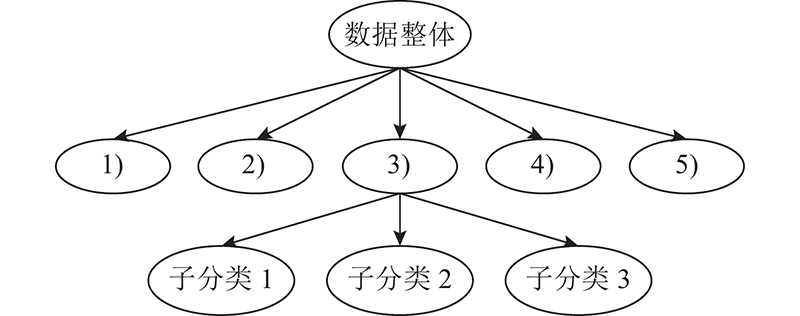

5.4.1. 未知类别识别树

本研究采用勾勒出已知数据边界并拒绝边界外数据的方式进行未知类别识别. 受K-Means聚类算法启发,设计基于已知数据的未知类别识别树,树形结构如图10所示. 计算有标签数据1)~5)组的FFT幅度谱,分别计算其均值xi作为数据中心点. 对每组数据计算每个数据点到数据中心欧式距离,获得距离均值dm和距离标准差ds,相似度判断阈值为

图 10

计算xi的加权平均x0作为数据整体中心,计算xi到x0的欧式距离ci,相似度判断阈值为

数据组3)的距离标准差显著大于其他类别. 使用层次聚类(连接标准为全连接)将数据组3)分为4个子类并舍弃数据量最小的1个子类(88条数据),对剩余3个子类遵循与父类相同方法,计算数据中心点与相似度判断阈值. 实际使用时,数据在进入分类模型前经过识别树判断:若数据到每个中心的欧氏距离都不在阈值范围,则该数据被标记为未知类别.

5.4.2. SoftMax 阈值

对模型SoftMax输出设置0.99的置信度阈值,若最大项输出小于阈值,则标记为未知类.

5.4.3. 针对空中手部移动类别模型

实际使用中,表面上手部移动的误判大部分来自空中手部移动,因此在训练模型A、B、D的同时,训练模型G以区分空中手部运动. 实际使用中,空中手部移动类别并入未知类别以减少对程序的影响.

5.5. 程序功能介绍

5.5.1. 点击计数功能

当程序进入点击状态,程序将对点击计数. 程序首先计算加速度向量模长,使三轴数据合并为一轴,再计算加速度曲线中大于3.5g的峰值个数且各峰值之间最小距离为200个数据点. 计算所得峰值个数即为点击次数.

5.5.2. 划动与画圈分类识别

当程序进入划动状态,程序开始计算状态持续时间,直至返回手部静止状态或进入画圈状态. 程序根据模型E、F获得划动方向,同时根据模型C获得画圈方向并将判断结果放入长度为20的滑动窗口中. 当进入划动状态超过20个数据帧长时,程序进入画圈状态,并以滑动窗口中占比超过50%的方向作为当前方向输出.

5.5.3. 控制信号种类与发送时机

对于点击状态和划动状态,程序从当前状态进入手部静止状态时,向目标发送点击或划动信号;对于未佩戴状态和画圈状态,程序进入当前状态时,向目标发送休眠或画圈开始信号,并在离开当前状态时发送结束信号.

5.6. 模型与程序时延

如表3所示为各模型实际运行的计算时延均值与标准差, 计算过程均在型号为i7-12700的 CPU上完成. 表中,T为计算时延,括号外数字为均值,括号内数字为标准差. 识别程序从数据帧接收到完成单次响应的整体时延为6.01 ms(标准差为6.29 ms).

表 3 模型计算时延的均值与标准差

Tab.3

| 模型名称 | T/ms | 模型名称 | T/ms | |

| A | 0.92(1.95) | E | 1.28(1.86) | |

| C | 1.04(1.34) | F | 2.02(3.28) | |

| D | 0.99(1.75) | G | 1.15(2.76) |

6. 结 论

(1)手部状态间的差异主要体现在频域分布上,手势间的差异主要体现在时域上且频段分布比手部状态的低. 针对数据差异进行差异化建模可以提升数据的可分程度.

(2)使用简单神经网络模型对手部状态数据与手势数据分类,在手部状态数据中达到99%的综合正确率,在2种手势数据中均达到98%的正确率,表明使用单个IMU同时进行手部状态识别与手势识别具有可行性.

(3)搭建实时系统并测量了实际运行下的计算时延,证明了IMU识别手部状态与手势在实际应用环境下的可行性.

(4)本研究侧重于证明使用 IMU 实现手部状态与手势识别的技术路线,忽略了硬件设备的轻量化设计. 本研究最大限度地限制了数据采集端的运算且模型运算量小,可以适应可佩戴设备运算环境,因此本研究的技术路线对应用于未来轻量化设备以及现有可佩戴设备技术集成具有参考意义.

(5)为了应对未来应用中面临的设备便携性与可佩戴设备计算资源限制问题,后续工作计划从设备轻量化与无线化设计、优化模型、减少实时识别程序能耗3个方向展开.

参考文献

A high integrity IMU/GPS navigation loop for autonomous land vehicle applications

[J].DOI:10.1109/70.768189 [本文引用: 1]