[1]

FOGGIA P, SAGGESE A, VENTO M Real-time fire detection for video-surveillance applications using a combination of experts based on color, shape, and motion

[J]. IEEE Transactions on Circuits and Systems for Video Technology , 2015 , 25 (9 ): 1545 - 1556

DOI:10.1109/TCSVT.2015.2392531

[本文引用: 1]

[2]

严云洋, 杜静, 高尚兵, 等 融合多特征的视频火焰检测

[J]. 计算机辅助设计与图形学学报 , 2015 , 27 (3 ): 433 - 440

[本文引用: 3]

YAN Yun-yang, DU Jing, GAO Shang-bing, et al Video flame detection based on fusion of multi-feature

[J]. Journal of Computer-Aided Design and Computer Graphics , 2015 , 27 (3 ): 433 - 440

[本文引用: 3]

[3]

HASHEMZADEH M, ZADEMEHDI A Fire detection for video surveillance applications using ICA k-medoids-based color model and efficient spatio-temporal visual features

[J]. Expert Systems with Applications , 2019 , 130 : 60 - 78

DOI:10.1016/j.eswa.2019.04.019

[本文引用: 2]

[4]

MUHAMMAD K, AHMAD J, BAIK S W Early fire detection using convolutional neural networks during surveillance for effective disaster management

[J]. Neurocomputing , 2018 , 288 : 30 - 42

DOI:10.1016/j.neucom.2017.04.083

[本文引用: 1]

[5]

MUHAMMAD K, AHMAD J, MEHMOOD I, et al Convolutional neural networks based fire detection in surveillance videos

[J]. IEEE Access , 2018 , 6 : 18174 - 18183

DOI:10.1109/ACCESS.2018.2812835

[6]

MUHAMMAD K, AHMAD J, LV Z, et al Efficient deep CNN-based fire detection and localization in video surveillance applications

[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems , 2018 , 49 (7 ): 1419 - 1434

[7]

MUHAMMAD K, KHAN S, ELHOSENY M, et al Efficient fire detection for uncertain surveillance environment

[J]. IEEE Transactions on Industrial Informatics , 2019 , 15 (5 ): 3113 - 3122

DOI:10.1109/TII.2019.2897594

[本文引用: 1]

[8]

LI S, YAN Q, LIU P An efficient fire detection method based on multiscale feature extraction, implicit deep supervision and channel attention mechanism

[J]. IEEE Transactions on Image Processing , 2020 , 29 : 8467 - 8475

DOI:10.1109/TIP.2020.3016431

[本文引用: 1]

[9]

JEON M, CHOI H S, LEE J, et al Multi-scale prediction for fire detection using convolutional neural network

[J]. Fire Technology , 2021 , 57 (5 ): 1 - 19

[本文引用: 1]

[11]

晋耀, 张为 采用Anchor-Free网络结构的实时火灾检测算法

[J]. 浙江大学学报: 工学版 , 2020 , 54 (12 ): 2430 - 2436

[本文引用: 1]

JIN Yao, ZHANG Wei Real-time fire detection algorithm with anchor-free network architecture

[J]. Journal of Zhejiang University: Engineering Science , 2020 , 54 (12 ): 2430 - 2436

[本文引用: 1]

[12]

李欣健, 张大胜, 孙利雷, 等 复杂场景下基于CNN的轻量火焰检测方法

[J]. 模式识别与人工智能 , 2021 , 34 (5 ): 415 - 422

DOI:10.16451/j.cnki.issn1003-6059.202105004

[本文引用: 1]

LI Xin-jian, ZHANG Da-sheng, SUN Li-lei, et al CNN-based lightweight fire detection method in complex scenes

[J]. Pattern Recognition and Artificial Intelligence , 2021 , 34 (5 ): 415 - 422

DOI:10.16451/j.cnki.issn1003-6059.202105004

[本文引用: 1]

[13]

KIM B, LEE J A video-based fire detection using deep learning models

[J]. Applied Sciences , 2019 , 9 (14 ): 2862

DOI:10.3390/app9142862

[本文引用: 1]

[14]

TIAN Z, SHEN C, CHEN H, et al. FCOS: fully convolutional one-stage object detection [C]// Proceedings of the IEEE International Conference on Computer Vision . Seoul: IEEE, 2019: 9627–9636.

[本文引用: 2]

[15]

HAN K, WANG Y, TIAN Q, et al. Ghostnet: more features from cheap operations [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Seattle: IEEE, 2020: 1580-1589.

[本文引用: 2]

[16]

LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 2117–2125.

[本文引用: 1]

[17]

YANG B, BENDER G, LE Q V, et al CondConv: conditionally parameterized convolutions for efficient inference

[J]. Advances in Neural Information Processing Systems , 2019 , 32 : 1307 - 1318

[本文引用: 1]

[18]

HU J, SHEN L, ALBANIE S, et al Squeeze-and-excitation networks

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2020 , 42 (8 ): 2011 - 2023

DOI:10.1109/TPAMI.2019.2913372

[本文引用: 1]

[19]

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module [C]// European Conference on Computer Vision . Munich: Springer, 2018: 1-19.

[本文引用: 1]

[20]

REZATOFIGHI H, TSOI N, GWAK J, et al. Generalized intersection over union: a metric and a loss for bounding box regression [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Long Beach: IEEE, 2019: 658-666.

[本文引用: 1]

[21]

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft coco: common objects in context [C]// European Conference on Computer Vision . Zurich: Springer, 2014: 740-755.

[本文引用: 1]

[22]

MA N, ZHANG X, ZHENG H T, et al. Shufflenet v2: practical guidelines for efficient CNN architecture design [C]// Proceedings of the European Conference on Computer Vision . Munich: Springer, 2018: 116-131.

[本文引用: 1]

[23]

SANDLER M, HOWARD A, ZHU M, et al. Mobilenetv2: inverted residuals and linear bottlenecks [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 4510-4520.

[本文引用: 1]

[24]

HOWARD A, SANDLER M, CHEN B, et al. Searching for mobilenetv3 [C]// International Conference on Computer Vision . Seoul: IEEE, 2019: 1314-1324.

[本文引用: 1]

[25]

KO B C, CHEONG K H, NAM J Y Fire detection based on vision sensor and support vector machines

[J]. Fire Safety Journal , 2009 , 44 (3 ): 322 - 329

DOI:10.1016/j.firesaf.2008.07.006

[本文引用: 1]

[26]

BORGES P V K, IZQUIERDO E A probabilistic approach for vision-based fire detection in videos

[J]. IEEE Transactions on Circuits and Systems for Video Technology , 2010 , 20 (5 ): 721 - 731

DOI:10.1109/TCSVT.2010.2045813

[本文引用: 1]

[27]

TRUONG T X, KIM J M Fire flame detection in video sequences using multi-stage pattern recognition techniques

[J]. Engineering Applications of Artificial Intelligence , 2012 , 25 (7 ): 1365 - 1372

DOI:10.1016/j.engappai.2012.05.007

[本文引用: 1]

[28]

KONG S G, JIN D, LI S Fast fire flame detection in surveillance video using logistic regression and temporal smoothing

[J]. Fire Safety Journal , 2016 , 79 : 37 - 43

DOI:10.1016/j.firesaf.2015.11.015

[本文引用: 2]

[29]

吴茜茵, 严云洋, 杜静, 等 多特征融合的火焰检测算法

[J]. 智能系统学报 , 2015 , 10 (2 ): 240 - 247

DOI:10.3969/j.issn.1673-4785.201406022

[本文引用: 1]

WU Xi-yin, YAN Yun-yang, DU Jing, et al Fire detection based on fusion of multiple features

[J]. CAAI Transactions on Intelligent Systems , 2015 , 10 (2 ): 240 - 247

DOI:10.3969/j.issn.1673-4785.201406022

[本文引用: 1]

[30]

梅建军, 张为 基于ViBe与机器学习的早期火灾监测算法

[J]. 光学学报 , 2018 , 38 (7 ): 60 - 67

[本文引用: 2]

MEI Jian-jun, ZHANG Wei Early fire detection algorithm based on ViBe and machine learning

[J]. Acta Optica Sinica , 2018 , 38 (7 ): 60 - 67

[本文引用: 2]

[31]

KANG L W, WANG I S, CHOU K L, et al. Image-based real-time fire detection using deep learning with data augmentation for vision-based surveillance applications [C]// 16th IEEE International Conference on Advanced Video and Signal Based Surveillance . Taipei: IEEE, 2019: 1-4.

[本文引用: 1]

[32]

DAI Z. Image flame detection method based on improved yolov3 [C]// IOP Conference Series: Earth and Environmental Science . Xi’an: IOP Publishing, 2021, 693(1): 012012.

[本文引用: 1]

[33]

AHMED H, JIE Z, USMAN M. Lightweight fire detection system using hybrid edge-cloud computing [C]// 4th IEEE International Conference on Computer and Communication Engineering Technology . Beijing: IEEE, 2021: 153-157.

[本文引用: 1]

Real-time fire detection for video-surveillance applications using a combination of experts based on color, shape, and motion

1

2015

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

融合多特征的视频火焰检测

3

2015

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

... Comparison with fire detection algorithms based on traditional image features

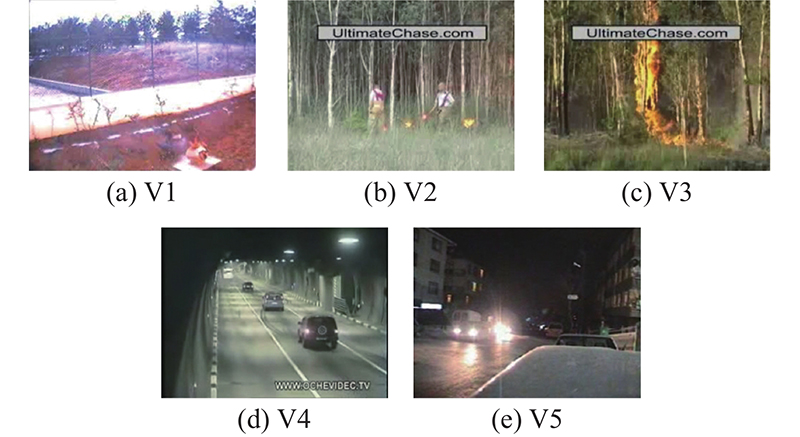

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

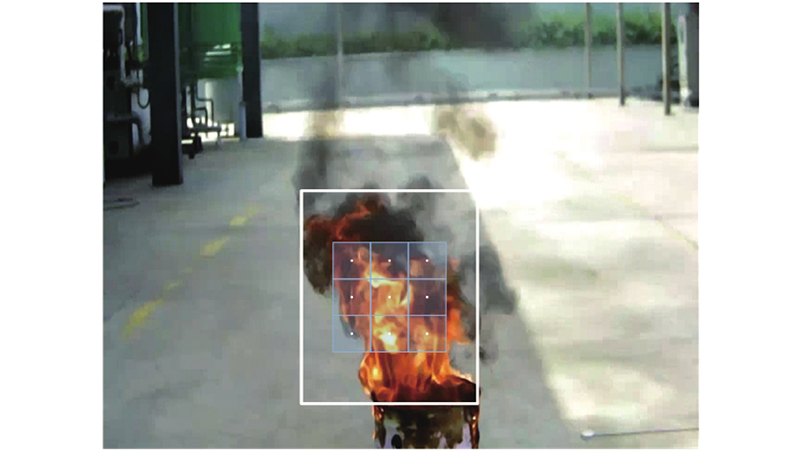

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

... 为了探究本文火灾检测算法的性能,将本文算法与基于传统图像特征的火灾检测方法进行对比实验. 表4 中,“—”表示文献中没有相关数据. 可以看出,改进后的本文算法2在4个视频上的实验结果最优,对于存在移动车灯干扰的视频V4,检测精度略低于利用运动特征的火灾检测算法[28 ,2 ,30 ] . 如图7 所示为部分误报案例,由于夜间光源在图像中存在光晕和星芒现象,导致夜间车灯与火焰的静态特征非常相似,这对仅凭单张图像判定的轻量级火灾检测网络存在挑战. ...

融合多特征的视频火焰检测

3

2015

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

... 为了探究本文火灾检测算法的性能,将本文算法与基于传统图像特征的火灾检测方法进行对比实验. 表4 中,“—”表示文献中没有相关数据. 可以看出,改进后的本文算法2在4个视频上的实验结果最优,对于存在移动车灯干扰的视频V4,检测精度略低于利用运动特征的火灾检测算法[28 ,2 ,30 ] . 如图7 所示为部分误报案例,由于夜间光源在图像中存在光晕和星芒现象,导致夜间车灯与火焰的静态特征非常相似,这对仅凭单张图像判定的轻量级火灾检测网络存在挑战. ...

Fire detection for video surveillance applications using ICA k-medoids-based color model and efficient spatio-temporal visual features

2

2019

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

Early fire detection using convolutional neural networks during surveillance for effective disaster management

1

2018

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

Convolutional neural networks based fire detection in surveillance videos

0

2018

Efficient deep CNN-based fire detection and localization in video surveillance applications

0

2018

Efficient fire detection for uncertain surveillance environment

1

2019

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

An efficient fire detection method based on multiscale feature extraction, implicit deep supervision and channel attention mechanism

1

2020

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

Multi-scale prediction for fire detection using convolutional neural network

1

2021

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

Information-guided flame detection based on faster R-CNN

1

2020

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

采用Anchor-Free网络结构的实时火灾检测算法

1

2020

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

采用Anchor-Free网络结构的实时火灾检测算法

1

2020

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

复杂场景下基于CNN的轻量火焰检测方法

1

2021

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

复杂场景下基于CNN的轻量火焰检测方法

1

2021

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

A video-based fire detection using deep learning models

1

2019

... 基于视觉的火灾检测方法通常利用火焰的颜色、纹理、形状、运动等手工特征,结合分类器进行判别. Foggia等[1 ] 提出基于多专家系统的火灾检测方法,该方法利用了火焰的颜色、形状和运动特征. 严云洋等[2 ] 提出融合颜色、纹理和动态特征的火焰检测方法. Hashemzadeh等[3 ] 利用基于K-medoids聚类的颜色模型和运动信息提取疑似火灾区域,通过支持向量机对时空特征进行分类. 随着深度学习技术的发展,研究人员将注意力转向使用卷积神经网络(convolutional neural networks, CNN)提取火焰的特征. Muhammad等[4 -7 ] 利用AlexNet、GoogLeNet、SqueezeNet和MobileNetV2等经典网络进行火灾检测. Li等[8 ] 通过多尺度特征融合、跳跃连接和注意力机制,改进AlexNet. Jeon等[9 ] 提出基于CNN的多尺度火灾预测模型. 将火灾检测视为分类任务,无法获得火焰在图像中的位置,因此目标检测网络被广泛研究. Chaoxia等[10 ] 使用颜色引导锚框和全局信息策略改进 Faster R-CNN,以提高计算效率和准确率. 晋耀等[11 ] 提出基于无锚框结构的火灾检测算法,平衡检测精度和速度. 李欣健等[12 ] 利用深度可分离卷积优化YOLO网络结构,通过数据增强和改进损失函数来提高精度. Kim等[13 ] 使用长短期记忆网络提取连续帧的火焰特征,对多帧的检测结果作出综合判断,但复杂度过高的模型难以部署. ...

2

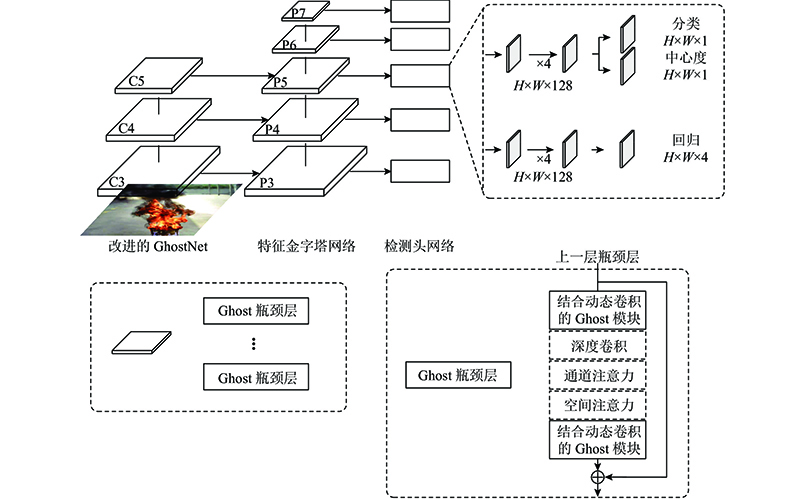

... 鉴于上述各方法存在的局限性,综合考虑火灾定位、检测精度和模型复杂度,将无锚框、单阶段的目标检测网络FCOS[14 ] 作为基础网络展开研究. 本文提出基于改进GhostNet-FCOS的火灾检测方法,选用轻量化网络GhostNet[15 ] 作为主干网络,降低特征金字塔网络(feature pyramid networks,FPN)[16 ] 和检测头网络的通道维数. 针对火焰这类非刚性物体,采用动态卷积改进GhostNet,在不增加网络宽度和深度的情况下提高特征提取能力. 在GhostNet中增加空间注意力模块,提高主干网络对火焰的空间特征提取能力. 利用中心采样和中心度分支分别改进正负样本定义和回归损失权重,优化训练过程中检测网络对不同区域的关注程度. ...

... FCOS算法是由Tian等[14 ] 提出的全卷积、无锚框的单阶段目标检测网络. 该算法的基本思想是通过对图像内的每个位置进行分类和回归,达到目标检测的目的. 无锚框结构避免了锚框的超参数问题,减少了内存占用. FCOS网络的结构灵活,检测精度高,是具有代表性的无锚框目标检测网络,因此将其作为本文火灾检测算法的基础网络. 如图1 所示为基于改进GhostNet-FCOS的火灾检测算法的整体结构图. FPN可以结合强语义特征与高分辨率特征,提高对不同尺度火焰的检测效果. FPN 的特征层为P3、P4、P5、P6和P7,对应的下采样率分别为8、16、32、64和128. 如图1 所示,P3、P4和P5由GhostNet的特征层C3、C4和C5生成. P6和P7分别为P5和P6经过3×3卷积生成. 检测头网络由3个分支组成,分别用于分类预测、回归预测和中心度预测. 分类分支前4个特征图的尺寸为H×W× 128,最后一个特征图的通道数表示类别数,火焰检测的类别数为1,故尺寸为H×W× 1. 中心度分支与分类分支共享前4个特征图,最后一个特征图的尺寸为H×W× 1. 回归分支的前4个特征图尺寸为H×W× 128,最后一个特征图的尺寸为H×W× 4,表示每个采样点的位置信息. ...

2

... 鉴于上述各方法存在的局限性,综合考虑火灾定位、检测精度和模型复杂度,将无锚框、单阶段的目标检测网络FCOS[14 ] 作为基础网络展开研究. 本文提出基于改进GhostNet-FCOS的火灾检测方法,选用轻量化网络GhostNet[15 ] 作为主干网络,降低特征金字塔网络(feature pyramid networks,FPN)[16 ] 和检测头网络的通道维数. 针对火焰这类非刚性物体,采用动态卷积改进GhostNet,在不增加网络宽度和深度的情况下提高特征提取能力. 在GhostNet中增加空间注意力模块,提高主干网络对火焰的空间特征提取能力. 利用中心采样和中心度分支分别改进正负样本定义和回归损失权重,优化训练过程中检测网络对不同区域的关注程度. ...

... 较高的模型复杂度阻碍了FCOS在监控系统中的广泛应用.GhostNet是Han等[15 ] 提出的在多个计算机视觉任务中具有出色表现的轻量化分类网络. 引入GhostNet作为FCOS的主干网络,可以大幅度地降低模型复杂度. 为了应对真实环境中复杂多变的火焰,特征提取和表示能力需要进一步的提升. 引入动态卷积和空间注意力模块,改进GhostNet的Ghost模块与Ghost瓶颈层,提高网络对火焰图像的特征提取能力. 如图1 所示,主干网络的特征层包含若干Ghost瓶颈层,所有Ghost瓶颈层均包含2个改进的Ghost模块,步长为2的Ghost瓶颈层利用深度卷积进行下采样,部分Ghost瓶颈层包含通道注意力和空间注意力模块. 主干网络的参数细节如表1 所示. 为了与轻量化的主干网络相匹配,将FPN和检测头网络分支的特征通道维数均由256调整至128. ...

1

... 鉴于上述各方法存在的局限性,综合考虑火灾定位、检测精度和模型复杂度,将无锚框、单阶段的目标检测网络FCOS[14 ] 作为基础网络展开研究. 本文提出基于改进GhostNet-FCOS的火灾检测方法,选用轻量化网络GhostNet[15 ] 作为主干网络,降低特征金字塔网络(feature pyramid networks,FPN)[16 ] 和检测头网络的通道维数. 针对火焰这类非刚性物体,采用动态卷积改进GhostNet,在不增加网络宽度和深度的情况下提高特征提取能力. 在GhostNet中增加空间注意力模块,提高主干网络对火焰的空间特征提取能力. 利用中心采样和中心度分支分别改进正负样本定义和回归损失权重,优化训练过程中检测网络对不同区域的关注程度. ...

CondConv: conditionally parameterized convolutions for efficient inference

1

2019

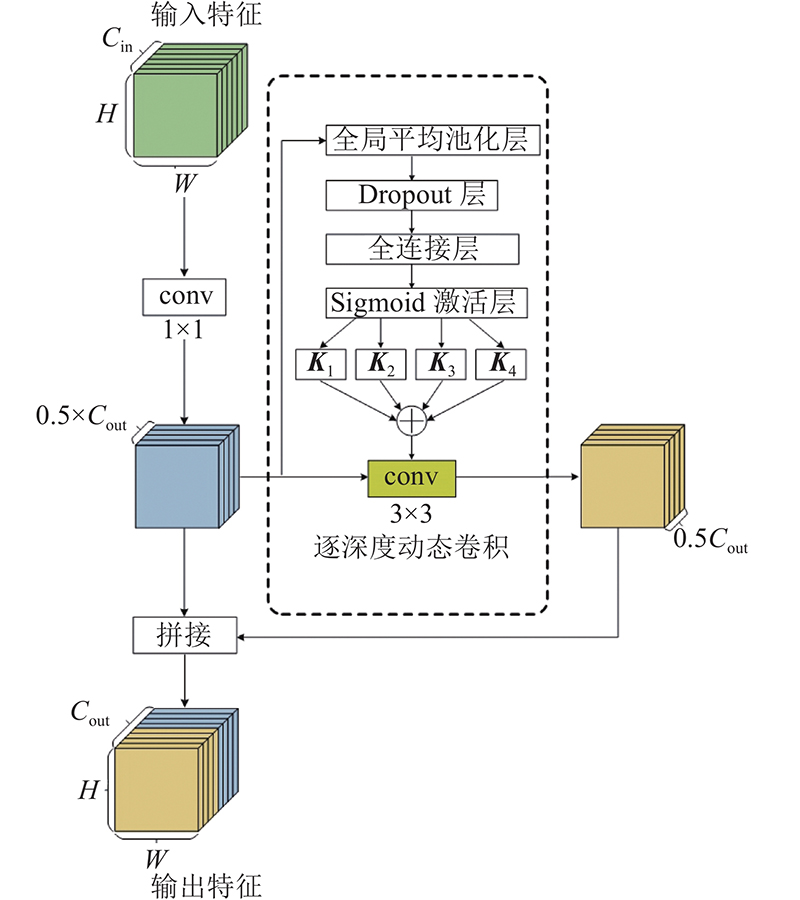

... 动态卷积的基本思想是根据输入图像,自适应地调整卷积核参数,在实现方式上参考了文献[17 ]. 对于动态卷积,卷积核参数是由4个具有相同大小和维度的卷积核加权计算得到的,4个卷积核的权重是通过输入特征计算得到的,如图2 所示. 对于输入特征图 $ {\boldsymbol{x}} $

Squeeze-and-excitation networks

1

2020

... 为了选择对目标任务具有显著贡献的特征,GhostNet引入通道注意力[18 ] 来衡量不同通道特征的重要程度. 随着卷积层的叠加,语义信息不断丰富,不同空间位置的特征信息与火焰的关联程度不同,但仅依靠通道注意力的GhostNet难以筛选出贡献显著的空间位置. 为了丰富特征的空间表达,筛选出对火焰识别贡献较大的特征空间位置,在GhostNet的瓶颈层中增加空间注意力模块. ...

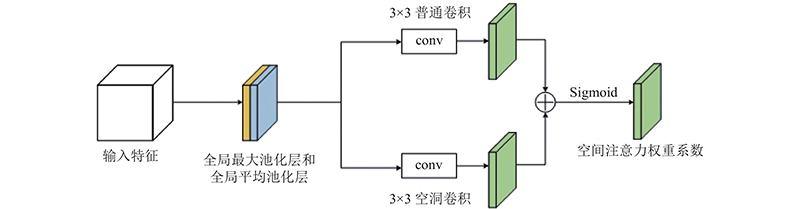

1

... 空间注意力模块如图3 所示,实现方式如下. 对于高、宽和通道数分别为H×W× C 的输入特征,参考CBAM[19 ] 分别进行通道维度的平均池化操作和最大池化操作,得到2个H×W× 1的特征,并将其拼接在一起. 经过3×3普通卷积和3×3空洞卷积,特征图相加后通过Sigmoid激活函数,得到特征空间维度的权重系数. ...

1

... 式中: $ {L_{{\text{reg}}}} $ $ {L_{{\text{GIoU}}}} $ [20 ] 回归损失, $ {t_{x,y}} $ $ t_{x,y}^* $

1

... 由于目前尚无公开的具有标注框的火灾检测数据集,根据MS COCO数据集[21 ] 格式创建具有标注框的火灾检测数据集. 数据集共有13 655张图像,其中训练集有10 070张,测试集有3 585张. 数据源自42个真实火灾视频和95个实验火灾视频,包括工厂、学校、地铁站、停车场、超市和寺庙等数百个场景,涵盖室内、室外、日间、夜间和光线干扰等复杂情况,以尽可能地模拟真实应用环境. 自建火灾数据集上进行的实验使用AP50 和AR作为主要的评价指标. ...

1

... 将轻量级主干网络ShuffleNetV2[22 ] 、MobileNetV2[23 ] 、MobileNetV3[24 ] 、GhostNet替换FCOS原主干网络ResNet50,在自建火灾数据集上进行对比实验,结果如表2 所示. 表中,AP50 为平均精确率,AR为平均召回率,FLOPS为浮点计算量,g 为分组数量,P 为参数量,v 为速度. FCOS在主干网络替换为轻量级网络并降低通道数后,参数量和浮点计算量明显降低,速度提升,其中ShuffleNetV2速度快于MobileNet系列和GhostNet. 鉴于引入轻量级网络后的速度均满足实时火灾检测的需求,综合考虑检测精度、参数量和计算量,GhostNet较其他轻量级网络具有一定的优势. ...

1

... 将轻量级主干网络ShuffleNetV2[22 ] 、MobileNetV2[23 ] 、MobileNetV3[24 ] 、GhostNet替换FCOS原主干网络ResNet50,在自建火灾数据集上进行对比实验,结果如表2 所示. 表中,AP50 为平均精确率,AR为平均召回率,FLOPS为浮点计算量,g 为分组数量,P 为参数量,v 为速度. FCOS在主干网络替换为轻量级网络并降低通道数后,参数量和浮点计算量明显降低,速度提升,其中ShuffleNetV2速度快于MobileNet系列和GhostNet. 鉴于引入轻量级网络后的速度均满足实时火灾检测的需求,综合考虑检测精度、参数量和计算量,GhostNet较其他轻量级网络具有一定的优势. ...

1

... 将轻量级主干网络ShuffleNetV2[22 ] 、MobileNetV2[23 ] 、MobileNetV3[24 ] 、GhostNet替换FCOS原主干网络ResNet50,在自建火灾数据集上进行对比实验,结果如表2 所示. 表中,AP50 为平均精确率,AR为平均召回率,FLOPS为浮点计算量,g 为分组数量,P 为参数量,v 为速度. FCOS在主干网络替换为轻量级网络并降低通道数后,参数量和浮点计算量明显降低,速度提升,其中ShuffleNetV2速度快于MobileNet系列和GhostNet. 鉴于引入轻量级网络后的速度均满足实时火灾检测的需求,综合考虑检测精度、参数量和计算量,GhostNet较其他轻量级网络具有一定的优势. ...

Fire detection based on vision sensor and support vector machines

1

2009

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

A probabilistic approach for vision-based fire detection in videos

1

2010

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

Fire flame detection in video sequences using multi-stage pattern recognition techniques

1

2012

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

Fast fire flame detection in surveillance video using logistic regression and temporal smoothing

2

2016

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

... 为了探究本文火灾检测算法的性能,将本文算法与基于传统图像特征的火灾检测方法进行对比实验. 表4 中,“—”表示文献中没有相关数据. 可以看出,改进后的本文算法2在4个视频上的实验结果最优,对于存在移动车灯干扰的视频V4,检测精度略低于利用运动特征的火灾检测算法[28 ,2 ,30 ] . 如图7 所示为部分误报案例,由于夜间光源在图像中存在光晕和星芒现象,导致夜间车灯与火焰的静态特征非常相似,这对仅凭单张图像判定的轻量级火灾检测网络存在挑战. ...

多特征融合的火焰检测算法

1

2015

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

多特征融合的火焰检测算法

1

2015

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

基于ViBe与机器学习的早期火灾监测算法

2

2018

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

... 为了探究本文火灾检测算法的性能,将本文算法与基于传统图像特征的火灾检测方法进行对比实验. 表4 中,“—”表示文献中没有相关数据. 可以看出,改进后的本文算法2在4个视频上的实验结果最优,对于存在移动车灯干扰的视频V4,检测精度略低于利用运动特征的火灾检测算法[28 ,2 ,30 ] . 如图7 所示为部分误报案例,由于夜间光源在图像中存在光晕和星芒现象,导致夜间车灯与火焰的静态特征非常相似,这对仅凭单张图像判定的轻量级火灾检测网络存在挑战. ...

基于ViBe与机器学习的早期火灾监测算法

2

2018

... Comparison with fire detection algorithms based on traditional image features

Tab.4 算法 TPR/% TNR/% V1 V2 V3 V4 V5 文献[25 ] 92.50 94.21 — 95.45 — 文献[26 ] 92.25 94.59 — 96.15 — 文献[27 ] 93.00 94.98 — 96.50 — 文献[28 ] 93.10 95.70 — 100 — 文献[2 ] 96.15 100.0 94.29 100 95.20 文献[29 ] — 91.20 — 95.80 — 文献[3 ] 93.30 — — — 94.70 文献[30 ] 91.00 93.00 — 100 — 本文算法1 96.66 96.53 99.59 95.41 96.10 本文算法2 98.75 100 100 99.23 99.35

图 7 Ghost-FCOS在改进前、后的检测效果对比 ...

... 为了探究本文火灾检测算法的性能,将本文算法与基于传统图像特征的火灾检测方法进行对比实验. 表4 中,“—”表示文献中没有相关数据. 可以看出,改进后的本文算法2在4个视频上的实验结果最优,对于存在移动车灯干扰的视频V4,检测精度略低于利用运动特征的火灾检测算法[28 ,2 ,30 ] . 如图7 所示为部分误报案例,由于夜间光源在图像中存在光晕和星芒现象,导致夜间车灯与火焰的静态特征非常相似,这对仅凭单张图像判定的轻量级火灾检测网络存在挑战. ...

1

... Comparison with lightweight object detection network used in fire detection

Tab.5 算法 AP50 /% AR/% P /106 FLOPs/109 YOLOV3 Tiny [31 ] 76.5 43.2 8.67 16.24 YOLOV3-MobileNet[32 ] 82.6 46.8 22.67 53.46 SSD-MobileNetV2 [33 ] 76.6 46.9 5.45 8.08 本文算法 90.9 55.1 4.58 31.45

图 8 实验与真实火灾的检测效果图 ...

1

... Comparison with lightweight object detection network used in fire detection

Tab.5 算法 AP50 /% AR/% P /106 FLOPs/109 YOLOV3 Tiny [31 ] 76.5 43.2 8.67 16.24 YOLOV3-MobileNet[32 ] 82.6 46.8 22.67 53.46 SSD-MobileNetV2 [33 ] 76.6 46.9 5.45 8.08 本文算法 90.9 55.1 4.58 31.45

图 8 实验与真实火灾的检测效果图 ...

1

... Comparison with lightweight object detection network used in fire detection

Tab.5 算法 AP50 /% AR/% P /106 FLOPs/109 YOLOV3 Tiny [31 ] 76.5 43.2 8.67 16.24 YOLOV3-MobileNet[32 ] 82.6 46.8 22.67 53.46 SSD-MobileNetV2 [33 ] 76.6 46.9 5.45 8.08 本文算法 90.9 55.1 4.58 31.45

图 8 实验与真实火灾的检测效果图 ...