为了进一步测试不同挑战场景下算法的跟踪性能,测试并记录上述5种算法在光照变化(illumination variation, IV)、非平面内旋转(out-of-plane rotation, OPR)、尺度变化(scale variation, SV)、遮挡(occlusion, OCC)、非刚性变换(deformation, DEF)、运动模糊(motion blur, MB)、快速运动(fast motion, FM)、平面内旋转(in-plane-rotation, IPR)、离开视野(out-of-view, OV)、背景杂乱(background clutters, BC)、低分辨率(low resolution, LR)等11种挑战场景序列下的跟踪效果.

[1]

陈政. 智能监控系统中运动检测与目标跟踪模块的设计与实现[D]. 哈尔滨: 哈尔滨工业大学, 2020: 11-21.

[本文引用: 1]

CHEN Zheng. Design and implementation of motion detection and tracking module in intelligent surveilance system [D]. Harbin: Harbin Institute of Technology, 2020: 11-21.

[本文引用: 1]

[2]

黄石磊. 基于视觉计算的运动目标跟踪及异常行为分析[D]. 郑州: 郑州大学, 2014: 42-47.

[本文引用: 1]

HUANG Shi-lei. Moving target tracking and abnormal behavior analysis based on visual calculation [D]. Zhengzhou: Zhengzhou University, 2014: 42-47.

[本文引用: 1]

[3]

吴昊, 姜文斌, 陆增洁, 等 机器人视觉动态目标跟踪的最优方案研究

[J]. 信息与电脑 , 2020 , (1 ): 129 - 130

[本文引用: 1]

WU Hao, JIANG Wen-bin, LU Zeng-jie, et al Research on optimal scheme of robot vision dynamic target tracking

[J]. China Computer and Communication , 2020 , (1 ): 129 - 130

[本文引用: 1]

[4]

程相博, 李建胜, 胡鹏, 等 改进的GOTURN算法

[J]. 测绘科学技术学报 , 2018 , 35 (6 ): 605 - 608

[本文引用: 1]

CHENG Xiang-bo, LI Jian-sheng, HU Peng, et al An improved algorithm of the generic object tracking using regression networks

[J]. Journal of Geomatics Science and Technology , 2018 , 35 (6 ): 605 - 608

[本文引用: 1]

[5]

葛宝义, 左宪章, 胡永江 视觉目标跟踪方法研究综述

[J]. 中国图象图形学报 , 2018 , 23 (8 ): 1091 - 1107

DOI:10.11834/jig.170604

[本文引用: 1]

GE Bao-yi, ZUO Xian-zhang, HU Yong-jiang Review of visual object tracking technology

[J]. Journal of Image and Graphics , 2018 , 23 (8 ): 1091 - 1107

DOI:10.11834/jig.170604

[本文引用: 1]

[6]

BOLME D S, BEVERIDGE J R, DRAPER B A , et al. Visual object tracking using adaptive correlation filters [C]// 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco: IEEE, 2010: 2544-2550.

[本文引用: 1]

[7]

HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//Proceedings of European Conference on Computer Vision . Berlin: Springer Verlag, 2012: 702-715.

[本文引用: 1]

[8]

HENRIQUES J F, CASEIRO R, MARTINS P, et al High-speed tracking with kernelized correlation filters

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2015 , 37 (3 ): 583 - 596

DOI:10.1109/TPAMI.2014.2345390

[本文引用: 1]

[9]

DANELLJAN M, HÄGER G, KHAN F S, et al Discriminative scale space tracking

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2017 , 39 (8 ): 1561 - 1575

DOI:10.1109/TPAMI.2016.2609928

[本文引用: 1]

[10]

LI Y, ZHU J. A Scale adaptive kernel correlation filter tracker with feature integration [M]// AGAPITO L, BRONSTEIN M, ROTHER C, et al. Computer vision: ECCV 2014. [S.l.]: Springer, 2014: 254-265.

[本文引用: 1]

[11]

DANELLJAN M, HÄGER G, KHAN F S, et al. Learning spatially regularized correlation filters for visual tracking [C]// 2015 IEEE International Conference on Computer Vision . Santiago: IEEE, 2015: 4310-4318.

[本文引用: 1]

[12]

DANELLJAN M, HÄGER, KHAN F S, et al. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking [C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition . Las Vegas: IEEE, 2016: 1430-1438.

[本文引用: 1]

[13]

DANELLJAN M, HÄGER G, KHAN F S, et al. Beyond correlation filters: Learning continuous convolution operators for visual tracking [C]// European Conference on Computer Vision . Amsterdam: Springer, 2016: 472-488.

[本文引用: 1]

[14]

DANELLJAN M, BHAT G, KHAN F S, et al. ECO: efficient convolution operators for tracking [C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 6638-6646.

[本文引用: 5]

[15]

FELZENSZWALB P F, GIRSHICK R B, MCALLESTER D, et al Object detection with discriminatively trained part-based models

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2010 , 32 (9 ): 1627 - 1645

DOI:10.1109/TPAMI.2009.167

[本文引用: 1]

[16]

DANELLJAN M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking [C]// 2014 IEEE Conference on Computer Vision and Pattern Recognition . Columbus: IEEE, 2014: 1090-1097.

[本文引用: 1]

[17]

WANG M, LIU Y, HUANG Z. Large margin object tracking with circulant feature maps [C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 4800-4808.

[本文引用: 1]

[18]

周勇. 改进的卡尔曼滤波在目标跟踪中的应用[D]. 哈尔滨: 哈尔滨工程大学, 2016: 19-29.

[本文引用: 1]

ZHOU Yong. Application of the improved Kalman filter in target tracking [D]. Harbin: Harbin Institute of Technology, 2016: 19-29.

[本文引用: 1]

[19]

WU Y, LIM J, YANG M H Object tracking benchmark

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2015 , 37 (9 ): 1834 - 1848

DOI:10.1109/TPAMI.2014.2388226

[本文引用: 4]

[20]

KRISTAN M, MATAS J, LEONARDIS A, et al A novel performance evaluation methodology for single-target trackers

[J]. IEEE transactions on pattern analysis and machine intelligence , 2016 , 38 (11 ): 2137 - 2155

DOI:10.1109/TPAMI.2016.2516982

[本文引用: 3]

1

... 视觉目标跟踪是计算机视觉的重要基础,也是智能监控 [ 1 ] 、视觉行为分析 [ 2 ] 和视觉导航 [ 3 ] 的关键技术. 它着眼于解决一般物体的跟踪问题,依托初始帧给定的目标位置与尺度信息初始化跟踪算法模型,在后续帧里对目标进行持续准确地定位. ...

1

... 视觉目标跟踪是计算机视觉的重要基础,也是智能监控 [ 1 ] 、视觉行为分析 [ 2 ] 和视觉导航 [ 3 ] 的关键技术. 它着眼于解决一般物体的跟踪问题,依托初始帧给定的目标位置与尺度信息初始化跟踪算法模型,在后续帧里对目标进行持续准确地定位. ...

1

... 视觉目标跟踪是计算机视觉的重要基础,也是智能监控 [ 1 ] 、视觉行为分析 [ 2 ] 和视觉导航 [ 3 ] 的关键技术. 它着眼于解决一般物体的跟踪问题,依托初始帧给定的目标位置与尺度信息初始化跟踪算法模型,在后续帧里对目标进行持续准确地定位. ...

1

... 视觉目标跟踪是计算机视觉的重要基础,也是智能监控 [ 1 ] 、视觉行为分析 [ 2 ] 和视觉导航 [ 3 ] 的关键技术. 它着眼于解决一般物体的跟踪问题,依托初始帧给定的目标位置与尺度信息初始化跟踪算法模型,在后续帧里对目标进行持续准确地定位. ...

机器人视觉动态目标跟踪的最优方案研究

1

2020

... 视觉目标跟踪是计算机视觉的重要基础,也是智能监控 [ 1 ] 、视觉行为分析 [ 2 ] 和视觉导航 [ 3 ] 的关键技术. 它着眼于解决一般物体的跟踪问题,依托初始帧给定的目标位置与尺度信息初始化跟踪算法模型,在后续帧里对目标进行持续准确地定位. ...

机器人视觉动态目标跟踪的最优方案研究

1

2020

... 视觉目标跟踪是计算机视觉的重要基础,也是智能监控 [ 1 ] 、视觉行为分析 [ 2 ] 和视觉导航 [ 3 ] 的关键技术. 它着眼于解决一般物体的跟踪问题,依托初始帧给定的目标位置与尺度信息初始化跟踪算法模型,在后续帧里对目标进行持续准确地定位. ...

改进的GOTURN算法

1

2018

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

改进的GOTURN算法

1

2018

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

视觉目标跟踪方法研究综述

1

2018

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

视觉目标跟踪方法研究综述

1

2018

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

1

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

1

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

High-speed tracking with kernelized correlation filters

1

2015

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

Discriminative scale space tracking

1

2017

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

1

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

1

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

1

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

1

... 判别类目标跟踪方法 [ 4 ] 关注异类数据之间的差异性,将目标从背景中分离出来实现跟踪,使跟踪准确率显著提高. 相关滤波类算法 [ 5 ] 具有速度优势,是判别类方法的重要分支,被广泛地应用于工业实践. Bolme等 [ 6 ] 提出最小输出平方和误差滤波将相关滤波思想引入目标跟踪领域,此后改进算法相继出现,跟踪效果也不断提升. 基于核函数的循环结构(exploiting the circulant structure of tracking-by-detection with kernels, CSK) [ 7 ] 针对最小平方和误差滤波中样本冗余的问题,引入循环移位与核方法. 核相关滤波(kernel correlation filter, KCF) [ 8 ] 在理论上完善了CSK中岭回归的数学技巧推导,同时增加了多通道特征. 判别式尺度空间跟踪器(discriminative scale space tracker, DSST) [ 9 ] 与基于特征融合的尺度自适应核相关滤波 [ 10 ] 从2个不同的角度解决了跟踪尺度自适应问题. 空间正则化滤波(spatially regularized discriminative correlation filter, SRDCF) [ 11 ] 使用空间正则化减轻了傅里叶变换带来的边界效应影响,自适应去污空间正则化滤波(SRDCFdecon) [ 12 ] 在此基础上改进了样本和学习率的问题. 提升改进算法的跟踪精度往往以牺牲速度为代价,连续卷积算子视觉跟踪(continuous convolution operators for visual tracking, C-COT) [ 13 ] 将深度特征融入相关滤波框架,在连续空间域学习滤波器,实现多分辨率特征图的融合和精确的子网格定位,跟踪精度达到新高峰,但CPU下的运行速度不超过1 帧/s,不能满足实时需求. ...

5

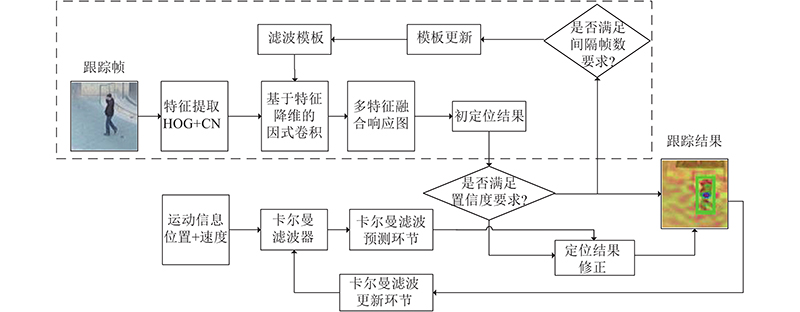

... Danelljan等 [ 14 ] 分析制约相关滤波类算法速度的主要因素,提出高效卷积算子 (efficient convolution operator, ECO). 该算法使用因式卷积实现特征降维,高斯混合模型减少样本数量,间隔帧更新减少更新频率,从特征复杂度、训练集大小和模板更新策略上大幅减少计算量,提高了C-COT算法的时间和空间效率. Danelljan等 [ 14 ] 提供了高效卷积算子的2种实现形式:1)基于卷积特征的ECO算法,2)基于人工特征方向梯度直方图 (histogram of oriente gridients, HOG) [ 15 ] 与颜色命名 (color names, CN) [ 16 ] 的ECO-HC算法. 形式2)的精度虽然略低于形式1)的,但在CPU下具有实时运算速度. 这2种实现形式均缺少跟踪质量判断和滤波模板更新监督机制,使目标跟踪连续定位和模板更新存在很大风险. 一方面,当跟踪质量较差时,继续使用原有定位结果会导致下一帧目标搜索范围偏移,影响后续帧的跟踪效果;另一方面,当出现遮挡、目标离开视野范围时,按照间隔特定帧更新模型会持续引入背景噪声,导致跟踪漂移与失败. ...

... [ 14 ] 提供了高效卷积算子的2种实现形式:1)基于卷积特征的ECO算法,2)基于人工特征方向梯度直方图 (histogram of oriente gridients, HOG) [ 15 ] 与颜色命名 (color names, CN) [ 16 ] 的ECO-HC算法. 形式2)的精度虽然略低于形式1)的,但在CPU下具有实时运算速度. 这2种实现形式均缺少跟踪质量判断和滤波模板更新监督机制,使目标跟踪连续定位和模板更新存在很大风险. 一方面,当跟踪质量较差时,继续使用原有定位结果会导致下一帧目标搜索范围偏移,影响后续帧的跟踪效果;另一方面,当出现遮挡、目标离开视野范围时,按照间隔特定帧更新模型会持续引入背景噪声,导致跟踪漂移与失败. ...

... 滤波器组中有许多滤波器对定位几乎没有贡献,却占用着大量的计算资源 [ 14 ] . ECO算法不再为每个特征通道单独训练滤波器,而是将特征通道对应的滤波器表示为一组贡献度较大的滤波器组 ${f}^{\mathrm{C}}=\{{f}^{1},{f}^{2},\cdots,{f}^{C}\} (C \lt D)$ ${D}\times {C}$ ${{\boldsymbol{P}}}=\left({p}_{d,c}\right)$

... 式中: $ J\left\{x\right\} $ ${F}_{{f}^{\mathrm{C}}}\left\{x\right\}$ 14 ]称之为因式卷积操作. ...

... 式(4)是滤波器学习最小化目标函数的频域表示,用正则项 $\lambda\|\boldsymbol{P}\|_{F}^{2}$ ${{\boldsymbol{P}}}$ . 在滤波器更新阶段,通过高斯−牛顿(Gauss-Newton)和共轭梯度(conjugate gradient)法求解式(4)获得更新的滤波器组和 ${{\boldsymbol{P}}}$ ${{\boldsymbol{P}}}$ [ 14 ] . ...

Object detection with discriminatively trained part-based models

1

2010

... Danelljan等 [ 14 ] 分析制约相关滤波类算法速度的主要因素,提出高效卷积算子 (efficient convolution operator, ECO). 该算法使用因式卷积实现特征降维,高斯混合模型减少样本数量,间隔帧更新减少更新频率,从特征复杂度、训练集大小和模板更新策略上大幅减少计算量,提高了C-COT算法的时间和空间效率. Danelljan等 [ 14 ] 提供了高效卷积算子的2种实现形式:1)基于卷积特征的ECO算法,2)基于人工特征方向梯度直方图 (histogram of oriente gridients, HOG) [ 15 ] 与颜色命名 (color names, CN) [ 16 ] 的ECO-HC算法. 形式2)的精度虽然略低于形式1)的,但在CPU下具有实时运算速度. 这2种实现形式均缺少跟踪质量判断和滤波模板更新监督机制,使目标跟踪连续定位和模板更新存在很大风险. 一方面,当跟踪质量较差时,继续使用原有定位结果会导致下一帧目标搜索范围偏移,影响后续帧的跟踪效果;另一方面,当出现遮挡、目标离开视野范围时,按照间隔特定帧更新模型会持续引入背景噪声,导致跟踪漂移与失败. ...

1

... Danelljan等 [ 14 ] 分析制约相关滤波类算法速度的主要因素,提出高效卷积算子 (efficient convolution operator, ECO). 该算法使用因式卷积实现特征降维,高斯混合模型减少样本数量,间隔帧更新减少更新频率,从特征复杂度、训练集大小和模板更新策略上大幅减少计算量,提高了C-COT算法的时间和空间效率. Danelljan等 [ 14 ] 提供了高效卷积算子的2种实现形式:1)基于卷积特征的ECO算法,2)基于人工特征方向梯度直方图 (histogram of oriente gridients, HOG) [ 15 ] 与颜色命名 (color names, CN) [ 16 ] 的ECO-HC算法. 形式2)的精度虽然略低于形式1)的,但在CPU下具有实时运算速度. 这2种实现形式均缺少跟踪质量判断和滤波模板更新监督机制,使目标跟踪连续定位和模板更新存在很大风险. 一方面,当跟踪质量较差时,继续使用原有定位结果会导致下一帧目标搜索范围偏移,影响后续帧的跟踪效果;另一方面,当出现遮挡、目标离开视野范围时,按照间隔特定帧更新模型会持续引入背景噪声,导致跟踪漂移与失败. ...

1

... 针对上述问题,本研究以具有实时运算特性的ECO-HC算法作为基线算法进行如下改进. 1)跟踪质量判别. 引入特征融合响应图震荡程度指标 $ {E}_{\mathrm{A}\mathrm{P}\mathrm{C}\mathrm{E}} $ [ 17 ] ,结合最大峰值响应 $ {F}_{\mathrm{m}\mathrm{a}\mathrm{x}} $ [ 18 ] 加入ECO-HC定位框架,对评价未达到置信度阈值的跟踪结果进行加权修正. 3)新的滤波模板稀疏更新策略. 当前帧同时满足间隔特定帧与置信度要求时,执行模板更新. ...

1

... 针对上述问题,本研究以具有实时运算特性的ECO-HC算法作为基线算法进行如下改进. 1)跟踪质量判别. 引入特征融合响应图震荡程度指标 $ {E}_{\mathrm{A}\mathrm{P}\mathrm{C}\mathrm{E}} $ [ 17 ] ,结合最大峰值响应 $ {F}_{\mathrm{m}\mathrm{a}\mathrm{x}} $ [ 18 ] 加入ECO-HC定位框架,对评价未达到置信度阈值的跟踪结果进行加权修正. 3)新的滤波模板稀疏更新策略. 当前帧同时满足间隔特定帧与置信度要求时,执行模板更新. ...

1

... 针对上述问题,本研究以具有实时运算特性的ECO-HC算法作为基线算法进行如下改进. 1)跟踪质量判别. 引入特征融合响应图震荡程度指标 $ {E}_{\mathrm{A}\mathrm{P}\mathrm{C}\mathrm{E}} $ [ 17 ] ,结合最大峰值响应 $ {F}_{\mathrm{m}\mathrm{a}\mathrm{x}} $ [ 18 ] 加入ECO-HC定位框架,对评价未达到置信度阈值的跟踪结果进行加权修正. 3)新的滤波模板稀疏更新策略. 当前帧同时满足间隔特定帧与置信度要求时,执行模板更新. ...

Object tracking benchmark

4

2015

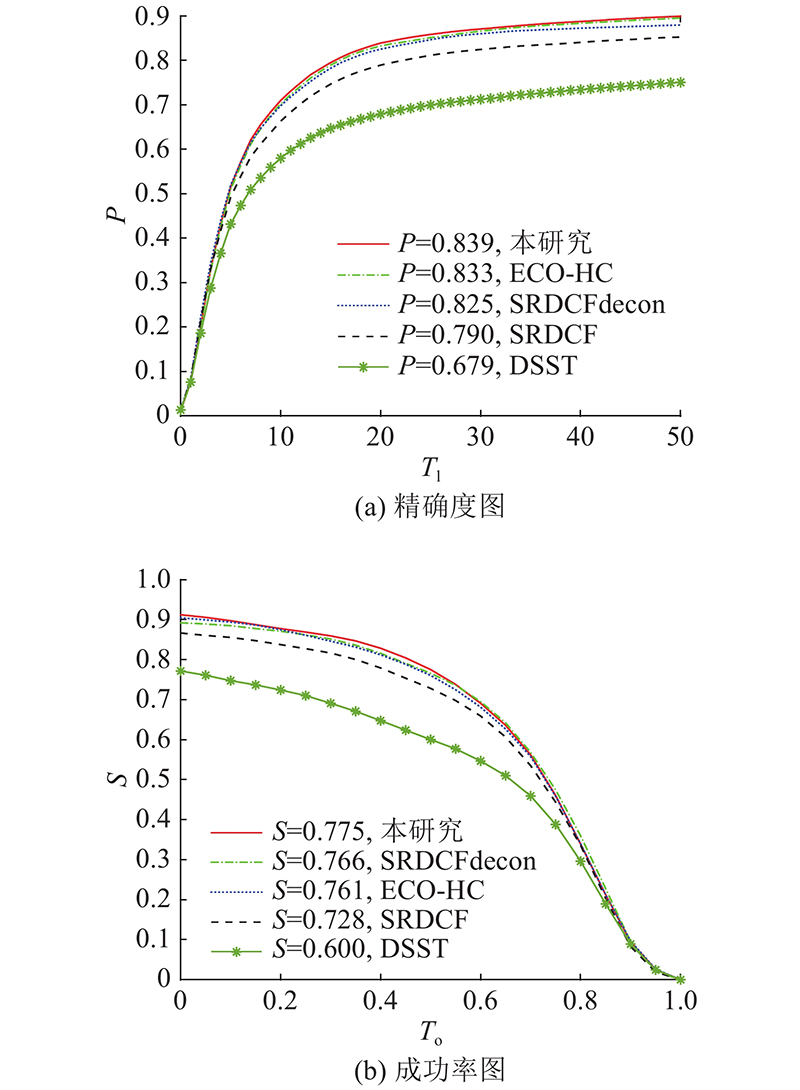

... 实验硬件环境为CPU Intel(R) Xeon(R),主频2.10 GHZ,内存64 GB 的计算机,软件开发平台为Matlab 2017b. 实验主要基于公开数据集OTB-2015 [ 19 ] 和VOT2016 [ 20 ] 设计实验评估算法的跟踪效果. ...

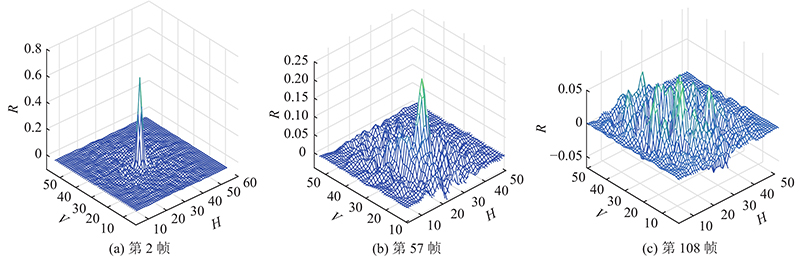

... OTB-2015包含100个帧数不同的测试序列,对应光照变化、运动模糊和遮挡等11种难度较大的挑战场景. OTB-2015通过统计不同阈值下中心位置误差(location error)和重叠率(overlap),提出用精确度图(precision plots)和成功率图(success plots)展现算法跟踪效果. 中心位置误差 [ 19 ] 指算法跟踪所得目标中心位置与标定位置间平均欧式距离小于阈值 $ {{S}}_{\mathrm{D}\mathrm{P}} $ [ 19 ] 指算法跟踪所得目标框与标定目标框交并比大于某个阈值的帧数占总帧数的百分比. ...

... [ 19 ] 指算法跟踪所得目标框与标定目标框交并比大于某个阈值的帧数占总帧数的百分比. ...

... 在OTB-2015的100个序列上分别执行改进算法DSST、SRDCF、SRDCFdecon和ECO-HC,统计不同阈值下的精确度,以中心位置误差阈值 $ {T}_{\mathrm{l}} $ $ P $ $ {T}_{\mathrm{l}}=20 $ $ {T}_{{\rm{o}}} $ $ S $ $ {T}_{{\rm{o}}}=0.5 $ [ 19 ] 作为评测结果. ...

A novel performance evaluation methodology for single-target trackers

3

2016

... 实验硬件环境为CPU Intel(R) Xeon(R),主频2.10 GHZ,内存64 GB 的计算机,软件开发平台为Matlab 2017b. 实验主要基于公开数据集OTB-2015 [ 19 ] 和VOT2016 [ 20 ] 设计实验评估算法的跟踪效果. ...

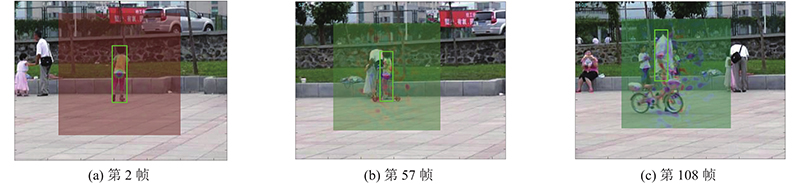

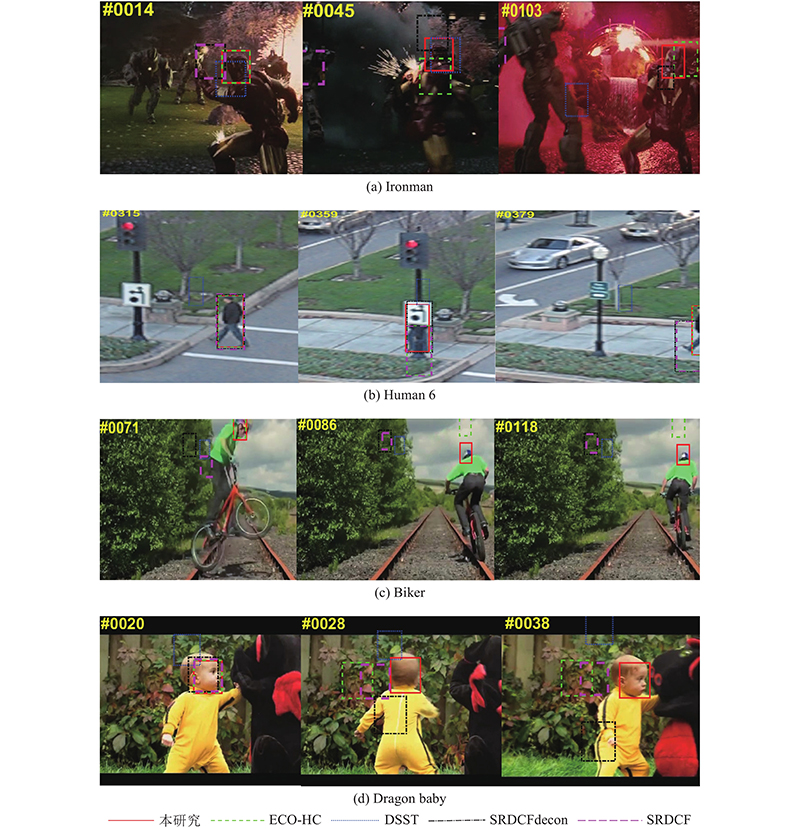

... VOT2016的60组测试序列,对应相机抖动、形状变化、光照变化等6种挑战场景,每帧含有多个挑战场景标签,主要评价指标有期望平均重叠率(expected average overlap, EAO) [ 20 ] 、失败率(failure rate)、准确率(accuracy)等. 共设计4组对照实验: 1)跟踪质量置信度指标阈值选定. 2)对比DSST、SRDCF、SRDCFdecon、ECO-HC等 4种相关滤波跟踪算法,使用OTB-2015全部100个序列的运行结果,定量分析算法在测试集上整体跟踪效果以及应对不同挑战时的跟踪效果. 3)在OTB-2015中选取4组包含遮挡、运动模糊和光照变化等复杂场景的序列,对本研究算法跟踪效果做定性分析. 4)在数据集VOT2016 [ 20 ] 上进一步验证算法的有效性. ...

... [ 20 ] 上进一步验证算法的有效性. ...