平腕臂作为接触网悬挂装置中主要的支撑和承力结构,其工作状态是否正常将直接影响整个接触网悬挂装置. 平腕臂状态异常将会直接导致整个接触网悬挂的异常,轻则引起接触网停电事故,重则影响行车安全,导致重大列车事故. 平腕臂U型抱箍位于平腕臂与套管的连接处,是接触网悬挂支撑装置的重要连接部件,U型抱箍工作状态正常与否将直接影响套管装置和平腕臂连接的稳定性,因此平腕臂U型抱箍的故障检测对保证高速列车安全运行有着重要的意义.

目前对于接触网悬挂部件检测主要分为2步进行:目标定位与故障检测. 韩帅[1]利用直线检测结果,通过逐像素搜索的方法定位管帽区域,提出有限角度旋转不变HOG (histogram of oriented gradients, HOG)特征提取算法,结合支持向量机(support vector machine, SVM)完成对管帽的故障检测. 闵锋等[2]利用以MobileNets为基础网络的SSD(single shot multibox detector, SSD)目标检测算法进行插销的初定位,通过语义分割精定位开口销像素位置,利用面积比作为判据,实现开口销缺失检测. 狄亚柳[3]利用以VGG16(visual geometry group,VGG)为基础网络的Faster-RCNN目标检测算法,实现对接触网U型抱箍的定位,通过SVM二分类进行故障检测. 徐钥斌[4]利用Faster-RCNN算法对定位线夹进行定位,通过Canny边缘检测算法,提取吊弦特征,以吊弦直线度和曲率作为判据进行故障诊断. 赵亚男等[5]提出多尺度SSD_VGG16网络,利用Top_Down的结构来实现对织物瑕疵数据进行检测.

对于背景复杂的接触网图像目标,如雨天、强光背景下目标,由于背景噪声较大,利用传统图像处理方法难以直接提取,基于深度学习的目标检测方法相对于传统检测算法具有更高的鲁棒性. 对于本文U型抱箍的故障检测,抱箍故障主要为螺母缺失和松动,抱箍螺母大小只有20×20,4C接触网悬挂图像大小为6 600×4 400,螺母只占原图的1/72 600,属于微小目标无法直接进行故障诊断;由于故障样本有限,几乎一千张接触网悬挂图片才有个别故障样本,难以通过图像分类实现对螺母故障松动的检测.

本文提出平腕臂U型抱箍螺母故障检测的方法,该方法包含U型抱箍定位和抱箍螺母故障检测2个过程. 为了提高U型抱箍区域定位精度和速度,本文提出UND-Net目标检测算法,实现对U型抱箍区域进行初定位. 在故障检测阶段,利用Mask_RCNN实例分割神经网络对初定位图像4颗螺母进行像素级别分割,得到单个螺母的精确定位以及类别信息;利用单个螺母精定位信息,提出2种故障诊断算法,分别检测螺母松动及螺母缺失故障.

1. 平腕臂U型抱箍初定位

1.1. UND-Net检测网络主要结构

对比主流的one-stage网络,如SSD、YOLO(you only look once, YOLO)系列,本文算法在精度上相对SSD算法有较大提升. 对比主流two-stage网络,如Faster-RCNN网络,本文算法在速度上有较大提升,在U型抱箍区域检测任务上,对于不同检测图片具有良好的适应性和较高的检测效率.

对于传统目标检测网络,随着网络深度的增加,特征图尺寸变小,网络的表征能力不断增加,但是对于目标的几何位置信息表达能力变弱,本文接触网的图片大小为6 600×4 400,平腕臂U型抱箍区域大小只有200×300左右,抱箍区域在原图中占比只有1/400,属于微小目标. 提出残差特征增强层(residual feature augmentation module, RFAM). 该模块能够通过自适应残差的方式融合高低层特征,从而减少信息损失,提高检测U型抱箍的准确率.

传统特征金字塔层(feature pyramid networks, FPN)能够关注不同特征层之间的上下文信息,但是没有关注不同金字塔层之间的信息. 本文提出跨金字塔自适应特征融合层(adaptive fusion module, AFM). 该模块能够有效地关注不同金字塔层之间的特征信息,提高检测准确率.

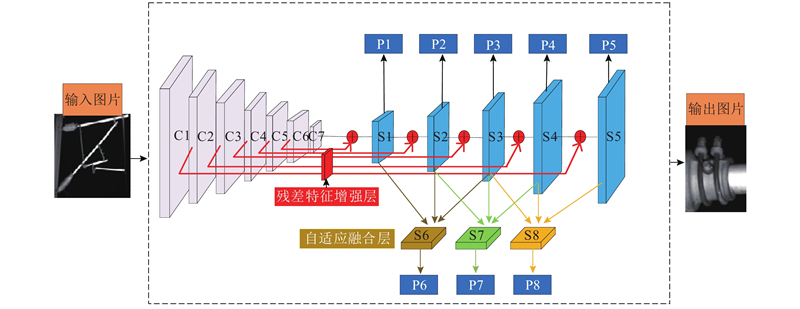

提出的UND-Net目标检测算法的整体网络结构如图1所示. 其中{C1,C2,C3,C4,C5,C6,C7}是主干特征层,特征层单边尺寸大小分别为{512,256,128,64,32,16,8}. {S1,S2,S3,S4,S5}为经过残差特征增强层得到的增强特征层,特征层单边尺寸大小分别为{16,32,64,128,256},{P1,P2,P3,P4,P5}为增强特征层的预测层,{S6,S7,S8}为增强金字塔特征层经过自适应融合层得到的特征层,{P6,P7,P8}为自适应特征层的预测. 整个网络的损失函数如下所示:

图 1

式中:

1.1.1. 主干网络结构

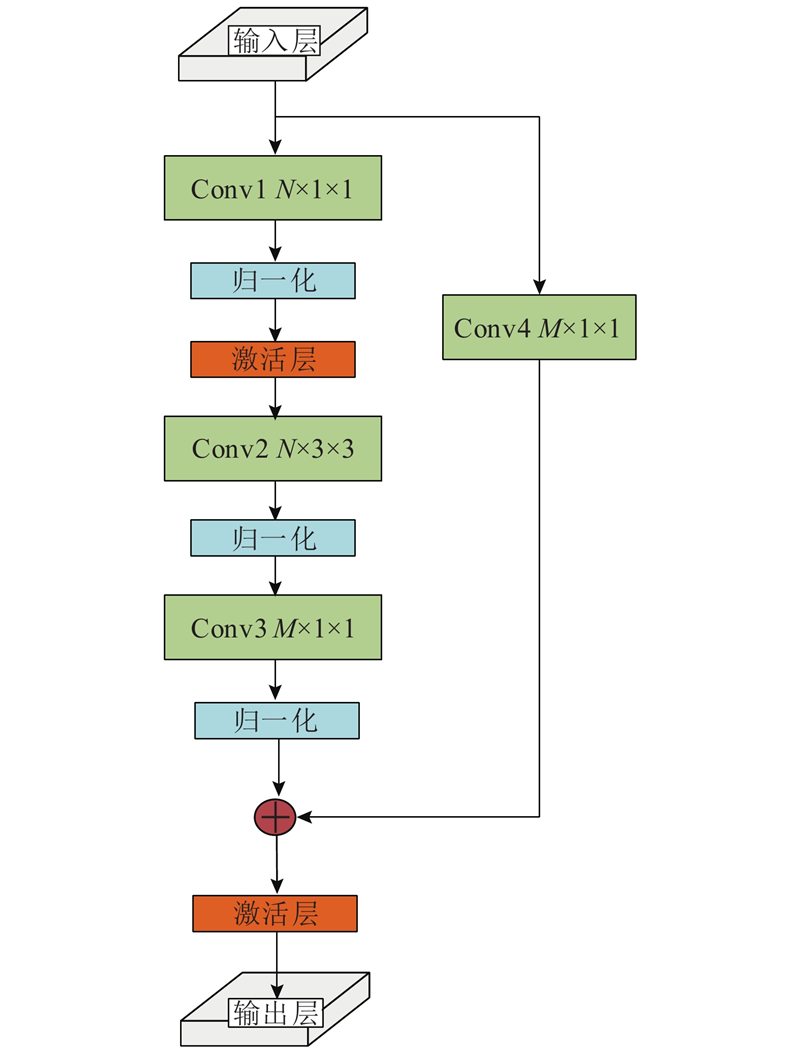

对于提出的HND-Net主干网络结构编码层由多个图2所示的残差结构块构成,该结构块主要参考ResNet[6]作出相应调整得到. 每个残差结构块主要将上一个残差结构的输出作为该模块的输入,通过第1层1×1×N(N < 输入通道数)卷积核降低通道数,将第1层卷积得到低维度特征送入第2层3×3× N卷积核,对低维度特征进行卷积提取特征. 将第2层的结果送入第3层1×1×M(M > N)卷积核恢复通道数,此时判断本残差模块最开始的输入与第3层输出结果的通道数尺寸是否相同. 如果相同,则直接进行元素相加结合;如果不同,则通过1×1×M卷积核提升至相同通道数,再与第3层的结果进行矩阵相加,将相加得到的结果归一化之后输出至下一个残差结构块.

图 2

假设其中输入通道数为256,N为128,M为512,则利用该残差结构整个模块所需要的参数量为:1×1×256×128 + 3×3×128×128 + 1×1×128×512 + 1×1×256×512 = 376 832. 若不利用该残差结构,则整个模块所用的参数量为:3×3×256×512 + 3×3×256×512 = 2 359 292. 不利用残差结构参数量为残差结构参数量的6.26倍,所以本文的神经网络选择采用该残差结构来保证特征提取的精度,减少不必要的参数计算量.

1.1.2. 残差特征增强层(residual feature augmentation module)

卷积神经网络本身主要有以下特点. 高层网络特征图具有较大的感受野,语义信息的表征能力强,但由于特征图的分辨率很低,对几何信息的表征能力相对较弱. 低层网络特征图的感受野相对较小,几何信息表征能力强,但是语义信息表征能力很弱,因此由单一层提取特征往往缺失部分信息.

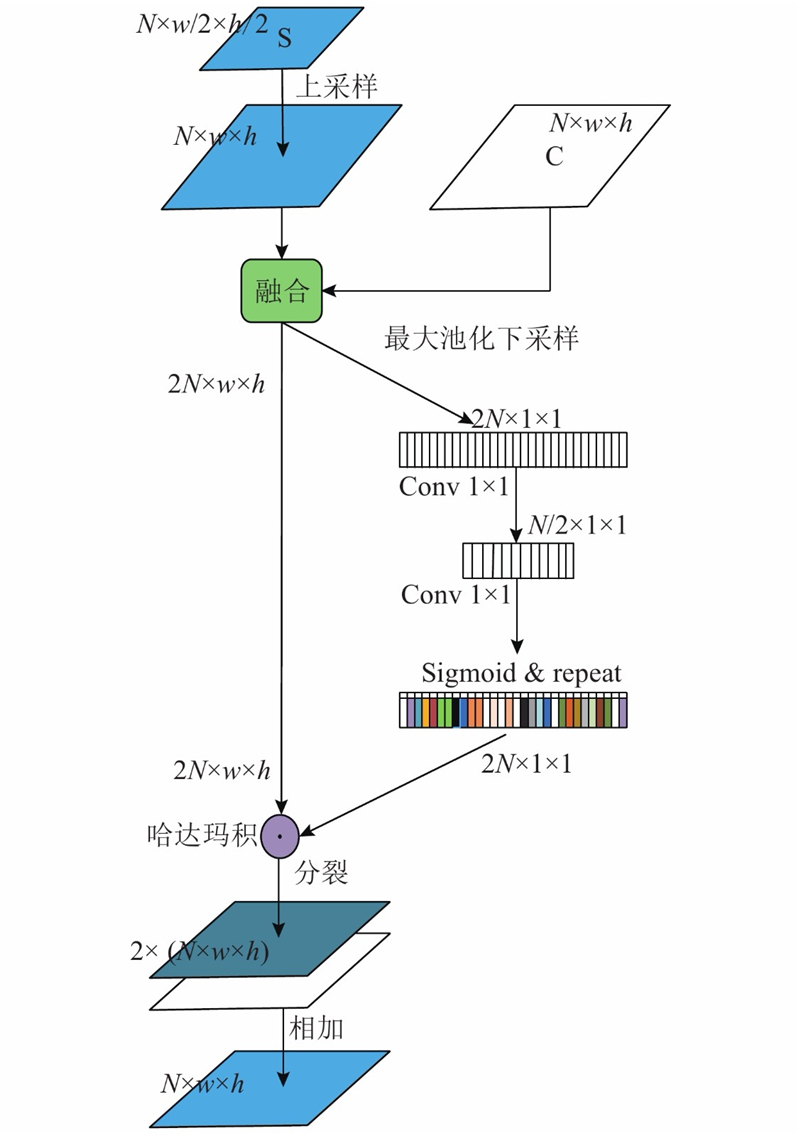

为了使特征图同时得到合适的语义信息和几何信息,受SENet[7]神经网络中通道注意力机制的启发,提出如图3所示的残差特征增强模块. 与SENet的不同之处在于该模块旨在结合网络高低特征信息,达到结合不同层特征信息的目的. SENet旨在关注每个单一子结构内的通道信息. 将S层特征通过双线性插值的方法进行上采样,达到和C层相同的尺寸. 为了避免双线性插值带来的误差和直接融合导致的通道信息缺失,提出如图3所示的残差融合方法. 由于不同通道之间的特征权重不同,若将所有层权重视为相同,则直接融合可能会导致丢失重要的通道信息. 将高低特征层直接堆叠,通过如下卷积变形后求取每个通道的权重信息;与堆叠层求取Hadamard积,再进行融合. 如表1所示为高低层融合特征参数.

图 3

表 1 增强特征层参数表

Tab.1

| 融合规则 | 输出层 | 输出特征图尺寸 |

| C7+C6 | S1 | 16×16×512 |

| C5+S1 | S2 | 32×32×512 |

| C4+S2 | S3 | 64×64×512 |

| C3+S3 | S4 | 128×128×512 |

| C2+S4 | S5 | 256×256×512 |

1.1.3. 跨金字塔自适应融合层(adaptive fusion module, AFM)

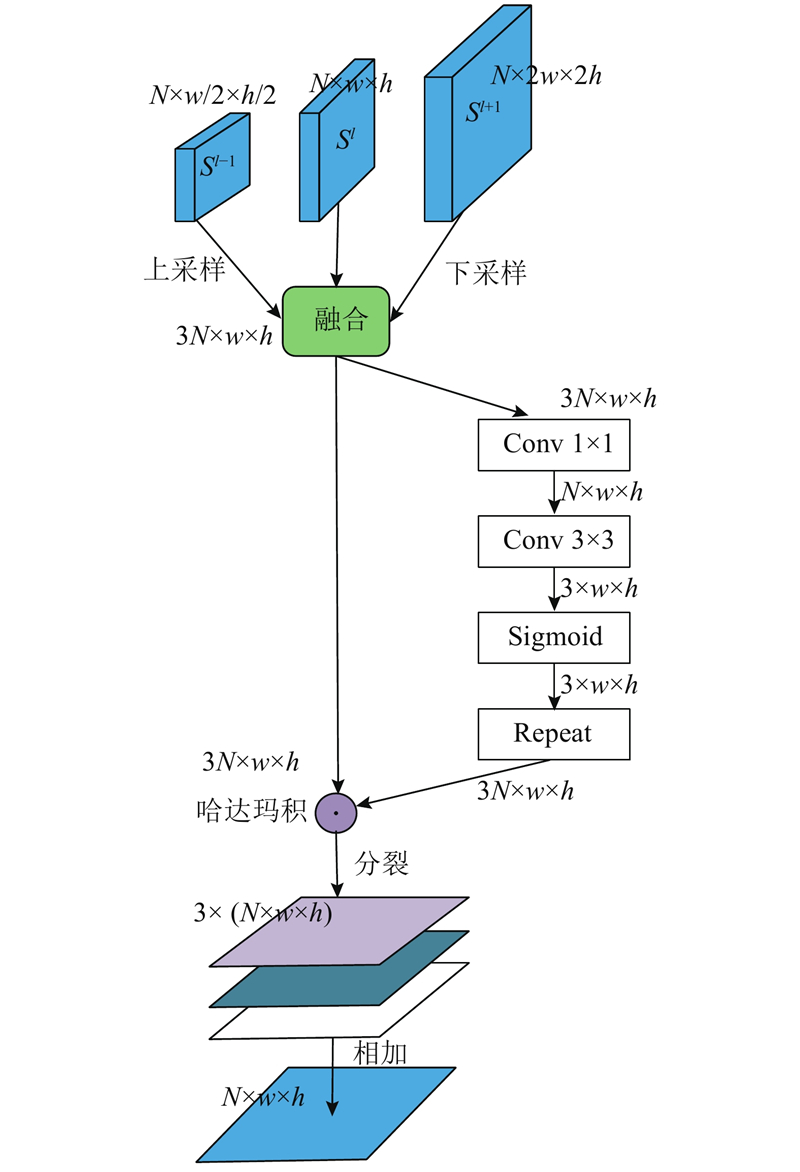

跨金字塔自适应融合层的主要结构如图4所示. FPN是非常有效的提取不同尺度特征的方法,这种方法主要在不同层级之间聚集上下文信息,但是没有考虑特征金字塔内部不同层次之间的相关性. 借鉴早期计算机视觉通过空间和尺度维度上定位特征极值来提取尺度不变特征的方法,提出跨金字塔自适应特征融合模块,可以关注相连的3层金字塔特征层之间的特征信息,能够有效地提高检测结果. 特征层结合算法如下:

图 4

式中:

1.2. 平腕臂U型抱箍定位实验

抱箍初定位实验的训练硬件条件如下:12核24线程amd3900X CPU, 32 GB海盗船内存条,一张Tesla V100显卡. 软件条件如下:ubantu系统18.04版本,基于tensorflow1.13深度学习框架,利用python3.6进行实验.

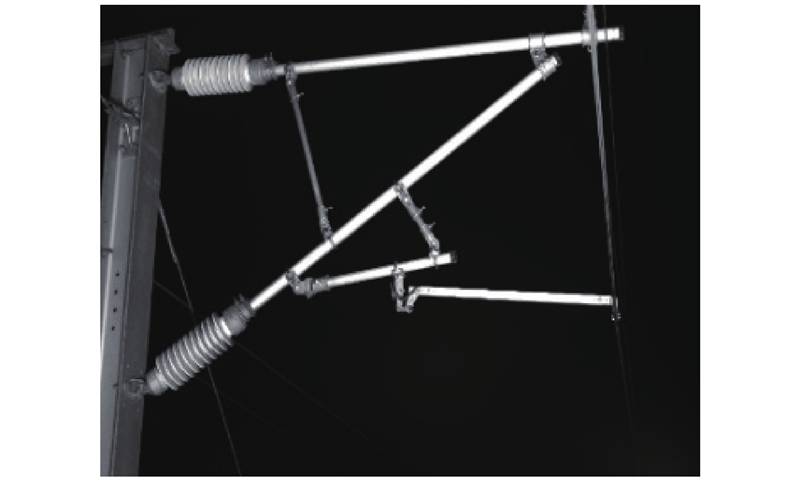

数据来源为高铁运行时现场4C检测车拍摄的接触网悬挂图像,原图片尺寸大小为6600×4 400像素,共计8 163张接触网悬挂图片. 利用LabelImg标注工具对所有数据进行U型抱箍区域标记,标注完成过后将所有数据按照7∶3比例分为5 714张训练集和2 449张测试集. 接触网悬挂样本图如图5所示.

图 5

对于U型抱箍图像初定位,采用以下检测步骤进行检测.

1)将5 714张训练集和2 449张测试集图片大小统一resize成513×513大小,batch-size设置为8,初始学习率设为0.003,经过数据增强后送入HND-Net网络进行训练.

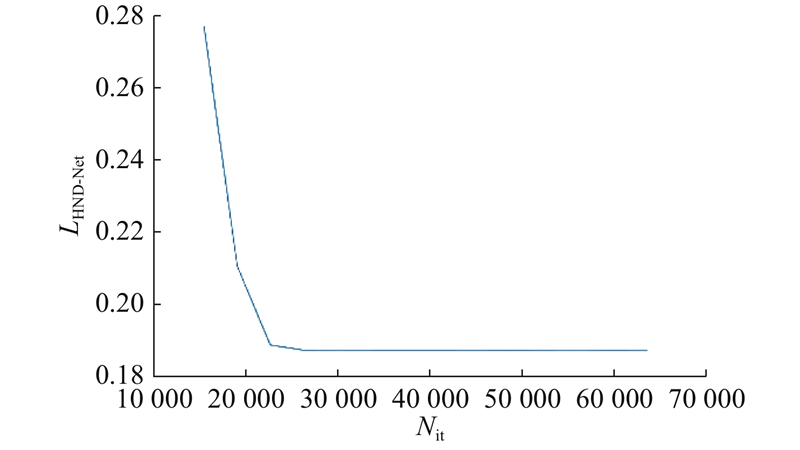

2)通过损失值变化曲线,确定训练达到稳定点,冻结模型参数保存模型. 如图6所示为训练损失随着迭代次数Nit改变的曲线. 可以发现,在迭代至41 000次的时候损失值趋于稳定,保存模型.

图 6

3)利用2)保存的模型,对接触网悬挂图片进行U型抱箍初定位,得到的定位图如图7所示.

图 7

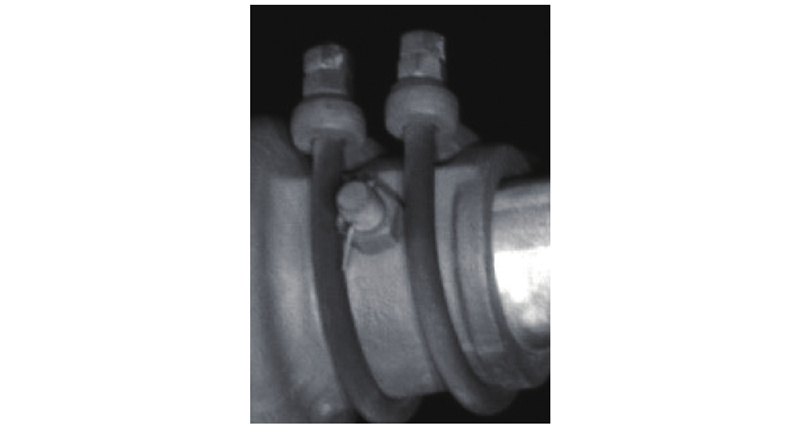

4)在3)定位阶段,给出定位边框,即U型抱箍在整个接触网图片中的坐标位置. 利用opencv将抱箍初定位图截取并保存用于下文螺母实例分割,如图8所示为U型抱箍截取图片.

图 8

2. U型抱箍螺母故障检测

观察大量样本可以发现,对于U型抱箍螺母故障,主要为顶层螺母的缺失和松动,但由于缺失和松动故障数量极少,几千张图片中仅有少量故障样本,不适合直接利用图像分类(图像分类需要大量故障样本)对螺母故障进行松动和缺失检测. 提出利用Mask_RCNN实例分割、结合图像处理的U型抱箍螺母故障检测方法.

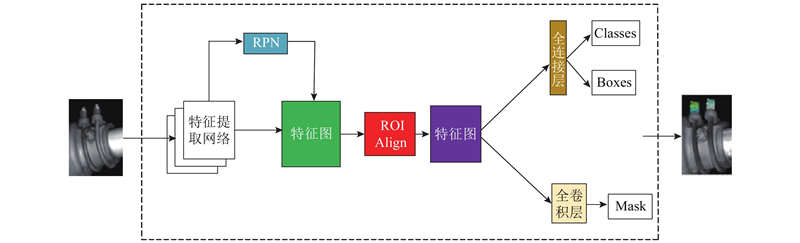

实例分割结合目标检测和语义分割的优点,既可以对同一类物品的不同个体进行分类,还可以对检测目标精确到目标物体的像素边缘,实现像素级别的分割. 利用实例分割算法对4颗螺母进行像素级别分割,利用分割得到的boxes位置信息和classes类别信息,通过本文算法进行螺母缺失和螺母松动故障检测.

2.1. Mask_RCNN检测网络结构

图 9

2.2. U型抱箍螺母缺失检测[9-25]

缺失检测的硬件条件和目标检测相同.

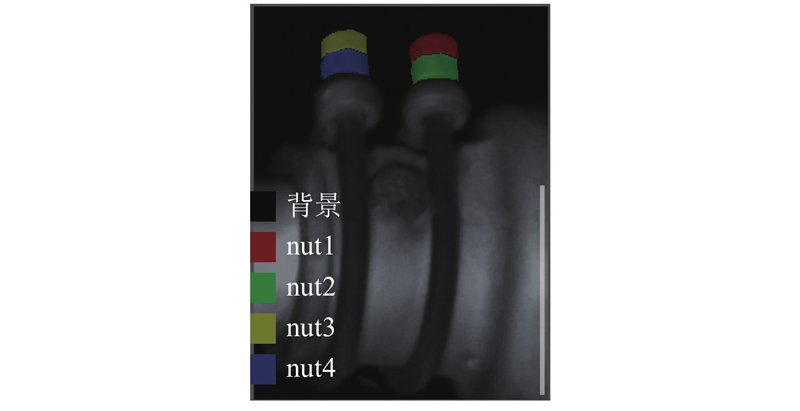

选取4 00张定位阶段得到U型抱箍截取图像,利用Labelme标注工具进行mask标注,在标注时给出以下规定. 将靠近绝缘子端的上层螺母标注为nut1,索引为1;下层螺母标注为nut2,索引为2;远离绝缘子上层螺母标注为nut3,索引为3;下层螺母标注为nut4,索引为4. 将标注得到的图片按照7∶3比例分为2 800张训练集和1 200张验证集,分别用于模型训练和模型效果测试. U型抱箍螺母实例分割标注图像如图10所示.

图 10

对于U型抱箍螺母缺失故障研究,采用以下检测步骤进行检测.

1)将2 800张训练集图片和1 200张测试集图片统一resize成200×300像素,batch-size设置为16,初始学习率设置为0.001,经过数据增强后送入Mask_RCNN网络进行训练.

2)当训练至loss趋于稳定时,保存模型. 在螺母检测训练过程中,迭代至25 000次loss基本拟合,故将迭代25 000次的模型参数冻结,保存成模型,用于检测U型抱箍初定位图像.

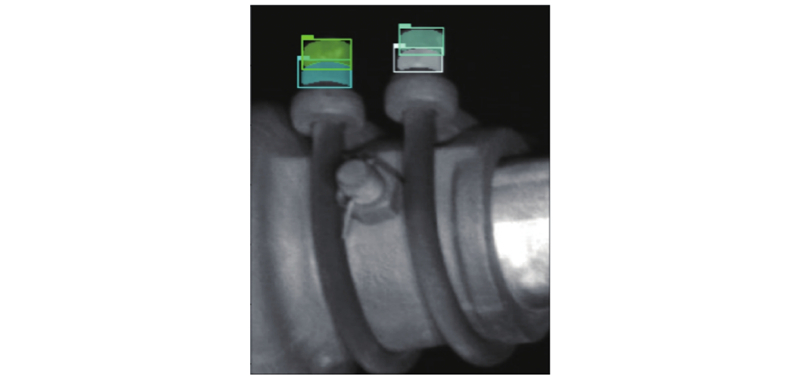

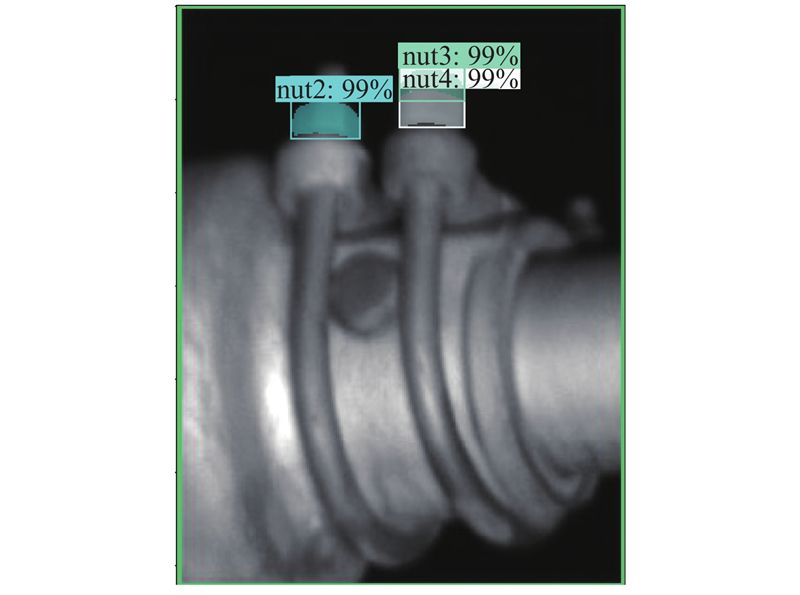

3)利用2)训练得到的模型进行螺母检测,如图11所示为螺母实例分割检测图像.

图 11

4)将螺母实例分割结果classes类别信息打印得到字典,其中1、2、3、4数字是图像标注时定义的索引标签,每个标签对应一个类别,分别对应1号螺母、2号螺母、3号螺母、4号螺母. 打印出所有标签索引,可以直接判断缺失的索引号,从而判断缺失的螺母. 如图12所示为缺失螺母1.

图 12

2.3. 螺母松动检测

检测螺母松动即判断两螺母之间的间隙是否超过间隙临界值,但由于4C检测车行驶过程中拍摄距离及拍摄角度存在细微差异,不同接触网图片中每个螺母的像素及螺母角度存在差异,螺母之间的间隙不同,不能够直接将螺母之间的间隙作为评判标准. 提出基于实例分割的图像处理故障检测方法,针对通过实例分割得到的4颗螺母像素区域分别求取最小外接矩形,经过仿射变换旋转至水平后设定比值判据进行故障诊断.

对于U型抱箍螺母松动故障研究,采用以下检测步骤进行检测.

1)求取4颗螺母外接矩形框.

图 13

式中:

2)求取各螺母中心点.

求取各螺母中心点,判断上、下螺母之间的位置关系. 每颗螺母的像素中心点既是mask区域的中心点,也是最小外接矩形框boxes的中心点. 利用经过仿射变换后的最小外接框boxes坐标,计算得出螺母像素中心点. 设实例分割中的最小外接矩形框坐标表示为(ymin, xmin, ymax, xmax).

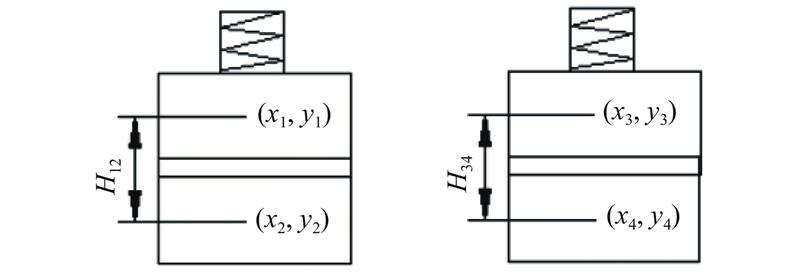

设nut1的中心坐标为(x1, y1), nut2的中心坐标为(x2, y2),nut3的中心坐标为(x3, y3),nut4的中心坐标为(x4, y4). 根据式(5)、(6),可以得到各螺母的中心坐标. 螺母外接矩形框的位置关系图如图14所示.

3)求取螺母之间的位置关系.

设1号螺母和2号螺母中心点之间的高度差为H12,3号螺母和4号螺母中心点之间的高度差为H34. 由图14可得,各参数的计算公式如下:

4)设定比值判据.

在实际装配中,4颗螺母的尺寸相同,但由于拍摄角度问题,螺母厚度有细微差异,按照式(11),取

经过多次实验分析,对100组抱箍的K值进行统计,取平均值Km得到结果为0.875. 对结果进行取整,制定如下判据. 1)若K12 > 0.875,则认为1号螺母松动. 2)若 K34 > 0.875,则认为3号螺母松动. 3)若 K ≤ 0.875,则认为螺母正常.

图 14

图 14 螺母外接矩形框位置关系示意图

Fig.14 Diagram of relationship between position of external rectangular frame of nut

3. 实验结果分析

消融实验的硬件条件如下:12核24线程amd3900X CPU, 32 GB海盗船内存条,一张Tesla V100显卡. 软件条件如下:ubantu系统18.04版本,基于tensorflow1.13深度学习框架利用python3.6进行实验.

3.1. 消融实验

为了验证分析提出的残差特征增强层和跨金字塔自适应融合层在HND-Net网络中的作用,开展如下对应模块的消融实验.

为了验证残差特征增强模块的有效性,分别对比网络中不添加残差特征增强模块以及逐层添加残差特征增强层情况下的精度对比,如表2所示. 可以发现,随着残差特征增强模块的增加,精度mAP由97.21%提升到了99.84%,证明了该模块的有效性.

为了验证跨金字塔自适应融合层的有效性,分别对比网络中在不添加自适应融合层以及逐层添加自适应融合层的情况下的精度,如表3所示. 在完全不添加跨金字塔自适应融合层的情况下,精度只有97.44%;随着自适应层的添加,精度提升到了99.84%,验证了跨金字塔自适应模块的有效性.

表 2 残差特征增强模块消融实验

Tab.2

| 模型 | RFAM层数 | mAP/% |

| HND-Net | 0 | 97.21 |

| HND-Net | 1 | 97.82 |

| HND-Net | 2 | 98.89 |

| HND-Net | 3 | 99.22 |

| HND-Net | 4 | 99.51 |

| HND-Net | 5 | 99.84 |

表 3 自适应特征融合层消融实验

Tab.3

| 模型 | AFD层数 | mAP/% |

| HND-Net | 0 | 97.44 |

| HND-Net | 1 | 97.82 |

| HND-Net | 2 | 99.33 |

| HND-Net | 3 | 99.84 |

3.2. 不同模型实验

为了验证该定位算法相对于现阶段主流算法的可靠性,使用上述5 714张训练集,经过数据增强后,对该HND-Net算法与现阶段主流开源目标检测算法Faster_RCNN-ResNeXt101-FPN、EfficientDet-D7、M2Det- ResNet101、DETR- ResNeXt101 4种神经网络分别进行训练. 利用2 449张测试集,对训练结果测试形成对比实验,制定5种模型下的检测精度、检测速度v及参数量N表格. 通过表4的检测结果可以发现,该HND-Net神经网络在本文抱箍定位项目上相对于准确率最高的EfficientDet-D7神经网络准确度仅低0.11%,但是检测速度提升了11.9帧/s,参数量减少了14×106. 相对于Faster_RCNN-ResNeXt101-FPN,本文算法在抱箍定位精度上提升了1.51%,在检测速度上提升了7.6帧/s. 相对于DETR-ResNeXt101、M2Det- ResNet101,本文算法在精度和速度上都有小幅度的提升. 总体来看,本文的HND-Net目标检测算法在U型抱箍定位任务上具有一定的效果.

表 4 不同模型定位精度、检测速度及参数量的对比

Tab.4

| 模型 | 主干网络 | mAP/% | v /(帧·s−1) | N /106 |

| Faster_RCNN | ResNeXt101 | 98.33 | 9.5 | 60 |

| DETR | ResNeXt101 | 98.61 | 15.0 | 61 |

| M2Det | ResNet101 | 98.75 | 2.4 | 98.9 |

| EfficientDet | D7 | 99.95 | 5.2 | 66 |

| HND-Net | HND-Net | 99.84 | 17.1 | 52 |

为了验证该定位算法具有较强的鲁棒性,利用该HND-Net算法模型与另外4种神经网络模型,分别对双支架复杂结构进行检测. 该定位算法以及Faster_RCNN-ResNeXt101-FPN、EfficientDet-D7、M2Det- ResNet101均能定位U型抱箍区域,如图15所示,但是DETR- ResNeXt101算法不能准确定位出该抱箍区域,可以证明该定位算法具有一定的鲁棒性.

图 15

表 5 U型抱箍实验检测数据

Tab.5

| 检测类别 | 总数 | 正确数 | 误检数 | mAP/% |

| 抱箍定位 | 800 | 797 | 3 | 99.6 |

| 松动检测 | 53 | 49 | 4 | 92.4 |

| 缺失检测 | 68 | 66 | 2 | 97.1 |

4. 结 论

(1)提出新的HND-Net抱箍区域检测网络,介绍了该网络的主要结构及原理功能,提出利用该模型对平腕臂U型抱箍进行定位的方法.

(2)介绍实例分割的主要功能,提出利用Mask_RCNN对抱箍螺母进行精确定位和螺母缺失检测的方法.

(3)提出结合实例分割和图像处理的螺母松动检测算法.

(4)使用接触网悬挂数据集,对提出方法进行检测对比验证. 实验证明,本文方法有较高的准确率,对拍摄背景环境、距离有较高的鲁棒性.

参考文献

基于语义分割的接触网开口销状态检测

[J].

Detection of cotter pin status based on semantic segmentation

[J].

基于多尺度融合SSD的小目标检测算法

[J].

Small target detection algorithm based on multi-scale fusion SSD

[J].

基于级联Faster R-CNN的高铁接触网支撑装置等电位线故障检测

[J].DOI:10.3969/j.issn.1001-8360.2019.06.010 [本文引用: 1]

High-speed rail catenary support device equipotential line fault detection based on cascaded Faster R-CNN

[J].DOI:10.3969/j.issn.1001-8360.2019.06.010 [本文引用: 1]

基于加速区域卷积神经网络的高铁接触网承力索底座裂纹检测研究

[J].DOI:10.3969/j.issn.1001-8360.2019.07.006

Research on crack detection of high-speed railway catenary cable base based on accelerated regional convolutional neural network

[J].DOI:10.3969/j.issn.1001-8360.2019.07.006

基于反卷积和特征融合的SSD小目标检测算法

[J].

SSD small target detection algorithm based on deconvolution and feature fusion

[J].

全卷积神经网络研究综述

[J].DOI:10.3778/j.issn.1002-8331.1910-0164

A review of research on fully convolutional neural networks

[J].DOI:10.3778/j.issn.1002-8331.1910-0164

一种改进的Mask RCNN特征融合实例分割方法

[J].DOI:10.3969/j.issn.1000-386x.2019.10.023

An improved Mask RCNN feature fusion instance segmentation method

[J].DOI:10.3969/j.issn.1000-386x.2019.10.023

基于实例分割的双目特征点匹配目标识别和定位研究

[J].DOI:10.3969/j.issn.1003-3106.2020.02.002

Research on target recognition and location based on instance segmentation with binocular feature point matching

[J].DOI:10.3969/j.issn.1003-3106.2020.02.002

一种基于双分支车道线实例分割的检测算法

[J].DOI:10.3969/j.issn.1672-6944.2020.03.051

A detection algorithm based on instance segmentation of dual-branch lane lines

[J].DOI:10.3969/j.issn.1672-6944.2020.03.051

基于SURF特征匹配的电气化铁路接触网支撑装置旋转双耳不良状态检测

[J].DOI:10.3969/j.issn.1001-8360.2016.08.005

Detection of the bad state of the rotating binaural of the catenary support device of the electrified railway based on SURF feature matching

[J].DOI:10.3969/j.issn.1001-8360.2016.08.005

高铁接触网旋转双耳销钉状态检测方法研究

[J].DOI:10.3969/j.issn.1001-8360.2017.06.009

Research on the detection method of rotating binaural pins for high-speed railway catenary

[J].DOI:10.3969/j.issn.1001-8360.2017.06.009

基于DSSD的接触网鸟窝识别检测研究

[J].

Study on the identification and detection of catenary bird's nest based on DSSD

[J].

Grape disease image classification based on lightweight convolution neural networks and channelwise attention

[J].

Segmentation of X-ray microtomography data of porous scaffold

[J].

Hierarchical reasoning network for pedestrian attribute recognition

[J].DOI:10.1109/TMM.2020.2975417 [本文引用: 1]