近年来,随着生活水平的提高和城市化的发展,生活垃圾数量急剧增加,全球许多城市面临“垃圾围城”危机[1]. 垃圾分类被认为是在现有环境下解决垃圾困境、提高资源利用率的主要措施. 但是,垃圾分类的实施情况却不容乐观,主要原因在于相关法律法规不健全、居民的垃圾分类意识不强、垃圾种类过多难以精确分类等. 因此,大量研究人员对智能垃圾分类设备进行研究[2-4],或者设计垃圾分类应用程序[5-6],分类回收垃圾,提升垃圾分类效率. 智能垃圾分类的关键技术是垃圾图像分类. 目前,深度学习在计算机视觉领域已经取得了显著进展,在图像分类上的准确率超越人眼. 因此,深度学习技术为垃圾图像分类识别提供了理论和技术支撑.

深度学习的发展有大型网络和轻量级网络两大趋势. 2012年,Krizhevsky等[7]提出的AlexNet在ImageNet数据集上达到15.3%的top5错误率,远超其他传统的特征提取方式,引爆了深度学习的热潮. 再到2014年的GoogleNet[8]、VGG[9]网络,2015年的ResNet[10],深度学习在计算机视觉任务中的应用效果越来越好,同时模型的体积也变得越来越大. 由于大型网络的参数和计算量庞大,通常只能在高算力的GPU上运行,促使深度学习分支转向轻量级研究. 最早的轻量级神经网络是2016年提出的SqueezeNet[11],它保持了AlexNet的精度,但模型参数量只有AlexNet的1/540. 轻量级神经网络发展至今,已有SqueezeNet、ShuffleNet[12]、Xception[13]、MobileNet[14]等一系列轻量级网络,在保证精度的同时,体积更小,速度更快. 这些模型的出现使得边缘设备直接运行深度学习模型成为可能.

由于轻量级神经网络在推理速度上的优势,大量学者基于轻量级网络实现垃圾图像分类. Yang等[15]基于深度可分离卷积,借鉴当前主流的网络设计思路,同时嵌入注意力机制,设计轻量级的垃圾分类网络WasNet,在自建生活垃圾数据集中准确率为82.5%,模型参数量为1.5 M. Liu等[16]选取MobileNet v2主干作为研究对象,利用模型蒸馏算法进行优化训练,模型在12类的垃圾数据集中的准确率为97.9%,模型参数量为14 M. 袁建野等[17]以垃圾分类的实时性为重点,利用深度可分离卷积轻量化模型,通过构建残差网络结构来提升模型的准确率,最终设计的MAPMobileNet-18模型精度为86.3%,参数量为18 M. 高明等[18]以轻量级网络EficientNet作为主干网络,基于新型注意力机制和迁移学习进行优化,在华为云端垃圾识别任务中的准确率为96.17%,推理时间约为80 ms. Shi等[19]通过调整网络分支和网络层对Xception网络改进,实现垃圾分类,精度为94.34%,在I5-8300K的CPU推理耗时约为44 ms. 上述研究针对轻量级的垃圾图像分类从多个方面进行改进,提升了模型的精度.

本研究在前人研究基础上,进一步探索设计低消耗、高精度的垃圾分类网络. 基于轻量级MobileNet v2[20]网络主干,从以下4个方面设计快速准确的垃圾图像分类方法:1)压缩MobileNet v2的通道因子,在精度下降可接受的范围内,降低模型的参数及计算量;2)在模型中嵌入通道与空间注意力机制来增强模型的重要特征,抑制无用特征;3)设计多尺度特征融合结构替代普通结构,加强网络对尺度的适应性;4)使用迁移学习的训练方式,更好地初始化网络参数,提升模型性能.

1. 算法设计

以搭建低消耗、高精度的垃圾分类模型为目标. 选取MobileNet v2网络主干,通过宽度因子调整、卷积块注意力模块(convolutional block attention module,CBAM)[21]和多尺度特征融合的方法进行改进. 改进后的网络结构如图1所示,相同序号的模块表示在网络设计过程中将这些子模块堆叠为一个大模块进行设计. 图中,Bottleneck_A为带注意力机制的瓶颈,Bottleneck_I为具有多尺度特征融合结构的瓶颈,s为卷积或池化操作的步长,DW、PW分别为深度卷积和逐点卷积. 改进后模型的通道数为原始网络的一半,在步长为1的情况下嵌入注意力机制,在步长为2时将瓶颈换成多尺度特征融合结构.

图 1

图 1 改进MobileNet v2网络整体框图

Fig.1 Overall network framework of improved MobileNet v2

改进后的网络结构如表1所示. 表中,t为MobileNet v2的瓶颈结构中进行升维的通道扩增系数,c为经过网络层后输出的通道数,n为该操作模块重复堆叠的次数.

表 1 改进MobileNet v2网络结构表

Tab.1

| 输入尺寸 | 操作 | t | c | n | s |

| 2242×3 | 卷积 | − | 16 | − | 2 |

| 1122×16 | Bottleneck_A | 1 | 8 | 1 | 1 |

| 1122×8 | Bottleneck_I | 6 | 8 | 1 | 2 |

| 562×8 | Bottleneck_A | 6 | 12 | 1 | 1 |

| 562×12 | Bottleneck_I | 6 | 12 | 1 | 2 |

| 282×12 | Bottleneck_A | 6 | 16 | 2 | 1 |

| 282×16 | Bottleneck_I | 6 | 16 | 1 | 2 |

| 142×16 | Bottleneck_A | 6 | 32 | 3 | 1 |

| 142×32 | Bottleneck_A | 6 | 48 | 3 | 1 |

| 142×48 | Bottleneck_I | 6 | 48 | 1 | 2 |

| 72×48 | Bottleneck_A | 6 | 80 | 2 | 1 |

| 72×80 | Bottleneck_A | 6 | 160 | 1 | 1 |

| 72×160 | PW卷积 | − | 640 | − | 1 |

| 72×640 | 平均池化 | − | 640 | − | 1 |

| 72×640 | PW卷积 | − | 14 | − | 1 |

1.1. MobileNet v2

MobileNet v2[19]是谷歌团队于2018年提出的轻量级神经网络,其相较于MobileNet v1版本,模型参数量降低了20%,但其精度却超过MobileNet v1. MobileNet v2主要特性包含:1)使用深度可分离卷积代替普通卷积,以降低模型的计算量和参数量;2)提出反向残差结构加深网络层数和增强特征的表达能力;3)采用线性瓶颈结构代替非线性瓶颈,减少低维特征信息的丢失.

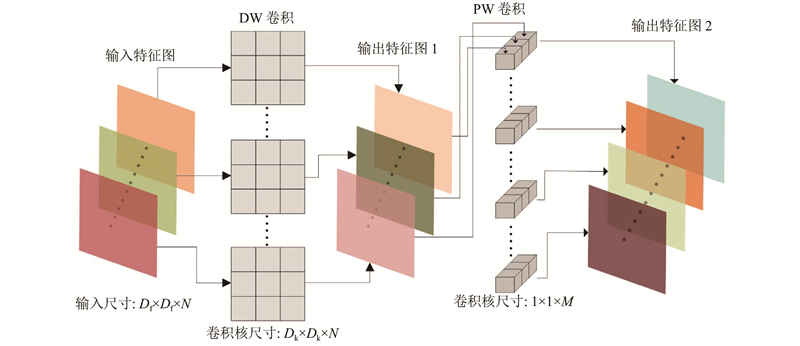

深度可分离卷积由深度卷积(depthwise convolution,DW)和逐点卷积(pointwise convolution,PW)组成. 深度卷积不同于普通卷积,在卷积过程中,特征图的一个通道仅由一个卷积核进行卷积,卷积核的个数等于通道数. 深度卷积的表达式如下:

式中:G为输出特征图,K为宽W、高H的卷积核,X为输入特征图,m表示特征图的第m通道,i、j表示输出特征图在第m通道上的i、j坐标,w、h为第m通道的卷积核权重元素坐标.

逐点卷积和普通卷积基本相同,只是将卷积核的尺寸设置为1×1. 深度可分离卷积的原理图如图2所示,首先利用深度卷积提取每个通道的特征,再利用逐点卷积对通道进行特征关联. 图中,Df、N分别为输入特征图的边长和通道数,Dk为DW卷积核的边长,M为PW卷积的通道数. 深度可分离卷积以较少的参数和计算量代替标准卷积,其与标准卷积的计算量对比如下:

图 2

式中:P1、P2分别为深度可分离卷积和标准卷积的计算量.

在特征提取过程中,通常卷积核的尺寸都是采用3×3大小. 因此,深度可分离卷积的计算量和参数量均约为常规卷积的1/9.

图 3

1.2. 宽度因子调整

宽度因子是MobileNet系列中存在的超参数,在各版本的MobileNet中均可以使用. 宽度因子的作用是将网络中每个模块的卷积核数调整为原来的α倍,α为宽度因子. 在使用深度可分离卷积时,调整α后的计算量如下:

式中:T为深度可分离卷积的计算量. 可以看出,通过调整α可以将模型的计算量和参数量降低至α的平方倍.

MobileNet v1版本通过调整宽度因子得到的效果如表2所示. 表中,括号内为宽度因子,Atop1为模型在ImageNet数据下的top1准确率,GFL为计算量,P为参数量. 可以看出,在调整宽度因子后,虽然损失了一定的精度,但模型的计算量和参数量大幅度降低.

鉴于降低通道因子可以在精度下降可接受范围内减少模型的参数量和计算量,首先通过调整通道因子α=0.5来轻量化MobileNet v2;然后,采用其他优化策略来提高网络的精度,从而在网络轻量化的同时保证较高的精度.

表 2 不同宽度因子下的MobileNet性能表现

Tab.2

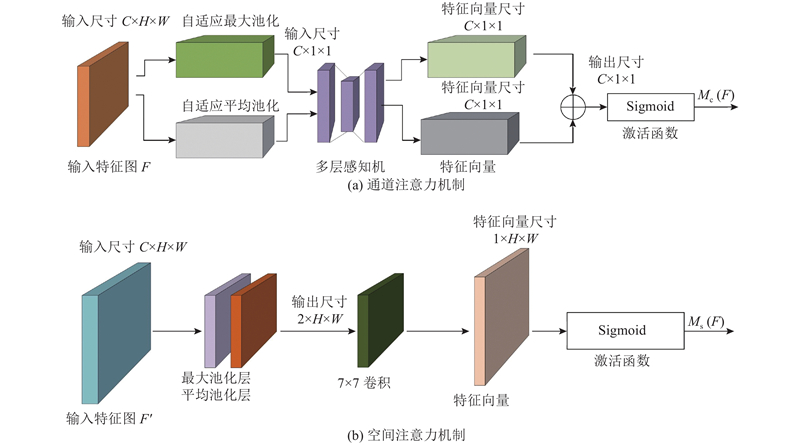

1.3. 通道和空间注意力机制

图 4

式中:F为输入特征图,σ为非线性激活函数sigmoid,f1为不带偏置的多层感知机前向计算函数,f2、f3分别为平均池化函数与最大池化函数,W0、W1为2层线性层的权重,Favg、Fmax分别为输入特征F经过平均池化和最大池化运算后的结果.

空间注意力机制如图4(b)所示,首先沿着通道方向同时进行平均池化和最大池化操作,并将它们连接起来生成一个2×H×W的有效特征描述,随后使用一层卷积层进行卷积计算,将得到的1×H×W的特征向量使用sigmoid函数进行激活,最后输出空间注意力映射Ms. 表达式如下:

式中:f为卷积运算,fc为拼接操作.

CBAM模块就是由上述通道和空间2个顺序子模块构成,整体计算过程如下:

式中:F′为F经过通道注意力机制的加权结果,F″为F′经过空间注意力机制的加权结果.

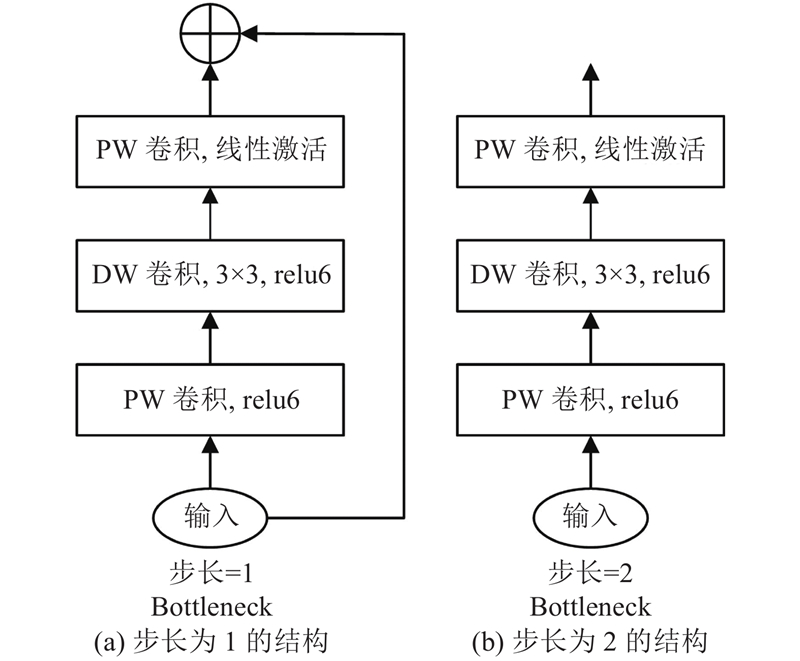

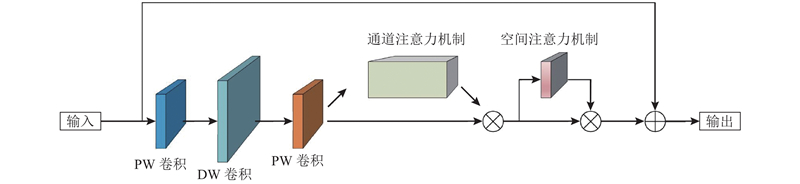

本研究将CBAM模块串联嵌入到MobileNet v2的每个反向残差模块(步长为1下的瓶颈结构)中,使得模型在通道和空间维度上都能关注重要特征,抑制不必要的特征. 模块命名为Bottleneck_A,其在反向残差模块中的位置如图5所示. 在每个具有残差连接的模块中,在第2个PW卷积之后依次串联通道注意力机制和空间注意力机制.

图 5

图 5 带注意力机制的反向残差模块(Bottleneck_A)

Fig.5 Reverse residual module with attention mechanism (Bottleneck_A)

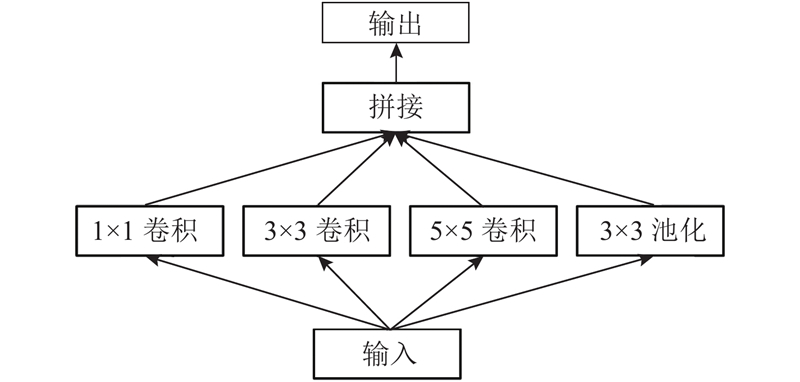

1.4. 多尺度特征融合

图 6

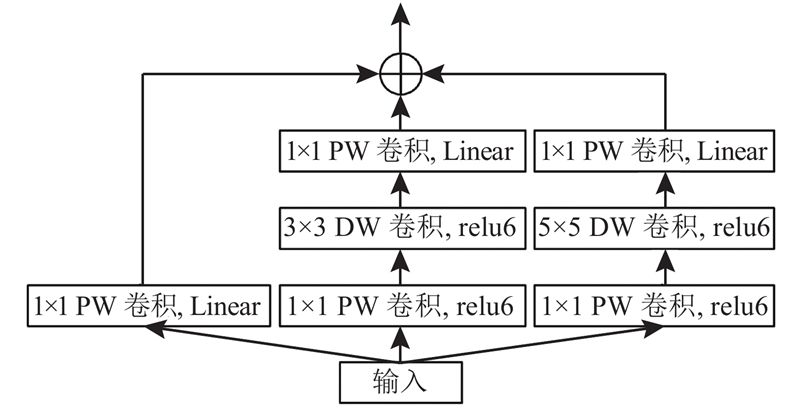

由于MobileNet v2网络使用的是深度可分离卷积,对Inception模块进行改进,将改进后的模块替换为步长为2、不带残差短接的线性瓶颈结构. 改进后的结构如图7所示,采用3条并行分支进行特征提取,分别进行1×1、3×3、5×5的多尺度特征提取,考虑到拼接方法会使输出特征图的通道数增加,导致网络参数量大幅度增加,将拼接方法改为加的方法,以减少模型参数的数量,将改进后的瓶颈结构命名为Bottleneck_I.

图 7

图 7 多尺度特征融合模块(Bottleneck_I)

Fig.7 Multi-scale feature fusion module (Bottleneck_I)

1.5. 迁移学习

迁移学习利用模型在相似任务中的学习权重,避免模型从零开始学习,使模型获得更好的初始化权重参数. 本研究利用MobileNet v2在ImageNet数据集中的预训练权重,优化模型的初始化权重参数,以提升模型的识别精度.

具体步骤如下:下载官方发布的开源模型权重;由于改进模型的部分结构发生了变化,在导入权重时应跳过不匹配的操作层;在模型开始训练前,载入预训练权重.

2. 实验与结果

2.1. 数据集及实验环境

针对垃圾分类任务,目前尚未有标准的专用数据集,因此,按照图像分类任务文件格式建立场景丰富的生活垃圾分类数据集. 垃圾图像数据集来源于网络和现实生活照片,包括单物体、多个同类物体、复杂背景等多个场景,涉及光照、运动模糊、物体变形等多种干扰情况,共14类,累计4 256张图片,具体数量见表3. 在训练过程中,数据集按7∶2∶1划分为训练集、验证集和测试集.

表 3 本研究所提出的数据集样本分布

Tab.3

| 垃圾名称 | 数目/张 | 垃圾名称 | 数目/张 | |

| 毛巾 | 302 | 树叶 | 341 | |

| 塑料袋 | 270 | 纸箱 | 260 | |

| 纸团 | 264 | 碎玻璃 | 283 | |

| 包装袋 | 291 | 瓶子 | 357 | |

| 橘子皮 | 287 | 书 | 298 | |

| 金属块 | 365 | 电池 | 300 | |

| 灯泡 | 321 | 香蕉皮 | 317 |

实验平台电脑配置如下:CPU为Intel Core I5-8500,搭载2张Tesla P100显卡,操作系统为Ubuntu 14.04,python版本为3.6.7,深度学习框架及版本为Pytorch1.7.0. 边缘设备为英伟达公司生产的嵌入式AI边缘计算设备JETSON TX2.

模型的训练使用Tesla P100进行加速训练,对数据集执行随机尺寸裁剪、随机翻转和随机亮度变换等数据增强方式,加强模型的泛化能力. 模型优化器选择Adam,学习率设置为0.001,损失函数使用交叉熵;训练周期设置为200,每批次训练图像16张.

2.2. 消融实验

为了证明网络的各项改进点对模型的性能提升都有贡献,进行消融实验. 在消融实验中,主要以模型在测试集top1准确率为指标,消融实验包括带注意力机制的瓶颈模块、引入多尺度特征融合结构和迁移学习.

为了证明在MobileNet v2中加入CBAM模块能够提升模型准确率,设计对比实验. 在每个具有短接连接的瓶颈结构中,在瓶颈内的第2个PW卷积之后依次串联通道注意力机制和空间注意力机制;为了证明多尺度特征融合结构对模型的贡献,将每个不具备短接连接的瓶颈替换为多尺度特征融合结构;为了证明迁移学习的训练方式能够优化网络参数,对MobileNet v2使用迁移学习的方式初始化模型权重参数.

实验结果如表4所示. 可以看出,对于MobileNet v2压缩通道因子,可以牺牲一定的精度来加速模型的推理,模型精度虽然下降2.2%,但模型的参数量仅为原来的1/4;在加入CBAM模块后,模型在仅增加微量开销的情况下,准确率提高了1.7%,参数量只增加了0.02 M;多尺度特征融合结构以多个大小不同的卷积核对输入特征进行提取,加强了网络对尺度的适应性,同时增加了网络宽度,模型的准确率提升1.3%;使用迁移学习的训练方式,更好地初始化网络参数,模型准确率提升0.8%.

表 4 消融实验结果

Tab.4

| 网络 | 因素 | A/% | P/M | |||

| 宽度 因子 | CBAM | 多尺度 特征融合 | 迁移 学习 | |||

| Mobilenet v2 | − | − | − | − | 92.6 | 2.24 |

| 0.5 | − | − | − | 90.4 | 0.59 | |

| − | √ | − | − | 94.3 | 2.26 | |

| − | − | √ | − | 93.9 | 3.09 | |

| − | − | − | √ | 93.4 | 2.24 | |

| 本研究算法 | 0.5 | √ | √ | √ | 94.6 | 0.83 |

最终,通过压缩宽度因子、引入注意力机制、多尺度特征融合和迁移学习,本研究所提算法在生活垃圾数据集中的准确率较改进前模型高2%,参数量减少约63%,实现了预测准确率和推理速度的提升.

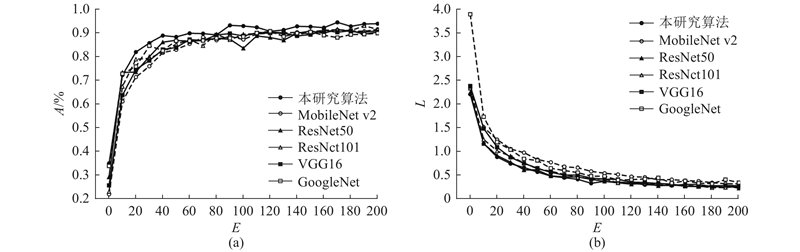

2.3. 算法对比与分析

当前的卷积神经网络种类繁多,为了体现本模型的有效性,选取当下多种流行的神经网络进行实验对比. 实验模型选取当下流行的ResNet、GoogleNet和VGG等模型,分别使用上述模型于本研究的自建数据集中进行训练. 在训练过程中,模型每完成一个训练周期,记录其测试集准确率和训练损失值,以便及时掌握模型的训练情况,确保各个模型在收敛的状态下完成训练.

如图8所示为各个模型在垃圾数据集上的训练结果曲线. 图中,E为训练的迭代周期,A为测试准确率,L为训练损失. 从训练曲线可知,虽然MobileNet v2网络采用了轻量级的深度可分离卷积,但它在垃圾分类任务中仍然取得了优异的成绩,训练效果接近ResNet50,优于VGG16和GoogleNet. 当ResNet结构叠加到101层时,识别效果才略优于MobileNet v2,证明了MobileNet v2网络的性能优势. 本研究算法基于MobileNet v2网络改进,准确率分别比MobileNet v2、ResNet101高2.0%、1.2%,并且网络参数量仅约为MobileNet v2的2/5,ResNet101的1/50,原因如下:1)MobileNet v2本身是优秀的轻量级网络,使用深度可分离卷积降低模型运算量及参数量,构建的反向残差结构有助于特征提取;2)本研究将MobileNet v2的宽度因子进行压缩,实验证明,在宽度因子为0.5时,准确率在下降可接受范围的情况下,压缩宽度因子可以大幅降低模型的参数量;3)本算法引入CBAM结构,在通道及空间的维度上集成了注意力机制,使得重要的特征得到加强,而不重要的特征被抑制;4)将普通不带残差连接的瓶颈结构换成改进后的多尺度特征融合结构,使得网络可以在多尺度上进行特征提取,加大了网络的宽度,提升了模型的鲁棒性;5)迁移学习利用模型在大型数据集中的权重,在相似的任务中能更好地初始化网络参数,进而提升模型的性能.

图 8

为了进一步分析本研究算法在其他分类任务场景下的性能提升效果,添加大型公共数据集CIFAR-100[22]和tiny-ImageNet[23]进行对比实验. 在测试集上的分类精度如表5所示. 表中,AIM为模型在tiny-ImageNet数据集上的测试准确率,ACF为模型在CIFAR-100数据集上的测试准确率. 可以看出,本研究算法在tiny-ImageNet和CIFAR-100数据集中的准确率分别为68.4%、75.4%,准确率超过标准的MobileNet v2,仅次于ResNet101算法. MobileNet v2的准确率低于ResNet101的原因是ResNet101网络层太深,模型复杂,在大型数据集上往往能够取得更好的学习效果. 但ResNet101体积过大,不能保证实时性,在前端计算资源有限的场景中并不会被部署使用. 因此,本研究算法同样适用于其他分类任务,具有普适性,在复杂场景下仍能保持较高的准确率.

在垃圾分类任务中,各模型在本研究自建数据集中的实验结果如表6所示. 表中,Ts为单张图片推理时间(CPU). 可以看出,VGG16模型在测试集的准确率最低,平均准确率为91.2%;本研究算法在测试集的准确率最高,平均准确率为94.6%,并且推理时间最短,在仅使用CPU的情况下,单张图片推理耗时仅为37.97 ms.

表 5 各模型在公共数据集中的测试准确率

Tab.5

| 模型 | AIM/% | ACF/% |

| 本研究算法 | 68.4 | 75.4 |

| MobileNet v2 | 66.2 | 74.0 |

| ResNet101 | 72.3 | 76.5 |

| ResNet50 | 69.4 | 74.6 |

| GoogleNet | 62.7 | 63.9 |

| VGG16 | 64.5 | 70.5 |

表 6 各模型在本研究自建数据集中的训练结果对比

Tab.6

| 模型 | A/% | P/M | Ts/ms |

| 本研究算法 | 94.6 | 0.83 | 37.97 |

| MobileNet v2 | 92.6 | 2.24 | 44.32 |

| ResNet101 | 93.4 | 42.53 | 204.94 |

| ResNet50 | 92.3 | 23.53 | 124.22 |

| GoogleNet | 91.4 | 10.35 | 68.64 |

| VGG16 | 91.2 | 70.32 | 197.28 |

2.4. 算法测试

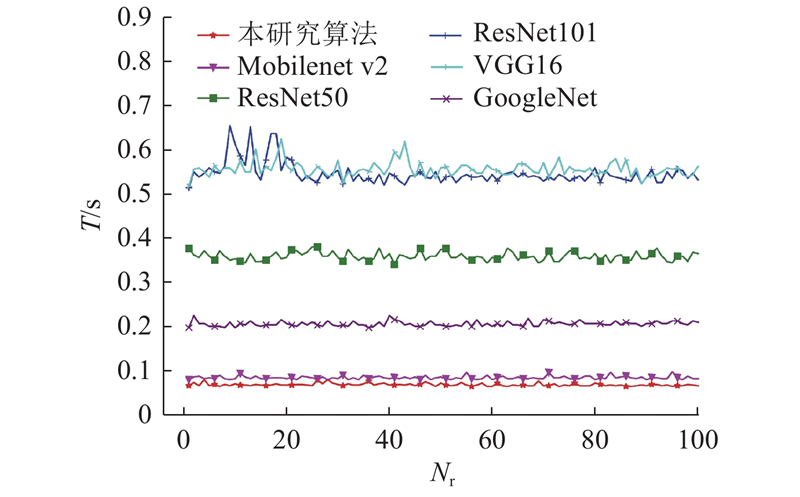

2.4.1. 识别速度测试

将本研究算法、标准的MobileNet v2、ResNet101和ResNet50等模型部署于边缘设备JETSON TX2上,对每个模型利用程序连续识别100次垃圾图像,识别速度如图9所示. 图中,Nr为识别次数,T为单次识别耗时. 由测试结果可知,本研究算法在JETSON TX2上的单次识别平均耗时为0.068 s,比标准的MobileNet v2低0.015 s,速度远超其他大型模型,具有较好的实时效果.

图 9

2.4.2. 识别结果测试

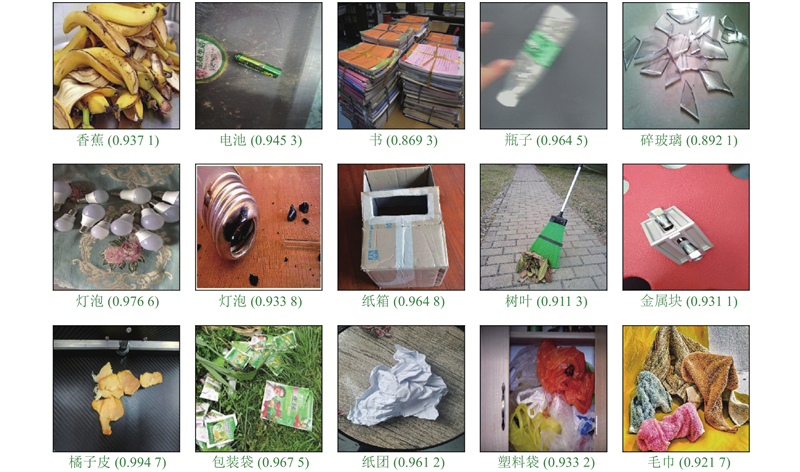

将本算法预测结果进行可视化测试,选取一组常见的真实场景下的生活垃圾图像,将图像传入模型中进行分类识别,结果如图10所示. 图中,括号内的数值是识别结果的置信度. 可以看出,在各种单物体、多个同类物体和复杂背景等环境中,模型都能快速准确地识别出垃圾种类. 因此,本研究提出的改进的MobileNet v2模型是低消耗、高精度的网络模型.

图 10

3. 结 语

对轻量级神经网络MobileNet v2进行改进,应用于垃圾图像分类中. 实验结果表明,嵌入CBAM模块能以较小的开销提升模型准确率;引入多尺度特征融合的识别效果优于普通结构;采用迁移学习的训练方式可以优化模型的初始化权重参数. 实现了垃圾图像分类的低消耗与高精度,对帮助居民基于边缘设备完成垃圾分类具有学术意义和实际应用价值.

本研究算法主要考虑的是单标签的图像分类,在识别单个图像的多个目标物体时存在不足. 今后研究重点是将垃圾分类任务拓展为多标签分类,实现多物体的分类识别,使之能够应用于更多垃圾分类场景.

参考文献

基于横向视角的垃圾回收处理体系的国际比较研究及启示

[J].DOI:10.3969/j.issn.1671-4407.2015.12.022 [本文引用: 1]

An international comparison study and enlightenment of waste recycling system based on lateral perspective

[J].DOI:10.3969/j.issn.1671-4407.2015.12.022 [本文引用: 1]

Vision-based robotic system for on-site construction and demolition waste sorting and recycling

[J].

基于深度迁移学习的垃圾分类系统设计与实现

[J].

Design and implementation of garbage classification system based on deep transfer learning

[J].

基于机器视觉的垃圾自动分类系统设计

[J].

Automatic garbage classification system based on machine vision

[J].

微信小程序在垃圾分类中的应用研究

[J].

Research on WeChat small program in garbage classification application

[J].

Interlinking of IoT, big data, smart mobile app with smart garbage monitoring

[J].

WasNet: a neural network-based garbage collection management system

[J].DOI:10.1109/ACCESS.2020.2999678 [本文引用: 1]

基于轻量级残差网路的垃圾图片分类方法

[J].

Garbage image classification by lightweight residual network

[J].

基于新型空间注意力机制和迁移学习的垃圾图像分类算法

[J].DOI:10.12011/SETP2020-1645 [本文引用: 1]

Classification algorithm of garbage images based on novel spatial attention mechanism and transfer learning

[J].DOI:10.12011/SETP2020-1645 [本文引用: 1]

A novel multi-branch channel expansion network for garbage image classification

[J].DOI:10.1109/ACCESS.2020.3016116 [本文引用: 2]

MF-Net: compute-in-memory SRAM for multibit precision inference using memory-immersed data conversion and multiplication-free operators

[J].