在中老年男性中,前列腺癌(prostate cancer,PCa)是最常见的癌症类型之一. 根据最新的流行病学资料[1-6]显示,近年来我国PCa发病率上升趋势明显. 多参数磁共振成像(multi-parametric magnetic resonance imaging,mp-MRI)作为PCa早期诊断的常规手段之一[6-8],mp-MRI上前列腺癌病灶区域的准确分割对评估病灶恶性程度及引导活检穿刺具有重要意义. 人工勾画前列腺癌病灶区域的准确性依赖于专家经验,且非常耗时[9]. 通过计算机实现前列腺癌病灶区域的自动精确分割具有重要的意义,但目前面临以下3个方面的挑战:1)不同患者的前列腺癌病灶形状和大小具有较大的差异性;2)前列腺癌病灶的边界模糊;3)前列腺癌病灶的多发性,即一个患者的前列腺上可能存在多个前列腺癌病灶.

与基于像素分类的图像分割方法不同,Mask-RCNN采用基于区域分类的图像分割方法[15]. 当Mask-RCNN应用于前列腺癌病灶区域分割时,可以定位存在病灶的候选区域,缩小需要精细分割的范围;针对前列腺癌病灶区域进行优化,提升分割精度.

虽然Mask-RCNN能够提取前列腺癌病灶区域的有效特征,但如何有效融合mp-MRI中的信息需要进一步研究. Tsehay等[16]为了充分利用现有网络模型,将mp-MRI分别放入RGB图像的3个通道,在输入图像层面对mp-MRI信息进行融合. Yang等[17]使用2个并行的卷积网络,分别提取表观扩散系数(apparent diffusion coefficient,ADC)和T2加权(T2-weighted,T2W)图像特征,使用ADC特征图与T2W特征图之间的差距作为约束条件,在网络训练过程中指导卷积网络提取不同序列MRI上的有效特征.Yuan等[18]使用多个并行卷积网络分别提取不同序列MRI特征,通过特征串联的方式对mp-MRI信息进行融合. 虽然这些方法可以同时利用mp-MRI训练网络模型,但是难以充分融合mp-MRI中的高级特征,故模型精度有待提高.

本文提出基于区域分类的图像分割方法SE-Mask-RCNN,实现mp-MRI前列腺区域上前列腺癌病灶的自动分割. 使用Mask-RCNN网络作为基础框架,定位包含前列腺癌病灶的候选区域,对候选区域内的病灶进行精细分割. 提出使用2个并行的卷积网络分别提取ADC和T2W图像特征,使用挤压与激励块(squeeze-and-excitation block,SE-block)对串联的ADC和T2W图像特征间相关性进行建模;利用不同序列MRI中的互补信息,通过显式学习的方式自动标定不同特征通道的权重,提升有用特征并抑制无效特征,有效融合mp-MRI中的有效信息. 实验结果表明,提出的SE-Mask-RCNN能够有效地提升前列腺癌病灶区域的分割精度.

1. 基于SE-Mask-RCNN的前列腺癌病灶自动分割网络

1.1. Mask-RCNN深度学习网络

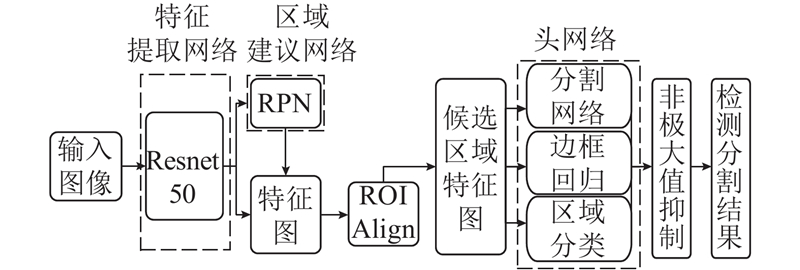

如图1所示,Mask-RCNN深度学习网络结合目标检测与目标的准确分割,主要由3个部分组成:1)特征提取网络;2)区域建议网络(region proposal network,RPN);3)头网络.

图 1

将图像输入到由Resnet50构成的特征提取网络中,得到多个不同层级的特征图. 由RPN生成可能包含检测目标的候选区域. 通过RoI Align层得到候选区域特征图. 候选区域特征图被输入到头网络中,由头网络中的边框回归分支网络对候选区域进行修正;由区域分类分支网络给出候选区域包含检测目标的类别及可能性;由分割网络给出候选区域内检测目标的分割结果. 使用非极大值抑制去除物体存在可能性较小或者交并比较高的候选区域,得到最终的候选区域和分割结果. 与基于像素分类的图像分割网络相比,Mask-RCNN定位并提取可能包含检测目标的候选区域,对候选区域内的目标物体进行更精细的分割.

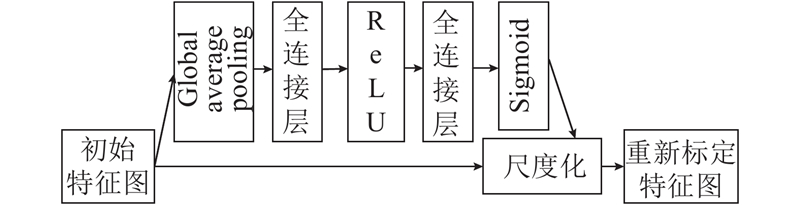

1.2. SE-block

图 2

1.3. SE-Mask-RCNN深度学习网络

为了利用mp-MRI中的有效信息,提升前列腺癌病灶分割精度,提出基于区域分类的、使用双通道卷积网络提取特征的深度卷积神经网络SE-Mask-RCNN.

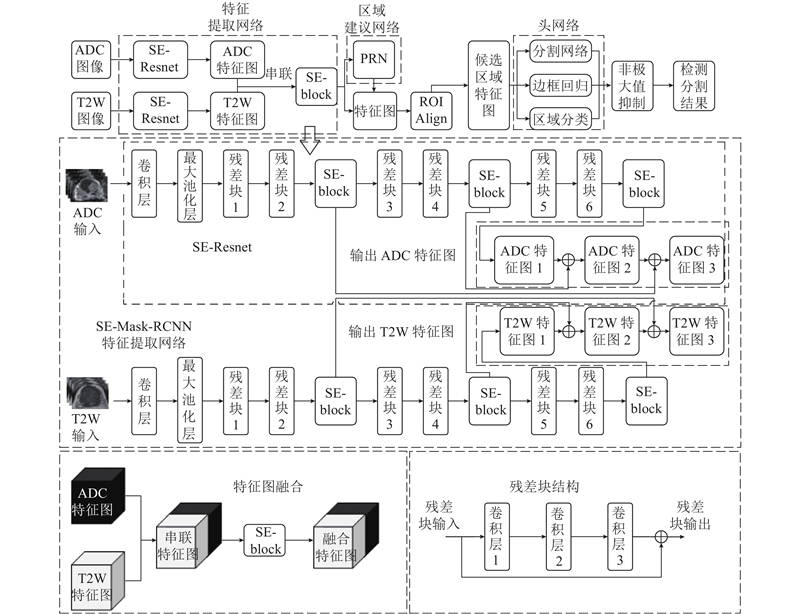

如图3所示,SE-Mask-RCNN与Mask-RCNN的整体框架相同,主要由特征提取网络、RPN网络和头网络3部分构成. 由特征提取网络提取输入图像特征图,由RPN给出特征图上的候选区域. 通过RoI Align层获得候选区域特征图并输入到头网络中,由头网络对候选区域存在病灶的概率进行评估,对候选区域的位置和大小进行修正并分割出候选区域内的前列腺癌病灶区域. 使用非极大值抑制法除去小概率存在病灶的候选区域和重叠程度较高候选区域,得到最终的候选区域和病灶分割结果.

图 3

图 4

图 4 SE-block改进的mp-MRI信息融合方式

Fig.4 mp-MRI information fusion method improved by SE-block

如图3所示,SE-Mask-RCNN特征提取网络中使用并行的2个SE-Resnet网络,分别提取不同序列MRI图像的3个层级特征图,通过串联的方式构成串联特征图. 使用SE-block分别对每个串联特征图不同特征通道间的相关性建模,自动标定不同特征通道权重,提升串联特征图中的有用特征并抑制无关特征,得到融合了mp-MRI有效信息的融合特征图.

SE-Resnet中处理输入图像的卷积层采用步长为1的7×7卷积核进行卷积,最大池化层采用3×3池化操作. 所有残差块具有相似的结构,都由3个卷积层构成,其中卷积层1和卷积层3卷积操作的卷积核均为1×1,卷积层2卷积操作的卷积核为3×3. 将残差块1、残差块3和残差块5中卷积层2的步长设为2,以实现特征图的降采样,卷积层1和卷积层3的步长均为1. 在其他残差块中,所有卷积层步长均设为1. 综合考虑性能和计算效率,仅在残差块2、残差块4和残差块6后分别添加1个SE-block,分别筛选3个不同层次特征图上的有效特征. 将高层级特征图上采样后与低层级特征图相加,得到兼顾图像细节信息和整体信息的多尺度均衡特征图.

2. 实验分析

2.1. 数据选取

回顾性分析苏州大学附属第二医院2015年1月至2017年3月期间的140例前列腺癌患者的ADC和T2W图像. 在140例患者中,患者的平均年龄为74.4岁,范围为51~93. 在这些患者中,129例患者前列腺区域存在1个前列腺癌病灶,11例患者存在2个前列腺癌病灶,总计151个病灶. 对于每例前列腺癌患者mp-MRI数据,由放射科医生选择其中1~3对能清晰可见前列腺癌病灶的ADC和T2W图像对. 总共产生了273个ADC-T2W图像对,作为数据集. 选取2015年1月至2016年10月间的112例患者的219个ADC-T2W图像对作为训练集,剩下的2016年11月至2017年3月间的28例患者中,随机选择14名患者的27个ADC-T2W图像对作为验证集,剩下14名患者的27个ADC-T2W图像对作为测试集.

2.2. 数据预处理

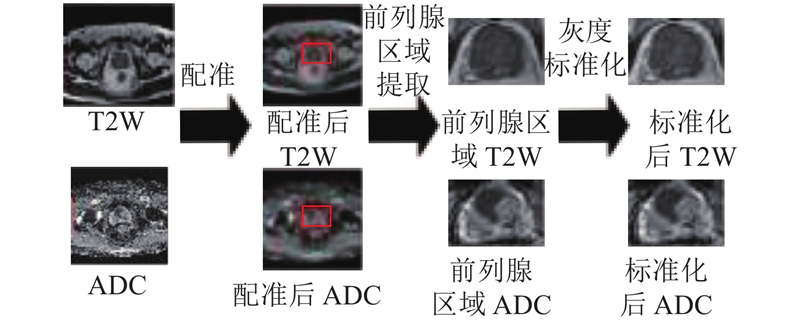

如图5所示为数据预处理中配准、前列腺区域提取和灰度标准化流程示例.

图 5

为了有效利用ADC和T2W图像上的信息,需要对ADC和T2W图像进行配准操作. Liu等[20]提出在前列腺形变较小的情况下,使用存储在DICOM图像中的坐标信息进行配准的方法,具有简单、有效的优点. 本文使用的患者数据,均通过形变筛选,满足使用交互的坐标信息进行配准的条件. 使用存储在不同序列MRI中的坐标信息进行配准.

前列腺MRI图像包含的人体组织结构较多,前列腺区域仅占图像中的一小部分. 直接在前列腺MRI图像上分割前列腺癌病灶,容易受到其他组织结构信息的干扰,导致分割结果较差. 手动将前列腺区域框选出来,方框大小以恰好能包含整个前列腺区域为准,将背景影响降至最小.

由于在不同病人间,前列腺mp-MRI的灰度分布范围存在一定的差异,为了降低灰度分布范围的差异性对前列腺癌病灶自动分割结果的影响,对前列腺区域mp-MRI图像灰度分别进行标准化[16].

在训练集中,使用左右和上下翻转的刚性扩增方法和滑动最小二乘变换的非刚性扩增方法,对数据进行扩增. 对于每一个训练图像,随机选取10个点作为初始点集. 对点集中的每一个点,横坐标随机移动x个像素,纵坐标移动y个像素(x、y的取值为[−5,5])产生变换后的点集. 计算出初始点集和变换后点集之间对应的滑动最小二乘变换[21](moving least squares),对原始图像使用该变换产生非刚性扩增数据. 通过非刚性数据扩增,将训练集中的数据量扩增至原先的5倍. 在训练过程中,使用在线数据扩增,对每一个batch的图像进行左右和上下翻转的刚性扩展. 本文未在验证集和测试集中使用数据扩增.

2.3. 模型训练

在训练过程中,使用Adam优化器(Adam optimizer)实现梯度下降算法,寻找使误差函数最小的网络参数. 设置初始网络学习率为0.0001,设置epoch为100. 在网络训练过程中,epoch为50时学习率降低为0.00005.Batch大小设为2.

所有模型的训练、验证及测试均在同一台Windows 10系统环境的计算机上运行. 计算机配置为:Intel i7-9700k@3.60 GHz CPU和11 GB显存的NVIDIA GTX 1080Ti显卡. 主要的软件环境如下:Python 3.6,CUDA 10.1,Keras2.2.4,底层架构为tensorflow1.10.0等.

2.4. 评价指标

式中:P表示预测得到的病灶区域,G表示医生勾画的病灶区域.

敏感度能够有效反映分割结果对病灶区域的敏感程度,特异度能够有效评估得到的假阳性比例,阳性预测值(positive predicted value,PPV)能够得到真实病灶在检测出的阳性病灶中所占比例. 敏感度、特异度和阳性预测值的公式表示如下:

将被正确分为病灶区域的像素个数作为真实阳性(true positive,TP),被正确分为正常组织的像素个数作为真实阴性(true negative,TN),被错误分为病灶的像素个数记为假阳性(false positive,FP),被错误分为正常组织的像素个数记为假阴性(false negative,FN).

3. 结果分析

3.1. 基于像素分类的图像分割模型与基于区域分类的图像分割模型性能对比

对比基于区域分类的图像分割网络Mask- RCNN[15]和3种典型的基于像素分类的图像分割网络模型(U-net[14]、V-net[24]以及ISHIOKA等[25]提出的T2W前列腺癌病灶自动分割的Resnet50-U-net). 其中,Mask-RCNN采用Resnet50作为特征提取网络.表1给出不同模型的分割结果,其中ADC+T2W表示对应的网络模型将ADC和T2W图像串联成双通道图像后作为输入进行训练和测试. 如表1所示,在仅使用ADC或者T2W图像以及同时使用ADC和T2W图像作为模型输入时,Mask-RCNN在DSC、特异度和PPV上均优于基于像素的图像分割模型. U-net、V-net和Resnet 50-U-net等基于像素分类的图像分割模型仅在敏感度上优于Mask-RCNN.

表 1 前列腺癌病灶分割不同网络模型结果的定量比较

Tab.1

| 网络模型 | MRI类型 | DSC | 敏感度 | 特异度 | PPV |

| U-net | ADC | 0.539 | 0.639 | 0.970 | 0.324 |

| V-net | ADC | 0.525 | 0.707 | 0.945 | 0.472 |

| Resnet50-U-net | ADC | 0.525 | 0.720 | 0.956 | 0.462 |

| Mask-RCNN | ADC | 0.592 | 0.582 | 0.979 | 0.680 |

| U-net | T2W | 0.370 | 0.651 | 0.886 | 0.283 |

| V-net | T2W | 0.343 | 0.580 | 0.896 | 0.282 |

| Resnet50-U-net | T2W | 0.349 | 0.624 | 0.902 | 0.276 |

| Mask-RCNN | T2W | 0.403 | 0.395 | 0.962 | 0.473 |

| U-net | ADC+T2W | 0.562 | 0.765 | 0.955 | 0.480 |

| V-net | ADC+T2W | 0.553 | 0.763 | 0.949 | 0.476 |

| Resnet50-U-net | ADC+T2W | 0.561 | 0.683 | 0.972 | 0.532 |

| Mask-RCNN | ADC+T2W | 0.612 | 0.653 | 0.968 | 0.650 |

如图6所示,为了能够直观展示不同网络模型的分割结果,随机选取5组患者的病灶分割结果. 图中,第1列和第2列分别为T2W和ADC图像,第3列为医生勾画的标准(ground truth,GT)分割结果,第4~7列分别为U-net、V-net、Resnet50-U-net、Mask-RCNN分割结果.

图 6

图 6 不同网络模型mp-MRI前列腺癌病灶分割结果示例

Fig.6 Examples of prostate cancer lesion segmentation results from different network models on mp-MRI

图6中,标记区域表示分割出的前列腺癌病灶区域. 比较不同模型对5位患者肿瘤的分割结果可知,U-net、Resnet50-U-net和V-net对前列腺癌边缘的分割精度较差,明显存在过分割或欠分割的情况. U-net、Resnet50-U-net对图6(a)的分割结果中存在较多的假阳性. 虽然Mask-RCNN模型分割出的病灶区域敏感度低于U-net、V-net等基于像素分类的图像分割模型,但是Mask-RCNN能够分割出主要的病灶区域,且假阳性区域较少. 综合表1的数据以及图5的可视化样例可知,基于区域分类的图像分割算法Mask-RCNN在前列腺癌病灶分割任务上的分割精度优于U-net、Resnet50-U-net等基于像素分类的图像分割方法.

对于同一个网络结构,同时使用ADC和T2W图像训练得到的模型的分割结果均在多个指标上优于使用单序列MRI训练得到的网络模型的分割结果. 由此可见,与单序列MRI相比,使用mp-MRI图像能够有效提升前列腺癌病灶区域的自动分割精度.

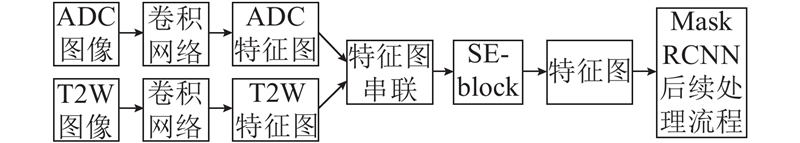

3.2. SE-block改进的mp-MRI信息融合方式

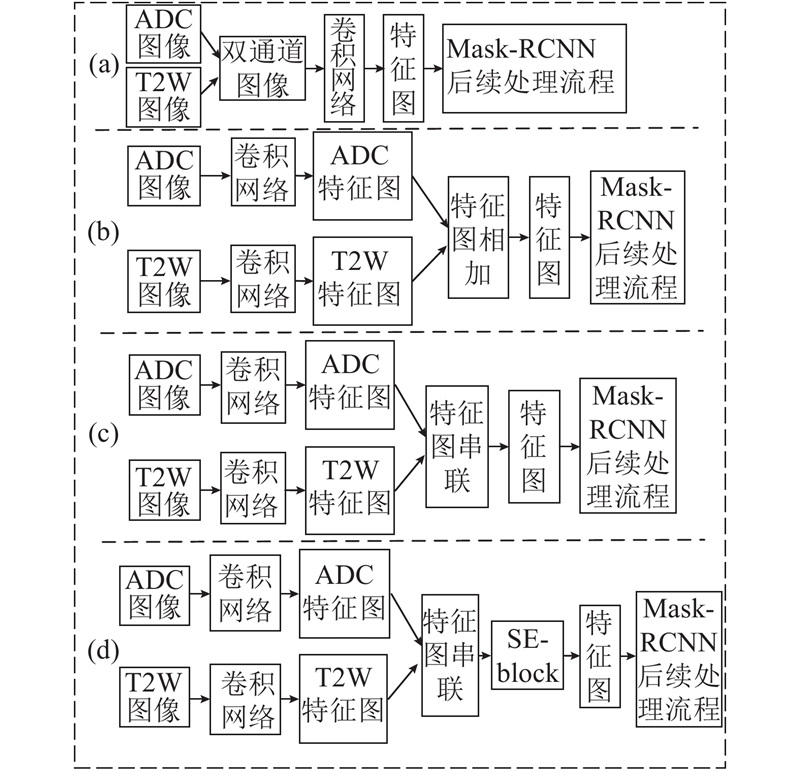

针对Mask-RCNN最初应用在自然图像的物体检测分割任务中,没有考虑mp-MRI信息的有效融合,提出应用于Mask-RCNN的SE-block改进的mp-MRI信息融合方式. 为了验证提出的mp-MRI信息融合方法的有效性,与其他3种在其他研究中常用的mp-MRI信息融合方式进行比较. 如图7(a)所示为输入图像串联的融合方式,将双通道图像输入到一个卷积网络中,提取出融合mp-MRI信息的特征图. 如图7(b)所示为特征图相加的融合方式. 将ADC和T2W图像分别输入2个并行的卷积网络,提取ADC和T2W的特征图,将ADC和T2W的特征图相加得到融合mp-MRI信息的特征图. 如图7(c)所示为特征图串联的融合方式. 与图7(b)不同的是,在得到ADC和T2W特征图后,通过ADC和T2W的特征图串联的方式得到融合mp-MRI信息的特征图. 如图7(d)所示为提出的SE-block改进的mp-MRI信息融合方式,下文简称为SE-特征图串联. 与图7(c) 不同的是,使用SE-block对图7(c) 得到的串联特征图中不同特征通道间的相关性建模,自动标定不同特征通道的权重,提升有用特征并抑制无关特征.

图 7

由于使用2个并行卷积网络会使得网络参数量大大增加,为了避免过拟合对不同信息融合方式效果的比较造成影响,分别使用Resnet50和参数量大大减少的SE-Resnet作为图7的卷积网络来提取特征. 综合考虑性能和计算效率,将SE-block的数量设置为3,分别筛选3个不同层次的特征图上的有效特征.

如表2所示,当使用Resnet50作为卷积网络时,采用SE-特征图串联方式的分割结果在DSC、敏感度、特异度和PPV上均优于其他3种mp-MRI信息融合方式的分割结果. 当使用SE-Resnet作为卷积网络时,虽然采用SE-特征图串联方式得到的分割结果在特异度和PPV上与采用输入图像串联方式得到的分割结果相同,但是DSC和敏感度明显更优. 虽然采用SE-特征图串联方式得到的分割结果在敏感度和PPV指标上与采用特征图串联方式得到的分割结果相近,但是DSC和PPV明显提升. 对比特征图相加方式可知,SE-特征图串联方式的分割结果在4个评价指标上均更优. 由此可得,在mp-MRI前列腺癌病灶自动分割任务中,采用SE-特征图串联的mp-MRI信息融合方式得到的分割结果优于其他3种mp-MRI信息融合方式的分割结果. 当使用SE-Resnet作为卷积网络时,SE-特征图串联融合方式取得了最好的前列腺癌病灶分割结果.

表 2 4种mp-MRI信息融合方式对比

Tab.2

| 融合方式 | 卷积网络 | DSC | 敏感度 | 特异度 | PPV |

| 输入图像串联(Mask-RCNN) | Resnet50 | 0.612 | 0.653 | 0.968 | 0.650 |

| 特征图相加 | Resnet50 | 0.611 | 0.667 | 0.966 | 0.643 |

| 特征图串联 | Resnet50 | 0.609 | 0.645 | 0.968 | 0.659 |

| SE-特征图串联 | Resnet50 | 0.630 | 0.676 | 0.970 | 0.663 |

| 输入图像串联 | SE-Resnet | 0.637 | 0.660 | 0.970 | 0.685 |

| 特征图相加 | SE-Resnet | 0.638 | 0.684 | 0.970 | 0.658 |

| 特征图串联 | SE-Resnet | 0.640 | 0.697 | 0.967 | 0.652 |

| SE-特征图串联(SE-Mask-RCNN) | SE-Resnet | 0.654 | 0.695 | 0.970 | 0.685 |

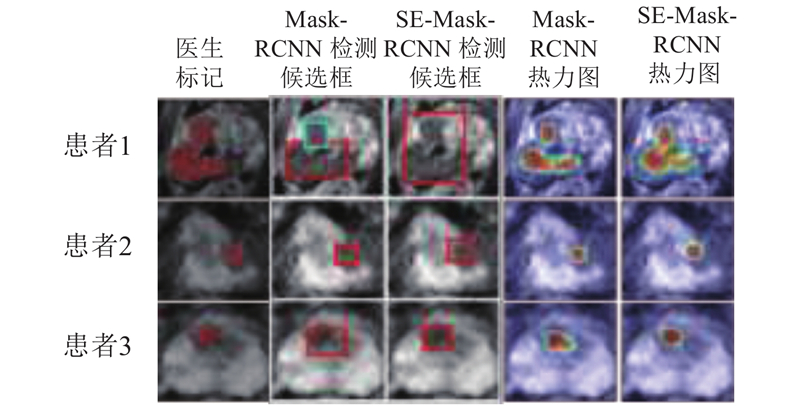

如图8所示,为了比较提出的SE-Mask -RCNN与Mask-RCNN在前列腺癌病灶自动分割任务中的性能,随机选取3组患者分割结果作为示例. 对于每个患者示例,给出医生标记、Mask-RCNN和SE-Mask-RCNN检测得到的候选区域及对应的热力图. 从图8可以看出,对于患者1,SE-Mask-RCNN能够有效地找到前列腺癌病灶的候选区域. Mask-RCNN将病灶分为2个候选区域分别进行处理,导致2个区域间的病灶区域分割不准确. 对于患者2,SE-Mask-RCNN得到的候选区域能够比Mask-RCNN得到的候选区域更好地包含整个病灶区域,对病灶边缘的分割结果更好. 对于患者3,Mask-RCNN得到的候选区域过大,分割出的病灶区域相对医生标记有较大偏差. SE-Mask-RCNN能够较准确地找到病灶区域,分割结果更贴近于医生的标准. 结合统计结果和直观比较可知,提出的SE-Mask-RCNN比原始的Mask-RCNN能够有效提升前列腺癌病灶的分割精度.

图 8

为了探究SE-特征图串联融合方式在使用SE-Resnet作为卷积网络时的分割结果优于使用Resnet50作为卷积网络分割结果的原因,对比去掉SE-Resnet中SE-block时的分割结果. 如表3所示,ADC SE-Resnet为图7(d)中提取ADC特征图的卷积网络,T2W SE-Resnet为图7(d)中提取T2W特征图的卷积网络,去掉SE-block表示将SE-Resnet中的所有SE-block去掉. 由表3可知,当2个并行的SE-Resnet中有1个去掉了SE-block时,除了敏感度稍微有所提升,其他3个指标均明显下降. 当2个并行的SE-Resnet中的SE-block都去掉时,4个指标均明显下降,且多个指标低于表2中使用Resnet50作为卷积网络的分割结果.

表 3 卷积网络SE-block去除方式性能比较

Tab.3

| 融合方式 | ADC SE-Resnet是否去掉SE-block | T2W SE-Resnet是否去掉SE-block | DSC | 敏感度 | 特异度 | PPV |

| SE-特征图串联 | 否 | 否 | 0.654 | 0.695 | 0.970 | 0.685 |

| SE-特征图串联 | 否 | 是 | 0.633 | 0.722 | 0.960 | 0.634 |

| SE-特征图串联 | 是 | 否 | 0.633 | 0.726 | 0.960 | 0.630 |

| SE-特征图串联 | 是 | 是 | 0.621 | 0.641 | 0.975 | 0.670 |

3.3. 模型计算时间对比

在本文的患者数据中,一位患者单个序列的MRI图像数约为30. 本文方法和其他方法从单张MRI图像前列腺区域自动分割出前列腺癌病灶时间,如表4所示.

表 4 不同模型平均处理图像时间

Tab.4

| 模型 | 运算时间/ms |

| U-net | 78 |

| V-net | 84 |

| Resnet50-U-net | 85 |

| Mask-RCNN | 131 |

| SE-Mask-RCNN | 144 |

从表4可知,虽然SE-Mask-RCNN比其他4种方法的处理时间长,但是处理一位患者的所有图像只需要3.0~4.0 s,在临床使用可接受的范围内. SE-Mask-RCNN相比于Mask-RCNN只是较小程度上增加了计算时间,在临床使用中的影响较小.

4. 实验讨论

针对mp-MRI前列腺癌病灶自动分割任务中存在的病灶间形状大小差异大、病灶边界模糊和病灶多发性问题,提出适用于mp-MRI前列腺区域前列腺癌病灶区域自动分割的SE-Mask-RCNN深度学习方法. 利用该方法检测出可能包含前列腺癌病灶的候选区域,基于候选区域实现病灶的精细分割. 使用SE-特征图串联的信息融合方法,能够充分融合mp-MRI中的有效信息,从而提升分割精度.

在本研究过程中发现,基于区域分类的Mask-RCNN分割性能优于几种经典的基于像素分类的语义分割网络. 这可能是由于Mask-RCNN能够搜索定位病灶候选区域,缩小了前列腺癌病灶分割的候选区域. 基于像素分类的分割网络从整幅输入图像中分割出病灶区域,需要学习的区域较大,不能充分学习病灶区域特征,从而限制了分割精度.

与其他3种mp-MRI信息融合方式相比,利用提出的SE-特征图串联信息融合方式得到的分割结果在4个指标上均优于其他3种mp-MRI信息融合方式. 通过输入图像串联的信息融合方式虽然能够提取出融合mp-MRI信息的特征,但是没有充分提取不同序列MRI上特有的高级特征,限制了前列腺癌自动分割性能. 特征图串联和特征图相加的信息融合方式虽然能够有效提取不同序列MRI特有的高级特征,但没有显式地考虑不同特征的有效性及不同特征通道间的关联,不能充分融合不同序列MRI的有效特征. 提出的SE-特征图串联信息融合方式能够提取出不同序列MRI上特有的高级特征,通过SE-block显式地学习不同特征间的联系,提升串联特征图中的有用特征并抑制无关特征,从而提升了前列腺癌病灶分割精度. 针对使用SE-特征图串联信息融合的方式,使用SE-Resnet作为卷积网络时的分割结果优于使用Resnet50作为卷积网络的现象进行研究. 实验结果表明,去掉2个并行SE-Resnet中的所有SE-block时,得到的分割精度大大降低,且低于使用Resnet50作为卷积网络时的分割结果. SE-Resnet中的SE-block在mp-MRI特征融合前对提取出的单序列MRI特征进行筛选,提升了有用特征并抑制无关特征,得到更有效的单序列MRI特征.

目前,除了ADC和T2W图像,动态增强磁共振成像(dynamic contrast enhanced MRI,DCE-MRI)在前列腺癌诊断中具有重要作用[26]. 进一步的研究方向是扩展SE-Mask-RCNN的特征提取网络,充分融合ADC、T2W和DCE-MRI图像信息,提升前列腺癌病灶区域的自动分割精度.

5. 结 语

本文提出改进的深度卷积网络分割模型SE-Mask-RCNN,可以实现mp-MRI前列腺区域上前列腺癌病灶的自动准确分割. 不同于基于像素分类的图像分割网络直接在网络输入图像上分割病灶的方法,该方法在检测定位前列腺癌病灶候选区域的基础上对病灶进行精细分割,避免其他区域的干扰,增强对病灶区域特征的学习. 使用SE-block改进的特征图串联信息融合方式,对mp-MRI特征间的相关性建模,提升有用特征并抑制无关特征. 实验结果表明,利用该方法能够有效地提升前列腺癌病灶自动分割的精度.

参考文献

Cancer statistics in China, 2015

[J].DOI:10.3322/caac.21338 [本文引用: 1]

Annual report on status of cancer in China, 2011

[J].

中国各类癌症的发病率和死亡率现状及发展趋势

[J].DOI:10.3969/j.issn.1000-2715.2018.06.001

Trends of cancer incidence and mortality in China

[J].DOI:10.3969/j.issn.1000-2715.2018.06.001

2018全球癌症统计报告解读

[J].

Interpretation on the report of global cancer statistics 2018

[J].

Cancer statistics, 2019

[J].

Multiparametric magnetic resonance imaging vs. standard care in men being evaluated for prostate cancer: a randomized study

[J].DOI:10.1016/j.urolonc.2014.09.013 [本文引用: 2]

Can clinically significant prostate cancer be detected with multiparametric magnetic resonance imaging? a systematic review of the literature

[J].DOI:10.1016/j.eururo.2015.01.013

MRI在前列腺癌诊断和治疗中的应用

[J].

MRI in clinical diagnosis and treatment of prostate cancer

[J].

一种改进的I-Unet网络的皮肤病图像分割算法

[J].

An improved skin disease image segmentation algorithm based on I-Unet network

[J].

多分类CNN的胶质母细胞瘤多模态MR图像分割

[J].

Glioblastoma multiforme nulti-modal MRI images segmentation using multi-class CNN

[J].

改进的全卷积神经网络的脑肿瘤图像分割

[J].

A brain tumor image segmentation method based on improved fully convolutional neural network

[J].

基于深度学习的图像语义分割方法综述

[J].

Review of image semantic segmentation based on deep learning

[J].

Co-trained convolutional neural networks for automated detection of prostate cancer in multi-parametric MRI

[J].DOI:10.1016/j.media.2017.08.006 [本文引用: 1]

Prostate cancer classification with multiparametric MRI transfer learning model

[J].DOI:10.1002/mp.13367 [本文引用: 1]

In vivo MRI based prostate cancer localization with random forests and auto-context model

[J].DOI:10.1016/j.compmedimag.2016.02.001 [本文引用: 1]

Computer-aided diagnosis of prostate cancer using multi-parametric MRI: comparison between PUN and Tofts models

[J].DOI:10.1088/1361-6560/aab956 [本文引用: 1]

Computer‐aided diagnosis of prostate cancer on magnetic resonance imaging using a convolutional neural network algorithm

[J].DOI:10.1111/bju.14397 [本文引用: 1]

定量动态增强磁共振成像及其在前列腺癌诊断和治疗中的研究进展

[J].DOI:10.3969/j.issn.1674-8034.2015.10.016 [本文引用: 1]

Progress of quantitative dynamic contrast-enhanced magnetic resonance imaging and in diagnosis and evaluation on the therapeutic response of prostate cancer

[J].DOI:10.3969/j.issn.1674-8034.2015.10.016 [本文引用: 1]