Chang等[8-9]将双目视觉应用于自动装配系统中. Semim等[10]结合皮尔逊相关系数,设计基于视觉的发动机缸体搬运系统. Borangiu等[11]结合零件几何及图像信息,提出零件分离、数量统计及零件位姿确定算法. Nerakae等[12]结合机器学习与视觉,提出柔性自动取放系统原型. 钟德星等[13]结合基于改进型Camshift的动态目标识别跟踪算法、单目视觉测距算法,实现了运动工件的自动抓取和装配. Jiang等[14-15]提出目标工件抓取点及抓取角度的计算方法,结合双目视觉及机器人搭建自动抓取系统,分别实现了铆钉及蝴蝶兰培养苗的自动抓取. Guo等[16]结合视觉、深度网络及传感器,赋予机器人自动获取抓取框并判别抓取稳定性的能力. 刘毅等[17]搭建视觉处理系统,通过视觉系统获取猪腹轮廓,引导机器人完成猪腹剖切. Zhang等[18]结合图像预处理、多尺度边缘检测方法、图像分割,实现了焊缝边缘及中心线的准确提取. Abdullah等[19-21]结合人工操作的习惯、力学信息反馈及视觉系统,赋予机器人模拟人类进行装配的能力.

本文针对柔性夹具抓取异形零件特殊场景,考虑夹取后工件与机器人相对位姿不确定的视觉校正问题,提出基于机器视觉的机器人装配位姿在线校正算法. 通过视觉系统配合示教,获取工件的期望位姿;通过对比待校正工件位姿及期望位姿,获取校正量;通过对校正过程进行分析并获取误差来源,进一步减小误差;实现工件平面位姿校正,通过实验验证位姿校正算法的正确性.

1. 手眼装配系统方案

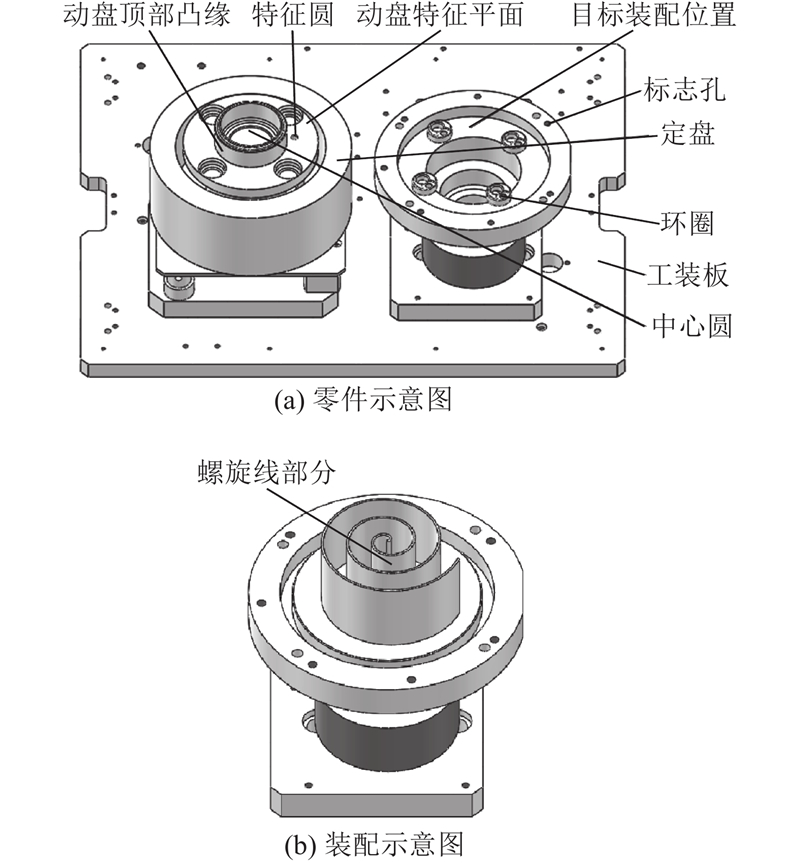

1.1. 装配任务

图 1

1.2. 系统方案

如图2所示,涡旋式汽车空调压缩机动盘自动装配系统包括硬件系统及软件系统. 硬件系统主要由辅助翻转机构、工业机器人、柔性夹具、送料线体、工装板及视觉系统组成;软件系统包括视觉处理程序、上位机程序、PLC程序及机器人程序.

图 2

系统工作流程如下:1)送料线体将工装板运送至动盘装配工位,辅助翻转机构夹取动盘顶部凸缘,将其从定盘中取出并翻转180°;2)机器人通过四爪柔性夹具夹取动盘螺旋线部分,并运动至取像点;3)摄像机获取动盘的图像信息并传送至工控机;4)图像处理程序处理图像,并获得相应的特征数据;5)采用位姿校正算法处理特征数据,获得位姿校正量;6)通过位姿校正量补偿机器人运动,校正动盘位姿并完成装配.

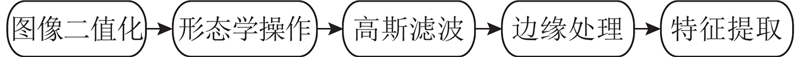

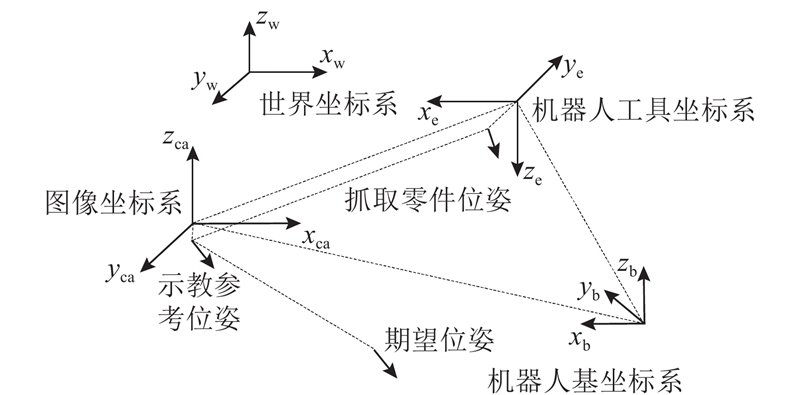

2. 图像处理及位姿信息提取

图 3

图 4

以三维向量描述位姿信息[23],记为

3. 位姿校正算法

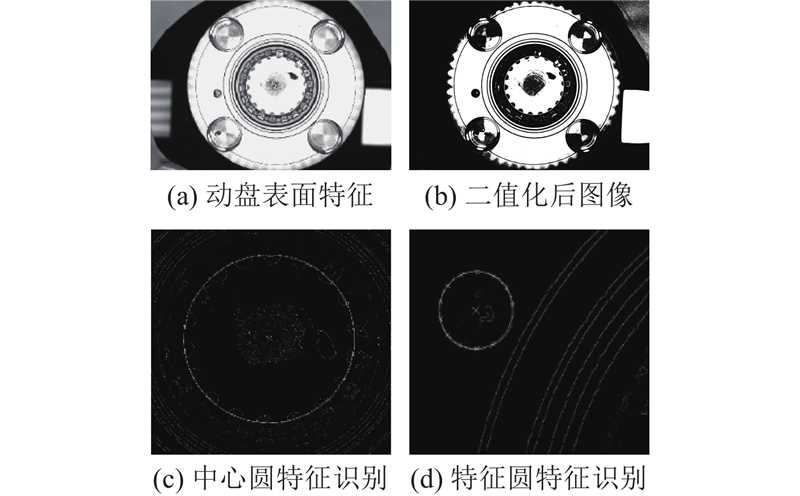

图 5

定义世界坐标系

3.1. 位姿及点位示教

采用示教的方式,获取示教参考位姿及机器人各点位置[4]. 具体步骤如下.

1)机器人末端夹具夹取处于期望位姿的动盘,确保末端夹具夹紧动盘时,动盘状态不发生变化,记此时机器人位置为

2)处于

3)机器人从辅助翻转机构上抓取待校正工件,记录此时机器人位置为

在操作过程中需要注意以下2点:1)运动过程

3.2. 位姿校正算法

3.2.1. 位姿校正量来源分析

利用示教参考位姿与抓取零件位姿的差值对零件的平面位姿进行校正,将该校正量记为原始位姿差,通过绕垂直于安装平面的轴旋转及平面内平移运动进行校正;在柔性夹具夹取异形零件的过程中,由于异形零件角向位置不固定,导致平面内零件的回转中心

综上所述,本文的位姿校正量包括原始位姿差、旋转引入位姿差及残余位姿差,从抓取零件姿态到示教参考姿态的位姿校正量以三维向量

3.2.2. 原始位姿差校正算法

通过视觉系统获得抓取零件位姿

使用原始位姿差坐标分量

3.2.3. 旋转引入位姿差校正算法

对旋转引入位姿差的校正方法分为回转中心坐标计算及位姿差计算两部分. 结合三点确定一个圆,计算机器人末端回转中心坐标,通过机器人末端夹具夹取带有明显特征的工件以一定间隔进行旋转,通过视觉系统获取特征在机器人基坐标系下的一组坐标

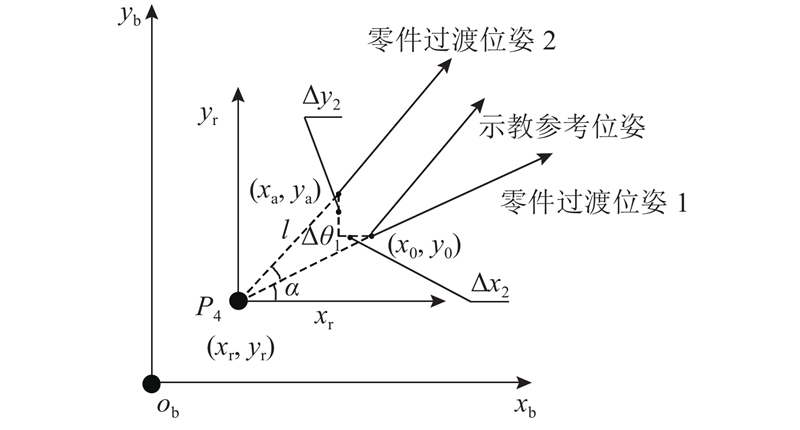

旋转引入位姿差产生的几何模型如图6所示,记完成零件原始位姿差坐标分量校正后的零件位姿为零件过渡位姿1,坐标分量为

图 6

式中:

其中

根据向量起点与终点坐标的关系,确定向量方向,通过

表 1

Tab.1

| | | | |

| | | 0 | 1 |

| | | 2 | −1 |

| | | 1 | −1 |

| | | 1 | 1 |

3.2.4. 残余位姿差校正算法

由于机器人安装误差及夹具夹取误差导致工件特征平面与安装平面无法保持绝对平行,这使得通过圆方程求解的圆心坐标与实际

分析可得如图7所示的误差模型,其中

式中:

式中:

3.2.5. 位置校正量整合算法

由于所求得的原始位姿差、旋转引入位姿差及残余位姿差均为引导机器人末端在基坐标系下进行旋转及平移运动,可以通过线性组合对上述3个位姿差进行整合,获得位姿校正量:

将该位姿校正量反馈给机器人,即可实现工件位姿差补偿,从而完成装配.

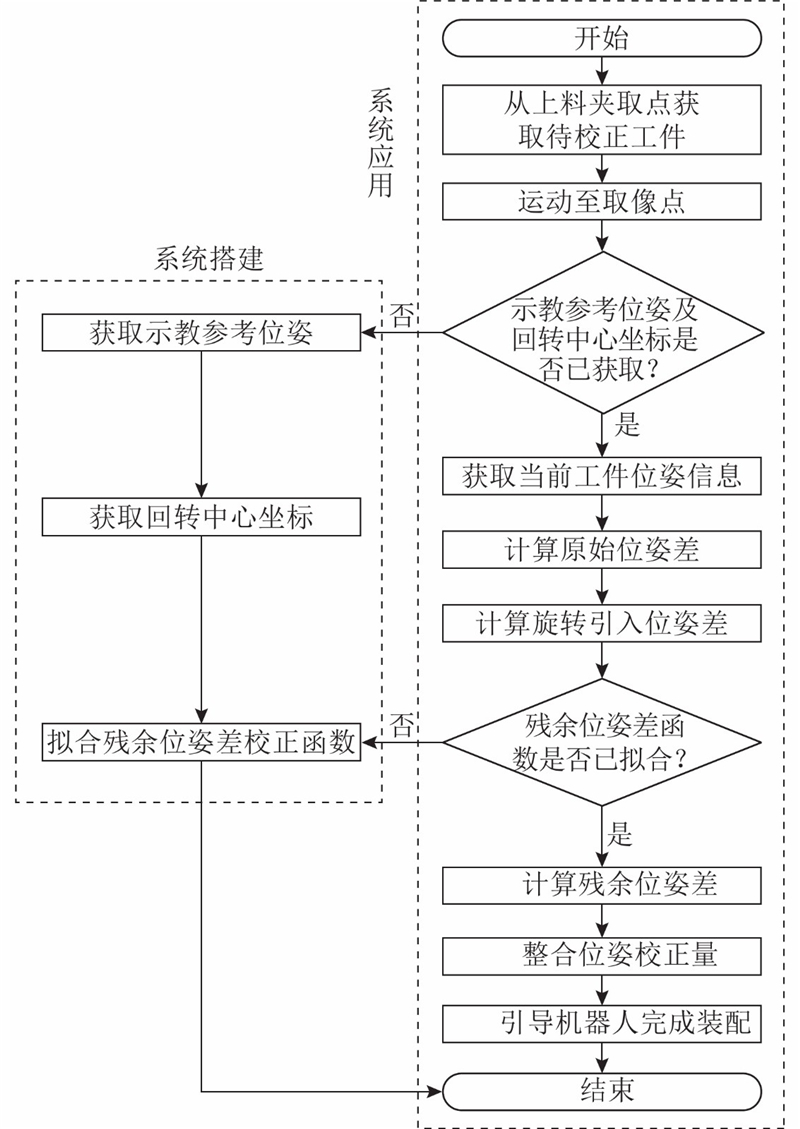

3.3. 位姿校正算法

在实际应用中,回转中心

图 8

图 7

4. 实验与结果分析

4.1. 实验系统搭建

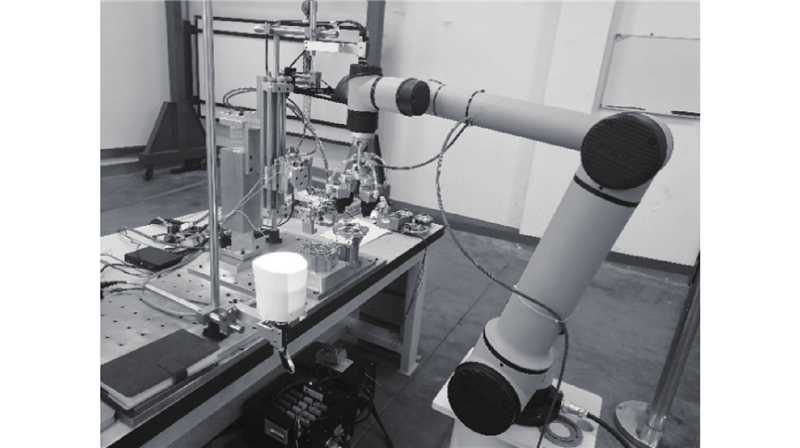

为了分析该方法的有效性及精度,搭建装配实验系统,如图9所示. 硬件系统主要由AUBO-i7机器人、海康威视MV-CE100-30GC工业相机、海康威视MVL-HF0828M-6MP镜头、光源及其控制器、辅助翻转机构、柔触夹爪、西门子S7-1200PLC及PC组成. 软件系统包括视觉处理程序、上位机程序、PLC程序及机器人程序. 系统通过PLC程序,控制气动元件及机器人运动。通过上位机程序控制取像,运行视觉处理程序并计算位姿校正量。通过机器人程序,控制机器人末端夹具。通过视觉处理程序对数字图像进行处理,获取相应的特征及位姿信息.

图 9

4.2. 原始位姿差及旋转引入位姿差校正实验

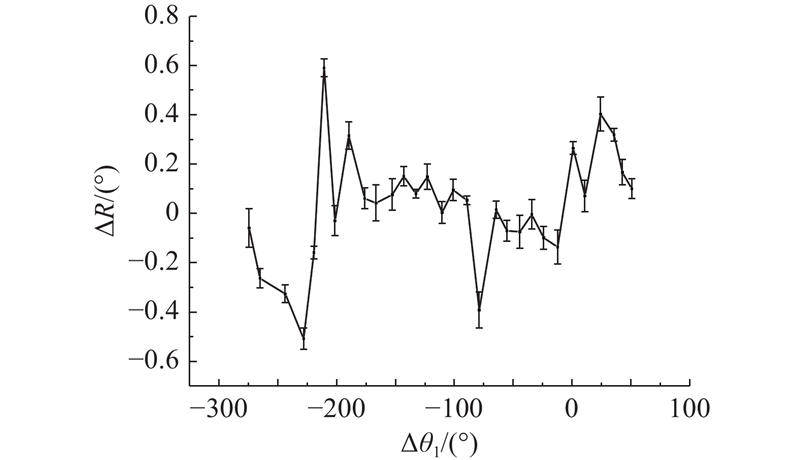

图 10

图 10 残余位姿差角度分量的测量结果

Fig.10 Measurement results of angular component of residual pose difference

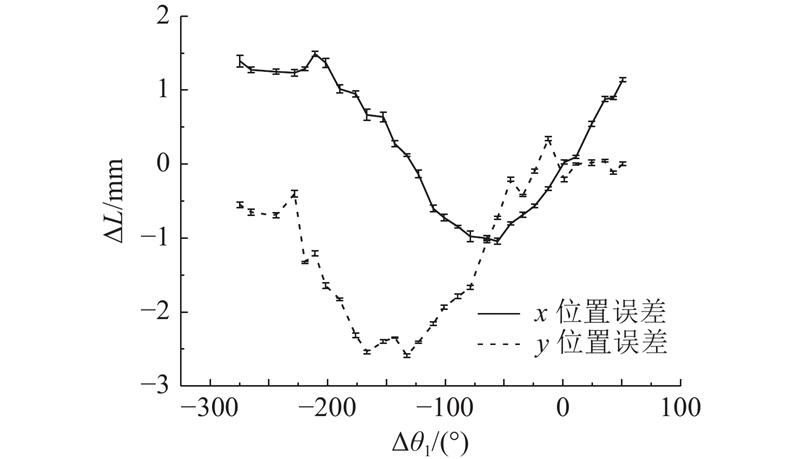

图 11

图 11 残余位姿差位置分量的测量结果

Fig.11 Measurement results of positional component of residual pose difference

4.3. 残余位姿差校正实验

图 12

图 12

Fig.12

Fitting results of

图 13

图 13

Fig.13

Fitting results

表 2 函数参数表

Tab.2

| 项目 | | | | |

| 拟合 | 1.161 | −0.3529 | 0.01923 | 0.2911 |

| 拟合 | 1.246 | 0.2909 | 0.02011 | −1.155 |

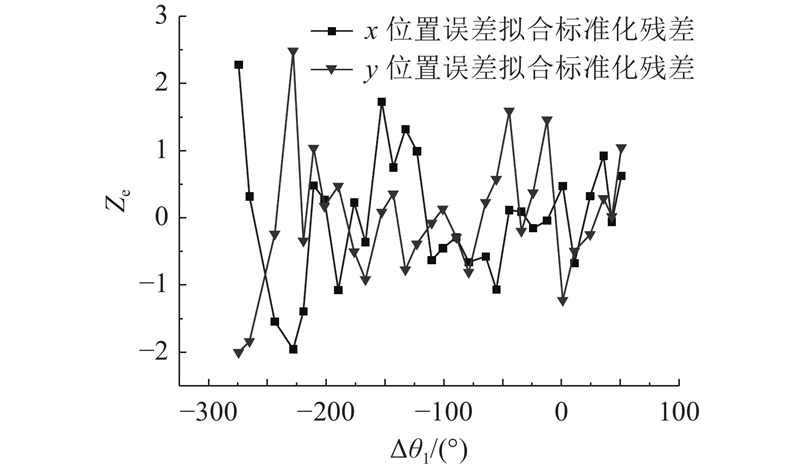

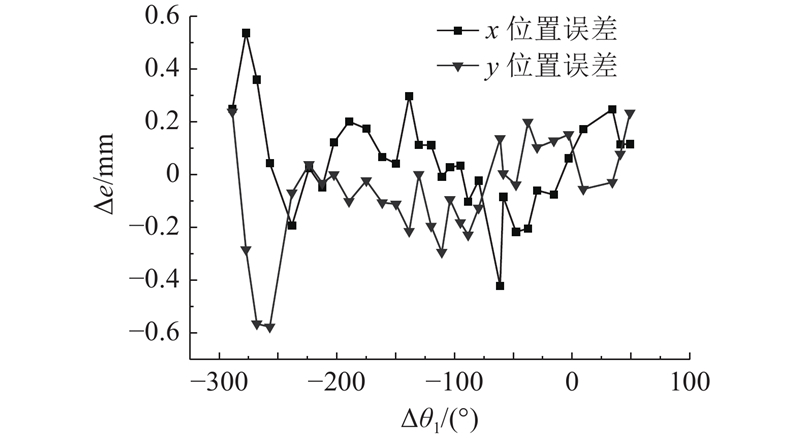

图 14

图 14 位置误差拟合标准化残差图

Fig.14 Standardized residuals diagram of position error fitting

图 15

通过该实验装置进行300次装配实验,实验装配成功率达到99.67%,平均单次装配节拍控制在20 s以内.

5. 结 语

本文针对每次夹取后零件与机器人位姿存在随机偏差的零件,开发基于视觉引导的机器人位姿在线校正算法. 通过视觉系统与机器人系统相结合,扩展了机器人在自动化装配领域的应用,提高了机器人系统的适应性. 通过装配过程特点及误差分析,提出适用于夹取后工件相对于夹具位姿有较大偏差的位姿校正算法,提高了机器人装配系统的精度. 该方法将误差分为原始位姿差、旋转引入位姿差及残余位姿差,通过位姿向量差、几何建模及曲线拟合等方法,实现了机器人抓取平面位姿校正,具有成本较低、装配成功率高、操作过程简单、适应性强等特点. 实验结果表明,该方法对工件位姿向量坐标分量的校正精度达到0.6 mm,角度分量校正精度达到0.6°.

参考文献

Smart and optimal manufacturing: the key for the transformation and development of the process industry

[J].DOI:10.1016/J.ENG.2017.02.016 [本文引用: 1]

Highly flexible assembly–scope and justification

[J].DOI:10.1016/S0007-8506(07)62987-4 [本文引用: 1]

我国工业机器人技术现状与产业化发展战略

[J].

Research status and industrialization development strategy of Chinese industrial robot

[J].

Vision-guided fixtureless assembly of automotive components

[J].

State-of-the-art control strategies for robotic PiH assembly

[J].DOI:10.1016/j.rcim.2019.101894 [本文引用: 1]

A vision guided robotic system for flexible gluing process in the footwear industry

[J].DOI:10.1016/j.rcim.2020.101965 [本文引用: 1]

Design and application of industrial machine vision systems

[J].DOI:10.1016/j.rcim.2007.02.005 [本文引用: 2]

Robotic assembly of Smartphone back shells with eye-in-hand visual servoing

[J].

Multi-angle automotive fuse box detection and assembly method based on machine vision

[J].DOI:10.1016/j.measurement.2019.05.100 [本文引用: 1]

Engine head blocks handling robot guided by vision system

[J].DOI:10.3182/20120523-3-RO-2023.00244 [本文引用: 1]

Robotized flange assembling with line scan camera control

[J].DOI:10.1016/S1474-6670(17)37672-3 [本文引用: 1]

Using machine vision for flexible automatic assembly system

[J].DOI:10.1016/j.procs.2016.08.090 [本文引用: 1]

基于单目视觉的装配机器人研究及应用

[J].

Study and application of monocular vision-based assembly robot

[J].

Dual-camera-based method for identification and location of scattered self-plugging rivets for robot grasping

[J].DOI:10.1016/j.measurement.2018.11.017 [本文引用: 1]

An automatic machine vision-guided grasping system for Phalaenopsis tissue culture plantlets

[J].DOI:10.1016/j.compag.2009.08.011 [本文引用: 1]

Robotic grasping using visual and tactile sensing

[J].

基于改进遗传算法与机器视觉的工业机器人猪腹剖切轨迹规划

[J].

Trajectory planning for porcine abdomen cutting based on an improved genetic algorithm and machine vision for industrial robot

[J].

A study on seam tracking in robotic GMA welding process

[J].DOI:10.1016/j.matpr.2020.03.010 [本文引用: 1]

An approach for peg-in-hole assembling using intuitive search algorithm based on human behavior and carried by sensors guided industrial robot

[J].DOI:10.1016/j.ifacol.2015.06.295 [本文引用: 1]

Position identification in force-guided robotic peg-in-hole assembly tasks

[J].DOI:10.1016/j.procir.2014.10.077 [本文引用: 1]

Integration of multi-camera vision system for automatic robotic assembly

[J].DOI:10.1016/j.promfg.2019.12.063 [本文引用: 1]

一种基于机器人的航天器大型部件自主装配方法

[J].

A method of autonomous assembly of large spacecraft components using robot

[J].