近年来,深度学习以其优良的特征提取能力、较强的泛化性和鲁棒性,被引入隧道病害检测领域. 黄宏伟等[5]基于全卷积网络(FCN),实现了盾构隧道表征病害的高效检测. 宋娟等[6]通过引入Mobile ViT网络、TP Block和CA注意力机制,提出TDD-YOLO,实现隧道衬砌病害的高精度检测. 王健等[7]结合点云数据,在Mask RCNN中引入空洞卷积和可变形卷积,实现了隧道渗漏水病害的快速检测. 周中等[8]基于DeepLabV3+,引入EfficientNetv2和CBAM注意力机制,在轻量化模型的同时,实现渗漏水检测的高效检测. Tan等[9]将ShuffleNetv2作为编码器,应用跳跃连接结构,设计轻量化渗漏水检测网络(LSNet). Wang等[10]引入自定义侧面引导和并行注意力模块,设计CSG-Unet,实现复杂环境下的高效渗漏水区域分割. 诸多学者基于编码器-解码器结构的语义分割算法实现对隧道病害的精细化检测,但此类算法需要多次卷积和采样操作,参数量、计算量较大且检测速度慢. 地铁隧道环境复杂,渗漏水形态多样,在检测过程中存在精度低、抗干扰能力差的问题. 此外,由于地铁系统维护的窗口期短,隧道渗漏水数据集的获取较困难. 本文选用在小样本数据集上效果较好的U-net[11]为基础,从轻量化角度出发,在提高模型检测效率的同时,提高渗漏水区域检测的精度和抗干扰能力.

本文基于U-net设计HMARU-net,提出HC-MobileNetV3轻量化主干特征提取网络. 设计部分注意力卷积聚合网络,构建残差模块用于组成U-net解码器. 引入Attention Gate,应对跳跃连接层存在的语义鸿沟问题. 该模型具有高精度且能够满足实际工程检测的实时性需求,为地铁隧道衬砌渗漏水的实际检测提供技术支持.

1. HMARU-net网络

选取U-net作为基线网络,该网络的U型对称结构由编码器与解码器2部分构成,是基于全卷积神经网络(fully convolutional network, FCN)的像素级语义分割模型. 编码器通过多次卷积和下采样操作提取输入图像的多层级特征表示,解码器通过多次卷积与上采样的逆向操作,将特征图的空间分辨率逐步恢复至原始尺寸,并在最终层通过1×1卷积实现区域的像素级精确分割. 此外,编码器与解码器之间通过跳跃连接将编码阶段特征直接传递给解码部分,弥补了上采样过程可能导致的特征信息流失. U-net网络的对称性和跳跃连接设计使其在小样本语义分割任务中表现出良好的性能,因此被广泛应用于各种分割场景[12-13].

U-net常用VGG[14]、ResNet和EfficientNet等作为主干特征提取网络,尽管此类网络使得U-net在图像语义分割中具备较高的精确度,但其较深的卷积层导致模型的参数量和计算量较高,不利于资源受限环境下的图像快速处理. 在实际地铁隧道的检修场景中,由于夜间检修窗口期仅约为4 h,且硬件资源有限,轻量化的语义分割模型更具实际应用价值.

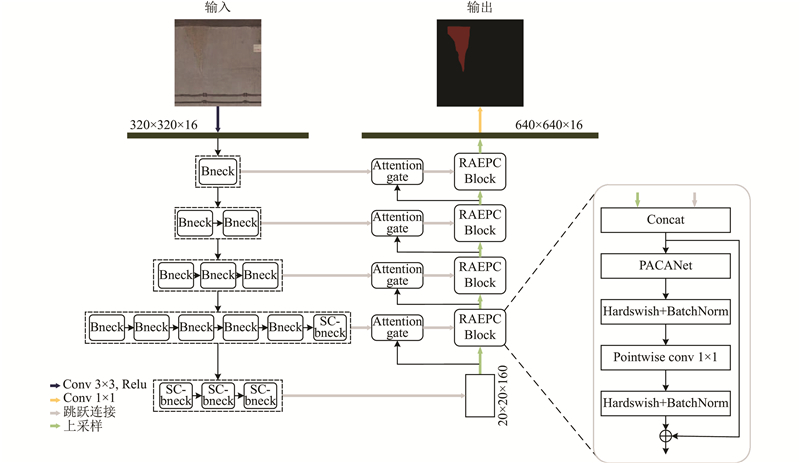

为了满足衬砌渗漏水病害检测的要求,对U-net进行轻量化改进,使其更适用于实际工程应用的场景. 改进后的轻量化模型HMARU-net结构如图1所示. 模型的左侧结构为HC-MobileNetV3组成的编码器;右侧是由RAEPC Block组成的解码器,且在跳跃连接层加入了注意力门机制.

图 1

1.1. HC-MobileNetV3轻量化主干特征提取网络

主干网络作为特征提取的重要组成部分,对目标特征的提取能力直接影响整个模型的分割效果. 为了保证模型精度并降低参数量和计算量,提出HC-MobileNetV3特征提取网络.

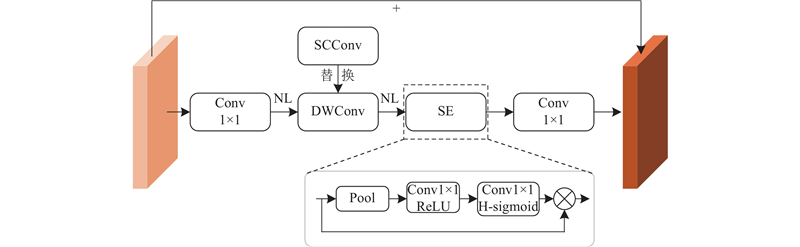

自校准结构通过围绕扩展感受野、多尺度信息融合以及增强通道间的依赖性进行设计,能够在不增加大量参数的前提下,提升卷积网络的特征提取能力. 改进后的SC-bneck结构如图2所示.

图 2

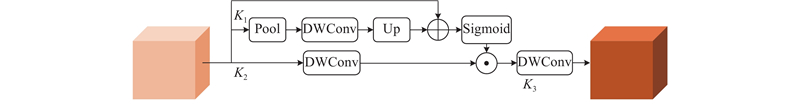

自校准结构如图3所示,原理如下.

图 3

1)

式中:

2)

式中:

3)

从图3可知,自校准结构共有K1、K2和K3 3个分支. 其中K1分支通过下采样、卷积和上采样操作及残差连接,获取注意力权重. 通过K1分支得到的注意力权重,对K2分支进行动态校准. 在K3分支进行通道调整,实现多尺度信息互补. 相比于深度卷积,自校准结构通过多分支和深度卷积的联合设计,平衡轻量化和特征表征能力,使得SC-bneck在具有较高的渗漏水多尺度特征提取能力的同时,仅增加少量的参数量和计算量.

主干网络中的浅层网络主要处理低级特征,深层次网络负责提取较高级的语义信息,需要更多的上下文信息和全局理解. 随着网络层数的加深,MobileNetV3-Large中第12~15层bneck负责提取高级语义信息,将MobileNetV3-Large第12~15层的bneck替换为SC-bneck,提出HC-MobileNetV3轻量化主干特征提取网络,在提高多尺度特征提取能力的同时保持网络的轻量化. 网络层数的配置如表1所示. 其中,e为扩张因子,c为输出的通道个数,s为步长,“—”表示没有使用SE注意力机制,“+”表示该层使用了SE注意力机制. 由于U-net网络拼接层要求2个张量尺寸匹配,根据网络结构选择第1、3、6、12、15层的输出作为U-net编码器部分的5个输出特征层,传递给后续的解码器进行特征拼接.

表 1 HC-MobileNetV3网络配置

Tab.1

| 序号 | 输入特征尺寸 | 操作类型 | e | c | SE | 激活函数 | s |

| 0 | 6402×3 | Conv2d | — | 16 | — | HS | 2 |

| 1 | 3202×16 | bneck, 3×3 | 16 | 16 | — | RE | 1 |

| 2 | 3202×16 | bneck, 3×3 | 64 | 24 | — | RE | 2 |

| 3 | 1602×24 | bneck, 3×3 | 72 | 24 | — | RE | 1 |

| 4 | 1602×24 | bneck, 5×5 | 72 | 40 | + | RE | 2 |

| 5 | 802×40 | bneck, 5×5 | 120 | 40 | + | RE | 1 |

| 6 | 802×40 | bneck, 5×5 | 120 | 40 | + | RE | 1 |

| 7 | 802×40 | bneck, 3×3 | 240 | 80 | — | HS | 2 |

| 8 | 402×80 | bneck, 3×3 | 200 | 80 | — | HS | 1 |

| 9 | 402×80 | bneck, 3×3 | 184 | 80 | — | HS | 1 |

| 10 | 402×80 | bneck, 3×3 | 184 | 80 | — | HS | 1 |

| 11 | 402×80 | bneck, 3×3 | 480 | 112 | + | HS | 1 |

| 12 | 402×112 | SC-bneck, 3×3 | 672 | 112 | + | HS | 1 |

| 13 | 402×112 | SC-bneck, 5×5 | 672 | 160 | + | HS | 2 |

| 14 | 202×160 | SC-bneck, 5×5 | 960 | 160 | + | HS | 1 |

| 15 | 202×160 | SC-bneck, 5×5 | 960 | 160 | + | HS | 1 |

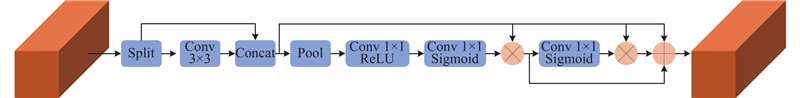

1.2. RAEPC Block

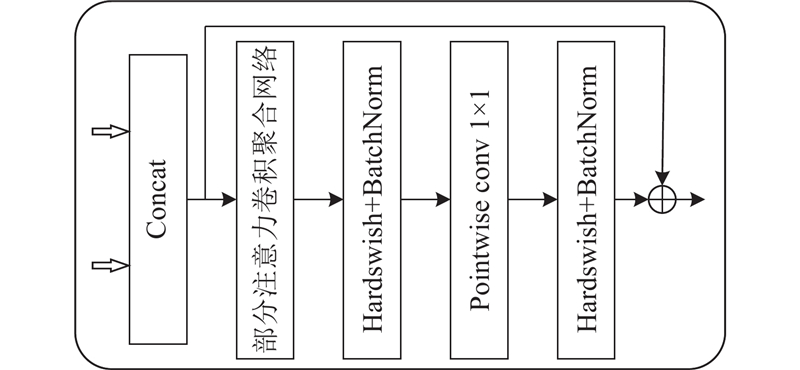

在U-net中,解码器由多个3×3标准卷积组成. 标准卷积的使用导致模型的参数量和计算量较大,同时由于标准卷积是对所有区域进行均匀处理,对特征细节和边界的关注度不够. 在渗漏水区域与背景特征相似的情况下,这种局限性使得模型对目标区域和背景噪声的区分能力不足,导致渗漏水区域边界模糊、漏检或错检等问题. 针对上述问题,设计残差注意力增强部分卷积块(residual attention-enhanced partial convolution block,RAEPC Block)用于构建解码器,进一步轻量化模型并提高分割精度和抗干扰能力,结构如图4所示.

图 4

输入的2种特征图通过Concat拼接后,采用部分注意力卷积聚合网络(partial attention convolution and aggregation network,PACANet),在复杂背景环境中聚焦渗漏水区域. 通过Hardswish激活函数和BatchNorm,加速模型训练,提高泛化能力和稳定性. 利用1×1逐点卷积进行跨通道整合特征,处理不同尺度的渗漏水特征. 通过引入残差连接,解决深层网络中信息丢失和退化的问题. RAEPC Block能够在降低模型的参数量和计算量的同时,提高模型的多尺度特征融合能力和复杂隧道场景下的抗干扰能力.

图 5

具体原理如下. 将输入特征图

式中:

PACANet利用通道注意力增强重要特征通道的动态感知能力,有效区分渗漏水特征通道和背景冗余通道. 引入像素注意力机制,提高网络对复杂空间细节特征的敏感性,精确定位渗漏水区域. 结合残差结构,融合全局、局部和原始信息,实现特征的多维度增强. 通过以上改进,PACANet具有较高的全局上下文信息建模能力和复杂细节特征提取能力,适用于渗漏水病害检测任务.

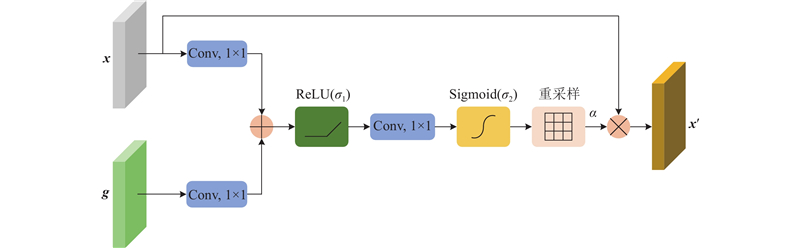

1.3. 注意力门机制

U-net在上采样过程中存在语义信息丢失的问题,且跳跃连接层将深层和浅层特征简单拼接,导致语义鸿沟问题. 为了解决该问题,在上采样和跳跃连接层中间引入Attention Gate[18],利用深层特征图对浅层特征图进行注意力加权激活,动态抑制隧道背景及无关信息,突出渗漏水区域的显著特征.

Attention Gate在提高特征选择性的同时,有效降低了编解码器之间的语义差异,增强了浅层空间细节与深层语义信息的融合效果,从而提高网络对渗漏水目标区域的识别与检测能力. 结构如图6所示,原理如下.

图 6

1) 将深层特征

2) 将压缩后的特征结果进行逐元素相加,通过

3) 将注意力权重矩阵

2. 数据集建立

2.1. 构建渗漏水数据集

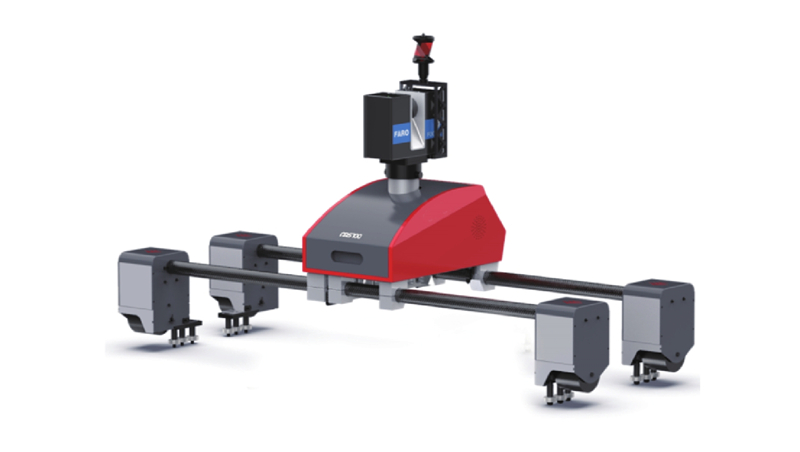

表 2 MS100采集设备的参数

Tab.2

| 类别 | 参数 |

| 工作方式 | 相位式 |

| 扫描距离 | 0.6~350 m |

| 扫描现场角 | 水平360°,垂直300° |

| 扫描速度 | 106点/s |

| 行走速度 | 50~ |

| 测距精度 | ±1 mm |

| 角精度 | ≥19角秒 |

| 相机 | 同轴影像内置1.65亿像素 |

图 7

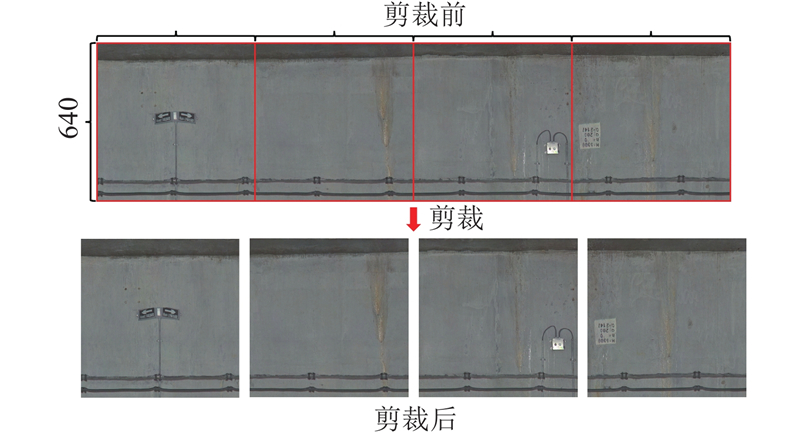

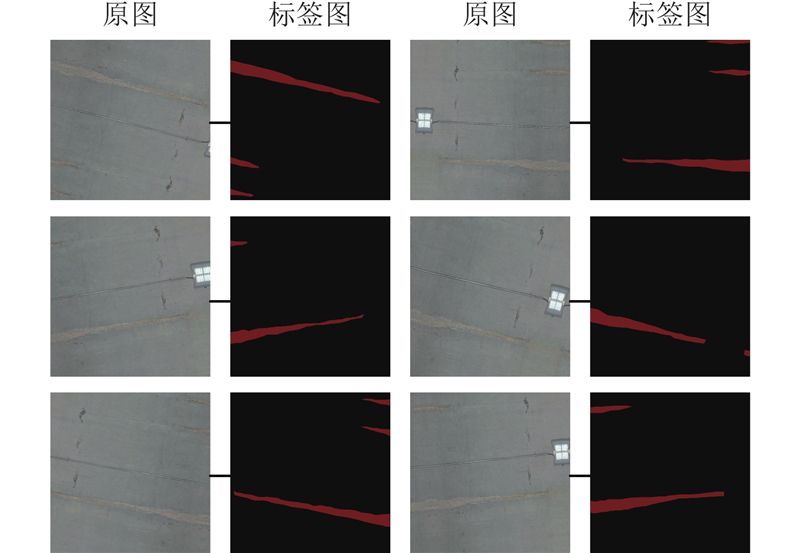

由于原始渗漏水数据的尺寸过大,无法直接输入算法进行学习,采用滑动图像剪裁算法对原始图像进行处理. 获取原始采集图像的分辨率为

图 8

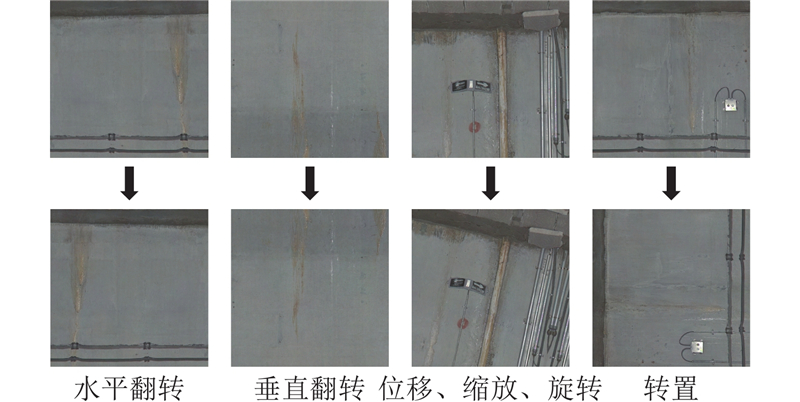

2.2. 数据增强

图 9

图 10

3. 实验准备

在CPU为12th Gen Core i5-12600KF,内存为32 GB,装有NVIDIA GeForce RTX4060Ti 8G GPU的Windows11 64bit系统上进行实验. 实验环境为pycharm2023.1.3集成开发环境(IDE),python版本为3.10.11,CUDA版本为12.1,深度学习框架为PyTorch2.3.1.

检测对象为衬砌渗漏水,是二分类语义分割任务,且渗漏水区域和背景占比的差异较大. 数据集中的渗漏水像素点数为20 059 464,背景像素点数为341 270 456,渗漏水占比仅为5.55%,存在严重的正负样本不均衡现象,传统的交叉熵损失函数会导致模型分割性能较差. 采用结合了相似系数损失函数LD焦点损失函数LF的统一损失函数LU.

式中:

使用语义分割中常用的评价指标,对分割结果进行定量分析,包括分割精度指标和模型效率指标. 精度和效率指标分别包括平均交并比(mean Intersection over Union,mIOU)、平均像素准确率(mean pixel accuracy,mPA)、分类准确率acc、模型参数量Np、每秒浮点运算次数FLOPs和图片处理速度v.

式中:

4. 实验结果与分析

4.1. 训练结果

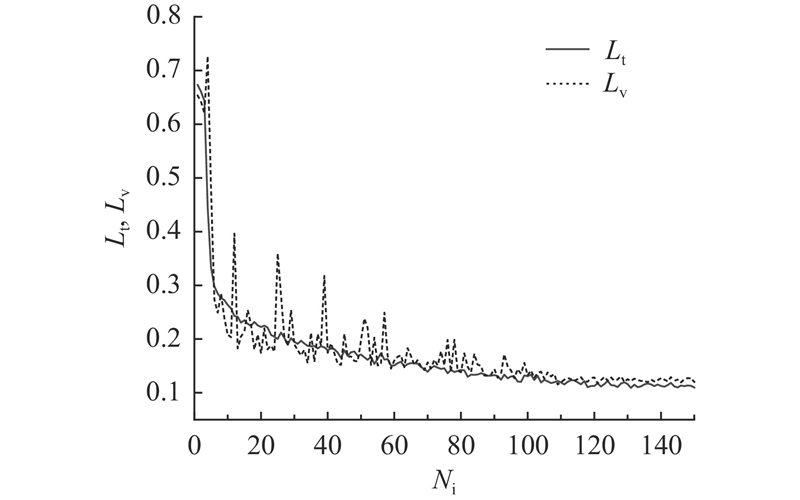

为了保证模型在训练过程中收敛迅速并充分发挥网络性能,根据模型的复杂性和数据集的特点设置模型的参数. 本实验中模型迭代次数为150,采用Adam自适应学习率优化器,将验证集损失值作为优化目标,批量处理大小为8,初始学习率为0.000 1,最小学习率为0.000 001,动量为0.9. 学习率下降策略采用余弦退火衰减法,以加速收敛并防止陷入局部最优,具体公式为

式中:

如图11所示为模型训练过程的训练和验证损失函数曲线. 其中,Lt、Lv分别为训练集损失和验证集损失,Ni为迭代次数. 可以看出,在120轮左右模型基本趋于平稳,表明模型此时已经收敛且没有过拟合现象.

图 11

由于训练集、验证集和测试集的划分在分割任务中直接影响模型的性能,对数据集的划分比例进行对比实验,如表3所示. 可知,当训练集、验证集和测试集的比例为8∶1∶1时,模型的分割精度最高.

表 3 数据集比例的对比

Tab.3

| 训练集、验证集、测试集的比例 | mIOU/% | mPA/% | acc/% |

| 8∶1∶1 | 86.00 | 93.07 | 98.33 |

| 7∶2∶1 | 85.25 | 91.79 | 97.99 |

| 6∶2∶2 | 85.13 | 91.46 | 98.15 |

4.2. 损失函数的对比实验

分别采用交叉熵损失函数和统一损失函数作为模型损失函数进行实验对比,结果如表4所示.

表 4 损失函数的对比

Tab.4

| 损失函数 | mIOU/% | mPA/% | acc/% |

| 统一损失函数 | 86.00 | 93.07 | 98.33 |

| 交叉熵损失函数 | 83.66 | 90.10 | 98.07 |

从结果可知,与交叉熵损失函数相比,提出的统一损失函数能够有效地适应渗漏水检测任务,mIOU、mPA和acc分别提升了2.34%、2.97%和0.26%. 统一损失函数结合

4.3. 主干网络的对比实验

表 5 主干网络的对比

Tab.5

| 主干网络 | mIOU/% | mPA/% | acc/% | Np/106 | FLOPs/109 | v/(帧·s-1) |

| VGG16 | 81.35 | 90.06 | 97.65 | 24.891 | 705.738 | 14.83 |

| MobilenetV2 | 81.79 | 90.62 | 97.70 | 3.449 | 12.272 | 104.01 |

| MobilenetV3 | 83.28 | 91.31 | 97.94 | 3.295 | 8.588 | 96.883 |

| MobilenetV4M | 82.00 | 91.26 | 97.71 | 11.078 | 36.220 | 81.23 |

| Ghostnet | 83.17 | 91.16 | 97.93 | 2.999 | 7.372 | 78.36 |

| HC-MobileNetV3 | 84.18 | 92.59 | 98.04 | 3.325 | 8.651 | 91.521 |

从结果分析可知,MobileNet和Ghostnet作为U-net网络的主干特征提取网络,均能有效地降低模型的参数量和计算量. 其中HC-MobileNetV3网络相较于其他主干网络具有显著的优势. 具体而言,MobileNetV4M能够提高模型的分割性能,但是参数量和计算量较其他轻量化网络最大. Ghostnet具有最小的计算量和参数量,但精度低于HC-MobileNetV3. MobileNetV3的效率指标略高于HC-MobileNetV3,但是精度指标明显低于HC-MobileNetV3. MobileNetV2作为主干模型,分割性能指标和效率指标均低于HC-MobileNetV3.

分析主干网络在渗漏水数据集上的数据表现可知,HC-MobileNetV3将模型参数量降为原模型的13.35%,计算量降至8.651×109,显著提高了模型的分割精度和图片处理速度,作为主干特征网络的效果最佳.

4.4. 消融实验

为了验证所提的HC-MobileNetV3、RAEPA Block和Attention Gate对本文所提模型性能的影响,以U-net作为基线模型进行消融实验,结果如表6所示.

表 6 消融实验

Tab.6

| 模型 | mIOU/% | mPA/% | acc/% | Np/106 | FLOPs/109 | v/(帧·s-1) |

| U-net | 81.35 | 90.06 | 97.65 | 24.891 | 705.738 | 14.830 |

| U-net+HC-MobileNetV3 | 84.18 | 92.59 | 98.04 | 3.325 | 8.651 | 91.521 |

| U-net+HC-MobileNetV3+RAEPC Block | 85.37 | 92.70 | 98.24 | 3.094 | 6.437 | 82.965 |

| U-net+HC-MobileNetV3+Attention Gate | 85.48 | 92.69 | 98.26 | 3.365 | 9.085 | 89.367 |

| U-net+HC-MobileNetV3+RAEPC Block +Attention Gate | 86.00 | 93.07 | 98.33 | 3.134 | 6.872 | 79.102 |

通过表6中模型的精度和效率指标并结合理论分析可得如下结论. 1) HC-MobileNetV3作为主干特征提取网络的引入,显著提高了模型的渗漏水分割精度,极大地优化了图片处理速度,mIOU、mPA和acc分别提升了2.83%、2.53%和0.39%,图片处理速度提升至91.521 帧/s. 此外,HC-MobileNetV3的轻量化设计大幅降低了模型的参数量和计算量. 2) 在轻量化主干网络的基础上引入RAEPC Block,提高了模型的分割精度,模型的参数量和计算量降至3.094×106和6.437×109. RAEPC Block内部的残差结构和注意力增强特性有效地提高了特征提取能力,但由于残差结构的引入,图片处理速度略微下降. 3) 通过在跳跃连接层引入Attention Gate,可以有效地提高模型的精度,仅略微增加模型参数量和计算量,对模型整体性能的提升效果显著.

4.5. 模型对比实验

表 7 不同模型的对比实验结果

Tab.7

| 模型 | mIOU/% | mPA/% | acc/% | Np/106 | FLOPs/109 | v/(帧·s-1) |

| Deeplabv3+ | 77.90 | 86.80 | 97.16 | 54.709 | 260.688 | 29.680 |

| PSPnet | 79.87 | 87.26 | 97.53 | 46.707 | 184.982 | 42.710 |

| U-net | 81.35 | 90.06 | 97.65 | 24.891 | 705.738 | 14.830 |

| Segformer | 77.39 | 87.32 | 97.01 | 3.715 | 21.152 | 61.730 |

| 文献23 | 77.60 | 91.47 | 96.75 | 5.813 | 82.604 | 69.253 |

| TR-Unet | 83.94 | 91.38 | 98.06 | 26.360 | 762.284 | 7.356 |

| 文献24 | 79.44 | 89.77 | 97.28 | 11.720 | 75.729 | 69.522 |

| HMARU-net | 86.00 | 93.07 | 98.33 | 3.134 | 6.872 | 78.967 |

从表7可知,HMARU-net在分割精度和效率方面均优于其他7种模型. 具体而言,HMARU-net的mIOU、mPA和acc分别达到86.0%、93.07%和98.33%. 此外,模型的参数量和计算量显著减少,分别降至3.134×106和6.872×109,图片处理速度达到78.967帧/s. 与原始U-net相比,分割精度有了大幅提升,mIOU、mPA和acc分别提高了4.65%、3.01%和0.68%,参数量和计算量分别降为原模型的12.59%和0.97%,表现出显著的轻量化特性,图片处理速度提升至U-net的5.32倍. 与文献[23]、[24]的轻量化模型相比,HMARU-net的参数量和计算量均最低,图片处理速度最高,有较高的轻量化优势. 与TR-Unet相比,所提的HMARU-net具有更高的mIOU、mPA和acc,抗干扰能力更强.

通过应用多网络融合、残差结构和注意力机制,有效提高了模型的特征表达能力,在渗漏水检测任务中实现高精度分割的同时,极大降低了参数量和计算量,显著提高了图片处理速度,能够满足实际工程应用的高效、高精度检测需求.

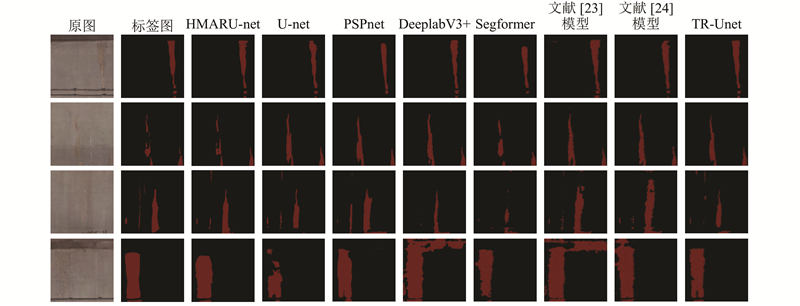

4.6. 渗漏水区域分割结果

为了更直观地对比模型的渗漏水分割效果,选取几张具有代表性的渗漏水图像进行可视化展示,结果如图12所示. 其中,第1列为渗漏水原始图像,第2列为对应的掩码图,作为模型预测结果的对比. 第1~4行的图像分别为背景存在管线干扰的图像、简单背景的不规则渗漏水图像、存在多种形态的渗漏水图像和光线干扰不易分辨的渗漏水图像.

图 12

图 12 不同模型的分割效果可视化

Fig.12 Visualization of segmentation effects of different models

4.7. 实时性分析

模型的图片处理速度须不低于采集设备的速度,才能满足地铁隧道渗漏水检测的实时性要求. 设备行驶速度与模型图片处理速度之间的关系如下:

式中:

本文模型的图片处理速度为78.967帧/s,根据北京市建设工程质量第三检测所有限责任公司提供的工程质量检测报告,对比病害区域像素和实际面积,计算可得

5. 结 论

(1)提出适用于地铁隧道衬砌渗漏水检测的轻量化HMARU-net模型. 通过在构建的渗漏水数据集上训练,该模型的mIOU、mPA和acc分别达到86.0%、93.07%和98.33%. 此外,模型参数量仅为3.134×106,计算浮点数为6.872×109,图片处理速度达到78.967 帧/s. 在实现轻量化的同时保证了渗漏水分割的高精度,与主流的语义分割算法相比,能够满足实际地铁隧道衬砌渗漏水病害检测任务的高效、高精度要求.

(2) 针对渗漏水检测任务的特点,提出HC-MobileNetV3主干特征提取网络,大幅降低了模型的参数量、计算量,提高了多尺度特征提取能力. 设计PACANet,融合双注意力机制和残差连接,增强特征区分和全局信息建模能力,构建RAEPC Block组成解码器,在降低模型复杂度的同时,提高了多尺度特征融合及抗干扰能力. 引入Attention Gate注意力机制,解决跳跃连接层带来的语义鸿沟问题.

(3) 当前的渗漏水等级判定以定性分析为主,后续研究应考虑渗漏水区域面积的量化分析,并开展维修优先级的评定研究,为地铁隧道智能化运维提供科学、有效的决策依据.

参考文献

2024年中国内地城市轨道交通运营线路概况

[J].

Overview of urban rail transit operations in Chinese China’s mainland in 2024

[J].

铁路隧道衬砌表观病害等级评定研究

[J].DOI:10.3969/j.issn.1003-1995.2023.04.17

Research on evaluation of surface disease grade for railway tunnel lining

[J].DOI:10.3969/j.issn.1003-1995.2023.04.17

基于深度学习的盾构隧道渗漏水病害图像识别

[J].DOI:10.13722/j.cnki.jrme.2017.0552 [本文引用: 1]

Image recognition for water leakage in shield tunnel based on deep learning

[J].DOI:10.13722/j.cnki.jrme.2017.0552 [本文引用: 1]

基于深度学习的隧道衬砌多病害检测算法

[J].DOI:10.3785/j.issn.1008-973X.2024.06.007 [本文引用: 1]

Deep learning-based algorithm for multi defect detection in tunnel lining

[J].DOI:10.3785/j.issn.1008-973X.2024.06.007 [本文引用: 1]

改进Mask RCNN的盾构隧道渗漏水检测方法

[J].DOI:10.13474/j.cnki.11-2246.2024.0232 [本文引用: 1]

Improved Mask RCNN method for shield tunnel leakage detection

[J].DOI:10.13474/j.cnki.11-2246.2024.0232 [本文引用: 1]

基于深度语义分割的隧道渗漏水智能识别

[J].DOI:10.13722/j.cnki.jrme.2022.0016 [本文引用: 2]

Automatic identification of tunnel leakage based on deep semantic segmentation

[J].DOI:10.13722/j.cnki.jrme.2022.0016 [本文引用: 2]

A lightweight metro tunnel water leakage identification algorithm via machine vision

[J].DOI:10.1016/j.engfailanal.2023.107327 [本文引用: 2]

Image segmentation of tunnel water leakage defects in complex environments using an improved Unet model

[J].DOI:10.1038/s41598-024-75723-4 [本文引用: 1]

基于多重多尺度融合注意力网络的建筑物提取

[J].DOI:10.3785/j.issn.1008-973X.2022.10.004 [本文引用: 1]

Building extraction based on multiple multiscale-feature fusion attention network

[J].DOI:10.3785/j.issn.1008-973X.2022.10.004 [本文引用: 1]

遥感图像语义分割空间全局上下文信息网络

[J].DOI:10.3785/j.issn.1008-973X.2022.04.019 [本文引用: 1]

Spatial global context information network for semantic segmentation of remote sensing image

[J].DOI:10.3785/j.issn.1008-973X.2022.04.019 [本文引用: 1]

基于DeepLabV3+网络改进的快速隧道病害分割方法

[J].DOI:10.3969/j.issn.1002-0268.2023.08.018 [本文引用: 4]

Improved fast tunnel disease segmentation method based on DeepLabV3+ network

[J].DOI:10.3969/j.issn.1002-0268.2023.08.018 [本文引用: 4]

Segmentation of tunnel water leakage based on a lightweight DeepLabV3+ model

[J].DOI:10.1088/1361-6501/ad894f [本文引用: 4]

基于TR-Unet的隧道渗漏水智能识别方法

[J].DOI:10.16058/j.issn.1005-0930.2025.02.018 [本文引用: 1]

Intelligent identification of tunnel water leakage based on TR-Unet

[J].DOI:10.16058/j.issn.1005-0930.2025.02.018 [本文引用: 1]