(6) $ \begin{split} {L_{{\text{GAN}}}} =& L_{{\text{GAN}}}^{\text{G}}(G,D_Y^{\text{G}},x,y)+L_{{\text{GAN}}}^{\text{G}}(F,D_X^{\text{G}},x,y)+ \\ & L_{{\text{GAN}}}^{\text{L}}(F,D_Y^{\text{L}},x,y) + L_{{\text{GAN}}}^{\text{L}}(F,D_X^{\text{L}},x,y). \end{split}$

[1]

LI X, MENG Q, WEI M, et al Identification of underwater structural bridge damage and BIM-based bridge damage management

[J]. Applied Sciences , 2023 , 13 (3 ): 1348

DOI:10.3390/app13031348

[本文引用: 1]

[2]

ORINAITĖ U, KARALIŪTĖ V, PAL M, et al Detecting underwater concrete cracks with machine learning: a clear vision of a murky problem

[J]. Applied Sciences , 2023 , 13 (12 ): 7335

DOI:10.3390/app13127335

[本文引用: 1]

[3]

KOV’ARI K, PETER G Continuous strain monitoring in the rock foundation of a large gravity dam

[J]. Rock Mechanics and Rock Engineering , 1983 , 16 (3 ): 157 - 171

DOI:10.1007/BF01033277

[本文引用: 1]

[4]

FAN X, CAO P, SHI P, et al An underwater dam crack image segmentation method based on multi-level adversarial transfer learning

[J]. Neurocomputing , 2022 , 505 : 19 - 29

DOI:10.1016/j.neucom.2022.07.036

[本文引用: 1]

[5]

HUANG B, KANG F, LI X, et al Underwater dam crack image generation based on unsupervised image-to-image translation

[J]. Automation in Construction , 2024 , 163 : 105430

DOI:10.1016/j.autcon.2024.105430

[本文引用: 1]

[6]

YE X, LUO K, WANG H, et al An advanced AI-based lightweight two-stage underwater structural damage detection model

[J]. Advanced Engineering Informatics , 2024 , 62 : 102553

DOI:10.1016/j.aei.2024.102553

[本文引用: 1]

[7]

程风雯, 甘进, 李星, 等 基于DCGAN的水下结构物表面缺陷图像生成

[J]. 长江科学院院报 , 2023 , 40 (9 ): 155 - 161

DOI:10.11988/ckyyb.20220421

[本文引用: 1]

CHENG Fengwen, GAN Jin, LI Xing, et al Image generation for surface defects of underwater structures based on deep convolutional generative adversarial networks

[J]. Journal of Changjiang River Scientific Research Institute , 2023 , 40 (9 ): 155 - 161

DOI:10.11988/ckyyb.20220421

[本文引用: 1]

[8]

王桂平, 陈旺桥, 杨建喜, 等 基于迁移学习的桥梁表观病害检测技术研究

[J]. 铁道科学与工程学报 , 2022 , 19 (6 ): 1638 - 1646

[本文引用: 1]

WANG Guiping, CHEN Wangqiao, YANG Jianxi, et al A bridge surface distress detection technology based on transfer learning

[J]. Journal of Railway Science and Engineering , 2022 , 19 (6 ): 1638 - 1646

[本文引用: 1]

[9]

ZHAO S, SHADABFAR M, ZHANG D, et al Deep learning-based classification and instance segmentation of leakage-area and scaling images of shield tunnel linings

[J]. Structural Control and Health Monitoring , 2021 , 28 (6 ): e2732

[本文引用: 1]

[10]

马金祥, 范新南, 吴志祥, 等 暗通道先验的大坝水下裂缝图像增强算法

[J]. 中国图象图形学报 , 2016 , 21 (12 ): 1574 - 1584

DOI:10.11834/jig.20161202

[本文引用: 1]

MA Jinxiang, FAN Xinnan, WU Zhixiang, et al Underwater dam crack image enhancement algorithm based on improved dark channel prior

[J]. Journal of Image and Graphics , 2016 , 21 (12 ): 1574 - 1584

DOI:10.11834/jig.20161202

[本文引用: 1]

[11]

XIN G, FAN X, SHI P, et al A fine extraction algorithm for image-based surface cracks in underwater dams

[J]. Measurement Science and Technology , 2023 , 34 (3 ): 035402

DOI:10.1088/1361-6501/ac9db2

[本文引用: 1]

[12]

QI Z, LIU D, ZHANG J, et al Micro-concrete crack detection of underwater structures based on convolutional neural network

[J]. Machine Vision and Applications , 2022 , 33 (5 ): 74

DOI:10.1007/s00138-022-01327-5

[本文引用: 1]

[13]

雍子叶, 郭继昌, 李重仪 融入注意力机制的弱监督水下图像增强算法

[J]. 浙江大学学报: 工学版 , 2021 , 55 (3 ): 555 - 562,570

[本文引用: 1]

YONG Ziye, GUO Jichang, LI Chongyi Weakly supervised underwater image enhancement algorithm incorporating attention mechanism

[J]. Journal of Zhejiang University: Engineering Science , 2021 , 55 (3 ): 555 - 562,570

[本文引用: 1]

[14]

范新南, 顾丽萍, 巫鹏, 等 一种仿水下生物视觉的大坝裂缝图像增强算法

[J]. 光电子 激光 , 2014 , 25 (2 ): 372 - 377

[本文引用: 2]

FAN Xinnan, GU Liping, WU Peng, et al A dam crack image enhancement algorithm based on underwater biological vision

[J]. Journal of Optoelectronics Laser , 2014 , 25 (2 ): 372 - 377

[本文引用: 2]

[15]

温佩芝, 陈君谋, 肖雁南, 等 基于生成式对抗网络和多级小波包卷积网络的水下图像增强算法

[J]. 浙江大学学报: 工学版 , 2022 , 56 (2 ): 213 - 224

[本文引用: 1]

WEN Peizhi, CHEN Junmou, XIAO Yannan, et al Underwater image enhancement algorithm based on GAN and multi-level wavelet CNN

[J]. Journal of Zhejiang University: Engineering Science , 2022 , 56 (2 ): 213 - 224

[本文引用: 1]

[16]

ZHU J Y, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks [C]//Proceedings of the IEEE International Conference on Computer Vision . Venice: IEEE, 2017: 2242–2251.

[本文引用: 1]

[17]

ROY A G, NAVAB N, WACHINGER C. Concurrent spatial and channel ‘squeeze&excitation’ in fully convolutional networks [C]// Medical Image Computing and Computer Assisted Intervention – MICCAI 2018 . Cham: Springer, 2018: 421–429.

[本文引用: 1]

[18]

SONG Y, HE Z, QIAN H, et al Vision transformers for single image dehazing

[J]. IEEE Transactions on Image Processing , 2023 , 32 : 1927 - 1941

DOI:10.1109/TIP.2023.3256763

[本文引用: 1]

[19]

LIU Z, LIN Y T, CAO Y, et al. Swin transformer: hierarchical vision transformer using shifted windows [C]// Proceedings of the IEEE/CVF International Conference on Computer Vision . Montreal: IEEE, 2021: 10012-10022.

[本文引用: 1]

[20]

BA J L, KIROS J R, HINTON G E. Layer normalization [EB/OL]. [2024-06-01]. https://arxiv.org/abs/1607.06450.

[本文引用: 1]

[21]

HENDRYCKS D, GIMPEL K. Gaussian error linear units (gelus)[EB/OL]. [2024-06-01]. https://arxiv.org/abs/1606.08415v5.

[本文引用: 1]

[22]

WANG P, CHEN P, YUAN Y, et al. Understanding convolution for semantic segmentation [C]// IEEE Winter Conference on Applications of Computer Vision . Lake Tahoe: IEEE, 2018: 1451–1460.

[本文引用: 1]

[23]

ENGIN D, GENÇ A, KEMAL EKENEL H. Cycle-dehaze: Enhanced cyclegan for single image dehazing [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops . Salt Lake City: IEEE, 2018: 825-833.

[本文引用: 1]

[24]

WANG Y, YAN X, GUAN D, et al Cycle-SNSPGAN: towards real-world image dehazing via cycle spectral normalized soft likelihood estimation patch GAN

[J]. IEEE Transactions on Intelligent Transportation Systems , 2022 , 23 (11 ): 20368 - 20382

DOI:10.1109/TITS.2022.3170328

[本文引用: 1]

[25]

WANG Y, YAN X, WANG F L, et al UCL-dehaze: toward real-world image dehazing via unsupervised contrastive learning

[J]. IEEE Transactions on Image Processing , 2024 , 33 : 1361 - 1374

DOI:10.1109/TIP.2024.3362153

[本文引用: 1]

[26]

YANG M, SOWMYA A An underwater color image quality evaluation metric

[J]. IEEE Transactions on Image Processing , 2015 , 24 (12 ): 6062 - 6071

DOI:10.1109/TIP.2015.2491020

[本文引用: 1]

[27]

PANETTA K, GAO C, AGAIAN S Human-visual-system-inspired underwater image quality measures

[J]. IEEE Journal of Oceanic Engineering , 2016 , 41 (3 ): 541 - 551

DOI:10.1109/JOE.2015.2469915

[本文引用: 1]

[28]

YANG X, LI H, YU Y, et al Automatic pixel-level crack detection and measurement using fully convolutional network

[J]. Computer-Aided Civil and Infrastructure Engineering , 2018 , 33 (12 ): 1090 - 1109

DOI:10.1111/mice.12412

[本文引用: 1]

[29]

WANG W, YANG Y A color image fusion model by saturation-value total variation

[J]. Journal of Computational and Applied Mathematics , 2024 , 446 : 115832

DOI:10.1016/j.cam.2024.115832

[本文引用: 1]

[30]

ZHAO Y, LV W, XU S, et al. Detrs beat yolos on real-time object detection [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition . Seattle: IEEE, 2024: 16965-16974.

[本文引用: 1]

[31]

CHATTOPADHAY A, SARKAR A, HOWLADER P, et al. Grad-CAM: generalized gradient-based visual explanations for deep convolutional networks [C]// Proceedings of the IEEE Winter Conference on Applications of Computer Vision . Lake Tahoe: IEEE, 2018: 839–847.

[本文引用: 1]

Identification of underwater structural bridge damage and BIM-based bridge damage management

1

2023

... 水下桥墩裂缝的检测对于桥梁结构的安全评估至关重要[1 -2 ] . 然而,裂缝数据稀缺且水下环境复杂. 桥墩以及水上大型建筑表面缺陷的传统检测方法之一是聘用蛙人[3 ] ,由专业人员穿戴蛙人作业服通过肉眼进行观测并采集数据. 这种方式效率低下,耗费时间长,存在较大的安全隐患,同时也依赖于蛙人的主观经验. ...

Detecting underwater concrete cracks with machine learning: a clear vision of a murky problem

1

2023

... 水下桥墩裂缝的检测对于桥梁结构的安全评估至关重要[1 -2 ] . 然而,裂缝数据稀缺且水下环境复杂. 桥墩以及水上大型建筑表面缺陷的传统检测方法之一是聘用蛙人[3 ] ,由专业人员穿戴蛙人作业服通过肉眼进行观测并采集数据. 这种方式效率低下,耗费时间长,存在较大的安全隐患,同时也依赖于蛙人的主观经验. ...

Continuous strain monitoring in the rock foundation of a large gravity dam

1

1983

... 水下桥墩裂缝的检测对于桥梁结构的安全评估至关重要[1 -2 ] . 然而,裂缝数据稀缺且水下环境复杂. 桥墩以及水上大型建筑表面缺陷的传统检测方法之一是聘用蛙人[3 ] ,由专业人员穿戴蛙人作业服通过肉眼进行观测并采集数据. 这种方式效率低下,耗费时间长,存在较大的安全隐患,同时也依赖于蛙人的主观经验. ...

An underwater dam crack image segmentation method based on multi-level adversarial transfer learning

1

2022

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

Underwater dam crack image generation based on unsupervised image-to-image translation

1

2024

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

An advanced AI-based lightweight two-stage underwater structural damage detection model

1

2024

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

基于DCGAN的水下结构物表面缺陷图像生成

1

2023

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

基于DCGAN的水下结构物表面缺陷图像生成

1

2023

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

基于迁移学习的桥梁表观病害检测技术研究

1

2022

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

基于迁移学习的桥梁表观病害检测技术研究

1

2022

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

Deep learning-based classification and instance segmentation of leakage-area and scaling images of shield tunnel linings

1

2021

... 一些学者通过深度学习方法处理数据集来扩充数据,Fan等[4 ] 提出迁移学习方法MA-AttUNet,利用多级对抗传递网络实现裂纹图像特征的知识转移,可以将从源域中学到的先验知识应用于目标域实现水下裂纹图像分割,但没有从根本上解决裂缝数据稀缺的问题. Huang等[5 ] 通过CycleGAN方法将大坝裂缝图像转换成水下大坝裂缝图像,缓解了水下大坝数据稀缺的问题,但图像有雾呈现蓝绿色. Ye等[6 ] 为了解决水下结构检测不准、模型性能较差的问题,提出使用CycleGAN和Retinex方法将陆地结构缺陷转换为高质量的水下结构缺陷图像,但这种方法过于繁琐. 程风雯等[7 ] 提出基于深度卷积生成对抗网络(deep convolutional generative adversarial networks,DCGAN)的水下结构物表面缺陷图像生成方法,改进损失函数,建立水下结构物表面缺陷图像的生成,但结果与实际的水下环境裂缝差异较大. 王桂平等[8 ] 使用迁移学习方法解决桥梁表观病害数据缺失的问题,提高了病害识别率,但未从根本上解决数据缺失的问题. 针对盾构隧道衬砌的渗漏区缺陷的分类,Zhao等[9 ] 通过添加缩放图像来放大泄漏区域图像数据集,并在分类数据集中实现数据增强以丰富数据库,增强后的分类数据集包含5776 张图像,但是缩放图像会导致图像内容的模糊或失真. 扩充数据集的方法大多都是在原始数据的基础上进行的,容易出现过拟合的情况,且容易出现处理的数据较差的情况. 基于深度学习方法扩充数据可以缓解上述情况,为此提出使用CycleGAN网络转换水下桥墩裂缝以扩充数据. ...

暗通道先验的大坝水下裂缝图像增强算法

1

2016

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

暗通道先验的大坝水下裂缝图像增强算法

1

2016

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

A fine extraction algorithm for image-based surface cracks in underwater dams

1

2023

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

Micro-concrete crack detection of underwater structures based on convolutional neural network

1

2022

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

融入注意力机制的弱监督水下图像增强算法

1

2021

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

融入注意力机制的弱监督水下图像增强算法

1

2021

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

一种仿水下生物视觉的大坝裂缝图像增强算法

2

2014

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

... 由于水下裂缝图像存在雾化且易受光线干扰,利用身份映射损失[14 ] 保留输入和输出纹理的一致性. 身份映射损失可以表示为 ...

一种仿水下生物视觉的大坝裂缝图像增强算法

2

2014

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

... 由于水下裂缝图像存在雾化且易受光线干扰,利用身份映射损失[14 ] 保留输入和输出纹理的一致性. 身份映射损失可以表示为 ...

基于生成式对抗网络和多级小波包卷积网络的水下图像增强算法

1

2022

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

基于生成式对抗网络和多级小波包卷积网络的水下图像增强算法

1

2022

... 足够数量数据集是检测水下桥墩裂缝模型训练的一个重要条件,但数据的质量也不能忽视,其容易影响检测模型训练的效果. 水下桥墩裂缝的图像通常受到水质、光照条件、散射、噪声等多种因素的影响,使得裂缝的准确检测和分析变得异常困难. 马金祥等[10 ] 提出基于改进的暗通道先验的水下大坝裂缝图像自适应增强算法,有效消除了水下图像的噪声,增强了图像的清晰度,但是对光照不均匀的水下裂缝的恢复较差. Xin等[11 ] 利用自适应直方图均衡将水下图像的不均匀光照区域变为均匀光照区域,实现了库坝裂缝的图像增强,但去雾性能较弱. Qi等[12 ] 通过全局光照平衡、图像色彩校正、细节增强等一系列算法对水下光学图像进行预处理,针对长距离输水工程的混凝土结构的微裂缝实现增强,但预处理耗时较长且繁琐. 雍子叶等[13 ] 提出融入注意力机制的弱监督水下图像增强算法,但是算法的鲁棒性有待加强. 范新南等[14 ] 提出仿生水下生物视觉的大坝裂缝图像增强算法,借鉴生物视觉亮度调节性改善裂缝图像的亮度非均匀问题,但仿生方法需要复杂的设计来模拟生物过程. 温佩芝等[15 ] 提出融合生成对抗网络(GAN)和优化卷积神经网络(CNN)的水下图像增强技术,有效解决了水下图像的雾化模糊和色彩偏差问题,但该方法在图像增强过程中仍存在局部失真和色彩偏差的问题. ...

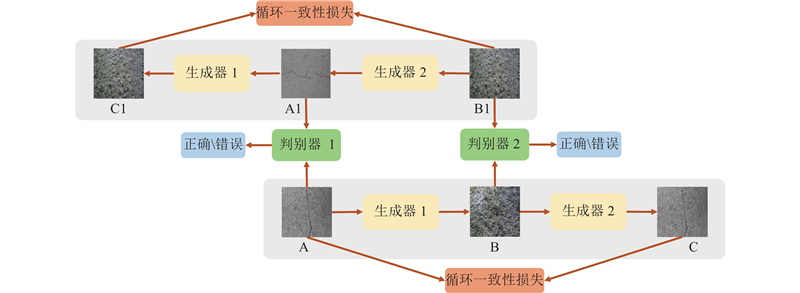

1

... 本研究添加scSE注意力和Dehazeformer模块改进CycleGAN[16 ] 的生成器生成水下风格的桥墩裂缝数据集,采用全局局部判别模块和像素注意力改进判别器判别生成的裂缝数据. 利用水下机器人采集的水下桥墩壁面图像和公开的陆地裂缝数据集,训练并测试改进的模型,生成水下裂缝图像,扩充数据. 结合水下机器人采集的真实水下桥墩裂缝数据进行水下图像质量评估实验、水下图像色彩评估实验、峰值信噪比指标评估实验验证生成的数据质量. ...

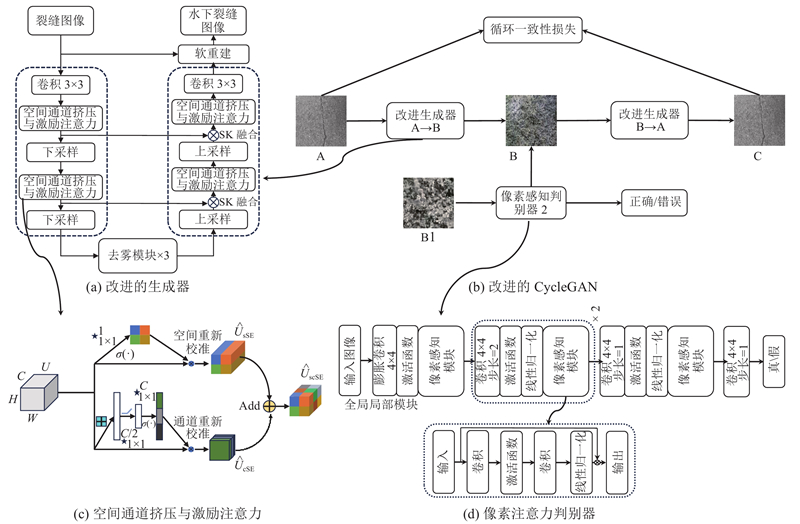

1

... 水下环境容易受到光线折射以及水中杂质的干扰,故生成器选择UNet作为主体框架,可以更好地保留图像的细节信息,如图2 (a)所示. 为了缓解水下环境对生成的水下桥墩裂缝的效果,对生成器进行改进,主要分为2个部分. 一部分是空间通道挤压与激励(scSE)注意力[17 ] 机制(见图2 (c)),scSE注意力在空间和通道维度上同时调节特征图的重要性,使得生成器能够更加专注于水下桥墩壁面图像中关键的裂缝区域,可以显著提升水下桥墩裂缝图像的生成效果. 通过通道Channel Squeeze-and-Excitation(cSE)和空间Spatial Squeeze-and-Excitation(sSE)模块,scSE机制增强了对重要陆地裂缝细节和空间结构的关注,使生成器能够更精准地捕捉裂缝的形态和细节,同时减少背景噪声和干扰. 这种结构优化提高了图像的清晰度和真实感,确保生成的水下桥墩裂缝图像更具视觉准确性和细节表现. 另一部分添加DehazeFormer模块[18 ] 至生成器的瓶颈. 它改进了Swin Transformer模块[19 ] ,引入SK融合层和软重建层以替代拼接融合层和全局残差学习,提升了模型对裂缝区域的重建效果,尤其在处理重建图像中的散斑时表现更为出色. SK融合层的采用使得模型能够更灵活地整合多尺度信息,更好地捕捉水下桥墩裂缝图像中的结构和特征. 软重建层的引入进一步增强了模型对复杂场景的适应性,使得重建结果更为真实和清晰. ...

Vision transformers for single image dehazing

1

2023

... 水下环境容易受到光线折射以及水中杂质的干扰,故生成器选择UNet作为主体框架,可以更好地保留图像的细节信息,如图2 (a)所示. 为了缓解水下环境对生成的水下桥墩裂缝的效果,对生成器进行改进,主要分为2个部分. 一部分是空间通道挤压与激励(scSE)注意力[17 ] 机制(见图2 (c)),scSE注意力在空间和通道维度上同时调节特征图的重要性,使得生成器能够更加专注于水下桥墩壁面图像中关键的裂缝区域,可以显著提升水下桥墩裂缝图像的生成效果. 通过通道Channel Squeeze-and-Excitation(cSE)和空间Spatial Squeeze-and-Excitation(sSE)模块,scSE机制增强了对重要陆地裂缝细节和空间结构的关注,使生成器能够更精准地捕捉裂缝的形态和细节,同时减少背景噪声和干扰. 这种结构优化提高了图像的清晰度和真实感,确保生成的水下桥墩裂缝图像更具视觉准确性和细节表现. 另一部分添加DehazeFormer模块[18 ] 至生成器的瓶颈. 它改进了Swin Transformer模块[19 ] ,引入SK融合层和软重建层以替代拼接融合层和全局残差学习,提升了模型对裂缝区域的重建效果,尤其在处理重建图像中的散斑时表现更为出色. SK融合层的采用使得模型能够更灵活地整合多尺度信息,更好地捕捉水下桥墩裂缝图像中的结构和特征. 软重建层的引入进一步增强了模型对复杂场景的适应性,使得重建结果更为真实和清晰. ...

1

... 水下环境容易受到光线折射以及水中杂质的干扰,故生成器选择UNet作为主体框架,可以更好地保留图像的细节信息,如图2 (a)所示. 为了缓解水下环境对生成的水下桥墩裂缝的效果,对生成器进行改进,主要分为2个部分. 一部分是空间通道挤压与激励(scSE)注意力[17 ] 机制(见图2 (c)),scSE注意力在空间和通道维度上同时调节特征图的重要性,使得生成器能够更加专注于水下桥墩壁面图像中关键的裂缝区域,可以显著提升水下桥墩裂缝图像的生成效果. 通过通道Channel Squeeze-and-Excitation(cSE)和空间Spatial Squeeze-and-Excitation(sSE)模块,scSE机制增强了对重要陆地裂缝细节和空间结构的关注,使生成器能够更精准地捕捉裂缝的形态和细节,同时减少背景噪声和干扰. 这种结构优化提高了图像的清晰度和真实感,确保生成的水下桥墩裂缝图像更具视觉准确性和细节表现. 另一部分添加DehazeFormer模块[18 ] 至生成器的瓶颈. 它改进了Swin Transformer模块[19 ] ,引入SK融合层和软重建层以替代拼接融合层和全局残差学习,提升了模型对裂缝区域的重建效果,尤其在处理重建图像中的散斑时表现更为出色. SK融合层的采用使得模型能够更灵活地整合多尺度信息,更好地捕捉水下桥墩裂缝图像中的结构和特征. 软重建层的引入进一步增强了模型对复杂场景的适应性,使得重建结果更为真实和清晰. ...

1

... 考虑到散斑在图像中的特殊性,将LayerNorm[20 ] 替换为RescaleNorm以确保特征图的规范化. 采用RescaleNorm有助于增强裂缝区域的细节和纹理,使模型更好地适应水下环境的变化,稳定性得以提高. 此外,选择RELU作为激活函数替换GELU[21 ] ,能够显著提升水下桥墩裂缝图像的生成效果. DehazeFormer的自注意力机制可以捕捉全局特征,改善图像的对比度和颜色,还原真实感. 同时,该模块的去噪能力和全局建模功能可以减少伪影和噪声,提高图像质量和生成稳定性. ...

1

... 考虑到散斑在图像中的特殊性,将LayerNorm[20 ] 替换为RescaleNorm以确保特征图的规范化. 采用RescaleNorm有助于增强裂缝区域的细节和纹理,使模型更好地适应水下环境的变化,稳定性得以提高. 此外,选择RELU作为激活函数替换GELU[21 ] ,能够显著提升水下桥墩裂缝图像的生成效果. DehazeFormer的自注意力机制可以捕捉全局特征,改善图像的对比度和颜色,还原真实感. 同时,该模块的去噪能力和全局建模功能可以减少伪影和噪声,提高图像质量和生成稳定性. ...

1

... 判别器对于CycleGAN来说至关重要,水下环境过于复杂致使生成的桥墩裂缝受到干扰,质量降低,为此,本研究提出像素感知鉴别器来判别生成的裂缝质量,如图2 (d)所示. 像素感知判别器能够更加精确地评估生成图像的真实性,通过关注像素级别的细微差异,有助于减少误判和提高去雾效果的准确性. 首先,该判别器结合了全局和局部信息,在评估图像时不仅考虑了整体结构,还关注了细节特征,从而使得生成图像更加真实且保留了原始裂缝的形状和纹理. 其次,采用膨胀卷积[22 ] 替换原来的卷积,可以提高判别器对输入图像的整体特征的感知能力,从而更好地判断图像的真实性,同时,将膨胀卷积放在判别器的入口处有助于增强对这些重要特征的捕捉能力. 最后,像素注意力的引入提高了生成图像和判别图像的像素区分度,使其在复杂水下环境中仍能有效地去除雾化效果,从而提高整体的水下裂缝图像去雾性能. 像素感知判别器的综合结果如下: ...

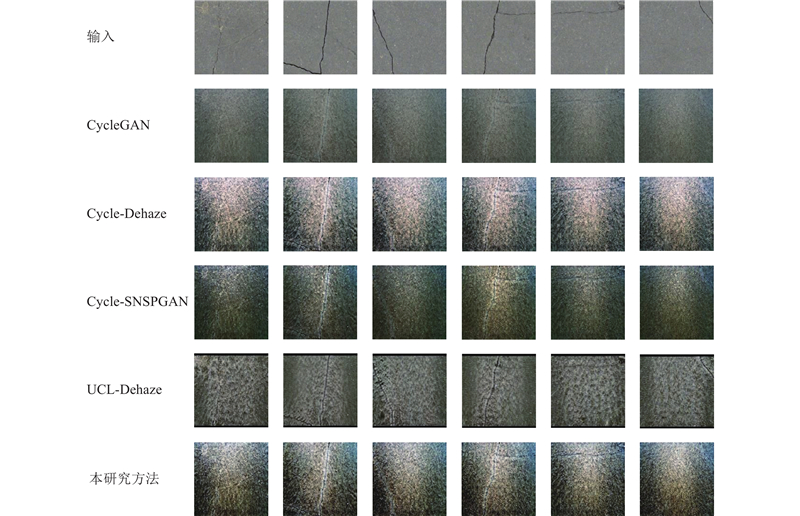

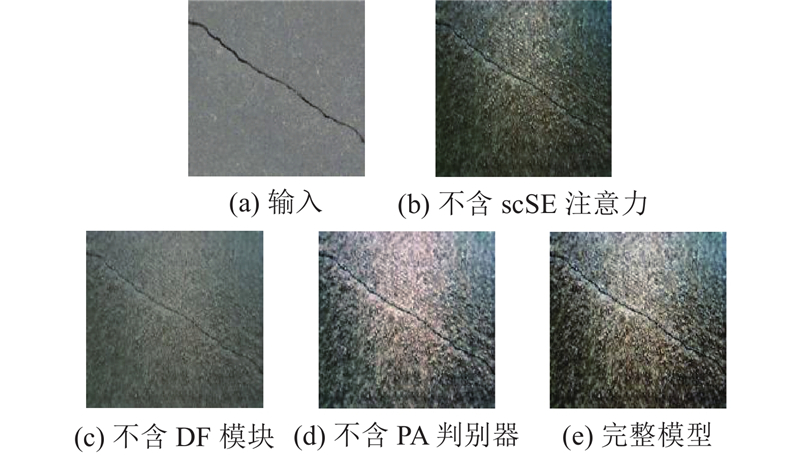

1

... 使用改进的CycleGAN将陆地混凝土桥梁裂缝转换为水下桥墩裂缝,在捕捉陆地裂缝图像纹理细节的同时,也起到图像增强的效果. 为了验证模型的可行性,挑选几种基于CycleGAN改进的图像转换算法模型(CycleGAN、Cycle-Dehaze[23 ] 、Cycle-SNSPGAN[24 ] 、UCL-Dehaze[25 ] )作为对比,通过峰值信噪比(peak signal to noise ratio, PSNR)、水下彩色图像质量评估(underwater color image quality evaluation, UCIQE)[26 ] 、水下图像质量评价指标(underwater image quality measures, UIQM)[27 ] 等指标定量分析实验结果. 为了验证各个模块的效果,也对提出的模型进行消融实验. ...

Cycle-SNSPGAN: towards real-world image dehazing via cycle spectral normalized soft likelihood estimation patch GAN

1

2022

... 使用改进的CycleGAN将陆地混凝土桥梁裂缝转换为水下桥墩裂缝,在捕捉陆地裂缝图像纹理细节的同时,也起到图像增强的效果. 为了验证模型的可行性,挑选几种基于CycleGAN改进的图像转换算法模型(CycleGAN、Cycle-Dehaze[23 ] 、Cycle-SNSPGAN[24 ] 、UCL-Dehaze[25 ] )作为对比,通过峰值信噪比(peak signal to noise ratio, PSNR)、水下彩色图像质量评估(underwater color image quality evaluation, UCIQE)[26 ] 、水下图像质量评价指标(underwater image quality measures, UIQM)[27 ] 等指标定量分析实验结果. 为了验证各个模块的效果,也对提出的模型进行消融实验. ...

UCL-dehaze: toward real-world image dehazing via unsupervised contrastive learning

1

2024

... 使用改进的CycleGAN将陆地混凝土桥梁裂缝转换为水下桥墩裂缝,在捕捉陆地裂缝图像纹理细节的同时,也起到图像增强的效果. 为了验证模型的可行性,挑选几种基于CycleGAN改进的图像转换算法模型(CycleGAN、Cycle-Dehaze[23 ] 、Cycle-SNSPGAN[24 ] 、UCL-Dehaze[25 ] )作为对比,通过峰值信噪比(peak signal to noise ratio, PSNR)、水下彩色图像质量评估(underwater color image quality evaluation, UCIQE)[26 ] 、水下图像质量评价指标(underwater image quality measures, UIQM)[27 ] 等指标定量分析实验结果. 为了验证各个模块的效果,也对提出的模型进行消融实验. ...

An underwater color image quality evaluation metric

1

2015

... 使用改进的CycleGAN将陆地混凝土桥梁裂缝转换为水下桥墩裂缝,在捕捉陆地裂缝图像纹理细节的同时,也起到图像增强的效果. 为了验证模型的可行性,挑选几种基于CycleGAN改进的图像转换算法模型(CycleGAN、Cycle-Dehaze[23 ] 、Cycle-SNSPGAN[24 ] 、UCL-Dehaze[25 ] )作为对比,通过峰值信噪比(peak signal to noise ratio, PSNR)、水下彩色图像质量评估(underwater color image quality evaluation, UCIQE)[26 ] 、水下图像质量评价指标(underwater image quality measures, UIQM)[27 ] 等指标定量分析实验结果. 为了验证各个模块的效果,也对提出的模型进行消融实验. ...

Human-visual-system-inspired underwater image quality measures

1

2016

... 使用改进的CycleGAN将陆地混凝土桥梁裂缝转换为水下桥墩裂缝,在捕捉陆地裂缝图像纹理细节的同时,也起到图像增强的效果. 为了验证模型的可行性,挑选几种基于CycleGAN改进的图像转换算法模型(CycleGAN、Cycle-Dehaze[23 ] 、Cycle-SNSPGAN[24 ] 、UCL-Dehaze[25 ] )作为对比,通过峰值信噪比(peak signal to noise ratio, PSNR)、水下彩色图像质量评估(underwater color image quality evaluation, UCIQE)[26 ] 、水下图像质量评价指标(underwater image quality measures, UIQM)[27 ] 等指标定量分析实验结果. 为了验证各个模块的效果,也对提出的模型进行消融实验. ...

Automatic pixel-level crack detection and measurement using fully convolutional network

1

2018

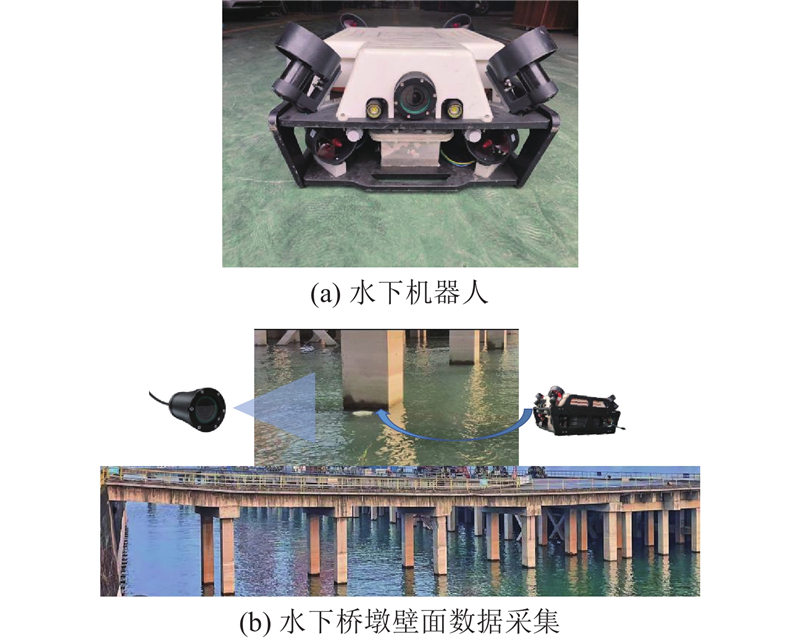

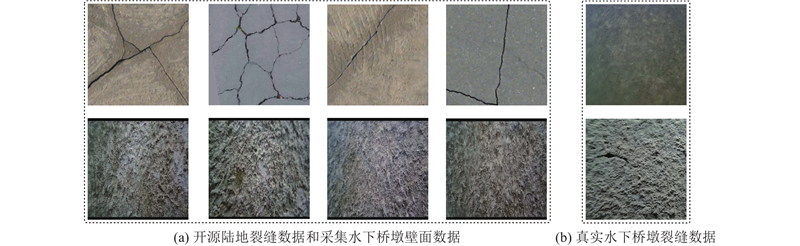

... CycleGAN网络不需要配对的图像来训练,可采用公开裂缝数据集[28 ] . 作为数据集A,共约3500 张,其中2200 张作为训练集,1300 张作为测试集,以测试改进的CycleGAN. 另外,采用一款搭载高清防水相机的有缆水下机器人(ROV),如图3 所示. 采集地点为重庆市涪陵区鹤凤大道的攀华码头,数十根水下桥墩桩基提供了充足的桥墩壁面数据,水下机器人通过高清摄像头以及前置灯光构成感知系统采集水下桥墩壁面图像数据,利用8个无刷推进器驱动机器人前后左右、上浮下潜运动实现桥墩壁面的全局环绕扫描. 对视频流处理,共得到约2200 张水下桥墩壁面图像数据,如图4 (a)所示. 在采集壁面数据的同时也采集到约50张水下桥墩裂缝数据,如图4 (b)所示. ...

A color image fusion model by saturation-value total variation

1

2024

... 为了更直观地展现陆地与水下环境的差异性,对陆地裂缝和水下桥墩壁面进行评估,由于UIQM和UCIQE指标是针对水下环境,PSNR指标为参考图像指标,故不采用这3个指标评估两者的差异性,而选择自然图像质量评估器NIQE[29 ] 指标进行评估. NIQE是基于图像自然场景统计特性(natural scene statistic,NSS)的视觉质量评价指标,它的优势在于无须与参考图像进行比较即可评估图像质量. 这一评估方法依赖于多变量高斯(multivariate Gaussian,MVG)模型,该模型能够捕捉自然图像的关键统计特征,并构建起一个质量评估框架. NIQE计算图像的局部属性,例如梯度的强度和方向,并将这些属性与从大量高品质自然图像中提取的统计数据模型进行对比. 量化图像特征与该属性之间的偏差,NIQE能够评估图像质量,较小的偏差表明图像质量更接近于高质量的自然图像,而较大的偏差则暗示着较低的图像质量. ...

1

... 目标检测的目的是检测图像中感兴趣的物体并确定他们的类别和位置. 通过改进的CycleGAN网络生成水下桥墩裂缝,弥补了水下桥墩裂缝数据稀缺的问题,为后续的目标检测算法在水下机器人工作中的部署奠定基础. RT-DETR实时性能卓越、高精度、无需NMS后处理并且可扩展性较好;YOLOv8在速度和精度的平衡上较优,且一直持续迭代更新. 2种检测方法都能为水下结构检测提供强有力的支持. 为了验证所提方法在目标检测任务中的效果,采用RT-DETRr18[30 ] 和YOLOv8n进行效果验证. ...

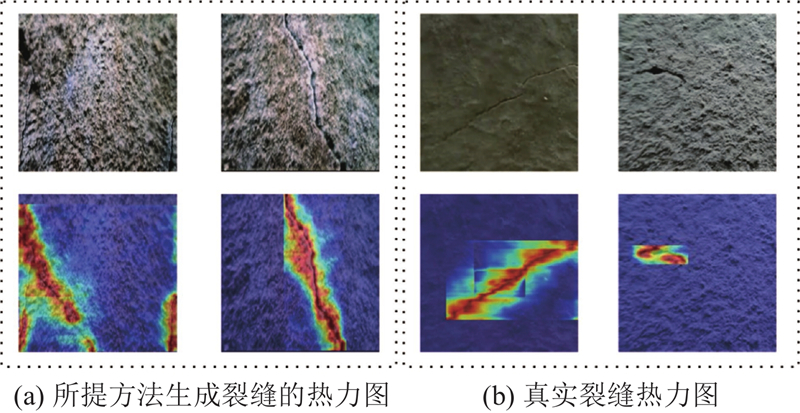

1

... 为了凸显生成样本的有效性,将所提方法转换出的水下桥墩裂缝数据的测试集替换为真实的由水下机器人采集的水下桥墩裂缝数据,生成样本和真实样本的目标检测效果验证如表4 所示. 其中,粗体表示最好的. 可以看出,真实样本的准确率高于生成样本的准确率,但是在其他3个指标的得分上,生成样本分数更高,总体相差不大. 同时,利用可视化注意力热图Grad-CAM++ (Gradient-weighted Class Activation Mapping Plus Plus) [31 ] 创建热图矩阵,以可视化和理解深度学习模型在执行预测时如何关注输入图像中的重要特征. 通过Grad-CAM++,不仅能够直观展示模型是否捕捉到了裂缝的关键特征,并通过热图的形式,突出显示了对模型输出结果影响最大的像素区域. 这种可视化策略不仅增强了对模型决策过程的理解,而且为进一步优化模型提供了有力的视觉支持,另外还可以体现出所提方法产生的水下桥墩裂缝和真实水下桥墩裂缝的质量. 具体来说,颜色的深浅代表图像中每个位置的重要性,颜色越深,表示模型对该区域的积极反应越强烈,即模型对该区域的关注度越高. ...