[1]

WANG B, ZHANG S, ZHANG J, et al Architectural style classification based on CNN and channel–spatial attention

[J]. Signal, Image and Video Processing , 2023 , 17 (1 ): 99 - 107

DOI:10.1007/s11760-022-02208-0

[本文引用: 1]

[2]

FU R, LI J, YANG C, et al Image colour application rules of Shanghai style Chinese paintings based on machine learning algorithm

[J]. Engineering Applications of Artificial Intelligence , 2024 , 132 : 107903

DOI:10.1016/j.engappai.2024.107903

[本文引用: 1]

[3]

ZHAO R, LIU K. Research on painting image classification based on convolution neural network [C]// Proceedings of the Third International Conference on Artificial Intelligence and Computer Engineering . Wuhan: SPIE, 2023: 225.

[本文引用: 2]

[4]

JIANG S, SHAO M, JIA C, et al Learning consensus representation for weak style classification

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2018 , 40 (12 ): 2906 - 2919

DOI:10.1109/TPAMI.2017.2771766

[本文引用: 7]

[5]

SHAJINI M, RAMANAN A A knowledge-sharing semi-supervised approach for fashion clothes classification and attribute prediction

[J]. The Visual Computer , 2022 , 38 (11 ): 3551 - 3561

DOI:10.1007/s00371-021-02178-3

[本文引用: 1]

[6]

ZHANG H, LUO Y, ZHANG L, et al Considering three elements of aesthetics: multi-task self-supervised feature learning for image style classification

[J]. Neurocomputing , 2023 , 520 : 262 - 273

DOI:10.1016/j.neucom.2022.10.076

[本文引用: 1]

[7]

ZHAO W, ZHOU D, QIU X, et al How to represent paintings: a painting classification using artistic comments

[J]. Sensors , 2021 , 21 (6 ): 1940

DOI:10.3390/s21061940

[本文引用: 2]

[8]

CASTELLANO G, LELLA E, VESSIO G Visual link retrieval and knowledge discovery in painting datasets

[J]. Multimedia Tools and Applications , 2021 , 80 (5 ): 6599 - 6616

DOI:10.1007/s11042-020-09995-z

[本文引用: 1]

[9]

EFTHYMIOU A, RUDINAC S, KACKOVIC M, et al. Graph neural networks for knowledge enhanced visual representation of paintings [EB/OL]. (2021–05–17)[2024–06–09]. https://arxiv.org/pdf/2105.08190.

[本文引用: 2]

[10]

STERMAN S, HUANG E, LIU V, et al. Interacting with literary style through computational tools [C]// Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems . Honolulu: ACM, 2020: 1–12.

[本文引用: 2]

[11]

MITCHELL V W, HARVEY W S, WOOD G Where does all the ‘know how ’ go? The role of tacit knowledge in research impact

[J]. Higher Education Research and Development , 2022 , 41 (5 ): 1664 - 1678

DOI:10.1080/07294360.2021.1937066

[本文引用: 1]

[12]

CUI J, LIU Y Q, LU H J, et al PortraitNET: photo-realistic portrait cartoon style transfer with self-supervised semantic supervision

[J]. Neurocomputing , 2021 , 465 : 114 - 127

DOI:10.1016/j.neucom.2021.08.088

[本文引用: 1]

[13]

SUN M, ZHANG D, WANG Z, et al Monte Carlo Convex Hull Model for classification of traditional Chinese paintings

[J]. Neurocomputing , 2016 , 171 : 788 - 797

DOI:10.1016/j.neucom.2015.08.013

[本文引用: 1]

[14]

GENG J, ZHANG X, YAN Y, et al MCCFNet: multi-channel color fusion network for cognitive classification of traditional Chinese paintings

[J]. Cognitive Computation , 2023 , 15 (6 ): 2050 - 2061

DOI:10.1007/s12559-023-10172-1

[本文引用: 3]

[15]

LIU S, YANG J, AGAIAN S S, et al Novel features for art movement classification of portrait paintings

[J]. Image and Vision Computing , 2021 , 108 : 104121

DOI:10.1016/j.imavis.2021.104121

[本文引用: 1]

[16]

WANG Z, SUN M, HAN Y, et al Supervised heterogeneous sparse feature selection for Chinese paintings classification

[J]. Journal of Computer-Aided Design and Computer Graphics , 2013 , 25 (12 ): 1848 - 1855

[本文引用: 1]

[17]

CUI J, ZANG M, LIU Z, et al BIM product style classification and retrieval based on long-range style dependencies

[J]. Buildings , 2023 , 13 (9 ): 2280

DOI:10.3390/buildings13092280

[本文引用: 2]

[18]

杨冰, 许端清, 杨鑫, 等 基于艺术风格相似性规则的绘画图像分类

[J]. 浙江大学学报: 工学版 , 2013 , 47 (8 ): 1486 - 1492

[本文引用: 1]

YANG Bing, XU Duanqing, YANG Xin, et al Painting image classification based on aesthetic style similarity rule

[J]. Journal of Zhejiang University: Engineering Science , 2013 , 47 (8 ): 1486 - 1492

[本文引用: 1]

[20]

钱文华, 徐丹, 徐瑾, 等 基于信息熵的风格绘画分类研究

[J]. 图学学报 , 2019 , 40 (6 ): 991 - 999

[本文引用: 1]

QIAN Wenhua, XU Dan, XU Jin, et al Artistic paintings classification based on information entropy

[J]. Journal of Graphics , 2019 , 40 (6 ): 991 - 999

[本文引用: 1]

[21]

PAN S J, YANG Q A survey on transfer learning

[J]. IEEE Transactions on Knowledge and Data Engineering , 2010 , 22 (10 ): 1345 - 1359

DOI:10.1109/TKDE.2009.191

[本文引用: 1]

[22]

KRIZHEVSKY A, SUTSKEVER I, HINTON G E ImageNet classification with deep convolutional neural networks

[J]. Communications of the ACM , 2017 , 60 (6 ): 84 - 90

DOI:10.1145/3065386

[本文引用: 1]

[23]

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context [C]// Computer Vision – ECCV 2014 . [S. l.]: Springer, 2014: 740–755.

[本文引用: 1]

[24]

CHAIB S, YAO H, GU Y, et al. Deep feature extraction and combination for remote sensing image classification based on pre-trained CNN models [C]// Proceedings of the Ninth International Conference on Digital Image Processing . Hong Kong: SPIE, 2017: 104203D.

[本文引用: 1]

[25]

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [EB/OL]. (2015–04–10)[2024–06–09]. https://arxiv.org/pdf/1409.1556.

[本文引用: 1]

[26]

SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Las Vegas: IEEE, 2016: 2818–2826.

[本文引用: 1]

[27]

HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 2261–2269.

[本文引用: 1]

[28]

MILANI F, FRATERNALI P A dataset and a convolutional model for iconography classification in paintings

[J]. Journal on Computing and Cultural Heritage , 2021 , 14 (4 ): 1 - 18

[本文引用: 2]

[29]

ALIREZAZADEH P, DORNAIKA F, MOUJAHID A A deep learning loss based on additive cosine margin: application to fashion style and face recognition

[J]. Applied Soft Computing , 2022 , 131 : 109776

DOI:10.1016/j.asoc.2022.109776

[本文引用: 1]

[30]

STREZOSKI G, WORRING M. OmniArt: multi-task deep learning for artistic data analysis [EB/OL]. (2017–08–02)[2024–06–09]. https://arxiv.org/pdf/1708.00684.

[本文引用: 1]

[31]

YIN X C, YIN X, HUANG K, et al Robust text detection in natural scene images

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2014 , 36 (5 ): 970 - 983

DOI:10.1109/TPAMI.2013.182

[本文引用: 1]

[32]

BIANCO S, MAZZINI D, NAPOLETANO P, et al Multitask painting categorization by deep multibranch neural network

[J]. Expert Systems with Applications , 2019 , 135 : 90 - 101

DOI:10.1016/j.eswa.2019.05.036

[本文引用: 1]

[33]

WANG Z, ZHAO L, XING W. StyleDiffusion: controllable disentangled style transfer via diffusion models [C]// Proceedings of the IEEE/CVF International Conference on Computer Vision . Paris: IEEE, 2023: 7643–7655.

[本文引用: 1]

[34]

CUI J, LIU G, JIA Z L, et al Similar visual complexity analysis model based on subjective perception

[J]. IEEE Access , 2019 , 7 : 148873 - 148881

DOI:10.1109/ACCESS.2019.2946695

[本文引用: 1]

[35]

MENIS-MASTROMICHALAKIS O, SOFOU N, STAMOU G. Deep ensemble art style recognition [C]// Proceedings of the International Joint Conference on Neural Networks . Glasgow: IEEE, 2020: 1–8.

[本文引用: 1]

[36]

ELFWING S, UCHIBE E, DOYA K Sigmoid-weighted linear units for neural network function approximation in reinforcement learning

[J]. Neural Networks , 2018 , 107 : 3 - 11

DOI:10.1016/j.neunet.2017.12.012

[本文引用: 1]

[37]

VINCENT P, LAROCHELLE H, BENGIO Y, et al. Extracting and composing robust features with denoising autoencoders [C]// Proceedings of the 25th International Conference on Machine Learning . Helsinki: ACM, 2008: 1096–1103.

[本文引用: 3]

[38]

BOURLARD H, KAMP Y Auto-association by multilayer perceptrons and singular value decomposition

[J]. Biological Cybernetics , 1988 , 59 (4 ): 291 - 294

[本文引用: 1]

[39]

LI C, HARRISON B. StyleM: stylized metrics for image captioning built with contrastive N-grams [EB/OL]. (2022–01–04)[2024–06–09]. https://arxiv.org/pdf/2201.00975.

[本文引用: 1]

[40]

KHAN F S, BEIGPOUR S, VAN DE WEIJER J, et al Painting-91: a large scale database for computational painting categorization

[J]. Machine Vision and Applications , 2014 , 25 (6 ): 1385 - 1397

DOI:10.1007/s00138-014-0621-6

[本文引用: 1]

[41]

FLOREA C, CONDOROVICI R, VERTAN C, et al. Pandora: description of a painting database for art movement recognition with baselines and perspectives [C]// Proceedings of the 24th European Signal Processing Conference . Budapest: IEEE, 2016: 918–922.

[本文引用: 1]

[42]

湛颖, 高妍, 谢凌云 中国国画情感—美感数据库

[J]. 中国图象图形学报 , 2019 , 24 (12 ): 2267 - 2278

DOI:10.11834/jig.190102

[本文引用: 2]

ZHAN Ying, GAO Yan, XIE Lingyun Database for emotion and aesthetic analysis of traditional Chinese paintings

[J]. Journal of Image and Graphics , 2019 , 24 (12 ): 2267 - 2278

DOI:10.11834/jig.190102

[本文引用: 2]

[43]

TAKAGI M, SIMO-SERRA E, IIZUKA S, et al. What makes a style: experimental analysis of fashion prediction [C]// Proceedings of the IEEE International Conference on Computer Vision Workshops . Venice: IEEE, 2017: 2247–2253.

[本文引用: 1]

[44]

XU Z, TAO D, ZHANG Y, et al. Architectural style classification using multinomial latent logistic regression [C]// Computer Vision – ECCV 2014 . [S. l.]: Springer, 2014: 600–615.

[本文引用: 1]

[45]

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Las Vegas: IEEE, 2016: 770–778.

[本文引用: 1]

[46]

VINCENT P, LAROCHELLE H, LAJOIE I, et al Stacked denoising autoencoders: learning useful representations in a deep network with a local denoising criterion

[J]. Journal of Machine Learning Research , 2010 , 11 : 3371 - 3408

[本文引用: 1]

[47]

VIJENDRAN M, LI F W, SHUM H P. Tackling data bias in painting classification with style transfer [EB/OL]. (2023–01–06) [2024–06–09]. https://arxiv.org/pdf/2301.02524.

[本文引用: 1]

Architectural style classification based on CNN and channel–spatial attention

1

2023

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

Image colour application rules of Shanghai style Chinese paintings based on machine learning algorithm

1

2024

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

2

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

Learning consensus representation for weak style classification

7

2018

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

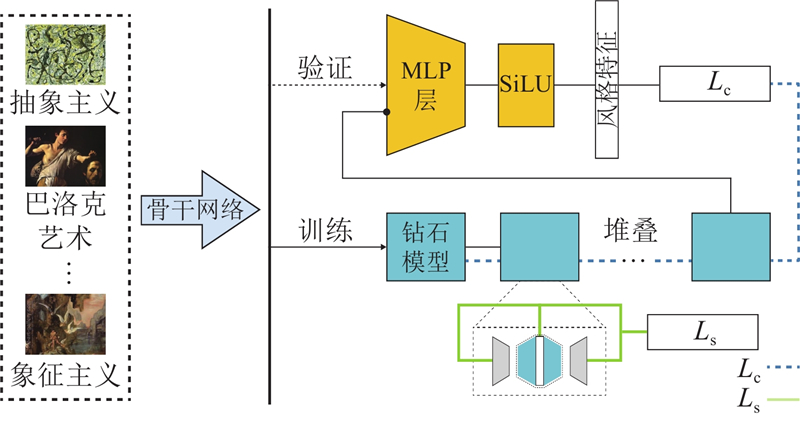

... 设计师通过经验积累学习风格概念,利用比较法辨别风格[10 ] . 研究发现,单个图像(如油画)中通常包含1种主风格和多种不确定的子风格. 本研究定义这些子风格元素为风格噪声. 风格噪声使同类别图像之间出现特征偏差,给分类模型带来挑战. 风格迁移(neural style transfer, NST)研究表明,风格越相似,迁移越容易(迭代越少)[33 -34 ] . 本研究将在同一风格类别中学习到的共享风格特征作为风格描述因子,降低风格扩散带来的干扰. 共享特征学习无需像NST工作那样提前准备配对数据,只需类别监督. 不同于风格降噪研究[4 ] ,风格共享特征学习无需指定主风格元素和子风格元素(即使专业设计人员也难以精准辨别),而是从迁移过程中提取风格共享特征. 除此之外,为了提高特征学习和分类模型的收敛性,本研究提出使用堆叠的钻石模型提取共享特征,原因是堆叠使用方式比其他模型融合策略表现更佳[35 ] . 在训练过程中使用共享损失和分类损失进行反向传播,整体框架如图1 所示. 通过预训练模型(VGG或ResNet)提取特征后,风格数据送入钻石模型进行主风格特征学习. 经过钻石模型提取风格特征后,通过多层感知器进行特征映射,由SiLU[36 ] 激活后进行风格类别推理. ...

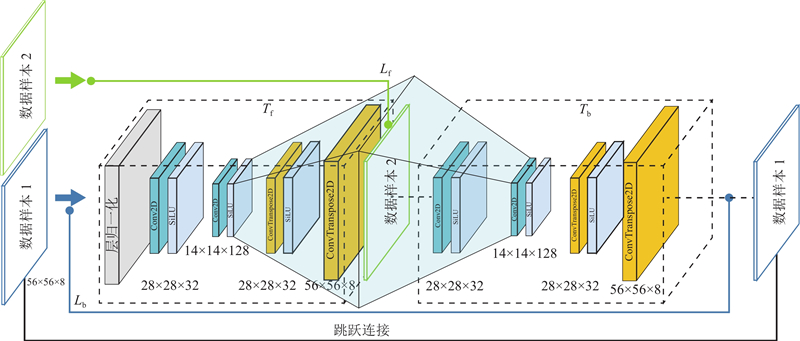

... 为了解决风格偏差问题,许多研究采用降噪技术处理子风格差异. 堆叠自编码器[38 ] ( stacked auto-encoders, SAE)重建输入向量,利用数据自身信息无监督地降噪. Vincent等[37 ] 在SAE的基础上引入去噪自动编码器(denoising autoencoder, DAE),通过在训练阶段加入随机噪声使算法具有一定的抗噪性. Jiang等[4 ] 提出风格集中的方法,通过使用输入数据重建具有更强风格特征的图像来学习主风格特征. 在降噪模型训练中,纯净数据与噪声数据对至关重要,但高质量数据对难获得. 如图2 所示,本研究构建的钻石模型由风格迁移过程${T_{\text{f}}}$ ${T_{\text{b}}}$ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$

... 在Painting91和Pandora上开展模型消融实验,对比不同模块的分类效果. 其中E[37 ] 仅采用自动编码器进行特征提取;E-D采用基于重建的生成过程提取风格特征[4 ] ;$ {T_{\text{f}}} $ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$ 表2 所示. E提取特征无法屏蔽子风格干扰,受风格扩散现象影响,准确率较低;E-D采用基于重建的方法可以轻微改善分类效果,但仍无法抑制子风格扩散;采用循环生成方式可以有效改善该问题,如$ {T_{\text{f}}} $ ${T_{\text{f}}}$ ${T_{\text{b}}}$

... 如表4 所示,将所提模型与3类风格分类方法进行对比. 1)预训练CNN模型:VGG16、VGG19、ResNet50[45 ] 、ResNet101和Inception-V3. 在风格分类研究领域中,主流工作仍广泛采用VGG、ResNet和Inception预训练模型[28 ] ,研究发现,粗粒度的特征更有利于后续的风格特征学习. 本研究主要采用上述模型进行粗粒度特征提取. 2)降噪分类模型:DAE[46 ] 、SCAE和SSCAE[4 ] . 3)新的风格分类算法:STSACLF[47 ] 、MCCFNet[14 ] 和DDS[17 ] . 本研究1为采用VGG16作为骨干网络结合本文方法的模型,本研究2为采用ResNet50作为骨干网络结合本文方法的模型. 第1类模型使用预训练模型提取图像特征,为了避免维度灾难,使用PCA将图像特征降为4 096维. 预训练模型效果受风格偏差影响较大,同类数据之间的偏差程度会直接影响分类的效果. 相比油画风格数据,建筑与时尚数据之间的偏差较小,由表可知,油画风格数据集的准确率明显低于建筑风格数据集和时尚风格数据集. 在第2类模型中,DAE依靠数据自身信息以无监督的方式去噪,效果较差. SCAE将风格划分成若干等级,使用输入数据重建风格更强的图像,增强了风格特征强度,分类性能获得一定提升. SSCAE采用堆叠SCAE的方式,进一步减少了风格噪声的影响,但在风格偏差较大的Pandora中效果提升不明显. 在第3类模型中,DDS利用设计特征来保持风格分类的稳定性,但无法提高准确率. MCCFNet为基于预训练模型DenseNet121的改进模型,在风格偏差较大的数据上效果明显下降. STSACLF使用风格迁移模型训练风格数据进行分类. 由于未对风格类内共享特征进行学习,在风格偏差较大的数据集中,分类准确率提升有限. 本研究使用预训练模型提取图像特征,堆叠多个钻石模型进行训练学习共享特征. 在5个数据集上均获得不同程度的性能提升(提升2~7个百分点). 实验发现,共享特征是对风格数据的主风格提取后获得的,当输入特征抽象等级较高时,将会损失部分主风格特征;当输入特征包含更多底层信息时,所提模型可以更好地提取可迁移的主风格特征,获得稳定的分类效果. ...

A knowledge-sharing semi-supervised approach for fashion clothes classification and attribute prediction

1

2022

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

Considering three elements of aesthetics: multi-task self-supervised feature learning for image style classification

1

2023

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

How to represent paintings: a painting classification using artistic comments

2

2021

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

... 结合视觉风格和辅助信息的多任务模型逐渐引起研究人员关注. Strezoski等[30 ] 提出多任务分类CNN模型,该模型在全连接层后设有多个输出层,分别用于预测艺术家、风格和流派等任务. GraphSAGE[9 ] 使用图神经网络联合学习视觉和语义特征进行知识推理任务,同时使用CNN预测风格和设计相关属性. Yin等[31 ] 提出基于稀疏编码的多任务共享参数模型. Bianco等[32 ] 提出基于分辨率金字塔的多分支模型,用于分析粗略布局和详细构成. MCCFNet[14 ] 使用区域加权池化层和3个色彩通道进行基于色彩特征的风格识别. ArtGAN[7 ] 使用图卷积模型学习绘画数据和艺术评论,以完成风格分类. 尽管辅助数据提高了风格分类的准确性,但高昂的计算成本和额外负担限制了这些方法的实际应用. ...

Visual link retrieval and knowledge discovery in painting datasets

1

2021

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

2

... 风格分类是根据可视化媒介(图像、油画、照片等)的风格特征进行类别预测. 风格既包括媒介的色调、纹理、构图等视觉特征,也指代抽象的艺术概念,如印象派、写实主义、巴洛克等. 图像风格分类方法可分为2种:单任务模式和多任务模式. 单任务模式用特征统计模型[1 ] 和深度学习策略[2 -3 ] 提取具有区分度的风格描述因子. 这种方法主要依赖于特征学习的准确性,图像数据在弱风格区域会出现不同的子风格(风格扩散现象) [4 ] ,因此单任务模式受数据集影响较大. 多任务模型通过多模态特征表示图像的不同信息,例如属性预测[5 ] 、子图识别[6 ] 、艺术评论[7 ] 和知识图谱[8 -9 ] 等,各种信息相互补充,可以有效地减缓风格扩散带来的影响,但高昂的额外标注成本影响方法的实际应用. ...

... 结合视觉风格和辅助信息的多任务模型逐渐引起研究人员关注. Strezoski等[30 ] 提出多任务分类CNN模型,该模型在全连接层后设有多个输出层,分别用于预测艺术家、风格和流派等任务. GraphSAGE[9 ] 使用图神经网络联合学习视觉和语义特征进行知识推理任务,同时使用CNN预测风格和设计相关属性. Yin等[31 ] 提出基于稀疏编码的多任务共享参数模型. Bianco等[32 ] 提出基于分辨率金字塔的多分支模型,用于分析粗略布局和详细构成. MCCFNet[14 ] 使用区域加权池化层和3个色彩通道进行基于色彩特征的风格识别. ArtGAN[7 ] 使用图卷积模型学习绘画数据和艺术评论,以完成风格分类. 尽管辅助数据提高了风格分类的准确性,但高昂的计算成本和额外负担限制了这些方法的实际应用. ...

2

... 图像风格具有难以用语言描述但易于感知的特点[10 ] . 艺术家可以通过视觉作品表达个人特色,但难以用文字形式化描述. 因此,风格被认为是隐性知识[11 ] ,即使在同一类别中,不同作者的个人偏好也可能导致数据间的特征偏差,为风格分类任务带来较大挑战. 借鉴风格迁移研究[12 ] ,本研究提出面向风格扩散的共享特征学习框架. 假设来自相同类别的数据具有相同或相似的风格分类特点,将同类别中可相互迁移的特征定义为风格类内的共享特征,通过迁移学习主风格特征达到对不同风格的区分和辨别. 相同风格类别中的共享特征更易迁移(所需迭代次数更少),不同类别之间则较难. 本研究提出钻石模型,通过互逆的2个生成过程学习同类别数据的共享特征. 借鉴多任务模型,通过基于类别监督的方式同时优化风格分类模型和共享特征学习模型. ...

... 设计师通过经验积累学习风格概念,利用比较法辨别风格[10 ] . 研究发现,单个图像(如油画)中通常包含1种主风格和多种不确定的子风格. 本研究定义这些子风格元素为风格噪声. 风格噪声使同类别图像之间出现特征偏差,给分类模型带来挑战. 风格迁移(neural style transfer, NST)研究表明,风格越相似,迁移越容易(迭代越少)[33 -34 ] . 本研究将在同一风格类别中学习到的共享风格特征作为风格描述因子,降低风格扩散带来的干扰. 共享特征学习无需像NST工作那样提前准备配对数据,只需类别监督. 不同于风格降噪研究[4 ] ,风格共享特征学习无需指定主风格元素和子风格元素(即使专业设计人员也难以精准辨别),而是从迁移过程中提取风格共享特征. 除此之外,为了提高特征学习和分类模型的收敛性,本研究提出使用堆叠的钻石模型提取共享特征,原因是堆叠使用方式比其他模型融合策略表现更佳[35 ] . 在训练过程中使用共享损失和分类损失进行反向传播,整体框架如图1 所示. 通过预训练模型(VGG或ResNet)提取特征后,风格数据送入钻石模型进行主风格特征学习. 经过钻石模型提取风格特征后,通过多层感知器进行特征映射,由SiLU[36 ] 激活后进行风格类别推理. ...

Where does all the ‘know how ’ go? The role of tacit knowledge in research impact

1

2022

... 图像风格具有难以用语言描述但易于感知的特点[10 ] . 艺术家可以通过视觉作品表达个人特色,但难以用文字形式化描述. 因此,风格被认为是隐性知识[11 ] ,即使在同一类别中,不同作者的个人偏好也可能导致数据间的特征偏差,为风格分类任务带来较大挑战. 借鉴风格迁移研究[12 ] ,本研究提出面向风格扩散的共享特征学习框架. 假设来自相同类别的数据具有相同或相似的风格分类特点,将同类别中可相互迁移的特征定义为风格类内的共享特征,通过迁移学习主风格特征达到对不同风格的区分和辨别. 相同风格类别中的共享特征更易迁移(所需迭代次数更少),不同类别之间则较难. 本研究提出钻石模型,通过互逆的2个生成过程学习同类别数据的共享特征. 借鉴多任务模型,通过基于类别监督的方式同时优化风格分类模型和共享特征学习模型. ...

PortraitNET: photo-realistic portrait cartoon style transfer with self-supervised semantic supervision

1

2021

... 图像风格具有难以用语言描述但易于感知的特点[10 ] . 艺术家可以通过视觉作品表达个人特色,但难以用文字形式化描述. 因此,风格被认为是隐性知识[11 ] ,即使在同一类别中,不同作者的个人偏好也可能导致数据间的特征偏差,为风格分类任务带来较大挑战. 借鉴风格迁移研究[12 ] ,本研究提出面向风格扩散的共享特征学习框架. 假设来自相同类别的数据具有相同或相似的风格分类特点,将同类别中可相互迁移的特征定义为风格类内的共享特征,通过迁移学习主风格特征达到对不同风格的区分和辨别. 相同风格类别中的共享特征更易迁移(所需迭代次数更少),不同类别之间则较难. 本研究提出钻石模型,通过互逆的2个生成过程学习同类别数据的共享特征. 借鉴多任务模型,通过基于类别监督的方式同时优化风格分类模型和共享特征学习模型. ...

Monte Carlo Convex Hull Model for classification of traditional Chinese paintings

1

2016

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

MCCFNet: multi-channel color fusion network for cognitive classification of traditional Chinese paintings

3

2023

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

... 结合视觉风格和辅助信息的多任务模型逐渐引起研究人员关注. Strezoski等[30 ] 提出多任务分类CNN模型,该模型在全连接层后设有多个输出层,分别用于预测艺术家、风格和流派等任务. GraphSAGE[9 ] 使用图神经网络联合学习视觉和语义特征进行知识推理任务,同时使用CNN预测风格和设计相关属性. Yin等[31 ] 提出基于稀疏编码的多任务共享参数模型. Bianco等[32 ] 提出基于分辨率金字塔的多分支模型,用于分析粗略布局和详细构成. MCCFNet[14 ] 使用区域加权池化层和3个色彩通道进行基于色彩特征的风格识别. ArtGAN[7 ] 使用图卷积模型学习绘画数据和艺术评论,以完成风格分类. 尽管辅助数据提高了风格分类的准确性,但高昂的计算成本和额外负担限制了这些方法的实际应用. ...

... 如表4 所示,将所提模型与3类风格分类方法进行对比. 1)预训练CNN模型:VGG16、VGG19、ResNet50[45 ] 、ResNet101和Inception-V3. 在风格分类研究领域中,主流工作仍广泛采用VGG、ResNet和Inception预训练模型[28 ] ,研究发现,粗粒度的特征更有利于后续的风格特征学习. 本研究主要采用上述模型进行粗粒度特征提取. 2)降噪分类模型:DAE[46 ] 、SCAE和SSCAE[4 ] . 3)新的风格分类算法:STSACLF[47 ] 、MCCFNet[14 ] 和DDS[17 ] . 本研究1为采用VGG16作为骨干网络结合本文方法的模型,本研究2为采用ResNet50作为骨干网络结合本文方法的模型. 第1类模型使用预训练模型提取图像特征,为了避免维度灾难,使用PCA将图像特征降为4 096维. 预训练模型效果受风格偏差影响较大,同类数据之间的偏差程度会直接影响分类的效果. 相比油画风格数据,建筑与时尚数据之间的偏差较小,由表可知,油画风格数据集的准确率明显低于建筑风格数据集和时尚风格数据集. 在第2类模型中,DAE依靠数据自身信息以无监督的方式去噪,效果较差. SCAE将风格划分成若干等级,使用输入数据重建风格更强的图像,增强了风格特征强度,分类性能获得一定提升. SSCAE采用堆叠SCAE的方式,进一步减少了风格噪声的影响,但在风格偏差较大的Pandora中效果提升不明显. 在第3类模型中,DDS利用设计特征来保持风格分类的稳定性,但无法提高准确率. MCCFNet为基于预训练模型DenseNet121的改进模型,在风格偏差较大的数据上效果明显下降. STSACLF使用风格迁移模型训练风格数据进行分类. 由于未对风格类内共享特征进行学习,在风格偏差较大的数据集中,分类准确率提升有限. 本研究使用预训练模型提取图像特征,堆叠多个钻石模型进行训练学习共享特征. 在5个数据集上均获得不同程度的性能提升(提升2~7个百分点). 实验发现,共享特征是对风格数据的主风格提取后获得的,当输入特征抽象等级较高时,将会损失部分主风格特征;当输入特征包含更多底层信息时,所提模型可以更好地提取可迁移的主风格特征,获得稳定的分类效果. ...

Novel features for art movement classification of portrait paintings

1

2021

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

Supervised heterogeneous sparse feature selection for Chinese paintings classification

1

2013

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

BIM product style classification and retrieval based on long-range style dependencies

2

2023

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

... 如表4 所示,将所提模型与3类风格分类方法进行对比. 1)预训练CNN模型:VGG16、VGG19、ResNet50[45 ] 、ResNet101和Inception-V3. 在风格分类研究领域中,主流工作仍广泛采用VGG、ResNet和Inception预训练模型[28 ] ,研究发现,粗粒度的特征更有利于后续的风格特征学习. 本研究主要采用上述模型进行粗粒度特征提取. 2)降噪分类模型:DAE[46 ] 、SCAE和SSCAE[4 ] . 3)新的风格分类算法:STSACLF[47 ] 、MCCFNet[14 ] 和DDS[17 ] . 本研究1为采用VGG16作为骨干网络结合本文方法的模型,本研究2为采用ResNet50作为骨干网络结合本文方法的模型. 第1类模型使用预训练模型提取图像特征,为了避免维度灾难,使用PCA将图像特征降为4 096维. 预训练模型效果受风格偏差影响较大,同类数据之间的偏差程度会直接影响分类的效果. 相比油画风格数据,建筑与时尚数据之间的偏差较小,由表可知,油画风格数据集的准确率明显低于建筑风格数据集和时尚风格数据集. 在第2类模型中,DAE依靠数据自身信息以无监督的方式去噪,效果较差. SCAE将风格划分成若干等级,使用输入数据重建风格更强的图像,增强了风格特征强度,分类性能获得一定提升. SSCAE采用堆叠SCAE的方式,进一步减少了风格噪声的影响,但在风格偏差较大的Pandora中效果提升不明显. 在第3类模型中,DDS利用设计特征来保持风格分类的稳定性,但无法提高准确率. MCCFNet为基于预训练模型DenseNet121的改进模型,在风格偏差较大的数据上效果明显下降. STSACLF使用风格迁移模型训练风格数据进行分类. 由于未对风格类内共享特征进行学习,在风格偏差较大的数据集中,分类准确率提升有限. 本研究使用预训练模型提取图像特征,堆叠多个钻石模型进行训练学习共享特征. 在5个数据集上均获得不同程度的性能提升(提升2~7个百分点). 实验发现,共享特征是对风格数据的主风格提取后获得的,当输入特征抽象等级较高时,将会损失部分主风格特征;当输入特征包含更多底层信息时,所提模型可以更好地提取可迁移的主风格特征,获得稳定的分类效果. ...

基于艺术风格相似性规则的绘画图像分类

1

2013

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

基于艺术风格相似性规则的绘画图像分类

1

2013

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

基于多特征融合的油画艺术风格分类

1

2023

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

基于多特征融合的油画艺术风格分类

1

2023

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

基于信息熵的风格绘画分类研究

1

2019

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

基于信息熵的风格绘画分类研究

1

2019

... 特征学习方法[4 ] 通过手工特征或核函数的方式提取通用图像描述因子〔常用图像特征提取方法包括HOG (histogram of oriented gradient, HOG)和LBP(local binary pattern, LBP)〕,再通过相似度计算来训练分类器(包括决策树、支持向量机、最近邻和其他统计算法),将风格数据分配到最合适的类别中. 色彩是最直观的风格信息特征,色彩矩、色调和色彩范围信息都可用于识别图像的风格[13 ] . Geng等[14 ] 研究Lab、RGB和HSV等色彩空间,详细讨论它们的互补作用. Liu等[15 ] 提出2种新的色彩距离算法: 修正色彩距离和色彩比率特征,用于预测肖像画的艺术流派. 除了色彩外,边缘信息也是表达风格信息的重要特征,通过边缘检测和形态学处理,可以捕捉绘画的笔触特征[16 ] . Cui等[17 ] 从设计学角度提出的16个维度笔触特征增强了对家具风格识别的鲁棒性. 研究人员还使用复合特征表达风格信息. 杨冰等[18 ] 将艺术领域中普遍认可的风格特征量化,通过计算图像与其他样本图像间的相似性系数,建立基于图像自相似性的复合特征,证明了艺术风格相似性的有效性. 谢秦秦等[19 ] 通过将空间特征与底层特征串联融合为新的复合特征,提出基于多特征融合的油画分类算法. 钱文华等[20 ] 将图像的颜色熵、分块熵和轮廓熵合并,构成信息熵作为图像特征,利用支持向量机训练艺术风格图像. 尽管核函数特征在指定数据集上表现良好,但受所选择特征因子和目标风格的制约,稳定性较差. ...

A survey on transfer learning

1

2010

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

ImageNet classification with deep convolutional neural networks

1

2017

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

1

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

1

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

1

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

1

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

1

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

A dataset and a convolutional model for iconography classification in paintings

2

2021

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

... 如表4 所示,将所提模型与3类风格分类方法进行对比. 1)预训练CNN模型:VGG16、VGG19、ResNet50[45 ] 、ResNet101和Inception-V3. 在风格分类研究领域中,主流工作仍广泛采用VGG、ResNet和Inception预训练模型[28 ] ,研究发现,粗粒度的特征更有利于后续的风格特征学习. 本研究主要采用上述模型进行粗粒度特征提取. 2)降噪分类模型:DAE[46 ] 、SCAE和SSCAE[4 ] . 3)新的风格分类算法:STSACLF[47 ] 、MCCFNet[14 ] 和DDS[17 ] . 本研究1为采用VGG16作为骨干网络结合本文方法的模型,本研究2为采用ResNet50作为骨干网络结合本文方法的模型. 第1类模型使用预训练模型提取图像特征,为了避免维度灾难,使用PCA将图像特征降为4 096维. 预训练模型效果受风格偏差影响较大,同类数据之间的偏差程度会直接影响分类的效果. 相比油画风格数据,建筑与时尚数据之间的偏差较小,由表可知,油画风格数据集的准确率明显低于建筑风格数据集和时尚风格数据集. 在第2类模型中,DAE依靠数据自身信息以无监督的方式去噪,效果较差. SCAE将风格划分成若干等级,使用输入数据重建风格更强的图像,增强了风格特征强度,分类性能获得一定提升. SSCAE采用堆叠SCAE的方式,进一步减少了风格噪声的影响,但在风格偏差较大的Pandora中效果提升不明显. 在第3类模型中,DDS利用设计特征来保持风格分类的稳定性,但无法提高准确率. MCCFNet为基于预训练模型DenseNet121的改进模型,在风格偏差较大的数据上效果明显下降. STSACLF使用风格迁移模型训练风格数据进行分类. 由于未对风格类内共享特征进行学习,在风格偏差较大的数据集中,分类准确率提升有限. 本研究使用预训练模型提取图像特征,堆叠多个钻石模型进行训练学习共享特征. 在5个数据集上均获得不同程度的性能提升(提升2~7个百分点). 实验发现,共享特征是对风格数据的主风格提取后获得的,当输入特征抽象等级较高时,将会损失部分主风格特征;当输入特征包含更多底层信息时,所提模型可以更好地提取可迁移的主风格特征,获得稳定的分类效果. ...

A deep learning loss based on additive cosine margin: application to fashion style and face recognition

1

2022

... 得益于深度神经网络的优势和互联网带来的海量数据,深度学习方法在风格分类中的应用取得显著进展. 相比传统方法,深度模型能够从未经处理的风格数据中学习深层特征. 卷积神经网络[3 ] 在艺术风格分类任务中越来越受到研究人员的关注,主要原因是它拥有知识迁移能力[21 ] . 研究人员通常使用ImageNet[22 ] 和COCO[23 ] 数据集的预训练模型,采用迁移学习策略进行模型微调以适应下游风格分类任务[24 ] . VGG[25 ] 、Inception-V3[26 ] 和DenseNet[27 ] 等模型均可通过微调适应风格分类任务. Milani等[28 ] 对上述模型在风格分类任务中的表现进行量化对比,由于可用于训练的图像数量有限,相较于从零开始训练的深度模型,预训练模型在风格分类任务中表现更好且计算成本更低. 为了减少同一风格类别中的风格偏差,Alirezazadeh等[29 ] 提出加性余弦间隔损失函数(additive cosine margin loss, ACML)用于时尚风格识别. 为了解决风格扩散现象,Jiang等[4 ] 提出堆叠去噪模型. 相似风格的图像判断具有模糊性(用户分类时容易出现混淆现象),某些风格概念抽象容易使用户主观判断不统一,这些问题会导致预训练模型的分类性能下降甚至模型崩溃. ...

1

... 结合视觉风格和辅助信息的多任务模型逐渐引起研究人员关注. Strezoski等[30 ] 提出多任务分类CNN模型,该模型在全连接层后设有多个输出层,分别用于预测艺术家、风格和流派等任务. GraphSAGE[9 ] 使用图神经网络联合学习视觉和语义特征进行知识推理任务,同时使用CNN预测风格和设计相关属性. Yin等[31 ] 提出基于稀疏编码的多任务共享参数模型. Bianco等[32 ] 提出基于分辨率金字塔的多分支模型,用于分析粗略布局和详细构成. MCCFNet[14 ] 使用区域加权池化层和3个色彩通道进行基于色彩特征的风格识别. ArtGAN[7 ] 使用图卷积模型学习绘画数据和艺术评论,以完成风格分类. 尽管辅助数据提高了风格分类的准确性,但高昂的计算成本和额外负担限制了这些方法的实际应用. ...

Robust text detection in natural scene images

1

2014

... 结合视觉风格和辅助信息的多任务模型逐渐引起研究人员关注. Strezoski等[30 ] 提出多任务分类CNN模型,该模型在全连接层后设有多个输出层,分别用于预测艺术家、风格和流派等任务. GraphSAGE[9 ] 使用图神经网络联合学习视觉和语义特征进行知识推理任务,同时使用CNN预测风格和设计相关属性. Yin等[31 ] 提出基于稀疏编码的多任务共享参数模型. Bianco等[32 ] 提出基于分辨率金字塔的多分支模型,用于分析粗略布局和详细构成. MCCFNet[14 ] 使用区域加权池化层和3个色彩通道进行基于色彩特征的风格识别. ArtGAN[7 ] 使用图卷积模型学习绘画数据和艺术评论,以完成风格分类. 尽管辅助数据提高了风格分类的准确性,但高昂的计算成本和额外负担限制了这些方法的实际应用. ...

Multitask painting categorization by deep multibranch neural network

1

2019

... 结合视觉风格和辅助信息的多任务模型逐渐引起研究人员关注. Strezoski等[30 ] 提出多任务分类CNN模型,该模型在全连接层后设有多个输出层,分别用于预测艺术家、风格和流派等任务. GraphSAGE[9 ] 使用图神经网络联合学习视觉和语义特征进行知识推理任务,同时使用CNN预测风格和设计相关属性. Yin等[31 ] 提出基于稀疏编码的多任务共享参数模型. Bianco等[32 ] 提出基于分辨率金字塔的多分支模型,用于分析粗略布局和详细构成. MCCFNet[14 ] 使用区域加权池化层和3个色彩通道进行基于色彩特征的风格识别. ArtGAN[7 ] 使用图卷积模型学习绘画数据和艺术评论,以完成风格分类. 尽管辅助数据提高了风格分类的准确性,但高昂的计算成本和额外负担限制了这些方法的实际应用. ...

1

... 设计师通过经验积累学习风格概念,利用比较法辨别风格[10 ] . 研究发现,单个图像(如油画)中通常包含1种主风格和多种不确定的子风格. 本研究定义这些子风格元素为风格噪声. 风格噪声使同类别图像之间出现特征偏差,给分类模型带来挑战. 风格迁移(neural style transfer, NST)研究表明,风格越相似,迁移越容易(迭代越少)[33 -34 ] . 本研究将在同一风格类别中学习到的共享风格特征作为风格描述因子,降低风格扩散带来的干扰. 共享特征学习无需像NST工作那样提前准备配对数据,只需类别监督. 不同于风格降噪研究[4 ] ,风格共享特征学习无需指定主风格元素和子风格元素(即使专业设计人员也难以精准辨别),而是从迁移过程中提取风格共享特征. 除此之外,为了提高特征学习和分类模型的收敛性,本研究提出使用堆叠的钻石模型提取共享特征,原因是堆叠使用方式比其他模型融合策略表现更佳[35 ] . 在训练过程中使用共享损失和分类损失进行反向传播,整体框架如图1 所示. 通过预训练模型(VGG或ResNet)提取特征后,风格数据送入钻石模型进行主风格特征学习. 经过钻石模型提取风格特征后,通过多层感知器进行特征映射,由SiLU[36 ] 激活后进行风格类别推理. ...

Similar visual complexity analysis model based on subjective perception

1

2019

... 设计师通过经验积累学习风格概念,利用比较法辨别风格[10 ] . 研究发现,单个图像(如油画)中通常包含1种主风格和多种不确定的子风格. 本研究定义这些子风格元素为风格噪声. 风格噪声使同类别图像之间出现特征偏差,给分类模型带来挑战. 风格迁移(neural style transfer, NST)研究表明,风格越相似,迁移越容易(迭代越少)[33 -34 ] . 本研究将在同一风格类别中学习到的共享风格特征作为风格描述因子,降低风格扩散带来的干扰. 共享特征学习无需像NST工作那样提前准备配对数据,只需类别监督. 不同于风格降噪研究[4 ] ,风格共享特征学习无需指定主风格元素和子风格元素(即使专业设计人员也难以精准辨别),而是从迁移过程中提取风格共享特征. 除此之外,为了提高特征学习和分类模型的收敛性,本研究提出使用堆叠的钻石模型提取共享特征,原因是堆叠使用方式比其他模型融合策略表现更佳[35 ] . 在训练过程中使用共享损失和分类损失进行反向传播,整体框架如图1 所示. 通过预训练模型(VGG或ResNet)提取特征后,风格数据送入钻石模型进行主风格特征学习. 经过钻石模型提取风格特征后,通过多层感知器进行特征映射,由SiLU[36 ] 激活后进行风格类别推理. ...

1

... 设计师通过经验积累学习风格概念,利用比较法辨别风格[10 ] . 研究发现,单个图像(如油画)中通常包含1种主风格和多种不确定的子风格. 本研究定义这些子风格元素为风格噪声. 风格噪声使同类别图像之间出现特征偏差,给分类模型带来挑战. 风格迁移(neural style transfer, NST)研究表明,风格越相似,迁移越容易(迭代越少)[33 -34 ] . 本研究将在同一风格类别中学习到的共享风格特征作为风格描述因子,降低风格扩散带来的干扰. 共享特征学习无需像NST工作那样提前准备配对数据,只需类别监督. 不同于风格降噪研究[4 ] ,风格共享特征学习无需指定主风格元素和子风格元素(即使专业设计人员也难以精准辨别),而是从迁移过程中提取风格共享特征. 除此之外,为了提高特征学习和分类模型的收敛性,本研究提出使用堆叠的钻石模型提取共享特征,原因是堆叠使用方式比其他模型融合策略表现更佳[35 ] . 在训练过程中使用共享损失和分类损失进行反向传播,整体框架如图1 所示. 通过预训练模型(VGG或ResNet)提取特征后,风格数据送入钻石模型进行主风格特征学习. 经过钻石模型提取风格特征后,通过多层感知器进行特征映射,由SiLU[36 ] 激活后进行风格类别推理. ...

Sigmoid-weighted linear units for neural network function approximation in reinforcement learning

1

2018

... 设计师通过经验积累学习风格概念,利用比较法辨别风格[10 ] . 研究发现,单个图像(如油画)中通常包含1种主风格和多种不确定的子风格. 本研究定义这些子风格元素为风格噪声. 风格噪声使同类别图像之间出现特征偏差,给分类模型带来挑战. 风格迁移(neural style transfer, NST)研究表明,风格越相似,迁移越容易(迭代越少)[33 -34 ] . 本研究将在同一风格类别中学习到的共享风格特征作为风格描述因子,降低风格扩散带来的干扰. 共享特征学习无需像NST工作那样提前准备配对数据,只需类别监督. 不同于风格降噪研究[4 ] ,风格共享特征学习无需指定主风格元素和子风格元素(即使专业设计人员也难以精准辨别),而是从迁移过程中提取风格共享特征. 除此之外,为了提高特征学习和分类模型的收敛性,本研究提出使用堆叠的钻石模型提取共享特征,原因是堆叠使用方式比其他模型融合策略表现更佳[35 ] . 在训练过程中使用共享损失和分类损失进行反向传播,整体框架如图1 所示. 通过预训练模型(VGG或ResNet)提取特征后,风格数据送入钻石模型进行主风格特征学习. 经过钻石模型提取风格特征后,通过多层感知器进行特征映射,由SiLU[36 ] 激活后进行风格类别推理. ...

3

... 在式(5)为真时[37 ] , ...

... 为了解决风格偏差问题,许多研究采用降噪技术处理子风格差异. 堆叠自编码器[38 ] ( stacked auto-encoders, SAE)重建输入向量,利用数据自身信息无监督地降噪. Vincent等[37 ] 在SAE的基础上引入去噪自动编码器(denoising autoencoder, DAE),通过在训练阶段加入随机噪声使算法具有一定的抗噪性. Jiang等[4 ] 提出风格集中的方法,通过使用输入数据重建具有更强风格特征的图像来学习主风格特征. 在降噪模型训练中,纯净数据与噪声数据对至关重要,但高质量数据对难获得. 如图2 所示,本研究构建的钻石模型由风格迁移过程${T_{\text{f}}}$ ${T_{\text{b}}}$ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$

... 在Painting91和Pandora上开展模型消融实验,对比不同模块的分类效果. 其中E[37 ] 仅采用自动编码器进行特征提取;E-D采用基于重建的生成过程提取风格特征[4 ] ;$ {T_{\text{f}}} $ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$ 表2 所示. E提取特征无法屏蔽子风格干扰,受风格扩散现象影响,准确率较低;E-D采用基于重建的方法可以轻微改善分类效果,但仍无法抑制子风格扩散;采用循环生成方式可以有效改善该问题,如$ {T_{\text{f}}} $ ${T_{\text{f}}}$ ${T_{\text{b}}}$

Auto-association by multilayer perceptrons and singular value decomposition

1

1988

... 为了解决风格偏差问题,许多研究采用降噪技术处理子风格差异. 堆叠自编码器[38 ] ( stacked auto-encoders, SAE)重建输入向量,利用数据自身信息无监督地降噪. Vincent等[37 ] 在SAE的基础上引入去噪自动编码器(denoising autoencoder, DAE),通过在训练阶段加入随机噪声使算法具有一定的抗噪性. Jiang等[4 ] 提出风格集中的方法,通过使用输入数据重建具有更强风格特征的图像来学习主风格特征. 在降噪模型训练中,纯净数据与噪声数据对至关重要,但高质量数据对难获得. 如图2 所示,本研究构建的钻石模型由风格迁移过程${T_{\text{f}}}$ ${T_{\text{b}}}$ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$ ${T_{\text{f}}}$ ${T_{\text{b}}}$

1

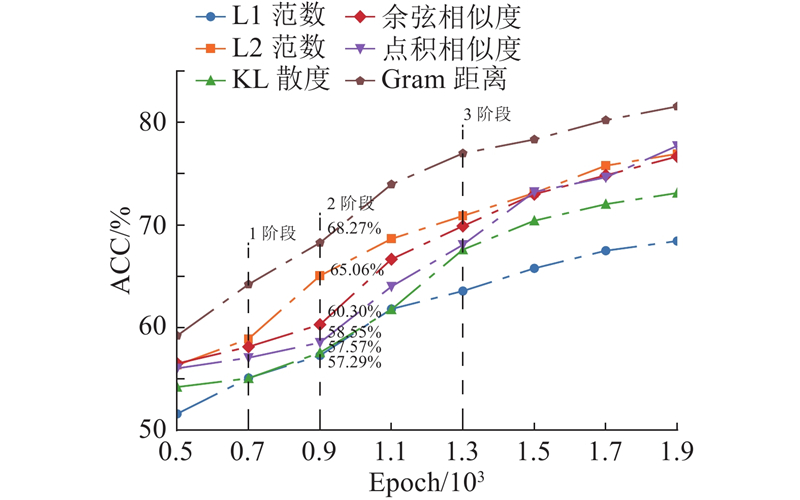

... 损失函数分成:1)共享损失$ {L_{\text{s}}} $ $ {L_{\text{c}}} $ ${L_{\text{f}}}$ ${T_{\text{f}}}$ [39 ] 的L2范数损失. 在正向迁移过程中, ${L_{\text{f}}}$ ${T_{\text{f}}}$ ${\boldsymbol{T}}$ $ {\boldsymbol{A}} $

Painting-91: a large scale database for computational painting categorization

1

2014

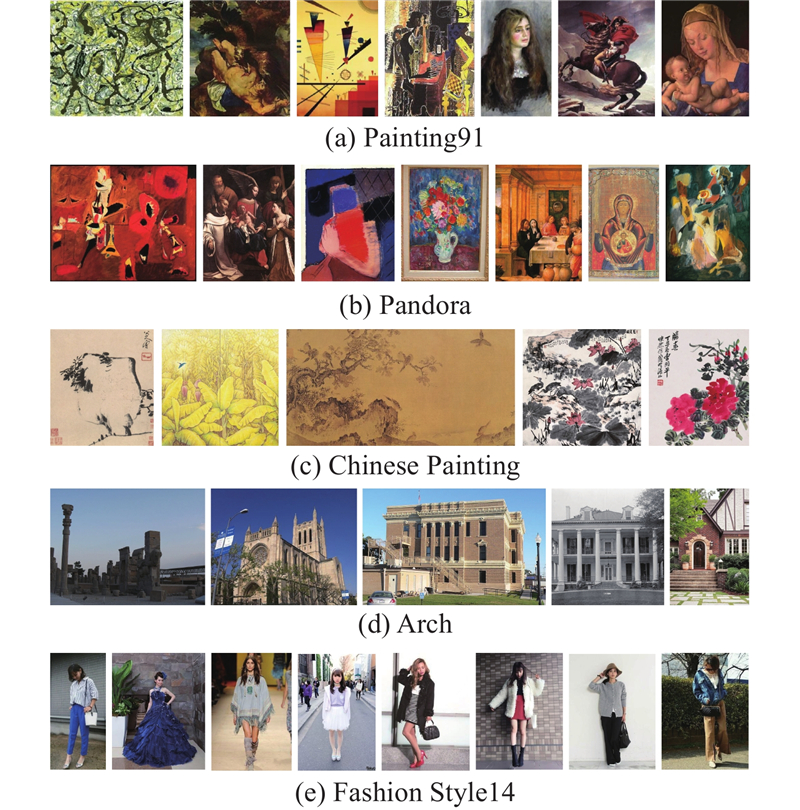

... 在主流风格数据集上进行对比实验,包括油画风格数据集Painting91[40 ] 、Pandora[41 ] ,中国画数据集[42 ] (Chinese Painting),建筑风格数据集Arch,时尚风格数据集Fashion Style14[43 ] . 数据集图片示例如图3 所示,数据统计信息如表1 所示. 1)油画风格数据集根据艺术家所属派别进行标注. Painting91包含2 338张画作,涵盖13种风格标签. Pandora是用于识别艺术运动的绘画数据集,包含7 726张画作,涵盖12种风格标签. 2)Arch包含10 113张图像,涵盖25种风格标签. 它是从Google Images和Xu等[44 ] 的原始数据集中抽取图像组成的混合数据集. 为了获得更好的图像质量,使用了多种数据增强方法. 3)Fashion Style14包含13 126张图像,涵盖14种风格标签,每种风格包含大约1 000张服装模特图像,反映了现代时尚风格的多样性和复杂性. 4)Chinese Painting是基于中国画数据集[42 ] 随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

1

... 在主流风格数据集上进行对比实验,包括油画风格数据集Painting91[40 ] 、Pandora[41 ] ,中国画数据集[42 ] (Chinese Painting),建筑风格数据集Arch,时尚风格数据集Fashion Style14[43 ] . 数据集图片示例如图3 所示,数据统计信息如表1 所示. 1)油画风格数据集根据艺术家所属派别进行标注. Painting91包含2 338张画作,涵盖13种风格标签. Pandora是用于识别艺术运动的绘画数据集,包含7 726张画作,涵盖12种风格标签. 2)Arch包含10 113张图像,涵盖25种风格标签. 它是从Google Images和Xu等[44 ] 的原始数据集中抽取图像组成的混合数据集. 为了获得更好的图像质量,使用了多种数据增强方法. 3)Fashion Style14包含13 126张图像,涵盖14种风格标签,每种风格包含大约1 000张服装模特图像,反映了现代时尚风格的多样性和复杂性. 4)Chinese Painting是基于中国画数据集[42 ] 随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

中国国画情感—美感数据库

2

2019

... 在主流风格数据集上进行对比实验,包括油画风格数据集Painting91[40 ] 、Pandora[41 ] ,中国画数据集[42 ] (Chinese Painting),建筑风格数据集Arch,时尚风格数据集Fashion Style14[43 ] . 数据集图片示例如图3 所示,数据统计信息如表1 所示. 1)油画风格数据集根据艺术家所属派别进行标注. Painting91包含2 338张画作,涵盖13种风格标签. Pandora是用于识别艺术运动的绘画数据集,包含7 726张画作,涵盖12种风格标签. 2)Arch包含10 113张图像,涵盖25种风格标签. 它是从Google Images和Xu等[44 ] 的原始数据集中抽取图像组成的混合数据集. 为了获得更好的图像质量,使用了多种数据增强方法. 3)Fashion Style14包含13 126张图像,涵盖14种风格标签,每种风格包含大约1 000张服装模特图像,反映了现代时尚风格的多样性和复杂性. 4)Chinese Painting是基于中国画数据集[42 ] 随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

... [42 ]随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

中国国画情感—美感数据库

2

2019

... 在主流风格数据集上进行对比实验,包括油画风格数据集Painting91[40 ] 、Pandora[41 ] ,中国画数据集[42 ] (Chinese Painting),建筑风格数据集Arch,时尚风格数据集Fashion Style14[43 ] . 数据集图片示例如图3 所示,数据统计信息如表1 所示. 1)油画风格数据集根据艺术家所属派别进行标注. Painting91包含2 338张画作,涵盖13种风格标签. Pandora是用于识别艺术运动的绘画数据集,包含7 726张画作,涵盖12种风格标签. 2)Arch包含10 113张图像,涵盖25种风格标签. 它是从Google Images和Xu等[44 ] 的原始数据集中抽取图像组成的混合数据集. 为了获得更好的图像质量,使用了多种数据增强方法. 3)Fashion Style14包含13 126张图像,涵盖14种风格标签,每种风格包含大约1 000张服装模特图像,反映了现代时尚风格的多样性和复杂性. 4)Chinese Painting是基于中国画数据集[42 ] 随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

... [42 ]随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

1

... 在主流风格数据集上进行对比实验,包括油画风格数据集Painting91[40 ] 、Pandora[41 ] ,中国画数据集[42 ] (Chinese Painting),建筑风格数据集Arch,时尚风格数据集Fashion Style14[43 ] . 数据集图片示例如图3 所示,数据统计信息如表1 所示. 1)油画风格数据集根据艺术家所属派别进行标注. Painting91包含2 338张画作,涵盖13种风格标签. Pandora是用于识别艺术运动的绘画数据集,包含7 726张画作,涵盖12种风格标签. 2)Arch包含10 113张图像,涵盖25种风格标签. 它是从Google Images和Xu等[44 ] 的原始数据集中抽取图像组成的混合数据集. 为了获得更好的图像质量,使用了多种数据增强方法. 3)Fashion Style14包含13 126张图像,涵盖14种风格标签,每种风格包含大约1 000张服装模特图像,反映了现代时尚风格的多样性和复杂性. 4)Chinese Painting是基于中国画数据集[42 ] 随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

1

... 在主流风格数据集上进行对比实验,包括油画风格数据集Painting91[40 ] 、Pandora[41 ] ,中国画数据集[42 ] (Chinese Painting),建筑风格数据集Arch,时尚风格数据集Fashion Style14[43 ] . 数据集图片示例如图3 所示,数据统计信息如表1 所示. 1)油画风格数据集根据艺术家所属派别进行标注. Painting91包含2 338张画作,涵盖13种风格标签. Pandora是用于识别艺术运动的绘画数据集,包含7 726张画作,涵盖12种风格标签. 2)Arch包含10 113张图像,涵盖25种风格标签. 它是从Google Images和Xu等[44 ] 的原始数据集中抽取图像组成的混合数据集. 为了获得更好的图像质量,使用了多种数据增强方法. 3)Fashion Style14包含13 126张图像,涵盖14种风格标签,每种风格包含大约1 000张服装模特图像,反映了现代时尚风格的多样性和复杂性. 4)Chinese Painting是基于中国画数据集[42 ] 随机采样扩充后的改进数据集. Chinese Painting是专门量化分析中国传统国画不同风格所引发情感的数据库. 本研究在原有数据集基础上,采用256×256的随机采样策略,每张图采样10张得到扩充数据库. 扩充后的数据集包含5 110张传统中国画,有5种风格标签,分别为气势美(1 110张)、清幽美(530张)、生机美(1 870张)、雅致美(1 030张)和萧瑟美(570张). 该数据库能够帮助研究人员理解国画的情感风格价值,为计算机视觉、风格、美学计算等领域的研究提供研究数据. 由于国画的意境和艺术表达的多样性,不同类别存在一定的风格交叉和重叠,尤其是清幽美与雅致美、生机美与气势美的区别较为微妙. ...

1

... 如表4 所示,将所提模型与3类风格分类方法进行对比. 1)预训练CNN模型:VGG16、VGG19、ResNet50[45 ] 、ResNet101和Inception-V3. 在风格分类研究领域中,主流工作仍广泛采用VGG、ResNet和Inception预训练模型[28 ] ,研究发现,粗粒度的特征更有利于后续的风格特征学习. 本研究主要采用上述模型进行粗粒度特征提取. 2)降噪分类模型:DAE[46 ] 、SCAE和SSCAE[4 ] . 3)新的风格分类算法:STSACLF[47 ] 、MCCFNet[14 ] 和DDS[17 ] . 本研究1为采用VGG16作为骨干网络结合本文方法的模型,本研究2为采用ResNet50作为骨干网络结合本文方法的模型. 第1类模型使用预训练模型提取图像特征,为了避免维度灾难,使用PCA将图像特征降为4 096维. 预训练模型效果受风格偏差影响较大,同类数据之间的偏差程度会直接影响分类的效果. 相比油画风格数据,建筑与时尚数据之间的偏差较小,由表可知,油画风格数据集的准确率明显低于建筑风格数据集和时尚风格数据集. 在第2类模型中,DAE依靠数据自身信息以无监督的方式去噪,效果较差. SCAE将风格划分成若干等级,使用输入数据重建风格更强的图像,增强了风格特征强度,分类性能获得一定提升. SSCAE采用堆叠SCAE的方式,进一步减少了风格噪声的影响,但在风格偏差较大的Pandora中效果提升不明显. 在第3类模型中,DDS利用设计特征来保持风格分类的稳定性,但无法提高准确率. MCCFNet为基于预训练模型DenseNet121的改进模型,在风格偏差较大的数据上效果明显下降. STSACLF使用风格迁移模型训练风格数据进行分类. 由于未对风格类内共享特征进行学习,在风格偏差较大的数据集中,分类准确率提升有限. 本研究使用预训练模型提取图像特征,堆叠多个钻石模型进行训练学习共享特征. 在5个数据集上均获得不同程度的性能提升(提升2~7个百分点). 实验发现,共享特征是对风格数据的主风格提取后获得的,当输入特征抽象等级较高时,将会损失部分主风格特征;当输入特征包含更多底层信息时,所提模型可以更好地提取可迁移的主风格特征,获得稳定的分类效果. ...

Stacked denoising autoencoders: learning useful representations in a deep network with a local denoising criterion

1

2010

... 如表4 所示,将所提模型与3类风格分类方法进行对比. 1)预训练CNN模型:VGG16、VGG19、ResNet50[45 ] 、ResNet101和Inception-V3. 在风格分类研究领域中,主流工作仍广泛采用VGG、ResNet和Inception预训练模型[28 ] ,研究发现,粗粒度的特征更有利于后续的风格特征学习. 本研究主要采用上述模型进行粗粒度特征提取. 2)降噪分类模型:DAE[46 ] 、SCAE和SSCAE[4 ] . 3)新的风格分类算法:STSACLF[47 ] 、MCCFNet[14 ] 和DDS[17 ] . 本研究1为采用VGG16作为骨干网络结合本文方法的模型,本研究2为采用ResNet50作为骨干网络结合本文方法的模型. 第1类模型使用预训练模型提取图像特征,为了避免维度灾难,使用PCA将图像特征降为4 096维. 预训练模型效果受风格偏差影响较大,同类数据之间的偏差程度会直接影响分类的效果. 相比油画风格数据,建筑与时尚数据之间的偏差较小,由表可知,油画风格数据集的准确率明显低于建筑风格数据集和时尚风格数据集. 在第2类模型中,DAE依靠数据自身信息以无监督的方式去噪,效果较差. SCAE将风格划分成若干等级,使用输入数据重建风格更强的图像,增强了风格特征强度,分类性能获得一定提升. SSCAE采用堆叠SCAE的方式,进一步减少了风格噪声的影响,但在风格偏差较大的Pandora中效果提升不明显. 在第3类模型中,DDS利用设计特征来保持风格分类的稳定性,但无法提高准确率. MCCFNet为基于预训练模型DenseNet121的改进模型,在风格偏差较大的数据上效果明显下降. STSACLF使用风格迁移模型训练风格数据进行分类. 由于未对风格类内共享特征进行学习,在风格偏差较大的数据集中,分类准确率提升有限. 本研究使用预训练模型提取图像特征,堆叠多个钻石模型进行训练学习共享特征. 在5个数据集上均获得不同程度的性能提升(提升2~7个百分点). 实验发现,共享特征是对风格数据的主风格提取后获得的,当输入特征抽象等级较高时,将会损失部分主风格特征;当输入特征包含更多底层信息时,所提模型可以更好地提取可迁移的主风格特征,获得稳定的分类效果. ...

1

... 如表4 所示,将所提模型与3类风格分类方法进行对比. 1)预训练CNN模型:VGG16、VGG19、ResNet50[45 ] 、ResNet101和Inception-V3. 在风格分类研究领域中,主流工作仍广泛采用VGG、ResNet和Inception预训练模型[28 ] ,研究发现,粗粒度的特征更有利于后续的风格特征学习. 本研究主要采用上述模型进行粗粒度特征提取. 2)降噪分类模型:DAE[46 ] 、SCAE和SSCAE[4 ] . 3)新的风格分类算法:STSACLF[47 ] 、MCCFNet[14 ] 和DDS[17 ] . 本研究1为采用VGG16作为骨干网络结合本文方法的模型,本研究2为采用ResNet50作为骨干网络结合本文方法的模型. 第1类模型使用预训练模型提取图像特征,为了避免维度灾难,使用PCA将图像特征降为4 096维. 预训练模型效果受风格偏差影响较大,同类数据之间的偏差程度会直接影响分类的效果. 相比油画风格数据,建筑与时尚数据之间的偏差较小,由表可知,油画风格数据集的准确率明显低于建筑风格数据集和时尚风格数据集. 在第2类模型中,DAE依靠数据自身信息以无监督的方式去噪,效果较差. SCAE将风格划分成若干等级,使用输入数据重建风格更强的图像,增强了风格特征强度,分类性能获得一定提升. SSCAE采用堆叠SCAE的方式,进一步减少了风格噪声的影响,但在风格偏差较大的Pandora中效果提升不明显. 在第3类模型中,DDS利用设计特征来保持风格分类的稳定性,但无法提高准确率. MCCFNet为基于预训练模型DenseNet121的改进模型,在风格偏差较大的数据上效果明显下降. STSACLF使用风格迁移模型训练风格数据进行分类. 由于未对风格类内共享特征进行学习,在风格偏差较大的数据集中,分类准确率提升有限. 本研究使用预训练模型提取图像特征,堆叠多个钻石模型进行训练学习共享特征. 在5个数据集上均获得不同程度的性能提升(提升2~7个百分点). 实验发现,共享特征是对风格数据的主风格提取后获得的,当输入特征抽象等级较高时,将会损失部分主风格特征;当输入特征包含更多底层信息时,所提模型可以更好地提取可迁移的主风格特征,获得稳定的分类效果. ...