[1]

吴朝晖 类脑研究: 为人类构建超级大脑

[J]. 浙江大学学报: 工学版 , 2020 , 54 (3 ): 425 - 426

[本文引用: 1]

WU Zhao-hui Cybrain: building superbrain for humans

[J]. Journal of Zhejiang University: Engineering Science , 2020 , 54 (3 ): 425 - 426

[本文引用: 1]

[2]

PANKSEPP J Neuro-psychoanalysis may enliven the mind brain sciences

[J]. Cortex , 2007 , 8 (43 ): 1106 - 1107

[本文引用: 1]

[3]

BRUN N C, MOEN A, BORCH K, et al Near-infrared monitoring of cerebral tissue oxygen saturation and blood volume in newborn piglets

[J]. American Journal of Physiology-Heart and Circulatory Physiology , 1997 , 273 (2 ): 682 - 686

DOI:10.1152/ajpheart.1997.273.2.H682

[本文引用: 1]

[4]

QIU L, ZHONG Y, XIE Q, et al. Multi-modal integration of EEG-fNIRS for characterization of brain activity evoked by preferred music [EB/OL]. [2022-01-31]. https://doi.org/10.3389/fnbot.2022.823435.

[本文引用: 1]

[5]

KOELSTRA S, MUHL C, SOLEYMANI M, et al Deap: a database for emotion analysis, using physiological signals

[J]. IEEE Transactions on Affective Computing , 2011 , 3 (1 ): 18 - 31

[本文引用: 1]

[6]

ZHENG W L, LU B L Investigating critical frequency bands and channels for EEG-based emotion recognition with deep neural networks

[J]. IEEE Transactions on Autonomous Mental Development , 2015 , 7 (3 ): 162 - 175

DOI:10.1109/TAMD.2015.2431497

[本文引用: 1]

[7]

SHEN F, DAI G, LIN G, et al EEG-based emotion recognition using 4D convolutional recurrent neural network

[J]. Cognitive Neurodynamics , 2020 , 14 (6 ): 815 - 828

DOI:10.1007/s11571-020-09634-1

[本文引用: 1]

[8]

CUI F, WANG R, DING W, et al A novel DE-CNN-BiLSTM multi-fusion model for EEG emotion recognition

[J]. Mathematics , 2022 , 10 (4 ): 582

DOI:10.3390/math10040582

[本文引用: 1]

[9]

BANDARA D, VELIPASALAR S, BRATT S, et al Building predictive models of emotion with functional near-infrared spectroscopy

[J]. International Journal of Human-Computer Studies , 2018 , 110 : 75 - 85

DOI:10.1016/j.ijhcs.2017.10.001

[本文引用: 1]

[10]

HU X, ZHUANG C, WANG F, et al fNIRS evidence for recognizably different positive emotions

[J]. Frontiers in Human Neuroscience , 2019 , 13 : 120

DOI:10.3389/fnhum.2019.00120

[本文引用: 1]

[11]

高宇航, 司娟宁, 何江弘, 等 脑电与功能近红外光谱技术在脑机接口中的应用

[J]. 北京生物医学工程 , 2022 , 41 (3 ): 318 - 325

DOI:10.3969/j.issn.1002-3208.2022.03.019

[本文引用: 1]

GAO Yu-hang, SI Juan-ning, HE Jiang-hong, et al Applications of EEG and fNIRS in brain computer interface

[J]. Beijing Biomedical Engineering , 2022 , 41 (3 ): 318 - 325

DOI:10.3969/j.issn.1002-3208.2022.03.019

[本文引用: 1]

[13]

DELIGANI R J, BORGHEAI S B, MCLINDEN J, et al Multimodal fusion of EEG-fNIRS: a mutual information-based hybrid classification framework

[J]. Biomedical Optics Express , 2021 , 12 (3 ): 1635 - 1650

DOI:10.1364/BOE.413666

[本文引用: 1]

[14]

王恩慧. 基于EEG-fNIRS的情绪识别系统研究[D]. 长春: 吉林大学, 2020: 48-50.

[本文引用: 1]

WANG En-hui. Research of emotion recognition system based on EEG-fNIRS [D]. Changchun: Jilin University, 2020: 48-50.

[本文引用: 1]

[15]

SUN Y, AYAZ H, AKANSU A N Multimodal affective state assessment using fNIRS+EEG and spontaneous facial expression

[J]. Brain Sciences , 2020 , 10 (2 ): 85 - 105

DOI:10.3390/brainsci10020085

[本文引用: 4]

[16]

吴文一. 基于EEG-fNIRS特征融合的多强度负性情绪识别研究[D]. 天津: 天津大学, 2021: 35-47.

[本文引用: 1]

WU Wen-yi. Research on multi-intensity negative emotion recognition based on EEG-fNIRS feature fusion [D]. Tianjin: Tianjin University, 2021: 35-47.

[本文引用: 1]

[17]

LI J, LI S, PAN J, et al. Cross-subject EEG emotion recognition with self-organized graph neural network [EB/OL]. [2021-06-09]. https://doi.org/10.3389/fnins.2021.611653.

[本文引用: 1]

[18]

SONG T, ZHENG W, SONG P, et al EEG emotion recognition using dynamical graph convolutional neural networks

[J]. IEEE Transactions on Affective Computing , 2018 , 11 (3 ): 532 - 541

[本文引用: 1]

[19]

KIPF T N, WELLING M. Semi-supervised classification with graph convolutional networks [EB/OL]. [2016-09-09]. http://doi.org/10.48550/arxiv.1609.02907.

[本文引用: 1]

[20]

DEFFERRARD M, BRESSON X, VANDERGHEYNST P. Convolutional neural networks on graphs with fast localized spectral filtering [EB/OL]. [2016-06-30]. https://doi.org/10.48550/arXiv.1606.09375.

[本文引用: 1]

[21]

HAMILTON W, YING Z, LESKOVEC J. Inductive representation learning on large graphs[EB/OL]. [2017-06-07]. https://doi.org/10.48550/arXiv.1706.02216.

[本文引用: 2]

[22]

VELIKOVI P , CUCURULL G , CASANOVA A , et al. Graph attention networks[EB/OL]. 2017. /arxiv. 1710.10903.

[本文引用: 1]

[23]

张静, 张雪英, 陈桂军, 等 结合3D-CNN和频-空注意力机制的EEG情感识别

[J]. 西安电子科技大学学报 , 2022 , 49 (3 ): 191 - 198

[本文引用: 1]

ZHANG Jing, ZHANG Xue-ying, CHEN Gui-jun, et al EEG emotion recognition based on the 3D-CNN and spatial-frequency attention mechanism

[J]. Journal of Xidian University , 2022 , 49 (3 ): 191 - 198

[本文引用: 1]

[24]

SONG T, ZHENG W, LU C, et al MPED: a multi-modal physiological emotion database for discrete emotion recognition

[J]. IEEE Access , 2019 , 7 : 12177 - 12191

DOI:10.1109/ACCESS.2019.2891579

[本文引用: 1]

[25]

SCHAEFER A, NILS F, SANCHEZ X, et al Assessing the effectiveness of a large database of emotion-eliciting films: a new tool for emotion researchers

[J]. Cognition and Emotion , 2010 , 24 (7 ): 1153 - 1172

DOI:10.1080/02699930903274322

[本文引用: 1]

[26]

BRADLEY M M, LANG P J Measuring emotion: the self-assessment manikin and the semantic differential

[J]. Journal of Behavior Therapy and Experimental Psychiatry , 1994 , 25 (1 ): 49 - 59

DOI:10.1016/0005-7916(94)90063-9

[本文引用: 1]

[27]

SCHOLKMANN F, KLEISER S, METZ A J, et al A review on continuous wave functional near-infrared spectroscopy and imaging instrumentation and methodology

[J]. Neuroimage , 2014 , 85 : 6 - 27

DOI:10.1016/j.neuroimage.2013.05.004

[本文引用: 1]

[28]

ZHANG G, YU M, LIU Y J, et al. SparseDGCNN: recognizing emotion from multichannel EEG signals [EB/OL]. [2021-01-13]. https://doi.org/10.1109/TAFFC.2021.3051332.

[本文引用: 1]

[29]

DUAN R N, ZHU J Y, LU B L. Differential entropy feature for EEG-based emotion classification [C]// 6th International IEEE/EMBS Conference on Neural Engineering(NER) . San Diego: IEEE, 2013: 81-84.

[本文引用: 1]

[30]

BAO G, YANG K, TONG L, et al. Linking multi-layer dynamical GCN with style-based recalibration CNN for EEG-based emotion recognition [EB/OL].[2022-02-24]. https://doi.org/10.3389/fnbot.2022.834952.

[本文引用: 1]

[31]

ACHARD S, BULLMORE E Efficiency and cost of economical brain functional networks

[J]. PLoS Computational Biology , 2007 , 3 (2 ): 174 - 183

[本文引用: 1]

[32]

LIU Z, SHEN Y, LAKSHMINARASIMHAN V B, et al. Efficient low-rank multimodal fusion with modality-specific factors [C]// Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics . Melbourne: ACL, 2018: 2247-2256.

[本文引用: 2]

[33]

LI Y, ZHENG W, WANG L, et al From regional to global brain: a novel hierarchical spatial-temporal neural network model for EEG emotion recognition

[J]. IEEE Transactions on Affective Computing , 2019 , 13 (2 ): 568 - 578

[本文引用: 2]

类脑研究: 为人类构建超级大脑

1

2020

... 情感识别在人机交互领域具有广阔的应用前景,当前基于大脑信号进行情感识别及交互的研究得到广泛关注[1 ] . 情感的产生变化和大脑皮层的神经活动[2 ] 以及血氧浓度变化具有一定关联[3 ] . 脑电(electroencephalogram, EEG)和功能近红外(functional near infrared spectroscopy, fNIRS)具有相对便携、灵活和廉价的特性,可以同时采集互不干扰,应用前景广泛[4 ] . EEG信号可以反映大脑皮层神经元的电活动,fNIRS信号反映出大脑皮层的血氧浓度变化,这2种信号反映了大脑神经活动的不同方面,两者皆可客观地表征大脑的情感认知过程. ...

类脑研究: 为人类构建超级大脑

1

2020

... 情感识别在人机交互领域具有广阔的应用前景,当前基于大脑信号进行情感识别及交互的研究得到广泛关注[1 ] . 情感的产生变化和大脑皮层的神经活动[2 ] 以及血氧浓度变化具有一定关联[3 ] . 脑电(electroencephalogram, EEG)和功能近红外(functional near infrared spectroscopy, fNIRS)具有相对便携、灵活和廉价的特性,可以同时采集互不干扰,应用前景广泛[4 ] . EEG信号可以反映大脑皮层神经元的电活动,fNIRS信号反映出大脑皮层的血氧浓度变化,这2种信号反映了大脑神经活动的不同方面,两者皆可客观地表征大脑的情感认知过程. ...

Neuro-psychoanalysis may enliven the mind brain sciences

1

2007

... 情感识别在人机交互领域具有广阔的应用前景,当前基于大脑信号进行情感识别及交互的研究得到广泛关注[1 ] . 情感的产生变化和大脑皮层的神经活动[2 ] 以及血氧浓度变化具有一定关联[3 ] . 脑电(electroencephalogram, EEG)和功能近红外(functional near infrared spectroscopy, fNIRS)具有相对便携、灵活和廉价的特性,可以同时采集互不干扰,应用前景广泛[4 ] . EEG信号可以反映大脑皮层神经元的电活动,fNIRS信号反映出大脑皮层的血氧浓度变化,这2种信号反映了大脑神经活动的不同方面,两者皆可客观地表征大脑的情感认知过程. ...

Near-infrared monitoring of cerebral tissue oxygen saturation and blood volume in newborn piglets

1

1997

... 情感识别在人机交互领域具有广阔的应用前景,当前基于大脑信号进行情感识别及交互的研究得到广泛关注[1 ] . 情感的产生变化和大脑皮层的神经活动[2 ] 以及血氧浓度变化具有一定关联[3 ] . 脑电(electroencephalogram, EEG)和功能近红外(functional near infrared spectroscopy, fNIRS)具有相对便携、灵活和廉价的特性,可以同时采集互不干扰,应用前景广泛[4 ] . EEG信号可以反映大脑皮层神经元的电活动,fNIRS信号反映出大脑皮层的血氧浓度变化,这2种信号反映了大脑神经活动的不同方面,两者皆可客观地表征大脑的情感认知过程. ...

1

... 情感识别在人机交互领域具有广阔的应用前景,当前基于大脑信号进行情感识别及交互的研究得到广泛关注[1 ] . 情感的产生变化和大脑皮层的神经活动[2 ] 以及血氧浓度变化具有一定关联[3 ] . 脑电(electroencephalogram, EEG)和功能近红外(functional near infrared spectroscopy, fNIRS)具有相对便携、灵活和廉价的特性,可以同时采集互不干扰,应用前景广泛[4 ] . EEG信号可以反映大脑皮层神经元的电活动,fNIRS信号反映出大脑皮层的血氧浓度变化,这2种信号反映了大脑神经活动的不同方面,两者皆可客观地表征大脑的情感认知过程. ...

Deap: a database for emotion analysis, using physiological signals

1

2011

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

Investigating critical frequency bands and channels for EEG-based emotion recognition with deep neural networks

1

2015

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

EEG-based emotion recognition using 4D convolutional recurrent neural network

1

2020

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

A novel DE-CNN-BiLSTM multi-fusion model for EEG emotion recognition

1

2022

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

Building predictive models of emotion with functional near-infrared spectroscopy

1

2018

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

fNIRS evidence for recognizably different positive emotions

1

2019

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

脑电与功能近红外光谱技术在脑机接口中的应用

1

2022

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

脑电与功能近红外光谱技术在脑机接口中的应用

1

2022

... 脑电情感识别领域的研究主要基于公开的DEAP[5 ] 与SEED[6 ] 情感数据库. Shen等[7 ] 提出四维卷积递归神经网络方法;Cui等[8 ] 将CNN与BiLSTM相结合,在SEED数据集上的准确率达到94.82%;fNIRS情感识别研究主要基于自建非公开数据库;Bandara等[9 ] 使用与DEAP相同的刺激材料建立fNIRS情感数据库;Hu等[10 ] 使用视频片段刺激建立了fNIRS数据库,对离散情感进行两两分类聚类,证明fNIRS可以区分细分的积极情绪. 单模态情感识别仍存在特征提取不足及识别准确率不高的问题.因此将EEG与fNIRS进行融合,挖掘二者之间的相关性和互补性[11 ] 是后期研究的重点. ...

A novel multimodal approach for hybrid brain–computer interface

10

2020

... Sun等[12 ] 提出P阶多项式方法融合EEG和fNIRS信号,对运动想象和心算的二分类识别率相比单模态有明显提升;Deligani等[13 ] 提出基于互信息的特征选择方法,将EEG和fNIRS特征进行筛选得到融合特征集,并对ALS患者与健康者进行分类;王恩慧[14 ] 使用fNIRS特征对EEG信号进行筛选,得到新特征集后进行情感分类;Sun等[15 ] 将EEG和fNIRS特征直接拼接之后使用SVM进行分类;吴文一[16 ] 使用主成分分析法对拼接的EEG和fNIRS特征矩阵进行降维.以上研究中双模态融合后分类识别率均显著提高. ...

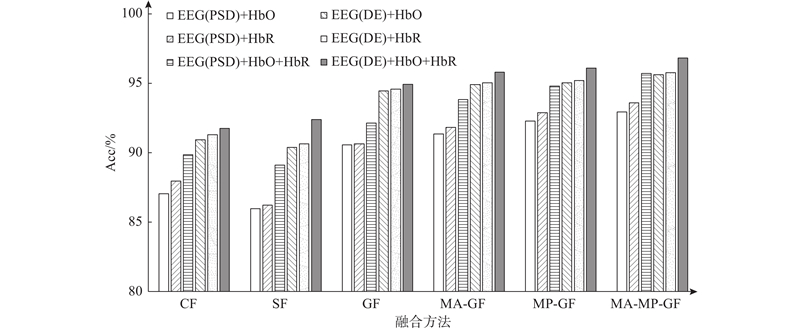

... 拼接融合(concat-fusion, CF)在文献[12 ]中被称为线性融合(linear fusion,LF). 将不同模态经过2D-CNN从池化层输出的特征向量进行直接拼接,从而实现不同模态的融合识别. 空间融合(space fusion, SF)为空间融合方法,相当于去掉图卷积层之后的模型. 它将不同模态的特征映射到同一个EEG-fNIRS空间位置排布矩阵之中,输入2D-CNN实现分类. ...

... SVM[15 ] 是将不同模态的特征矩阵进行拼接后输入SVM进行分类的特征融合方法. 张量融合(tensor fusion, TF)[12 ] 是将不同模态的特征向量进行外积得到多维矩阵后,使用可训练权重矩阵加权求和得到新融合特征向量的方法. P阶多项式融合(Pth order polynomial fusion, PF)[12 ] 将不同模态的特征向量拼接为长向量,将长向量进行复制,同时将这些长向量进行外积得到多维矩阵,最后使用可训练的权重矩阵进行加权求和得到新的融合特征向量. 低阶多模融合(low rank multimodal fusion, LMF)[32 ] 通过对每个模态设定低阶权重向量,利用各自模态的特征向量进行加权求和生成新的融合特征. 将以上3种特征向量融合方法应用于2D-CNN池化层输出的特征向量中,随后将融合后的向量输入全连接层以及softmax层进行分类. ...

... [12 ]将不同模态的特征向量拼接为长向量,将长向量进行复制,同时将这些长向量进行外积得到多维矩阵,最后使用可训练的权重矩阵进行加权求和得到新的融合特征向量. 低阶多模融合(low rank multimodal fusion, LMF)[32 ] 通过对每个模态设定低阶权重向量,利用各自模态的特征向量进行加权求和生成新的融合特征. 将以上3种特征向量融合方法应用于2D-CNN池化层输出的特征向量中,随后将融合后的向量输入全连接层以及softmax层进行分类. ...

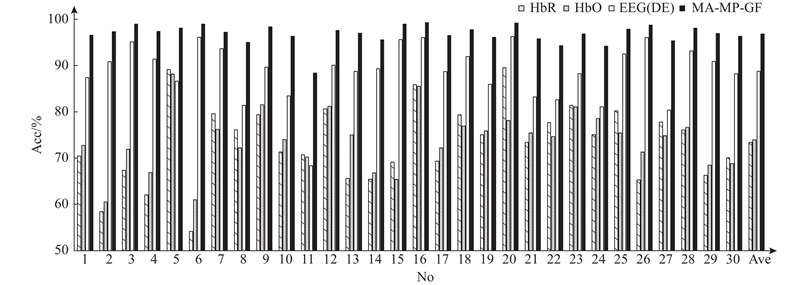

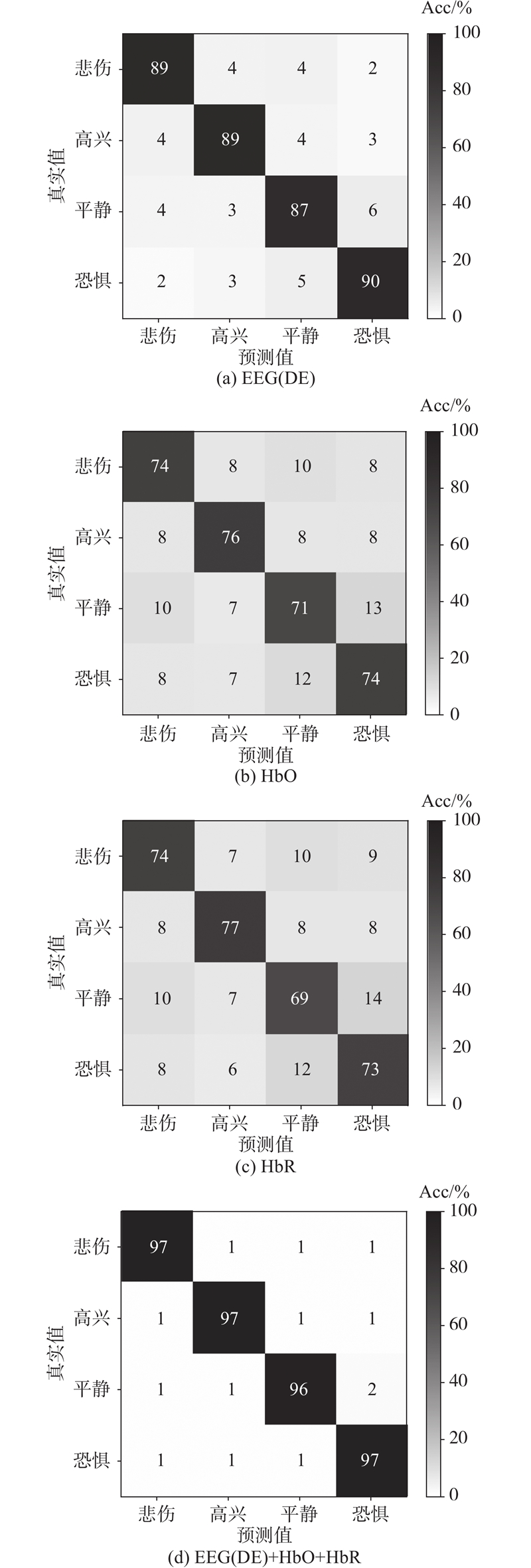

... Results of different fusion methods on EEG-fNIRS dataset

Tab.5 模型 Acc(Std)/% EEG(DE)+HbO+HbR EEG(PSD)+HbO+HbR SVM[15 ] [12 ] [12 ] 90.36(5.97) 81.47(13.29) TF[12 ] 92.91(3.22) 90.58(3.91) LMF[32 ] 94.07(3.84) 90.69(4.53) GF(本研究) 94.93(3.12) 92.15(3.99) MA-GF(本研究) 95.81(2.78) 93.83(3.34) MP-GF(本研究) 96.11(2.50) 94.80(2.44) MA-MP-GF(本研究) 96.83(2.13) 95.71(2.14)

为了全面验证模型的效果,本研究进行跨受试者的实验,采用留一折验证,即29名被试的数据作为训练集,1名被试的数据作为测试集,特征组合采用效果更好的EEG(DE)+HbO+HbR,结果如表6 所示. 可以看出,在跨受试者的实验中,本研究所提的4种图卷积融合方法的识别准确率均要强于其他论文方法的,且添加模态注意力机制能够提升图卷积融合的跨被试识别率. 由于跨受试者实验中训练与测试数据分布差异较大,结果要低于被试依赖的实验. 目前主流的跨受试者情感识别方法均涉及迁移学习,将在以后的研究中加以应用. ...

... [

12 ]

90.36(5.97) 81.47(13.29) TF[12 ] 92.91(3.22) 90.58(3.91) LMF[32 ] 94.07(3.84) 90.69(4.53) GF(本研究) 94.93(3.12) 92.15(3.99) MA-GF(本研究) 95.81(2.78) 93.83(3.34) MP-GF(本研究) 96.11(2.50) 94.80(2.44) MA-MP-GF(本研究) 96.83(2.13) 95.71(2.14) 为了全面验证模型的效果,本研究进行跨受试者的实验,采用留一折验证,即29名被试的数据作为训练集,1名被试的数据作为测试集,特征组合采用效果更好的EEG(DE)+HbO+HbR,结果如表6 所示. 可以看出,在跨受试者的实验中,本研究所提的4种图卷积融合方法的识别准确率均要强于其他论文方法的,且添加模态注意力机制能够提升图卷积融合的跨被试识别率. 由于跨受试者实验中训练与测试数据分布差异较大,结果要低于被试依赖的实验. 目前主流的跨受试者情感识别方法均涉及迁移学习,将在以后的研究中加以应用. ...

... [

12 ]

92.91(3.22) 90.58(3.91) LMF[32 ] 94.07(3.84) 90.69(4.53) GF(本研究) 94.93(3.12) 92.15(3.99) MA-GF(本研究) 95.81(2.78) 93.83(3.34) MP-GF(本研究) 96.11(2.50) 94.80(2.44) MA-MP-GF(本研究) 96.83(2.13) 95.71(2.14) 为了全面验证模型的效果,本研究进行跨受试者的实验,采用留一折验证,即29名被试的数据作为训练集,1名被试的数据作为测试集,特征组合采用效果更好的EEG(DE)+HbO+HbR,结果如表6 所示. 可以看出,在跨受试者的实验中,本研究所提的4种图卷积融合方法的识别准确率均要强于其他论文方法的,且添加模态注意力机制能够提升图卷积融合的跨被试识别率. 由于跨受试者实验中训练与测试数据分布差异较大,结果要低于被试依赖的实验. 目前主流的跨受试者情感识别方法均涉及迁移学习,将在以后的研究中加以应用. ...

... Cross-subject results of different fusion methods on EEG-fNIRS data set

Tab.6 模型 Acc(Std)/% SVM[15 ] [12 ] [12 ] 48.08(11.47) TF[12 ] 51.03(10.45 ) LMF[33 ] 52.52(11.41) GF(本研究) 53.82(13.02) MA-GF(本研究) 54.41(12.73) MP-GF(本研究) 53.86(13.56) MA-MP-GF(本研究) 54.44 (13.12)

3. 结 语 本研究提出基于模态注意力多路图卷积(MA-MP-GF)的EEG和fNIRS融合情感识别方法. 与单模态相比,图卷积融合MP-MA-GF对情感识别准确率的提升明显;所提模态注意力机制对于情感识别率也有一定提升效果;与其他对比方法以及其他论文的多模态融合方法相比,本研究的图卷积融合方法具有更高的准确率和更好的稳定性. ...

... [

12 ]

48.08(11.47) TF[12 ] 51.03(10.45 ) LMF[33 ] 52.52(11.41) GF(本研究) 53.82(13.02) MA-GF(本研究) 54.41(12.73) MP-GF(本研究) 53.86(13.56) MA-MP-GF(本研究) 54.44 (13.12) 3. 结 语 本研究提出基于模态注意力多路图卷积(MA-MP-GF)的EEG和fNIRS融合情感识别方法. 与单模态相比,图卷积融合MP-MA-GF对情感识别准确率的提升明显;所提模态注意力机制对于情感识别率也有一定提升效果;与其他对比方法以及其他论文的多模态融合方法相比,本研究的图卷积融合方法具有更高的准确率和更好的稳定性. ...

... [

12 ]

51.03(10.45 ) LMF[33 ] 52.52(11.41) GF(本研究) 53.82(13.02) MA-GF(本研究) 54.41(12.73) MP-GF(本研究) 53.86(13.56) MA-MP-GF(本研究) 54.44 (13.12) 3. 结 语 本研究提出基于模态注意力多路图卷积(MA-MP-GF)的EEG和fNIRS融合情感识别方法. 与单模态相比,图卷积融合MP-MA-GF对情感识别准确率的提升明显;所提模态注意力机制对于情感识别率也有一定提升效果;与其他对比方法以及其他论文的多模态融合方法相比,本研究的图卷积融合方法具有更高的准确率和更好的稳定性. ...

Multimodal fusion of EEG-fNIRS: a mutual information-based hybrid classification framework

1

2021

... Sun等[12 ] 提出P阶多项式方法融合EEG和fNIRS信号,对运动想象和心算的二分类识别率相比单模态有明显提升;Deligani等[13 ] 提出基于互信息的特征选择方法,将EEG和fNIRS特征进行筛选得到融合特征集,并对ALS患者与健康者进行分类;王恩慧[14 ] 使用fNIRS特征对EEG信号进行筛选,得到新特征集后进行情感分类;Sun等[15 ] 将EEG和fNIRS特征直接拼接之后使用SVM进行分类;吴文一[16 ] 使用主成分分析法对拼接的EEG和fNIRS特征矩阵进行降维.以上研究中双模态融合后分类识别率均显著提高. ...

1

... Sun等[12 ] 提出P阶多项式方法融合EEG和fNIRS信号,对运动想象和心算的二分类识别率相比单模态有明显提升;Deligani等[13 ] 提出基于互信息的特征选择方法,将EEG和fNIRS特征进行筛选得到融合特征集,并对ALS患者与健康者进行分类;王恩慧[14 ] 使用fNIRS特征对EEG信号进行筛选,得到新特征集后进行情感分类;Sun等[15 ] 将EEG和fNIRS特征直接拼接之后使用SVM进行分类;吴文一[16 ] 使用主成分分析法对拼接的EEG和fNIRS特征矩阵进行降维.以上研究中双模态融合后分类识别率均显著提高. ...

1

... Sun等[12 ] 提出P阶多项式方法融合EEG和fNIRS信号,对运动想象和心算的二分类识别率相比单模态有明显提升;Deligani等[13 ] 提出基于互信息的特征选择方法,将EEG和fNIRS特征进行筛选得到融合特征集,并对ALS患者与健康者进行分类;王恩慧[14 ] 使用fNIRS特征对EEG信号进行筛选,得到新特征集后进行情感分类;Sun等[15 ] 将EEG和fNIRS特征直接拼接之后使用SVM进行分类;吴文一[16 ] 使用主成分分析法对拼接的EEG和fNIRS特征矩阵进行降维.以上研究中双模态融合后分类识别率均显著提高. ...

Multimodal affective state assessment using fNIRS+EEG and spontaneous facial expression

4

2020

... Sun等[12 ] 提出P阶多项式方法融合EEG和fNIRS信号,对运动想象和心算的二分类识别率相比单模态有明显提升;Deligani等[13 ] 提出基于互信息的特征选择方法,将EEG和fNIRS特征进行筛选得到融合特征集,并对ALS患者与健康者进行分类;王恩慧[14 ] 使用fNIRS特征对EEG信号进行筛选,得到新特征集后进行情感分类;Sun等[15 ] 将EEG和fNIRS特征直接拼接之后使用SVM进行分类;吴文一[16 ] 使用主成分分析法对拼接的EEG和fNIRS特征矩阵进行降维.以上研究中双模态融合后分类识别率均显著提高. ...

... SVM[15 ] 是将不同模态的特征矩阵进行拼接后输入SVM进行分类的特征融合方法. 张量融合(tensor fusion, TF)[12 ] 是将不同模态的特征向量进行外积得到多维矩阵后,使用可训练权重矩阵加权求和得到新融合特征向量的方法. P阶多项式融合(Pth order polynomial fusion, PF)[12 ] 将不同模态的特征向量拼接为长向量,将长向量进行复制,同时将这些长向量进行外积得到多维矩阵,最后使用可训练的权重矩阵进行加权求和得到新的融合特征向量. 低阶多模融合(low rank multimodal fusion, LMF)[32 ] 通过对每个模态设定低阶权重向量,利用各自模态的特征向量进行加权求和生成新的融合特征. 将以上3种特征向量融合方法应用于2D-CNN池化层输出的特征向量中,随后将融合后的向量输入全连接层以及softmax层进行分类. ...

... Results of different fusion methods on EEG-fNIRS dataset

Tab.5 模型 Acc(Std)/% EEG(DE)+HbO+HbR EEG(PSD)+HbO+HbR SVM[15 ] [12 ] [12 ] 90.36(5.97) 81.47(13.29) TF[12 ] 92.91(3.22) 90.58(3.91) LMF[32 ] 94.07(3.84) 90.69(4.53) GF(本研究) 94.93(3.12) 92.15(3.99) MA-GF(本研究) 95.81(2.78) 93.83(3.34) MP-GF(本研究) 96.11(2.50) 94.80(2.44) MA-MP-GF(本研究) 96.83(2.13) 95.71(2.14)

为了全面验证模型的效果,本研究进行跨受试者的实验,采用留一折验证,即29名被试的数据作为训练集,1名被试的数据作为测试集,特征组合采用效果更好的EEG(DE)+HbO+HbR,结果如表6 所示. 可以看出,在跨受试者的实验中,本研究所提的4种图卷积融合方法的识别准确率均要强于其他论文方法的,且添加模态注意力机制能够提升图卷积融合的跨被试识别率. 由于跨受试者实验中训练与测试数据分布差异较大,结果要低于被试依赖的实验. 目前主流的跨受试者情感识别方法均涉及迁移学习,将在以后的研究中加以应用. ...

... Cross-subject results of different fusion methods on EEG-fNIRS data set

Tab.6 模型 Acc(Std)/% SVM[15 ] [12 ] [12 ] 48.08(11.47) TF[12 ] 51.03(10.45 ) LMF[33 ] 52.52(11.41) GF(本研究) 53.82(13.02) MA-GF(本研究) 54.41(12.73) MP-GF(本研究) 53.86(13.56) MA-MP-GF(本研究) 54.44 (13.12)

3. 结 语 本研究提出基于模态注意力多路图卷积(MA-MP-GF)的EEG和fNIRS融合情感识别方法. 与单模态相比,图卷积融合MP-MA-GF对情感识别准确率的提升明显;所提模态注意力机制对于情感识别率也有一定提升效果;与其他对比方法以及其他论文的多模态融合方法相比,本研究的图卷积融合方法具有更高的准确率和更好的稳定性. ...

1

... Sun等[12 ] 提出P阶多项式方法融合EEG和fNIRS信号,对运动想象和心算的二分类识别率相比单模态有明显提升;Deligani等[13 ] 提出基于互信息的特征选择方法,将EEG和fNIRS特征进行筛选得到融合特征集,并对ALS患者与健康者进行分类;王恩慧[14 ] 使用fNIRS特征对EEG信号进行筛选,得到新特征集后进行情感分类;Sun等[15 ] 将EEG和fNIRS特征直接拼接之后使用SVM进行分类;吴文一[16 ] 使用主成分分析法对拼接的EEG和fNIRS特征矩阵进行降维.以上研究中双模态融合后分类识别率均显著提高. ...

1

... Sun等[12 ] 提出P阶多项式方法融合EEG和fNIRS信号,对运动想象和心算的二分类识别率相比单模态有明显提升;Deligani等[13 ] 提出基于互信息的特征选择方法,将EEG和fNIRS特征进行筛选得到融合特征集,并对ALS患者与健康者进行分类;王恩慧[14 ] 使用fNIRS特征对EEG信号进行筛选,得到新特征集后进行情感分类;Sun等[15 ] 将EEG和fNIRS特征直接拼接之后使用SVM进行分类;吴文一[16 ] 使用主成分分析法对拼接的EEG和fNIRS特征矩阵进行降维.以上研究中双模态融合后分类识别率均显著提高. ...

1

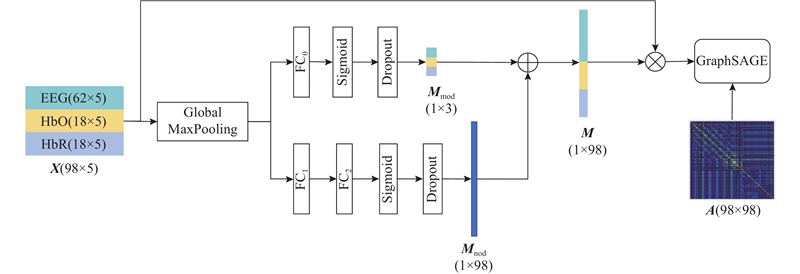

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

EEG emotion recognition using dynamical graph convolutional neural networks

1

2018

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

1

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

1

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

2

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

... GraphSAGE[21 ] 图卷积是一种空间域图卷积,其算法的核心在于对邻居节点的采样与聚合. ...

1

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

结合3D-CNN和频-空注意力机制的EEG情感识别

1

2022

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

结合3D-CNN和频-空注意力机制的EEG情感识别

1

2022

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

MPED: a multi-modal physiological emotion database for discrete emotion recognition

1

2019

... EEG和fNIRS是多通道信号,若将各通道作为节点,各通道特征作为节点特征,相关通道之间的关系看作边,则EEG与fNIRS实质上是图结构数据. 图卷积神经网络(graph convolutional neural networks, GCN)是一类专门处理图结构数据的神经网络. Li等[17 ] 提出自组织图卷积模型,根据不同卷积层自动提取出脑电特征生成脑电连接图,实现情感分类. Song等[18 ] 提出动态图卷积情感识别模型,图的结构可以进行动态变化,使得图卷积层可以更好地提取EEG电极之间的连接信息. 以上研究表明,图卷积神经网络能够有效地提取EEG信号各通道间连接信息. 图卷积神经网络可以分为频谱域图卷积(如GCN[19 ] 、ChebNet[20 ] )以及空间域图卷积(如GraphSAGE[21 ] 、GAT[22 ] ). 频域图卷积是从频域出发,参考传统的信号处理方法,引入滤波器来定义图卷积. 空间域图卷积对每个节点的邻居节点进行某种方式的加权求和,得到新的节点特征. 注意力机制通过对信号特征中与情感显著相关的信息分配较大的权重,来提高情感识别性能. 张静等[23 ] 提出频-空注意力机制,综合脑电信号在时间、空间和频率3个维度的信息,提高情感识别的准确率. Song等[24 ] 提出注意力LSTM,将注意力系数分别加在LSTM的不同结构上,对3种生理信号分别进行特征提取,最终拼接实现多模态融合. 本研究将模态注意力机制加入图卷积融合方法中,来学习不同模态不同通道信号的权重. ...

Assessing the effectiveness of a large database of emotion-eliciting films: a new tool for emotion researchers

1

2010

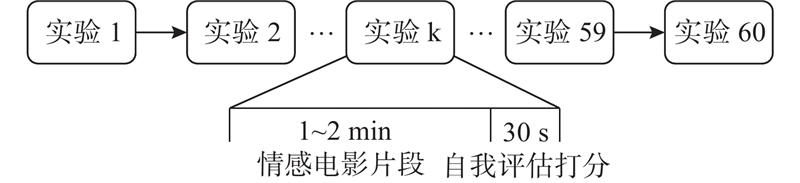

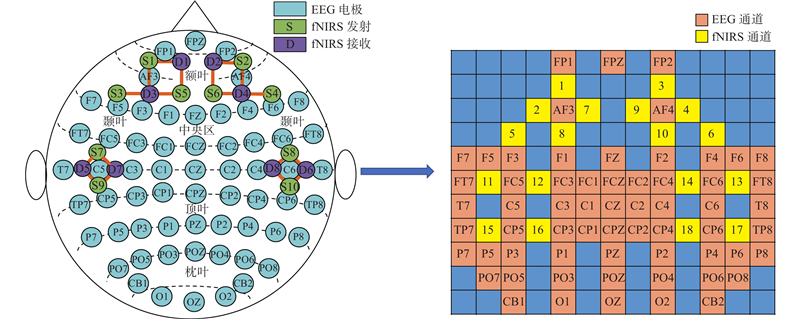

... Schaefer等[25 ] 研究了电影片段在诱发情绪方面的可靠性和效率,表明带有情感的电影片段可以使受试者产生代入感,并引发情感共鸣,是良好的情感激发材料. 本研究初步选取包含悲伤、高兴、中性和恐惧这4种情感的80个电影片段,每种情感有20个电影片段. 通过观看者填写SAM问卷的方式[26 ] ,在愉悦度(pleasure, P)、激活度(arousal, A)和支配度(dominance, D)3个维度对每个视频片段进行打分,选择每种情感下与目标情感得分距离最小的前15个视频,经过筛选最终得到60个视频. 共有30名被试(15男,15女,平均年龄24.1±1.5岁,视听力均正常,均为右利手)参与实验数据录制. 参与录制前每位受试者均填写了个人基本信息以及知情同意书. 受试者被要求头上佩戴脑电-功能近红外测量帽,坐姿调整到舒适的位置,认真观看即将开始的电影片段,并尽可能避免明显的动作. ...

Measuring emotion: the self-assessment manikin and the semantic differential

1

1994

... Schaefer等[25 ] 研究了电影片段在诱发情绪方面的可靠性和效率,表明带有情感的电影片段可以使受试者产生代入感,并引发情感共鸣,是良好的情感激发材料. 本研究初步选取包含悲伤、高兴、中性和恐惧这4种情感的80个电影片段,每种情感有20个电影片段. 通过观看者填写SAM问卷的方式[26 ] ,在愉悦度(pleasure, P)、激活度(arousal, A)和支配度(dominance, D)3个维度对每个视频片段进行打分,选择每种情感下与目标情感得分距离最小的前15个视频,经过筛选最终得到60个视频. 共有30名被试(15男,15女,平均年龄24.1±1.5岁,视听力均正常,均为右利手)参与实验数据录制. 参与录制前每位受试者均填写了个人基本信息以及知情同意书. 受试者被要求头上佩戴脑电-功能近红外测量帽,坐姿调整到舒适的位置,认真观看即将开始的电影片段,并尽可能避免明显的动作. ...

A review on continuous wave functional near-infrared spectroscopy and imaging instrumentation and methodology

1

2014

... 对于采集的脑电信号和功能近红外信号,需要预处理后才能进行下一步的特征提取. 对于脑电信号要进行信号重参考、去基线以及0.1~50.0 Hz滤波处理,再使用独立成分分析(independent component analysis, ICA)去除脑电信号中的伪迹,并将信号降采样至200 Hz. 将脑电信号划分为5个频段:δ (1~4 Hz),θ (4~8 Hz),α (8~14 Hz),β (14~30 Hz),γ (30~50 Hz),随后对每个频段的脑电信号提取特征. 对于采集的fNIRS原始光密度信号进行基线校正以及0.01~0.20 Hz带通滤波,通过修正的Beer-Lambert定律[27 ] 计算得到氧合血红蛋白(HbO)以及脱氧血红蛋白(HbR)浓度变化. ...

1

... 分别计算每个频段的特征. 功率谱密度(power spectral density, PSD)[28 ] 表示脑电信号在不同频段的平均能量: ...

1

... 使用快速傅里叶变换(fast fourier transform, FFT)计算信号的离散傅里叶变换(discrete fourier transform, DFT),使用200个采样点的窗估计得到每个频段的功率谱密度. 微分熵(differential entropy, DE)[29 ] 是脑电信号的一种非线性特征,是香农信息熵在连续变量上的推广形式,即 ...

1

... 图结构数据的特征矩阵X $ {\boldsymbol{A}} $ [30 ] 将皮尔逊相关系数作为图卷积网络的邻接矩阵,在EEG情感识别中取得较好效果. ...

Efficiency and cost of economical brain functional networks

1

2007

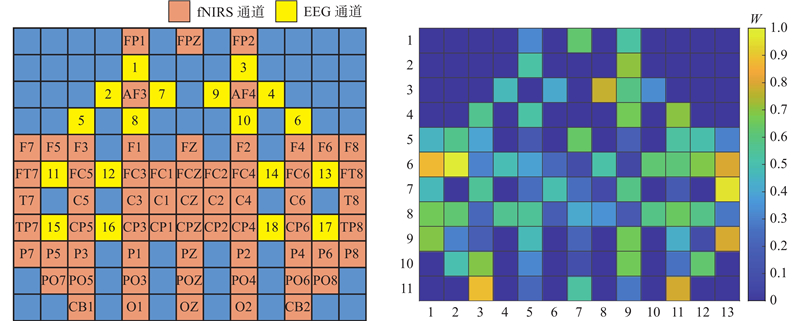

... 由于EEG和fNIRS是2种不同采样率的信号,对EEG原始信号进行平均降采样至11 Hz,使之与fNIRS信号的采样率一致;利用皮尔逊相关系数计算每1 s信号两两通道之间的相关性,并构建EEG-fNIRS通道邻接矩阵. Achard等[31 ] 指出在稀疏的fMRI脑网络中,当实际连接数等于全部可能连接数的20%时,通常会最大限度地提高网络拓扑的效率;当选择保留EEG-fNIRS邻接矩阵全部连接的20%时,由于直接选取全局最相关的20%连接,连接可能会聚集于某个区域,同样重要但相关系数稍微较弱的区域可能被忽略. 整个邻接矩阵分为EEG-EEG、fNIRS-fNIRS以及EEG-fNIRS子矩阵,分别在每个子矩阵中选取相关系数最大的前20%连接进行保留,最终得到图数据特征矩阵X A

2

... SVM[15 ] 是将不同模态的特征矩阵进行拼接后输入SVM进行分类的特征融合方法. 张量融合(tensor fusion, TF)[12 ] 是将不同模态的特征向量进行外积得到多维矩阵后,使用可训练权重矩阵加权求和得到新融合特征向量的方法. P阶多项式融合(Pth order polynomial fusion, PF)[12 ] 将不同模态的特征向量拼接为长向量,将长向量进行复制,同时将这些长向量进行外积得到多维矩阵,最后使用可训练的权重矩阵进行加权求和得到新的融合特征向量. 低阶多模融合(low rank multimodal fusion, LMF)[32 ] 通过对每个模态设定低阶权重向量,利用各自模态的特征向量进行加权求和生成新的融合特征. 将以上3种特征向量融合方法应用于2D-CNN池化层输出的特征向量中,随后将融合后的向量输入全连接层以及softmax层进行分类. ...

... Results of different fusion methods on EEG-fNIRS dataset

Tab.5 模型 Acc(Std)/% EEG(DE)+HbO+HbR EEG(PSD)+HbO+HbR SVM[15 ] [12 ] [12 ] 90.36(5.97) 81.47(13.29) TF[12 ] 92.91(3.22) 90.58(3.91) LMF[32 ] 94.07(3.84) 90.69(4.53) GF(本研究) 94.93(3.12) 92.15(3.99) MA-GF(本研究) 95.81(2.78) 93.83(3.34) MP-GF(本研究) 96.11(2.50) 94.80(2.44) MA-MP-GF(本研究) 96.83(2.13) 95.71(2.14)

为了全面验证模型的效果,本研究进行跨受试者的实验,采用留一折验证,即29名被试的数据作为训练集,1名被试的数据作为测试集,特征组合采用效果更好的EEG(DE)+HbO+HbR,结果如表6 所示. 可以看出,在跨受试者的实验中,本研究所提的4种图卷积融合方法的识别准确率均要强于其他论文方法的,且添加模态注意力机制能够提升图卷积融合的跨被试识别率. 由于跨受试者实验中训练与测试数据分布差异较大,结果要低于被试依赖的实验. 目前主流的跨受试者情感识别方法均涉及迁移学习,将在以后的研究中加以应用. ...

From regional to global brain: a novel hierarchical spatial-temporal neural network model for EEG emotion recognition

2

2019

... 图特征融合模块中使用了模态注意力机制,在训练过程中可赋予不同模态不同通道以不同的权重,使之能够更好地体现各通道对情感识别的贡献. 如图10 所示,以全部30名被试为例,绘制了各通道的平均注意力权重图. 通道位置与图6 中的EEG-fNIRS空间位置映射矩阵的相对应. 可以看出,不同通道被赋予不同的权重. 在情感识别中,额叶和颞叶的EEG与fNIRS通道发挥了较大的作用,而顶叶和枕叶的通道作用较小. 其中右额叶的权重高于左额叶的,右颞叶的要略高于左颞叶的. Li等[33 ] 的结论中也反映出额叶和颞叶区域在EEG情绪识别中很重要. 模态注意力机制的消融实验使用效果最好的EEG(DE)+HbO+HbR特征组合,结果如表4 中,MA1 为只保留节点权重的注意力机制,MA2 为只保留模态权重的注意力机制,MA3 为去掉了dropout保留模态和节点权重支路的注意力机制. 在2种图卷积融合模型上,所提出的模态注意力机制的结果均为最优. ...

... Cross-subject results of different fusion methods on EEG-fNIRS data set

Tab.6 模型 Acc(Std)/% SVM[15 ] [12 ] [12 ] 48.08(11.47) TF[12 ] 51.03(10.45 ) LMF[33 ] 52.52(11.41) GF(本研究) 53.82(13.02) MA-GF(本研究) 54.41(12.73) MP-GF(本研究) 53.86(13.56) MA-MP-GF(本研究) 54.44 (13.12)

3. 结 语 本研究提出基于模态注意力多路图卷积(MA-MP-GF)的EEG和fNIRS融合情感识别方法. 与单模态相比,图卷积融合MP-MA-GF对情感识别准确率的提升明显;所提模态注意力机制对于情感识别率也有一定提升效果;与其他对比方法以及其他论文的多模态融合方法相比,本研究的图卷积融合方法具有更高的准确率和更好的稳定性. ...