人体血细胞分类检测[1]是临床检验中一项重要的检测,通过对人体外周血中红细胞及5种白细胞的检测与计数可以为疾病诊断提供重要帮助. 传统的血细胞图像检测和分类主要依靠人工镜检,此方法不仅效率低,且需要经验丰富的形态学专业人员才能完成. 近年来,基于深度学习的目标检测方法在医学领域图像处理方面应用广泛。深度学习的应用依赖于大规模带标签数据集的支撑,血细胞中白细胞样本稀有性及收集、标定过程的复杂性,限制了深度学习方法在细胞图像分类检测方面的应用. 因此,研究高质量细胞图像的生成方法扩充细胞检测网络的训练集对提升血细胞分类检测精度尤为重要.

目前,基于深度学习的目标检测方法主要分为2类. 1)基于候选框目标检测的方法,如Faster RCNN[2]、SSD[3]、YOLOV1-V3[4-6]等. 该类方法适用于大目标检测,对于血细胞图像中小目标在粘连情况下的检测精度较差. 徐晓涛等[7]采用YOLO候选框对细胞进行分类检测,刘树杰[8]采用Faster RCNN候选框对红细胞进行检测。这些检测均在红细胞黏附遮挡情况下进行,精度较低. 2)基于密度图的目标检测方法,如FCRN[9]、SDBN[10]。该类方法将小目标回归到独立的高斯核上,对于小目标在场景复杂情况下的检测效果较好. 这2类方法普遍存在细胞样本较少,收集和标定工作困难,导致精度不能满足实际检测需求的情况.

随着生成对抗网络(generative adversarial network,GAN)[11]的出现,大规模带标签数据集缺乏的问题得以解决. 同时原始GAN通过输入随机噪声生成的图像不带标签信息,无法解决医学细胞图像难以注释的问题. Cui等[12]提出基于条件生成对抗网络(conditional generative adversarial network,CGAN),通过同时输入噪声和条件信息生成结果可控的图像. Isola等[13]提出pix2pix(image-to-image translation with conditional adversarial networks)的条件生成对抗网络模型,该模型利用场景的分割掩膜,实现图像到图像的生成. 现有条件生成对抗网络中生成器输入的条件信息有限,且鉴别器结构在对生成图像进行真假鉴别时忽略了图像在不同尺度上的细节信息,导致生成的细胞图像在细节信息(如亮度、边缘清晰度)上与细胞原图相比缺乏真实感.

为了解决上述方法存在的问题,本文提出基于多尺度鉴别器的条件生成对抗网络(multi-scale conditional generative adversarial network,MCGAN)。该结构生成器采用U-Net[14]编解码结构,利用跳跃连接网络提取更深层次的图片特征,融合浅层和深层的特征,在现有条件生成对抗网络鉴别器结构中引入多尺度鉴别器(multi-scale discriminator,MD),经过多尺度卷积操作(multi-scale convolution,M-Conv)与多尺度池化模块(multi-scale pooling structure,MPS-block)提取真实图像和生成图像不同尺度上的细节信息进行真假辨别,提高鉴别器性能,以促进生成器生成细胞图像的细节信息,提高图像的真实感。同时在pix2pix生成器的损失函数中引入梯度相似性损失项,通过最小化原图与生成图像在亮度、对比度及梯度结构上的差距,提高生成细胞图像的亮度及边缘清晰度. 在条件生成对抗网络后加入检测器,其结构与生成器结构一致,将生成的细胞图像用于目标分类检测网络的训练阶段,增加细胞样本多样性,以此扩充训练集.

1. 相关工作

GAN是无监督的深度学习模型,由生成器G(generator)和鉴别器D(discriminator)2个网络构成. GAN的大概流程:G以噪声z作为输入,生成图像G(z),然后将真实图像x与G(z)一起输入D,D对x和G(z)做二分类,检测图像的真假,D的输出为0或1,0代表假图像,1代表真图像. 鉴别器的目标是尽可能区分真假样本,生成器的目标是生成让鉴别器无法区分的假样本,二者相互博弈,生成对抗网络的对抗目标函数为

式中:z为随机噪声,x为真实图像,Pdata为真实数据分布,Pz为均匀噪声分布,G(z)为生成的图像,D(x)为鉴别器对真实图像的鉴别,D(G(z))为鉴别器对生成图像的鉴别,E为期望值.

pix2pix在原始GAN的基础上,将噪声替换为条件信息y输入生成器,实现图像到图像翻译的过程. 该过程是输入带图像位置掩膜的二元极小极大值的博弈问题,pix2pix生成器G和鉴别器D中都加入条件变量指导数据的生成. pix2pix网络的目标函数为

其中

式中:

2. 基于MCGAN的血细胞检测方法

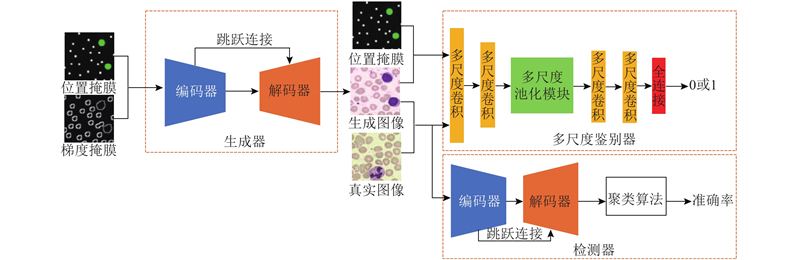

MCGAN整体结构如图1所示. 该网络包括细胞图像生成器、MD、细胞分类检测器. 细胞图像生成器输入细胞的位置掩膜和梯度掩膜,输出生成的细胞图有2种形式:1)以随机数为圆心坐标,指定半径与颜色,随机生成的细胞位置与梯度掩膜;2)细胞原图中提取的位置与梯度掩膜. MD输入细胞原图与生成细胞图、位置掩膜与生成细胞图像二元组,首先经过多尺度卷积操作与多尺度池化模块得到全局多尺度特征,最后经过全连接层,激活函数用Sigmoid函数,输出鉴别结果0或1,以此实现对生成细胞图像的真假鉴别与位置匹配鉴别;检测器输入生成的细胞图像和真实细胞图像,输出检测彩色密度图后再经过聚类算法得到每类细胞的准确率,以此实现对细胞图像的分类检测.

图 1

2.1. MCGAN目标函数

为了提高生成细胞图像的亮度及边缘清晰度,在pix2pix目标函数的基础上引入梯度相似性损失函数

式中:

式中:

式中:N为图像中像素个数,H为像素块的中间像素值. 在细胞检测阶段,采用交叉熵损失函数为

式中:W为最小训练批次;K为类别的数量;

综上,MCGAN网络的目标函数为:

式中:

2.2. MCGAN生成器结构

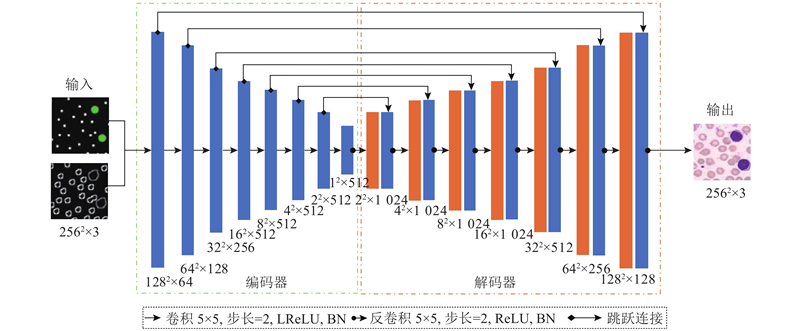

MCGAN生成器结构如图2中所示。

图 2

由图2可知,生成器由编码器和解码器组成,生成器首先输入细胞位置掩膜和梯度掩膜,经过8层卷积和8层反卷积,其中卷积层激活函数采用带泄露的整流函数(leaky rectified linear units,LReLU),梯度设置为0.2,为了加速网络的收敛,在每层卷积后都使用批量归一(batch-normalization,BN);反卷积层激活函数采用线性修正单元(rectified linear units,ReLU),最后一层使用双曲正切作为激活函数生成图像,并在每次反卷积过后都使用模块提取到的特征图和与之相应成镜像关系的卷积层特征图进行跳跃连接(skip-connect),对应特征图直接叠加后传入下一层,融合深层和浅层的特征. 原始的条件GAN输入的是条件y与噪声向量z共2种信息,在本文的生成器中只使用条件信息,因此不能生成多样性的结果,在训练时,本文在生成器的前4层反卷积输出时使用随机丢弃部分参数(dropout),不仅能防止网络过拟合,还在一定程度上增加了生成样本的多样性.

2.3. MCGAN鉴别器结构

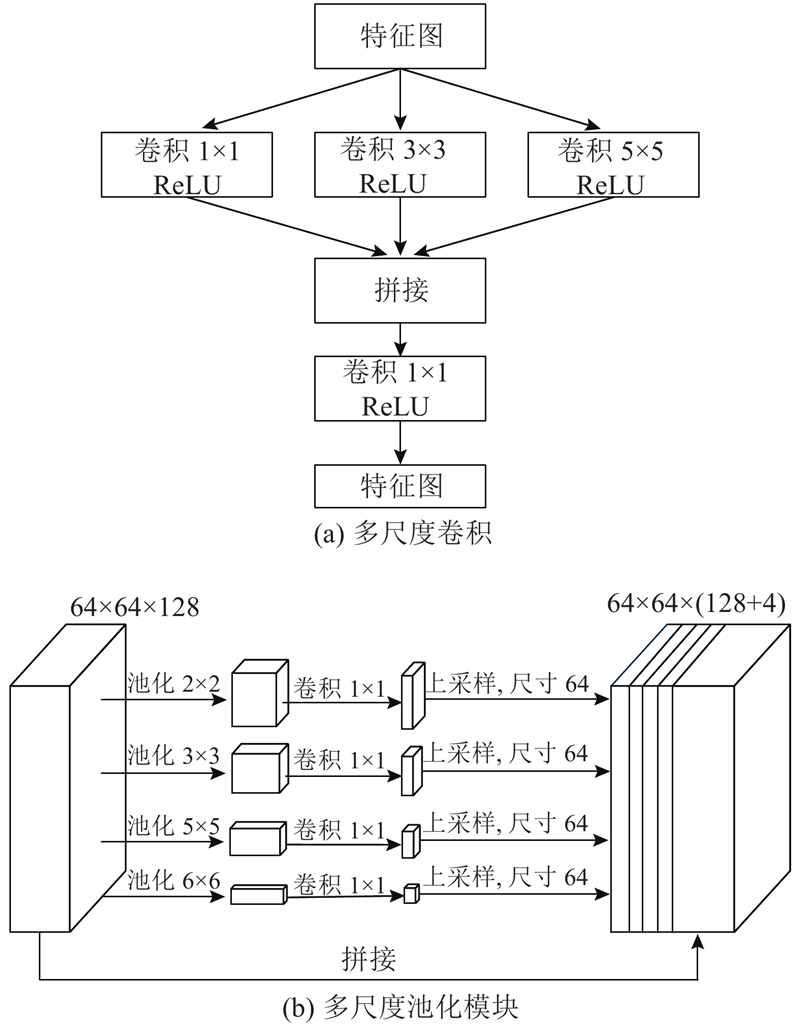

MCGAN鉴别器与原始GAN仅输入生成图像和真实图像不同,它是把掩膜图像与生成细胞图像、掩膜图像与真实细胞图像一起成对输入鉴别器中鉴别真假,以此保证生成细胞图像与输入细胞位置掩膜的信息一致. 为了提高鉴别器对生成细胞样本不同尺度上细节信息上的鉴别能力,本文对现有条件生成对抗网络鉴别器做出以下2点改进. 1)将现有条件GAN的鉴别器中卷积操作全部替换成多尺度卷积操作(M-conv),如图3(a)所示. 对输入图片分别使用1×1、3×3、5×5共3种不同尺度的卷积核提取特征,采用级联的方式拼接这些包含多尺度信息的特征图,接着输入尺寸为1×1的卷积核进行特征映射,生成新的特征图,输入下一层. 2)在鉴别器中加入多尺度池化结构模块(MPS-block),该模块如图3(b)所示. 具体操作为将前一多尺度卷积操作的特征图,分别通过4种不同核大小的池化操作;为了维护全局特性的权重,在每个池化操作后分别用1×1卷积,将对应级别的通道数量降为原本的1/N;通过双线性插值直接对低维特征图进行上采样,得到与原始特征映射相同尺寸的特征图;将不同级别的特征在倒数第一个维度上进行拼接,作为最终多尺度池化的全局特性输入到下一层.

图 3

大多数现有鉴别器在提取原图与生成图像特征进行鉴别时几乎都只使用较小或较大的感受野,并在一个维度上进行学习,但实际上,图像的结构信息往往是不同尺度的,单一尺度的特征提取不足以完全鉴别图像的高频纹理区域. 改进鉴别器的作用:通过不同尺度卷积和池化操作,融合不同尺度的特征,提高鉴别器对生成图像微观纹理和宏观几何特征的鉴别能力,促进生成器生成细节信息更逼真的细胞样本以提高细胞分类检测的精度. 鉴别器最后一层为全连接,其输出为真假二分类问题,故激活函数采用Sigmoid函数.

2.4. MCGAN分类检测器结构

全卷积神经网络(full convolutional neural network,FCNN)[15]是将卷积神经网络(convolutional neural network,CNN)[16]的全连接层全部替换为卷积层得来的,由于CNN在对图像进行分类时不能识别图片中特定部位的物体,只能得到输入图像属于某一类的概率,不能满足细胞分类检测需求. 本文将CNN中的全连接层替换为卷积层,采用反卷积层对网络最后一个卷积层提取到的特征图进行上采样,使它恢复到与输入图像相同的尺寸,实现对图像的每个像素值都产生一个预测,同时保留原始输入图像中的空间信息,在上采样的特征图上进行逐像素分类. 为了得到更精确的分类结果,在全卷积网络中每次反卷积过后都使用跳跃连接来融合图像浅层和深层的特征,具体结构同MCGAN中的生成器结构一致. 网络测试时,在细胞分类检测器的输出后面加入聚类算法,通过聚类算法得到标定图与检测图中每类细胞的个数、中心位置,比对2个图片中细胞的位置、个数得到每类细胞的准确率(每类细胞的准确率等于分类正确的每类细胞个数除以标定时每类的细胞个数).

2.5. 聚类算法

检测网络在对细胞样本进行训练时,损失函数使用交叉熵损失,在标定图输入检测网络前先做预处理,将标定图上红细胞与5类白细胞密度图像素依次改为背景为0,红细胞为1,中性粒细胞为2,嗜酸性粒细胞为3,嗜碱性粒细胞为4,淋巴细胞为5,单核细胞为6,共7类,将预处理后的密度图作为网络的标定图. 细胞图像输入检测网络得到检测密度图后,将像素为1、2、3、4、5、6的区域做聚类,聚类算法遵循:1)就近原则,将像素值相同且距离a(本文a=5)像素以内的点分为同一类;2)连通性原则,若2个像素值相同的点连线上的像素值均高于0则表示2个像素点连通,中间没有背景区域. 通过聚类算法得到检测图每类细胞的中心坐标后,将此坐标在标定图中找出,判断该点的像素值是否与检测图中聚类得到点的像素值一致,若一致则分类准确,不一致则分类错误,以此得到每类细胞的准确率.

3. 血细胞分类检测实验

3.1. 实验设备

实验采用Linux操作系统,基于tensorflow1.13的深度学习框架,在显卡配置为4块NVIDIA,2080Ti-11G,内存为DDR4-3000-32G的设备中开展对比实验.

3.2. 数据集建立与预处理

数据集建立与标定工作与广西医科大学第二附属医院检验科共同完成,随机选取100位患者的血细胞分析样本,经过制片、染色、推片等操作制备外周血细胞染色玻片共100张,采集用光学显微镜调整不同亮度、角度情况下的细胞图像共4 000张(分辨率256×256),并在医院专业人员指导下完成数据集标定工作. 记录每张图片中每个细胞中心的位置,生成对应的位置掩膜,具体操作过程:用半径为8像素的实心圆将红细胞中心位置标记为RGB(255,255,255);用半径为15像素的实心圆将5类白细胞中心位置分别标记为中性粒细胞RGB(0,255,255),嗜酸性粒细胞RGB(255,0,0),嗜碱性粒细胞RGB(255,0,255),淋巴细胞RGB(0,255,0),单核细胞RGB(255,255,0),该位置掩膜同样作为检测与分类网络的标定信息.

3.3. 网络训练

网络训练分2个阶段进行:1)细胞图像生成阶段,2)细胞图像分类检测阶段.

3.3.1. 细胞图像生成阶段

将4 000张图像样本的50%作为数据集,其中训练集、测试集、验证集的比例为6∶2∶2,同时将随机生成的位置掩膜与梯度掩膜的15 000张图像以1∶1∶1加入实验的训练集、验证集、测试集中。训练时生成器输入细胞位置掩膜和梯度掩膜图像分辨率为256×256,并做平移、镜像、旋转等数据增强操作,每训练100次,从验证集中随机选取批处理大小(batch_size)张图像做验证,保存验证生成的图像,训练采用亚当优化器. 实验参数设置选取策略如下。1)随机丢弃参数的系数按照惯例设为0.5。2)为了保证每次验证生成细胞样本多样性将批处理大小设置为1。3)学习率的范围一般为[0.0001,0.01],对于较小的批处理大小,为了避免异常值对结果造成的巨大扰动,要设置较小的学习率,因此本文设置为0.000 1。4)损失函数相关常数项设置;在提取原图与生成图像的梯度时认为亮度、对比度、梯度各分量重要程度一致,故α、β、γ均设置为1,

表 1

不同

Tab.1

| | I | P/% |

| 1 | 100 000 | 92.4 |

| 5 | 70 000 | 93.7 |

| 10 | 50 000 | 94.7 |

| 15 | 40 000 | 94.1 |

由表1可知,当

3.3.2. 细胞图像检测阶段

将阶段1)生成的细胞图像与真实图像的50%一起作为训练集,实验参数设置选取策略:学习率设置为0.000 1;损失函数采用交叉熵损失函数,本文中类别K=7,表示背景和6类细胞;为了加速网络训练设置W=5. 将细胞图像生成阶段验证和测试生成的图像与真实图像一起送入检测器中训练,训练结束后用剩余的真实细胞图像做测试,用聚类算法得到各类细胞的个数及中心坐标,通过与标定图比对得到各类细胞的准确率.

4. 结果与分析

4.1. 细胞图像生成实验

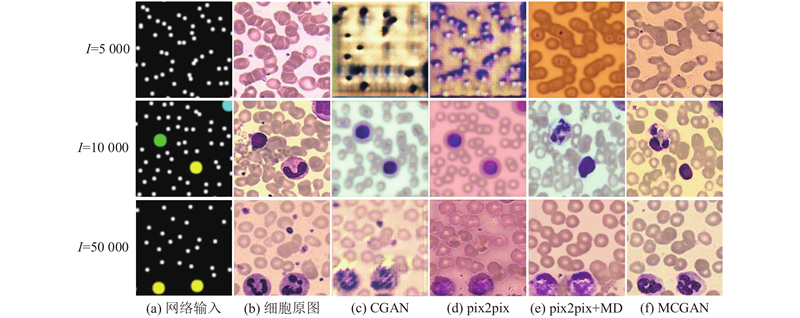

4.1.1. 可视化细胞图像生成结果

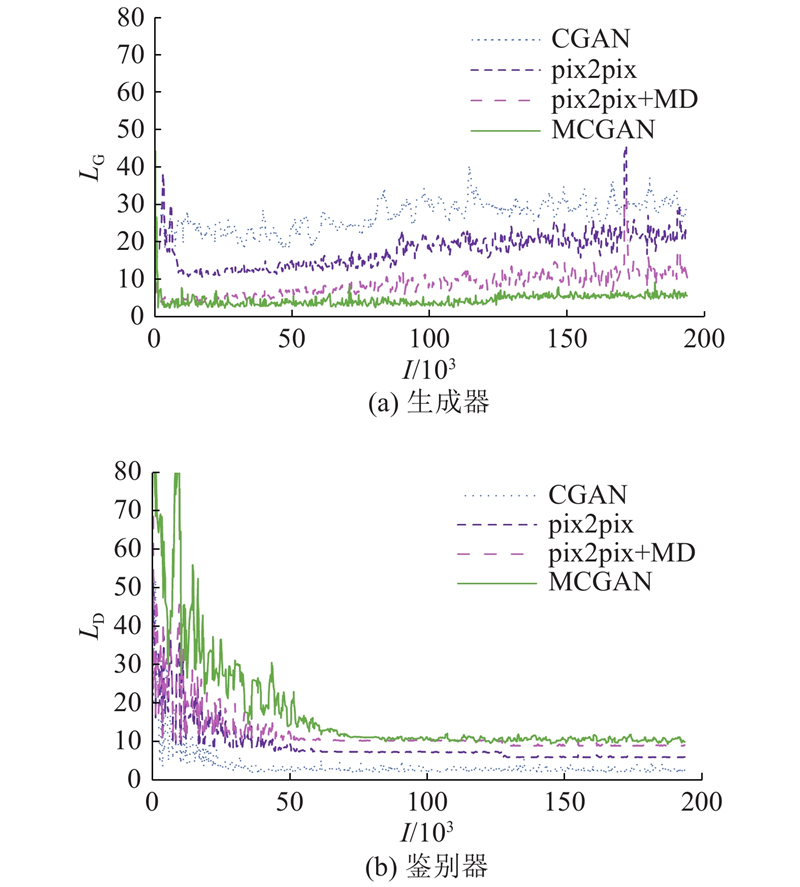

分别采用CGAN、pix2pix、pix2pix+MD、MCGAN网络结构作对比实验,当I=5 000、10 000、50 000时各网络生成的图像如图4所示. 由图可知,MCGAN通过输入外周血细胞的位置掩膜和梯度掩膜,可以控制生成细胞的类别和位置,而细胞在形状上与原图存在一定的差异,保证了生成细胞样本的真实性与多样性. 与CGAN、pix2pix对比,pix2pix+MD和MCGAN的生成器与鉴别器的损失收敛得更快,相同迭代次数生成的红细胞在重叠情况下的边缘更加明显,白细胞图像细节信息更加丰富. 各网络的生成器及鉴别器损失函数曲线如图5所示。图中,

图 4

图 5

4.1.2. 生成图像质量定量评价

式中:n为每像素的比特数,H、W分别为细胞图像的高度、宽度.

SSIM能够有效客观地评估真实图像与生成图像的相似度,评估分别从亮度、对比度和结构共3个方面进行,更加符合人类的视觉效果. SSIM值越大,就说明2张图片的相似度越高,计算公式为

式中:

当生成的样本与真实样本越像时,FID越小. FID的计算公式为

式中:

在实验中设置相同的学习率、迭代次数、通道数等,当I=50 000时计算不同网络结构模型生成细胞图像的PNSR、SSIM、FID指标,结果如表2所示. 由表可知,MCGAN的PNSR、SSIM值最大,FID的值最小;与pix2pix相比,MCGAN的PNSR值提高5.27 dB,SSIM值提高0.18,FID值降低19.88(加入多尺度鉴别器PNSR提高4.42 dB,SSIM提高0.14,FID降低了17.03;在此基础上加入梯度相似性损失函数后,PNSR又提高0.85 dB,SSIM提高0.04,FID降低2.85)。由此可知,与其他3个模型相比,MCGAN生成图像的细节更逼真,与真实图像相似性更高.

表 2 不同模型的PNSR、SSIM及FID值对比

Tab.2

| 模型 | R/dB | S | F |

| CGAN | 13.63 | 0.56 | 84.13 |

| pix2pix | 18.41 | 0.69 | 54.37 |

| pix2pix+MD | 22.83 | 0.83 | 37.34 |

| MCGAN | 23.68 | 0.87 | 34.45 |

4.2. 细胞图像分类检测实验

4.2.1. 可视化分类检测结果

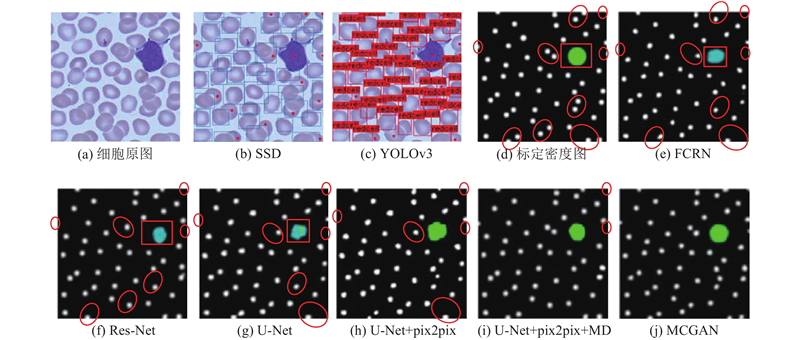

将不同的网络结构模型SSD,YOLOV3,FCRN,Res-Net,U-Net,U-Net+pix2pix,U-Net+pix2pix+MD(鉴别器结构加入多尺度卷积与池化结构)和MCGAN进行对比,测试集从真实外周血细胞样本中选取50%用训练过后不同模型进行测试,检测结果图如图6所示. 在(b)、(c)中,用半径为5像素的圆点将漏检的细胞在输出矩形框检测结果图上标记;在(e)、(f)、(g)、(h)、(i)、(j)中用椭圆框将漏检细胞在输出密度图上标记,用矩形框将误检细胞在输出密度图上标记.

由图6可知,在未加入生成图像训练情况下,使用候选框方法检测的SSD漏检15个,YOLOV3漏检11个;使用密度图方法检测的FCRN漏检8个,误检1个,Res-Net漏检7个,误检1个,U-NET漏检6个,误检1个. 在加入生成图像训练情况下,U-Net+pix2pix漏检5个,生成器和检测器采用U-Net,并在鉴别器加入多尺度卷积和池化结构后漏检2个,此基础上再加入梯度相似性损失函数,MCGAN无漏检. 由此可得,在条件生成对抗网络中加入多尺度鉴别器和梯度损失函数能有效提升细胞图像的检测精度.

图 6

图 6 细胞分类检测实验结果对比图

Fig.6 Comparison of cell classification and detection experimental results.

4.2.2. 不同网络检测准确率对比

细胞分类检测结果如表3所示。表中,T为总的细胞个数. 本文主要研究对血细胞中每类细胞的计数,因此引入2个新的评价指标,细胞的漏检个数M和误检个数e,即有多少个细胞被漏检和多少个细胞被错误检测为不是该细胞的其他类别. 由表可知,SSD、YOLOV3网络中使用矩形框标定方式对细胞图像进行训练,得到的检测准确率普遍低于使用密度图标定的情况,结合图6各网络检测输出图可知使用密度图可以有效改善在细胞黏附遮挡情况下和图像边界处的检测精度;同时在使用密度图标定情况下,U-Net网络与FCRN、Res-Net相比在细胞检测中效果最佳,原因在于U-Net中每一反卷积后都使用跳跃连接,融合了图像深层与浅层特征. 在U-Net中加入MCGAN生成细胞图像数据库训练的情况下细胞的准确率有明显提升,与仅有真实数据库训练情况对比,准确率由90.4%提升到94.7%(其中在加入多尺度鉴别器后准确率提高到94.1%,此基础上再加入梯度相似性损失函数准确率提高到94.7%).

表 3 不同模型的检测结果对比

Tab.3

| 模型 | P/% | T | M | e |

| SSD | 82.7 | 84 202 | 11 883 | 1 254 |

| YOLOV3 | 86.5 | 84 202 | 10 367 | 824 |

| FCRN | 89.3 | 84 202 | 8 910 | 314 |

| Res-Net | 89.7 | 84 202 | 8 573 | 291 |

| U-Net | 90.4 | 84 202 | 7 903 | 236 |

| U-Net+pix2pix | 92.7 | 84 202 | 6 138 | 172 |

| U-Net+pix2pix+MD | 94.1 | 84 202 | 5 115 | 121 |

| MCGAN | 94.7 | 84 202 | 4 624 | 76 |

由于真实数据中白细胞样本较少,为了凸显出在训练时加入生成白细胞样本后准确率的变化情况,在U-Net网络中,将红细胞和其他5类白细胞在加入不同GAN生成细胞样本训练情况下的每类细胞的准确率作对比. RD(Real Databases)为真实细胞图像数据集,RD+CGAN、RD+pix2pix、RD+pix2pix+MD、RD+MCGAN分别为各生成对抗网络生成的细胞图像和真实图像组合数据集,结果如表4所示。表中,P1、P2、P3、P4、P5、P6分别为红细胞、中性粒细胞、嗜酸性粒细胞、嗜碱性粒细胞、淋巴细胞、单核细胞的分类检测的准确率.由表可知,在U-Net中加入不同GAN网络生成的图像,检测精度均有提升,证明用生成对抗网络增加检测网络训练集以提高细胞分类检测精度的方法可行. MCGAN网络生成的样本对细胞检测准确率提升效果最好,原因是在MCGAN网络结构中解决了CGAN网络损失函数中缺乏

表 4 U-Net网络中各类细胞在不同数据库训练下测试结果对比

Tab.4

| 训练集 | P1 | P2 | P3 | P4 | P5 | P6 |

| RD | 90.5 | 91.3 | 88.6 | 87.6 | 90.9 | 88.1 |

| RD+CGAN | 91.0 | 91.7 | 90.7 | 88.7 | 91.9 | 89.1 |

| RD+pix2pix | 92.2 | 93.1 | 91.7 | 89.9 | 93.5 | 91.0 |

| RD+pix2pix+MD | 94.1 | 96.9 | 96.9 | 95.5 | 96.7 | 96.0 |

| RD+MCGAN | 94.7 | 99.1 | 98.9 | 98.9 | 98.9 | 99.0 |

5. 结 语

通过研究生成血细胞图像质量对血细胞检测精度的影响,提出基于MCGAN的血细胞分类检测方法。将所提方法应用于血细胞图像生成实验中,并将生成的血细胞图像加入分类检测网络的训练集中,与现有图像生成与检测方法对比,所提方法的优势在于:1)在血细胞图像生成阶段,所提算法生成的血细胞图像从视觉和评价指标上均优于现有条件生成对抗网络算法;2)在分类检测模型上,通过与当前主流的SSD、YOLOV3、FCRN、Res-Net、U-Net检测网络模型对比实验得到,增加生成细胞样本的细节信息和多样性,细胞的分类检测准确率有明显提升. 在未来研究工作中,将从以下2个方面改进以此降低细胞的漏检率与误检率:1)由于漏检细胞与误检细胞主要集中在细胞粘连严重的情况下,考虑增加粘连样本进行训练;2)进行细胞检测网络的结构优化,增加网络的深度,提高检测网络在细胞粘连情况下的检测精度.

参考文献

基于深度卷积神经网络的人体外周血白细胞显微图像分类

[J].

Human peripheral blood leukocyte microscopic image classification based on deep convolutional neural network

[J].

Faster R-CNN: towards real-time object detection with region proposal networks

[J].DOI:10.1109/TPAMI.2016.2577031 [本文引用: 1]

基于YOLO框架的血细胞自动计数研究

[J].DOI:10.3778/j.issn.1002-8331.1904-0268 [本文引用: 1]

Automated counting of blood cells based on YOLO framework

[J].DOI:10.3778/j.issn.1002-8331.1904-0268 [本文引用: 1]

Vehicle detection and counting in high-resolution aerial images using convolutional regression neural network

[J].

Detecting maneuvering target accurately based on a two-phase approach from remote sensing imagery

[J].DOI:10.1109/LGRS.2019.2935230 [本文引用: 1]

Generative adversarial networks

[J].

FashionGAN: display your fashion design using conditional generative adversarial nets

[J].

多分类CNN的胶质母细胞瘤多模态MR图像分割

[J].DOI:10.3969/j.issn.0372-2112.2019.08.018 [本文引用: 1]

Glioblastoma multiforme multi-modal MR image segmentation using multi-class CNN

[J].DOI:10.3969/j.issn.0372-2112.2019.08.018 [本文引用: 1]

基于多尺度特征映射网络的图像超分辨率重建

[J].

Image super-resolution reconstruction based on multi-scale feature mapping network

[J].

基于随机森林的红外图像超分辨力算法

[J].DOI:10.11805/TKYDA2019139 [本文引用: 1]

Infrared image super-resolution algorithm based on random forest

[J].DOI:10.11805/TKYDA2019139 [本文引用: 1]