视觉目标跟踪(visual object tracking, VOT)是计算机视觉领域中最具挑战性的问题之一. 它在视频监控、人机交互和自动驾驶领域中有着广泛的应用. 尽管近几年VOT技术取得了显著的进步,但面临着遮挡、形变和快速运动等诸多挑战.

近年来,检测跟踪(tracking-by-detection)类跟踪方法成为目标跟踪的最成功的范例之一. 遵循这种模式,跟踪器通过学习辨别模型来检测对象,并随着时间的推移对模型进行更新,以补偿目标外观和比例的变化. 尽管这类方法性能出众,但是当目标出现严重的遮挡或者剧烈的形变时,辨别模型可能会学习到背景的特征,从而导致模型漂移. 这需要跟踪器实时作出决定,何时更新外观模型,这种决定对于最终性能的提升至关重要.

为了解决上述问题,熊昌镇等[1]采取稀疏更新的策略,减弱遮挡、形变及快速运动等挑战导致的漂移问题. Wang等[2-3]采取高置信度更新的策略,即将相关滤波的最大响应值作为评估跟踪结果的指标,只有该值高于某个人为设定的阈值,跟踪器才更新模板. 最大响应值有时候不准确,在一些复杂的跟踪场景中,最大响应值会存在高于阈值的情况. 为了找到更准确的置信度指标,Bolme等[4]提出峰值旁瓣比(peak sidelobe ratio, PSR),Wang等[5]提出平均峰值相关能量(average peak-to-correlation energy, APCE). 虽然上述指标取得了更好的效果,但是阈值需要人为设定.

受到上述方法的启发,本文提出的方法学习了一种策略来决定何时更新模板以及是否要进行重新检测. 与之前的工作相比,主要有以下几点贡献:1)使用基于帧的策略梯度算法来训练策略网络,具备完全可观测性,能够学习更加可靠的策略;2)使用加权置信度差值图替代响应图来表示状态,使得状态表达更加准确全面;3)在重检测模块中,通过粒子滤波器及稀疏编码方法过滤大量的搜索区域,相比于全局搜索大大提高了速度,利用策略网络来检验重检测结果,确保重检测结果的准确性.

1. 方法介绍

如图1所示,提出的算法框架由一个跟踪网络和和一个策略网络组成. 在第t帧中,根据上一帧目标的位置信息裁剪得到搜索图像x. 通过输入初始模板图像z和搜索图像x,跟踪网络输出响应图ht. 通过计算加权置信度差值,将响应图ht转换成加权置信度差值图qt,再将qt输入策略网络中,得到动作集A中各个动作的正则化分数. 执行动作集A中得分最高的动作at.

图 1

1.1. 全卷积Siamese网络

提出算法的跟踪模块基于SiamFC[9]方法构建. SiamFC学习了一个相似度度量函数f,比较127×127模板图像z与较大的255×255搜索图像x中相同大小的候选区域的相似程度. 函数f是一个全卷积siamese网络,能够在一次评估中计算搜索图像的所有子窗口与模板图像的相似度:

式中:

1.2. 强化学习概述

强化学习是一种重要的机器学习方法,用于解决智能体(agent)在与环境的交互过程中通过学习策略以达成回报最大化或实现特定目标的问题. 强化学习问题通常由马尔可夫决策过程(Markov decision process, MDP)进行描述.

如图2所示,在t时刻给定一个状态st,agent必须根据策略π从给定的动作集中选择一个动作at,动作at和当前状态st决定了奖励rt和下一时刻的状态st+1. 在一次MDP中,所有状态和动作的集合称为一个轨迹,表示为

图 2

式中:T为一个轨迹的长度. 假设策略π已经被给定,对于每一个轨迹,可以计算它的累积回报以及发生的几率:

RL的任务是找到一个最优策略π,最大化期望回报,即

RL算法主要分为两大类:基于价值的方法和基于策略的方法. 基于价值的方法旨在学习一个最优值函数来获取最大期望回报. Q学习是典型的基于价值的方法. 基于策略的方法是直接对策略函数进行建模,策略梯度算法是该类方法中最关键的一种.

1.3. 基于策略梯度算法的策略学习

在上述RL模型的描述中,需要引入几个关键假设. 1)当agent与环境交互时,时间域被认为是离散的. 2)假设提供的环境包含一些奖励功能,作为成功的监督指标. 3)假设所设定的环境具有完全可观测性,即agent可以观测到完整的世界状态信息,此时满足马尔可夫性质:下一时刻的状态st+1只取决于当前时刻的状态st和此时选择的动作at.

现实世界的任务通常具有不完整和嘈杂的状态信息. 跟踪问题更是如此,在以往的工作中,响应图表示当前时刻的状态,即当前时刻所观测到的目标的位置. 仅根据当前时刻的目标的位置和动作无法决定下一时刻目标的状态,下一时刻的目标状态还与上一时刻目标的速度及方向等因素相关,因此不具备完全可观测性. 此时,跟踪过程变成部分可观测马尔可夫决策过程(partially observable Markov decision processes, POMDP),从观测值决定动作可能是错误的[10].

为了解决上述问题,采用基于帧的策略梯度算法训练策略网络,即将一帧的跟踪过程视为一个轨迹而不是一段视频序列的跟踪过程. 在一个轨迹中只有一个状态,所以满足马尔可夫性质,具备完全可观测性. 从某种程度上来说,基于帧的策略网络可以看作一个分类网络,将结果分为3类,对应3种动作. 训练数据在跟踪过程中生成,奖励对应训练数据的标签.

1.4. 跟踪过程中的状态表达

在评估跟踪器性能时,有2个重要的标准:准确性和鲁棒性. 在之前的工作中,用响应图h

为了使状态表达更加准确全面,使用加权置信度差值图q∈R33×33表示状态s,通过计算响应图上每一个坐标的加权置信度差值[11]同时衡量准确性和鲁棒性:

式中:h(c)为坐标c上的响应;c*为最大响应所对应的坐标;

假设c远离c*,可得

1.5. 跟踪过程中的动作表达

动作集A包含3种类型的动作:“跟踪”、“更新”及“重检测”. “跟踪”动作表示在跟踪过程中,不更新目标外观模板. “更新”动作表示在每一帧跟踪后更新目标外观模板.

式中:

当一个搜索区域x在正模板集的重构误差越小或者负模板集的重构误差越大时,表示该区域越可能存在目标. 更高的Ri意味着目标在该区域的可能性越高,计算每个候选搜索区域的Ri,然后舍弃Ri较低的候选搜索区域. 对于剩下的候选搜索区域,通过跟踪网络得到响应图,选择经过距离惩罚后响应值最大的候选搜索区域区域作为最佳候选搜索区域. 类似地,最佳候选搜索区域的响应图上最大值的坐标决定了重检测目标的位置. 将最佳候选搜索区域所对应的响应图输入策略网络来检验重检测结果. 当在同一帧内执行2次及以上“重检测”动作时,将放弃重检测结果,采用最初的跟踪结果.

1.6. 训练策略网络

为了学习到可靠的策略,采用基于帧的策略梯度算法. 在训练过程中,将策略网络πθ(at|st)用卷积神经网络近似表示,采用梯度下降算法最大化期望回报,梯度表示为

式中:

式中:a1、a2、a3分别表示“更新”、“跟踪”及“重检测”这3个动作. IoU表示预测框b和真实框g的重叠率. 当IoU > 0.6时,预测结果与真实的目标相接近,所以应该更新模板. 当0.2 < IoU

策略网络由2个卷积层、1个全连接层以及1个输出层组成. 其中第1个卷积层有6个6×6×1的卷积核,卷积步长为1,并经过一个2×2的步长为2的最大池化层. 第2个卷积层有6个5×5×6的卷积核,卷积步长为1. 全连接层有128个节点,输出层有3个输出动作. 整个算法在大规模单目标跟踪(large-scale single object tracking, LaSOT)数据集[13]上训练50个周期,对于每一个周期,在经验池收集到4096个样本后,策略网络随机抽取经验池中的64个样本进行学习. 继续采样新的样本,收集到的新样本将替换经验池中老的样本. 每次收集到新的32个样本后,策略网络将再次抽取经验池中的64个样本进行一次迭代学习. 如此循环往复,直到agent与所有的训练图像完成交互. 在整个训练过程中,学习率从10−6下降到10−8.

2. 实验结果

实验运行平台为Python3.6、Tensorflow1.9、Cuda9.0,运行环境配置为Intel Core i7,Nvidia GeForce Titan V,显存为12 GB,内存为16 GB.

图 3

为了证明提出方法的有效性,分别在LaSOT数据集的部分序列及OTB数据集上对不更新模板的SiamFC算法(Never update)、更新模板的SiamFC算法(Always update)、基于加权置信度差值图进行自适应模板更新的SiamFC算法(Adaptive update without re-detection)、基于响应图进行动作决策的SiamFC算法(response map based)以及基于加权置信度差值图进行动作决策的SiamFC(weighted confidence margin map based)进行性能对比. 结果如表1所示,虽然SiamFC算法在处理遮挡和变形方面表现出很强的鲁棒性,但是使用提出的决策策略获得了显著的提升(DP大约提升了4%,OP大约提升了2.5%).

表 1 不同设定下的算法性能对比

Tab.1

| 设定 | LaSOT结果 | OTB100结果 | 平均速度/(帧·s−1) | |||

| DP | OP | DP | OP | |||

| Never update (Baseline) | 42.5% | 0.363 | 74.2% | 0.567 | 67 | |

| Always update (Baseline) | 38.1% | 0.337 | 75.8% | 0.571 | 50 | |

| Adaptive update without re-detection | 40.8% | 0.359 | 78.0% | 0.587 | 46 | |

| Response map based | 43.8% | 0.366 | 77.8% | 0.587 | 33 | |

| Weighted confidence margin map based | 44.2% | 0.368 | 78.5% | 0.592 | 32 | |

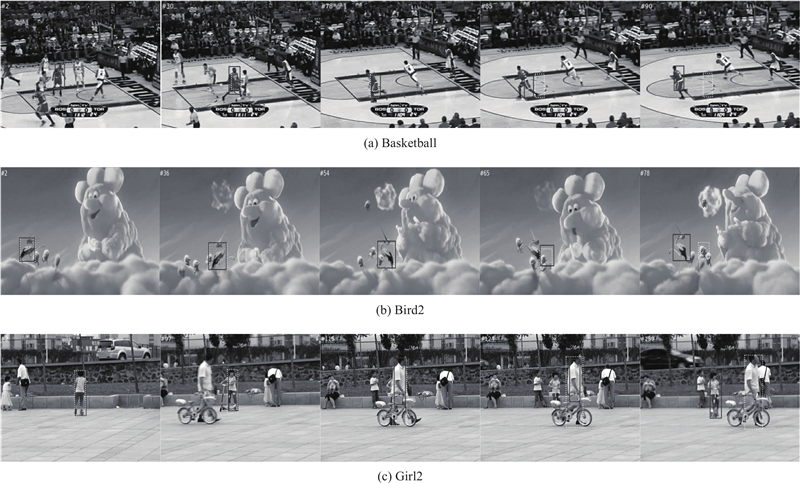

给出提出算法和SiamFC算法在具有挑战性的代表性视频序列上的部分跟踪过程,结果如图4所示. 其中Basketball序列包含了光照变化、遮挡、形变等挑战,Bird2序列包含了遮挡、形变、快速运动等挑战,Girl2序列包含了完全遮挡、形变、尺度变化等挑战. 图4中,实线为所提出算法的跟踪结果,虚线为SiamFC算法跟踪结果. 在Basketball序列第85帧以及Bird2序列第78帧的跟踪结果中,由于部分遮挡,SiamFC算法受到背景信息的干扰导致了跟踪器漂移,但提出的算法通过识别不可靠的跟踪结果避免了错误的模板更新,因此能够继续跟上目标. 在Girl2序列第124帧跟踪结果中,由于完全遮挡,提出算法和SiamFC算法都失去了目标,但是在第139帧,提出算法通过重检测找回了目标. 以上实验结果反映了利用提出算法能够有效地应对遮挡、形变、快速运动等重大挑战.

图 4

3. 结 语

本文提出鲁棒的跟踪算法,能够准确地识别不可靠的跟踪结果. 通过连续决策,有效地解决了严重遮挡、视线模糊、外观变化等问题. 在OTB数据集上对该算法进行评估. 实验结果表明,提出的算法在面临诸多挑战的情况下,取得了显著的性能提升. 在实验过程中发现,使用了重检测模块后,算法性能相对于自适应更新的算法版本没有特别大的提升,在速度方面有着明显的下降. 该问题的原因可能是策略网络存在小部分误判,导致错误地进行重检测. 在后续的研究中,将着重解决该问题.

参考文献

基于多高斯相关滤波的实时跟踪算法

[J].

Real time tracking algorithm based on multi Gaussian correlation filtering

[J].

Reliable re-detection for long-term tracking

[J].DOI:10.1109/TCSVT.2018.2816570 [本文引用: 2]

Real-time visual tracking by deep reinforced decision making

[J].

粒子滤波器及其在目标跟踪中的应用

[J].DOI:10.3969/j.issn.1672-2337.2003.03.010 [本文引用: 1]

Particle filter and its application in object tracking

[J].DOI:10.3969/j.issn.1672-2337.2003.03.010 [本文引用: 1]

High speed tracking with kernelized correlation filters

[J].DOI:10.1109/TPAMI.2014.2345390 [本文引用: 1]