随着高速公路车流量的不断增长,因高速公路抛洒物诱发的事故数量激增. 这些抛洒物大多为货车上未捆扎严实而掉下的货物或者汽车故障掉落的碎片,这些体积小而坚硬的物体,对高速公路司乘人员的安全带来了极大的威胁. 利用视频技术对高速公路抛洒物进行实时、准确地检测,成为智慧交通领域一个非常有意义且亟待解决的问题. 不同于高速公路上的机动车、护栏、标志标线等对象,抛洒物种类各异,不具有图形图像上的通用特征,本文利用背景建模和前景提取方法实现对抛洒物目标的检测.

传统的固定背景建模方法无法快速适应环境变化,导致前景提取过程中出现大量环境噪声. 现有的一些动态背景建模方法无法将静止的抛洒物目标长时间保存在前景,本文提出基于背景分离高斯混合模型(BS-GMM)的动态背景建模方法,在实时更新背景模型的前提下,保持静止目标在前景图像中停留足够的时间,以完成对抛洒物的准确检测.

1. 相关工作

1.1. 基于背景建模的抛洒物检测方法

基于背景建模方法实现对前景抛洒物目标的检测,主要原理是构建一个稳定且可不断更新的背景模型,然后提取不在背景模型中的目标对象,对其中抛洒物和噪声进行区分. 传统的背景建模方法有帧差法[1]、Codebook方法[2]、高斯混合模型[3]方法等. 帧差法依赖于全局的像素值差分阈值,方法的复杂度低,较难在高速公路类型的复杂场景将前景目标和噪声进行有效区分. Codebook方法根据像素点在时间序列上的变化程度来建立背景模型,该方法对光照变化比较敏感,且计算量较大,因此不适用于高速公路这类开放场景. Stauffer[3]提出高斯混合模型方法,对复杂场景下的视频序列进行背景建模和前景提取,目前为止大多数抛洒物检测算法都是基于高斯混合模型的方法来实现背景建模的,获取前景目标后利用前景目标的运动轨迹、图像特征等信息对抛洒物目标进行筛选. 陈祖爵等[4]在高斯混合模型的更新过程中引入加速因子和合理性反馈机制,从而消除运动车辆在前景提取时产生的拖影,以免对抛洒物检测造成影响. 刘鑫等[5]将帧差法与高斯混合模型相融合,用来实现前景目标检测的完整性,以避免将抛洒物或者车辆目标分割成多个目标.

1.2. 基于深度学习的抛洒物检测方法

随着深度学习的不断发展,相关网络模型提取图像特征的能力不断增强,使用深度学习进行抛洒物目标检测的方法越来越多. 阮雅端等[11]将抛洒物目标的识别转化为路面、非路面的二分类问题,将包含路面和非路面的区域图片标注作为训练集,通过卷积神经网络训练出分类网络;利用车辆检测算法进行判断,若不属于车辆且该区域属于路面的置信度低于非路面的类别,则将其判断为抛洒物. 金瑶等[12]基于YOLO V3构建网络,利用抛洒物目标更依赖于浅层特征的特点,增加了1 个尺度进行目标检测,通过模型训练能够有效地检测出城市道路上如纸屑、木块、石块等具体几类抛洒物目标. 尽管深度学习在特征提取和目标分类上具有突出的能力,但是其局限性在于训练集中目标检测对象是否充分,会直接影响最终识别效果. 这一类相关工作在某些特定场景下识别某些特定种类的抛洒物有一定的效果,但是不具有较强的泛化能力. 如何将深度学习应用于抛洒物这类不具备通用特征的目标对象识别,面临着巨大的挑战.

2. 背景分离高斯混合模型

在传统高斯混合模型算法的基础上,提出背景分离高斯混合模型(BS-GMM),实现背景建模和背景更新. 该模型重点解决以下2个问题:1)减少环境噪声出现在前景目标中;2)抛洒物一般具有从运动状态快速到静止状态的过程,避免静止状态的抛洒物被快速融入背景模型中,影响检测效果.

2.1. BS-GMM模型架构

为视频图像中每个像素点分解K个高斯分布作为背景模型:

式中:

BS-GMM模型在传统高斯混合模型的基础上对背景划分和模型匹配模块进行改进,分析每个像素点的高斯分布背景模型的权值

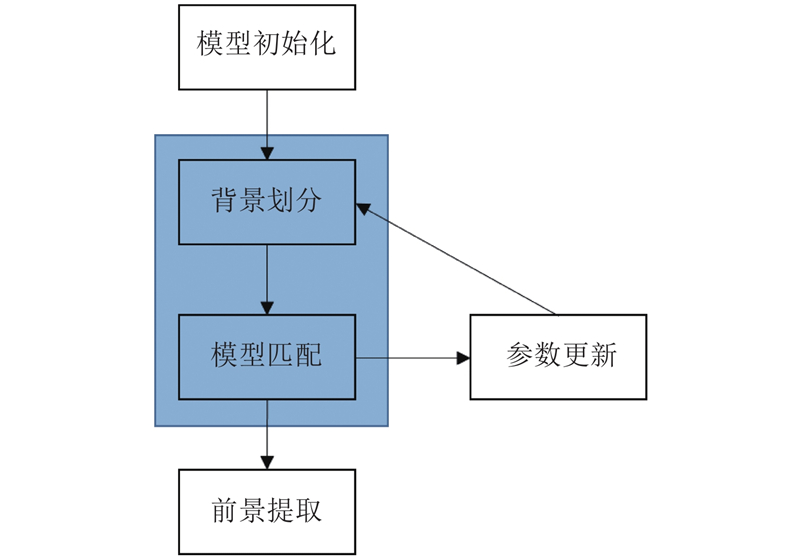

图 1

2.2. BS-GMM模型实现

2.2.1. 模型初始化

对图像中各个像素点的背景模型进行初始化,即创建一个权值和为1的高斯分布模型,这些高斯分布模型的均值设为视频首帧图像中对应点的像素,方差设为默认值. 高斯分布权值更新的学习率参数在初期N帧内使用较高的学习率过滤掉实际背景中的运动目标干扰信息,以获得稳定的高速公路背景. 经过N帧后,使用较低的学习率进行背景建模和前景提取,以保证前景目标的完整性,防止目标像素快速融入背景模型.

2.2.2. 背景划分和模型匹配

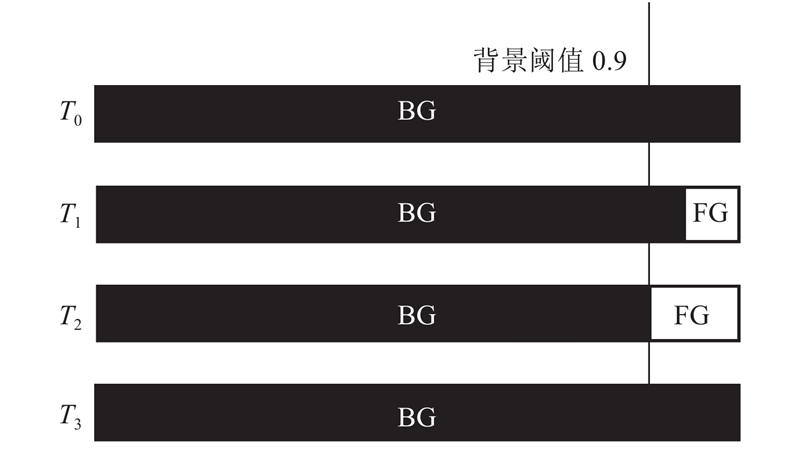

传统高斯混合模型在每一帧都对背景进行划分,将导致静止的抛洒物目标快速消失在前景中. 设定背景阈值为0.9,学习率为0.001,背景更新过程如图2所示.

图 2

提出的BS-GMM模型在模型初始化完成且构建稳定的背景模型后,按照背景阈值对高斯分布模型进行划分,标记为不同的背景模型和前景模型. 对像素点与其中的背景模型进行匹配,得到该像素点j在t时刻的类型

式中:

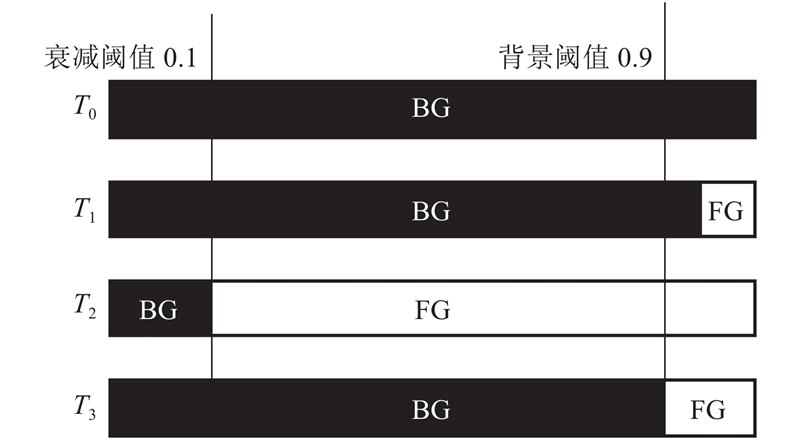

定义背景衰减阈值如0.1,当背景模型的权值和低于该阈值时,认为背景已发生更新,此时重新划分背景,在2次背景划分之间,保持各模型的类别不变. 改进后的背景划分方法如图3所示.

图 3

在

该方法改变了背景划分的策略和模型匹配的方法,在适应环境变化实现低噪声率的动态背景建模的同时,可以有效地对静止目标进行检测.

2.2.3. 参数更新

当第j个像素点与第i个模型匹配上时,对模型的参数进行如下更新:

式中:ρi,t为参数更新速率,

3. 实验结果和分析

3.1. 实验设置

实验设备配置如下:CPU为Intel Core i5 @2.3 GHz,内存为8 GB,操作系统为Windows 1 064位.

实验数据集:视频数据来源于某市高速公路支队的监控摄像头,一共取自30个不同点位的摄像头,所有视频时长均为2 min,帧率为25帧/s,分辨率为1 920×1 080. 抛洒物种类包括木块、石块、塑料袋、遮货布等,无抛洒物的视频中包含各类噪声,如阴影、抖动、天气变化等环境因素. 详细信息如表1所示.

表 1 视频数据集信息

Tab.1

| 视频类型 | 场景数量 | 视频数量 | 视频时长/min |

| 含抛洒物 | 30 | 40 | 2 |

| 无抛洒物 | 30 | 120 | 2 |

选取2个评价指标,比较各方法的背景建模和前景提取效果. 1)抛洒物目标检测的正确性指标,即将抛洒物实际运动过程中的位置进行手动标定作为真值. 若检测结果与标定位置的交并比(IOU)大于0.5,则认为该帧的检测结果匹配上了真实目标,最终得出匹配帧数占视频中含抛洒物总帧数的比值设为检测正确性指标. 该指标既评价了检出的正确性,也评价了对静止抛洒物检出的时间持久性. 2)检测过程中产生的前景噪声数量,对每一帧除抛洒物目标和车辆目标以外的路面区域噪声像素点进行统计,得出前景噪声数量. 该指标评价了前景提取的误检率.

实验各方法参数设置如下.

1)帧差法. 将差分阈值设置为15,其背景建模的方式为对视频前200帧进行学习,将路面分块进行背景的稳定性判断,找出一段时间内无变化的路面作为固定背景帧,用于后续的前景提取.

2)Codebook方法. 将前200帧用于模型训练,每个像素点用6个码元来描述,其他参数设置参考赵占杰等[15]的方法.

3)LL-GMM方法. 主要参数如下:高斯模型数量为5,背景阈值为0.9,学习率为0.001,方差阈值为16. 对前200帧视频使用高学习率,建立背景模型.

4)EM-GMM方法. 对LL-GMM方法的背景更新过程进行改进,将最近10帧的模型权值作为参数,通过期望最大化算法(EM)更新背景模型.

5)BS-GMM方法. 学习率设为0.001,背景模型衰减阈值设为0.5,其他参数与上述LL-GMM一致.

3.2. 实验分析

3.2.1. 检测正确性分析

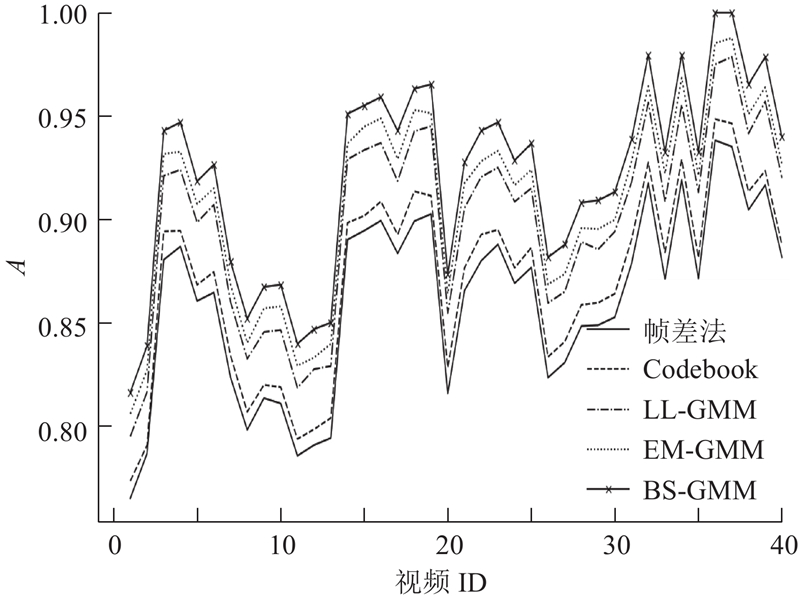

将各方法应用于40个含抛洒物目标的高速公路视频中,各方法检测的正确率A如图4所示.

图 4

由图4可知,GMM相关算法比帧差法和Codebook方法的正确性平均高5%左右. 这是由于在抛洒物目标检测过程中,抛洒物的颜色与路面接近时,使用帧差法和Codebook方法无法将前景目标提取出来,使用LL-GMM方法在抛洒物检测静止约4 s后会使部分前景目标融入背景,使前景检测框与真实目标框的IOU匹配结果偏小,从而丢失一些匹配帧数. EM-GMM方法能够通过历史帧计算出实际背景,但是无法将静止目标长时间保留在前景图像上. 基于权值衰减背景更新的BS-GMM方法在抛洒物目标的检测正确性方面表现更好.

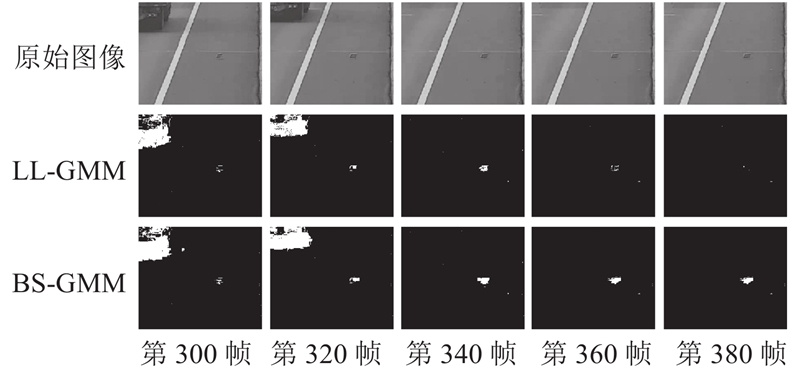

例如,选取其中一个视频,前200帧(即8 s)用于背景建模,从第300帧(即12 s)开始抛洒物静止了4 s,抛洒物目标的前景模型权值大于0.1,采用LL-GMM方法抛洒物目标开始逐渐融入背景,BS-GMM方法背景模型的权值衰减率没有触发背景更新,静止抛洒物能够较好地被持久提取出来. 具体效果如图5所示.

图 5

图 5 静止抛洒物目标持久性提取效果

Fig.5 Effect of static abandoned object sustainable extraction

3.2.2. 前景噪声数量分析

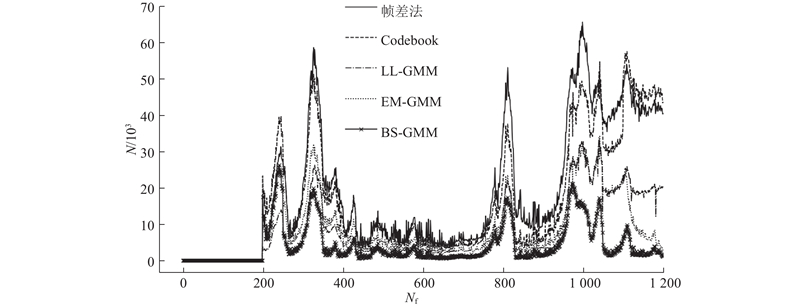

选取一个视频作为实验对象,比较各方法在视频每一帧的前景提取时出现的噪声数量N,结果如图6所示.图中,Nf为帧数.

图 6

由图6可知,该视频前200帧用于背景模型的初始化. 整体结果显示,基于GMM的前景提取方法比帧差法和Codebook方法的噪声数量少20%以上,且从第12 s(即300帧)开始,抛洒物处于静止状态,BS-GMM与LL-GMM和EM-GMM方法相比,噪声像素点数量更少.

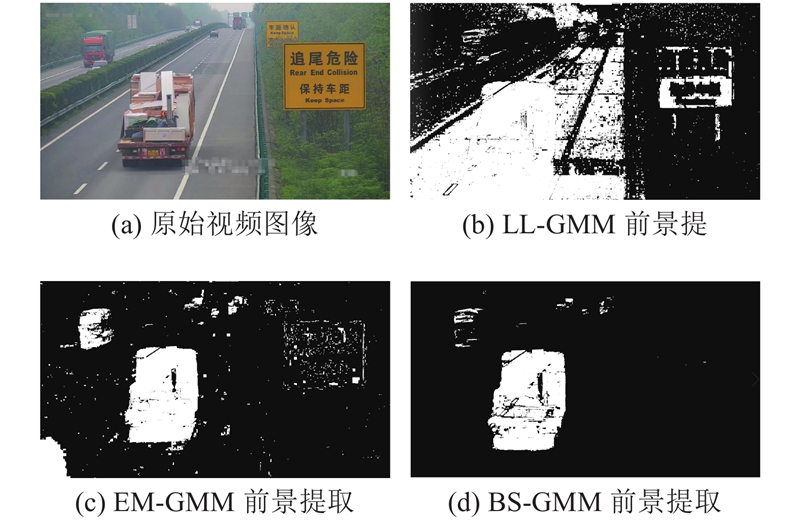

在视频第38 s(即950帧)开始,环境光照亮度发生较明显的变化,BS-GMM方法判定当背景模型的权值衰减至某一阈值时主动更新背景模型,因此更好地适应环境条件变化,噪声数量明显少于LL-GMM和EM-GMM方法. 如图7所示,对第1 000帧采用3种GMM方法提取前景图像,相比于BS-GMM方法,EM-GMM方法和LL-GMM方法无法快速适应环境的变化,在前景提取中受光照条件的影响较大.

图 7

图 7 环境条件变化下前景提取效果对比

Fig.7 Effect of foreground extraction in varying environmental conditions

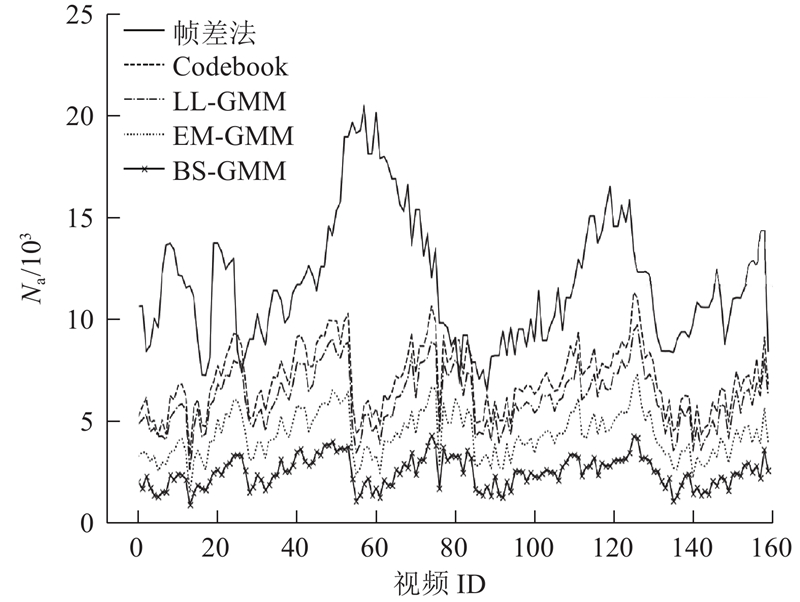

将各方法应用于全部160个视频数据集中,统计各视频中的平均噪声数量Na,如图8所示.

图 8

图 8 数据集平均前景噪声数量分析

Fig.8 Average number of noise in foreground of experimental data set

由图8可知,BS-GMM方法相比于其他方法,平均噪声数量都低10%以上,相比帧差法低50%以上. 在实际的抛洒物检测过程中,前景目标提取的误检可能性较低.

由上述实验结果可知,基于高斯混合模型的多种方法都使用多个高斯分量准确描述路面背景,且快速适应环境变化,因此在背景建模和前景提取的过程中,产生的噪声数量明显少于采用单一阈值提取前景的帧差法和对于光照变化环境条件敏感的Codebook方法. LL-GMM方法采用低学习率的方法会导致背景更新过慢,因而产生大量噪声;EM-GMM方法采用了较高的背景模型更新频率,但是固定频率无法做到及时更新,提出的BS-GMM方法能够根据背景模型衰减状况自适应更新,因此在提取的前景中噪声相对较少.

3.3. 效果展现

采用BS-GMM方法对包含木块、塑料袋、遮货布等抛洒物的高速公路视频进行检测,获得的前景图像如图9所示. 其中,静止状态是抛洒物静止20 s后对前景目标的提取结果.

图 9

上述结果展示,BS-GMM方法使得抛洒物在静止20 s后还不会融入背景中,且产生较少的噪声,因此前景图像中抛洒物目标的提取效果更好.

4. 结 语

本文提出基于背景分离高斯混合模型的动态背景建模方法. 该方法改进了传统高斯混合模型的背景划分和模型匹配模块,通过背景模型和前景模型分离的方式分析背景模型权值和衰减状况,实现对抛洒物静止状态后目标的有效检测. 与其他背景建模方法相比,该方法在目标检测正确性、持久性以及对环境噪声的抗误检性方面都有更好的效果.

该方法后续可以继续优化,对提取的前景目标进行形态学和图像特征的二次筛选,进一步减少环境噪声的影响.

参考文献

实时的静止目标与鬼影检测及判别方法

[J].

Real-time detection and discrimination of static objects and ghosts

[J].

基于改进的混合高斯模型的运动目标检测

[J].DOI:10.3969/j.issn.1006-8961.2007.09.014 [本文引用: 1]

Moving object detection based on improved mixture Gaussian models

[J].DOI:10.3969/j.issn.1006-8961.2007.09.014 [本文引用: 1]

混合高斯模型和帧间差分相融合的自适应背景模型

[J].DOI:10.11834/jig.20080422 [本文引用: 1]

Adaptive background modeling based on mixture Gaussian model and frame subtraction

[J].DOI:10.11834/jig.20080422 [本文引用: 1]

高速公路抛洒物事件图像检测算法

[J].

Image detection algorithm for incident of discarded things in highway

[J].

Real-time video-shot detection for scene surveillance applications

[J].DOI:10.1109/83.817599 [本文引用: 1]

城市道路视频中小像素目标检测

[J].

Object detection for small pixel in urban roads videos

[J].

Multiple object detection and tracking in complex background

[J].