目前,随着电子商务的蓬勃发展,个人身份安全认证已经成为一个重大现实问题,典型的个人身份识别技术包括指纹、掌纹、脸部、签名、虹膜识别等,其中掌纹识别技术具有较大的应用潜力. 相比于指纹,掌纹拥有更大的面积以及更丰富的纹理特征,并且已经在考勤和在线支付等领域大范围使用. 传统掌纹识别的研究主要集中在二维掌纹图像上,可划分为基于线的方法[1]、基于纹理的方法[2]等. 随着深度学习的发展,Zhang等[3]通过使用卷积神经网络进行二维掌纹特征的提取及匹配. 二维掌纹识别虽然取得了较高的识别精度,但仍存在一些固有的缺陷. 例如,二维掌纹图像质量容易受到光照变化、手掌摆放姿态等因素的影响,同时二维掌纹图像也容易被复制以及盗用.

与二维掌纹识别有所不同,三维掌纹识别主要根据掌纹表面三维凹凸结构进行判断,不易受到外界因素的影响,同时三维掌纹的复制难度也较大. 目前流行的三维掌纹识别方法首先通过特定的特征来描述掌纹的三维结构. 白雪飞等[4]使用分块的表面类型特征来提取三维掌纹的几何结构,随后通过主成分分析达到识别的目的. Zhang等[5]提出了一种基于协同表示的三维掌纹识别分类框架,通过表面类型特征来构建局部直方图从而形成特征描述符. Yang等[6]提出利用形状指数和脆弱位特征来进一步提高三维掌纹识别的性能. Fei等[7]提出使用精确方向编码和紧凑表面类型特征来表达三维掌纹特征. Bai等[8]则借助全场正弦光栅投影技术构建了更精确的三维掌纹数据库. 然而上述方法都局限于传统的分类识别框架,深度学习在三维掌纹识别中的优势并没有得以体现.

本文率先将深度学习框架引入到三维掌纹识别研究中,首先通过曲率特征、形状指数、表面类型分别提取三维掌纹的局部纹理信息,随后将其作为不同深度学习网络的输入,最终达到识别的目的. 在香港理工三维掌纹数据库上,本文对上述不同的特征、不同的深度学习网络进行全面分析与比较.

1. 局部特征提取

本文方法流程图如图1所示,首先针对三维掌纹进行局部几何特征提取,随后将提取出来的几何特征输入深度学习网络来完成三维掌纹识别任务.

图 1

三维掌纹数据在采集过程中往往容易受到噪声的干扰,手掌本身也不是一个刚性的物体,形变情况不可避免,因此,传统的迭代就近点方法(iterative closest point,ICP)并不适用于三维掌纹识别. 为了较好地提取三维掌纹的局部细节特征,采用曲率特征、形状指数、表面类型来进行描述,并将上述特征作为后续深度学习方法的输入.

1.1. 平均曲率和高斯曲率

平均曲率和高斯曲率是表面的内在量度,对于旋转、平移甚至非刚性形变具有鲁棒性. 在三维掌纹识别中平均曲率和高斯曲率都具有独特的性质[9]:平均曲率确定了掌纹表面的形状,而高斯曲率确定了掌纹凹凸面的形状. 对于任一三维掌纹曲面S(u,v,f(u,v)),高斯曲率(Gaussian curvature)G和平均曲率(mean curvature)M的计算公式如下:

式中:

式中:C为平均曲率或高斯曲率,

式中:round代表四舍五入操作.

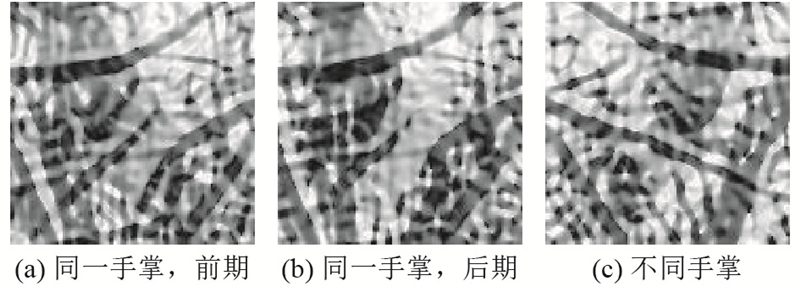

图 2

图 2 不同三维手掌平均曲率图与高斯曲率图

Fig.2 Mean curvature images and Gaussian curvature images of different 3D palms

1.2. 形状指数

根据第1.1节计算得出的平均曲率和高斯曲率,可以得到形状指数特征. 考虑曲面S上通过点P的所有曲线,每条曲线

在获取最大、最小曲率值后,根据文献[6]中所提出的方法,形状指数(shape index,SI)可表示为

目前,现有的三维掌纹识别方法大多利用掌纹的平均曲率和高斯曲率来提取特征,而研究表明,形状指数不易受到平移、旋转和尺度变换的影响,能够刻画三维掌纹几何结构上细微的变化[6]. 同时,由于形状指数图取值在[0,1],可以直接将其转化为8位灰度图像:

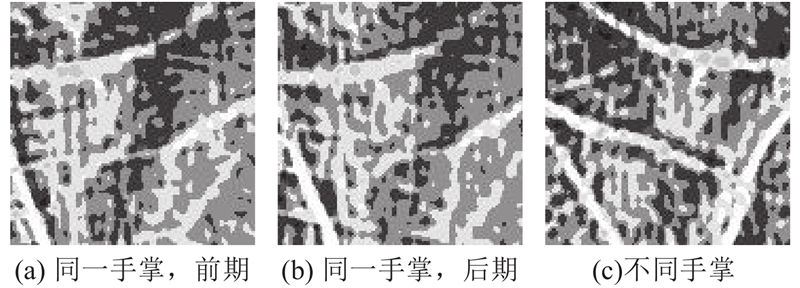

图 3

1.3. 表面类型

表面类型(surface type, ST)将平均曲率和高斯曲率以不同方式组合到一起来描述三维掌纹的特征,其具有高度的辨识力,而且对于掌纹的误对齐也表现出了很好的效果。假定根据式(1)、(2)得到平均曲率和高斯曲率,则三维表面类型的定义如表1所示,其中包括8种基本类型和1个M=0、G>0的特例.

表 1 三维表面类型定义

Tab.1

| 曲率 | G> 0 | G = 0 | G< 0 |

| M< 0 | 峰(ST = 1) | 岭(ST = 2) | 鞍岭(ST = 3) |

| M= 0 | 无(ST = 4) | 平坦(ST = 5) | 低点(ST = 6) |

| M> 0 | 坑(ST = 7) | 谷(ST = 8) | 鞍谷(ST = 9) |

在实际应用中,平均曲率和高斯曲率的取值为浮点数. 为了确定M=0、G=0这一特定的类型,首先对平均曲率和高斯曲率取值进行归一化:

图 4

2. 深度学习

深度学习是一种允许计算机系统从经验和数据中得到提高的技术,具有强大的识别能力和灵活性. 卷积神经网络(CNN)在深度学习的历史中发挥了重要作用,目前仍然是当今深度学习商业应用的前沿. 典型的卷积神经网络体系结构由卷积层、池化层、回归层组成.

1)卷积层. 使用卷积核,通过对输入图像进行反卷积来优化每个卷积单元的参数,通过逐层卷积运算不断从图像中提取复杂的纹理特征. 卷积运算由于具有稀疏交互、参数共享、等变表示等特性,极大地减少了神经网络的训练参数. 卷积计算结束之后加上一个偏置值,得到卷积神经网络的输出. 卷积层的计算公式可以表示为

式中:

2)池化层. 池化函数使用某一位置的相邻像素总体统计特征来代替网络在该位置的输出,具体操作时,将每个相邻的像素相加以得到一个新像素,然后通过采样函数down,并用标量

3)Softmax回归层. Softmax回归层主要用于解决多分类问题,对于输入

3. 实验结果与讨论

3.1. 三维掌纹数据库

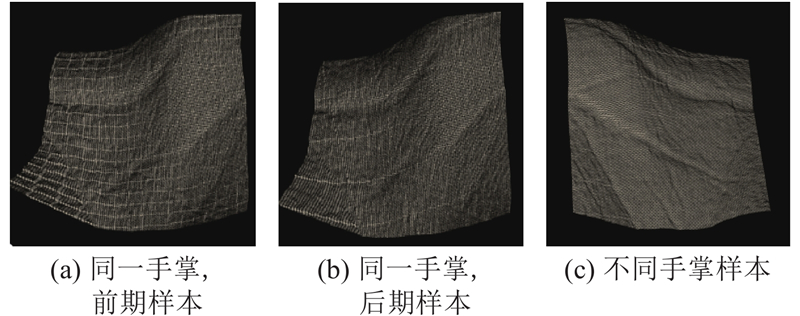

本文使用香港理工三维掌纹数据库[14]进行实验,该数据库总计有400 个不同三维掌纹类别,因此上述4种神经网络的输出为一个400维的向量. 该数据中包括8 000 个不同掌纹,分属200个不同人,其中男性为136 人,女性为64 人,年龄跨度在10~55 岁. 其中单独个人的三维掌纹数据分2次采集,采集时间间隔为1 个月. 每次采集时,记录单独个体左、右手各10 个三维掌纹数据. 同一个体左手或者右手的三维掌纹被视为同一类,总计有400 个不同类别,每一类别包括20 个三维掌纹. 相应地,第2章所述的4种神经网络的输出为一个400维向量. 原始三维掌纹的空间分辨率为768×576,Z方向上的精度为32 bit. 三维掌纹的中心区域(大小为128×128)通过感兴趣区域方法裁剪获得,并将其用于后续的特征提取和识别. 该数据库三维掌纹图像如图5所示,其中图5(a)和(b)来源于同一个手掌的两次不同采集时期,图5(c)则为另外一个手掌(为了便于观察,已经将其视角进行调整).

图 5

图 5 香港理工大学三维掌纹数据库示例图像

Fig.5 Examples from Hong Kong Polytechnic University 3D palmprint database

3.2. 三维掌纹识别实验

识别实验属于一对多(one-against-many)的比较过程,尝试确定输入三维掌纹所归属的类别. 本文识别实验设计如下:首先从每一类中随机挑选N(N=1,2,4,10)个样本作为训练样本(training sample),将该类其他样本视为探测样本(probe sample). 最后通过统计不同方法首选识别率(rank-one recognition rate)R来衡量方法的性能.

表 2 不同三维掌纹识别方法识别准确率比较

Tab.2

Fei等[7]使用精确方向编码和紧凑表面类型的混合表达来提取三维掌纹特征. 为了进行全面的比较,首先在本文方法、文献[5]方法中使用表面类型提取三维掌纹特征,然后在训练样本数量为N=1、2、4、10的条件下,对上述3种方法进行识别实验,如表3所示. 实验结果表明:当训练样本较少时(N=1,2),本文所采用的基于深度学习的掌纹识别方法与文献[7]方法相比较有一定性能差距,但随着训练样本的增加(N=4,10),两者在识别率上的差异并不明显. 另一方面,文献[7]采用2种特征的混合表达来提取三维掌纹,而本文方法仅采用表面类型这一单一特征. 因此,认为采用混合特征提取三维掌纹信息,并将其作为深度学习网络的输入,将进一步提升本文方法的性能,这也是未来的研究方向之一. 同时,由于深度学习网络可以直接输出三维掌纹对于各种类别的概率,在运行时间上本文方法要优于文献[7]方法,更适合一些对实时性要求较高的领域.

表 3 不同训练样本条件下识别准确率比较

Tab.3

3.3. 运行时间分析及不同特征、网络结构的性能讨论

表 4 不同三维掌纹识别方法的运行时间

Tab.4

为了进行全面的比较,对不同的三维特征、不同网络结构的深度学习模型进行三维掌纹识别实验(N=10),如表5、6所示. 可以看出,相比于目前流行的三维掌纹识别方法[5,7,15],不同网络结构的深度学习模型对于不同的三维特征识别准确率都较好,这说明深度学习方法在三维掌纹识别应用中具有普遍的适用性. 随着网络结构的复杂性加大,识别时间也随之增大,如GoogleNet、Vgg16、ResNet50的识别时间要大于AlexNet的识别时间. 值得注意的是,识别准确率并不随着网络结构复杂性的增大而得以提升,究其原因,是香港理工三维掌纹数据库整体样本数量偏少,相对简单的深度学习模型(如:AlexNet)也能获取较好的识别结果,复杂深度学习模型的优势无法体现.

表 5 不同特征、不同网络结构深度学习模型识别准确率对比

Tab.5

| 三维特征 | AlexNet | GoogleNet | Vgg16 | ResNet50 |

| 表面类型 | 99.40 | 99.55 | 99.25 | 99.45 |

| 形状指数 | 99.30 | 99.00 | 97.25 | 98.90 |

| 平均曲率 | 99.20 | 99.15 | 99.55 | 98.80 |

| 高斯曲率 | 98.75 | 96.60 | 97.50 | 96.25 |

表 6 不同特征、不同网络结构深度学习模型运行时间对比

Tab.6

| 三维特征 | AlexNet | GoogleNet | Vgg16 | ResNet50 |

| 表面类型 | 96.562 | 103.896 | 261.432 | 257.531 |

| 形状指数 | 95.865 | 103.812 | 261.175 | 256.421 |

| 平均曲率 | 94.993 | 103.461 | 259.813 | 254.594 |

| 高斯曲率 | 94.352 | 103.153 | 258.231 | 254.451 |

4. 结 语

基于局部纹理特征,本文率先将深度学习引入到三维掌纹识别应用中,并在香港理工三维掌纹数据库上对不同的提取特征、不同网络结构的深度学习模型进行了全面的分析与比较. 实验结果表明:1)本文方法在识别准确率和处理时间上都优于目前流行的三维掌纹识别方法,具有较大的应用前景;2)不同网络结构的深度学习模型在不同提取特征上识别准确率都较好. 这表明本文所提出的深度学习方法在三维掌纹识别应用中具有普遍的适用性. 未来计划研究不同提取特征之间的关联属性,挖掘并利用存在互补关系的特征来实现多特征融合,从而进一步提高模型的识别性能.

参考文献

Palmprint verification based on principal lines

[J].DOI:10.1016/j.patcog.2007.08.016 [本文引用: 1]

Double-orientation code and nonlinear matching scheme for palmprint recognition

[J].

Palmprint and palmvein recognition based on DCNN and a new large-scale contactless palmvein dataset

[J].DOI:10.3390/sym10040078 [本文引用: 1]

基于分块ST与主成分分析的三维掌纹识别

[J].

Three dimensional palmprint identification based on blocked ST and PCA

[J].

3D palmprint identification using block-wise features and collaborative representation

[J].DOI:10.1109/TPAMI.2014.2372764 [本文引用: 12]

3D palmprint recognition using shape index representation and fragile bits

[J].DOI:10.1007/s11042-016-3832-1 [本文引用: 3]

Precision direction and compact surface type representation for 3D palmprint identification

[J].

Person recognition using 3D palmprint data based on full-field sinusoidal fringe projection

[J].DOI:10.1109/TIM.2018.2877226 [本文引用: 1]

A novel 3D palmprint acquisition system

[J].DOI:10.1109/TSMCA.2011.2164066 [本文引用: 1]

Palmprint recognition using 3-D information

[J].DOI:10.1109/TSMCC.2009.2020790 [本文引用: 8]

Discriminative and robust competitive code for palmprint recognition

[J].DOI:10.1109/TSMC.2016.2597291 [本文引用: 3]

Palmprint recognition using neighboring direction indicator

[J].DOI:10.1109/THMS.2016.2586474 [本文引用: 3]