[1]

BOLME D S, BEVERIDGEJ R, DRAPERB A, et al. Visual object tracking using adaptive correlation filters [C]// Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition . San Francisco: IEEE, 2010: 2544-2550.

[本文引用: 1]

[2]

HENRIQUES J F, RUI C, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels [C]// Computer Vision-ECCV 2012 . Florence: Springer, 2012: 702-715.

[本文引用: 1]

[3]

HENRIQUESJ F, CASEIRO R, MARTINS P, et al High-speed tracking with kernelized correlation filters

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2015 , 37 (3 ): 583 - 596

DOI:10.1109/TPAMI.2014.2345390

[本文引用: 2]

[4]

DANELLJAN M, KHAN F S, FELSBERG M. Adaptive color attributes for real-time visual tracking [C]// Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition . Columbus: IEEE, 2014: 1090-1097.

[本文引用: 2]

[6]

BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: complementary learners for real-time tracking [C]// Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition . California: IEEE, 2016: 1401-1409.

[本文引用: 8]

[7]

MA C, HUANG J, YANG X, et al. Hierarchical convolutional features for visual tracking [C]// Proceedings of 2015 IEEE International Conference on Computer Vision . Santiago: IEEE, 2015: 3074-3082.

[本文引用: 2]

[8]

MA C, HUANG J B, YANG X, et al Robust visual tracking via hierarchical convolutional features

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2019 , 41 (11 ): 2709 - 2723

DOI:10.1109/TPAMI.2018.2865311

[本文引用: 2]

[9]

DANELLJAN M, ROBINSON A, KHAN F S, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking [C]// Computer Vision-ECCV 2016 . Amsterdam: Springer, 2016: 472-488.

[本文引用: 6]

[10]

DANELLJAN M, BHAT G, KHAN F S, et al. ECO: efficient convolution operators for tracking [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 6931-6939.

[本文引用: 6]

[11]

DANELLJAN M, HAGER G, KHAN F S, et al Discriminative scale space tracking

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2017 , 39 (8 ): 1561 - 1575

DOI:10.1109/TPAMI.2016.2609928

[本文引用: 1]

[12]

LI Y, ZHU J. A scale adaptive kernel correlation filter tracker with feature integration [C]// Proceedings of 2014 European Conference on Computer Vision . Zurich: Springer, 2014: 254-265.

[本文引用: 1]

[13]

GALOOGAHI H K, FAGG A, LUCEY S. Learning background-aware correlation filters for visual tracking [C]// Proceedings of 2017 IEEE International Conference on Computer Vision . Venice: IEEE, 2017: 1144-1152.

[本文引用: 1]

[14]

LUKEZIC A, VOJIR T, ČEHOVIN L, et al. Discriminative correlation filter with channel and spatial reliability [C]// Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 4847-4856.

[本文引用: 3]

[15]

DANELLJAN M, HAGER G, KHAN F S, et al. Learning spatially regularized correlation filters for visual tracking [C]// Proceedings of 2015 IEEE International Conference on Computer Vision . Santiago: IEEE, 2015: 4310-318.

[本文引用: 2]

[16]

卢维, 项志宇, 于海滨, 刘济林 基于自适应多特征表观模型的目标压缩跟踪

[J]. 浙江大学学报: 工学版 , 2014 , 48 (12 ): 2132 - 2138

[本文引用: 1]

LU Wei, XIANG Zhi-yu, YU Hai-bin, LIU Ji-lin Object compressive tracking based on adaptive multi-feature appearance model

[J]. Journal of Zhejiang University: Engineering Science , 2014 , 48 (12 ): 2132 - 2138

[本文引用: 1]

[17]

WU Y, LIM J, YANG M Object tracking benchmark

[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2015 , 37 (9 ): 1834 - 1848

DOI:10.1109/TPAMI.2014.2388226

[本文引用: 1]

[18]

KRISTAN M, MATAS J, LEONARDIS A, et al. The visual object tracking VOT2016 challenge results [C]// Computer Vision-ECCV 2016 . Amsterdam: Springer, 2016: 777-823.

[本文引用: 1]

[19]

DANELLJAN M, HAGER G, KHAN F S, et al. Convolutional features for correlation filter based visual tracking [C]// Proceedings of the IEEE International Conference on Computer Vision Workshop . Santiago: IEEE, 2015: 621-629.

[本文引用: 1]

[20]

BERTINETTO L, VALMADRE J, HENRIQUESJ F, et al. Fully-convolutional siamese networks for object tracking [C]// Computer Vision-ECCV 2016 . Amsterdam: Springer, 2016: 850-865.

[本文引用: 1]

[21]

VALMADRE J, BERTINETTO L, HENRIQUESJ F, et al. End-to-end representation learning for correlation filter based tracking [C]// Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition . Honolulu: IEEE, 2017: 5000-5008.

[本文引用: 1]

[22]

LI B, YAN J, WU W, et al. High performance visual tracking with siamese region proposal network [C]// Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition . Salt Lake City: IEEE, 2018: 8971-8980.

[本文引用: 1]

[23]

ZHU Z, WANG Q, LI B, et al. Distractor-aware siamese networks for visual object tracking [C]// Computer Vision - ECCV 2018 . Munich: Springer, 2018: 103-119.

[本文引用: 1]

[24]

ZHANG Z, PENG H, WANG Q, et al. Deeper and wider siamese networks for real-time visual tracking [C]// Proceedings of 2019 IEEE Conference on Computer Vision and Pattern Recognition . Long Beach: IEEE, 2019: 4591-4600.

[本文引用: 2]

[25]

FAN H, LING H. Siamese cascaded region proposal networks for real-time visual tracking [C]// Proceedings of 2019 IEEE Conference on Computer Vision and Pattern Recognition . Long Beach: [S. n.], 2019.

[本文引用: 1]

[26]

LI Y, ZHU J, HOI S, et al Robust estimation of similarity transformation for visual object tracking

[J]. AAAI Technical Track: Vision , 2019 , 33 (1 ): 8666 - 8673

[本文引用: 1]

[27]

PU S, SONG Y, MA C, et al. Deep attentive tracking via reciprocative learning [C]// Proceedings of the Conference on Neural Information Processing Systems . Montreal: Neural Information Processing Systems Foundation, 2018: 1931-1941.

[本文引用: 1]

1

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

1

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

High-speed tracking with kernelized correlation filters

2

2015

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 随着目标跟踪领域的发展,许多算法证实了多特征融合表征目标的能力远高于单一特征[5 , 16 ] . 在传统特征中,常选用HOG、CN和颜色直方图特征进行融合. HOG特征描述局部区域提取的目标轮廓和形状信息,可忽略目标的细微变形,对行人跟踪更有效,且对光照有较好的鲁棒性[3 ] . CN特征通过计算11种颜色的分布概率得到全局颜色特征,更易区分背景和目标颜色相差较大的情况,且对目标形变有较好的鲁棒性[4 ] . 根据颜色直方图特征统计前景与背景的颜色分布,计算2种分布的概率得到最终目标特征图预测位置,同样对目标形变的鲁棒性较强[6 ] . ...

2

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 随着目标跟踪领域的发展,许多算法证实了多特征融合表征目标的能力远高于单一特征[5 , 16 ] . 在传统特征中,常选用HOG、CN和颜色直方图特征进行融合. HOG特征描述局部区域提取的目标轮廓和形状信息,可忽略目标的细微变形,对行人跟踪更有效,且对光照有较好的鲁棒性[3 ] . CN特征通过计算11种颜色的分布概率得到全局颜色特征,更易区分背景和目标颜色相差较大的情况,且对目标形变有较好的鲁棒性[4 ] . 根据颜色直方图特征统计前景与背景的颜色分布,计算2种分布的概率得到最终目标特征图预测位置,同样对目标形变的鲁棒性较强[6 ] . ...

自适应特征融合的核相关滤波跟踪算法

3

2017

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 随着目标跟踪领域的发展,许多算法证实了多特征融合表征目标的能力远高于单一特征[5 , 16 ] . 在传统特征中,常选用HOG、CN和颜色直方图特征进行融合. HOG特征描述局部区域提取的目标轮廓和形状信息,可忽略目标的细微变形,对行人跟踪更有效,且对光照有较好的鲁棒性[3 ] . CN特征通过计算11种颜色的分布概率得到全局颜色特征,更易区分背景和目标颜色相差较大的情况,且对目标形变有较好的鲁棒性[4 ] . 根据颜色直方图特征统计前景与背景的颜色分布,计算2种分布的概率得到最终目标特征图预测位置,同样对目标形变的鲁棒性较强[6 ] . ...

... 特征融合一般分为特征层融合、响应层融合和决策层融合三类. 特征层融合是指使用多个特征融合的特征向量训练相关滤波器进行目标跟踪[14 ] . 响应层融合是将不同特征的相关滤波响应值进行融合后取响应值最大处为目标位置[9 ] . 决策层融合是通过融合多个特征预测的多个目标位置得到最终的目标跟踪位置[5 ] . 不同特征拥有不同的提取方法及功能特点,其所对应的特征向量和相关滤波响应的维度大小不同,将不同特征的向量或响应值转换为统一大小再进行融合是常用做法. 不过,文献[10 ]使用新的融合方法,保持不同特征向量原有大小不变,通过中心融合方法将两者结合. ...

自适应特征融合的核相关滤波跟踪算法

3

2017

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 随着目标跟踪领域的发展,许多算法证实了多特征融合表征目标的能力远高于单一特征[5 , 16 ] . 在传统特征中,常选用HOG、CN和颜色直方图特征进行融合. HOG特征描述局部区域提取的目标轮廓和形状信息,可忽略目标的细微变形,对行人跟踪更有效,且对光照有较好的鲁棒性[3 ] . CN特征通过计算11种颜色的分布概率得到全局颜色特征,更易区分背景和目标颜色相差较大的情况,且对目标形变有较好的鲁棒性[4 ] . 根据颜色直方图特征统计前景与背景的颜色分布,计算2种分布的概率得到最终目标特征图预测位置,同样对目标形变的鲁棒性较强[6 ] . ...

... 特征融合一般分为特征层融合、响应层融合和决策层融合三类. 特征层融合是指使用多个特征融合的特征向量训练相关滤波器进行目标跟踪[14 ] . 响应层融合是将不同特征的相关滤波响应值进行融合后取响应值最大处为目标位置[9 ] . 决策层融合是通过融合多个特征预测的多个目标位置得到最终的目标跟踪位置[5 ] . 不同特征拥有不同的提取方法及功能特点,其所对应的特征向量和相关滤波响应的维度大小不同,将不同特征的向量或响应值转换为统一大小再进行融合是常用做法. 不过,文献[10 ]使用新的融合方法,保持不同特征向量原有大小不变,通过中心融合方法将两者结合. ...

8

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 随着目标跟踪领域的发展,许多算法证实了多特征融合表征目标的能力远高于单一特征[5 , 16 ] . 在传统特征中,常选用HOG、CN和颜色直方图特征进行融合. HOG特征描述局部区域提取的目标轮廓和形状信息,可忽略目标的细微变形,对行人跟踪更有效,且对光照有较好的鲁棒性[3 ] . CN特征通过计算11种颜色的分布概率得到全局颜色特征,更易区分背景和目标颜色相差较大的情况,且对目标形变有较好的鲁棒性[4 ] . 根据颜色直方图特征统计前景与背景的颜色分布,计算2种分布的概率得到最终目标特征图预测位置,同样对目标形变的鲁棒性较强[6 ] . ...

... ECOhc算法结合HOG与CN特征的外观与颜色、局部与全局的互补特性预测目标位置,跟踪精度较高,但HOG与CN均是基于相关滤波的模板特征,无法应对边界效应带来的影响,所以在跟踪快速运动的目标时易失败. 为了解决边界效应,Staple[6 ] 算法提取统计类颜色直方图特征代替CN特征,利用积分图方法计算目标匹配概率预测目标位置. 为了获得更加鲁棒的跟踪算法,本研究算法采用HOG、CN和颜色直方图这3种特征进行多级融合. 其中,HOG和CN特征采用特征层中心融合方法预测目标位置 ${p_{{\rm{hc}}}}$ 6 ]提取颜色直方图特征后,加入余弦窗消除边界背景的影响,得到预测目标位置 ${p_{{\rm{his}}}}$

... ;在按文献[6 ]提取颜色直方图特征后,加入余弦窗消除边界背景的影响,得到预测目标位置 ${p_{{\rm{his}}}}$

... 实验的硬件平台配置为Intel Core i7-4790K CPU,内存为16 GB的台式电脑,软件平台为ubuntu16.04系统下的MATLAB R2015b. 实验在ECOhc算法的软件基础上进行改进,针对不同的测试数据调整相应参数. 在数据集OTB-100上,调整参数如下:搜索区域尺度因子为3.5,共轭梯度迭代次数为2,初始化高斯牛顿迭代次数为3,降维后的CN特征维度为2,滤波器更新间隔为2. 其余参数与ECOhc算法一致,颜色直方图特征提取的参数与文献[6 ]一致. ...

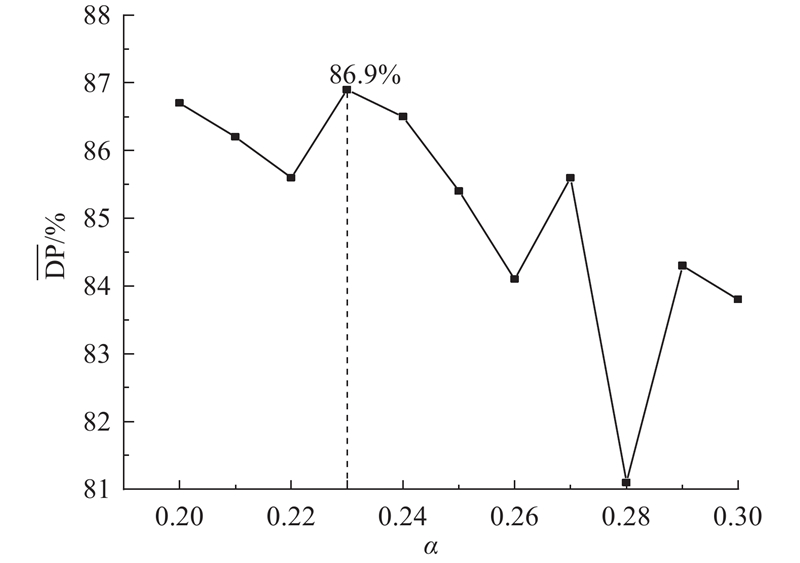

... 在数据集OTB-100上验证多特征融合策略,并找到最优位置融合因子. 使用文献[6 ]所提方法提取颜色直方图特征并计算特征响应值. 考虑到积分图法求得的响应值较大,且颜色直方图忽略了颜色的空间信息,文献[6 ]中给予颜色直方图特征较小的融合权重,基于此,本研究位置融合因子设为[0.2,0.3],以0.01为间隔进行实验,结果如图4 所示. 图中, $\overline {\rm{DP}}$ $\alpha {\rm{ = }}0.23$ $ \overline {\rm{DP}}$

... ]所提方法提取颜色直方图特征并计算特征响应值. 考虑到积分图法求得的响应值较大,且颜色直方图忽略了颜色的空间信息,文献[6 ]中给予颜色直方图特征较小的融合权重,基于此,本研究位置融合因子设为[0.2,0.3],以0.01为间隔进行实验,结果如图4 所示. 图中, $\overline {\rm{DP}}$ $\alpha {\rm{ = }}0.23$ $ \overline {\rm{DP}}$

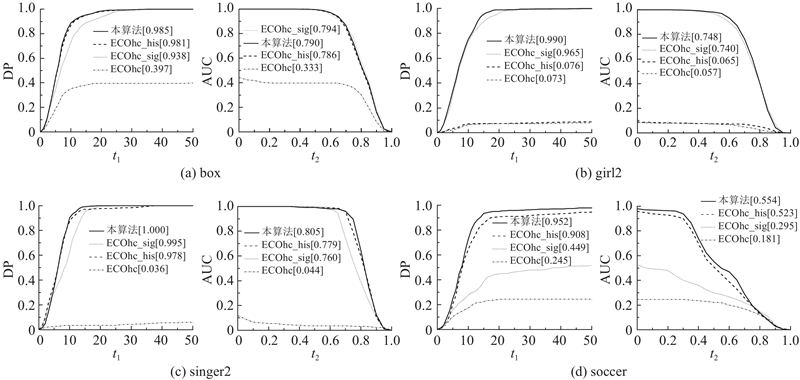

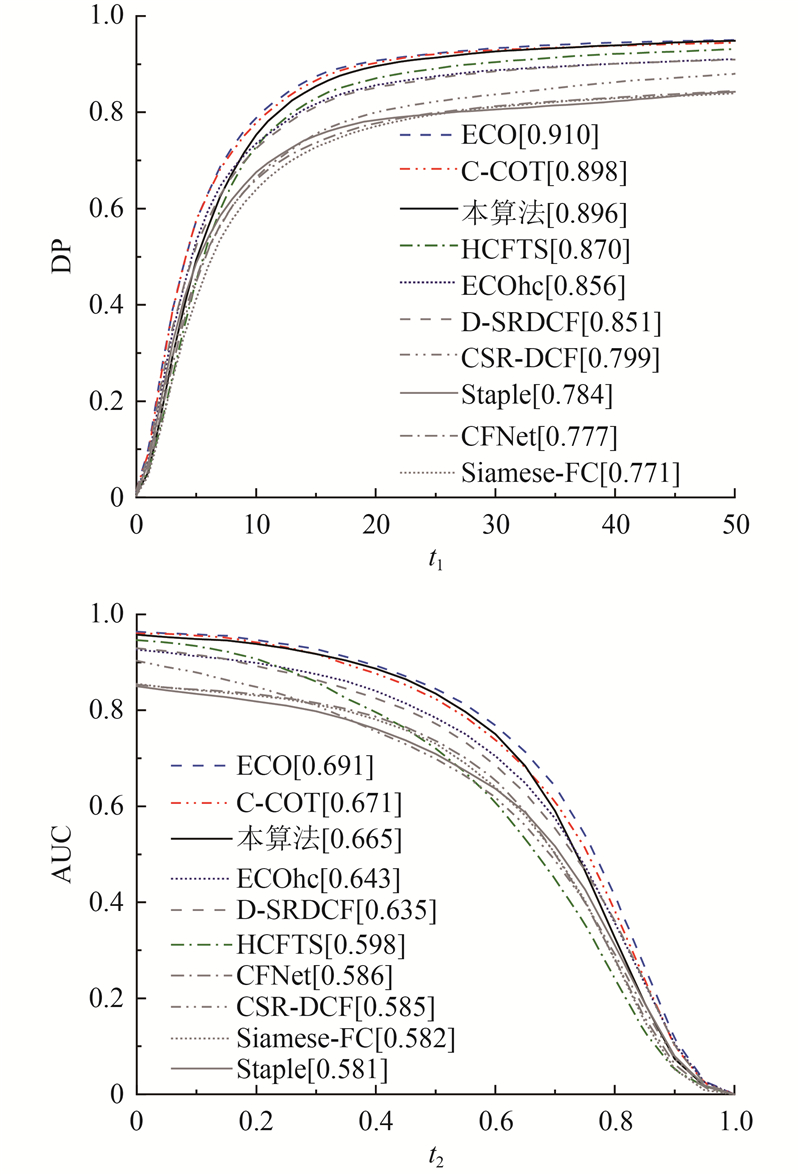

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

2

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 尽管相关滤波跟踪算法取得了长足的进步,然而现有算法在跟踪速度和精度上仍存在较大的矛盾. 跟踪精度较高的算法速度较慢,跟踪速度较快的算法精度较低,如何使两者达到更好的平衡值得深入研究. 使用HOG和CN特征的有效卷积操作(efficient convolution operators with HOG and CN,ECOhc)[10 ] 算法的速度为60帧/s,精度为85.6%,优于部分卷积特征跟踪算法[7 , 15 ] . 为了进一步提高ECOhc算法的跟踪精度,在根据目标形状选择形状比合适的高斯带宽因子后,使用新的高斯函数求取目标期望值用于训练相关滤波器,得到更优的目标位置;提取颜色直方图特征得到前景、背景概率图以预测目标新位置,将2个新位置进行加权融合得到最终目标位置. ...

Robust visual tracking via hierarchical convolutional features

2

2019

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

6

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... [9 ]提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 相关滤波跟踪方法主要是利用显著特征训练稳定的相关滤波器完成跟踪目标的任务,所以滤波器的性能决定跟踪目标的精确度. 训练更新相关滤波器 ${{f}}$ $E({{f}}{\rm{)}}$ ${{{y}}_j}$ ${{{u}}_j}$ ${{{u}}_j}$ $g$ $\exp\; ( - {({{t}} - {{{u}}_j})^2}/(2{\sigma ^2}))$ ${{t}}$ $\sigma $ [9 ] . ${{{y}}_j}$ ${{{S}}_{{f}}}({{{x}}_j})$ ${{{y}}_j}$ $\sigma $ ${{{y}}_j}$ $\sigma $ $\sigma $

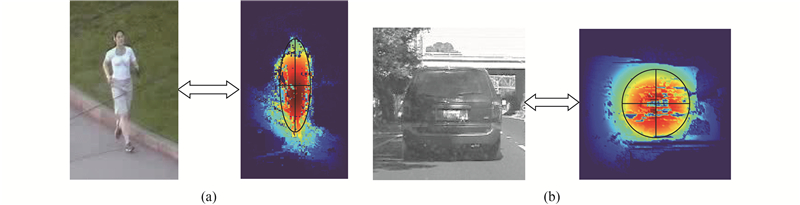

... 一般算法通过调节 $\sigma $ ${{{y}}_j}$ [9 ] . 但是实际跟踪的目标千差万别,其最显著的特点是长宽比分配不同. 不同长宽比的目标具有的特征分布特点差别较大,如图2 所示,以人为例的长条形目标特征在横轴上分布集中于中心,而在纵轴上分布较为分散,呈现出各向异性;以车为例的方形目标在横、纵坐标方向上分布相似,呈现出各向同性. 针对此种情况,仍使用传统的高斯函数会存在偏差. 为了充分发挥高斯函数求取期望输出值的优势,且在更大程度上使用目标的长宽比特征,引入各向异性的二维高斯标签函数: ...

... 特征融合一般分为特征层融合、响应层融合和决策层融合三类. 特征层融合是指使用多个特征融合的特征向量训练相关滤波器进行目标跟踪[14 ] . 响应层融合是将不同特征的相关滤波响应值进行融合后取响应值最大处为目标位置[9 ] . 决策层融合是通过融合多个特征预测的多个目标位置得到最终的目标跟踪位置[5 ] . 不同特征拥有不同的提取方法及功能特点,其所对应的特征向量和相关滤波响应的维度大小不同,将不同特征的向量或响应值转换为统一大小再进行融合是常用做法. 不过,文献[10 ]使用新的融合方法,保持不同特征向量原有大小不变,通过中心融合方法将两者结合. ...

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

6

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... [10 ]提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 尽管相关滤波跟踪算法取得了长足的进步,然而现有算法在跟踪速度和精度上仍存在较大的矛盾. 跟踪精度较高的算法速度较慢,跟踪速度较快的算法精度较低,如何使两者达到更好的平衡值得深入研究. 使用HOG和CN特征的有效卷积操作(efficient convolution operators with HOG and CN,ECOhc)[10 ] 算法的速度为60帧/s,精度为85.6%,优于部分卷积特征跟踪算法[7 , 15 ] . 为了进一步提高ECOhc算法的跟踪精度,在根据目标形状选择形状比合适的高斯带宽因子后,使用新的高斯函数求取目标期望值用于训练相关滤波器,得到更优的目标位置;提取颜色直方图特征得到前景、背景概率图以预测目标新位置,将2个新位置进行加权融合得到最终目标位置. ...

... 特征融合一般分为特征层融合、响应层融合和决策层融合三类. 特征层融合是指使用多个特征融合的特征向量训练相关滤波器进行目标跟踪[14 ] . 响应层融合是将不同特征的相关滤波响应值进行融合后取响应值最大处为目标位置[9 ] . 决策层融合是通过融合多个特征预测的多个目标位置得到最终的目标跟踪位置[5 ] . 不同特征拥有不同的提取方法及功能特点,其所对应的特征向量和相关滤波响应的维度大小不同,将不同特征的向量或响应值转换为统一大小再进行融合是常用做法. 不过,文献[10 ]使用新的融合方法,保持不同特征向量原有大小不变,通过中心融合方法将两者结合. ...

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

... [10 ]、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

Discriminative scale space tracking

1

2017

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

1

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

1

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

3

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 特征融合一般分为特征层融合、响应层融合和决策层融合三类. 特征层融合是指使用多个特征融合的特征向量训练相关滤波器进行目标跟踪[14 ] . 响应层融合是将不同特征的相关滤波响应值进行融合后取响应值最大处为目标位置[9 ] . 决策层融合是通过融合多个特征预测的多个目标位置得到最终的目标跟踪位置[5 ] . 不同特征拥有不同的提取方法及功能特点,其所对应的特征向量和相关滤波响应的维度大小不同,将不同特征的向量或响应值转换为统一大小再进行融合是常用做法. 不过,文献[10 ]使用新的融合方法,保持不同特征向量原有大小不变,通过中心融合方法将两者结合. ...

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

2

... 视频跟踪是计算机视觉技术的重要分支之一,被广泛应用于智能驾驶、人机交互和运动分析等领域. 近年来,相关滤波跟踪方法[1 ] 因其计算高效性得以快速发展. Henriques等[2 ] 提出利用循环矩阵进行稠密采样的相关滤波,以提升跟踪性能,但其仅使用灰度特征表征目标,在目标和背景灰度特征相似时易发生跟丢情况. 为了改善目标表观模型,陆续出现使用方向梯度直方图(histogram of oriented gradient,HOG)特征[3 ] 、颜色属性特征(color names,CN)[4 ] 、融合HOG和CN特征[5 ] 、融合HOG和颜色直方图特征[6 ] 、融合多层卷积特征[7 -8 ] 、融合卷积特征和传统特征[9 -10 ] 的相关滤波跟踪算法. 随着新特征的引入,相关滤波跟踪算法的精度得到较大提升. 为了提高预测目标框与真实目标框的重叠率,研究者们引入尺度估计算法. Danelljan等[11 ] 提出判别式尺度空间跟踪算法,快速估计目标尺度,使目标具有更好的重叠率;Li等[12 ] 设计基于特征融合的尺度自适应核相关滤波跟踪算法,采用尺度池技术估计最佳目标尺度,使得尺度预测和跟踪性能都有较大的提升. 以上算法在特征选择和尺度预测方面进行深入研究并取得了较好的结果,但在跟踪过程中使用循环矩阵近似采样易引起边界效应,影响跟踪精度的提升. Galoogahi等[13 ] 设计背景感知相关滤波器,能有效解决循环移位产生的边界效应,提高滤波器的跟踪性能;Lukezic等[14 ] 引入颜色直方图特征进行空域可靠性判断,让滤波器仅学习颜色特征较显著的部分来缓解边界效应;Danelljan等[15 ] 提出学习空间正则化判别相关滤波器(spatially regularized discriminative correlation filters,SRDCF)用于视觉跟踪来缓解边界效应. 为了进一步提高相关滤波算法的性能,Danelljan等[9 ] 提出学习连续卷积操作器(continuous convolution operators tracker,C-COT)用于视觉跟踪,并融合卷积、HOG和CN特征提高跟踪精度,但提取卷积特征的过程较为复杂导致跟踪速度较慢;为了提高跟踪速度,Danelljan等[10 ] 提出有效卷积操作(efficient convolution operators,ECO)算法,引入因式分解、稀疏更新,同时改变训练样本分布,提升算法的速度和精度. ...

... 尽管相关滤波跟踪算法取得了长足的进步,然而现有算法在跟踪速度和精度上仍存在较大的矛盾. 跟踪精度较高的算法速度较慢,跟踪速度较快的算法精度较低,如何使两者达到更好的平衡值得深入研究. 使用HOG和CN特征的有效卷积操作(efficient convolution operators with HOG and CN,ECOhc)[10 ] 算法的速度为60帧/s,精度为85.6%,优于部分卷积特征跟踪算法[7 , 15 ] . 为了进一步提高ECOhc算法的跟踪精度,在根据目标形状选择形状比合适的高斯带宽因子后,使用新的高斯函数求取目标期望值用于训练相关滤波器,得到更优的目标位置;提取颜色直方图特征得到前景、背景概率图以预测目标新位置,将2个新位置进行加权融合得到最终目标位置. ...

基于自适应多特征表观模型的目标压缩跟踪

1

2014

... 随着目标跟踪领域的发展,许多算法证实了多特征融合表征目标的能力远高于单一特征[5 , 16 ] . 在传统特征中,常选用HOG、CN和颜色直方图特征进行融合. HOG特征描述局部区域提取的目标轮廓和形状信息,可忽略目标的细微变形,对行人跟踪更有效,且对光照有较好的鲁棒性[3 ] . CN特征通过计算11种颜色的分布概率得到全局颜色特征,更易区分背景和目标颜色相差较大的情况,且对目标形变有较好的鲁棒性[4 ] . 根据颜色直方图特征统计前景与背景的颜色分布,计算2种分布的概率得到最终目标特征图预测位置,同样对目标形变的鲁棒性较强[6 ] . ...

基于自适应多特征表观模型的目标压缩跟踪

1

2014

... 随着目标跟踪领域的发展,许多算法证实了多特征融合表征目标的能力远高于单一特征[5 , 16 ] . 在传统特征中,常选用HOG、CN和颜色直方图特征进行融合. HOG特征描述局部区域提取的目标轮廓和形状信息,可忽略目标的细微变形,对行人跟踪更有效,且对光照有较好的鲁棒性[3 ] . CN特征通过计算11种颜色的分布概率得到全局颜色特征,更易区分背景和目标颜色相差较大的情况,且对目标形变有较好的鲁棒性[4 ] . 根据颜色直方图特征统计前景与背景的颜色分布,计算2种分布的概率得到最终目标特征图预测位置,同样对目标形变的鲁棒性较强[6 ] . ...

Object tracking benchmark

1

2015

... 为了验证本研究算法的有效性,分别在标准数据集OTB-100[17 ] 、VOT2016[18 ] 上进行测试. 数据集OTB-100有100组视频序列,其中74个为彩色图,26个为灰度图;跟踪目标主要有36个人体、26个人脸或头部,其余目标为汽车、玩具等物体;数据集OTB-100中视频的长短不一,包括短时跟踪和长时跟踪的视频序列;在跟踪难度上,数据集OTB-100中包括11种跟踪问题:光照变化(illumination variation)、尺度变化(scale variation)、遮挡(occlusion)、形变(deformation)、运动模糊(motion blur)、快速运动(fast motion)、平面内旋转(in-plane rotation)、平面外旋转(out-of-plane rotation)、出视野(out-of-view)、背景杂波(background clutters)、低分辨率(low resolution);主要通过计算中心位置误差(center local error,CLE)、距离精度(distance precision,DP)、重叠精度(overlap precision,OP)和成功曲线下的面积(area under curve of success plot,AUC)评估跟踪算法的性能. 其中,重叠精度即重叠率. 数据集VOT2016是视频跟踪大赛的官方数据集,有60组视频,分辨率普遍较高,且均属于彩色视频短时跟踪,在跟踪过程中也存在实际场景中的遮挡、背景杂波等问题,根据期望平均重叠率(expect average overlap rate,EAO)、精确性(accuracy)和鲁棒性(robustness)评估跟踪算法的整体性能. 2种数据集的素材取自各种实际环境,含有各种实际跟踪问题,能有效模拟实际跟踪过程. 选用数据集OTB-100、VOT2016可有效测试算法的性能. ...

1

... 为了验证本研究算法的有效性,分别在标准数据集OTB-100[17 ] 、VOT2016[18 ] 上进行测试. 数据集OTB-100有100组视频序列,其中74个为彩色图,26个为灰度图;跟踪目标主要有36个人体、26个人脸或头部,其余目标为汽车、玩具等物体;数据集OTB-100中视频的长短不一,包括短时跟踪和长时跟踪的视频序列;在跟踪难度上,数据集OTB-100中包括11种跟踪问题:光照变化(illumination variation)、尺度变化(scale variation)、遮挡(occlusion)、形变(deformation)、运动模糊(motion blur)、快速运动(fast motion)、平面内旋转(in-plane rotation)、平面外旋转(out-of-plane rotation)、出视野(out-of-view)、背景杂波(background clutters)、低分辨率(low resolution);主要通过计算中心位置误差(center local error,CLE)、距离精度(distance precision,DP)、重叠精度(overlap precision,OP)和成功曲线下的面积(area under curve of success plot,AUC)评估跟踪算法的性能. 其中,重叠精度即重叠率. 数据集VOT2016是视频跟踪大赛的官方数据集,有60组视频,分辨率普遍较高,且均属于彩色视频短时跟踪,在跟踪过程中也存在实际场景中的遮挡、背景杂波等问题,根据期望平均重叠率(expect average overlap rate,EAO)、精确性(accuracy)和鲁棒性(robustness)评估跟踪算法的整体性能. 2种数据集的素材取自各种实际环境,含有各种实际跟踪问题,能有效模拟实际跟踪过程. 选用数据集OTB-100、VOT2016可有效测试算法的性能. ...

1

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

1

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

1

... 为了进一步验证本研究所提算法性能的优越性,选取9种经典跟踪算法进行对比,分别为ECO[10 ] 、ECOhc[10 ] 、C-COT[9 ] 、HCFTS[8 ] 、CSR-DCF[14 ] 、D_SRDCF[19 ] 、Staple[6 ] 、Siamese-FC[20 ] 和CFNet[21 ] . 其中,ECOhc、Staple、CSR-DCF这3种算法为采用多种传统特征融合的相关滤波算法,ECO、C-COT、HCFTS、D_SRDCF这4种算法为使用深度卷积特征的相关滤波算法,Siamese-FC、CFNet这2种算法为使用孪生网络的跟踪算法. ...

1

... 如表3 所示为所提算法与近年的跟踪算法的对比结果. 其中,SiamRPN[22 ] 、DaSiamRPN[23 ] 、SiamFC+CIR[24 ] 、SiamRPN+CIR[24 ] 、C-RPN[25 ] 为现阶段最流行的孪生网络跟踪算法;LDES[26 ] 算法在相关滤波的基础上增加了对大位移相似变换的鲁棒性估计;DAT[27 ] 是利用视觉注意机制训练深度分类器的跟踪算法. 可以看出,本研究所提算法在 $\overline{\rm{DP}} $ $\overline{\rm{AUC}} $

1

... 如表3 所示为所提算法与近年的跟踪算法的对比结果. 其中,SiamRPN[22 ] 、DaSiamRPN[23 ] 、SiamFC+CIR[24 ] 、SiamRPN+CIR[24 ] 、C-RPN[25 ] 为现阶段最流行的孪生网络跟踪算法;LDES[26 ] 算法在相关滤波的基础上增加了对大位移相似变换的鲁棒性估计;DAT[27 ] 是利用视觉注意机制训练深度分类器的跟踪算法. 可以看出,本研究所提算法在 $\overline{\rm{DP}} $ $\overline{\rm{AUC}} $

2

... 如表3 所示为所提算法与近年的跟踪算法的对比结果. 其中,SiamRPN[22 ] 、DaSiamRPN[23 ] 、SiamFC+CIR[24 ] 、SiamRPN+CIR[24 ] 、C-RPN[25 ] 为现阶段最流行的孪生网络跟踪算法;LDES[26 ] 算法在相关滤波的基础上增加了对大位移相似变换的鲁棒性估计;DAT[27 ] 是利用视觉注意机制训练深度分类器的跟踪算法. 可以看出,本研究所提算法在 $\overline{\rm{DP}} $ $\overline{\rm{AUC}} $

... [24 ]、C-RPN[25 ] 为现阶段最流行的孪生网络跟踪算法;LDES[26 ] 算法在相关滤波的基础上增加了对大位移相似变换的鲁棒性估计;DAT[27 ] 是利用视觉注意机制训练深度分类器的跟踪算法. 可以看出,本研究所提算法在 $\overline{\rm{DP}} $ $\overline{\rm{AUC}} $

1

... 如表3 所示为所提算法与近年的跟踪算法的对比结果. 其中,SiamRPN[22 ] 、DaSiamRPN[23 ] 、SiamFC+CIR[24 ] 、SiamRPN+CIR[24 ] 、C-RPN[25 ] 为现阶段最流行的孪生网络跟踪算法;LDES[26 ] 算法在相关滤波的基础上增加了对大位移相似变换的鲁棒性估计;DAT[27 ] 是利用视觉注意机制训练深度分类器的跟踪算法. 可以看出,本研究所提算法在 $\overline{\rm{DP}} $ $\overline{\rm{AUC}} $

Robust estimation of similarity transformation for visual object tracking

1

2019

... 如表3 所示为所提算法与近年的跟踪算法的对比结果. 其中,SiamRPN[22 ] 、DaSiamRPN[23 ] 、SiamFC+CIR[24 ] 、SiamRPN+CIR[24 ] 、C-RPN[25 ] 为现阶段最流行的孪生网络跟踪算法;LDES[26 ] 算法在相关滤波的基础上增加了对大位移相似变换的鲁棒性估计;DAT[27 ] 是利用视觉注意机制训练深度分类器的跟踪算法. 可以看出,本研究所提算法在 $\overline{\rm{DP}} $ $\overline{\rm{AUC}} $

1

... 如表3 所示为所提算法与近年的跟踪算法的对比结果. 其中,SiamRPN[22 ] 、DaSiamRPN[23 ] 、SiamFC+CIR[24 ] 、SiamRPN+CIR[24 ] 、C-RPN[25 ] 为现阶段最流行的孪生网络跟踪算法;LDES[26 ] 算法在相关滤波的基础上增加了对大位移相似变换的鲁棒性估计;DAT[27 ] 是利用视觉注意机制训练深度分类器的跟踪算法. 可以看出,本研究所提算法在 $\overline{\rm{DP}} $ $\overline{\rm{AUC}} $