受装配空间的限制,智能手机的镜头设计大都采用单摄像头方案或光轴互相平行的非对称双焦摄像头方案. 主流双焦摄像头变焦方案只有长焦和短焦工作模式,对于长、短焦镜头倍数之间的任意变焦倍数,大多数方法都是基于插值法或传统单帧超分辨方法来完成变焦. 这些方法无法有效利用长焦图像的高频细节,导致所得变焦图像的边缘锐利度不够,被拍摄景物的纹理细节不能得到有效还原. 为了充分利用长焦图像的高频细节,充分提升变焦倍数在双镜头变焦倍数之间时变焦图像的视觉清晰度,需要研究非对称双摄像头的数字变焦方案.

目前,多数手机厂商采用的双焦相机连续变焦方案都是基于传统的像素插值技术,例如双三次插值、基于机器学习或基于卷积神经网络的单帧图像超分辨技术. Yang等[1-4]]提出了一些基于统计学习的单帧超分辨方法,这些方法通常需要预先使用大量数据训练高低分辨字典对,利用预训练好的字典对进行超分辨工作. 相对于传统插值方法,这些超分辨方法可以获得分辨率更高、更加自然的图像. 近几年,卷积神经网络在很多领域都表现出十分优秀的性能,一些研究者将卷积神经网络应用在了单帧超分辨工作上[5-7]. 相较于上文提到的基于统计学习的超分辨结果,利用超分辨网络获得的超分辨图像的分辨率和自然程度有了进一步的提升,不过超分辨网络的工作对硬件性能的要求也更高.

有研究者基于智能手机双焦镜头连续变焦的应用背景,针对性地提出了基于长焦图像和短焦图像的变焦方案. Yu等[8]利用配准和块搜索的策略,对长焦视场内的图像进行分辨率提升. 对于处于长焦视场外、短焦视场内的部分,则使用传统的单帧超分辨方法进行处理. Moon等[9]在配准长短焦图像后,提出了长焦图像到短焦图像的退化模型,估计退化点扩散函数(point spread function, PSF),并以此为依据使用传统的图像恢复算法进行图像复原. Ma等[10]在配准的基础上,将长焦和短焦图像进行频带分解,在每个频带内使用图像修复的方法[11],利用长焦图像的清晰纹理对短焦图相似纹理进行修复,并进一步得到变焦图像. Chen等[12]将VDSR超分辨网络作了一些修改,使其能够胜任双分辨变焦任务并且比传统的超分辨网络获得更好的视觉效果和更高的定量评价指标.

以上方法中,单帧超分辨技术虽然可以获得比插值方法更锐利的边界和更舒适的视觉效果,但若将其应用于双焦相机连续变焦,则不能有效地利用长焦图像的高频细节,景物的纹理细节不够丰富. 基于长、短焦图像的变焦算法可以获得比单帧超分辨方法更好的恢复效果,但其变焦图像在长焦视场内的细节清晰度无法和长焦图像相比,长焦视场外的效果则和单帧超分辨方法相差无几.

1. 实验原理

1.1. 非对称双焦相机成像模型

非对称双焦摄像头一般指2个光轴平行放置的镜头,两者焦距成一定比例,一般为2∶1~3∶1. 为了阐述方便,设定长焦镜头和短焦镜头焦距之比N=2∶1. 两者的视场角也成相应的倍数关系. 其中焦距较短的短焦镜头拥有更大的视场范围,可以完成一般的成像任务. 当用户希望拍摄远处景物的局部细节时,可切换到长焦工作模式,此时拍摄视场角变小,由于物方空间采样率更高,景物的细节可以更多地被还原.

长、短焦镜头对应的2个成像传感器一般拥有相近或相同的成像面积和像素数. 由于焦距的倍数关系,其视场角通常也成倍数关系. 根据几何关系可以得出,该比例近似和焦距比相同. 即短焦图像(记为

容易得到:

其中,

此时变焦图的视场大小变为短焦图的

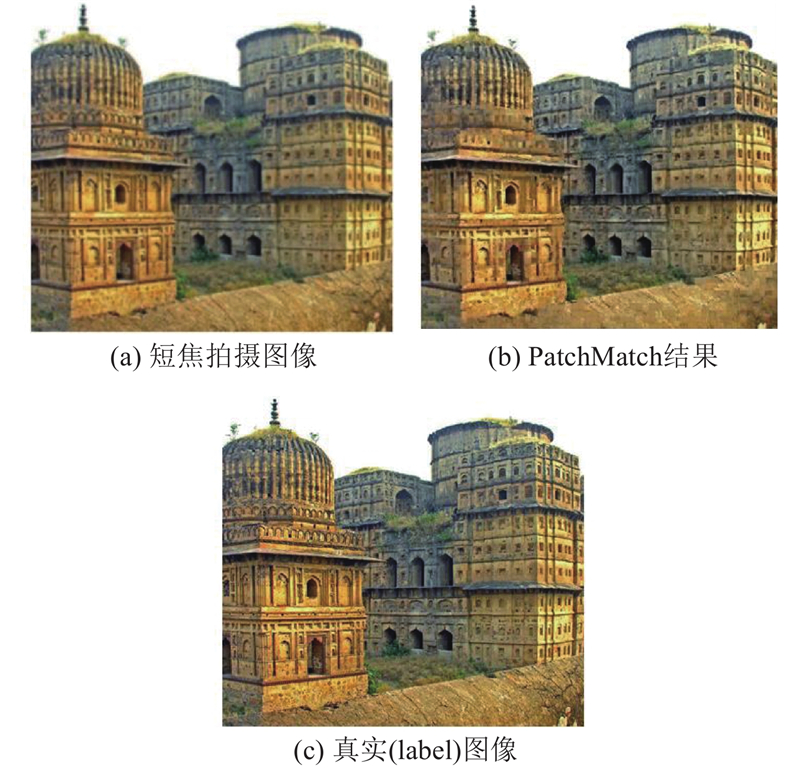

图 1

图 1 应用块匹配(PatchMatch)对仿真图像进行纹理修复

Fig.1 Texture restoring results of stimulated images with PatchMatch method

1.2. 所提方法流程

假设

上采样后得到的图像

式中:H、W为原始短焦(或长焦)图像的高和宽,M为用户给定的变焦倍数,HSUC和WSUC为裁剪图像的高和宽. 按照式(5)裁剪

式中:HZ和WZ分别为最终变焦结果图IZ的高和宽. 下采样后得到所需的变焦图像

2. 基于特征提取的短焦图像细节恢复

借鉴文献[13]中用到的特征块提取和优化策略,将长焦图像

图 2

图 2 非对称双焦摄像头典型成像模型示意图

Fig.2 Schematic diagram of classical asymmetric dual zooming imaging model

式(7)中的损失函数共由三部分组成.

式中:

其中,

从

即当欧几里得距离

为了平衡各部分损失函数,在式(7)中加入

第2章所述算法都在图像特征层上进行。若直接在原图像上进行操作,会引起严重的块效应,结果图中会出现网格状纹理,如图2所示。

3. 实验结果与分析

3.1. 仿真实验

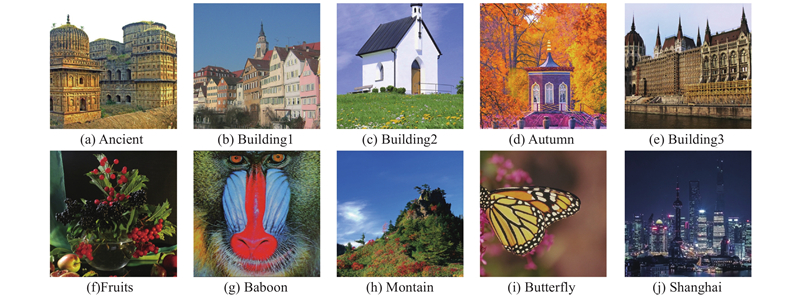

仿真实验选取如图3所示的自然景物图像,这些图像经过裁剪作为真实(label)图像,图像尺寸均为

图 3

使用本文框架编写代码,进行仿真实验. 计算机配置如下:处理器:Intel(R) Core(TM) i5-7500 @3.40 GHz (4核),RAM:8 GB DDR4,显卡:NVIDIA GeForce GTX 1050Ti,显存:4 GB DDR5. 将本文的处理结果同基于传统插值的处理结果以及基于单图像超分辨方法[2](A+)的处理结果进行对比.

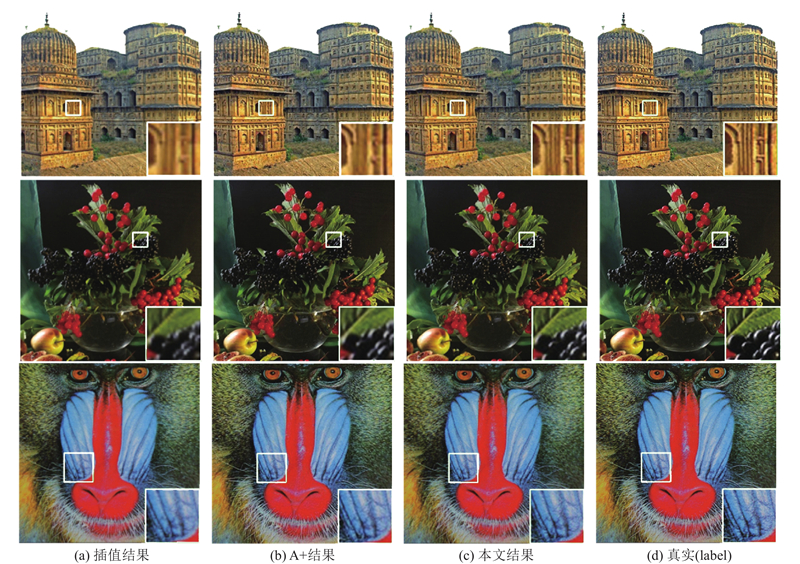

图 4

图 4 本文细节修复方法与其他方法的仿真结果对比

Fig.4 Comparison of stimulation results for proposed texture restoring method and other methods

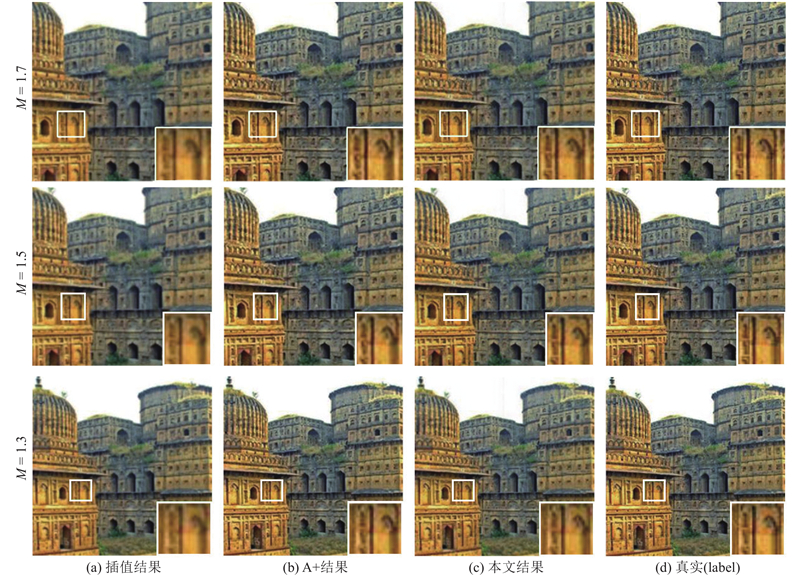

对本文提出的一整套变焦算法流程进行仿真实验,实验结果如图5所示. 可以看到,相比使用传统的插值算法得到的变焦图像,以及仅利用单幅短焦图像使用单帧超分辨算法[2]进行上采样和裁剪得到的变焦图像而言,利用本文方法得到的变焦图像可以更好地还原被拍摄景物的纹理细节,边缘也更加锐利自然,视觉观感更好. 但是随着变焦倍数的不断下降,本文方法的修复效果越来越接近于插值图像、单帧超分辨结果图像以及真实图像,这是数字变焦工作的必然结果. 由于手机双焦摄像头的成像质量通常受到成像单元像素尺寸的限制,为了得到与原拍摄图像像素数相同的变焦图像,将含有高频细节的短焦修复图像

图 5

图 5 不同变焦倍数、采用不同方法的变焦结果对比

Fig.5 Comparison of zooming results for different zooming scales using different methods

使用定量评价指标峰值信噪比(peak signal to noise ratio, PSNR)对各变焦倍率图像质量进行评价,结果如表1所示. 从表中可以看出,在PSNR指标上,本文处理结果要优于传统插值方法,但部分情况下其PSNR值低于基于单帧图像的超分辨方法,尤其是在变焦倍数较低时. 可能原因如下:一是如前文所述,变焦处理流程包含了下采样处理,在下采样过程中,已被修复的高频细节可能会有所丢失;二是细节修复的过程基于迭代块处理,并且是在较高的特征层上进行,纹理在被迁移的过程中有可能产生微小位移或形变.

表 1 仿真实验变焦结果定量评价

Tab.1

| 图像 | M =1.3 | M =1.5 | M =1.7 | ||||||||

| 双线性插值 | A+ | 本文方法 | 双线性插值 | A+ | 本文方法 | 双线性插值 | A+ | 本文方法 | |||

| Ancient | 27.45 | 29.81 | 27.78 | 24.32 | 25.52 | 24.46 | 25.62 | 27.46 | 27.30 | ||

| Autumn | 25.27 | 25.93 | 26.65 | 21.59 | 22.03 | 22.28 | 23.60 | 24.27 | 25.52 | ||

| Baboon | 27.20 | 28.57 | 27.54 | 23.53 | 24.27 | 23.62 | 27.47 | 28.09 | 28.16 | ||

| Building1 | 27.20 | 29.33 | 28.17 | 23.13 | 23.93 | 23.67 | 24.27 | 25.57 | 26.01 | ||

| Building2 | 29.26 | 31.79 | 29.48 | 25.66 | 26.71 | 25.87 | 27.45 | 29.60 | 29.23 | ||

| Building3 | 23.33 | 25.57 | 24.89 | 20.08 | 21.00 | 20.95 | 20.21 | 21.59 | 22.19 | ||

| Butterfly | 29.73 | 34.79 | 31.23 | 28.77 | 31.97 | 29.97 | 26.96 | 31.27 | 29.54 | ||

| Fruits | 29.32 | 31.62 | 30.85 | 27.12 | 28.56 | 28.02 | 27.38 | 29.38 | 30.11 | ||

| Shanghai | 26.07 | 28.32 | 27.26 | 22.21 | 22.99 | 22.83 | 22.88 | 24.02 | 24.24 | ||

| Mountain | 29.75 | 30.80 | 31.31 | 26.04 | 26.43 | 26.77 | 27.43 | 28.17 | 29.64 | ||

本文的变焦算法对位于长焦视场外、短焦视场内的纹理细节同样具有修复的作用,前提是该纹理细节在长焦视场内有对应的相似纹理. 如图6所示为该问题的仿真结果示例,其中的中央方框内为长焦相机视场区域. 从图中可以看到,栏杆部分在长焦视场内、外均有分布,这就为利用长焦视场内纹理修复长焦视场外纹理提供了可能. 为衡量算法的处理时间,运用本文算法对512×512的RGB三通道仿真图像进行处理实验,平均处理时间为41.62 s. 实验结果说明本方法的图像处理时间较长,算法还有待改进.

图 6

图 6 长焦视场外纹理修复效果验证实验

Fig.6 Texture restoring examination for field out of Long-Focal-Len

3.2. 真实图像实验与视差分析

为了验证所提方法对视差的鲁棒性,使用小米手机6的双焦摄像头,选取一处景物拍摄一组视差较大的长焦、短焦图像. 经计算,该双焦摄像头的焦距比为1.85倍,即

图 7

图 7 真实图像实验结果及视差鲁棒性验证

Fig.7 Experimental result of real image and verification of parallax problem

真实图像实验的客观评价指标使用拉普拉斯算子法,如下式所示:

式中:

4. 结 论

本研究提出了一种基于卷积神经网络的双焦相机数字连续变焦算法,对一定范围内用户给定的任意变焦倍数,可以得到比传统插值方法和超分辨方法质量更好的数字变焦图像. 仿真和实验结果表明,相比基于单帧的超分辨方法,所提方法主要有以下优势.

1)清晰度高,可以充分利用长焦图像更为丰富的景物细节. 无论是从主观清晰度还是从客观评价指标来看,其处理结果均比基于单帧的超分辨方法更清晰.

2)对长焦视场外、短焦视场内的细节有一定的修复效果. 很多研究者处理双焦相机变焦问题时,对长焦视场外的图像只是简单地利用单帧超分辨方法进行处理,而本文方法可以充分利用长焦视场内的纹理细节来修复长焦视场外的可修复纹理,更好地还原被拍摄景物的细节.

3)对视差有较好的鲁棒性. 实验结果表明,当双焦相机图像存在视差,即被拍摄景物在长、短焦图像内的遮挡关系不同,或者曝光和白平衡等参数有所不同时,本文方法都能得到完整自然的变焦图像. 所得变焦图像的视差、遮挡关系、曝光和白平衡等参数与短焦图像的参数是一致的. 因此在实际应用中不需要对长焦图像和短焦图像进行图像配准等复杂预处理操作.

所提方存在以下不足:1)处理时间比较长,不能在拍摄景物时实时变焦,需要在拍摄完成后花费一定时间进行后处理. 2)算法对内存和处理器的性能要求比较高,不能在很多性能不高的嵌入式系统上运行,只能在PC、智能手机和一些高性能的AI嵌入式芯片上运行.

参考文献

Image super-resolution via sparse representation

[J].DOI:10.1109/TIP.2010.2050625 [本文引用: 1]

Image super-resolution using deep convolutional networks

[J].DOI:10.1109/TPAMI.2015.2439281 [本文引用: 1]

Continuous digital zooming of asymmetric dual camera images using registration and variational image restoration

[J].DOI:10.1007/s11045-017-0534-4 [本文引用: 1]

Continuous digital zooming using local self-similarity-based super-resolution for an asymmetric dual camera system

[J].DOI:10.1364/JOSAA.34.000991 [本文引用: 1]

Photo-realistic continuous digital zooming for an asymmetrical dual camera system

[J].DOI:10.1016/j.optlastec.2018.07.056 [本文引用: 1]

Region filling and object removal by exemplar-based image inpainting

[J].DOI:10.1109/TIP.2004.833105 [本文引用: 1]

PatchMatch: a randomized correspondence algorithm for structural image editing

[J].