肺癌是全世界范围内癌症首要死亡原因,其5年生存率仅为18%[1]. 随着低剂量CT扫描和肺癌筛查的普及,肺结节作为肺癌早期表征之一,越来越多地被发现[2]. 根据实性成分含量,可将肺结节分为实性结节、单纯性磨玻璃结节(pure ground glass nodules,pGGNs)和混合性磨玻璃结节(mixed ground glass nodules,mGGNs). 比起其他2种肺结节,混合性磨玻璃结节的恶性可能性更高[3-4]. 2015年世界卫生组织(WHO)提出的肺腺癌分类表明,肺腺癌影像上表现为mGGNs,病理上可能为浸润性腺癌(invasive adenocarcinoma,IAC)或微浸润性腺癌(minimally invasive adenocarcinoma,MIA)[5-7].

中国许多医院仍使用厚层CT扫描进行肺癌筛查,5 mm层厚CT扫描是最常规的扫描方式,其X射线的剂量和强度较低,对人体损害更小. 但5 mm层厚CT扫描影像分辨率低,可获取的纹理信息少,从影像上分类鉴别肺腺癌组织学亚型具有挑战性. 随着计算机技术和大数据的发展,深度学习近年来发展迅猛,为实现从5 mm层厚CT影像中分类鉴别肺腺癌组织学亚型提供了可能. 目前,深度学习可应用于CT图像中肺结节的检测、分割和诊断,辅助放射科医生工作,减少漏诊率,增加诊断正确率. 已有很多研究学者致力于采用深度学习技术分类判别肺结节的良恶性[15-16],但对肺腺癌组织学亚型的分类研究仍较少. 因此,本研究旨在利用深度学习技术从5 mm层厚低剂量CT扫描影像中,实现对肺腺癌组织学亚型的分类鉴别.

本研究提出一种基于深度学习DenseNet[17]模型的方法,将影像上表现为mGGNs的IAC和MIA从低分辨率(5 mm层厚)厚层CT筛查中区分开来,探讨深度学习方法对IAC和MIA的鉴别诊断价值,以期在肺癌筛查中辅助放射科医生对患者的肺腺癌组织学亚型预判和指导,为临床治疗方式的选择和预后判断提供依据.

1. 材料和方法

1.1. 数据来源

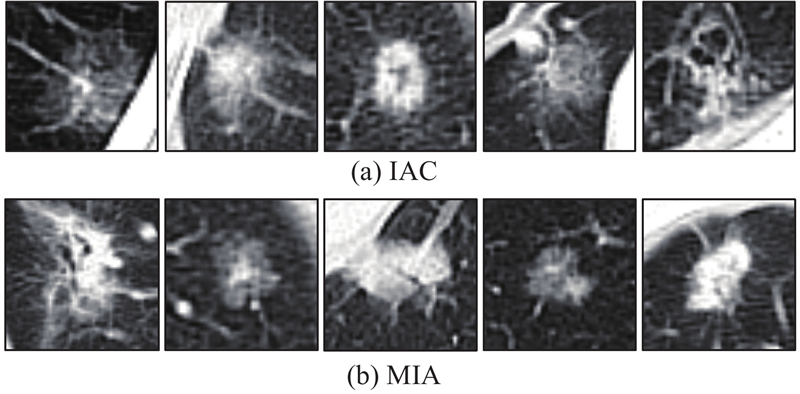

回顾性分析丽水市中心医院2015年1月至2016年12月期间的105例患者5 mm层厚胸部常规CT扫描,从中挑选出105个带有混合性磨玻璃结节的CT影像. 所有的混合性磨玻璃结节均通过病理诊断,确诊为IAC或MIA,分别为71个和34个,详细情况见表1. 图1列举了10个确诊为IAC和MIA的混合性磨玻璃结节CT图像,其具有相似的影像学特征,当医生从影像上预判病理结果时,很容易导致对mGGNs肺腺癌组织学亚型的判断出错. 当前研究[15-16]表明,计算机辅助诊断技术,尤其是深度学习方法,可以辅助医生对肺结节良恶性诊断提供参考信息,因此引入深度学习DenseNet模型对影像上表现为mGGNs的IAC和MIA进行分类鉴别.

表 1 患者和肺结节的属性

Tab.1

| 属性 | 各分类值 |

| 患者人数 | 33/72/105(男性/女性/总数) |

| 患者年龄 | 39/84/62(最小值/最大值/平均值) |

| 肺结节数目 (按病理结果分类) | 71/34/105(IAC/MIA/总数) |

| 肺结节数目 (按长轴直径分类) | 23/57/20/5(≤1 cm/≤2 cm/≤3 cm/>3 cm) |

图 1

图 1 确诊为IAC和MIA的混合性磨玻璃结节CT图像示例

Fig.1 CT images of mixed ground glass nodules diagnosed as IAC and MIA

1.2. 扫描仪器与方法

采用德国Siemens Force双源96排CT扫描仪,管电压为120 kV,采用CARE Dose 4D 技术,ref.mAs 104 mAs,扫描层厚5 mm,层间距为5 mm,kemel Bl57、ADMIRE level 3进行肺窗重建,采用kemel Br40、ADMIRE level 3进行纵隔窗重建. 常规进行平扫,然后经肘静脉注射碘克沙醇(含碘320 mg/mL)对比剂,注射速率3.0 mL/s,按照1.5 mL/kg的剂量注射,延迟28 s进行动脉期扫描,动脉期扫描结束后30 s进行延迟期扫描.

1.3. 数据预处理

对获得的5 mm层厚低剂量CT图像进行数据标注,由2名从事胸部疾病影像诊断5年以上的放射科医生完成mGGNs病灶中心点([xnod,ynod,znod])的定位. 得到结节中心的三维坐标点后,通过分析mGGNs长轴直径的大小分布确定实验所需的结节样本大小. 具体做法如下:将长轴直径(单位:mm)和图像像素间距([xps,yps,zps],单位:mm/pixel)相除,得到结节长轴直径实际所占像素数([xp,yp,zp],单位:pixel),详情见图2. 其中,xp(或yp)的范围为9~92,64及其以下共102个,占97.14%;zp的范围为1~10,6及其以下共100个,占95.24%. 因此,在每个mGGNs影像中,以[xnod,ynod]为中心、64×64为尺寸提取出ROI(region of interest)结节2D样本;以[xnod,ynod,znod]为中心、64×64×6为尺寸提取出VOI(volume of interest)结节3D样本. 为了利用结节背景信息,保留了病灶周围的图像. ROI和VOI均获得了105个结节样本(71个IAC样本和34个MIA样本),使用5折交叉验证实验,在每次实验过程中随机选取68个样本(34个IAC样本和34个MIA样本)作为数据集,再从中随机抽出56个结节样本(28个IAC样本和28个MIA样本)构成训练集,剩下的12个结节样本作为测试集.

图 2

图 2 结节长轴直径实际所占像素数分布情况

Fig.2 Distribution of actual pixel number of nodule diameter long axis

1.4. 数据扩展

在训练集中,只进行图像的平移、旋转和翻转,不改变样本数据的尺寸和质量. 具体做法如下:将结节样本的横断面作为基准,在上、下、左、右4个方向,以1为步长、[1,5]为像素范围进行平移;以30°为步长旋转结节样本;对结节样本进行水平翻转和垂直翻转. 这些完成后,训练集数量可扩增至原先的33倍. 本研究未在测试集中使用数据扩展.

1.5. DenseNet卷积神经网络

Huang等[17]提出了一种新型卷积神经网络DenseNet,主要包含紧密块(dense block)和过渡层(transition layer)2个组成模块. 在每个紧密块内,第l层的输出xl满足式(1),层与层之间的非线性转换函数Hl(·)包含3个连续的操作:批标准化、线性整流函数和3×3卷积(Conv3×3). 定义超参数k为生长率,如果Hl(·)产生k个特征映射,则第l层将有k0+k×(l−1)个特征映射输入(k0为首个输入层的通道数). 这将导致每一层有太多输入,因此在每个紧密块的Conv3×3前引入Conv1×1作为颈瓶层(bottle neck layer),来减少特征映射输入的数量. 每2个紧密块之间用颈瓶层连接,通过卷积和池化操作改变特征映射的大小:

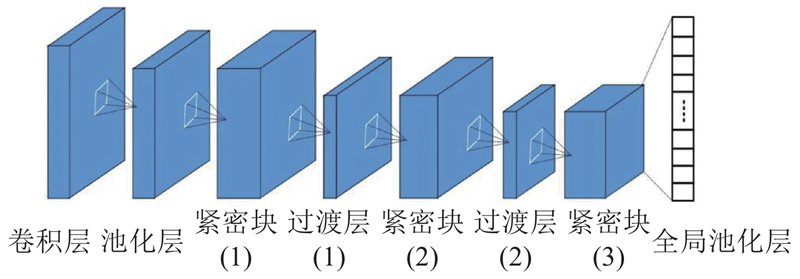

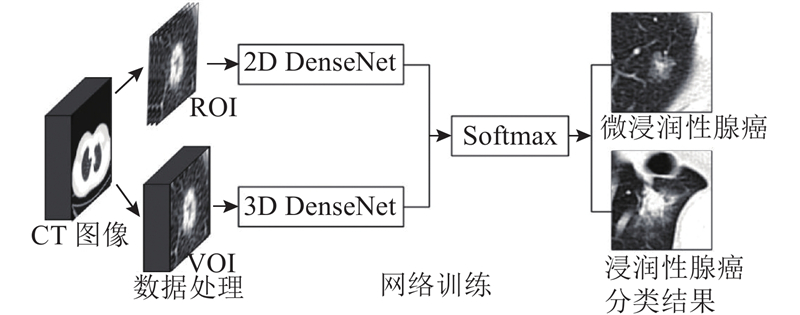

1.6. 2D DenseNet和3D DenseNet模型

图 3

图 4

图 4 2D和3D DenseNet网络模型实验流程

Fig.4 Experiment flows of 2D and 3D DenseNet models

表 2 2D和3D DenseNet模型结构细节

Tab.2

| 组成成分 | 2D DenseNet | 3D DenseNet |

| 卷积层 | 7×7 | 7×7×7 |

| 池化层 | 3×3 | 3×3×3 |

| 紧密块(1) | | |

| 过渡层(1) | | |

| 紧密块(2) | | |

| 过渡层(2) | | |

| 紧密块(3) | | |

| 全局池化层 | 3×3 | 3×3×3 |

在2D DenseNet模型中,卷积层采用7×7卷积(Conv7×7),输出2k个特征映射,而其余层仅产生k个特征映射(k=14);池化层和全局池化层采用的均为3×3池化(Pool3×3)操作;考虑到输入的ROI尺寸是64×64,仅设置3个紧密块,每个紧密块包含Lblock个卷积组合(Conv1×1+Conv3×3),这3个紧密块的Lblock分别是6、12和24;每2个紧密块之间,用Conv1×1和Pool2×2构成的过渡层连接;所有的卷积操作步长为1,使用零填充;所有的池化操作步长为2,不使用零填充. 3D DenseNet模型与2D Dense Net的区别在于:将输入由ROI结节2D样本替换为VOI结节3D样本,所有卷积和池化的尺寸从2D更改为3D(例如:卷积层中的卷积尺寸由Conv7×7更改为Conv7×7×7). 2D DenseNet模型和3D DenseNet模型得到全局池化层的输出后,在最后连接1个Softmax层,利用Adam优化器(Adam optimizer)在网络训练的过程中执行梯度下降算法寻找使误差函数最小的网络参数.

在每个卷积操作(卷积层除外)之后均采用弃权(dropout)[18]操作缓解过拟合问题. 设置初始网络学习率为0.005,迭代总次数(epoch)为200. 在网络训练过程中,学习率共改变2次,在完成迭代总次数的50%后,学习率降低到初始学习率的10%;在完成迭代总次数的75%后,学习率降低到初始学习率的1%.

整个实验使用Python 3.5实现,基于TensorFlow v1.1.0[19]环境,在1台内存为32 GB的Intel(R) Xeon(R) CPU机器上进行,并在NVIDIA GTX-1080Ti GPU (11GB内存)上加速.

2. 实验结果

2.1. 2D DenseNet和3D DenseNet模型性能对比

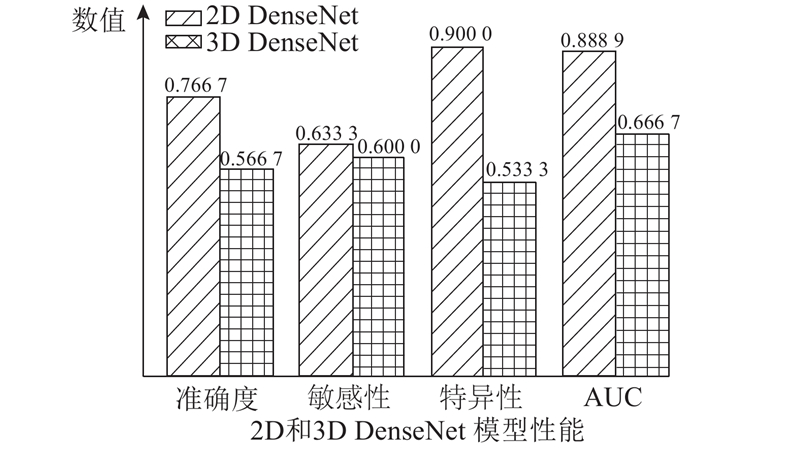

实验采用5折交叉验证,将MIA作为正类,IAC作为负类,使用ROI和VOI训练集分别对2D DenseNet和3D DenseNet模型进行网络训练,在测试集中分别从准确度、敏感性、特异性和受试者工作特征曲线下的区域面积(the area under the receiver operating characteristic curve,AUC)4个方面对2D DenseNet和3D DenseNet 这2种网络模型定量地进行诊断性能评估. 由图5可知,2D DenseNet性能显著高于3D DenseNet,前者的4个性能指标均高于后者. 尽管2D DenseNet的准确度仅为76.67%,但其AUC值高达0.888 9. 文献[20]表明,准确度是基于较佳的截断值计算的,而AUC是基于所有可能的截断值计算,是一种比准确度更加稳健的测量方法. 由此可知,2D DenseNet模型可对厚层CT影像上表现为mGGNs的IAC和MIA进行有效地分类预判. 此外,2D DenseNet的高特异性(90.00%)表明使用该深度学习模型误诊率(在分类错误的情况下,将MIA判为IAC的几率)较低.

图 5

图 5 2D和3D DenseNet网络模型的性能对比

Fig.5 Comparison of performance of 2D and 3D DenseNet models

2.2. 2D DenseNet参数调整

深度学习网络模型的参数直接决定了其性能优劣,本节对颈瓶层、弃权和数据扩展进行调整,以探究这些参数对2D DenseNet模型的影响. 设计颈瓶层的目的是减少特征映射数量,弃权是为了提高2D DenseNet模型的收敛速度,数据扩展可从有限的临床数据集中获得更多的训练数据,这3个参数对2D DenseNet模型性能有很大影响,如表3所示. 表中,a为准确度,e为敏感性,p为特异性,AUC为受试者工作特征曲线下的区域面积. 当不使用颈瓶层、弃权、数据扩展时,2D DenseNet网络模型性能下降,尤以颈瓶层影响最为严重. 颈瓶层在减少特征映射数量、节省计算量的同时,还能够融合2D DenseNet各个通道的特征,有助于提升网络性能.

表 3 2D DenseNet网络模型不同参数的性能对比

Tab.3

| 深度学习网络 | a/% | e/% | p/% | AUC |

| 注:括号内是与2D DenseNet相应性能指标相比下降的百分比 | ||||

| 2D DenseNet | 76.67 | 63.33 | 90.00 | 0.888 9 |

| 2D DenseNet-无颈瓶层 | 54.17(↓22.5) | 20.84(↓42.49) | 87.50(↓2.50) | 0.592 6(↓0.296 3) |

| 2D DenseNet-无弃权 | 58.33(↓18.34) | 33.33(↓30.00) | 83.33(↓6.67) | 0.683 3(↓0.205 6) |

| 2D DenseNet-无数据扩展 | 58.33(↓18.34) | 63.33(↓0.00) | 53.34(↓36.66) | 0.694 4(↓0.194 5) |

2.3. 与其他深度学习网络模型对比

在使用颈瓶层、弃权和数据扩增的条件下,2D DenseNet模型在mGGNs的IAC和MIA分类鉴别中达到了最优性能(a=76.67%,e=63.33%,p=90.00%,AUC=0.888 9). 为了与其他深度学习网络模型性能对比,本研究选择4个其他2D深度学习网络(LeNet[21]、AlexNet[22]、AgileCNN[16]和Multi-channel CNN[15]作为对照). 其中,LeNet和AlexNet均是较经典的卷积神经网络,AgileCNN和Multi-channel CNN是2018年提出的用于肺结节良恶性分类鉴别的新卷积神经网络模型. 从表4可以看出,LeNet模型的敏感性略高于2D DenseNet(3.34%),但LeNet模型的特异性要显著低于2D DenseNet(36.67%). 除此以外,2D DenseNet模型的性能指标均高于其他深度学习网络模型.

表 4 2D DenseNet与其他深度学习网络模型的性能对比

Tab.4

| 深度学习网络 | a/% | e/% | p/% | AUC |

| LeNet | 60.00 | 66.67 | 53.33 | 0.750 0 |

| AlexNet | 53.33 | 56.67 | 50.00 | 0.722 2 |

| AgileCNN | 53.33 | 63.33 | 43.33 | 0.638 9 |

| Multi-channel CNN | 56.66 | 63.33 | 50.00 | 0.777 8 |

| 2D DenseNet | 76.67 | 63.33 | 90.00 | 0.888 9 |

3. 结果与讨论

实验结果表明,2D DenseNet模型的性能显著优于3D DenseNet模型(见图5). 这可能是由于影像上表现为mGGNs的MIA和IAC的影像特征相似,给5 mm层厚的3D结节样本造成更多的混淆;另一方面,3D DenseNet模型比2D DenseNet模型含有更多待训练参数,过拟合问题可能会更严重. 与其他4种2D深度学习网络模型(LeNet、AlexNet、AgileCNN和Multi-channel CNN)相比,2D DenseNet模型性能最优. 这表明使用深度学习技术,尤其是2D DenseNet模型,从厚层CT影像对肺腺癌组织学亚型进行分类鉴别是可行的,本研究为辅助放射科医师从常规低剂量CT扫描图像对肺腺癌类型评估和诊断提供了一种方法.

此外,前期工作还探究了影像组学从常规CT扫描影像中分类鉴别肺腺癌组织学亚型. 特征提取后利用序列前向选择(sequential forward selection,SFS)算法选取出49个最优影像组学特征,使用支持向量机(SVM)获得最终分类准确度为70.00%(<76.67%). 由此可见,在CT影像分类预判肺腺癌组织学亚型的实验中,2D DenseNet深度学习方法比影像组学方法结果更优.

目前,尚缺乏利用深度学习技术从肺部结节CT影像对肺腺癌组织学亚型分类鉴别的针对性研究. 原因是多方面的,其中最大的限制是肺腺癌组织学亚型的数据数量. 与公开的肺结节影像相比,肺腺癌组织学亚型的临床数据集,尤其是带有病理结果的数据集,十分有限. 因此在本研究中,通过图像平移、旋转和翻转操作来增加训练样本的数据量,实验证明采用数据增强的方法可获得更好的分类性能(如表3所示). 为了克服数据集有限的问题,接下来还需要收集更多的肺腺癌数据,或运用迁移学习技术. 有病理结果的肺结节CT图像数量有限,但无病理结果的相对较多,未来的工作将对无病理结果的肺结节(尤其是mGGNs)组织学亚型分类进行研究,如采用无监督学习技术.

4. 结 语

本研究提出了基于DenseNet的深度学习方法从低剂量、低分辨率CT扫描中实现对肺浸润性腺癌和微浸润性腺癌的分类鉴别. 选取了5 mm层厚的混合性磨玻璃结节CT图像,数据预处理后,获得了ROI结节2D样本和VOI结节3D样本作为实验数据集. 构建的2D DenseNet模型准确度为76.67%、敏感性为63.33%、特异性为90.00%、AUC为0.888 9,性能显著高于3D DenseNet及其他几种深度学习网络模型. 实验结果表明,深度学习技术尤其是2D DenseNet模型,可用于肺腺癌组织学亚型的分类预判. 提出的方法可帮助放射科医师对低分辨率CT图像进行鉴别诊断,进一步的研究将探索更多的肺腺癌数据、迁移学习和无监督学习.

参考文献

Cancer statistics, 2018

[J].DOI:10.3322/caac.21442 [本文引用: 1]

Advances in intelligent diagnosis methods for pulmonary ground-glass opacity nodules

[J].DOI:10.1186/s12938-018-0435-2 [本文引用: 1]

CT screening for lung cancer: frequency and significance of part-solid and nonsolid nodules

[J].DOI:10.2214/ajr.178.5.1781053 [本文引用: 1]

CT-texture analysis of subsolid nodules for differentiating invasive from in-situ and minimally invasive lung adenocarcinoma subtypes

[J].DOI:10.1016/j.diii.2017.12.013 [本文引用: 1]

International association for the study of lung cancer/American thoracic society/European respiratory society international multidisciplinary classification of lung adenocarcinoma

[J].DOI:10.1097/JTO.0b013e318206a221 [本文引用: 1]

The 2015 world health organization classification of lung tumors: impact of genetic, clinical and radiologic advances since the 2004 classification

[J].DOI:10.1097/JTO.0000000000000630

Recommendations for the management of subsolid pulmonary nodules detected at CT: a statement from the fleischner society

[J].DOI:10.1148/radiol.12120628 [本文引用: 1]

HRCT morphological characteristics distinguishing minimally invasive pulmonary adenocarcinoma from invasive pulmonary adenocarcinoma appearing as subsolid nodules with a diameter of </=3 cm

[J].DOI:10.1016/j.crad.2017.11.014 [本文引用: 1]

Surgical implications of the new IASLC/ATS/ERS adenocarcinoma classification

[J].

Precise diagnosis of intraoperative frozen section is an effective method to guide resection strategy for peripheral small-sized lung adenocarcinoma

[J].

Why do pathological stage IA lung adenocarcinomas vary from prognosis?: a clinicopathologic study of 176 patients with pathological stage IA lung adenocarcinoma based on the IASLC/ATS/ERS classification

[J].DOI:10.1097/JTO.0b013e31829f09a7 [本文引用: 1]

计算机辅助定量分析对磨玻璃密度型肺腺癌浸润性的诊断价值

[J].

The value of computer-aided quantitative analysis in the diagnosis of invasiveness of lung adenocarcinoma manifesting as ground glass nodule

[J].

Quantitative CT analysis of pulmonary ground-glass opacity nodules for the distinction of invasive adenocarcinoma from pre-invasive or minimally invasive adenocarcinoma

[J].DOI:10.1371/journal.pone.0104066 [本文引用: 1]

肺纯磨玻璃结节微浸润腺癌与浸润性腺癌的CT鉴别诊断

[J].

CT differential diagnoses of pulmonary minimally invasive adenocarcinoma and invasive adenocarcinoma presenting as pure ground glass nodule

[J].

A hybrid CNN feature model for pulmonary nodule malignancy risk differentiation

[J].DOI:10.3233/XST-17302 [本文引用: 3]

Agile convolutional neural network for pulmonary nodule classification using CT images

[J].DOI:10.1007/s11548-017-1696-0 [本文引用: 3]

Dropout: a simple way to prevent neural networks from overfitting

[J].

Comparative study of deep learning software frameworks

[J].

AUC: a better measure than accuracy in comparing learning algorithms

[J].

Gradient-based learning applied to document recognition

[J].DOI:10.1109/5.726791 [本文引用: 1]

ImageNet classification with deep convolutional neural networks

[J].