图像融合是图像处理研究的一大分支,广泛应用于医学、军事和目标探测等领域[1-3].常见的图像融合方法有变换域中的多尺度方法和稀疏表示方法.最流行的多尺度方法有离散小波变换法(discrete wavelet transform, DWT)[4]、对偶树复小波变换(dual-tree complex wavelet transform, DTCWT)[5]、四元数小波变换法[6]等.常见的稀疏表示方法有DCT字典融合方法[7]和多字典自适应稀疏表示方法[8].迄今为止,稀疏理论在图像融合中已经取得了丰硕成果[9-10],研究表明,传统的多尺度方法在图像融合中易减弱图像的对比度,而稀疏理论方法可以很好地解决这一问题.

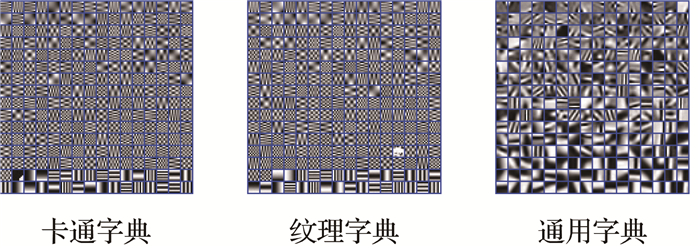

现有的基于稀疏表示的图像融合模型中所学习的大多是通用字典,并没有明确的几何意义.笔者认为,如果字典有明确的几何意义,则会进一步提升融合效果.因此,本文利用图像可以表示成卡通特征和纹理特征的特点,通过学习得到卡通字典和纹理字典,利用几何意义明确的2个字典提出了一种图像融合方法.主要过程分3步:首先,利用先进的图像分解方法(fast cartoon + texture image decomposition, FCTD)[11]将训练集和测试集中的图像分解成卡通和纹理两大部分;接着,利用在训练集上学习好的卡通字典和纹理字典分别对测试集中源图像的卡通部分和纹理部分进行融合;最后,将融合好的卡通部分和纹理部分相加得到最终的融合图像.

1 基于特征分解的图像融合方法 1.1 FCTD图像分解方法BUADES等[11]提出的FCTD分解方法主要是利用一对低-高通滤波器简单并快速地实现卡通纹理的分解.由于篇幅所限,本文只给出FCTD分解效果图的一个示例,具体算法可参见文献[11].一张512×512的‘Lena’图,用FCTD分解大约需要2 s. 图 1给出了‘Lena’图分解后的卡通部分和纹理部分(原图减去卡通部分).

|

图 1 ‘Lena’的特征分解图 Fig. 1 Feature decomposition image for 'Lena' |

从图 1中可以看到,图像的两大特征是完全不同的,因此如果用在此2种特征下学习得到的2种字典来分别表示卡通部分和纹理部分,不仅可知其几何意义,而且还可以提供融合效果,这和以往的稀疏表示模型是完全不同的.

1.2 特征字典在训练数据集上选取8张高质量的自然图像,利用FCTD进行分解,分别得到卡通部分和纹理部分,利用K-SVD[12]算法分别进行训练,得到2个表示不同几何意义的卡通字典Dc和纹理字典Dt. 图 2给出了本文得到的2个字典和文献[10]通过40幅高质量图像学习得到的通用字典.

|

图 2 稀疏字典 Fig. 2 The sparse dictionaries |

假设源图像I1, I2都是配准好的,应用FCTD方法将其分解成卡通部分和纹理部分,分别记为I1c,I2c,I1t和I2t,应用滑动窗技术、学习好的特征字典Dc和Dt以及正交匹配方法(orthogonal matching pursuit algorithm,OMP),计算得到稀疏表示系数α1ci,α2ci,α1ti和α2ti:

| $ \begin{array}{l} {\alpha _{{\rm{1c}}}} = {\rm{argmin}}{\left\| \alpha \right\|_0}{\rm{s}}{\rm{.t}}{\left\| {{D_{\rm{c}}}\alpha-{{\boldsymbol{\hat v}}_{{\rm{1c}}}}} \right\|_2}^2 \le \varepsilon, \\ {\alpha _{{\rm{2c}}}} = {\rm{argmin}}{\left\| \alpha \right\|_0}{\rm{s}}{\rm{.t}}{\left\| {{D_{\rm{c}}}\alpha-{{\boldsymbol{\hat v}}_{2{\rm{c}}}}} \right\|_2}^2 \le \varepsilon, \\ {\alpha _{{\rm{1t}}}} = {\rm{argmin}}{\left\| \alpha \right\|_0}{\rm{s}}{\rm{.t}}{\left\| {{D_{\rm{t}}}\alpha-{{\boldsymbol{\hat v}}_{{\rm{1t}}}}} \right\|_2}^2 \le \varepsilon, \\ {\alpha _{{\rm{2t}}}} = {\rm{argmin}}{\left\| \alpha \right\|_0}{\rm{s}}{\rm{.t}}{\left\| {{D_{\rm{t}}}\alpha - {{\boldsymbol{\hat v}}_{{\rm{2t}}}}} \right\|_2}^2 \le \varepsilon, \end{array} $ |

其中,

利用系数的“L1-范数”最大进行融合:

| $ \begin{array}{l} {\alpha _{f{\rm{c}}}}^i = \left\{ \begin{array}{l} {\alpha _{{\rm{1c}}}}^i, {\rm{if}}{\left\| {{\alpha _{{\rm{1c}}}}^i} \right\|_1} \ge {\left\| {{\alpha _{{\rm{2c}}}}^i} \right\|_1}, \\ {\alpha _{{\rm{2c}}}}^i, {\rm{otherwise}}, \end{array} \right.\\ {\alpha _{f{\rm{t}}}}^i = \left\{ \begin{array}{l} {\alpha _{{\rm{1t}}}}^i, {\rm{if}}{\left\| {{\alpha _{{\rm{1t}}}}^i} \right\|_1} \ge {\left\| {{\alpha _{{\rm{2t}}}}^i} \right\|_1}, \\ {\alpha _{{\rm{2t}}}}^i, {\rm{otherwise}}{\rm{.}} \end{array} \right. \end{array} $ |

通过系数稀疏表示融合图像块:

| $ \begin{array}{l} \mathit{\boldsymbol{v}}_{f{\rm{c}}}^i = {D_{\rm{c}}}\alpha _{f{\rm{c}}}^i + \mathit{\boldsymbol{\bar v}}_{f{\rm{c}}}^i \cdot 1, \\ \mathit{\boldsymbol{v}}_{f{\rm{t}}}^i = {D_{\rm{t}}}\alpha _{f{\rm{t}}}^i + \mathit{\boldsymbol{\bar v}}_{f{\boldsymbol{\rm{t}}}}^i \cdot 1, \end{array} $ |

其中,

| $ \begin{array}{l} \mathit{\boldsymbol{\bar v}}_{f{\rm{c}}}^i = \left\{ \begin{array}{l} \mathit{\boldsymbol{\bar v}}_{1{\rm{c}}}^i, \;\;\;\;\alpha _{f{\rm{c}}}^i = \alpha _{1{\rm{c}}}^i, \\ \mathit{\boldsymbol{\bar v}}_{2{\rm{c}}}^i, \;\;\;\;{\rm{otherwise, }} \end{array} \right.\\ \mathit{\boldsymbol{\bar v}}_{f{\rm{t}}}^i = \left\{ \begin{array}{l} \mathit{\boldsymbol{\bar v}}_{1{\rm{t}}}^i, \;\;\;\;\alpha _{f{\rm{t}}}^i = \alpha _{1{\rm{t}}}^i, \\ \mathit{\boldsymbol{\bar v}}_{2{\rm{t}}}^i, \;\;\;\;{\rm{otherwise, }} \end{array} \right. \end{array} $ |

图 3给出了本文方法的融合流程图.

|

图 3 基于特征分解的图像融合方法流程图 Fig. 3 The feature decomposition-based fusion algorithm |

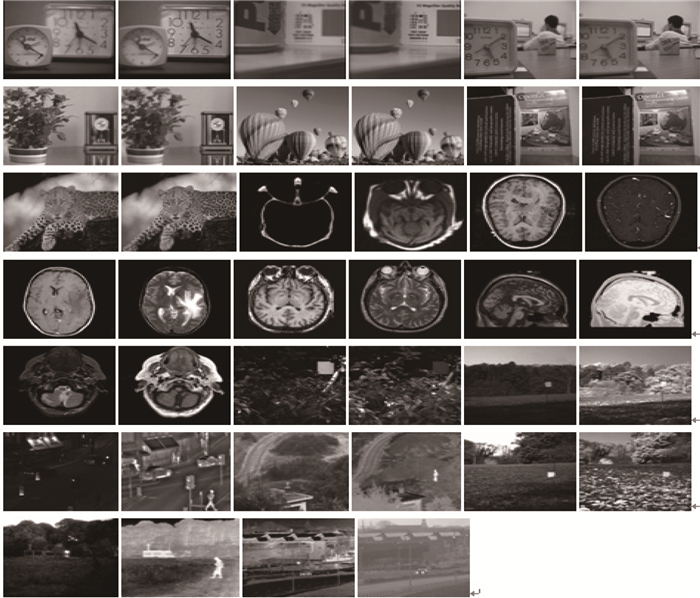

测试图来源于图像融合方法常用的标准数据库http://imagefusion.org.

2.2 客观指标利用常用的熵(entropy, EN)、标准偏差(standard deviation, SD)、互信息(mutual information, MI)[13]、梯度QG指标[14]和相位一致性度量指标QP[15]来测试本文算法和比较算法,其值越大说明融合效果越好.

|

图 4 测试图集 Fig. 4 Testing images |

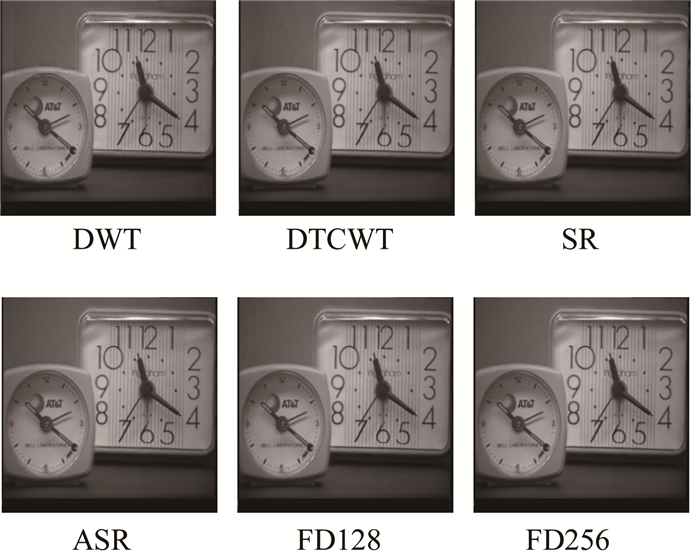

本文学习了2种大小的字典,为表述方便,用记号FD128和FD256指代本文方法,其中128和256表示融合字典的大小.将2种稀疏融合比较方法记为SR[7]和ASR[10].将本文方法与DWT[5]、DTCWT[6]、SR、ASR融合方法进行比较. DWT和DTCWT方法分解层数为4,SR和ASR采用原文献提供的代码和参数.

图 5~图 7分别给出了不同方法对3种图像融合的效果. 图 5给出了几种不同方法对多聚焦图像融合的效果.显然,稀疏表示方法较DWT、DTCWT方法要好,而本文方法对此类图像的融合效果与SR、ASR方法区别不明显.

|

图 5 一组多聚焦图像的融合效果 Fig. 5 The effects for multi-focus image |

|

图 6 一组医学图像的融合效果 Fig. 6 The effects for medical image |

|

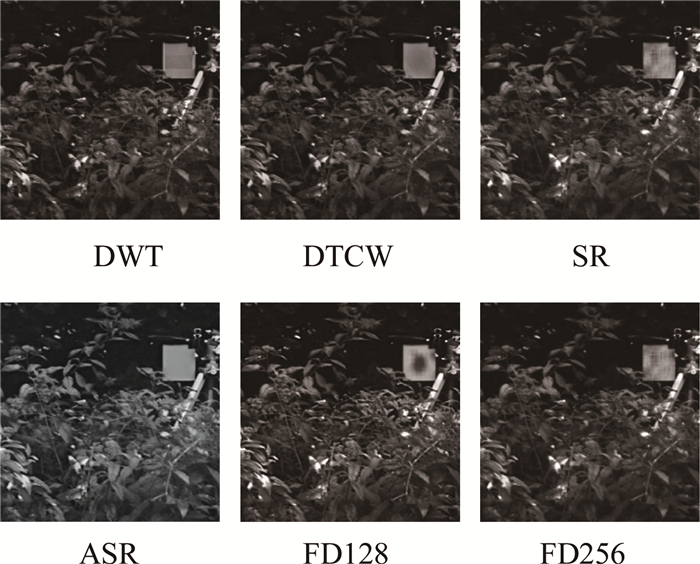

图 7 一组红外线-可见光图像的融合效果 Fig. 7 The effects for visible-infrared image |

图 6给出了各方法对医学图像的融合效果.显然,DWT出现了严重的块效应,DTCWT对骨骼(图中亮的部分)的提取明显弱于其他几种稀疏表示方法,本文方法能很好地保护医学图像中的软组织和骨骼结构,图像融合纹路更清晰.

图 7给出了一组红外线-可见光的图像融合例子. DWT的块效应仍然存在,DWT对比度损失较为严重,如广告牌的亮度明显不及其他几种稀疏表示方法.在几种稀疏表示方法中,本文的FD256方法最好,这也表明了字典越大融合效果越好.

表 1~表 3给出了不同方法在3组不同测试图像集上融合效果的平均指标值,最好的用粗黑体表示,次好的用斜粗黑体表示.从表中可以得到:1)基于稀疏表示的方法:SR、ASR、FD128和FD 256,基本上都优于传统的多尺度分析方法DWT和DTCWT.对于多聚焦图像,各方法差异不大,但对于医学图像和红外线-可见光图像,本文方法在各指标上都较其他方法要好,且随着字典尺寸的增大,融合效果未见增好,对红外线-可见光图像的融合尤其明显.

| 表 1 不同方法对多聚焦图像融合的平均指标值 Table 1 The average objective metrics of different methods on pairs of multi-focus images |

| 表 2 不同方法对医学图像融合的平均指标值 Table 2 The average objective metrics of different methods on pairs of medical images |

| 表 3 不同方法对红外线-可见光图像融合的平均指标值 Table 3 The average objective metrics of different methods on pairs of visible-infrared images |

利用几何意义明确的结构字典和纹理字典,分别对源图像的结构和纹理部分进行融合,通过叠加得到了最终的融合效果.实验结果表明,本文方法大大改善了医学图像和红外线-可见光图像的融合效果.

| [1] | LIU Z, FORSYTH D S, SAFIZADEH M S, et al. A data-fusion scheme for quantitative image analysis by using locally weighted regression and Dempster-Shafer theory[J]. IEEE Transactions on Instrumentation and Measurement, 2008, 57(11): 2554–2560. DOI:10.1109/TIM.2008.924933 |

| [2] | HASSAINIA F, MAGAFIA I, LANGEVIN F. Image fusion by an orthogonal wavelet transform and comparison with other methods[C]//International Conference of the IEEE Engineering in Medicine and Biology Society. Paris: The IEEE Engineering in Medicine and Biology Society, 1992(3): 1246-1247. |

| [3] | PETROVIC V S, XYDEAS C S. Gradient-based multiresolution image fusion[J]. IEEE Transactions on Image Processing, 2004, 13(2): 228–237. DOI:10.1109/TIP.2004.823821 |

| [4] | LI H, MANJUNATH B, MITRA S. Multisensor image fusion using the wavelet transform[J]. Graphical Models and Image Processing, 1995, 57(3): 235–245. DOI:10.1006/gmip.1995.1022 |

| [5] | HILL P, CANAGARAJAH N C, BULL D R. Image fusion using complex wavelet[C]//Proc of the 13th British Machine Vision Conference. Durham: British Machine Vision Association, 2002: 487-496. |

| [6] |

常莉红. 一种基于四元数小波变换的图像融合方法[J].

宝鸡文理学院学报(自然科学版), 2016, 36(3): 8–14.

CHANG L H. An image fusion method based on quaternion wavelet transform[J]. Journal of Baoji University of Art and Sciences(Natural Science Edition), 2016, 36(3): 8–14. |

| [7] | YANG B, LI S T. Multifocus image fusion and restoration with sparse representation[J]. IEEE Transactions on Instrumentation and Measurement, 2010, 59(4): 884–892. DOI:10.1109/TIM.2009.2026612 |

| [8] | LIU Y, WANG Z F. Simultaneous image fusion and denoising with adaptive sparse representation[J]. IET Image Processing, 2014, 9(5): 347–357. |

| [9] | LIU Y, LIU S P, WANG Z F. A general framework for image fusion based on multi-scale transform and sparse representation[J]. Information Fusion, 2015, 24: 147–164. DOI:10.1016/j.inffus.2014.09.004 |

| [10] | YIN H T, LI S T, FANG L Y. Simultaneous image fusion and super-resolution using sparse representation[J]. Information Fusion, 2013, 14(3): 229–240. DOI:10.1016/j.inffus.2012.01.008 |

| [11] | BUADES A, LE T, MOREL J, et al. Cartoon +Texture image decomposition[J]. Image Processing on Line, 2011(1): 200–207. |

| [12] | AHARON M, ELAD M, BRUCKSTEIN A. K-SVD:An algorithm for designing overcomplete dictionaries for sparse representation[J]. IEEE Transactions on Signal Processing, 2006, 54(11): 4311–4322. DOI:10.1109/TSP.2006.881199 |

| [13] | HOSSNY M, NAHAVANDI S, CREIGHTON D. Comments on 'Information measure for performance of image fusion'[J]. Electronics Letters, 2008, 44(18): 1066–1067. DOI:10.1049/el:20081754 |

| [14] | XYDEAS C S, PETROVIÉ V. Objective image fusion performance measure[J]. Electronics Letters, 2000, 36(4): 308–309. DOI:10.1049/el:20000267 |

| [15] | LIU Z, BLASCH E, XUE Z Y, et al. Objective assessment of multiresolution image fusion algorithms for context enhancement in night vision:A comparative study[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(1): 94–109. DOI:10.1109/TPAMI.2011.109 |