2. 浙江大学 地理信息科学研究所, 浙江 杭州 310027

2. Department of Geographic Information Science, Zhejiang University, Hangzhou 310027, China

近年来,图像中空间位置信息的研究成了图像识别领域的研究热点,且随着各个学科的发展融合,GIS(geographic information system)中的空间关系理论已成为研究图像检索中特征点之间关系的一个重要方向.

基于地理位置服务的增强现实(augmented reality, AR)技术是目前智慧校园建设中重要的技术手段.随着数字图像的大量增加,传统的基于内容的图像搜索方法很难满足目前的检索需求.NISTER等[1]提出的基于词汇树的词袋模型表示算法是目前图像检索领域的主流算法.LAZEBNIK等[2]提出的空间金字塔匹配SPM(spatial pyramid matching)采用多尺度分块,分别统计并比较每一个子块的特征,考虑了视觉词袋模型忽视的视觉单词在图像上的空间分布信息.SPM能有效提升图像的识别精度,得到了普遍认可和广泛应用.

然而,SPM方法是对图像整体进行划分,限制了视觉目标在图像上的位置,具体表现为对发生了旋转、平移和缩放的图像的表示所包含的信息不精确,导致匹配精确度下降.本文研究的图像数据集为校园建筑物数据,这些建筑物图片具有一定的规格,同时主体明显,背景一般较为干净.数据集中的图像在采集的过程中,由于设备、人员的不同,常常会出现图片旋转的状况,导致视觉目标发生较为严重的旋转变化,同时也伴有一定的尺度和平移变化.

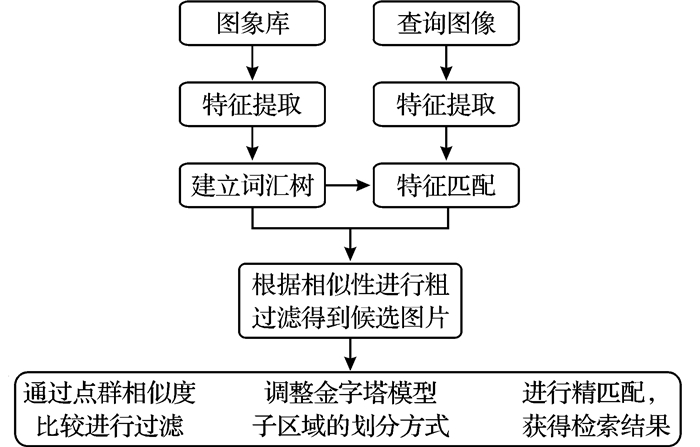

结合本文的数据特点,同时考虑到移动端设备对于特征提取的效率,本文在SPM方法的基础上进行了改进,提出了一种基于特征点群相似度计算模型的图像表示方法.该方法采取FREAK二进制描述符进行图像特征的提取,并构建词汇树模型.通过词汇树模型的粗匹配,筛选出距离目标图像较近的训练图像.在此基础上,对粗筛选结果进行特征点群相似度计算,过滤特征点群相似度较差的训练图像.然后,借助由特征点群计算得到的标准差椭圆的圆心、旋转角度来调整SPM对图像子区域的划分,提高SPM在处理发生旋转、平移和尺度变化的图像时的精确度.

1 相关研究 1.1 FREAK特征描述符移动终端设备在配置和性能上与普通计算机仍存在一定的差距,传统的SIFT等算法存在计算量大、占用内存多、匹配时间长等问题.因此,近年来,出现了一些实效性更强、更适合在移动端计算的特征点提取和描述方法.CALONDER等[3]提出的BRIEF算法,RUBLEE等[4]提出的ORB算法,ALAHI等[5]提出的FREAK算法等,都采用了二进制描述符,降低了描述符的维度,依靠计算特征描述符之间的汉明距离,使得运算速度和内存占用得到了优化.文献[6]证明了FREAK算法在处理诸多变化时其性能强于ORB算法和BRIEF算法,特别在处理光照变化时其稳定性最好.

FREAK是一种二值描述符,其核心思想就是采用仿视网膜结构的采样模板对特征点进行描述符构造[5].与人眼的视网膜神经节细胞相似,FREAK特征描述符采样点结构由许多大小不同并有重叠的圆构成.圆代表感受野,重叠的结构可以获取更多的信息;对应的圆心代表采样点,采样点均匀分布在以特征点为中心的同心圆上.同时,FREAK采样结构根据距离特征点的距离决定采样密集度,离中心特征点越近,采样点越密集.通过采样点之间像素值的两两比较级联成的FREAK描述子是二进制比特串,假设F为某个特征点的FREAK描述符,则

| $ \mathit{F}{\rm{ = }}\sum\limits_{\mathit{a} = 0}^\mathit{N} {{{\rm{2}}^\mathit{a}}\mathit{T}{\rm{(}}{\mathit{P}_\mathit{a}}{\rm{)}}} {\rm{, }} $ | (1) |

其中,Pa是第a对采样点,N表示描述符的维数,且T(Pa)满足:

| $ \mathit{T}\left( {{\mathit{P}_\mathit{a}}} \right){\rm{ = }}\left\{ \begin{array}{l} {\rm{1}}, \;{\rm{if}}\;\mathit{I}\left( {\mathit{P}_\mathit{a}^{{\mathit{r}_{\rm{1}}}}} \right){\rm{ - }}\mathit{I}\left( {\mathit{P}_\mathit{a}^{{\mathit{r}_2}}} \right){\rm{ > 0, }}\\ {\rm{0}}, \;\;\;{\rm{otherwise, }} \end{array} \right. $ | (2) |

其中,I(Par1)表示采样点对前一个采样点的像素值,I(Par2)表示后一个采样点的像素值.

本文选取较高维的二进制特征描述符——FREAK特征在客户端对图像进行处理,同时在服务器端采取同样的特征进行层级式聚类,以汉明空间概率中心向量作为聚类中心,进行词汇树的构建.

1.2 基于词汇树的金字塔匹配方法词袋模型源于自然语言处理和信息检索,与文本相似,图像可以被视为一些与位置无关的局部特征的集合.基于树形结构的词袋模型通过树形结构的层次索引方式,解决了非层次化检索量化过程太慢的问题,大大提高了检索的效率[1].

词汇树采用TF-TDF模型量化训练图像各特征在词汇树中的分布情况,本文词汇树各节点权值计算采用文献[7]的计算方法.

| $ \begin{array}{l} {\mathit{w}_{\mathit{i}{\rm{, }}\mathit{j}}}{\rm{ = }}{\mathit{m}_{\mathit{i}{\rm{, }}\mathit{j}}}{\rm{ \times }}\mathit{id}{\mathit{f}_{\rm{i}}}{\rm{ = }}{\mathit{m}_{\mathit{i}{\rm{, }}\mathit{j}}}{\rm{ \times lo}}{{\rm{g}}_{{\rm{10}}}}\frac{\mathit{N}}{{{\mathit{n}_\mathit{i}}}}{\rm{, }}\;\mathit{i} \in \left( {{\rm{1, }}\mathit{M}} \right){\rm{, }}\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\mathit{j} \in \left( {{\rm{1, }}\mathit{N}} \right), \end{array} $ | (3) |

其中,mi, j为视觉单词Fi在图像Pj中出现的次数,N为训练图像的总数,ni为包含视觉单词Fi的训练图像数目.

依据生成的词汇树,可将图像特征表示转化为视觉单词表示.具体过程为:对于图像中提取的某特征点,计算其与视觉词典中各个视觉单词间的距离,找到距离最近的视觉单词代替此底层特征.对图像所有提取的特征点重复上述步骤,并通过统计图像中每个视觉单词出现的频次得到该图像的视觉词汇直方图.通过TF-TDF模型量化,图片可由向量[w1, j, w2, j, w3, j, w4, j…, wM-1, j, wM, j]表示.

视觉词袋模型忽略了图像视觉单词之间的空间分布信息.SPM采用多尺度的分块方法,即将特征空间划分为不同尺度0, 1, …, L,在尺度l下特征空间的每一维划出2l个细分区域.在每个尺度下计算每个细分子区域内的直方图,每层金字塔的提取方式和分块直方图类似,当L=0时,即为词袋模型的情景.SPM将图像划分为金字塔各个水平上需逐渐精细的网格序列,然后分别计算各个子区域的词典直方图向量,将不同层次、不同区域的直方图向量组合起来,以此作为图像的表示.这样虽然考虑了特征点的空间信息,但是SPM限制了目标在图像中出现的方位,当图像目标出现旋转、平移和缩放变化时,匹配精确度就会受到比较大的影响.

在GIS中,空间关系具有尺度、认知、层次、拓扑等特征.本文针对空间金字塔模型的缺陷,提出了基于特征点群相似度计算模型的图像表示方法.该方法通过计算特征点群之间的空间拓扑相似度、距离相似度和方向相似度对图像进行筛选,并围绕由特征点群计算得到的标准差椭圆的中心以及旋转角度来调整SPM对图像子区域的划分,以进一步增强图像分类检索的准确性.

2 基于特征点群相似度计算模型的图像表示方法 2.1 基于FREAK特征的层级式聚类FREAK是二进制描述符,二进制向量汉明空间一般采用汉明距离衡量二进制特征差异.在对二进制向量进行聚类的过程中,需要将这些二进制向量分成K份,每一份用一个均值向量表示,也就是所谓的聚类中心.

文献[8]证明了汉明空间存在密集边缘特性,同时由于汉明距离中心不具有明显的区分性,二进制向量聚类也无法求出理想的聚类中心.为了有效克服这些问题,本文采取512维的FREAK特征,避免了边缘密集特征,用概率中心与词汇树节点替代原始二进制中心向量[9]进行关联,能有效量化特征分布情况.

2.2 特征点群相似度计算模型当通过词汇树进行粗筛选后,得到与待匹配图像距离较为接近的一些训练图像.由于词袋模型对特征点空间信息的描述有缺失,此时,可能会在结果集中遇到仅仅与直方图统计结果近似,但实际却不是同一目标的结果.

由此,需要分析特征点的空间位置分布,进一步提高对图像描述的准确性.点群目标是空间分布分析的重要研究对象,点群目标的拓扑关系、距离关系、方向关系、分布范围和分布密度等是对空间点群相似度整体度量的重要参考.特征点群的分布具有一定的规律性,同一个目标物体所在的图片提取的点群分布其点群之间的拓扑关系、方向关系和距离关系具有相似性.在图像规格相差不大,同一目标物体发生旋转、平移、缩放变化的情况下,提取的特征点群的拓扑、方向和距离表示如图 1所示.

|

图 1 特征点群相似度示意图 Fig. 1 Similarity of keypoints |

图 1中彩色块代表的是特征点周围的Voronoi邻居,可以作为特征点群的拓扑邻居来衡量点群的拓扑关系.根据特征点群计算得到的标准差椭圆,其大小和方向反映了特征点群的分布形状和分布方向等信息,即可以代表图像中目标主体的大小位置和朝向,并且平移和旋转不变形.

因此,本文就从拓扑、方向、距离三方面对特征点群相似度进行度量.通过对特征点群相似度的计算,从粗筛选结果中过滤掉特征点群相似度较差的训练图像.同时,根据特征点群计算得到的标准差椭圆,通过其圆心所在位置以及旋转角度,进一步改进SPM多尺度下细分区域的划分,得到抗旋转、平移和缩放的图像表示.处理过程如图 2所示.

|

图 2 系统流程示意图 Fig. 2 System flow |

对于特征点群之间的拓扑关系判定,本文采用的是Voronoi邻居作为点群拓扑信息的描述参数.不同于地理空间中拓扑关系的判定,栅格图像中距离的界定无统一标准,而采用Voronoi邻居作为点群拓扑信息的描述,其邻居个数不需要人为固定,也不需要考虑特征点之间距离的绝对关系,同时对于尺度和密度变化具有一定适应性[10].

定义

定义

点群P1和点群P2的拓扑相似度判定采用文献[11]的计算公式:

| $ {\rm{SIM\_topo = 1 - }}\frac{{{\rm{|}}{\mathit{H}_{\rm{1}}}{\rm{ - }}{\mathit{H}_{\rm{2}}}{\rm{|}}}}{{{\rm{max(}}{\mathit{H}_{\rm{1}}}{\rm{, }}{\mathit{H}_{\rm{2}}}{\rm{)}}}}. $ | (3) |

GIS中对于空间点群模式一般会从点的疏密、方位、数量、大小等多角度进行考察.标准差椭圆就是同时对点的方位和分布进行分析的一种经典算法.它可以从二维的角度对特征点的分布方向的偏离大小以及分布形状等空间信息进行描述[12].

图像特征点群的方向会随着图像的旋转发生一定的变化,因此在计算2幅图像特征点群方向相似度时,不能直接用计算得到的标准差椭圆的方向进行度量.本文综合考虑特征点群方向以及特征点群的特征主方向,用计算得到的2个方向之间的夹角进行方向相似度度量.

2.2.2.1 FREAK特征点主方向在采样点对中选取45个长的、对称的采样点对来提取特征点的方向,因而提高了FREAK算法的速度,内存占用也可大大降低.本文采用文献[5]的公式计算FREAK特征方向.

| $ \mathit{H}{\rm{ = }}\frac{1}{\mathit{M}}\sum\limits_{{\mathit{P}_{\rm{0}}} \in \mathit{G}} {{\rm{(}}\mathit{I}{\rm{(}}\mathit{P}_0^{{\mathit{r}_{\rm{1}}}}{\rm{) - (}}\mathit{I}{\rm{(}}\mathit{P}_0^{{\mathit{r}_{\rm{2}}}}{\rm{)}}} \frac{{\mathit{P}_0^{{\mathit{r}_{\rm{1}}}} - \mathit{P}_0^{{\mathit{r}_{\rm{2}}}}}}{{\left\| {\mathit{P}_0^{{\mathit{r}_{\rm{1}}}} - \mathit{P}_0^{{\mathit{r}_{\rm{2}}}}} \right\|}}, $ | (4) |

其中,H表示计算梯度所有采样点对的集合,M代表采样点对的数目,P0r1和P0r2为采样点中心的二维向量.

FREAK特征点主方向代表了该特征点主要的梯度变化方向.本文对图像中所有获取的特征点进行特征方向计算,得到梯度方向后,使用直方图进行统计.直方图的横轴是梯度方向的角度,为0°~360°,每36°一个柱共10个柱;纵轴为梯度方向统计数量,直方图的峰值就是该幅图像特征点群的主方向.

2.2.2.2 标准差椭圆标准差椭圆的生成算法包含了3个重要因素:圆心、旋转角度和XY轴的长度[11].计算步骤如下:

(ⅰ)由椭圆圆心直接计算算术平均:

| $ \left( {\mathit{\bar x}{\rm{, }}\mathit{\bar y}} \right){\rm{ = }}\left[{\frac{{\sum\limits_{\mathit{i} = 1}^\mathit{n} {{\mathit{x}_\mathit{i}}} }}{\mathit{n}}, \frac{{\sum\limits_{\mathit{i} = 1}^\mathit{n} {{\mathit{y}_\mathit{i}}} }}{\mathit{n}}} \right]{\rm{, }} $ | (5) |

其中,xi和yi是每个要素在图像上的位置信息.

(ⅱ)确定椭圆的方向,即计算旋转角度.

| $ \begin{array}{l} \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{\rm{tan}}\;\mathit{\theta }{\rm{ = }}\frac{{\mathit{A}{\rm{ + }}\mathit{B}}}{\mathit{C}}{\rm{, }}\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\mathit{A}{\rm{ = }}\left( {\sum\limits_{\mathit{i} = 1}^\mathit{n} {\widetilde {\mathit{x}_\mathit{i}^2}} - \sum\limits_{\mathit{i} = 1}^\mathit{n} {\widetilde {\mathit{y}_\mathit{i}^2}} } \right){\rm{, }}\\ \mathit{B}{\rm{ = }}\sqrt {{{\left( {\sum\limits_{\mathit{i} = 1}^\mathit{n} {\widetilde {\mathit{x}_\mathit{i}^2}} - \sum\limits_{\mathit{i} = 1}^\mathit{n} {\widetilde {\mathit{y}_\mathit{i}^2}} } \right)}^2} + 4{{\left( {\sum\limits_{\mathit{i} = 1}^\mathit{n} {\widetilde {{\mathit{x}_\mathit{i}}}\widetilde {{\mathit{y}_\mathit{i}}}} } \right)}^2}} {\rm{, }}\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\mathit{C}{\rm{ = 2}}\sum\limits_{\mathit{i} = 1}^\mathit{n} {\widetilde {{\mathit{x}_\mathit{i}}}\widetilde {{\mathit{y}_\mathit{i}}}}, \end{array} $ | (6) |

其中

(ⅲ)确定XY轴的长度,即沿长轴方向的标准差δx和短轴方向的标准差δy :

| $ \left\{ \begin{array}{l} {\mathit{\delta }_\mathit{x}}{\rm{ = }}\sqrt {\frac{{\sum\limits_{\mathit{i} = 1}^\mathit{n} {{{\left( {\widetilde {{\mathit{x}_\mathit{i}}}\cos \mathit{\theta - }\widetilde {{\mathit{y}_\mathit{i}}}\cos \mathit{\theta }} \right)}^2}} }}{\mathit{n}}} {\rm{, }}\\ {\mathit{\delta }_\mathit{y}}{\rm{ = }}\sqrt {\frac{{\sum\limits_{\mathit{i} = 1}^\mathit{n} {{{\left( {\widetilde {{\mathit{x}_\mathit{i}}}\cos \mathit{\theta - }\widetilde {{\mathit{y}_\mathit{i}}}\cos \mathit{\theta }} \right)}^2}} }}{\mathit{n}}} . \end{array} \right. $ | (7) |

得到特征点群分布方向以及特征点群梯度方向统计值的主方向后,定义特征点群方向相似度:

| $ {\rm{SIM\_dire = }}\left| {{\rm{cos((}}{\mathit{\theta }_{\rm{1}}}{\rm{ - }}{\partial _{\rm{1}}}{\rm{) - (}}{\mathit{\theta }_{\rm{2}}}{\rm{ - }}{\partial _{\rm{2}}}{\rm{))}}} \right|, $ | (8) |

其中,θ,∂分别表示图像的特征点群分布方向和特征点群梯度主方向.

2.2.3 特征点群距离相似度特征点群距离相似度用于描述点群的集中程度,用标准差椭圆长、短轴距离之比来度量.本文采用文献[12]的计算公式:

| $ {\rm{SIM\_dist = 1 - }}\left( {\frac{{\left| {\frac{{{\mathit{b}_{\rm{1}}}}}{{{\mathit{a}_{\rm{1}}}}}{\rm{ - }}\frac{{{\mathit{b}_{\rm{2}}}}}{{{\mathit{a}_{\rm{2}}}}}} \right|}}{{\max \left( {\frac{{{\mathit{b}_{\rm{1}}}}}{{{\mathit{a}_{\rm{1}}}}}, \frac{{{\mathit{b}_{\rm{2}}}}}{{{\mathit{a}_{\rm{2}}}}}} \right)}}} \right){\rm{, }} $ | (9) |

其中,a1、b1和a2、b2分别为2个点群标准差椭圆的长、短轴.

2.3 特征点群相似度计算主要以特征点群之间的拓扑相似度、方向相似度以及距离相似度进行度量.充分考虑了由图像尺度变化、旋转变化等因素造成的影响.在无显著侧重的条件下,取几何平均进行空间相似度计算:

| $ \sqrt[3]{{{\rm{SIM\_topo \times SIM\_dire \times SIM\_dist}}}}. $ | (10) |

用特征点群相似度计算的结果,进一步筛选通过词汇树进行的粗匹配结果,从而可以排除与目标物体不一样的图像,同时,通过计算得到的标准差椭圆的圆心、旋转角度,为金字塔匹配更好地划分子区域提供依据.

2.4 改进的空间金字塔匹配通过特征点群相似度计算得到标准差椭圆的圆心和旋转角度,由此可以得到目标物体在图像中的位置和朝向.本文以椭圆圆心为划分中心,通过旋转角度对坐标轴进行旋转,以调整金字塔匹配图像子区域的划分.通过改善金字塔匹配方法,得到抗旋转、平移和缩放的图像表达,并用于进一步的匹配工作.改进划分示意图如图 3所示.

|

图 3 金字塔匹配调整示意图 Fig. 3 The adjustment of SPM |

为了验证算法的正确性,在自建的建筑物图像数据集上进行了相关的实验.

实验中,以浙江大学紫金港校区建筑物数据集中的数据为例,包括20类建筑物图片,每一类10张共200张.首先,对图像集中的20类建筑物图像进行了特征点群相似度计算,初步得到属于同一类建筑物图像之间特征点群相似度平均约为0.74,最小值为0.6.同时,对不同类别的建筑物图像进行了抽样计算,得到其特征点群相似度平均值约为0.4.为了获得更好的查全率,以相似度0.6为特征点群相似度计算的临界值,作为不同目标图片的筛选标准,用于进一步过滤粗匹配的训练图像.

对移动端实时采集的图像进行分类检索,通过对分类检索的准确率以及查全率进行统计和比较,以验证本实验方法的抗旋转、抗平移和抗缩放性能.用移动端摄像头分别对其中6类建筑捕获10幅图像,计算每一幅图像检索分类的准确率和查全率,再取平均值作为实验的结果.

实验部分数据展示如图 4所示,从上至下分别为紫金港行政楼、安中大楼、蒙明伟楼和月牙楼.

|

图 4 4类建筑物图像 Fig. 4 The four class of building images |

准确率以最终的分类结果为准;查全率为排名前10的候选图像正确匹配数与所有训练的图像数之比.

分别采用基于SPM的图像表示方法和本实验方法对移动端采集的图像进行分类检索,运行结果如表 1~2所示.

| 表 1 建筑物数据集2种方法的分类准确率 Table 1 Classification precision of the two methods on building images |

| 表 2 建筑物数据集2种方法的查全率 Table 2 Recall of the two methods on building images |

从表 1和2中可以看出,总体上本实验的图像表示方法的识别准确率要高于基于SPM的图像表示方法.在平均查全率上,本实验的图像表示方法能更准确地找到对应的相似图像.尤其是校园建筑物数据集中某类别的图像出现旋转、平移和缩放变化时,如对于安中大楼、行政楼等建筑图像,本实验方法的识别准确率、查全率要高于基于SPM的图像表示方法.同时,实验中也发现,生命科学学院楼的准确率和查全率是下降的.通过对实验数据的分析可知,生命科学学院建筑在图像中主体不明显,特征点群相似度计算结果误差大,尤其是对于标准差椭圆的计算,最后导致了图像检索结果的偏差.

为了验证本文方法在处理图像旋转、平移和缩放上的优势,有针对性地建立了一些背景干净,具有明显旋转、平移和缩放变化的物品图像数据集20类,每类6幅共120幅图像,部分数据如图 5所示,分别为钥匙、墨水盒、眼镜、鼠标等日常用品.实验选取其中4类物体,分别采用基于SPM的图像表示方法和本实验方法对图像进行分类检索.

|

图 5 自建数据集中4类图像 Fig. 5 The four class of self-built image sets |

通过移动端在上述4类物体中每类采集10幅图像,计算每一幅图像检索分类的准确率和查全率,再取平均值作为实验的结果,并进行分析.

| 表 3 自建数据集2种方法分类准确率 Table 3 Classification precision of the two methods on self-built image sets |

| 表 4 自建数据集2种方法查全率 Table 4 Recall of the two methods on self-built image sets |

由实验结果可知,无论是检索准确率还是查全率,本实验的结果基本都要优于SPM,尤其当墨水和眼镜出现比较明显的旋转、平移和缩放变化时.而对于无明显缩放和平移的类别,准确率和查全率基本一致.表明基于本实验的图像表示方法具有良好的抗旋转、平移和缩放特征.

4 结语针对目前将空间位置信息引入图像表示的SPM方法没有考虑图像中视觉物体的旋转、平移和缩放变化,本文提出了基于特征点群相似度计算模型的图像表示方法,利用特征点群相似度的计算,在词汇树粗匹配的基础上,进一步筛选特征点群分布相似度较高的图像,同时,利用计算得到的标准差椭圆的圆心、旋转角度调整空间金字塔匹配方法对子区域的划分,得到了图像抗旋转、平移和缩放变化的表示.实验结果表明,相较基于SPM的图像表示方法本文方法的分类检索准确率和查全率更高;对于视觉物体具有明显旋转、平移和缩放变化的图像,本文方法优势更加显著.

但是,实验也发现,当采集图像中的建筑物主体发生较为严重的形变,或者只有建筑物主体一部分时,特征点群相似度的计算会受到影响,尤其是对于标准差椭圆的计算,会导致结果产生误差.如对于浙江大学生命科学学院建筑的识别,会因特征点群相似度的计算对结果产生误判.如何提高此类数据的查询准确率是本方法亟待解决的问题.

| [1] | NISTER D, STEWENIUS H.Scalable recognition with a vocabulary tree[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington:IEEE Computer Society, 2006, 2(10):2161-2168. |

| [2] | LAZEBNIK S, SCHMID C, PONCE J.Beyond bags of features:Spatial pyramid matching for recognizing natural scene categories[C]//IEEE Computer Society Conference on Computer Vision & Pattern Recognition.Washington:IEEE Computer Society, 2006:2169-2178. |

| [3] | CALONDER M, LEPETIT V, OZUYSAL M, et al. BRIEF:Computing a local binary descriptor very fast[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011, 34(7): 1281–1298. |

| [4] | RUBLEE E, RABAUD V, KONOLIGE K, et al.ORB:An efficient alternative to SIFT or SURF[C]//IEEE International Conference on Computer Vision. Washington:IEEE, 2012:2564-2571. |

| [5] | ALAHI A, ORTIZ R, VANDERGHEYNST P.FREAK:Fast retina keypoint[C]//IEEE Conference on Computer Vision andPattern Recognition, Washington:IEEE, 2012:510-517. |

| [6] |

索春宝, 杨东清, 刘云鹏, 等. 多种角度比较SIFT、SURF、BRISK、ORB、FREAK算法[J].

北京测绘, 2014(4): 23–26.

SUO C B, YANG D Q, LIU Y P. Comparing SIFT, SURF, BRISK, ORB and FREAK in some different perspectives[J]. Beijing Surveying and Mapping, 2014(4): 23–26. |

| [7] |

陈赟, 沈一帆. 基于词汇树的图片搜索[J].

计算机工程, 2010, 36(6): 189–191.

CHEN Y, SHEN Y F. Image search based on vocabulary tree[J]. Computer Engineering, 2010, 36(6): 189–191. |

| [8] | TRZCINSKI T, LEPETIT V, FUA P. Thick boundaries in binary space and their influence on nearest-neighbor search[J]. Pattern Recognition Letters, 2011, 33(16): 2173–2180. |

| [9] |

张运超, 陈靖, 王涌天, 等. 基于移动增强现实的智慧城市导览[J].

计算机研究与发展, 2014, 51(2): 302–310.

ZHANG Y C, CHEN J, WANG Y T, et al. Smart city guide using mobile augmented reality[J]. Journal of Computer Research and Development, 2014, 51(2): 302–310. DOI:10.7544/issn1000-1239.2014.20130991 |

| [10] |

刘涛. 空间群(组)目标相似关系及计算模型研究[D]. 武汉: 武汉大学, 2011.

LIU T.Similarity of Spatial Group Objects[D].Wuhan:Wuhan University, 2011. http://kns.cnki.net/KCMS/detail/detail.aspx?filename=chxb201304027&dbname=CJFD&dbcode=CJFQ |

| [11] |

刘涛, 杜清运, 闫浩文. 空间点群目标相似度计算[J].

武汉大学学报:信息科学版, 2011, 36(10): 1149–1153.

LIU T, DU Q Y, YAN H W. Spatial similarity assessment of point clusters[J]. Geomatics and Information Science of Wuhan University, 2011, 36(10): 1149–1153. |

| [12] |

石丹丹. 基于特征点空间关系的图像检索技术研究[D]. 南昌: 南昌航空大学, 2013.

SHI D D. Image Retrieval Technology Research based on the Spatial Relations of Feature Points[D].Nanchang:Nanchang Hangkong University, 2013. http://cdmd.cnki.com.cn/Article/CDMD-10406-1014006467.htm |

| [13] |

朱道广, 郭志刚, 赵永威, 等. 基于空间上下文加权词汇树的图像检索方法[J].

模式识别与人工智能, 2013, 26(11): 1050–1056.

ZHU D G, GUO Z G, ZHAO Y W. Image retrieval with spatial context weighting based vocabulary tree[J]. Pattern Recognition and Artificial Intelligence, 2013, 26(11): 1050–1056. DOI:10.3969/j.issn.1003-6059.2013.11.008 |