随着互联网的蓬勃发展,大量的文字信息不断涌现. 这些信息在新闻资讯、社交和网上购物等场景具有重要的价值,分类是上述应用场景的重要技术手段,而文字信息作为分类对象往往以单个语句或是几个词语拼接成的短句形式出现,因此建立一个准确的句子分类器是尤为关键的. 句子分类的研究具有很高的应用价值.

深度学习已经在计算机视觉[1]、语音识别[2]等领域取得了辉煌成果. 2013年,Mikolov等[3]通过CBOW和Skip-gram模型构建了word2vec工具,完成了对词向量的高效训练,让Hinton[4]提出的词向量理论得以广泛应用. 词向量作为从高维空间映射到低维空间的实数向量,能够将词语的大量潜在信息表示出来. 借助词向量,深度学习在自然语言处理领域的应用近年来成了研究热点[5-6].

卷积神经网络(convolutional neural network, CNN)能够从词向量表示的句子中获取局部敏感信息,得到高层次的句子特征,并能够有效应用于句子分类问题[7]. 目前,大多数用于句子分类的卷积神经网络模型往往直接以单一训练模型得到的句子中每个词的词向量作为输入,并提取特征,而在具体分类任务下,句子中不同的词对分类结果的影响是不同的,同时每个词对应的词向量受限于单一词向量训练模型,这两方面均影响最终提取的用于分类的句子特征. 针对上述问题,在前人研究成果的基础上,本文提出一种基于词向量注意力机制的双路卷积神经网络句子分类模型(Double CNN sentence classification with attention mechanism of word embeddings, AT-DouCNN). 该模型同时具有以下2个特点:

1)模型对句子中每个词对应的词向量进行调整得到扩展词向量,使得具体分类任务下句子中的关键信息更易被提取.

2)以不同词向量训练模型得到的词向量同时作为输入,分别进行卷积和池化,并在全连接层进行融合,使得提取的句子特征更加丰富.

在多个公开数据集下将该模型与几个典型的句子分类模型进行对比,实验结果表明本文所提出的模型具有良好的句子分类效果.

1 相关工作句子分类作为自然语言处理的基础研究问题一直受到研究人员的关注. 在深度学习大规模应用到自然语言处理领域之前,研究人员大多采用统计学习的方法,并结合语言学的思想. 针对具体分类任务,多种基于文本语言学特征的分类方法相继被提出. Turney[8]定义了5种句法模式,从评论中提取观点,并能够有效地应用到情感分类问题中. Yu等[9]用形容词标注的方法,在观点语句分类问题上取得了良好的效果. Wiebe等[10]通过基于规则的方法,利用主观性线索自动生成训练数据,并加入自我训练机制提升了主客观句的分类效果. Nakagawa等[11]利用带有隐变量的CRF模型,提出一种基于依存树的情感分类模型. Silva等[12]采用SVM模型并结合多种语言学特征,有效地应用在问题分类中. Wang等[13]在朴素贝叶斯方法的基础上,提出了MNB和NB-SVM 2种分类模型,并提取bigram特征,用于情感和主题的分类任务.

深度学习在自然语言处理领域的应用推动了句子分类问题的研究. Socher等[14]提出了一种递归神经张量网络(recursive neural tensor network, RNTN)模型,利用解析树表示短语,提升了句子情感分类的效果. Kalchbrenner等[15]提出了一种动态卷积神经网络(dynamic convolutional neural network, DCNN)模型,该模型以词向量作为输入,并通过宽卷积和动态k-max池化提取句子特征,有效地应用在情感和问题的分类任务中. Kim[7]提出了经典的卷积神经网络句子分类模型,同时给出几种变形,通过多个卷积核对词向量组成的矩阵进行卷积,然后进行最大池化提取句子特征,并用于多个分类任务. Zhou等[16]将卷积神经网络和长短期记忆网络(long-short term memory, LSTM)相结合,提出一种C-LSTM模型,该模型利用CNN提取句子中短语的特征,然后将短语特征输入到LSTM中获取具有短语间依赖信息的句子特征,在情感和问题的分类任务上同时取得了良好的效果.

总的来看,借助词向量、基于深度学习的句子分类模型在大多数分类任务中取得了比基于统计学习和语言学思想的传统方法更好的分类效果,并能够同时适用于多个不同的分类任务.

2 句子分类模型AT-DouCNN 2.1 词向量注意力机制注意力机制最早应用于图像处理领域,能够使神经网络在处理图像数据时重点关注对目标任务重要的信息.在自然语言处理领域,注意力机制能够有效提高机器翻译[17]、特定目标情感分析[18]等任务的效果.在句子分类问题中,句子中的每个词对具体任务分类结果的影响是不同的,例如在情感分类任务中的一个句子“the film is one of the year’s best.”,句子中的词语“best”对句子整体被判定为正向起到了关键作用,其重要性要大于句子中的其他词语. 基于注意力机制的神经网络模型在解决句子分类问题时应识别句子中哪一部分信息是重要的,并高度关注这些信息.

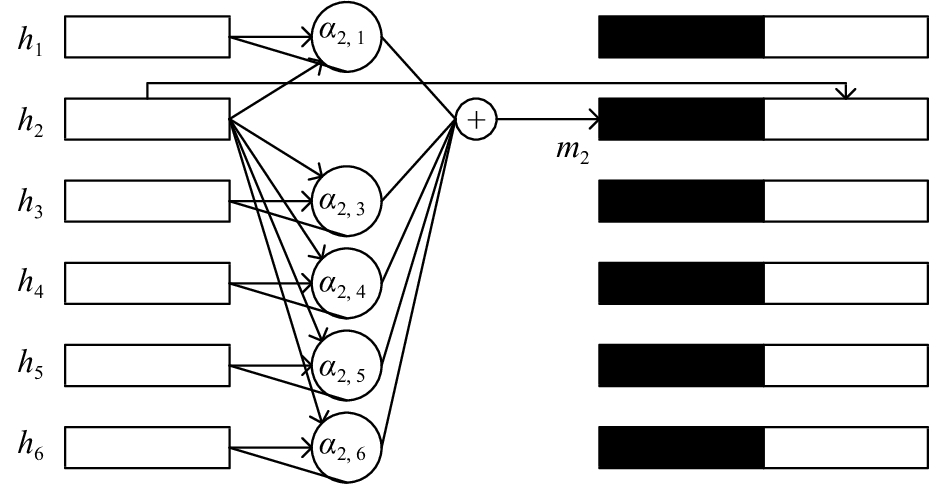

在长短期记忆网络、门控循环单元网络(gated recurrent unit, GRU)等记忆网络模型中,输入的词语之间具有依赖关系,基于注意力机制的记忆网络能够借助一个上下文向量(context vector),通过训练识别句子中词语的重要程度[19]. 在普通的卷积神经网络中,输入的词语之间是相互独立的,zhao等[20]提出了一种词向量注意力机制,通过计算句子中每个词语与其他词语在具体分类任务中的关联系数构建该词语的上下文向量,并与该词语对应的词向量连接作为输入,能够使得句子中与其他词语关系系数较大的词语得到更多关注,这些词语往往是分类的重要信息.图1给出了该词向量注意力机制的核心结构.

|

图 1 词向量注意力机制的核心结构 Fig. 1 Core architecture of attention mechanism of word embeddings |

假定一个句子的长度为n,hi∈Rk(1≤i≤n)为句子中第i个词对应的k维词向量表示. 在图1中,

| ${m_i} = \sum\limits_{j = 1,j \ne i}^n {\left({\alpha _{i,j}} \,\, {h_j}\right)} .$ | (1) |

式中:αi, j为注意力权重,通过softmax函数[17]得到:

| ${\alpha _{i,j}} = \frac{{\exp\, \, ({\rm{score}}\;({h_i},{h_j}))}}{{ \displaystyle\sum\limits_{j' = 1}^n {\exp \, \, ({\rm{score}}\;({h_i},{h_{j'}}))} }}.$ | (2) |

从式(2)中可以得到

| ${\alpha _{i,j}} \geqslant 0,\;\;\sum\limits_{j = 1}^n\, {{\alpha _{i,j}}} = 1.$ |

式(2)中的score函数用来计算2个词语间的关联系数,从而衡量词语之间的相关性,函数定义如下:

| ${\rm {score}}\,({h_i},{h_j}) ={ v_{\rm a}}{^{\rm{T}}}\tanh\,\, ({{ W}_{\rm a}}\,[{h_i} \oplus {h_j}]).$ | (3) |

其中,

从式(1)~(4)可以看出,对于一个句子中的词语i及对应的词向量

考虑到句子中2个词语间的相关性往往随着距离的增大而趋于减弱,zhao等[20]在式(4)的基础上引入了距离衰减因子

| ${\rm{score}}\,({h_i},{h_j}) = {(1 - \lambda )^u} \cdot { {v}_{\rm a}}{^{\rm{T}}}\tanh\,\, ({{ W}_{\rm a}}[{h_i} \oplus {h_j}]).$ | (4) |

其中

通过词向量

| ${h'_i} = {h_i} \oplus {m_i}.$ | (5) |

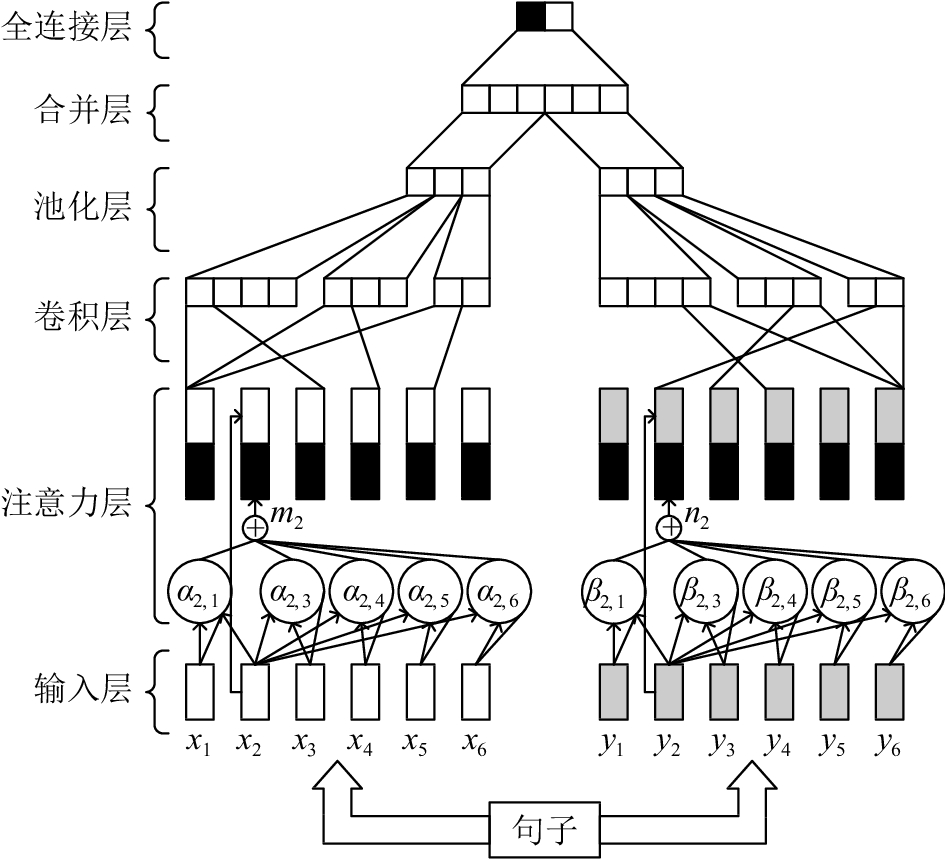

本文提出一种基于词向量注意力机制的双路CNN句子分类模型AT-DouCNN. 模型由输入层、注意力层、卷积层、池化层、合并层和全连接层6个部分组成. 模型整体框架如图2所示.

|

图 2 AT-DouCNN模型整体框架 Fig. 2 Overall framework of AT-DouCNN model |

第一层是输入层. 句子中每个词需要转化为神经网络能够识别的词向量作为输入. 本文提出的模型同时利用word2vec和Glove两种方法得到每个词语的词向量. word2vec是一种广泛使用的高效词向量训练工具[3],其基本思想是对出现在上下文环境里的词语进行预测,得到的词向量能够很好地建立词与词在语义和语法上的联系. Glove是Penning-ton等[21]通过语料库构建共现矩阵得到的一种基于全局信息的词向量训练模型,与word2vec相比,Glove更加充分地利用了语料库的全局统计信息.

假设一个分类任务的数据集中最大句子长度为n,不足长度n的句子采用零填充(zero padding)到最大长度,令

第二层是注意力层. 将输入句子矩阵A和B中每个词语的词向量表示xi、yi按照上述的式(1)~(2)、(4)~(5)得到对应的扩展词向量表示分别为

第三层是卷积层. 对于句子矩阵M和N,分别利用卷积核

| ${s_i} = {f_1}(w\cdot {{ x}'_{i:i + g - 1}} + {b_0}),$ | (6) |

| ${t_i} = {f_2}(v\cdot {{ y}'_{i:i + h - 1}} + {b_1}).$ | (7) |

式中:f1、f2为激活函数,

| $S = {\rm{ }}[{s_1},{s_2},\cdots,{s_{n - g + 1}}],$ | (8) |

| $T = [{t_1},{t_2},\cdots,{t_{n - h + 1}}].$ | (9) |

其中

第四层是池化层. 对卷积核产生的特征图S、T进行最大池化操作,获得卷积核获取的局部特征中的最重要特征,即

| $\hat s = [{\hat s_1},{\hat s_2},\cdots,{\hat s_a}],$ | (10) |

| $\hat t = [{\hat t_1},{\hat t_2},\cdots,{\hat t_b}].$ | (11) |

式中:

第五层是合并层. 对池化层得到的

| $r = \hat s \oplus \hat t.$ | (12) |

式中:

第六层是全连接层. 将合并层得到的句子特征r作为全连接层的输入,并利用softmax函数得到每个类别的概率,进而得到最终的分类结果,即

| $z = {{ W}_{\rm s}}r + {B_{\rm s}},$ | (13) |

| ${p_i} = {{\exp\,\, ({z_i})}}\left/{{\displaystyle\sum\limits_{j = 1}^C {\exp \,\,({z_j})} }}.\right.$ | (14) |

式中:

本文采用反向传播算法通过最小化交叉熵代价函数训练AT-DouCNN模型,代价函数为

| ${\rm {Loss}} = - \frac{1}{D}\sum\limits_{i = 1}^D \sum\limits_{j = 1}^C\; \left({{{\hat p}_{ij}}\log } \, {p_{ij}}\right)+ \beta\, {\left\| \theta \right\|^2}.$ | (15) |

其中D为训练的样本数,

在本文的实验中,设置word2vec和Glove训练的词向量的维数均为300,使用从10亿数量级的英文新闻语料库训练得到的word2vec词向量[23]以及从抓取的开源网络文本数据中训练得到的Glove词向量[24],采用随机初始化的方法处理实验数据集中没有出现在word2vec或glove词表中的词语. 对于模型的每路卷积操作,设置卷积核的滑动窗口大小均为3、4、5,每种尺寸的卷积核得到的特征图的数量为100,激活函数选取ReLU(rectified linear units)函数[7].

3.1 数据集为了验证模型的有效性,本文采用SST-1[25]、SST-2和TREC[26] 3个公开的数据集进行实验. SST-1是细粒度情感分类数据集,包含非常正面、正面、中性、负面、非常负面5种类别标签. SST-2是粗粒度情感分类数据集,除去了SST-1数据集中的中性评论,包含正面和负面2种类别标签. TREC是问题分类数据集,将问题按照内容分成了6个类别. 3个数据集的相关信息如表1所示.

| 表 1 数据集的相关信息 Table 1 Relevant information of datasets |

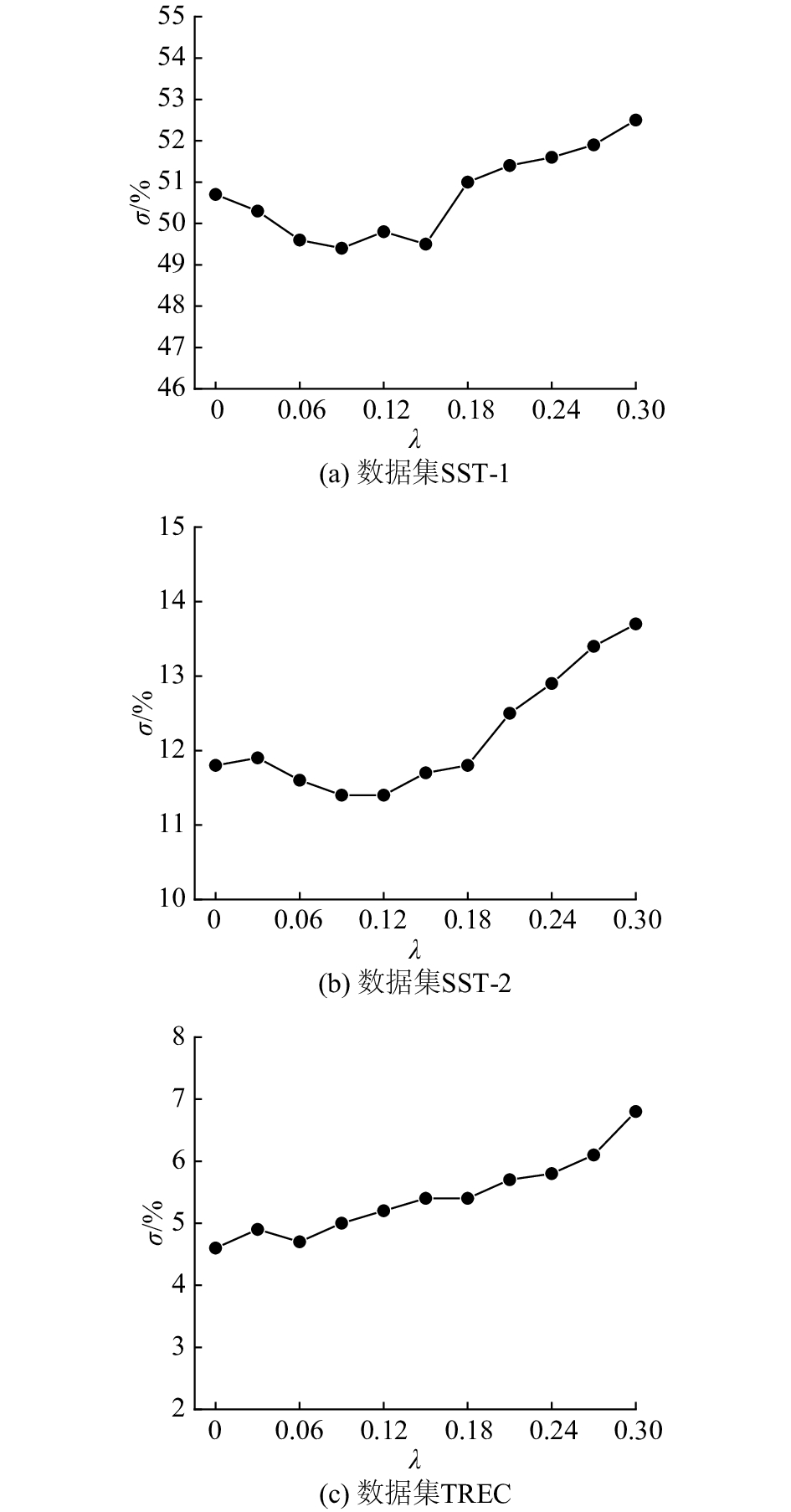

引入距离衰减是词语间关联系数计算的扩展,能够表现出词语间的距离因素对相关性的影响,从而更加准确地描述2个词语的相关性. 距离衰减因子

|

图 3 距离衰减对AT-DouCNN模型泛化能力的影响 Fig. 3 Effect of distance decay on generalization ability of AT-DouCNN model |

通过图3可以看出,对于不同分类任务下的数据集,

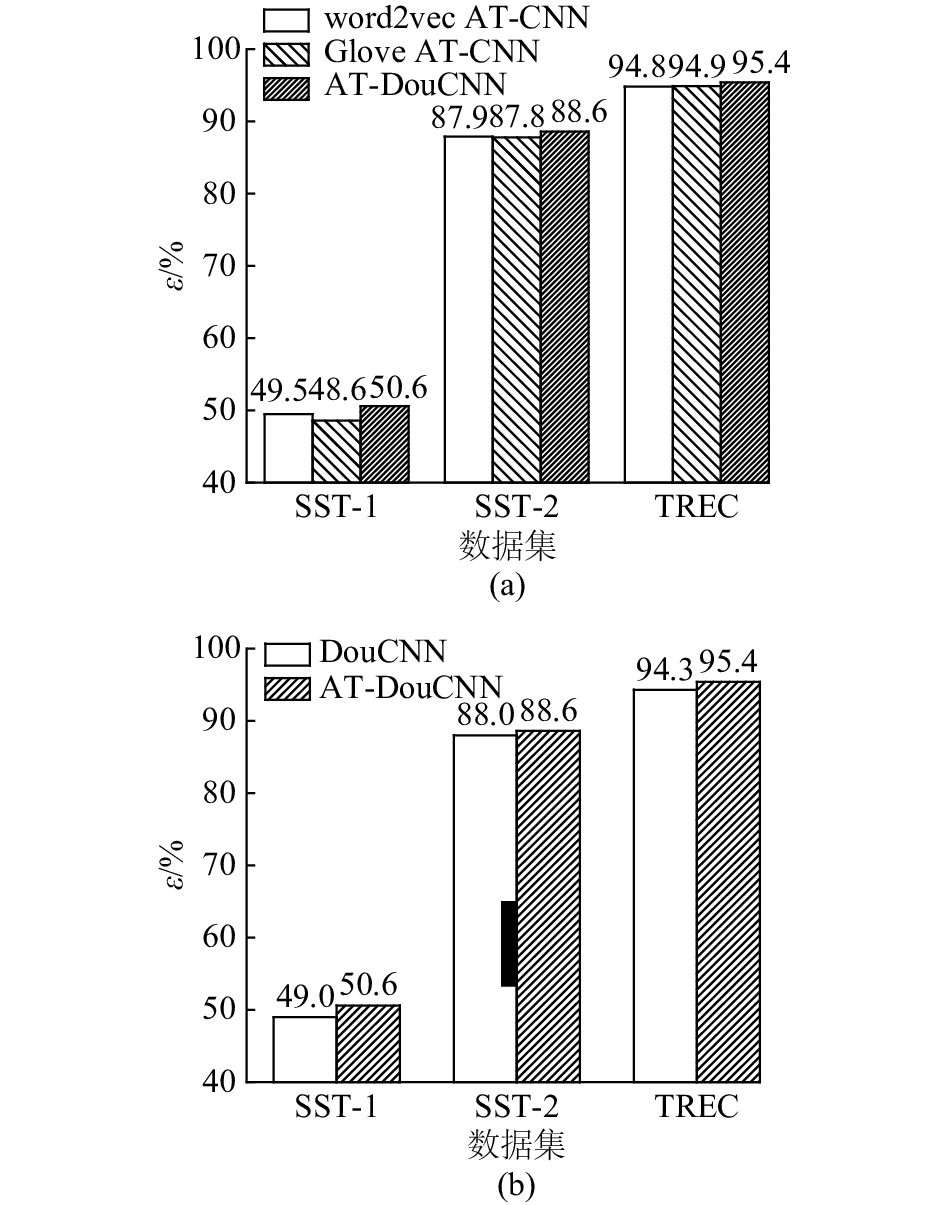

将本文提出的AT-DouCNN模型分别与基于注意力机制的单路卷积神经网络模型(AT-CNN)以及双路卷积神经网络模型(DouCNN)进行对比,其中AT-CNN模型是在经典卷积神经网络模型[7]的基础上引入上述的词向量注意力机制,以同一种词向量作为输入,这里同样选取

|

图 4 AT-DouCNN模型与AT-CNN模型和DouCNN模型的对比 Fig. 4 Comparison between AT-DouCNN and AT-CNN, DouCNN |

通过图4可知,AT-DouCNN模型相比其他2种模型具有更好的句子分类效果. 相比AT-CNN模型,AT-DouCNN模型以不同词向量训练模型得到的词向量同时作为输入,对不同种类的词向量分别进行卷积和池化操作,并在高层进行特征融合,避免了单一词向量训练模型的限制,使得所提取的句子特征更加丰富;相比DouCNN模型,AT-DouCNN模型引入了词向量注意力机制,使得具体分类任务下句子中的关键信息更易被提取,从而得到更加准确的句子特征. 本文提出的AT-DouCNN模型同时结合了注意力机制和双路卷积神经网络两方面的优势,使得句子分类的准确率进一步提高.

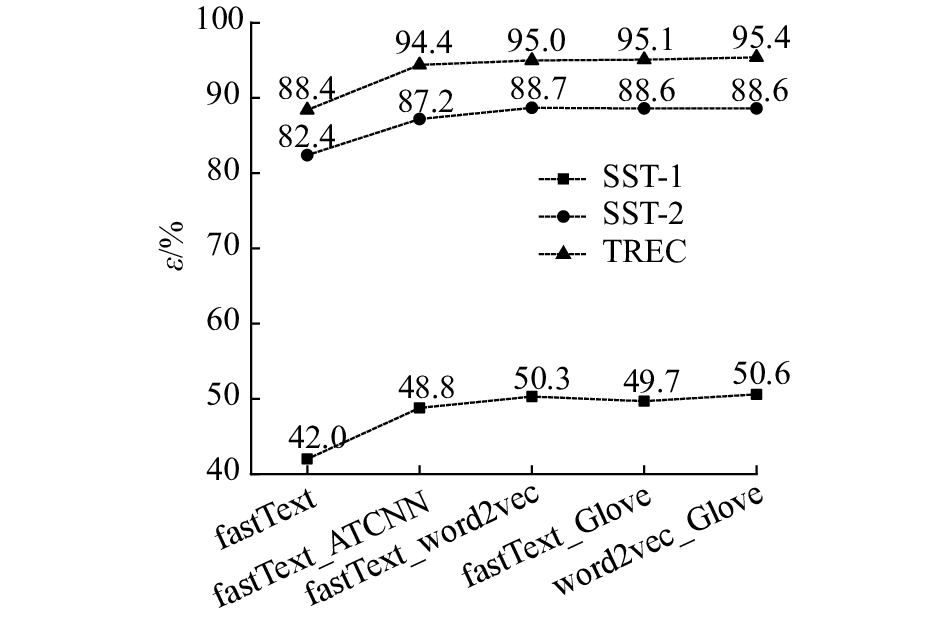

3.2.3 不同词向量作为输入的句子分类效果比较word2vec和Glove是生成词向量的经典工具,以此为理论基础能够生成其他的词向量训练工具,fastText是其中之一. fastText模型分为词向量训练和文本分类两部分,词向量训练可以看作word2vec的扩展. 与word2vec中每个词对应一个词向量相比,fastText引入了子字(subword)信息[27],以字符n-gram为单位(n一般取值为3~6),每个词可以产生多个字符n-gram,每个n-gram对应1个词向量,每个词的词向量是所有字符n-gram词向量的和. 对于未登录词,也可通过分解的字符n-gram得到对应的词向量. fastText文本分类模型[28]可看作一个浅层的神经网络,将文本用所有词的词向量均值表示,从隐层通过非线性变换得到输出层.

本节引入了fastText词向量,将fastText、word2vec和Glove词向量两两组合作为AT- DouCNN模型的输入进行比较,同时加入了以fastText词向量为输入的AT-CNN模型以及fastText文本分类模型作为对比. AT-CNN和AT-DouCNN模型均按前文所述的方式进行训练,fastText词向量通过维基百科和英文新闻等语料库训练得到[29],维数为300,并作为fastText文本分类模型的预训练词向量[30]. 实验结果如图5所示.

|

图 5 不同输入词向量的句子分类效果对比 Fig. 5 Comparison of sentence classification results with different input word embeddings |

通过图5可知,以fastText、word2vec和Glove词向量两两组合作为输入的AT-DouCNN模型在3个数据集上的句子分类效果较为接近,由于模型所提取的句子特征更加丰富,其分类效果均优于以fastText词向量为输入的AT-CNN模型,同时也说明本文所提出的模型能够适用于多组不同的词向量作为输入,得到良好的分类效果. 此外,AT-CNN和AT-DouCNN模型通过卷积和池化操作提取句子的局部特征,用高层特征表示文本,在3个数据集上的分类效果均明显优于以词向量均值表示文本的fastText文本分类模型.

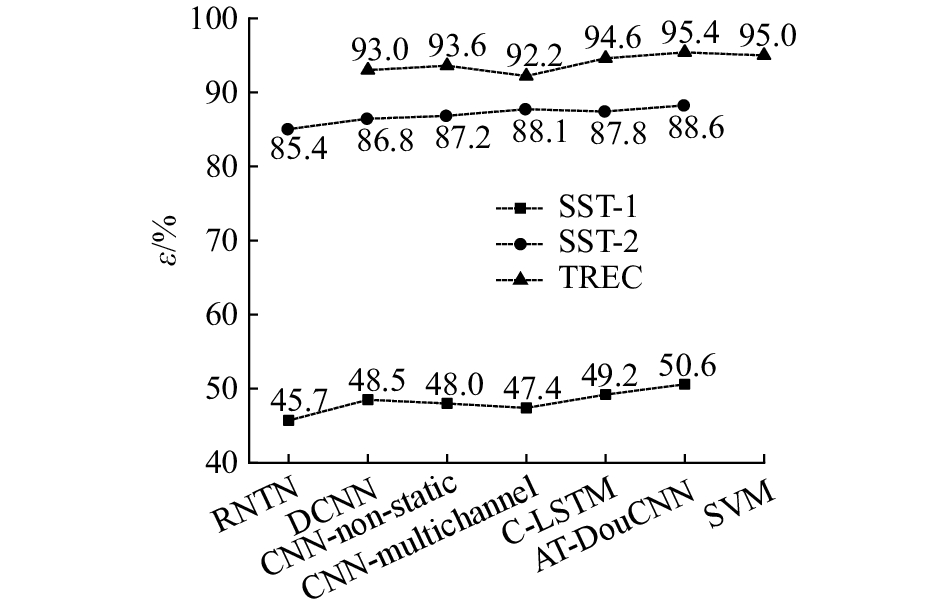

3.2.4 AT-DouCNN模型与其他句子分类模型的比较将AT-DouCNN模型与其他句子分类模型进行对比,设定以word2vec词向量和Glove词向量作为本文所提出模型的输入,选取以下几种具有代表性的模型:

1)RNTN[14]:递归神经张量网络模型,利用解析树表示短语,面向情感分析任务.

2)DCNN[15]:动态卷积神经网络模型,通过宽卷积和动态k-max池化提取句子特征.

3)CNN-non-static[7]:卷积神经网络模型,将输入的词向量矩阵作为训练过程中的可调参数.

4)CNN-multichannel[7]:卷积神经网络模型,将可调参数的词向量矩阵和不可调参数的词向量矩阵相结合作为输入.

5)C-LSTM[16]:将卷积神经网络和长短期记忆网络相结合的句子分类模型.

6)SVM[12]:结合多种语言学特征的问题分类模型.

从图6中可以看出,以word2vec和Glove词向量作为输入的AT-DouCNN模型在情感分类的2个数据集上的效果明显优于RNTN模型,在问题分类数据集上的效果略优于SVM模型,在3个数据集上的效果均优于C-LSTM模型以及所对比的其他CNN模型. 该模型利用不同的词向量同时作为输入,并引入词向量注意力机制,从而能够得到更加准确和丰富的句子特征,进而提高了句子分类的准确率. 此外,文献[12]提出的SVM模型在规模较小的问题分类数据集上取得了不亚于大多数神经网络模型的分类效果,但该模型基于语言学规则,在处理句子分类任务上具有一定的局限性,而本文提出的神经网络模型能够自动提取句子特征,在不同的分类任务上同时具有良好的效果.

|

图 6 AT-DouCNN模型与其他句子分类模型的对比 Fig. 6 Results of AT-DouCNN against other sentence classification models |

本文提出了一种基于词向量注意力机制的双路卷积神经网络句子分类模型AT-DouCNN. 该模型以不同训练模型得到的词向量同时作为输入,有效地利用不同种类的词向量得到更加丰富的句子特征. 同时该模型利用词向量注意力机制使得具体分类任务下句子中的关键信息更易被提取. 在多组公开数据集上的实验结果表明:本文所提出模型的分类准确率分别达到50.6%、88.6%和95.4%,分类效果优于经典卷积神经网络模型的48.0%、87.2%和93.6%以及所对比的其他经典神经网络模型.

本文提出的模型能够对句子等短文本进行有效分类,适用于不同的分类任务,并能够扩展到问题筛选,商品评论分析等多种实际应用场景. 对于未来的工作,可对卷积神经网络和循环神经网络的内部结构进行更加深入的探索,并应用到自然语言处理领域的其他问题中.

| [1] |

WANG X L, SHRIVASTAVA A, GUPTA A. A-Fast-RCNN: hard positive generation via adversary for object detection [C] // Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 3039–3048.

|

| [2] |

BELINKOV Y, GLASS J. Analyzing hidden representations in end-to-end automatic speech recognition systems [C] // Proceedings of the 31st Annual Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2017: 2438–2448.

|

| [3] |

MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality [C] // Proceedings of the 27th Annual Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2013: 3111–3119.

|

| [4] |

HINTON G. Learning distributed representations of concepts [C] // Proceedings of the 8th Annual Conference of the Cognitive Science Society. London: Psychology Press, 1986: 1–12.

|

| [5] |

PENG Y T, JIANG H. Leverage financial news to predict stock price movements using word embeddings and deep neural networks [C] // Proceedings of the 2016 Annual Conference of the North American Chapter of the Association for Computational Linguistics. Stroudsburg: NAACL, 2016: 374–379.

|

| [6] |

DAHOU A, XIONG S W, ZHOU J W, et al. Word embeddings and convolutional neural network for arabic sentiment classification [C] // Proceedings of the 26th International Conference on Computational Linguistics. New York: ACM, 2016: 2418–2427.

|

| [7] |

KIM Y. Convolutional neural networks for sentence classification [C] // Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: ACL, 2014: 1746–1751.

|

| [8] |

TURNEY P D. Thumbs up or thumbs down?: semantic orientation applied to unsupervised classification of reviews [C] // Proceedings of the 40th Annual Meeting on Association for Computational Linguistics. Stroudsburg: ACL, 2002: 417–424.

|

| [9] |

YU H, HATZIVASSILOGLOU V. Towards answering opinion questions: separating facts from opinions and identifying the polarity of opinion sentences [C] // Proceedings of the 2003 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: ACL, 2003: 129–136.

|

| [10] |

WIEBE J, RILOFF E. Creating subjective and objective sentence classifiers from unannotated texts [C] // Proceedings of the 6th International Conference on Computational Linguistics and Intelligent Text Processing. Berlin: Spring-Verlag, 2005: 486–497.

|

| [11] |

NAKAGAWA K, INUI K, KUROHASHI S. Dependency tree-based sentiment classification using CRFs with hidden variables [C] // Proceedings of the 2010 Annual Conference of the North American Chapter of the Association for Computational Linguistics. Stroudsburg: NAACL, 2010: 786–794.

|

| [12] |

SILVA J, COHEUR L, MENDES A. From symbolic to sub-symbolic information in question classification[J]. Artificial Intelligence Review, 2011, 35(2): 137-154. DOI:10.1007/s10462-010-9188-4 |

| [13] |

WANG S D, MANNING C. Baselines and bigrams: simple, good sentiment and topic classification [C] // Proceedings of the 50th Annual Meeting of the Association for Computational Linguistics. Stroudsburg: ACL, 2012: 90–94.

|

| [14] |

SOCHER R, PERELYGIN A, WU J, et al. Recursive deep models for semantic compositionality over a sentiment treebank [C] // Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: ACL, 2013: 1631-1642.

|

| [15] |

KALCHBRENNER N, GREFENSTETTE E, BLUNSOM P. A convolutional neural network for modelling sentences [C] // Proceedings of the 52nd Annual Meeting on Association for Computational Linguistics. Stroudsburg: ACL, 2014: 655–665.

|

| [16] |

ZHOU C T, SUN C L, LIU Z Y, et al. A C-LSTM neural network for text classification [EB/OL]. [2017-11-10]. http://arxiv.org/pdf/1511.08630.pdf. http://cn.bing.com/academic/profile?id=98a71da9620c7a60e8617962bec46dfd&encoded=0&v=paper_preview&mkt=zh-cn

|

| [17] |

LUONG M, PHAM H, MANNING C. Effective approaches to attention-based neural machine translation [C] // Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: ACL, 2015: 1412–1421.

|

| [18] |

梁斌, 刘全, 徐进, 等. 基于多注意力卷积神经网络的特定目标情感分析[J]. 计算机研究与发展, 2017, 54(8): 1724-1735. LIANG Bin, LIU Quan, XU Jin, et al. Aspect-based sentiment analysis based on multi-attention CNN[J]. Journal of Computer Research and Development, 2017, 54(8): 1724-1735. |

| [19] |

YANG Z C, YANG D Y, DYER C, et al. Hierarchical attention networks for document classification [C] // Proceedings of the 2016 Annual Conference of the North American Chapter of the Association for Computational Linguistics. Stroudsburg: NAACL, 2016: 1480–1489.

|

| [20] |

ZHAO Z W, WU Y Z. Attention-based convolutional neural networks for sentence classification [C] // Proceedings of the 2016 Annual Conference of the International Speech Communication Association. Baixas: ISCA, 2016: 705–709.

|

| [21] |

PENNINGTON J, SOCHER R, MANNING C. Glove: glove vectors for word representation [C] // Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: ACL, 2014: 1532–1543.

|

| [22] |

ZEILER M. Adadelta: an adaptive learning rate method [EB/OL]. [2017-11-10]. https://arxiv.org/pdf/1212.5701.pdf.

|

| [23] |

MIKOLOV T, SUTSKEVER I, CHEN K, et al. Tool for computing continuous distributed representations of words [EB/OL]. [2018-04-08]. http://code.google.com/p/word2vec/.

|

| [24] |

PENNINGTON J, SOCHER R, MANNING C. GloVe: global vectors for word representation [EB/OL]. [2018-04-08]. http://nlp.stanford.edu/projects/glove. http://cn.bing.com/academic/profile?id=537a8511c9ae20478a13d76f2a1e7035&encoded=0&v=paper_preview&mkt=zh-cn

|

| [25] |

SOCHER R, PERELYGIN A, WU J, et al. Sentiment analysis [EB/OL]. [2018-04-08]. http://nlp.stanford.edu/sentiment/.

|

| [26] |

LI X, ROTH D. Experimental data for question classification [EB/OL]. [2018-04-08]. http://cogcomp.cs.illinois.edu/Data/QA/QC/.

|

| [27] |

BOJANOWSKI P, GRAVE E, JOULIN A, et al. Enriching word vectors with subword information[J]. Transactions of the Association for Computational Linguistics, 2017, 5: 135-146. |

| [28] |

JOULIN A, GRAVE E, BOJANOWSKI P, et al. Bag of tricks for efficient text classification [C] // Proceedings of the 15th Conference of the European Chapter of the Association for Computational Linguistics. Stroudsburg: ACL, 2017: 427-431.

|

| [29] |

MIKOLOV T, GRAVE E, BOJANOWSKI P, et al. English word vectors [EB/OL]. [2018-04-08]. https://fasttext.cc/docs/en/english-vectors.html.

|

| [30] |

MIKOLOV T, GRAVE E, BOJANOWSKI P, et al. Advances in pre-training distributed word representations [EB/OL]. [2018-03-02]. https://arxiv.org/pdf/1712.09405.pdf.

|