随着网络技术、编解码技术、存储技术、移动互联技术等信息技术的迅速发展和智慧城市概念的提出, 视频监控业务的应用前景越来越广阔, 已不仅局限于单纯的安全防范, 更是成为企业、学校、交通、消防、金融等行业的监督手段和管理资源[1-3].随着视频监控所涉及的领域越来越广, 越来越多的监控设备如何管理逐渐成为一大问题, 仅仅依靠传统的人力资源已不能满足发展的要求.智能视频监控技术已成为当前的重要研究方向, 在智能家居、智能交通、智能安防等领域凸显出越来越重要的作用.

智能视频监控技术[4-5]集成了图像处理、模式识别和计算机视觉等新兴技术, 借助计算机强大的数据处理能力, 要求能够过滤视频画面的无用或干扰信息, 自动识别或跟踪目标, 分析视频源中的关键有用信息, 快速准确地定位事故现场, 判断监控画面中的异常情况, 从而有效地避免事故的发生或最大程度地减少事故带来的负面影响, 更好地保证安全.

智能视频安全监控主要包括宏观层面上中高密度群体的异常事件检测[6]和微观层面上个人的异常动作检测或者局部几个人异常行为的检测[7].由于群体性异常事件所涉及的人数更多, 事故现场更加不可控, 带来的后果更加严重, 因此本文主要研究群体性异常事件的检测.目前, 关于群体性异常事件的检测方法主要有基于社会力模型的分类[8-13]、基于特征提取的机器学习[14-16]和基于像素点特征的检测[10, 17-18]3种.这3种检测算法一般都能够得到较高的准确率, 但是由于其复杂的运算过程和超大量的处理数据, 往往运行处理效率低, 尤其在高分辨率视频的检测上很难满足实时性的要求.针对该问题, 研究群体异常事件中人群状态突变场景的检测, 提出结合背景差分与光流法的人群状态突变事件检测算法, 在保证算法具有较高准确率的前提下提高检测效率.

1 运动目标检测算法简介 1.1 视频前景提取算法智能监控系统往往由多个监控摄像头组成, 每一个监控摄像头都是静止的, 即观察到的背景几乎保持不变.在这种情况下, 感兴趣的元素为在场景中运动的物体.为了提取这些前景物体, 往往需要首先根据图像灰度、边缘等特征对背景进行建模;然后将当前的模型与背景模型进行比较, 从而检测出前景物体[19-20].目前, 静态背景下常用的视频前景提取算法主要有帧间差分法[21]、背景差分法[22-23]和混合高斯模型[20, 24]等.

帧间差分法[21]是基于像素的运动检测方法, 通过对视频图像序列中相邻两帧或者三帧图像进行差分运算来获得运动物体的轮廓, 适用于存在多个运动目标的情况.该算法实现简单, 处理速度快, 但是实际应用结果不理想, 针对运动速度较慢的目标, 过短的检测时间间隔会检测不到前景目标;针对运动速度较快的目标, 过长的检测时间间隔容易出现目标区域空洞的现象[19].

背景差分法[22-23]是利用当前帧的图像与背景图像作差分来检测运动目标的一种方法, 在背景已知的情况下是一种有效的前景提取算法.在实际应用中, 由于背景受光照因素的影响, 不存在适用于整个视频序列的理想背景.往往采用自适应的背景模型更新策略来适应实际背景环境的变化[25].

常见的背景更新策略有统计平均法、无限脉冲响应(infinite impulse response, IIR)滤波法、中值滤波法等[19, 25].其中, 统计平均法对于简单背景的情形,效果较好且处理速度快.假设pt为t时刻的像素, μt-1为当前的背景值, 则新的背景值[20]为

| $ {\mu _t} = \left( {1-\alpha } \right){\mu _{t-1}} + \alpha {p_t}. $ | (1) |

式中:α为学习率, 定义了当前像素对当前背景值的影响程度, α越大, 自适应学习速度越快.新的背景值将作为下一帧图像的背景.

混合高斯模型(Gaussian mixture model, GMM) [18, 24]是一种针对较复杂背景情况下的自适应背景模型更新方法.它不但保存背景序列的平均值, 而且保存背景序列方差, 形成一个高斯模型, 从而可得某个像素属于该背景模型的概率[20].混合高斯模型与统计平均法相比, 检测效果更好, 但由于算法复杂, 数据处理较慢, 难以达到视频序列处理实时性的要求.

1.2 光流算法光流[26-27]是一种简单实用的运动图像的表达方式, 通常定义为一个图像序列中图像亮度模式的表观运动, 即空间物体表面上的点的运动速度在视觉传感器的成像平面上的表达[28].光流的研究是利用图像序列中像素强度数据的时域变化和相关性来确定各自像素位置的“运动”, 即研究图像灰度在时间上的变化与景象中物体结构及运动的关系[29-30].光流计算大致可以分为基于匹配的方法、基于频域的方法和基于梯度的方法这3类.

光流法检测运动物体的基本原理[19]如下:给图像中每个像素点赋予一个速度矢量, 从而形成一个图像运动场.在视频序列中的一个特定时刻, 将运动物体投影在二维图像平面上, 可以得到图像上的像素点与三维物体上的点一一对应.根据各个像素点的速度矢量特征, 可以对图像进行动态分析.若视频序列图像中没有运动物体, 则光流矢量在整个图像区域内是连续变化的;当图像中有运动物体时, 运动目标和图像背景存在相对运动, 运动目标所形成的速度矢量必然和邻域背景速度矢量不同, 从而检测出运动物体及位置.

根据视觉感知原理可知,客观物体在空间上一般为相对连续运动, 在运动过程中, 投射到二维平面上的图像应该是连续变化的.根据该基本假设可知, 若视频序列某一图像上的点(x, y)在时刻t的灰度为I(x, y, t), 光流w=(u, v)在该点的水平和垂直移动分量u(x, y)和v(x, y)为

| $ u\left( {x, y} \right) = \frac{{{\rm{d}}x}}{{{\rm{d}}t}}, v\left( {x, y} \right) = \frac{{{\rm{d}}y}}{{{\rm{d}}t}}. $ | (2) |

可以得到基本的光流约束方程[31]:

| $ -\frac{{\partial I}}{{\partial t}} = \frac{{\partial I}}{{\partial x}} \cdot u + \frac{{\partial I}}{{\partial y}} \cdot v. $ | (3) |

光流约束方程表示灰度对时间的变化率等于灰度的空间梯度与光流速度的点积.为了定解(u, v)必须给式(3)附加其他约束条件, 从不同角度引入不同约束条件, 从而产生不同的光流分析方法.

Horn等[32]引入全局平滑性约束, 假设光流在整个图像上光滑变化, 即速度变化率为零, 提出HS(Horn-Schunck)光流算法.Lucas等[33]引入局部平滑性约束, 假设在一个小空间领域Ω上运动矢量保持恒定, 使用加权最小二乘法估计光流, 提出LK(Lucas-Kanade)光流算法.根据2种算法的原理特点可知, HS算法主要应用于计算稠密光流场, LK算法主要应用于计算稀疏光流场.

2 人群状态突变事件检测算法一般情况下, 当发生群体性异常事件时, 视频帧的运动状态会发生剧烈的变化, 相关特征点的光流位置会产生较大的位移, 从而得到一个相对较大的加速度.本文主要研究群体异常事件中人群状态突变场景的检测.当然, 一些有规律、有组织的运动行为, 例如多人集体跑步行为, 会在相应视频帧产生较大的加速度.为了避免该类类似行为的误检, 本文算法在处理光流加速度时, 引入光流运动方向数据, 将光流运动方向在同一个角度区间内的特征点作为一组数据进行归一化处理, 最大程度地减小正常行为的误检, 提高该算法的准确性.

提出的结合背景差分与光流法的人群状态突变事件检测算法的具体步骤如下.

1) 运用背景差分算法提取前景位置, 在前景位置处寻找特征点.

由于寻找特征点函数的计算量较大, 若利用传统方法直接在整幅图像中寻找特征点, 则会导致算法处理速度很慢, 难以达到视频实时处理的目的.该算法首先利用背景差分算法进行前景提取, 再在前景位置处调用寻找特征点函数[20]得到特征点位置信息, 假设第i个特征点的位置信息为(Pxi, Pyi).

2) 利用LK光流法进行特征点位置跟踪.

对于前一帧检测到的特征点, 调用LK光流算法函数[20]得到特征点在当前帧的位置信息(Pxi(t), Pyi(t)), 判断特征点的光流移动距离是否小于由实验设定的最小有效光流移动距离length.若小于length,则认为该特征点光流信息无效, 舍去该特征点.

3) 根据特征点位置的变化, 计算光流运动的速度、加速度和运动方向.

根据特征点前、后两帧的位置信息, 计算可得特征点的光流运动速度、加速度和运动方向分别为

| $ \begin{array}{l} {V_i}\left( t \right) = \sqrt {{V_{{x_i}}}{{\left( t \right)}^2} + {V_{{y_i}}}{{\left( t \right)}^2}} = \\ \sqrt {{{({P_{{x_i}}}\left( t \right)-{P_{{x_i}}}\left( {t-1} \right))}^2} + {{({P_{{y_i}}}\left( t \right)-{P_{{y_i}}}\left( {t - 1} \right))}^2}}, \end{array} $ | (4) |

| $ {a_i}\left( t \right) = {V_i}\left( t \right)-{V_i}\left( {t-1} \right), $ | (5) |

| $ {\theta _i}\left( t \right) = {\rm{arctan}}\frac{{{V_{{x_i}}}\left( t \right)}}{{{V_{{y_i}}}\left( t \right)}} = {\rm{arctan}}\frac{{{P_{{x_i}}}\left( t \right)-{P_{{x_i}}}\left( {t-1} \right)}}{{{P_{{y_i}}}\left( t \right)-{P_{{y_i}}}\left( {t - 1} \right)}}. $ | (6) |

4) 将运动方向360度w等分.

一方面, 由于一个运动个体可能会检测出多个特征点;另一方面, 为了避免群体性有规律、有组织的快速运动行为误检, 因此为了减少冗余特征点对结果的影响, 提高该算法检测的准确率, 以光流运动方向作为划分标准, 将360°w等分, θi(t)在同一个角度区间内的特征点作为一组数据.

5) 对每一个角度区间内的光流加速度进行高斯滤波,求均值.

假设某一个角度区间内共有n个特征点, 对应的光流加速度分别为a1, a2, a3, …, an.为了减少异常的光流值对检测结果的影响, 先对这n个光流加速度进行高斯滤波, 即对第m(1≤m≤n)个光流加速度, 有

| $ \overline {{a_m}} = {a_m}{\rm{exp}}[-{({a_m}-{a_{{\rm{avg}}}})^2}]. $ | (7) |

式中:

| $ {a_\theta } = \sum\limits_{i = 1}^n {\overline {{a_i}} /n.} $ | (8) |

6) 累加所有角度区间的光流加速度.

将划分的所有w个角度区间的加速度累加, 作为该帧视频图像的加速度A(t), 即

| $ A(t) = \sum\limits_{\theta = 1}^w {{a_\theta }(t).} $ | (9) |

7) 计算视频累积加速度,进行异常事件的判断.

由于人群状态突变事件一般有一个持续过程, 为了避免视频有些帧异常的加速度影响检测结果, 该算法引入累积加速度, 作为人群状态突变事件的检测值, 提高算法的稳定性和检测准确率.计算公式为

| $ E\left( t \right) = E\left( {t-1} \right){\partial _{{\rm{red}}}} + A\left( t \right). $ | (10) |

式中:E(t)为第t帧的累积加速度, E(t-1)为第t-1帧的累积加速度, ∂red为衰减系数, A(t)为第t帧图像的光流加速度.

设定累积加速度的阈值为Ethr, 当第t帧的累积加速度E(t)超过该阈值时, 判断为发生了人群状态突变的异常事件;当第t帧的累积加速度E(t)未超过该阈值时, 判断为未发生人群状态突变的异常事件或者人群状态突变事件恢复正常.

8) 判断是否需要增加特征点.

由于光流移动距离小于最小有效光流移动距离length的特征点被舍去, 若当前特征点个数小于由实验设定的最小特征点个数count, 则转到1),添加新的特征点;若当前特征点个数不小于由实验设定的最小特征点个数count, 则转到2),直接利用LK光流法进行特征点位置预测.

3 实验结果与分析为了验证该算法的有效性, 利用开源计算机视觉库(open source computer vision library, OpenCV), 在Windows操作系统Microsoft Visual Studio 2010开发平台下用Visual C++语言编写了检测程序, 利用自拍摄视频、CAVIAR数据库视频[34]和UMN数据库视频[35], 对该算法的检测程序进行测试.为了叙述方便, 定义正常场景视频为不含有人群状态突变场景异常事件的视频, 异常场景视频为含有人群状态突变场景异常事件的视频.数据库视频片段内容包括室内、室外各种典型的群体性异常事件和正常的运动场景.针对实验所用的测试视频, 为了保证算法在较高准确率的前提下提高运行效率, 每个参数经过10次左右的实验调整, 最终设定实验参数为length=0.5, w=72, ∂red=0.9, count=10.这是该研究的先验参数, 在一般的人群状态突变事件检测中具有代表性和通用性.在实际应用中, 可以根据不同的场景对实验参数作微小调整, 调整范围在10%以内.

3.1 算法准确性分析取其中一个自拍摄测试视频, 进行实验结果分析.如图 1所示, 该视频为自拍摄视频, 视频图像序列中, 150帧前人群没有明显的运动, 150帧开始人群突然向各个方向开始奔跑, 模拟人群状态突变事件的发生, 230帧左右人群奔跑速度开始下降, 250帧左右人群跑出图像范围或降速到慢走状态.

|

图 1 自拍摄测试视频截图 Fig. 1 Screenshots of self-shooting video |

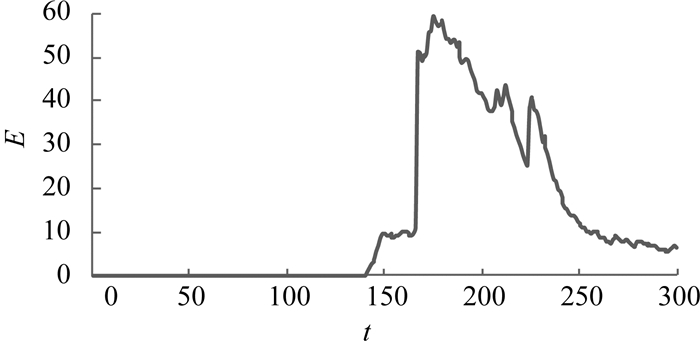

利用该算法所编写的检测程序对该自拍摄视频进行检测, 得到累积加速度随帧数变化的平滑曲线图,如图 2所示.可知, 该视频在150帧之前, 累积加速度都处于一个很低的值, 人群未发生明显运动.从160帧开始累积加速度急剧上升, 在170帧左右超过阈值, 在185帧左右达到峰值, 说明人群运动状态发生了突变, 有人群状态突变的异常事件发生.后面曲线开始阻尼下降, 说明人群运动状态趋于平稳, 在245帧之后减少到阈值以下, 恢复正常.

|

图 2 累积加速度曲线图 Fig. 2 Graph of cumulative acceleration |

根据图 2能够准确反映测试视频中的人群运动过程可知, 利用该算法能够较好地监测人群状态突变的异常事件的运动过程, 在发生人群状态突变事件时,能够及时、准确地判断.

为了验证该算法在实际应用过程中的准确率, 实验采用自拍摄视频、CAVIAR视频数据库和UMN视频数据库中的各种场景,共56个视频片段, 对该算法的检测程序进行测试.由上文定义得到56个视频片段的真实信息,如表 1所示.

| 表 1 测试视频片段信息 Table 1 Information of test video clip |

实验结果主要可以分为4类:正常场景识别、正常场景误检、异常场景识别、异常场景误检.具体的实验结果如表 2所示.表中,Ar为识别准确率.

| 表 2 视频数据库场景实验检测结果 Table 2 Test results of experiment of video database |

实验结果表明, 正常场景的识别准确率为92.1%, 异常场景的识别准确率为100%, 总识别准确率为94.6%, 说明利用该算法识别异常场景的准确率很高, 但存在将正常场景识别成异常的情况, 尤其是当场景中存在运动状态不稳定的目标时, 该算法可能会判断失败, 从而引起误检的发生.

3.2 算法效率分析为了验证该算法在实际应用过程中的效率, 实验利用不同CPU处理器的计算机, 对不同分辨率、不同场景的视频经过多次测试, 得到如下结果.

1) 不同分辨率视频的检测结果.

实验利用该算法检测程序, 采用UMN视频数据库中含有人群状态突变场景异常事件的14个测试视频, 分别设置为不同分辨率, 在i3-4150CPU处理器和8 GB内存的计算机上的运行结果如表 3所示.表中,vd为检测速度.

| 表 3 不同分辨率视频的检测速度 Table 3 Detection speed of video in different resolutions |

实验结果表明, 随着视频分辨率的提高, 算法的检测速度会降低.经调查可知, 目前的监控视频主要使用QCIF(176×144)、CIF(352×288)、HALF D1(704×288)、D1(704×576)等几种分辨率[36], 帧率一般设置为20~30帧/s可调,即33~50 ms/帧.由此可得, 对于目前主流的视频监控, 该算法能够满足实时检测的要求.

2) 不同CPU处理器的检测结果.

实验利用该算法检测程序, 采用UMN视频数据库中含有人群状态突变场景异常事件的14个测试视频, 设置分辨率为640×480, 在不同CPU处理器的计算机上运行, 结果如表 4所示.

| 表 4 不同CPU处理器的检测速度 Table 4 Detection speed of video using different CPU |

实验结果表明, CPU的处理速度会影响算法的检测效率, 但是该算法在Intel Core 2处理器上可以达到37.3 ms/帧的速度, 能够满足实时检测的要求.由此可得, 该算法可以保证在目前大多数的计算机上准确、实时地运行.

3.3 同类群体异常事件检测算法比较现今, 国际上一般使用受试者工作特征曲线(receiver operating characteristic, ROC),反映群体异常事件检测算法的准确性和鲁棒性[37-38].ROC曲线上的点由检测算法的真正率和假正率决定[37].首先, 对于一个测试视频进行标签, 即将不含有群体性异常突发事件的视频帧标记为正样本, 将含有群体性异常突发事件的视频帧标记为负样本.然后用检测算法对该测试视频进行检测, 对于视频中的每一帧, 定义检测结果值大于阈值的帧为检测正, 检测结果值小于阈值的帧为检测负.若检测结果如表 5所示, 则真正率TPR和假正率FPR[38]分别为

| 表 5 TPR和FPR计算表 Table 5 Calculation table of TPR and FPR |

| $ {\rm{TPR = TP/}}\left( {{\rm{TP + FN}}} \right), $ | (11) |

| $ {\rm{FPR = FP/}}\left( {{\rm{FP + TN}}} \right). $ | (12) |

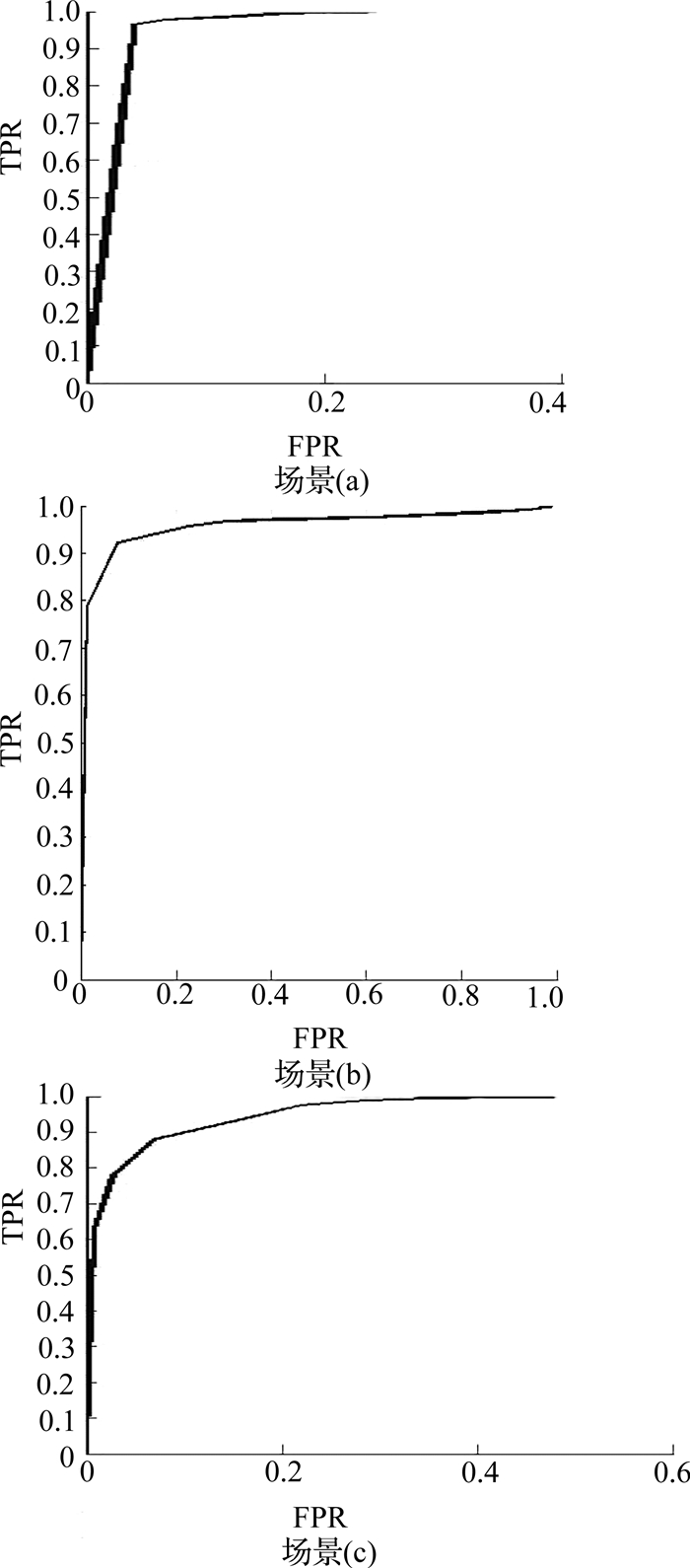

不断调整阈值, 可以得到若干组TPR和FPR.以FPR为横坐标、TPR为纵坐标,描点连线可得经过原点(0, 0)和点(1, 1)单调递增的ROC曲线.定义ROC曲线与x轴和直线x=1围成的封闭区域面积为AUC(area under curve)[38].AUC越大, 检测算法的准确性和鲁棒性越好[38].

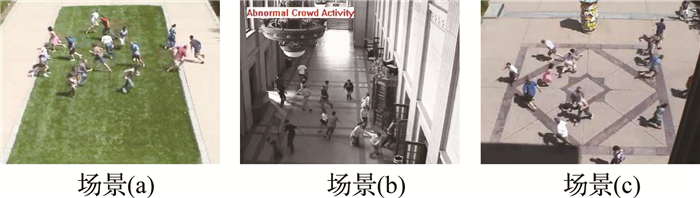

根据以上定义, 采用UMN视频数据库中3个不同场景的视频片段, 对该算法的检测程序进行测试.视频片段截图和ROC实验结果曲线图分别如图 3、4所示, 其中场景(a)处于室外操场之中, 场景(b)处于室内走廊之中, 场景(c)处于较空旷的大厅之中.经计算可知, UMN视频数据库中, 场景(a)~(c)视频片段的AUC分别为0.984 4、0.959 9、0.970 2.

|

图 3 UMN视频数据库视频截图 Fig. 3 Screenshots of UMN video |

|

图 4 UMN视频数据库视频片段ROC曲线图 Fig. 4 ROC curve of three UMN video |

对比同类检测算法, Wang等[12]提出基于时空纹理特征模型的实时人群异常检测算法;Kaltsa等[13]通过在群体理论的概念下应用方向集群直方图(histograms of oriented swarms, HOS)捕获人群异常动态的方法检测群体异常事件;Marsden等[16]提出具有平均运动速度和新人群密度两个特征的整体特征, 通过GMM和SVM进行异常检测.如表 6所示为文献[12]、[13]、[16]算法和本文算法的比较结果.

| 表 6 文献[12]、[13]、[16]算法和本文算法的性能比较 Table 6 Performance comparison of literature [12], [13], [16] and this paper |

由表 6发现, 以上4种算法都具有较高的性能.其中文献[13]算法的AUC最高, 但检测速度较慢;文献[12]算法的检测速度最快, 但AUC较低.相比而言, 本文算法能够在保证较高AUC的前提下具有较高的检测速度, 在综合性能上具有优势.

4 结语本文提出结合背景差分算法和LK光流算法的人群状态突变事件检测算法.该算法利用背景差分法提取视频帧中的前景目标, 在提取到的前景目标位置处寻找特征点, 利用LK稀疏光流法得到特征点的光流速度和光流运动方向.以光流运动方向作为划分数据依据, 采用高斯滤波, 计算得到每个运动方向内的平均高斯加速度.累加所有运动方向的平均高斯加速度作为该帧图像的加速度, 通过累积加速度来判断是否发生了人群状态突变事件.实验结果表明, 该算法针对含有人群状态突变场景的异常事件检测具有较高的准确性.此外, 该算法在不同CPU处理器的计算机上运行, 针对不同分辨率、不同帧率的监控视频, 都有较高的效率, 能够满足一般视频实时检测的要求, 较其他同类群体异常检测算法在综合性能上有明显的提高.

| [1] |

丁荣. 网络视频监控系统的构建[D]. 上海: 上海交通大学, 2007. DING Rong. Construction of internet video monitoring system[D]. Shanghai:Shanghai Jiao Tong University, 2007. http://d.wanfangdata.com.cn/Thesis/D053676 |

| [2] |

饶彦. 幼儿园智能视频监控系统探究[J]. 计算机光盘软件与应用, 2013(13): 217-218. RAO Yan. Research on intelligent video surveillance system in kindergarten[J]. Computer CD Software and Applications, 2013(13): 217-218. |

| [3] |

孙静. 校园网视频监控安全系统[D]. 天津: 天津大学, 2012. SUN Jing. Campus network video surveillance security system[D]. Tianjin:Tianjin University, 2012. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D287515 |

| [4] |

CUI W, CHEN Y, SUN C, et al. Design and imple-mentation of embedded video monitoring system based on Tiny210[C]//IEEE 11th World Congress on Intelligent Control and Automation. Shenyang:IEEE, 2014:4651-4656. http://ieeexplore.ieee.org/document/7053499/

|

| [5] |

BABAGUCHI N, CAVALLARO A, CHELLAPPA R, et al. Guest editorial:special issue on intelligent video surveillance for public security and personal privacy[J]. IEEE Transactions on Information Forensics and Security, 2013, 8(10): 1559-1561. DOI:10.1109/TIFS.2013.2279945 |

| [6] |

WANG Z, OUYANG N, HAN C. Unusual event detection without tracking[C]//2009 International Conference on Computational Intelligence and Software Engineering, Wuhan:IEEE, 2009:1-3. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5364381

|

| [7] |

WU X. Design of person flow counting and monitoring system based on feature point extraction of optical flow[C]//IEEE 5th International Conference on Intelligent Systems Design and Engineering Applications. Hunan:IEEE, 2014:376-380. http://ieeexplore.ieee.org/document/6977620/

|

| [8] |

何传阳, 王平, 张晓华, 等. 基于智能监控的中小人群异常行为检测[J]. 计算机应用, 2016, 36(6): 1724-1729. HE Chuan-yang, WANG Ping, ZHANG Xiao-hua, et al. Abnormal behavior detection of small and medium crowd based on intelligent video surveillance[J]. Journal of Computer Applications, 2016, 36(6): 1724-1729. DOI:10.11772/j.issn.1001-9081.2016.06.1724 |

| [9] |

曹艺华. 面向视频监控的大尺度人群行为分析[D]. 上海: 上海交通大学, 2013. CAO Yi-hua. The large-scale crowd analysis in video surveillance[D]. Shanghai:Shanghai Jiao Tong Uni-versity, 2013. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D544948 |

| [10] |

林沁. 视频中的大规模人群密度与异常行为分析[D]. 厦门: 厦门大学, 2014. LIN Qin. Crowd density and abnormal behavior analy-sis of video[D]. Xiamen:Xiamen University, 2014. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y2536052 |

| [11] |

王乔. 运动人体的异常行为检测研究[D]. 成都: 电子科技大学, 2012. WANG Qiao. Study on abnormal behavior detection of moving people[D]. Chengdu:University of Electronic Science and Technology of China, 2012. http://d.g.wanfangdata.com.cn/Thesis_D765527.aspx |

| [12] |

WANG J, XU Z. Spatio-temporal texture modelling for real-time crowd anomaly detection[J]. Computer Vision and Image Understanding, 2016, 144(C): 177-187. |

| [13] |

KALTSA V, BRIASSOULI A, KOMPATSIARIS I, et al. Swarm intelligence for detecting interesting events in crowded environments[J]. IEEE Transactions on Image Processing, 2015, 24(7): 2153-2166. DOI:10.1109/TIP.2015.2409559 |

| [14] |

彭怀亮. 视频监控场景中人群异常行为识别研究[D]. 杭州: 中国计量学院, 2014. PENG Huai-liang. Research on crowd abnormal behaviors recognition in video surveillance scene[D]. Hangzhou:China Jiliang University, 2014. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D556588 |

| [15] |

柴斌. 突发人群聚集事件智能视频监控[D]. 成都: 电子科技大学, 2010. CHAI Bin. Intelligent video surveillance of Burst crowd gathering event[D]. Chengdu:University of Electronic Science and Technology of China, 2010. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y1802787 |

| [16] |

MARSDEN M, MCGUINNESS K, LITTLE S, et al. Holistic features for real-time crowd behaviour anomaly detection[C]//IEEE International Conference on Image Processing. Phoenix:IEEE, 2016:918-922. http://ieeexplore.ieee.org/document/7532491/

|

| [17] |

杨世淼. 基于Web Server和Android平台的智能幼儿园管理系统[D]. 杭州: 浙江大学, 2016. YANG Shi-miao. Intelligent management system for kindergarten based on the web server and android[D]. Hangzhou:Zhejiang University, 2016. http://d.g.wanfangdata.com.cn/Thesis_Y2978904.aspx |

| [18] |

ROJAS O E, TOZZI C L. Abnormal crowd behavior detection based on Gaussian mixture model[C]//Computer Vision-ECCV 2016 Workshops. Amsterdam:[s.n.], 2016:668-675. https://link.springer.com/chapter/10.1007%2F978-3-319-48881-3_47

|

| [19] |

杜晶晶. 智能视频监控中运动目标检测与跟踪算法研究[D]. 成都: 西南交通大学, 2009. DU Jing-jing. Research on detection and tracking of moving object in intelligent video surveillance system[D]. Chengdu:Southwest Jiaotong University, 2009. http://d.wanfangdata.com.cn/Thesis/Y2191645 |

| [20] |

LAGANIERE R. OpenCV 2计算机视觉编程手册[M]. 张静, 译. 北京: 科学出版社, 2013: 46-71.

|

| [21] |

BRAGA-NETO U, GOUTSIAS J. Object-based image analysis using multiscale connectivity[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2005, 27(6): 892-907. DOI:10.1109/TPAMI.2005.124 |

| [22] |

HERRERO E, ORRITE C, SENAR J. Detected motion classifycation with a double background and a neighborhood based difference[J]. Pattern Recognition Letters, 2003, 24(12): 2079-2092. DOI:10.1016/S0167-8655(03)00045-X |

| [23] |

CUCCHIARA R, PICCARDI M, PRATI A. Detecting moving objects, ghosts, and shadows in video streams[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(10): 1337-1342. DOI:10.1109/TPAMI.2003.1233909 |

| [24] |

王永忠, 梁彦, 潘泉, 等. 基于自适应混合高斯模型的时空背景建模[J]. 自动化学报, 2009, 35(4): 371-378. WANG Yong-zhong, LIANG Yan, PAN Quan, et al. Spatio temporal background modeling based on adaptive mixture of Gaussians[J]. Acta Automatica Sinica, 2009, 35(4): 371-378. |

| [25] |

COLLINS R T, LIPTON A J, KANADE T, et al. A system for video surveillance and monitoring[C]//International Conference on Automated Deduction. Pittsburgh:[s. n.], 2000:497-501. http://www.ri.cmu.edu/publication_view.html?pub_id=3325

|

| [26] |

SONKA M, HLAVAC V, BOYLE R. 图象处理分析与机器视觉[M]. 艾海舟, 武勃, 等, 译. 2版. 北京: 人民邮电出版社, 2003: 469-491.

|

| [27] |

BEAUCHEMIN S S, BARRON J L. The computation of optical flow[J]. ACM Computing Surveys (CSUR), 1995, 27(3): 433-466. DOI:10.1145/212094.212141 |

| [28] |

VIDAL R, RAVICHANDRAN A. Optical flow estimation and segmentation of multiple moving dynamic textures[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition.San Diego:IEEE, 2005:516-521. http://doi.ieeecomputersociety.org/10.1109/CVPR.2005.263

|

| [29] |

MOCHIZUKI Y, KAMEDA Y, IMIYA A, et al. Variational method for super-resolution optical flow[J]. Signal Processing, 2011, 91(7): 1535-1567. DOI:10.1016/j.sigpro.2010.11.010 |

| [30] |

SáNCHEZ A, RUIZ J V, MORENO A S, et al. Differential optical flow applied to automatic facial expression recognition[J]. Neurocomputing, 2011, 74(8): 1272-1282. DOI:10.1016/j.neucom.2010.07.017 |

| [31] |

裴巧娜. 基于光流法的运动目标检测与跟踪技术[D]. 北京: 北方工业大学, 2009. PEI Qiao-na. Moving objects detection and tracking techniques based optical flow[D]. Beijing:North China University of Technology, 2009. http://cdmd.cnki.com.cn/Article/CDMD-10009-2009099796.htm |

| [32] |

HORN B, SCHUNCH B. Determining optical flow[J]. Artificial Intelligence, 1981, 17(1-3): 185-203. DOI:10.1016/0004-3702(81)90024-2 |

| [33] |

LUCAS B, KANADE T. An iterative image registration technique with an application to stereo vision[C]//Image Understanding Proceedings of a Workshop. Washington:[s. n.], 1981:121-130. http://dl.acm.org/citation.cfm?id=1623280

|

| [34] |

CAVIAR test case scenarios[DB/OL].[2017-01-13].http://homepages.inf.ed.ac.uk/rbf/CAVIARDATA1/.

|

| [35] |

Unusual crowd activity dataset[DB/OL].[2017-01-13]. http://mha.cs.umn.edu/proj_events.shtml.

|

| [36] |

视频监控格式[EB/OL]. [2017-01-13]. https://zhidao.baidu.com/ques-tion/558546721.html. The format of video surveillance[EB/OL].[2017-01-13].https://zhi-dao.baidu.com/question/558546721.html. |

| [37] |

HANLEY J A, MCNEIL B J. The meaning and use of the area under a receiver operating characteristic (ROC) curve[J]. Radiology, 1982, 143(1): 29-36. DOI:10.1148/radiology.143.1.7063747 |

| [38] |

FAWCETT T. An introduction to ROC analysis[J]. Pattern Recognition Letters, 2006, 27(8): 861-874. DOI:10.1016/j.patrec.2005.10.010 |