2. 中南大学 眼科医学影像处理研究中心, 湖南 长沙 410083

2. Center for Ophthalmic Imaging Research, Central South University, Changsha 410083, China

图像特征描述是计算机视觉领域中的重要研究内容, 广泛应用于图像分类、图像匹配、全景图接、场景三维重建等相关研究领域[1].其中, 图像分类任务主要根据图像特征对图像进行定量分析, 进而将图像划分为不同类别.在图像分类任务中, 有效的图像特征描述子必须能准确描述同类图像间的共同特性, 同时凸显不同类别图像的特征差异, 还须对图像光照、视角、尺寸等变化具有一定的鲁棒性.此外, 如何降低特性向量的维度, 去除其中的冗余信息, 也是构建特征描述子的关键问题.

目前, 专家学者根据图像的梯度、纹理等特征, 提出了许多图像特征描述子, 主要包括类Haar特征、局部二值模式(local binary patterns, LBP)特征, SIFT特征、梯度方向直方图(histogram of oriented gradient, HOG)特征等.其中, 类Haar特征[2]主要根据模板区域内图像像素点灰度差的值描述图像在水平、垂直方向上的边缘、轮廓特征.类Haar特征具有光照和旋转不变性, 在人脸检测领域有较好的应用效果[3-4], 但该特征对图像尺寸变化敏感, 不同尺寸的图像特征提取结果相差较大.LBP特征[5]主要根据图像局部区域内中心像素点与邻域像素点的灰度差构建二进制编码, 用来描述图像局部区域的纹理特征.LBP特征具有良好的光照不变性和灰度不变性, 但易受图像旋转的影响.在此基础上, Ojala等[6]对原始LBP特征进行改进, 通过多次旋转中心像素点的邻接区域, 构建多个LBP值, 并取其中的最小值作为中心点最终的LBP计算结果, 使得改进后的LBP特征描述子具有旋转不变性.SIFT特征[7]主要利用高斯差分(difference of Gaussian)的方法提取不同尺寸下的图像关键点, 并通过图像局部梯度分析计算得到关键点的方向, 使得提取得到的图像关键点包含位置、尺度、方向等特征信息.SIFT特征具有尺度不变性、旋转不变性和光照不变性, 应用范围较广.在众多特征描述子中, HOG特征[8]被广泛使用, 该特征通过统计图像局部区域内像素点的梯度幅值和方向, 描述图像物体的形状和轮廓特征, 其计算量小, 具有光照不变性和视角不变性等特点, 被广泛应用于行人检测[9]、人脸识别[10]、文本分类[11]、场景分类[12]等任务.

HOG特征在一定程度上能有效描述图像物体的形状和轮廓, 然而, 要求输入尺寸归一化的图像, 容易造成图像发生形变, 导致图像中的物体对应的轮廓、形状、边缘等失去原有梯度特征信息, 提取的特征向量不准确.此外, 场景图像可能包括大量的平滑区域, 该区域梯度幅值较小, 图像的轮廓和边缘不明显, 对应图像分类任务, 提供的图像特征信息较少, 无法有效地区分图像类别.因此, 直接在尺度归一化图像上提取HOG特征, 容易包含大量冗余信息.为了使提取的特征更为有效, 专家学者对传统HOG特征描述子进行改进.在图像文本分类任务中, Minetto等[11]提出了文本HOG特征.该方法根据文本行空间梯度分布特性, 将候选文本区域在垂直方向上划分成若干子区域, 提取子区域HOG特征, 并使用高斯模型计算子区域HOG特征权重, 构建加权的文本HOG特征向量.该方法计算量小, 对长条形文本区域有较好的分类效果, 但是对于单个字符的文本和非水平的文本分类效果不佳.Wu等[13]将候选文本区域的几何特征和HOG特征相结合, 构建文本特征向量.该方法对一定尺寸的文本区域有较好的分类效果, 对于其他尺寸的文本, 分类效果不佳.在图像场景分类任务中, Banerji等[12]使用Haar小波变换对传统的HOG特征进行改进.首先利用Haar小波变换对原始图像滤波得到不同的子图像, 然后提取滤波图像的HOG特征构建特征向量, 用于图像场景分类.Sinha等[14]将HOG特征与Gabor特征相结合, 提出了一种GPHOG特征描述子, 并结合主成分分析(PCA)方法对特征向量降维, 构建12 000维图像特征向量.该特征描述子能有效区分不同类别的场景图像, 但是构建的特征向量维数高、耗时长.

综上所述, 现有的基于HOG的特征描述子对传统HOG特征进行了一定的改进, 然而, 改进的HOG特征只针对特定计算机视觉任务有效[11-12], 泛化能力有待提升.此外, 如何使得提取得到的特征向量同时具有准确性和维度低的特点, 也是需要进一步研究的内容.考虑到传统HOG特征存在的问题, 本文将词汇袋模型(bag of words, BOW)模型与HOG特征相结合, 提出一种新的BOW-HOG特征描述子, 并将其用于图像分类任务.

1 研究方法基于BOW-HOG特征的图像分类流程如图 1所示.将输入图像划分为若干个尺寸一致的子区域, 移除梯度幅值较小的子区域, 对保留得到的子区域提取HOG特征;使用BOW模型对子区域的HOG特征进行编码, 构建BOW-HOG特征向量;将构建的特征向量输入训练好的分类器, 完成图像分类任务.

|

图 1 基于BOW-HOG特征的图像分类流程图 Fig. 1 Flowchart of image classification based on BOW-HOG feature |

HOG特征通过统计图像局部梯度幅值和方向的分布来描述物体的形状和轮廓, 能够适应光照变化和图像旋转, 广泛应用于图像分析领域.对图像进行HOG特征提取的主要步骤如下:

1) 输入图像预处理.将彩色图像尺寸S归一化为m×n的大小, 并将其转换为灰度图, 将像素点灰度值归一化到[0, 1].

2) 梯度计算.采用一阶差分Sobel[-1,0,1]算子计算得到灰度图像水平、垂直方向上的梯度.

3) Cell区域直方图统计.将归一化尺寸为m×n的图像划分为若干个8×8的细胞单元(Cell), 一共得到0.125m×0.125n个细胞单元.对于每个Cell, 在0~180°均匀划分的9个方向上, 统计像素点个数并使用梯度幅值对其进行加权, 计算得到该Cell区域内的直方图, 构建9维特征向量.

4) Block区域直方图统计.将2×2的Cell合并组成一个区域块(Block), 将同一个Block中的特征组合得到该Block的特征向量, 并采用L2范数对Block特征向量归一化, 得到36维特征向量.

5) 构建特征向量.将图像所有Block的特征向量进行组合, 得到输入图像最终完整的特征.

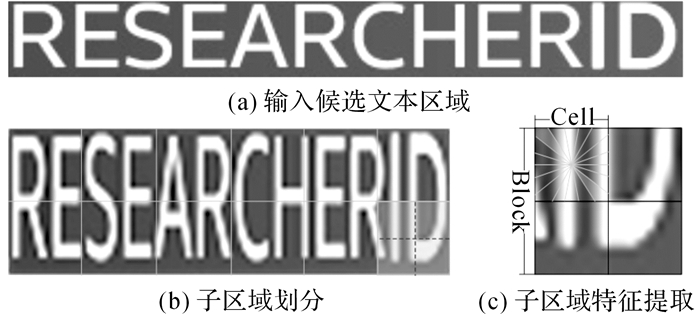

如图 2所示为说明对文本区域进行HOG特征提取的示意图.图 2(a)为输入的候选文本区域, 采用1)中的方法, 对输入图像进行尺寸归一化, 并将其转换为灰度图像.然后采用3)、4)的方法, 对灰度图像进行Cell划分, 每2×2相邻的Cell组合成一个Block, 如图 2(b)所示, 其中, 由实线划分形成的子区域为Block区域, 进一步由Block区域内的虚线划分形成的子区域为Cell区域.从图 2(b)可以看出, 通过尺寸归一化操作得到的灰度图像, 相对于原始输入图像, 存在一定的形变.对图 2(b)右下角的Block区域进行HOG特征提取, 示意图如图 2(c)所示, 采用2)中的方法, 提取每个Cell在9个不同方向上的HOG特征, 将相邻4个Cell提取的HOG特征组成一个Block特征向量, 并进行归一化处理.将所有Block中的特征向量组合得到图像最终的特征向量.

|

图 2 HOG特征提取示意图 Fig. 2 Example of HOG feature extraction |

BOW模型是信息检索领域中常用的文档表示方法.该模型通过统计字典中每个单词在文档中出现的次数, 构建文档的直方图特征向量, 用于文档分类和检索.近年来, BOW模型也广泛应用于计算机视觉领域.例如, 在图像分类领域, BOW模型首先对图像进行区域划分得到一系列子区域, 将每个子区域视为一个视觉单词.然后, 提取每个视觉单词的特征, 并与构建好的字典中的单词进行特征匹配, 统计字典单词频次直方图.最后, 根据字典单词频次直方图, 构建特征向量.本文将HOG特征与BOW模型相结合, 提取图像的BOW-HOG特征, 步骤如下:

1) 视觉单词划分与过滤.将图像划分为若干尺寸一致的子区域, 将每个子区域视为一个视觉单词.然后, 使用Sobel算子计算图像的梯度, 按下式过滤梯度幅值较小的视觉单词C(u, v):

| $ {\rm{mean}}~\left( \nabla \mathit{C}\left( u, v \right) \right)<\alpha \times {\rm{mean}}~\left( \nabla \mathit{I}\left( m, n \right) \right). $ | (1) |

式中:I(m, n)为尺寸m×n的输入图像, C(u, v)为尺寸u×v的视觉单词, α为子区域过滤因子, 具体取值通过实验进行讨论.

2) 视觉单词特征提取.对于过滤后保留的若干视觉单词, 按1.1节中的方法提取其HOG特征.

3) BOW-HOG特征构建.对于每个视觉单词, 根据下式, 计算其HOG特征与构建好的视觉字典中每个单词的距离d, 增加距离最小的字典单词的频次, 得到频次直方图:

| $ d=\sqrt{\left\| \mathit{\boldsymbol{c}}-\mathit{\boldsymbol{w}} \right\|_{2}^{2}}. $ | (2) |

式中:c为视觉单词C(u, v)的特征向量, w为字典单词的特征向量.

根据下式, 归一化得到的频率直方图, 构建BOW-HOG特征向量:

| $ {{{{n}'}}_{i}}=\frac{{{n}_{i}}}{\sum\nolimits_{i=1}^{K}{{{n}_{i}}}}. $ | (3) |

式中:K为视觉字典的大小, ni为第i个字典单词的频次, n′i为归一化后第i个字典单词的频率.

此外, 3)中的视觉字典构建主要包含3步.根据1)中的方法, 将训练集中图像样本进行视觉单词划分并过滤.采用2)中的方法, 提取每个视觉单词的HOG特征, 并根据HOG特征, 采用K-means均值聚类的方法, 将视觉单词聚K类.将每一类的聚类中心作为对应视觉单词的描述, 构建大小为K的视觉字典.

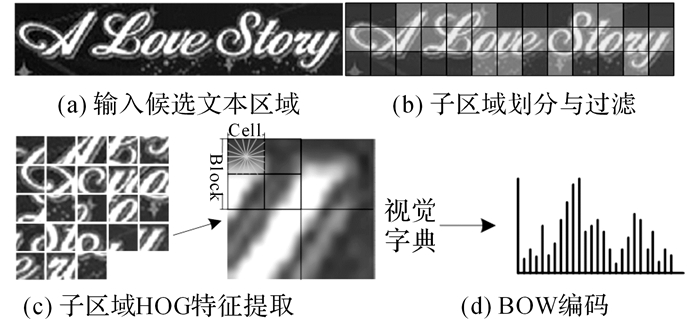

如图 3所示为说明对文本区域提取BOW-HOG特征的示意图.图 3(a)为输入的候选文本区域, 采用1)中的方法对候选文本区域进行子区域划分, 过滤梯度幅值较小的子区域, 保留边缘、轮廓明显的子区域, 如图 3(b)中的实心框标记区域, 记为视觉单词.然后, 对保留的有效子区域, 采用2)中的方法提取视觉单词的HOG特征, 如图 3(c)所示.最后, 根据3)中的方法, 计算视觉单词与视觉字典中单词的距离, 得到字典频次直方图, 构建BOW-HOG特征向量, 如图 3(d)所示.

|

图 3 BOW-HOG特征提取示意图 Fig. 3 Example of BOW-HOG feature extraction |

根据上述步骤提取得到原始图像的BOW-HOG特征向量, 输入训练好分类器, 完成图像分任务.目前, 常用分类器包括支持向量机(SVM)[15], Adaboost分类器[16], 随机森林(random forest, RF)分类器[17]等.其中, 随机森林分类器通过将多个决策树弱分类器组合形成一个强分类器, 对于噪声和异常值有一定的鲁棒性, 且泛化能力较强, 对多分类问题应用效果较好.本文选取随机森林分类器, 将BOW-HOG特征应用于不同图像分类任务.

2 实验与结果为了验证BOW-HOG特征描述子的有效性, 将其应用于具有一定挑战性的图像分类任务, 包括图像文本验证和图像场景分类.将1.3节中随机森林分类器的决策树数量设置为500.实验运行环境为4.0 GHz CPU和32 G内存64位操作系统的PC机.

2.1 数据集 2.1.1 图像文本分类数据集国际文本分析与识别大会(international conference on document analysis and recognition, ICDAR)提供了文本检测任务的公共数据集ICDAR2015.该数据集由470张网络合成图像组成, 其中训练集329张, 测试集141张.这些图像背景复杂, 包含大量与文本特征相似的背景区域, 如窗户、树叶、栏杆等, 如何选取有效特征区分文本与非文本区域是文本分类的关键.为了在ICDAR2015数据集图像上构建文本区域正负样本, 本文分别采用Matas等[18-19]提出的方法提取候选字符、构建候选文本行.将包含文字的候选文本行视为正样本;反之, 视为负样本.由此得到的训练集中包含2 077个正样本, 4 374个负样本, 测试集中包含1 320个正样本, 2 800个负样本.

2.1.2 图像场景分类数据集图像场景分类是计算机视觉领域中的重要任务, 引起专家学者的广泛关注, 同时存在大量公共数据集.其中, UIUC数据集(the UIUC sports event dataset)[20]在图像分类领域被广泛使用, 包含1 579张图像, 主要分为8种体育项目:羽毛球、室外滚球、槌球、马球、攀岩、划船、航海和滑雪, 其图像尺寸从845×1 077到1 808×496不等, 且在光照、拍摄角度、对比度等方面差异也较大.由于图像种类繁多, 不同种类图像存在相似特征, 相同种类图像在尺寸、视角等方面变化也较大, 使得图像场景分类是一项具有挑战性的任务.本文选取数据集中的1 000张图片作为训练集, 剩余图片作为测试集.

2.2 评价标准对于文本验证任务, 采用Zhang等[21]提出的召回率R、准确率P和F得分进行算法性能的评估.其中, R表示文本区域正确分类的比例;P表示候选文本区域正确分类和错误分类的比例;F用于综合衡量召回率和准确率, F值越高, 特征描述子对图像的特征表达能力越强.其具体定义分别如下:

| $ R=\frac{\sum\nolimits_{i=1}^{N}{\sum\nolimits_{j=1}^{\left| {{G}_{i}} \right|}{{\rm{max}}_{\mathit{k}=1}^{\left| {{\mathit{D}}_{\mathit{i}}} \right|}\mathit{m}\left( G_{i}^{(j)}, D_{i}^{(k)} \right)}}}{\sum\nolimits_{i=1}^{N}{\left| {{G}_{i}} \right|}}, $ | (4) |

| $ P=\frac{\sum\nolimits_{i=1}^{N}{\sum\nolimits_{k=1}^{\left| {{D}_{i}} \right|}{{\rm{max}}_{\mathit{j}=1}^{\left| {{\mathit{G}}_{\mathit{i}}} \right|}\mathit{m}\left( G_{i}^{(j)}, D_{i}^{(k)} \right)}}}{\sum\nolimits_{i=1}^{N}{\left| {{D}_{i}} \right|}}, $ | (5) |

| $ F=\frac{2\times P\times R}{P+R}. $ | (6) |

式中:N是数据集中图像的总数;Gi(j)表示第i幅图像中第j个真实的文本区域;Di(k)表示第i幅图像中第k个检测得到的文本框;m(Gi(j), Di(k))表示Gi(j)与Di(k)的匹配程度, 当两者相交面积与Gi(j)面积的比例大于0.8, 且当两者的高度比小于1.5时, 取值为1, 反之为0.

对于图像场景分类任务, 本文采用Li等[20]使用的平均准确率Pave来评估算法的性能.图像分类正确率越高, 特征描述子区分不同种类图像场景特征的能力越强.

| $ {{P}_{\rm{ave}}}=\frac{\sum\nolimits_{i}^{c}{{{m}_{i}}}}{{{N}_{\rm{T}}}}. $ | (7) |

式中:c为类别数量, mi表示第i类别正确分类的数量, NT表示测试集样本总量.

2.3 实验结果与分析将BOW-HOG特征与HOG特征应用于图像文本验证和图像场景分类任务, 实验结果如下.

2.3.1 子区域过滤因子α取值为合理选取子区域过滤因子α取值, 统计在不同参数α设置下, UIUC数据集中图像分类的正确率Pave, 随着α增大, 场景图像的分类正确率Pave先增大、后减小, 在α取值为0.8附近时, 图像场景分类性能达到最优.

2.3.2 图像文本分类(1) 基于HOG特征的文本分类.

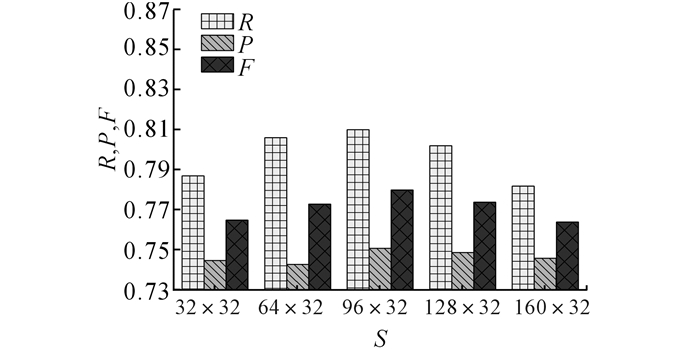

将HOG特征描述子应用于图像文本验证任务.采用1.1节的方法, 提取候选文本区域的传统HOG特征.将Cell的尺寸设置为8×8, 每个Cell划分为9个方向, 每4个Cell组成1个Block, 且Block之间不重叠, 由此每个Block区域提取得到36维特征向量.由于HOG描述子要求输入候选文本区域尺寸一致, 对文本数据集中的候选文本区域进行尺寸归一化, 分别缩放到同一尺寸.在尺寸归一化图像上, 提取HOG特征, 构建特征向量, 输入训练好的分类器, 进行文本分类.为了比较不同归一化尺寸S对HOG特征提取和文本分类的影响, 分别统计HOG特征在图像归一化尺寸S为32×32、64×32、96×32、128×32、160×32时, HOG特征表达和文本分类的性能, 统计结果如图 4所示.

|

图 4 不同图像尺寸下HOG特征文本分类性能 Fig. 4 HOG based text classification performances with different image sizes |

从图 4中可以看出, 在不同尺寸S下, 文本分类的召回率R、准确率P和F得分大致呈现先增大后减小的趋势, 且在图像尺寸为96×32时, R、P和F得分均达到最优, 分别为0.810、0.751和0.780.这是因为真实文本行的尺寸通常在一定范围内波动, 且文本验证数据集大多数文本行的宽、高比接近3:1, 因此, 当图像归一化尺寸设置为96×32时, 文本分类性能最佳.从图 4中可以看出, 文本分类的性能受图像尺寸影响较大, 说明HOG特征描述子对图像尺寸的变化较为敏感, 构建的特征向量准确性有待提高.

(2) 基于BOW-HOG特征的文本分类.

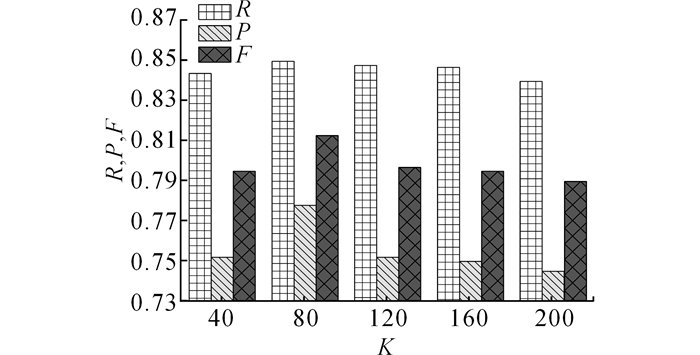

将BOW-HOG特征描述子应用于文本分类任务, 采用1.2节的方法, 构建候选文本区域的BOW-HOG特征.其中, 视觉单词C(u, v)的大小设置为32×32, 构建视觉单词时, 允许重叠采样, 设置重叠步长为16.为了比较不同视觉字典大小K对BOW-HOG特征的影响, 分别将K值设置为40、80、120、160、200, 进行文本分类性能比较, 统计结果如图 5所示.

|

图 5 不同视觉字典大小下BOW-HOG特征文本分类性能 Fig. 5 BOW-HOG based text classification performances with different visual dictionary sizes |

从图 5中可以看出, 随着视觉字典K的增大, 文本分类性能先上升后下降, 当将视觉字典大小设置为80时, 文本分类性能最佳, 召回率R、准确率P和F得分分别为0.850、0.778和0.813.这是因为, 当视觉字典较小时, 字典包含的视觉特征描述不足以准确表达候选区域的特征, 当视觉字典过大时, 同类样本之间的较小差别被过度表达, 影响特征提取的准确性.

(3) 基于HOG和BOW-HOG特征的文本分类结果比较.

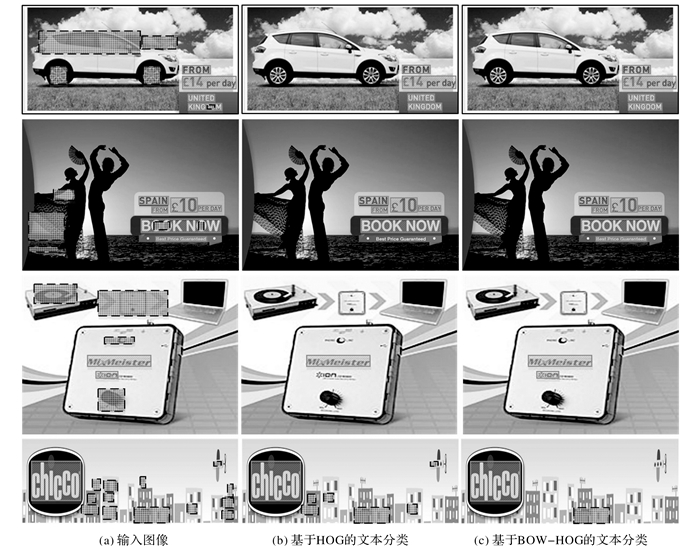

将上述HOG特征描述子与BOW-HOG特征描述子在文本公共数据集上进行试验, 部分结果如图 6所示.图 6(a)中实线文本框标定区域为文本区域, 虚线网格框标定区域为非文本区域.图 6(b)和图 6(c)分别为基于HOG特征描述子和基于BOW-HOG特征描述子的文本验证结果, 其中将分类器判定为文本的区域保留下来.

|

图 6 基于HOG和基于BOW-HOG特征的文本分类结果比较 Fig. 6 Comparison of text classification results based on HOG and BOW-HOG features |

从图 6中可以看出, 第1行图像背景简单, 并且文本尺寸适中, 基于HOG特征和基于BOW-HOG特征的文本分类方法都能取得较好的效果.第2行图像中文本与非文本区域存在相似特征, 且部分文本区域在尺寸上差异较大.基于HOG特征的方法需要对文本区域进行归一化操作, 影响提取得到的特征向量的准确性, 导致文本分类结果不理想, 如图中宽、高比相差较大的文本行“Best Price Guaranteed”会被误分割.基于BOW-HOG的文本分类方法不需对图像尺寸进行归一化操作, 因此能正确分类不同尺寸的文本, 如图 6(c)主第2行图像所示.第3行图像中包含低对比度的文本区域, 对于这类候选图像, 基于HOG特征的文本分类方法会错误过滤掉文本区域, 基于BOW-HOG的方法对低对比度的文本区域也具有较好的分类效果.对于第4行图像中的候选文本区域, 背景窗户区域与文本区域的纹理、梯度信息较为接近, 对于这种情况, 基于HOG特征的文本分类方法会产生较高的文本误分率, 无法移除特征相似的非文本.

此外, 将上述传统HOG特征描述子和BOW-HOG特征描述子的文本检测召回率、准确率和F得分进行定量比较, 结果如表 1所示.从表 1中可以看出, 基于BOW-HOG的文本分类召回率为0.850, 高于基于HOG特征的文本分类召回率(0.810), 表明BOW-HOG描述子在图像文本特征表达上优于HOG特征.同时, 基于BOW-HOG特征和传统HOG特征的文本分类准确率为分别为0.778和0.751, 说明BOW-HOG描述子能更好地表达图像中文本和非文本的特征差异.此外, 基于BOW-HOG特征的方法能获得0.813的F得分高于基于HOG特征的文本分类性能.从表 1中还可以看出, 对于尺寸为96×32的文本图像, 提取得到的HOG特征维数为432, 远高于基于BOW-HOG特征的特征向量维数80维.通过上述分析可知, 对于文本图像, BOW-HOG特征描述子提取得到的特征向量维数低, 文本分类性能高, 由此反映了BOW-HOG特征的准确性、有效性.

| 表 1 BOW-HOG和HOG在UIUC数据集上文本分类性能的比较 Table 1 Comparison of text classification performances with BOW-HOG and HOG on UIUC dataset |

在此实验过程中, 进一步地将基于BOW-HOG特征的分类方法与基于HOG特征的分类方法在分类器训练和图像测试运行时间上进行比较, 结果发现, 基于HOG特征的分类器训练耗时1 040 s, 远高于基于BOW-HOG特征的分类器训练时间(267 s).这是因为HOG提取得到的特征向量维数高, 包含大量冗余信息, 其训练时间长, 而BOW-HOG特征维数低, 耗时少.对于测试集中的单个文本行, 提取BOW-HOG特征平均耗时13 ms, 略高于HOG特征的平均提取时间(8 ms).

2.3.3 图像场景分类(1) 基于HOG特征的场景分类.

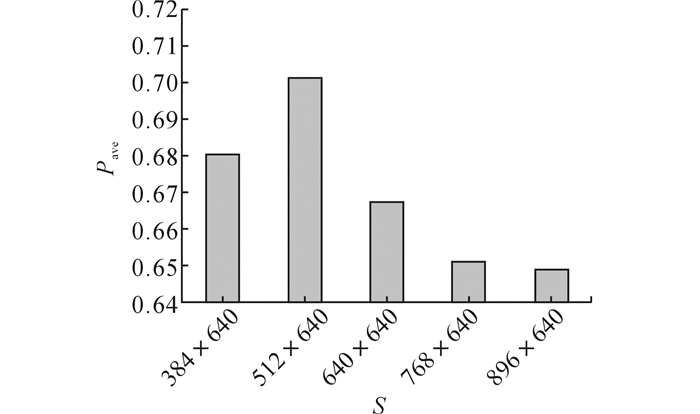

将HOG特征描述子应用于图像场景分类任务.采用1.1节的方法, 提取尺寸归一化的场景图像HOG特征, 进行图像场景分类.将Cell尺寸设置为16×16, 其他参数设置与文本分类任务保持一致.为了比较不同归一化尺寸S对HOG特征提取和场景分类的影响, 本文分别统计HOG特征在图像归一化尺寸S为384×640、512×640、640×640、768×640、896×640五个不同尺度下的场景分类性能, 结果如图 7所示.

|

图 7 不同图像尺寸下HOG特征图像场景分类性能 Fig. 7 HOG based image scenes classification performances with different image sizes |

从图 7中可以看出, 图像分类的准确率Pave先增大后减小, 当图像尺寸S为512×640时, 分类准确率最高达到0.701.这是因为公共数据库中场景图像的平均尺寸为845×1 077, 宽、高比大致为4:5, 与归一化尺寸512×640接近, 因此能获得最优的图像分类准确率.此外, 不同图像尺寸下, 图像场景分类的准确率差异较大, 相邻2个归一化尺度下的准确率平均大约相差了2%, 说明图像尺寸对HOG特征提取影响较大, 提取的HOG特征准确性需要进一步加强.

(2) 基于BOW-HOG特征的场景分类.

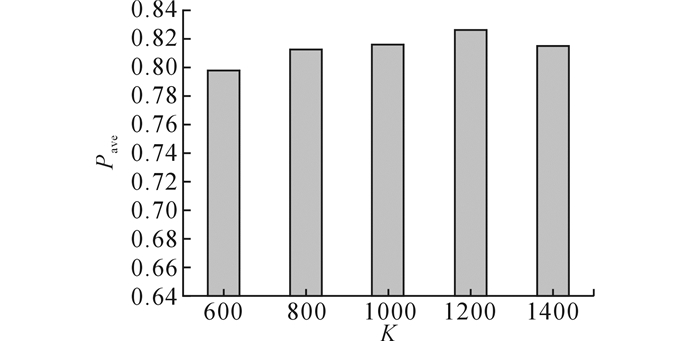

将BOW-HOG特征描述子应用于图像场景分类任务, 采用1.2节的方法, 提取场景图像的BOW-HOG特征, 构建图像特征向量, 进行场景分类.为了比较不同视觉字典大小对BOW-HOG特征的影响, 本文分别选取大小为600、800、1 000、1 200、1 400的视觉字典, 进行场景分类性能比较, 统计结果如图 8所示.

|

图 8 不同视觉字典大小BOW-HOG特征场景分类性能 Fig. 8 BOW-HOG based image scenes classification performances with different dictionary sizes |

从图 8中可以看出, 随着视觉字典大小K的变化, 场景分类性能变化较小, 不同大小字典设置下的场景分类准确率Pave平均相差0.5%, 这是因为当视觉字典包含的视觉单词描述子达到一定数量后, 就能对图像中多种场景进行特征表达, 使得图像分类准确率保持一定的稳定性.还可以看出, 当将视觉字典大小设置为1 200时, 文本分类性能最佳达到0.826.

(3) 基于HOG和BOW-HOG特征的场景分类结果比较.

将上述传统HOG特征描述子和BOW-HOG特征描述子的最优图像场景分类性能进行定量比较, 结果如表 2所示.其中W为特征维度, T1为训练时间, T2为测试时间.

| 表 2 BOW-HOG和HOG在UIUC数据集上的图像分类性能比较 Table 2 Comparison of image scenes classification performances with BOW-HOG and HOG on UIUC dataset |

从表 2中可以看出, 基于BOW-HOG特征的场景分类准确率达到0.826, 远高于基于HOG特征的场景分类准确率0.701.这是因为场景图像尺寸差异大, 基于HOG特征的方法对图像尺寸变化敏感, 使得图像场景分类效果不佳, 而BOW-HOG特征无需对图像尺寸归一化, 图像场景分类效果较好.还可以看出, 对于尺寸大小为512×640的图像, 基于BOW-HOG特征的方法构建得到的特征向量维数为1 200维, 远低于基于HOG特征方法的特征向量维数11 520维.从上述分析可知, 基于BOW-HOG特征描述子构建得到的特征向量维数低, 而获得的图像场景分类准确率更高, 说明了BOW-HOG特征描述子的优越性.此外, 由于BOW-HOG特征的方法能构建低维度的特征向量, 相应的分类器训练时长更短为542 s, 低于基于HOG特征的分类器训练时间(4 880 s).对于测试集中的图像, 提取1幅图像BOW-HOG特征平均耗时为54 ms, 略高于HOG特征的提取时间(16 ms).

(4) 不同特征图像场景分类结果比较.

进一步地, 将本文方法与现有的图像场景分类方法在不同数据集上进行定量比较, 包括UIUC数据集、MIT数据集[22]和15 Scenes数据集[23], 其中MIT数据集和15 Scenes数据集的BOW-HOG参数设置与UIUC数据集中保持一致, 将视觉单词C(u, v)的大小设置为32×32, 字典大小设置为1 200.图像分类结果如表 3所示.

| 表 3 不同分类方法在3个场景下正确率的比较 Table 3 Comparison of accuracy for different classification methods in three scenes |

从表 3中可以看出, 在UIUC数据集上, 与基于SIFT特征与图形化生成模型(SIFT generative graphical model, SIFT+GGM)的方法[20]、基于图像目标表达模型(object bank, OB)的方法[24]、上下文感知主题模型(context aware topic model, CATM)的方法[22]相比, 本文方法能获得较高的图像场景分类准确率.在MIT和15 Scenes数据集上, 本文方法与SE[23]、KC[25]方法相比, 准确率也明显提高.此外, 在UIUC和MIT数据集上, 本文方法与基于Haar-HOG特征方法[12]的图像场景分类性能相似.然而, 基于Haar-HOG特征的图像场景分类方法在多个颜色通道上提取图像特征, 构建的特征向量维数远高于本文基于BOW-HOG特征的维数, 说明BOW-HOG特征描述子优于Haar-HOG特征.

3 结语本文获得了较高的图像分类准确率.由于BOW-HOG特征无须对图像尺寸进行归一化操作, 构建得到的特征向量更能反映原始图像的特性.相对于其他特征描述子, BOW-HOG描述子构建的特征向量维数低, 这是因为BOW-HOG特征先对输入图像进行视觉单词划分, 并过滤掉梯度幅值较小的视觉单词, 移除部分冗余信息.此外, 本文运用BOW模型对视觉单词的HOG特征进行编码, 使得构建的特征向量维度低, 且只与字典大小有关, 与图像尺寸无关, 进一步说明了BOW-HOG特征的鲁棒性.

部分图像梯度特征相似度极高, 对于这类图像, 本文方法的分类效果不佳.后期要研究如何融合其他特征, 进一步提高图像分类的准确率.

| [1] |

葛娟, 曹伟国, 周炜, 等. 一种颜色仿射变换下的局部特征描述子[J].

计算机辅助设计与图形学学报, 2013, 25(1): 26–33.

GE Juan, CAO Wei-guo, ZHOU Wei, et al. A local feature descriptor under color affine transformation[J]. Journal of Computer-Aided Design and Computer Graphics, 2013, 25(1): 26–33. |

| [2] | LIENHART R, MAYDT J. An extended set of Haar-like features for rapid object detection[C]//International Conference on Image Processing 2002. New York:ICIP, 2002:Ⅰ-900-Ⅰ-903. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=1038171 |

| [3] | DO T T, DOAN K N, LE T H, et al. Boosted of Haar-like features and local binary pattern based face detection[C]//International Conference on Computing and Communication Technologies. Danang:IEEE, 2009:1-8.http://ieeexplore.ieee.org/document/5174627/ |

| [4] | MITA T, KANEKO T, HORI O. Joint Haar-like features for face detection[C]//IEEE International Conference on Computer Vision. Beijing:ICCV, 2005:1619-1626. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=1544911 |

| [5] | OJALA T, HARWOOD I. A comparative study of texture measures with classification based on feature distributions[J]. Pattern Recognition, 1996, 29(1): 51–59. DOI:10.1016/0031-3203(95)00067-4 |

| [6] | OJALA T, PIETIK, INEN M, et al. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971–987. DOI:10.1109/TPAMI.2002.1017623 |

| [7] | LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of ComputerVision, 2004, 60(2): 91–110. |

| [8] | DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego:IEEE, 2005:886-893. http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=1467360 |

| [9] | WANG X, HAN T X, YAN S. An HOG-LBP human detector with partial occlusion handling[C]//IEEE International Conference on Computer Vision. Kyoto:IEEE, 2009:32-39. https://www.researchgate.net/publication/224135946_An_HOG-LBP_human_detector_with_partial_occlusion_handling |

| [10] | KARAABA M F, SURINTA O, SCHOMAKER L R B, et al. Robust face identification with small sample sizes using bag of words and histogram of oriented gradients[C]//International Joint Conference on Computer Vision, Imaging and Computer Graphics Theory and Applications. Beijing:2016:582-589. |

| [11] | MINETTO R, THOME N, CORD M, et al. T-HOG:an effective gradient-based descriptor for single line text regions[J]. Pattern Recognition, 2013, 46(3): 1078–1090. DOI:10.1016/j.patcog.2012.10.009 |

| [12] | BANERJI S, SINHA A, LIU C. HaarHOG:improving the HOG descriptor for image classification[C]//IEEE International Conference on Systems, Man, and Cybernetics. San Diego:IEEE, 2013:4276-4281. |

| [13] | WU H, ZOU B, ZHAO Y Q, et al. Scene text detection using adaptive color reduction, adjacent character model and hybrid verification strategy[J]. Visual Computer International Journal of Computer Graphics, 2017, 33(1): 113–126. |

| [14] | SINHA A, BANERJI S, LIU C. New color GPHOGdescriptors for object and scene image classification[J]. Machine Vision and Applications, 2014, 25(2): 361–375. DOI:10.1007/s00138-013-0561-6 |

| [15] | SUYKENS J A K, VANDEWALLE J. Least squares support vector machine classifiers[J]. Neural Processing Letters, 1999, 9(3): 293–300. DOI:10.1023/A:1018628609742 |

| [16] | SCHAPIRE R E, SINGER Y. Improved boostingalgorithms using confidence-rated predictions[J]. Machine Learning, 1999, 37(3): 297–336. DOI:10.1023/A:1007614523901 |

| [17] | CUTLER A, CUTLER D R, STEVENS J R. Random forests[J]. Machine Learning, 2011, 45(1): 157–176. |

| [18] | MATAS J, CHUM O, URBAN M, et al. Robust wide-baseline stereo from maximally stable extremal regions[J]. Image and Vision Computing, 2004, 22(10): 761–767. DOI:10.1016/j.imavis.2004.02.006 |

| [19] | SUNG M C, JUN B, CHO H, et al. Scene text detection with robust character candidate extraction method[C]//201513th International Conference on Document Analysis and Recognition (ICDAR). Nancy:ICDAR, 2015:426-430. http://dl.acm.org/citation.cfm?id=2880779 |

| [20] | LI L J, LI F F. What, where and who classifyingevents by scene and object recognition[C]//IEEEInternational Conference on Computer Vision. Rio de Janeiro:IEEE. 2007:1-8. https://mycomputer.computer.org/csdl/proceedings/iccv/2007/1630/00/04408872.pdf |

| [21] | ZHANG Z, SHEN W, YAO C, et al. Symmetry-based text line detection in natural scenes[C]//IEEE Conference on Computer Vision and Pattern Recognition. Boston:IEEE, 2015:2558-2567. https://www.computer.org/csdl/proceedings/cvpr/2015/6964/00/07298871-abs.html |

| [22] | GAO X, HUA G, NIU Z, et al. Context aware topic model for scene recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. Portland:IEEE, 2012:2743-2750. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=6247997 |

| [23] | OLIVA A, TORRALBA A. Modeling the shape of the scene:a holistic representation of the spatial envelope[J]. International Journal of Computer Vision, 2001, 42(3): 145–175. DOI:10.1023/A:1011139631724 |

| [24] | SU H, XING E P, LI F F, et al. Object bank:a high-level image representation for scene classification andsemantic feature sparsification[J]. Advances in NeuralInformation Processing Systems, 2010, 26: 1378–1386. |

| [25] | VAN GEMERT J C, VEENMAN C J, SMEULDERS A W, et al. Visual word ambiguity[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(7): 1271–1283. DOI:10.1109/TPAMI.2009.132 |