[作者简介] 1.董惠敏(https://orcid.org/0000-0002-4951-0111),女,浙江大学人文学院哲学系助理研究员,哲学博士,主要从事道义逻辑、法律推理等研究; 2.雷卡・马尔科维奇(https://orcid.org/0000-0002-2488-2293),女,卢森堡大学计算机系助理研究员,哲学博士,主要从事人工智能与法律研究; 3.里昂・范德拓(https://orcid.org/0000-0003-4330-3717),男,卢森堡大学计算机系、浙江大学人文学院哲学系教授,博士生导师,计算机科学博士,主要从事人工智能、逻辑、法律推理等研究。

人工智能逻辑对智能主体推理进行形式表征。除了关于单主体知识和行动的推理以外,社会人工智能逻辑还可以通过主体的权利、义务、允许来推理多主体间的社会依赖性。权利这一概念可以表示智能主体的义务与允许之间的关系,通过比较形式论证可以识别并解决智能主体之间的各类冲突。重要的是,为了真正刻画日常推理,涵盖出现在日常生活中的各类争论,谬误论证也是可以被表征和推理的。新的基于论辩的社会人工智能逻辑研究计划面向人工智能逻辑的未来发展,可以应对社会人工智能逻辑发展中所遇到的挑战。基于论辩的社会人工智能逻辑是有效刻画社会智能主体之间依赖性的推理,它可以清晰地呈现存在于多样、复杂的社会现象中的各种冲突,可自然地解释使用某个社会冲突解决方案的原因。

Artificial Intelligence (AI) logic formalizes the reasoning of intelligent agents.With the rise of artificial intelligence and machine learning, questions are raised about how to describe the reasoning patterns of autonomous robots and other intelligent systems, especially about their capacities to reason in social interaction scenarios. When the intelligent system of a self-driving car is required to reason according to traffic rules in a social context, it can make judgments about whether or not its planned driving path will work. Reasoning, or how to balance their actions, desires,and goals with the legal and ethical norms of society has become a new challenge for the development of intelligent systems, and therefore, a new research program of social AI logic is required to respond to such demands for social reasoning in intelligent agents.

In this paper, we discuss how an argumentation-based AI logic could be employed to formalize important aspects of social reasoning. Besides reasoning about the knowledge and actions of individual agents, social AI logic can also reason about social dependence among multiple agents with the rights, and permissions of the agents. We discuss four aspects of social AI logic. First, how rights represent relations between obligations and permissions of intelligent agents. Second, how to argue about the right-to-know, a central issue in the recent discussion of privacy and ethics. Third, how a wide variety of conflicts among intelligent agents can be identified and (sometimes) resolved by comparing formal arguments, including fallacious arguments, which can also be represented and reasoned. Fourth, how to argue about free movement for intelligent agents. Examples from social, legal,and ethical reasoning are used to highlight the challenges in developing social AI logic. The discussions of the four challenges leads to a research program for an argumentation-based social AI logic, contributing to the future development of AI logic.

This paper also has two technical contributions. First, we propose a systematic way to express epistemic rights in terms of a modal language of AI logic, including actions, obligations, permissions, and knowledge. The modal language is essential for the formal representation of social reasoning. It provides a simple and compact method to formalize the possible information used by the intelligent system, via axioms and inferential rules possibly employed in their reasoning. For instance, the language can illustrate the reliable differences and interactions between ″permission to know″ and ″permission to do″, which is the key to understanding the debate regarding privacy in law and ethics. Based on the modal representations, we further develop a feasible argumentation framework to reason about the various facets of social dependence. It is a deontic epistemic action logic (DEAL) for AI to address social reasoning.

The second technical contribution is to model the reasoning among social intelligent agents, and to argue that argumentation-based AI logic is an efficient formal tool of representation. It can clearly present the conflicts among the complex and complicated social phenomena, for example, pointing out in which situation one's sensitive and classified information shall be known without violating ethical norms of the law. We further demonstrate how argumentation-based AI logic (DEAL) naturally explains each solution of solving social conflicts, by picking out the decisive elements during the argument procedure. A conclusion for an agent to reason some social phenomenon might then need to be withdrawn when the hypothetical information or the inferential rules are defeated. The case for protecting an individual's privacy can similarly be dismissed when there is another stronger and more prudent legal or ethical reason that attacks its background information or the reasoning procedure. An example of this might be to protect public safety. The DEAL logic can be viewed as a computational and logical system to model explainable AI for social reasoning.

【主持人语】 新一代人工智能是指围绕大数据智能、群体智能、跨媒体智能、人机混合增强智能和自主智能系统等新型人工智能应用领域, 以云计算、大数据和机器学习等为核心要素, 以伦理和规制为健康发展要求的人工智能新理论、新方法和新技术。在新一代人工智能的背景下, 逻辑学有望在不同层面发挥基础性作用, 尤其是关于人工智能伦理、法律和多智能体社会等的形式化分析和建模。其中, 人工智能伦理涉及社会价值和社会规范的遵循以及不同利益相关方的价值冲突和平衡等; 人工智能法律涉及法律规范、法律概念、法律解释等的形式化, 并在此基础上实现智能推理和决策; 多智能体社会涉及自主智能主体之间的各种交互, 而这种交互则受到社会、法律和伦理等方面的约束和导向。由于不同的逻辑系统具有不同的特性, 如何依据应用领域的要求建立各种逻辑系统, 是一个需要持续开展研究的开放性问题。

为了反映新一代人工智能背景下逻辑学发展的最新动态, 促进学科交叉以及国内外学者的交流与合作, 《浙江大学学报(人文社会科学版)》特推出“ 新一代人工智能驱动的逻辑学研究” 栏目。本期刊发四篇文章, 董惠敏、雷卡・ 马尔科维奇、里昂・ 范德拓的《面向社会推理的人工智能逻辑》提出了一个关于社会人工智能逻辑的研究计划, 展示了关于行动、知识、权利、义务和允许的人工智能论辩逻辑如何形式化社会推理的各个方面; 奥利弗・ 罗伊、 彼得・ 库里基的《带有强允许的分级法律体系中的法律允许与法律权能》就法律条文中的弱允许和强允许, 提出了一个逻辑分析工具来处理这两类允许, 旨在为进一步研究分级法律体系中签发强允许的影响奠定基础; 刘奋荣、付小轩的《关于偏好关系的质化与量化研究— — 中间道路的探索》把定性的逻辑方法和定量的概率方法相结合, 提出了一种概率偏好模型, 并研究了其逻辑性质; 石辰威的《潜在集体信念》研究社会网络中群体成员之间的相互影响如何在群体信念的形成中发挥作用, 提出了一种新的关于群体信念的理论。

《浙江大学学报(人文社会科学版)》开辟“ 新一代人工智能驱动的逻辑学研究” 栏目, 充分展现了引领学术前沿的风格。本栏目欢迎海内外学者惠赐佳作。

本栏目特约主持人: 浙江大学 廖备水教授

人工智能不仅是计算机科学的子学科, 还覆盖了哲学、心理学、社会学、法律、经济学等学科的不同方面。人工智能研究开发模仿人类智能的程序, 使计算机具有智能行为[1], 在感知、表征与推理、学习、自然交互、社会影响等五个方面开发相应的人工智能技术。将逻辑用于这些方面[2, 3], 尤其是在可解释性人工智能(explainable AI)这一背景下, 能弥补以往“ 黑匣子” 式人工智能技术的不足[4]。

随着人工智能和机器学习的兴起, 人们关心的不仅是自主机器人及其他智能系统对自身行为的推理问题, 还包括如何在个体愿望、目标与社会、法律、伦理规范之间保持平衡[5]。此外, 还要思考智能主体是如何考虑其他主体行为的[6, 7, 8]。例如, 自动驾驶汽车不仅能做出驾驶和导航这类行为, 而且必须考虑交通法规, 还需要对其他自动驾驶或人类驾驶行为进行推理。因此, 本文集中回应如下挑战:人工智能逻辑如何考虑社会推理?

尽管社会人工智能逻辑领域已经有一定的进展, 如利用道义逻辑去刻画人工智能规范推理, 但本文强调的是, 构建社会人工智能逻辑更为迫切。抽象地说, 社会推理和实践推理与经典推理的主要区别在于, 主体可以对何为正确行动、何为当前世界状态有各自不同的意见[9, 10, 11]。对实践推理的形式化旨在刻画个体概念与集体概念之间的多种互动方式, 例如基于知识的义务及其推理互动[12]。虽然在某种意义上, 社会集体行为是全部主体个人行为的总和[13], 但在形式理论层面上, 依然存在着如何将社会推理与实践推理联系起来这一挑战。单主体的推理是基于其能力与知识的, 主体的能力反映于他所能执行的行动, 同时他依据具有不确定性的知识进行决策[14, 15]。

因而, 就下面关于构建社会人工智能逻辑的问题, 本文将给出有针对性的回答:(1)如何通过智能主体的义务与允许之间的关系来表示权利这一概念?(2)如何将人工智能与知情权等社会概念结合起来?(3)何种智能主体之间的冲突可以得到识别?如何解决这些冲突?(4)如何为智能主体的自由行动做辩护?

本文首先将权利和允许作为社会推理的核心概念, 并将它们引入人工智能逻辑中来回答第一个问题。我们将给出这两个概念与禁止、义务的不同互动方式, 并解释它们是如何与自由行动等社会概念相互联系的[16, 17, 18]。权利和允许强调社会规范是如何授权给主体, 以实现仅主体自身无法实现的目标的[5, 19, 20]。从智能主体的角度来看, 禁止和义务是消极的, 它们仅强调社会规范是如何限制个人规划的[20]。

本文通过将重点放在知情权上来回答第二个问题。尽管知情权对隐私[21]等重要问题有实际影响, 但它仍未被充分研究; 同时, 知情权涉及不同主体和不同社会关系, 比如患者对他们自身治疗结果与治疗情况的知情权、士兵对他们奋斗原因的知情权[22]、公民对政府工作的知情权、美国环境法所规定的大众对所接触化学物品的知情权。

对第三个问题, 通过社会推理中普遍存在的冲突和不确定性, 本文指出形式论辩理论的重要性[18]。这一理论并没有忽略反而是接受冲突, 同时, 其推理目标不仅旨在解决此类冲突, 还在于使不同意见达成共识。

对第四个也是最后一个问题, 我们不仅从权利的角度来探讨自由, 也从允许这一语境来讨论。对于自由选择允许带来的挑战, 我们将使用形式论辩来应对。

通过回答上述四个问题, 本文提出一个基于论辩的社会人工智能逻辑研究计划, 或者, 更一般地讲, 一个社会人工智能逻辑。本文通过社会、法律、伦理推理中的例子来说明构建社会人工智能逻辑所面临的挑战。下面, 我们先谈谈关于使用逻辑语言或其他知识表示的形式语言对现实生活场景进行建模的三个著名论点。首先, 形式化这一工作是很难的, 它是一种技巧, 有人甚至称之为艺术。其次, 通常并不存在“ 最好” 的形式化, 而往往存在对一个论点的多种形式化, 因为每一种形式化都有它自身的优缺点。再次, 对例子进行建模的主要挑战总是与建模方法的发展息息相关。这就像决策论的发展一样, 对期望函数和概率分布的第一个猜测总是错的。人们需要实际参与到决策中, 例如在决策论里是参与到博彩中, 从而更好地理解它。决策分析中的偏好诱导概念正是这样提出的。不过, 本文并不就建模方法做进一步的讨论。

人工智能逻辑对智能自主主体的实践推理进行形式化。本文所采用的人工智能逻辑相对于经典逻辑具有两个特征:它具有丰富的语言表达力; 它能处理不确定性与不一致性。本节将解释人工智能逻辑如何从经典逻辑中扩张出来, 使其扩张语言包括了刻画智能自主主体行动、信念、知识、权利、义务和允许的模态算子。后面则会解释人工智能逻辑是如何采用形式论辩的技术来表示常识推理, 处理不确定性、冲突与异常的。本节使用如下示例。

例1[敏感数据]:每个人的健康数据均被视为敏感信息, 因此在大多数国家受到保护原则的严格约束(欧盟中称之为GDPR, 即欧洲议会及其理事会颁布于2016年4月27日的2016/679条例, 它针对自然人个人数据处理的保护与自由流通, 并废除95/46/EC命令)。这意味着其他人不允许知道这些敏感信息。然而, 如果有人生病并需要治疗, 那么医生应治疗, 而要履行这种义务, 医生就要求知道患者的健康数据。

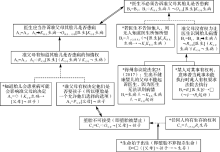

图1展示了上述示例所涉及的各种论点, 它是使用人工智能逻辑后得到的一个形式模型。此外, 通过竖箭头, 这些论点可划分为两组论据。左边四个论点组成了结论为不允许医生知道敏感信息的论据, 而右边三个论点组成了结论为允许医生知道这些信息的论据。最上面的论点为结论, 而其他论点用以支撑这些结论。最上面的从右往左指向的箭头表示医生的知情权占据上风这一事实。本节仅考虑自然语言陈述在人工智能逻辑中的形式化, 第三节将对论辩进行更为详尽的讨论。

(一) 模态人工智能逻辑语言

给出一个经典逻辑语言, 其公式包括生病和治疗, 从而表示患者生病和患者得到治疗。我们也可以添加变元, 使得公式生病(患者)表示患者生病。此外, 若考虑诸如医生、患者、张三这类主体, 在模态逻辑中我们可以用形如K医生生病的公式表示医生知道患者生病, 以及¬K医生生病表示患者不知道其生病。这里可以采取认知逻辑中最常见的假设, 即信念可以有误但知识必须正确。也就是说, 当医生知道患者生病, 那么推出患者生病这一事实。知识可刻画为得到辩护的真信念。

我们再来考虑权利、义务、允许的社会性。例如, O医生治疗可以表示医生有义务让患者得到治疗, 而P患者生病可以表示允许患者生病。在一些情况下, 在模态算子中标示出两个主体, 使得被标示的义务具有方向性①(① 针对主体间的社会依赖性的形式化也是多样的。依据本文的方法, 我们可以通过带有方向性的模态词来表示一个主体相对于或依赖于另一主体的某种社会性质。在下文的例2中, 医生知道某个患者a而非患者b的病情, 可以表示为K医生, a病情∧ ¬K医生, b病情。)(参见第二小节)。例如, O医生, 患者治疗可以表示医生有义务让患者得到治疗, 明确义务中所关涉的两个主体。在这里, 这是一个医生对患者的义务。一般来讲, 这个示例可以有多种形式化, 而这些都将留待建模者来完成。

由于实践推理考虑的是主体行动, 因此主体行动也必须在语言中得到表征[13], 例如, 公式[医生](治疗)表示医生具有使患者得到治疗的能力。也可以使用全称模态去表征必然性, 例如, □(生病→ 敏感)表示患者生病时的健康数据被视为敏感信息。

模态逻辑的好处在于其表达式可以通过不同方式混合使用, 本文会有大量这种例子。例如, P医生[医生]K医生生病表示允许医生让患者知道其病情。我们可以通过省略主体的方法来表征普遍允许和普遍义务, PK医生生病就是其中一个例子。

(二) 表示社会依赖性的权利

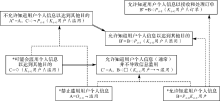

权利在本文中具有重要地位, 因为它指出一个关键的社会现象:主体的社会地位(在特定情况下为规范地位)依赖彼此之间的地位。在法学的实际操作中, 对权利本身的谈论往往是模糊的。这种模糊性很容易导致概念上的不清晰, 因此, 在一百年前, 美国著名法学家Hohfeld对权利的可能含义进行了区分[23, 24]。Hohfeld的权利系统由四组不同的法律关系构成, 其中包括四种不同的权利, 每种权利都对应一方对另一方的义务类型:某人的权利总是意味着他人的义务, 这些配对被称为规范地位[19]。而这四种可能关系被称为相邻权, 因为它们总是一起出现②(② 从逻辑的观点来看即等价关系。)。Hohfeld的权利系统如图2所示, 其中权利(包括主张权、自由权、权力、豁免权)③(③ 权利的英文为rights或legal rights; 权力的英文为power, 可理解为赋权。Hohfeld给出的法权系统中将主张、自由、义务、无主张、权力、豁免、责任、无能力作为八种最为基本的权利。可见, 权力也是权利的一种。)在上一行, 义务和责任在下一行。

主张和义务这两个权利概念之间的联系在采购合约的协商过程中体现得最为明显:卖家对买家的采购价格的主张和要求显然意味着买家有义务为卖家提供该信息。这一现象是很普遍的。在认知地位中, 如若某人具有知悉某事的主张权, 这意味着其他主体有义务告知他此事:Ra[b]Kaφ ⇔ Ob, a[b]Kaφ 。然而, 如果某人具有知悉某事的自由权, 那仅意味其他主体不具备主张其不得获悉此事的权利。我们通常认为这一规范地位为允许, 第三小节将会对其进行分析。

图2(b)具有类似图2(a)的结构, 并且涉及图2(b)的权利地位是动态的[25, 26, 27], 是关于改变他人权利和义务的潜力[24]。例如, 如果我们认为知情权是一种权利, 那这意味着具有这种权利的主体使其他主体具有使前者知情的义务, 而这样的规范地位在这个法理系统中被称为责任:Pa, b[a]Ob, a[b]Kaφ 。同时, 如果某人具有对其知识的豁免权, 我们可以认为其他主体没有权力对前者施加告知后者信息的义务。即便使用Hohfeld的法理系统和标示出主体的规范地位, 我们也并不排除谈论普遍权利和普遍义务①(① 从法律观点来看, 也可以称之为绝对权利和绝对义务。)的可能性。我们所常常讨论的公民自由, 如言论自由权利, 意味着一个主体对其他人而言具有能表达其所知所想的权利[24]。就像我们有不杀害他人的义务一样, 一般来说, 这并不需要指明这样的义务针对的是谁, 因为它指向的是所有人:Oa¬[a]杀人。这里涵盖了主体a与社会其他成员之间的全体相关法律关系的复合[28, 29]。更重要的是, 如果我们认为这一义务在一般意义上对所有人来说都是有效的, 而且只关注没有人应该被杀害这一结果, 那我们可以这样表达:O¬杀人。

(三) 自由选择允许

我们可以在系统层面上同时以逻辑来处理允许和义务这两个概念, 即建立一个道义逻辑[20]。这一工作归功于冯・ 赖特[30]。冯・ 赖特提出的弱允许通常可理解为“ 没有禁令” 。所以“ 这被允许” 这一表达方式意为“ 不被禁止” 。这样的还原论观点将弱允许简化, 使其等价于禁止的否定, 称之为义务的对偶。这样的相互定义由标准道义逻辑的两条基础公理之一所刻画[31]。正如正则模态逻辑中的可能性模态那样, 弱允许采用的是向上原则。“ 如果允许医生查阅患者的医疗记录并进行医治, 那么允许医生医治患者” :P医生(查阅∧ 治疗)→ P医生治疗。

这一向上封闭性不可避免地给弱允许带来过强的、超出社会推理所需要的推理能力, 引致罗斯悖论的变种[31]。假定允许医生去查阅患者的医疗记录, 它会推出允许医生去查阅患者的医疗记录或者将其售卖给保险公司:P医生治疗→ P医生(查阅∨ 售卖)②(② 因此, 如前所述, 允许始终与主体的行动有关, 这里所谈论的允许P医生查阅或P[医生]查阅是P医生[医生]查阅的缩写。), 但后者在道德、法律上都是不被允许的。

冯・ 赖特后来说, “ (强)允许意味着在所允许范围之内的所有选项中自由选择” [32]32。这种开放性意味的自由选择在哲学中往往被看作一种自由的[33]允许。这在日常语言和法律语境下, 往往以自主意志的形式出现, 如“ 顾客可自行决定给多少小费” , “ 保释由法院酌情决定” 。与弱允许相比, 这种开放性是受限向下封闭的(所用公理记为FCP)。“ 如果允许医生知道患者的医疗记录, 那么允许医生知道患者的病情” :PK医生记录→ PK医生病情, 因为当前病情往往是医疗记录的一种, 即□(病情→ 记录)。范・ 丙申的道义模态逻辑刻画了这类允许[34]。其中, 强允许不仅遵循那条刻画了开放性的公理, 还必须遵守一条被称为“ 义务为最弱允许” 的公理(OWP)[35]。针对强允许, 后面的这条公理给出了“ 不违反规定” 的限制:所有强允许必须在义务所设置的范围之内。当允许医生知道并使用患者的电子邮箱去与之联系时, 医生是被禁止滥用这些数据的, 例如, 不允许医生给患者发送垃圾邮件:O医生¬垃圾邮件。虽然允许医生知道和使用患者的电子邮箱, 即PK医生电邮, 但医生所被允许的行为受限于禁令, 即□(K医生电邮→ ¬垃圾邮件)。这一点与冯・ 赖特的观点十分相近[36]。

有人认为强允许的推理能力也会过强, 在社会推理中面临着自由选择悖论[16]那样的难题。这里主要是担心向下封闭性会导致异常情况:如果允许医生知道患者的医疗记录, 那么就允许医生知悉患者医疗记录并毁掉它, 即PK医生记录→ P(K医生记录∧ 毁坏)。这一异常结果基于这样一个假设:医生知道医疗记录并毁坏它是医生知道医疗记录的一个例子, 即□(K医生记录∧ 毁坏→ K医生记录)。不过这一假设并非日常生活中的常见例子。第四小节将对强允许做进一步分析。

主张权常常出现在法律、伦理规范中, 很容易与我们所说的强允许相混淆[32]。允许无论强弱, 总是关于我们自身的行动, 而与他人无关。所以, 允许与动态的权力更为相似。在某种程度上, 这两者都指向关于我们自身的在规范上不同的可能性。正如Makinson[37]所指出的, 它们之间的重要差别在于后果:当我们在没有允许的情况下做某事时, 后果就是被惩罚; 然而, 如果我们在没有权力的情况下做某事, 我们就不可能去做这件事。正如Markovich[24]所论述的, 权力与行动相关, 这些行动由构成性规则[38]所生成。我们不能售卖不属于我们的东西:售卖是一个构成性概念或行动, 由描述了当某人出售某物时将会发生何事的规则所构成。拥有财产的这一规范状态包括了出售这一财产的权力; 而如果不拥有这份财产, 我们就不能出售它。

(四) 隐私、知情权、允许获悉:可废止性、共存性与知识互动

对知识和规范概念的使用, 或许会影响我们可以(或应该)使用何种模型。隐私权是一个涉及众多权利的复杂概念①(① 参见关于敏感数据的例1。), 它指向隐私这样一个复合概念[21]。隐私权的内核是一组指向其他所有人的主张权, 要求他人远离其私人领域。也就是说, 其他人不得获悉其私人生活。这意味着长长的一系列禁令, 包括那些实际上可能采集或公开其隐私信息的行为。

这些权利像大多数权利一样是可废止的。这一性质意味着权利的存在(表达它们的句子的真值或者推出它们的推理有效性)可能依赖语境。某人的知情权所对应的信息可能出于某种原因需要保密, 同时存在一个更强的论证支持其保密性而非使之获悉, 在这种情况下, 并不存在使前者获悉此信息的义务。又或者反过来:某人的隐私权意味着禁止其他人知道其私人生活和私人信息, 这也是可废止的。他们的私人生活可能给他人带来危险, 而公共利益通常是反对个人利益的更强论证。有时候要决定哪一个论证更强不是一件容易的事, 这是我们所要面对的困境。这两种情况都可以通过第三节的形式论辩理论来表示。

当我们在知情权这一背景下去谈论数据和查询数据时, 需要考虑允许获悉与知识之间的互动。作为公民, 你被允许知道这个城市的历史档案。这似乎是一种许可, 并且你似乎显然可以(即允许)走进档案馆查阅资料。如果你提出要查询数据, 那似乎可以说档案馆应该将你所需要的数据提供给你。这意味着你所具有的许可不仅是一个允许, 而且是一个主张权。所以, 在此场景下, Pa[a]查询和Ra[b]Ka数据同时成立。这样的日常许可反映出使用多模态逻辑的另一挑战。考虑如下与知识交互的例子。如果我们认为在当前情景下所涉及的知识应该是经典的“ 得到辩护的真信念” , 即知识推出真, 那么依据知情权RaKaφ 这一前提, 我们会得到Ob, a[b]Ka数据这样一个奇怪的结论:档案馆必须让数据内容为真。当与规范概念互动时, 我们尚不清楚知识是否依然推出真。社会推理的其他方面也存在类似的关于知识的挑战[39]。其中一个著名例子是摩尔悖论[40], 它涉及语用悖论公式Ka(φ ∧ ¬Kaφ )。当我们对自然语言中的“ 允许” “ 获悉” 等模态词进行形式化时, 我们希望使用的是何种意义上的知识?在社会推理中, 这是一个重要问题。

(五) 人工智能逻辑中的主体间冲突

两个主体的信念可能是不同的, 这会导致主体之间的冲突。然而, 两个主体发生冲突的方式有很多。例如, 它们可以执行带来相反结果的行动, 或者它们具有互不兼容的权利。BOID逻辑[41]采用Thomason[42]划分优先级的想法, 将不同类型的信念、义务、愿望、意图划分不同优先级, 然后通过陈述不同主体类型的通用策略来解决冲突。下一节将介绍主体间的形式论辩理论, 以表征不同逻辑公式之间的矛盾冲突。

逻辑有两种定义冲突的方法。一种方法是使用形式语义, 如果一个句子没有模型, 那就有冲突。模态逻辑语义基于可能世界语义。每个模态算子都存在一集合可通达的可能世界, 使得形如Oφ 为真, 当且仅当它所通达的可能世界φ 为真。在一个具有持续性的模型上, 我们不能为O¬治疗和O治疗这两个句子找到同一个模型。另一种方法是为模态逻辑定义一个证明系统:在一集合给定的前提下得出矛盾冲突, 当且仅当这个系统同时推出一个公式和它的否定。证明系统的另一个优点是, 证明系统的公理可以反映出该逻辑的特征和性质。

论辩理论分析社会推理中的争论, 以期在不同意见中达成共识。争论在社会生活中是很常见的。下面的例子给出了人工智能逻辑中的三种常见冲突。通过使用论辩理论这一工具, 可以表示和解决现实情景中的冲突。我们以堕胎这一全球性话题为例讨论知情权, 并展示形式论辩理论的方法和工具(图3)。

例2[堕胎与知情权]:普遍认为, 准父母有权知道胎儿在出生后是否健康。这意味着医生必须告诉他们是否健康。支持这一观点的论据是, 如果预期胎儿会患重病, 那么准父母有权决定他们是否要这个孩子, 为了做这一决定, 他们必须知道这一点。这会得出堕胎是允许的(如果不被允许, 那么就不需要做决定了)。而事实上另一个与之相矛盾的观点认为堕胎是错误的, 支持这一观点的论据是每个人都有生存的权利, 即其他人包括准父母都不允许扼杀这个生命。而这一论证支持关系(即论点C1和C2之间的关系)被“ 生命是从出生开始算起” 这一论点所否定, 从而不成立, 也就是说, 堕胎并不违反生存的权利。在美国得克萨斯州, 参议院通过了一项法案, 宣布生下患有重疾的婴儿的父母不能因为在怀孕期间医生没有识别这一疾病而起诉医生。如果某事(或其赔偿)不能让法院强制执行, 则其不作为义务存在[24]。这意味着, 在得克萨斯州, 准父母没有权利让医生识别胎儿是否患病。我们将对疾病的识别形式化为[医生](K医生患病∨ K医生¬患病), 即医生让自己知道胎儿是否患病。而问题在于, 这一识别行为如何与这种(最可能的)义务相联系:如果医生知道胎儿患病, 那么他应当告诉准父母。而告诉准父母胎儿是否患病可以被形式化为[医生](K患者患病∨ K患者¬患病)。在理论上, 这两个命题似乎是相互独立的, 因为医生不必须识别, 而如果他识别了则必须告知。但在实际操作中, 如正被广泛讨论的, 在得克萨斯州和法律界, 这似乎给了医生选择的可能性:我们不知道医生是否识别出疾病, 或者医生已识别但他因为担心准父母可能不要这个胎儿而决定不告诉他们。由于我们似乎难以得知他人所知所想, 我们难以区分上面阐述的那两种情况:如果医生知道了这一疾病但并未让其他任何人知道, 那么我们可能永远不可能知道医生是否知道。这意味着识别疾病这一行为不可能被起诉, 更何况如果医生知道, 他就应当告知准父母。但如果医生没有告知准父母的义务(因为它不能被强制执行), 那么识别问题成了告知问题, 从实践角度来讲, 这也意味着准父母没有关于其胎儿是否健康的知情权。

(一) 可废止性

社会现实中的推理通常不像模态逻辑那样演绎有效, 而是不确定的, 需要解决冲突。不确定的社会推理是普遍存在的。如果患者患重病, 那么医生有义务为其治疗:患病→ O医生治疗。如果医生不知道患者的医疗记录, 那么他不应该去治疗:¬O医生¬治疗→ K医生患病。到目前为止, 一切还好。但如果换成是患者得病但其隐私权阻止医生得知患者的医疗记录的情景, 即这个假设为集合{患病, ¬K医生患病}, 那么我们会得出O医生治疗和O医生¬治疗这样的结论, 即医生有义务医治患者, 同时他也有义务不治疗。哪一个结论才应最终被接受呢?这样的不确定性给出了一组规范冲突[43, 44], 而人工智能逻辑正是要解决这一问题①(① 参见van der Torre L., ″Reasoning about Obligations: Defeasibility in Preference-Based Deontic Logic, ″ PhD Thesis, Erasmus University Rotterdam, 1997。)[45]。

智能的关键特征在于, 当例外的新证据出现时, 它能对社会推理的结论的不确定性进行处理[3, 45, 46]。一般采用“ 可废止性” 去处理这一问题, 后面将对这个概念进行解释。

(二) 表征、解决主体之间冲突的形式论辩理论

利用逻辑解决冲突的基本思路是很直接的。在经典逻辑中, 冲突就是不一致。如果假设中既存在结论为“ 门开着” 的论证, 也存在结论为“ 门关着” 的论证, 那么在经典逻辑中就会从这一假设推出任意结论。而在人工智能逻辑中, 仅有部分论证的逻辑有效并最终被接受。因此, 人工智能逻辑就像一个筛子那样对所有可能的论证进行筛选[43]。

这两种处理冲突的方法的微妙差别在于, 形式论辩系统并不假设所有的冲突都可以得到解决。有时候我们并没有足够的信息去解决冲突, 或者存在两种互不相容的方案。在这种情况下, 形式论辩理论仍然具有重要作用, 因为它能够明确表明分歧所在。正如其目标所示:赞同不同之处。

形式论辩系统的特殊性在于, 它并不事先假定论证在对话中的作用, 与之相反, 它假设所有论证都得到展示, 然后决定哪些论证会被接受、哪些被拒绝。这种方法与法律运作的方式相似:所有证据都会呈递给法官, 然后由法官来做出决定。而呈递、发现证据的顺序被认为与判决无关。

形式论辩系统和其他人工智能逻辑的重要特征是, 一旦有更多可用信息, 就可以舍弃原有结论[3, 45]。这使得缺省推理是可行的。例如, 在我们知道Tweety是企鹅之前, 我们可以假定Tweety会飞。在这种意义上, 人工智能逻辑是非单调逻辑[43]。

(三) 可废止知识、可废止规则、论证

通过系统地对论证的(可)废止性进行比较, 论辩理论提供一种方法去澄清社会推理的非单调原因。一般来讲, 论辩理论通过可废止知识或可废止推理规则来定义论证, 从而定义三种攻击论证的方法:攻击作为前提的可废止知识、攻击可废止规则的结论、攻击这些可废止规则的使用。这样也解释了可废止规则的前提是推定地而非演绎地支持其结论[47]。关于堕胎的例子表明了在论辩或争论的不同阶段其可废止性是如何成为可能的。

我们区分两类知识和推理规则(参见图3), 以刻画可废止规则和可废止论证。一类不是可废止的而是严格的。在图3中, 可废止的用虚线表示。严格规则记为➡, 图中用实线表示, 用以刻画演绎有效的推理, 其中前提的真保证了结论的真。而可废止规则记为⇨, 图中用虚线表示, 表示推定性推理, 其中前提很可能支持结论, 但它可以由相反证据来推翻。每个论证可以通过知识作用于推理规则来递归地定义。一个论证是可废止的, 当它所使用的规则是可废止的, 否则是严格的。一个论证是稳固的, 当前提中的所有知识都是严格的, 否则是可能的。在图3中, 带* 号的方块表示知识, 而没有* 号的表示那些通过推理规则构造的论证的结论。以“ 堕胎不可接受” 为结论的论证C2是可废止的, 因为它所使用的规则是可废止的; 而“ 生命始于出生” 的论证D本身就是严格知识, 因而它是稳固的。在图3中, 每一个方块代表了一个论点, 它们也是论证的结论。论证C2是可废止的而论证D是严格的。图3中所有论证除了B4和B5都是稳固的。

(四) 关于论证的偏好

我们首先介绍基于规则的偏好[18]来给论证划分优先级。基于规则的偏好总是偏好严格论证甚于可废止论证。因而在图1中, 它(严格)优于论证B3甚于论证A4。此外, 还有其他比较论证的方法, 其中一种叫作全称偏好, 另一种叫作基于前提的偏好[18, 47]。全称偏好对每一个论证的偏好都是一样的, 因而全称偏好是作用于所有论证的等价关系。我们也可以通过前提的性质来对论证进行分类。基于前提的偏好认为稳固的论证比可能的论证更优。

(五) 使用击败关系来解决论证之间的冲突

将带有不同论点的论证放在一起会导致不一致, 我们可以通过击败这个概念来比较它们。我们遵循已有文献所定义的三种击败关系:反驳、切断、削弱[47]。关于堕胎的争论很好地说明了这种区分。第一种击败关系是最广为人知的反驳关系, 它基于论证规则的结论去探讨可废止性。在这个争论中, 严格论证A4的结论“ 医生应当告诉准父母其胎儿是否患病” 与可废止论证B4的结论相反。因为在基于规则的偏好中A4比B4更优, 所以A4反驳了B4。第二个概念切断关系是基于论证前提来考察可废止性。稳固论证A2的前提“ 准父母有权决定他们是否要孩子” 与稳固论证C2的结论相反, 而在基于前提的偏好中A2不比C2更优, 因而我们说A2被C2切断。最后一个概念削弱关系指出一个论证是如何通过攻击另一个论证的规则使用来击败后者的。在基于规则的偏好下, 严格论证D的结论“ 生命始于出生” 与结论为“ 堕胎不可接受” 的可废止论证C2所使用的推理规则相矛盾, 因此论证D削弱了论证C2。

(六) 稳定外延

如何从一集合存在冲突的论证中挑选出得到辩护的、无冲突的论证?1995年Dung[48]提出一个叫作“ 稳定外延” 的概念来处理冲突。在Dung看来, 称一集合的论证为稳定外延, 当前仅当被这个外延里的论证所击败的那些论证都不包含在这个集合里。也就是说, 首先集合内的论证不会相互攻击, 其次所有外部论证会被这个外延中的某个论证所击败。每个稳定外延所包含的论证相互接受。因而, 稳定外延为我们提供了另一种一致性, 用以解释在何时一集合的论证不存在冲突。在例2中, 支持论点“ 医生应当告诉准父母其胎儿是否患病” 的那些论证形成了一个稳定外延, 也就是论证A1、A2、A3、A4、B1、D之间相互接受。

如第二节第三小节所阐释的, 如果我告诉你可以喝绿茶或喝红茶, 那么我是在建议你可以自由选择喝绿茶或喝红茶。因此, 你可以喝红茶, 也可以喝绿茶。这被称为自由选择允许[16, 36]。基于关于知识和行动的人工智能逻辑这一背景, 本节来探讨自由选择允许。例如, 假设你被允许知道客户住址或电话号码, 这是否意味着你被允许知道客户住址及电话号码?如果你被允许步行或坐公交车, 是否意味着你被允许步行及坐公交?

本节将描述基于论辩的人工智能逻辑是怎样使用形式论辩理论去应对关于自由选择允许的挑战的。我们必须谨慎对待自由选择允许这一概念。例如, 自由选择悖论[16]阐释了伦理冲突的核心之一在于不恰当地将义务、允许、可能行动放在一起考虑。这一点可以通过道义逻辑[34]的两个基本原则FCP和OWP来解释。

如第二节的第三小节所述, FCP描述了自由、自由行事的直观, 刻画了自由选择允许[16]和强允许[35]。FCP可以用来表示产品购买情景下的允许知悉。为了提供在线购买服务, 电商公司被允许知道顾客所提供的信息或顾客使用情况的信息。这会得出电商公司具有知道这两类信息的许可。电商公司这种知情的自由可被视为提供在线服务的必要条件, 而这是写在其隐私声明中的。

而OWP这一公理表达了所有允许都受限于义务。在在线购买这一例子里, 电商公司对不同类型私人信息的获悉允许被隐私声明、它所参与的隐私保护框架、数据保护法中的义务和责任所限制。FCP和OWP这两个原则在不同类型的社会推理中常常被用到, 例如自然语言推理[49]、博弈[17, 35]、法律推理[27]等。

以上提及的两个原则是相互一致的, 但与某些例外假设放在一起时可能会产生不一致的情况。考虑图4中的例子如下:

(1)允许知道用户个人信息。(B)

(2)禁止将用户个人信息用于其他目的。(A)

采用“ 义务为最弱允许” 原则OWP, 我们会得到如下结论:

(3)知道用户个人信息(通常)不会导致滥用。(C')

然而, 我们同时有作为例外的前提“ 知道用户个人信息后也可能将其用于其他目的” (C), 而这一前提与前面的陈述C'相矛盾。而较C'而言, 我们更偏好陈述C这一可能的新信息, 因为它以社会事实作为证据; 与此相比, 旧陈述C'是可废止的。如此, 我们便不再认为知道用户个人信息(通常)是在在线购买服务的目标范围内的(C)。此外, 我们不会推论说滥用信息是允许的(B'), 因为它是一个在已有的得知用户个人信息许可的基础上通过使用可废止规则FCP推出的结论。在社会情景下, 比起用可废止规则刻画自由选择允许, 我们认为将允许置于义务范围内是更合理和更可取的。因此, 规则OWP压倒规则FCP。不过, 依据社会思维, 我们仍然希望得到诸如电商公司被允许知道用户个人信息以接收和处理订单的论证(B″), 因为这里不存在比之更优的相反论证(图4)。

高性能计算和其他计算技术使得计算机的计算能力不断增强, 推动人工智能的惊人发展。目前, 应用于机器学习中的技术其实已经存在了几十年, 却在现今计算技术的帮助下才得到广泛应用。普遍认为, 在人工智能的其他领域, 如表示和推理, 也将有类似的革命到来。尤其是, 尽管数据科学和机器学习已经催生出被称为动物智能的技术, 但人们期待信息与知识技术的发展会带来人工智能, 虽然关于什么是人工智能依然没有达成共识。

对于社会人工智能的发展, 我们需要理解知识表示与推理所面临的挑战。我们可以从20世纪80年代系统的研究中吸取一些教训:以往的人工智能工作承诺了很多, 但缺少我们今天所拥有的计算能力。本节将基于对本文所提出的四个研究问题的讨论, 提出一个面向基于论辩的社会人工智能未来发展的研究方案。

本研究方案始于20多年前所编写的《人工智能逻辑和逻辑编程设计手册》[50]。其中人工智能逻辑包括五个主题:逻辑基础、演绎方法、非单调推理和不确定推理、认知与时态推理、逻辑编程。在过去的20多年中, 这些领域有了一些发展:(1)一阶逻辑的片段已经得到更为具体的研究和发展, 尤其是用于表示和推理本体的描述逻辑①(① 描述逻辑可参见Gabbay D.M., Hogger C.J. & Robinson J.A. (eds.), Handbook of Logic in Artificial Intelligence and Logic Programming, Volume 1: Logic Foundations, Oxford: Clarendon Press, 1994。)。(2)已有的演绎方法已在新的计算技术中得到采用, 而像Isabelle那样的交互式定理证明器对用户已经变得更为友好[51]。(3)形式论辩理论是处理非单调推理和不确定性的主流方法, 这可参见COMMA系列会议②(② The Conference on Computational Model of Arguments (COMMA系列会议)的历年信息可在http://comma.csc.liv.ac.uk查阅。)。形式论辩理论系列手册的第一卷于2019年出版, 而第二卷正在准备中。(4)认知与时态推理已经拓展至主体推理, 其中包括行动、偏好、意图等概念, 这些概念在AAMAS系列会议中得到讨论③(③ International Foundation for Autonomous Agents and Multiagent Systems (AMMAS系列会议)的历年会议论文集可在http://www.ifaamas.org/proceedings.html查阅。)。(5)逻辑编程已经发展至回答集编程[50]。

此外, 如前所述, 当前人工智能的挑战在于如何将人工智能逻辑应用于社会推理。

(一) 基于论辩的逻辑

本文方法论的第一步是将形式论辩系统和形式逻辑一起考虑, 从而建立基于论辩的逻辑。这里并不区分理论推理和实践推理。

本文假设形式论辩理论是形如ASPIC+这样的基于规则的论辩理论。它采用两个基本逻辑, 一个作为下限逻辑, 一个作为上限逻辑, 使一个刻画严格规则而另一个刻画可废止规则[47]。这种定义论证的方法被称为粗略方法。大致来说, 选出两个模态逻辑, 严格规则可由下限逻辑的推演来定义, 而可废止规则可由上限逻辑的推演来定义[18]。这种方法如Modgil和Prakken[47]所论述的, 是基于某种认知或理性标准。这种方法通常用于定义论辩理论, 并进一步通过关于社会推理的系统性论辩理论表示不同的非单调人工智能逻辑。

然后, 我们通过对知识分类来区分不同的论证[47]。我们将知识区分为可错的和可靠的。在这种情况下, 一个论证的可错性不仅可以存在于前提中, 还可以存在于从前提到结论的推理过程中[47]。这种分类定义了一个新的偏好, 即基于前提的偏好, 通过比较不同类型的击败关系来解决伦理冲突。人工智能逻辑的构建也会反映这样的区分:通过不同的前提来区分不同的推演。

我们在以往工作[18]中提出如何在稳定外延、两个单调逻辑和基于规则偏好的基础上通过一种统一的方法建立人工智能逻辑。这一逐步构建的方法与模态逻辑中的Lindenbaum引理证明[52]类似。其基本思想是先基于下限逻辑再基于上限逻辑去构建一个一致的论证集合, 在平衡严格规则和可废止规则所对应的论证的同时保持论证集的极大一致性。

基于这种两步构造法一步步地构建稳定外延, 从而给出我们的人工智能逻辑的定义[18]。所有逻辑推演来自下限逻辑或上限逻辑。这里有三步:首先构建基于论辩的逻辑, 其次构建基于论辩的人工智能逻辑, 最后构建基于论辩的社会人工智能逻辑。

(二) 基于论辩的人工智能逻辑及推理

在第二步中, 我们将聚焦实践推理在人工智能逻辑中的特殊性。由于理论和可观察现实之间的对应, 传统上认为理论推理比实践推理简单。但是, 随着量子力学等现代物理学的兴起, 实验检测理论的推进也变得越来越困难。然而, 一般来说, 由于实践推理所内含的模糊性以及缺乏实验数据, 对实践推理的形式化要比对理论推理的形式化困难。据此, 本文的示例提示了三点注意事项:

(1)复杂性:正如本文示例所展示, 形式化是困难的, 每一个给出的自然语言句子都有多种不同的形式化, 而每一种形式化都有其优缺点①(① 在例1中, 存在三种对稳固知识“ 医生应当治疗患者” 的形式化方式。图1中给出的O医生< 医生> 治疗是其中一种, 而另外两种是O医生[医生]治疗和生病→ O医生[医生]治疗。)。

(2)多样性:最优的形式化往往是不存在的, 而通常是在表征或模型之间做出权衡。

(3)论证提取:人们可能会在不同程度上错误地表征论证, 我们需要一种方法去调整其论证。

当前的数据驱动方法, 如自然语言处理、论证挖掘、机器学习等, 将帮助我们完成上述的论证提取任务, 帮助我们设计更好的社会人工智能逻辑。

(三) 基于论辩的社会人工智能逻辑

在架构社会人工智能逻辑时, 不仅对示例的表征必须足够灵活, 而且所给出的一种好的语言、一些好的公理和一种好的语义也是必须经过经验检验的。这解释了为何本文题目采用了“ 面向” 一词。

例如, 我们来考察使用强允许对表征多主体交互中的信任所起到的作用。信任反映了多种在社会交互下的依赖, 它赋予可信赖的个体以行动的自由。而另一方面, 可信赖的机构的大多数活动需要带来正面影响。因此, 要得到其他人的信任从而可自由行动, 被信任的主体需要针对其行为有一个好的决策规划。这些社会现象的形式模型需要处理信任、允许、决策行为之间的进一步联系。

许多来自人工智能逻辑和社会推理的概念已经得到了研究, 虽然本文尚未对它们进行讨论。人工智能逻辑和社会推理的总体领域是很广阔的[53], 表1中列出了其中的一部分。本文将必要的概念限制在知情权和隐私的范围之内, 因此没有明确地讨论信任、声誉、责任、职责等概念。不过, 通过形式扩展, 我们的人工智能逻辑也可以处理这些概念。例如, 可在我们的人工智能逻辑语言中增加多主体认知模态算子, 从而刻画多主体之间关于公平与偏见的社会认知。

| 表1 关于个体和集体推理的概念 |

社会推理考虑一个主体如何受其他主体行为的影响, 并明确展示出主体间的社会依赖性[13, 53]。此外, 社会依赖与主体间的信任相关[54, 55]。一方面, 信任是一种挑战, 因为信任的破坏会对个体规划造成负面影响[56]; 另一方面, 通过对其他主体的依赖能够比单个个体实现更多的目标[57]。从这个角度来讲, 社会依赖和社会信任是这个社会的黏合剂。在认知逻辑中, 它们由社会网络中的信念和信任所表征[58, 59, 60]。在规范推理中, 社会网络由主体之间的权利来表示。

在法律语境下, 部分社会规范是被制度化的[19, 25, 26, 61, 62, 63]。同样, 法律可以看作一种限制主体的方式, 或是一种赋予主体权利的机制[19, 26, 62]。隐私规范可以限制每一主体对其他主体的知情, 同时帮助每个主体保护自己的数据和隐私[64]。

按照这样的做法, 主体的其他认知态度也可以用相同方式来建模, 包括主体的愿望、目标、意图[13, 65, 66]。此外, 还可以对行动及其变化进行形式化[67]以表达因果性。虽然本文并没有考察这些概念的形式化, 不过, 下面给出了与之相关的三类工作。与它们相比, 本文所提出的用于刻画社会推理的人工智能逻辑是一个道义认知行动逻辑。

1.关于义务与主体的逻辑。STIT逻辑是一个得到广泛应用的关于义务与主体的逻辑[13]。基于Bratman关于实践推理的哲学观点, STIT逻辑给出了一个刻画主体义务的BDI框架[68]。STIT逻辑的语义是一个细化了主体选择的分支时态模型:主体的每一个选择都依赖它所处的时刻和历史。主体的行为通过其行为结果来隐含地表达。STIT模态的基本思想为:主体a导致状态φ , 即[a:STIT]φ , 当且仅当主体的选择保证了状态φ 的成立。因此对主体来说, STIT逻辑所刻画的并非“ 应当做” 而是“ 应当是” :对主体来说应当是的行为就是与之相关的主体的理想选择都能实现。事实上STIT逻辑不仅很好地刻画了个体行动, 也很好地刻画了集体行动[69]。所以, STIT逻辑广泛应用于对社会影响[70]、决策博弈[71]、法律推理[19, 24]等方面的分析。近年来, 关于义务和知识的STIT逻辑也得到了研究[12, 14]。关于STIT逻辑, 《多主体规范系统手册》相关章节有更多讨论[72]。

2.关于条件规范逻辑。条件规范通常用来表达道义分离陈述, 如“ 当ψ 时φ 是应当的” 。也就是说, 给出一个条件规范及其前件, 可以推出这个条件陈述的道义后承。道义逻辑学家给出不同的形式系统去探索条件规范的普遍特征, 其中, 输入/输出逻辑[73]与基于偏好的道义逻辑[74]及其动态逻辑[66]是刻画道义分离的两个主流方法。在实际应用中, 条件规范逻辑可以讨论法理学中的构成性规范[63]。

3.关于权利与允许的逻辑。在社会推理中, 要通过模拟主体之间的规范行为来充分考察主体间互动, 那么允许是一个重要但尚未被充分研究的概念①(① 关于允许这一道义概念的最新研究, 请参见Dong H., ″Permission in Non-monotonic Normative Reasoning, ″ PhD Thesis, University of Bayreuth, 2017。)[16]。在社会现实中允许是很常见的:“ 本杂志是开放获取的, 每个人都可以免费阅读并下载其中的文章” ; “ 在激活了月票后, 你可以在一个月之内乘搭卢森堡任意公共交通工具” ; “ 在签署房屋购买合同后, 你可以自由地装修自己的房子” 。这里的允许涉及几乎所有社会生活中的自由、隐私、赋权等概念。给定一个允许, 要理解这个概念的含义, 我们需要一种合适的方法对这个允许与义务、知识及主体所能实施的行为等相关概念之间的关系进行推理。

在哲学、语言学、计算机科学、法律等领域, 许多研究人员已经指出允许这一概念的多面性。例如, 允许可被看作作为义务对偶的弱允许[30]、刻画自由行动的强允许[36, 49, 75]、具有动态特征的允许[76]、作为已有规范的例外的可废止允许[77, 78]等等, 它们涵盖了许多在多主体互动中使用到的重要理性原则。

在这里, 我们依据冯・ 赖特的思想来比较弱允许和强允许两个概念[36]:如果一个行动不被禁止, 那么它在弱意义上被称为是可允许的; 如果它不被禁止并服从规范, 那么它就是在强意义上可允许的。被强允许的行动因而是被弱允许的, 但反过来不必然成立。这两种允许可以通过它们与知识的交互来区分。假如你有一张月票, 那么你被允许使用任意公共交通工具。但如果它是一个弱允许, 又假如你不知道在搭乘交通工具前并不禁止不打卡, 那么你就不知道在进入交通工具前是否可以不打卡。这样给出的弱允许并不能指导主体的行动。而如果将车票看作一个强允许, 而你知道不打卡是使用这一车票搭乘公共交通工具的其中一个行为, 那么你知道在搭乘交通工具前允许不打卡。此外, 在多主体交互语境下, 同伴的信任赋予你在其房屋中逗留并使用房屋设施的自由, 而无须明确指出什么是不被禁止的。

本文给出了一个社会人工智能逻辑研究计划, 它是在数据科学和机器学习技术等人工智能技术上的扩展。人工智能逻辑对智能主体的推理进行形式化。社会人工智能逻辑在人工智能逻辑的基础上增加与社会推理相关的机制。本文展示了关于行动、知识、权利、义务和允许的人工智能论辩逻辑如何形式化社会推理的各个重要方面。除了对个体知识和行动进行推理外, 社会人工智能逻辑也对主体间的社会依赖性进行推理。

首先, 我们指出权利如何分析主体的义务和允许之间的关系。例如, 将自由看作允许的一种, 那么, 一个主体有知道某信息的自由就是他人没有知道该信息的主张权。当一个主体对他人有对数据知情的主张权, 这意味着他人有义务去让这个主体知道这些数据。在社会实践中, 这种义务和允许之间的互动涉及主体之间的依赖。

其次, 我们解释了主体间的冲突是如何得到识别的且可以通过对比关于允许和禁止的逻辑论证来解决冲突。使用形式逻辑或者形式论辩理论工具可以达到这一目的。逻辑的不一致概念可以用来识别争论中的冲突, 而要解决冲突, 我们就要用到论辩理论。通过被击败的论证可以展示冲突。在论辩理论中解决冲突的方法是采用稳定外延来选出所有被相互接受的论证。

再次, 我们用两个例子来阐明如何探讨知情权。这与近年关于隐私和伦理讨论的中心问题密切相关。第一, 与其他社会推理类似, 关于知情权推理具有非单调性。我们的例子考虑了两类知情权的非单调性。一方面, 医生对病人健康数据的知情不应导致不良结果的产生, 如病人数据的滥用; 另一方面, 准父母是否对其胎儿是否患病有知情权, 这在伦理、法律的元理论层面依然存在争论。第二, 我们要回答如何通过逻辑对主体知情权进行建模。知情权不仅与允许、义务等规范概念相关, 也和主体的认知和行动紧密联系。这一方面要求我们尝试对知情权给出不同的形式表征, 另一方面则要求我们积极探索知情权与其他主体概念之间的多层次关联。例如, 知情权存在的前提在于主体的知识, 如何通过人工智能逻辑来表示知情权所涉及的争论, 依然值得我们进一步探讨。

最后, 我们在形式论辩的框架下讨论了自由选择允许所带来的挑战。在这里, 我们并没有简单地断言自由选择允许是否为一个理性概念, 而是给出关于个人信息的知情权这一实例, 指出自由选择允许所涉及的问题是如何在义务、允许、行动的互动之下得到重新解释的。使用用户个人信息的自由是受法律所约束的。如果不考虑自由选择允许与其他道义概念之间互动, 则很难说我们所拥有的自由是理性的、合理的。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|

| [43] |

|

| [44] |

|

| [45] |

|

| [46] |

|

| [47] |

|

| [48] |

|

| [49] |

|

| [50] |

|

| [51] |

|

| [52] |

|

| [53] |

|

| [54] |

|

| [55] |

|

| [56] |

|

| [57] |

|

| [58] |

|

| [59] |

|

| [60] |

|

| [61] |

|

| [62] |

|

| [63] |

|

| [64] |

|

| [65] |

|

| [66] |

|

| [67] |

|

| [68] |

|

| [69] |

|

| [70] |

|

| [71] |

|

| [72] |

|

| [73] |

|

| [74] |

|

| [75] |

|

| [76] |

|

| [77] |

|

| [78] |

|