2. 武汉理工大学 能源与动力工程学院,湖北 武汉 430063

2. School of Energy and Power Engineering, Wuhan University of Technology, Wuhan 430063, China

伴随着Web2.0时代的飞速发展,互联网上出现了大量带有情感色彩的文字. 微博作为新的社交方式为大众所接受,并且成为信息传播、舆情监控的重要平台. 微博用户可以发表对时事的看法,其中包含大量的文本情感信息. 通过对微博情感信息的分析,及时掌握用户的态度,是掌握网络舆情的重要手段. 微博情感极性分析主要是利用用户发布的微博数据对用户情感倾向加以分析和挖掘,识别用户发布的文本中的情感极性,如高兴、悲伤、中立等[1-3]. 能够使用的已标注样本少之又少,多数学者选择利用未标注样本来解决实际分类[4-5],利用未标注样本的主流学习技术分为3种:半监督学习、主动学习和直推学习.

半监督学习方法是目前最受欢迎的基于机器学习的方法,采取综合少量已标注样本和大量未标注样本来提高学习性能的机器学习方法,兼顾人工标注成本和学习效果,被视为监督学习和无监督学习的折中方案[6]. Blum等[7]提出最早的协同学习算法,之后的研究取得很多进展,使得协同学习成为半监督学习中最重要的方法. 协同学习算法的强假设为特征充分并且冗余,特征集满足下列要求:一致性,每一个特征集都包含足够的分类信息以进行分类学习并且分类器的目标函数在每个特征集上都能够训练出强分类模型;独立性,2个特征集相互条件独立. 在特征充分并冗余的情况下,可以进行自然分裂或合理划分,此时,协同学习优于其他半监督学习. 但是,特征充分冗余的要求往往难以满足,研究者试图寻找协同学习的变种以降低要求. Goldman等[8]使用2种不同的监督算法,将空间划分成一系列的等价类,采用交叉验证来确定如何对无标签数据进行标注. Zhou等[9]提出的Tri-training方法使用3个分类器,通过考察分类器的一致性隐式地获得标注置信度. Wang等[10]对多视图主动学习与半监督学习的组合进行分析,发现两者组合可以进一步降低取样复杂度,取较少的样本就可以使分类器达到较高的精度. Yu[11]对协同学习算法进行深入研究,在松散的协同学习条件下,提出集中协同学习策略,在新闻、在线评论和微博3个领域进行实验,结果表明协同学习算法在解决标注数据缺乏的问题上,具有很好的效果.

使用不同的分类器进行协同训练的工作有很多,但是将支持向量机(SVM)分类器和长短期记忆(long short-term memory,LSTM)网络分类器相结合的研究比较少. SVM算法的训练效率相对较高,训练样本的向量维度对SVM算法影响不大,在一定程度上解决了微博文本情感极性分类问题中特征维数过大导致的维数灾难问题. LSTM神经网络模型是深度学习算法在自然语言处理领域成功应用的代表。LSTM基于语义结构的文本情感极性分析模型,通过对文本的最小独立单位词向量的多级抽象,计算得到文本的向量表示,将获得的向量应用于预测文本的情感极性,具有学习能力强、容易训练等优点. 本文选取以SVM算法和LSTM算法作为2个基分类器的分类算法,进行协同学习的研究.

主动学习[12]由Lewis和Gale提出,在训练过程中,从未标注样本中找出含有较多分类信息的样本,优先标注这些样本,让分类系统获得较大的信息增益.目前国内外相关学者及机构针对主动学习在基于机器学习的文本分类中的应用进行了相关研究,主动学习算法的样本数据选择策略是研究热点[13]. 按照获取样本的工作方式不同将现有的样本选择策略分为基于流和基于池的策略. 在基于流的选择策略中,未标注样本以数据流的方式逐个提交给学习者,由学习者实时决定是否需要标注当前提交的样本;在基于池的选择策略中,学习者根据样本选择策略从含有未标注样本的历史数据池中选择当前需要标注的样本. Nguyen等[14]通过对池中的所有样本进行聚类,并且作为主动学习的分类特征,验证了预聚类信息可以使主动学习更加有效. Hajmohammadi 等[15]为了解决跨语言领域的语料库缺乏问题,提出结合主动学习与 Self- training的方法扩展训练数据集,实验结果验证了提出的方法能够极大地提高跨语言的情感极性分类性能. Hastie等 [16]提出基于多层次的不确定抽样方法,以解决多分类问题中分类精度不高的问题.

直推学习与半监督学习一样无需人工干预,不同的是,直推学习假设未标记数据就是最终用来分类的数据,学习的目的就是在这些数据上取得最佳泛化能力。

目前的研究主要针对单一的选择策略,没有考虑利用文本中的其他信息量(例如置信度)进行研究.为了充分利用文本中的信息量,围绕半监督学习算法中的协同学习算法,提出利用主动学习的思想对协同学习的未标注样本进行选择,采用不确定性选择策略与最高置信度选择策略相结合的方法选择样本数据加入到训练数据集中,以充分利用样本的不确定性和置信度这2个信息量. 针对协同学习算法中充分冗余的特征视图难以满足的问题,提出基于SVM算法和LSTM算法的松散条件下的协同学习算法模型. 通过实验来验证模型对中文微博的情感分类分析的准确率.

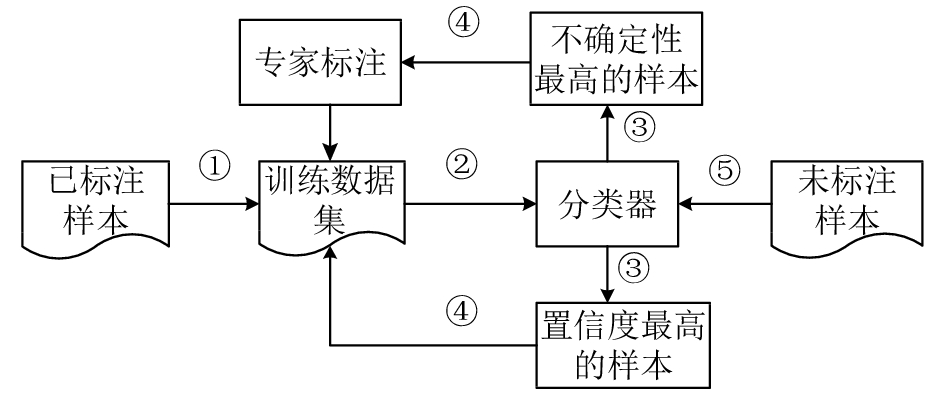

1 松散条件下的协同学习算法 1.1 改进的未标注样本选择策略主动学习算法使用尽量少的人工标注样本加快未知样本的自标注过程,在微博情感极性分析领域具有优势. 提出不确定策略与最高置信度相结合的选择策略来选择高质量的未标注样本以修正分类模型,选择策略如图1所示. 在学习阶段,将已标注样本作为初始的训练数据集,分类器在该数据集上训练得到初步的情感分类模型,随后利用模型对未标注样本进行分类,选择分类结果中置信度最高的样本加入到训练数据集中;利用主动学习的不确定策略将不确定性最高的样本交给专家进行标注后加入到训练数据集中. 在下一次迭代过程中,利用新的训练数据集建立分类模型,经过多次迭代直至满足终止条件后停止,得到最终分类模型进行微博情感极性预测.

|

图 1 不确定策略与最大置信度相结合的选择策略 Fig. 1 Selection strategy of combination of uncertain strategy and maximum certainty-factor |

分类模型最不确定的未标注样本是分类器不能准确判断所属的情感类别的样本,包含现有的分类模型所不具备的特征信息,有利于提高分类器性能. 选取基分类器最不确定的未标注样本作为候选数据集,由人工标注后加入到训练数据集中以修正分类模型. 未标注样本的不确定性权值利用分类器对样本的分类置信度来计算:

| ${\rm U}{\rm{ncertain}}(d) = \mathop {\min }\limits_{\displaystyle i = \{ {\rm pos},{\rm neg}\}} p({y_i}|d).$ | (1) |

式中:pos 表示积极情感类别,neg 表示消极情感类别,

协同学习算法要求分类问题有2个充分冗余的特征视图,利用2个视图在训练数据集上训练出2个不同的分类模型. 然而在中文微博的情感极性分类问题中,很难找到2个条件独立的特征视图,因此松散条件下的协同学习框架将基于向量空间模型的微博特征作为特征视图1,基于语义相关的词向量特征作为特征视图2. 针对2种特征视图对训练分类器的不同要求,将2个不同类型的监督学习算法作为协同学习算法的基分类器.在协同学习过程中,利用2个特征视图分别训练2个不同分类器,每个分类器从未标注样本中挑选出分类置信度最高的样本进行自标注,并且把标注后的样本数据加入到另一个分类器的训练数据集中,更新对方模型.

在样本选择过程中,采用不确定策略和置信度最高策略相结合的方法. 为了保证2个特征视图条件独立,使用SVM模型和LSTM模型作为协同学习框架的2个强分类器. SVM分类器从词法信息要素的角度对微博进行情感极性分类,LSTM分类器从文本上下文相关的语法角度进行极性分析. 可以选取对2个分类模型最有帮助的样本数据进行人工标注以减少噪声样本的引入,同时可以充分利用微博文本的词法和上下文的语义信息进行分类,提高分类的准确率.

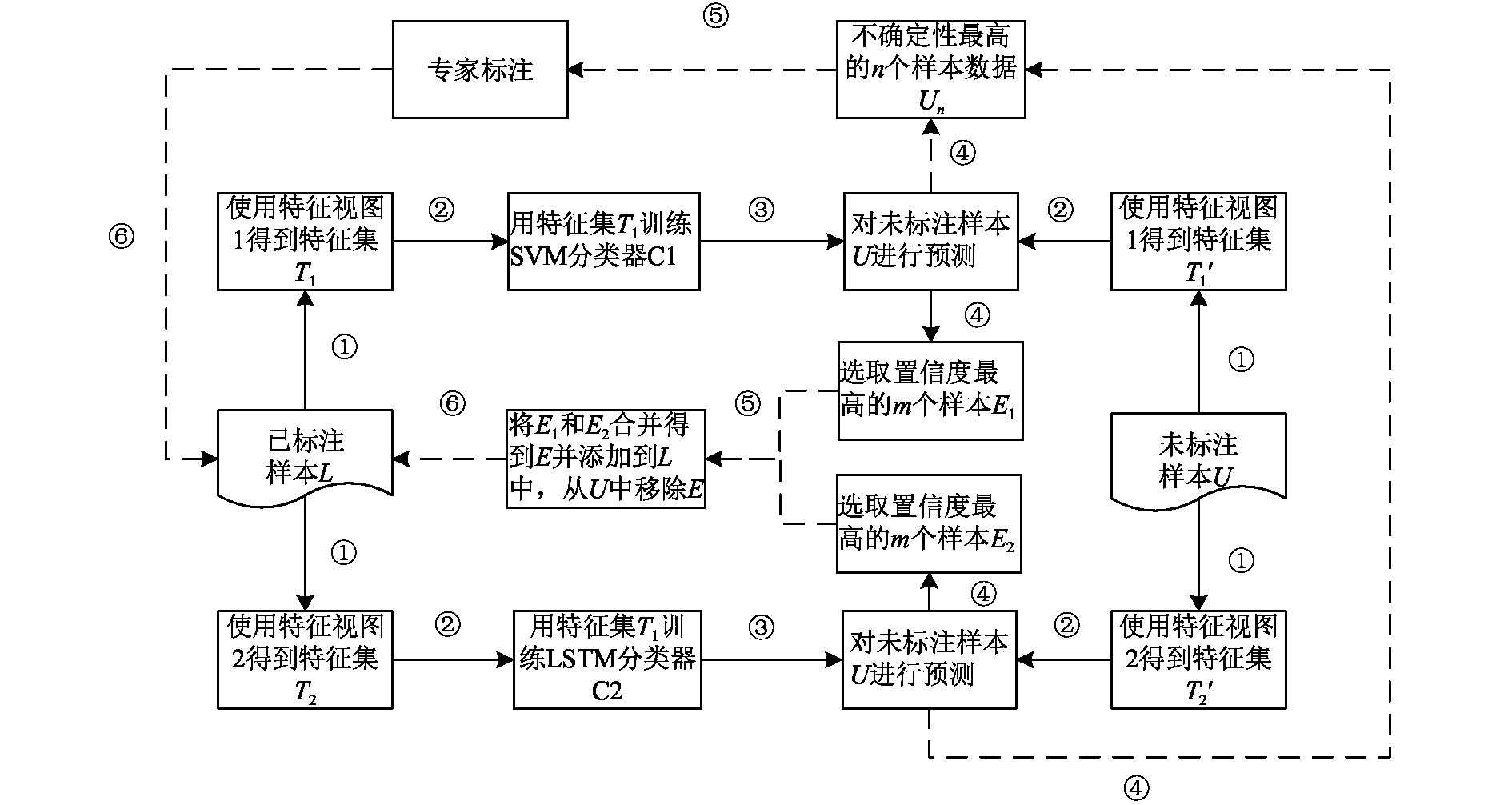

如图2所示. 与传统的松散条件下的协同学习框架采用2个相同基分类器不同,松散条件下的协同学习框架采用不同类型的2个基分类器.协同学习框架中包含SVM分类器C1和LSTM分类器C2. 对已标注样本数据和未标注样本数据,从文本的向量空间模型(vector space model,VSM)表示和词向量的分布式特征2个视图进行特征提取,利用已标注样本分别对C1和C2进行训练. 利用训练好的模型对未标注样本的极性进行预测,从C1预测的结果中挑选出置信度最高的m个样本组成样本集E1,从C2预测的结果中挑选出置信度最高的m个样本组成样本集E2,合并E1和E2,并且剔除C1和C2预测类别不一致的样本实例. 引入主动学习中的不确定策略,将不确定性最高的n个样本进行人工标注后加入到训练数据集中,保持下次训练模型的泛用性,修正分类模型,降低错误率.

|

图 2 松散条件下的协同学习框架 Fig. 2 Framework of collaborative learning in loose conditions |

协同学习框架训练得到2个独立的分类器C1和C2,因此在分类阶段,每条微博会有2个预测置信度值. 对于置信度的计算,SVM分类器对特征的每一维度进行归一化处理后,输出的分类概率即置信度控制在[0, 1]区间;将LSTM分类器采用Softmax回归模型得到的置信度映射到[0, 1]区间. 规定预测置信度值的正负号代表该微博的情感极性,消极情感类别的预测值为负数,积极情感类别的预测值为正数,如果预测某条微博为积极情感类别,预测置信度不变;如果预测某条微博为消极情感类别,预测置信度取反(乘以–1). 预测置信度值的范围控制在[–1,1]区间,选取2个预测置信度的平均值作为1条微博的整体预测置信度值. 在自举阶段,根据微博整体预测置信度值的绝对值大小进行降序排序,选取前m个样本加入到候选数据集. 在选择不确定性最高的样本时,选取整体预测置信度值的绝对值最低的n个样本进行人工标注后加入到候选数据集中,将候选数据集合并到训练数据集中进行下一次迭代过程,直至达到停止条件. 在极性预测阶段,利用2个分类器模型分别对测试用例进行极性预测,选择分类置信度值最高的分类器决定测试用例的情感极性.

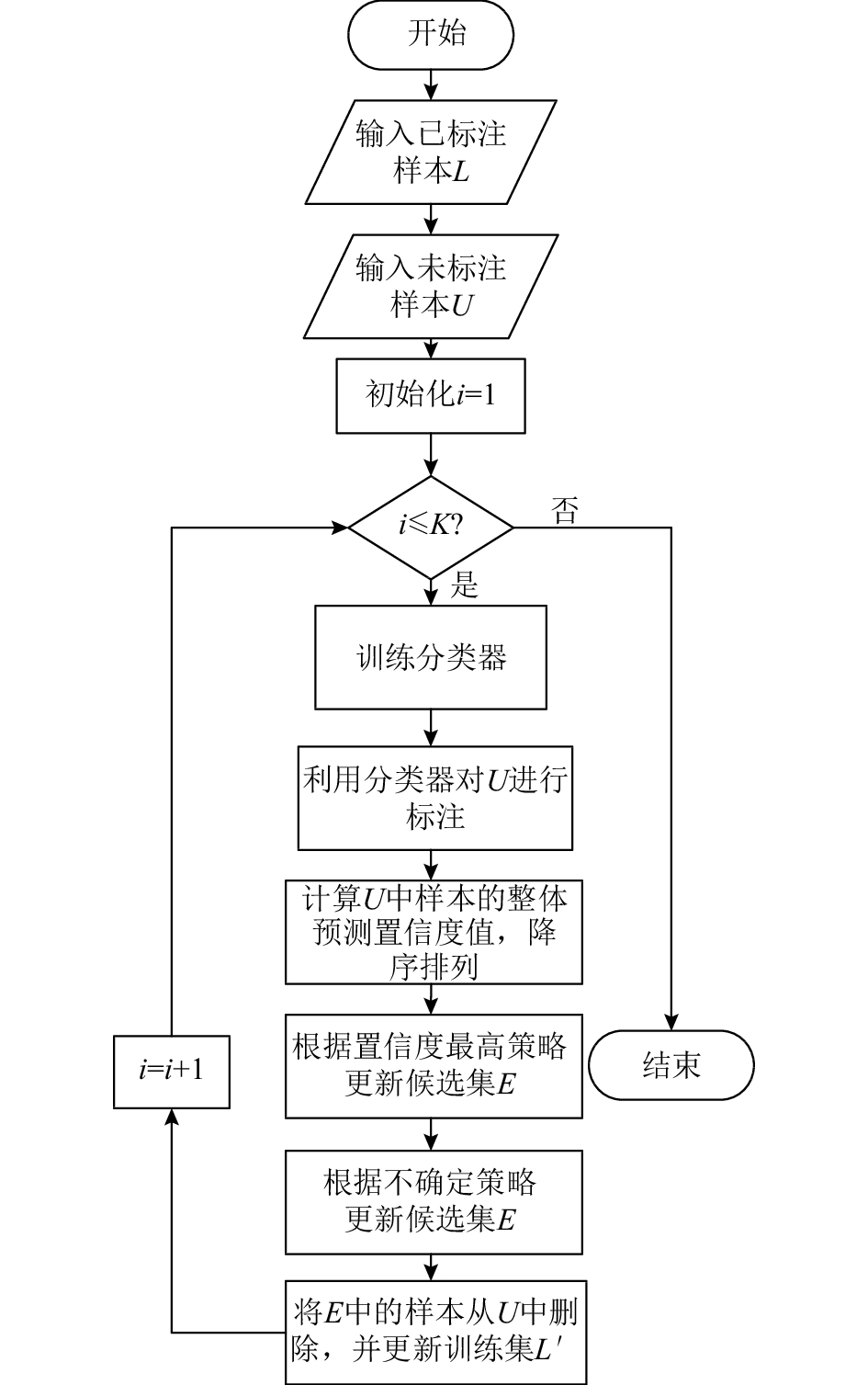

松散条件下基于协同学习的中文微博情感极性分析算法流程如图3所示. 可以看出,在选择已标注样本阶段时,选择的置信度最高的样本数量m、不确定性最高的样本数量n会影响到算法的分类性能. 实验部分会深入研究参数对分类器性能的影响并确定适用于算法的最佳参数.

|

图 3 松散条件下协同学习算法流程图 Fig. 3 Collaborative learning flow chart in loose conditions |

实验使用的数据集融合了NLP&CC 2015和NLP&CC 2016提供的中文微博情感标注语料集. 得到16 155条已标注微博(8 055条积极微博,8 100条消极微博). 为保证随机性,实验数据集采用5次划分,从已标注微博语料集中随机选取3 055条积极微博和3 100条消极微博作为训练数据集L,再选取3 000 条积极微博和3 000 条消极微博作为测试集,剩下的4 000条已标注微博作为不确定性样本数据集. 最终取5次训练和测试的F1值的平均值.

| 表 1 基于SVM、LSTM 的主动学习算法以及松散条件下的协同学习算法的F1值 Table 1 The F1-score of active learning algorithm based on SVM and LSTM and that of collaborative learning algorithm in loose conditions % |

在训练过程中,采用五折五轮交叉验证,将6 155条训练数据集平均分成5份,轮番将其中4份作为训练数据集,剩余1份作为验证数据集,根据实验取得的F1进行参数调优以达到尽可能好的效果。

2.2 评价指标采用文本情感极性分类领域常用的准确率Precision. 召回率Recall作为评价指标来评估分类器的分类性能:

| $\Pr {\rm{ecision}} = \frac{{{\rm TP}}}{{{\rm TP} + {\rm FP}}},$ | (2) |

| $\operatorname{Re} {\rm{call}} = \frac{{{\rm TP}}}{{{\rm TP} + {\rm FN}}}.$ | (3) |

式中:

F-Score是自然语言处理领域常用的评价标准,综合考虑了准确率和召回率,F-Score的公式为

| ${F_\beta } = \frac{{({\beta ^2} + 1) \cdot \Pr {\rm{ecision}} \cdot \operatorname{Re} {\rm{call}}}}{{{\beta ^2} \cdot \Pr {\rm{ecision + }}\operatorname{Re} {\rm{call}}}}.$ | (4) |

当

| ${F_1}{\rm{ = }}\frac{{2 \cdot \Pr {\rm{ecision}} \cdot \operatorname{Re} {\rm{call}}}}{{\Pr {\rm{ecision + }}\operatorname{Re} {\rm{call}}}}.$ | (5) |

选用F1衡量算法在情感极性分类任务中的整体性能.

2.3 实验参数设置对中文微博从词法和语法两方面进行特征提取,特征提取采用文献[17]中基于情感词典的子句情感极性判断方法,判断结果将作为微博的基本特征用于机器学习分类.

词向量的获取方法是利用多层神经网络的隐含层对输入特征进行梯度下降学习来逼近目标输出. 选取目前具有代表性的词向量训练模型,即Google公司推出的word2vec模型,在大规模中文微博语料库中训练得到词向量,作为分类算法的输入用于中文微博的情感极性计算.

SVM分类器采用LibSVM工具包实现,选择线性核函数.在 LSTM分类模型中,输入为文本词序列中每个词语的词向量,词向量的维数设置为50,输出为包含整个微博文本词序列信息的实值向量. 根据最后隐层的输出向量利用Softmax函数预测微博文本的情感极性. LSTM模型由输入门、输出门、遗忘门和记忆单元组成. 设ct为t时刻记忆单元的状态,xt为t时刻记忆单元的输出,it为t时刻记忆单元的词向量输入. LSTM的记忆单元的信息更新和结果计算分为以下几个步骤.

1)计算输入门的值:

| ${{{i}}_{{t}}} = \delta ({{{W}}^i}{x_t} + {{{U}}^i}{h_{t - 1}} + {{ b}^i}).$ | (6) |

2)计算遗忘门的值:

| ${{{f}}_{{t}}} = \delta ({{{W}}^{{f}}}{x_t} + {{{U}}^{{f}}}{h_{t - 1}} + {{ b}^{{f}}}).$ | (7) |

3)计算输出门的值:

| ${{{o}}_{{t}}} = \delta ({{{W}}^{{o}}}{x_t} + {{{U}}^{{o}}}{h_{t - 1}} + {{ b}^{{o}}}).$ | (8) |

4)计算当前时刻LSTM单元的激活状态值:

| ${{{g}}_{{t}}} = \tanh \,({{{W}}^{{g}}}{x_t} + {{{U}}^{{g}}}{h_{t - 1}} + {{ b}^{{g}}}).$ | (9) |

5)更新当前时刻记忆单元的状态值ct:

| ${{{h}}_{{t}}} = {{{o}}_{{t}}} \odot \tanh \,({c_t}).$ | (10) |

式中:

为了研究改进的选择策略对基于SVM的主动学习的影响,设置2组实验:实验1研究不确定性样本个数对基于SVM的主动学习性能的影响;实验2研究选择策略在学习步长(置信度最高的未标注样本数据个数)不同时对基于SVM的主动学习性能的影响.

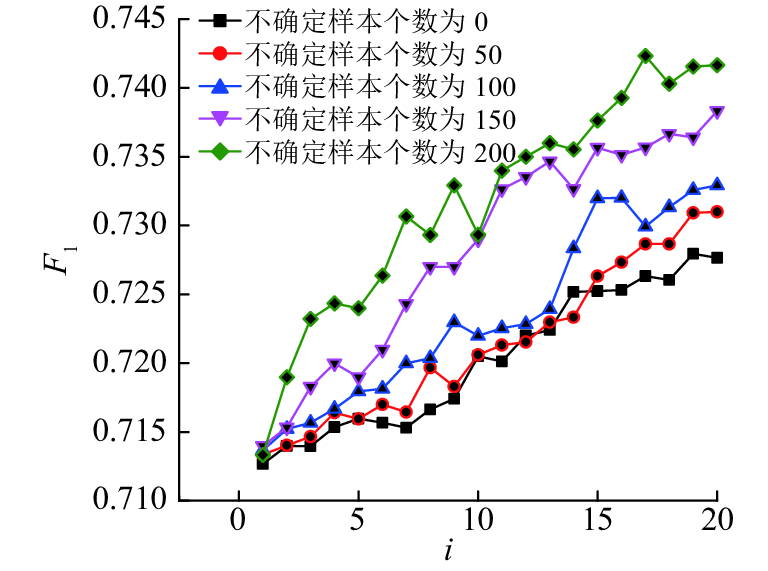

实验1 不确定性样本的个数对基于SVM的主动学习的影响. 在每次迭代中,分别选择50、100、150、200个不确定性最高的样本加入训练数据集中,由于不确定性样本数据集大小为4 000,当每次加入200个不确定性样本时,迭代20次后不确定性样本数据集全部用完,所以实验迭代次数设置为20次. 实验结果如图4所示,横坐标i为迭代次数. 可以看出,随着不确定性样本的增多,基于SVM的主动学习的分类性能越来越好. 当每次加入的不确定性样本个数为50或者100时,性能的提升较为缓慢,当每次加入的不确定性样本增加到150或200时,算法性能在较少的迭代次数内有明显提升. 之后的实验选取200作为基于SVM的主动学习中每次迭代添加的不确定性样本个数.

|

图 4 不确定样本个数对基于SVM的主动学习性能的影响 Fig. 4 Influence of number of uncertain sample on active learning based on SVM |

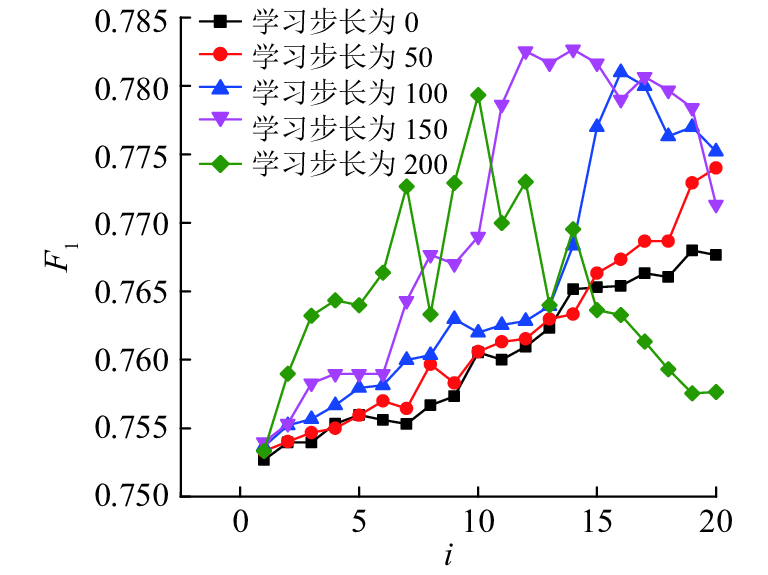

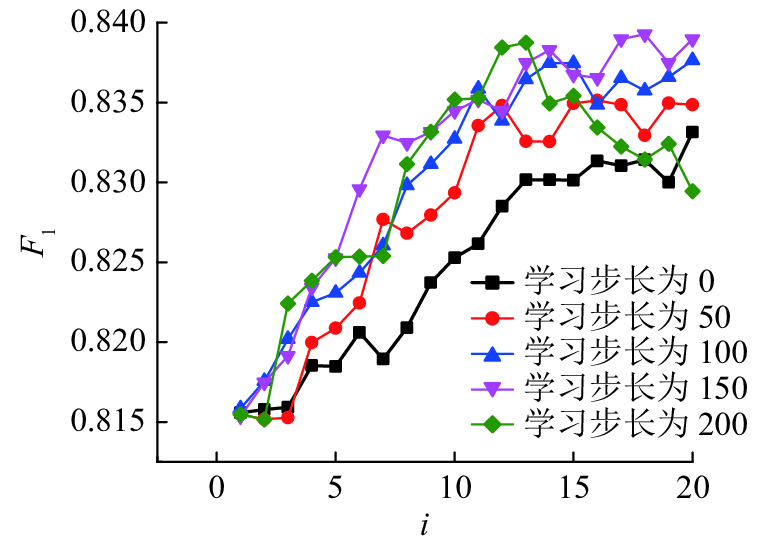

实验2 不同步长对基于SVM的主动学习的影响.如图5所示,当步长为0和步长大于0时相同迭代次数条件下对应的性能情况表明,添加了置信度最高的未标注样本能够提高分类器的性能,不确定策略和最高置信度策略相结合的性能优于只使用不确定策略的性能.

|

图 5 不同学习步长对基于SVM的主动学习性能的影响 Fig. 5 Influence of different learning steps on active learning based on SVM |

步长分别为150和200的实验结果表明,随着未标注样本的数据量不断增加,步长为200的实验在第15次迭代时的性能低于步长为0时的性能,随后分类性能整体随着迭代次数i的增加出现下降的趋势. 因为增加的未标注样本在修正分类模型的同时引入噪声数据,噪声数据的累积降低了分类性能. 对比不同步长的性能曲线,当步长从0到100变化时,分类性能呈平稳上升趋势,但是当步长由150增加到200时,分类性能出现较大波动,最后甚至出现下降趋势. 当步长为150左右时,分类算法具有较优的性能.

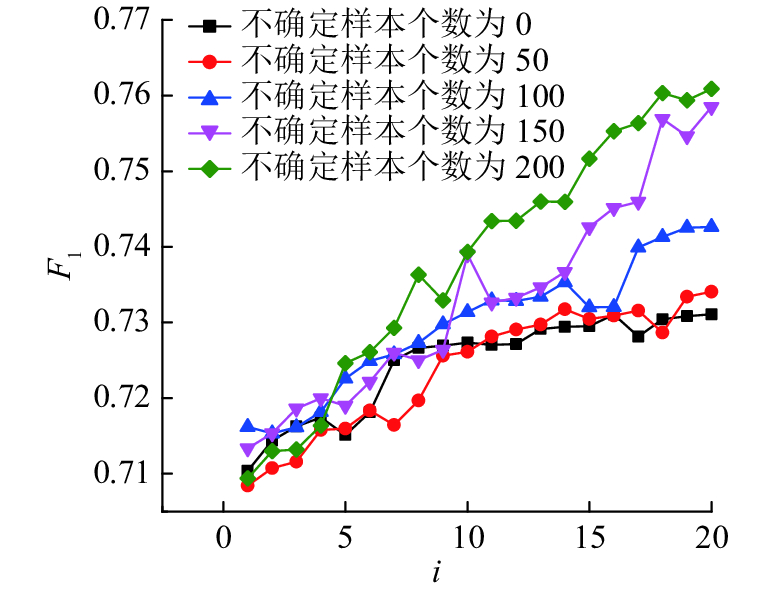

2.4.2 改进后的选择策略对基于LSTM的主动学习的影响实验1 不确定性样本的个数对基于LSTM的主动学习的影响. 在每次迭代中,分别选择50、100、150、200个不确定性最高的样本加入到训练数据集中,迭代20次后不确定性样本数据集全部用完,迭代次数i设置为20次. 实验数据如图6所示. 可以看出,随着不确定性样本的增加,基于LSTM的主动学习性能也越来越好,并且随着每次加入的不确定性样本个数的增多,算法在较少的迭代次数内分类效果提升明显,因此在之后的实验中选取200作为基于LSTM的主动学习中每次添加的不确定性样本个数.

|

图 6 不确定样本个数对基于LSTM的主动学习性能的影响 Fig. 6 Influence of number of uncertain samples on active learning based on LSTM |

对比基于SVM的主动学习,在加入的不确定性样本个数相同、迭代次数相同的情况下,基于LSTM的主动学习算法的性能优于基于SVM的主动学习. 因为LSTM是基于深度学习的分类算法,实验数据量较大,LSTM算法适用于大数据的训练环境,SVM在小样本的分类问题中具有出色的性能.

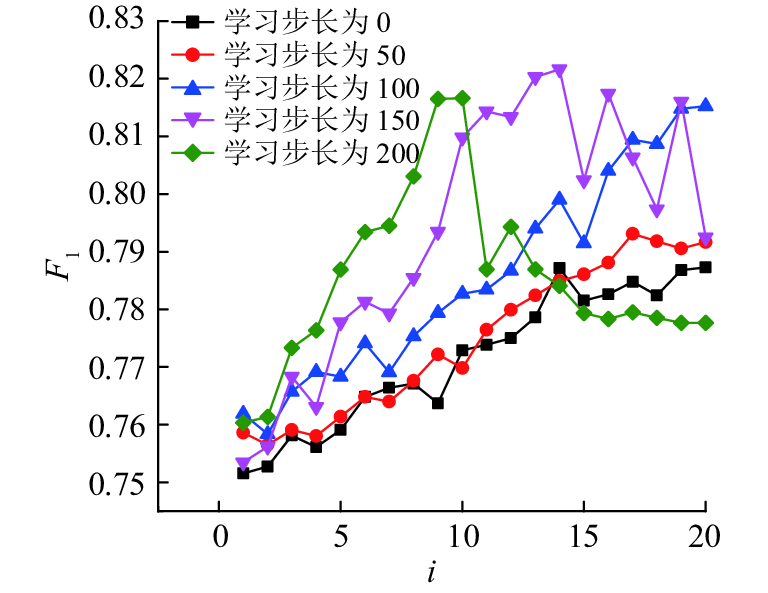

实验2 不同学习步长对基于LSTM的主动学习的影响. 图7中步长为0和步长大于0的性能曲线表明,在相同迭代次数下,算法加入了置信度最高的未标注样本比不加入时分类性能更好. 当步长为100时,分类性能随着迭代次数i的增加逐渐变好;当步长为150时,分类性能先随着迭代次数i增加而变好,迭代至13次时,分类性能随着迭代次数增加开始下降;当步长为200时,分类性能在迭代次数为10时就达到顶峰. 因为未标注样本的增加使得分类器获取更多有用的分类信息来修正分类模型,同时引入了噪声数据. 当步长为150左右时,分类性能最优.

|

图 7 不同学习步长对基于LSTM的主动学习性能的影响 Fig. 7 Influence of different learning steps on active learning based on LSTM |

对比基于SVM的主动学习,基于LSTM的主动学习整体上分类性能较好. 由于微博文本简洁,短短几十个字中包含的上下文语义对于情感分析十分重要,LSTM的词向量特征包含了词语的上下文相关的分布式特征,在取得良好分类性能上有重要的优势.

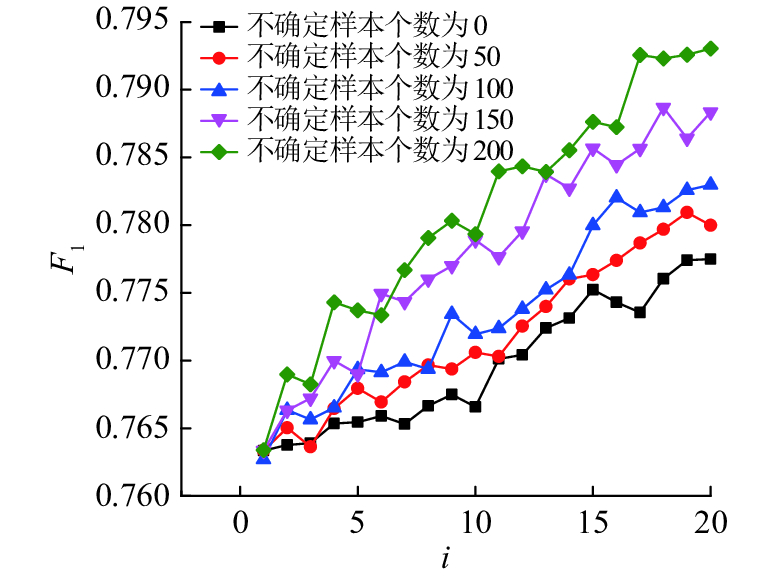

2.4.3 改进后的选择策略对松散条件下协同学习的影响实验1 不确定性样本的个数对松散条件下协同学习的影响. 如图8所示,当每次迭代添加的不确定性样本个数为0、50、100时,协同学习的分类性能缓慢提升,说明不确定性样本的添加使得主动学习算法的分类效果得到提高. 当不确定性样本数为150和200时,F1值在短时间内得到了较大的提升,说明每次添加的不确定性样本个数越多,算法得到的提升越多. 由于不确定性样本数目有限,因此在之后的实验中选取200作为协同学习中每次迭代添加的不确定性样本个数.

|

图 8 不确定样本个数对协同学习的影响 Fig. 8 Influence of number of uncertain sampls on collaborative learning |

实验2 不同学习步长对协同学习的影响. 实验结果如图9所示. 方点线表示每次不添加置信度最高的未标注样本,作为基础参照实验. 当步长为50和100时,添加置信度高的未标注样本有效地提高了分类结果;当步长为150时,分类效果较快地达到了平稳状态;当步长为200时,初次迭代时,分类性能上升比较快,在第12次迭代时达到峰值,随后出现下降趋势. 原因是在迭代过程中随着未标注样本的不断加入,一些错误样本数据也被加入到训练数据集中,引入的分类噪声影响了分类器的性能,使得分类器性能出现下降趋势. 当步长为150时获得较好的分类结果,分类性能最高为83.9%.

|

图 9 不同学习步长对协同学习的影响 Fig. 9 Influence of different learning steps on collaborative learning |

为了证明松散条件下的协同学习框架相比同样条件下的主动学习算法有更好的分类性能,对基于SVM的主动学习算法、基于LSTM的主动学习算法与协同学习算法的分类性能进行对比实验. 3种算法都采用提出的不确定策略与最高置信度相结合的选择策略,主动学习算法采用SVM算法和LSTM算法,协同学习算法的2个分类器分别基于SVM算法和LSTM算法.

依据实验得出的结论,每次迭代添加的不确定性样本个数为200,在学习步长为0、50、100、150、200的条件下,分别迭代5次、10次和20次后对得到的F1值取平均值. 实验结果如表1所示.在学习步长相同并且迭代次数相同的情况下,协同学习算法的F1值的平均值总是高于基于SVM的主动学习和基于LSTM的主动学习对应的F1的平均值,说明协同学习的分类效果整体优于主动学习算法. 松散条件下的协同学习算法的整体性能较主动学习提升约为8%. 协同学习结合 SVM 和 LSTM 分类器,协同学习框架中2个分类器在迭代过程中不断将各自的分类信息传递给对方,彼此之间相互学习,分类性能有所提升.

3 结 语针对中文微博的情感极性分析进行相关的研究,深入研究主动学习算法的学习策略,提出在每次迭代过程中将不确定策略与最高置信度策略相结合的选择策略. 实验表明选择策略能够有效提高分类器的性能. 针对协同学习中无法获得2个充分冗余视图的问题,提出基于SVM算法和LSTM算法的松散条件下的协同学习算法框架. 在框架中融合不确定性最高与置信度最高的样本选择策略,实验验证协同学习算法在中文微博情感极性分析中具有较好的分类性能.

将主动学习与协同学习相结合,虽然在微博情感分析领域取得了不错的分类效果,但是仍存在着不足和欠缺,以后的研究方向为:1)词向量模型的优化. 训练的词向量主要来自于基于分布式特征表示的word2vec模型,包含的情感信息并不全面,接下来可以通过融合上下文语义和微博文本中表情、转发关系,利用文本情感词来改进词向量模型.2)协同学习算法的时间优化.提出的协同学习算法虽然能够有效利用未标注数据,减小标注成本,但是由于协同学习需要同时建立2个分类模型,在多次迭代过程中,耗费大量的时间. 在下一阶段研究工作中,可以采用分布式并行计算的方式来加快算法训练和迭代过程.

| [1] |

HERLOCKER J L, KONSTAN J A, TERVEEN L G, et al. Evaluating collaborative filtering recommender system[J]. ACM Transactions on Information Systems, 2004, 22(1): 5-53. |

| [2] |

徐蕾, 杨成, 姜春晓, 等. 协同过滤推荐系统中的用户博弈[J]. 计算机学报, 2016, 39(6): 1176-1189. XU Lei, YANG Cheng, JIANG Chun-xiao et al. The user game in the collaborative filtering recommendation system[J]. Chinese Journal of Computers, 2016, 39(6): 1176-1189. |

| [3] |

梁军, 柴玉梅, 原慧斌, 等. 基于深度学习的微博情感分析[J]. 中文信息学报, 2014, 28(5): 155-161. LIANG Jun, CHAI Yu-mei, YUAN Hui-bin, et al. The analysis of microblog sentiment based on deep learning[J]. Journal of Chinese Information Processing, 2014, 28(5): 155-161. DOI:10.3969/j.issn.1003-0077.2014.05.019 |

| [4] |

ZHENG C, SHENG L, DAI N. Chinese microblog emotion classification based on class sequential rules[J]. Computer Engineering, 2016, 42(2): 184-189. |

| [5] |

CHANG Y C, CHU C H, CHEN C, et al. Linguistic template extraction for recognizing reader-emotion[J]. Journal of Chinese Computational Linguistics, 2016, 21(1): 29-50. |

| [6] |

唐慧丰, 谭松波, 程学旗. 基于监督学习的中文情感分类技术比较研究[J]. 中文信息学报, 2007, 6(2): 88-94. TANG Hui-feng, TAN Song-bo, CHENG Xue-qi. Research on sentiment classification of Chinese reviews based on supervised machine learning techniques[J]. Journal of Chinese Information Processing, 2007, 6(2): 88-94. |

| [7] |

BLUM A, MITCHELL T. Combining labeled and unlabeled data with co-training [C]// Conference on Computational Learning Theory. Madison: COLT, 1998: 92-100 http://dl.acm.org/citation.cfm?id=279962

|

| [8] |

GOLDMAN S, ZHOU Y. Enhancing supervised learning with unlabeled data [C]// Proceedings of the Seventeenth International Conference on Machine Learning. San Francisco: ICML, 2000: 327-334 http://dl.acm.org/citation.cfm?id=658273

|

| [9] |

ZHOU Z, LI M. Tri-training: exploiting unlabeled data using three classifiers[J]. IEEE Transactions on Knowledge and Data Engineering, 2005, 17(11): 1529-1541. |

| [10] |

WANG W, ZHOU Z H. On multi-view active learning and the combination with semi-supervised learning [C]// Proceedings of the Twenty-five International Conference on Machine Learling. Helsinki: DBLP, 2008: 1152-1159 http://www.doc88.com/p-1704612397473.html

|

| [11] |

YU N. Exploring co-training strategies for opinion detection[J]. Journal of the Association for Information Science and Technology, 2014, 65(10): 2098-2110. |

| [12] |

LEWIS D D, GALE W A. A sequential algorithm for training text classifiers [C] // International Conference on Computational Linguistics. Dublin: ICCL, 1994: 3-12 http://dl.acm.org/citation.cfm?id=188490.188495

|

| [13] |

居胜峰, 王中卿, 李寿山, 等. 情感分类中不同主动学习策略比较研究 [C]//中国计算语言学研究前沿进展. 洛阳: CCL, 2011: 506-511 JU Sheng-feng, WANG Zhong-qing, LI Shou-shan, et al. A comparative study of different active learning strategies for sentiment classification [C] // Advances of Computational Linguistics in China. Luoyang: CCL, 2011: 506-511 http://cpfd.cnki.com.cn/Article/CPFDTOTAL-ZGZR201108001085.htm |

| [14] |

NGUYEN H T, SMEULDERS A. Active learning using pre-clustering [C] // 2004 Proceedings of the Twenty-first International Conference on Machine Learning. Banff: ICML, 2004: 79 http://dl.acm.org/citation.cfm?id=1015349

|

| [15] |

HAJMOHAMMADI M S, IBRAHIM R, SELAMAT A, et al. Combination of active learning and self-training for cross-lingual sentiment classification with density analysis of unlabeled samples[J]. Information Sciences, 2015, 317(C): 67-77. |

| [16] |

HASTIE T, TIBSHIRANI R, FRIEDMAN J H, et al. The elements of statistical learning, second edition: data mining, inference, and prediction[J]. Mathematical Intelligencer, 2009, 27(2): 83-85. |

| [17] |

LI W, LI Y, WANG Y. Chinese microblog sentiment analysis based on sentiment features [C]// Asia-Pacific Web Conference. Suzhou: APWeb, 2016: 385-388 https://link.springer.com/chapter/10.1007/978-3-319-45817-5_30

|