2. 西安交通大学 工业设计系, 陕西 西安 710049

2. Department of Industrial Design, Xi'an Jiaotong University, Xi'an 710049, China

情感计算是和谐人机交互领域日益受到关注的新研究方向.在人机交互中,人类的需求沿袭了自然的交互方式,与社会环境下人与人之间的互动类似,这种情感的计算机运算称为“情感计算”[1].情感计算一方面涵盖情感、情绪的心理学研究[2],另一方面涉及到计算机视觉、统计分析[3]、机器学习等学科的应用技术.

在情绪心理学的研究中,对情绪的采集和评估一般从主观汇报、生理数据、外显行为三方面入手[2].主观汇报法得到的数据缺乏客观性,生理数据的采集对受试者造成的干扰较大;外在行为法采用非入侵的采集方法得到受试者的客观数据,不会对受试者造成干扰.此外,前两种方法已相对比较成熟,已取得实际的研究成果,外显行为的研究仍处于初期探索,在研究方法、技术、实践等方面还有较多的难题.Camurri等[4]发现人类肢体运动的灵活性有利于自身情绪的表达,同时便于实现计算机的自动识别.该研究的行为采集方法以非接触、非入侵的方式采集个体肢体行为数据,所采集的数据弥补了心理研究和用户研究中(缺少客观分析)的不足,更加客观揭示用户行为和情绪之间的关系;非接触、非入侵的采集方式减少甚至消除了对个体产生的干扰,数据采集更加客观、便捷.

在类似的研究中,主试主观评价法或被试主观汇报法是对行为特征的情绪进行评估的常用方法.Mehrabian[5-6]提出PAD三维情绪模型,该模型由愉悦度、激活度和优势度3个维度组成;不同于Scherer等[7]提出的6中基础情绪模型,该模型从连续情绪的角度对情绪进行评估和分类.

近年来,学界、业界都致力于采用计算机技术对人体(非言语)行为与情绪进行研究与探索,如Affectiva公司通过在线采集用户面部特征,输出用户的情感种类[8];Camurri采用物理参数(如身体的位置、速度、加速度)描述整个运动特征,从而实现人体运动的建模[4];Castellano等[9]通过多模型实验对比发现,与语言和面部表情相比,肢体行为的情感识别率更高.随着信息技术的发展,学者尝试采用计算机技术对人体行为进行分析和研究,摄像机采集人体行为的方法具有非侵入性、方便等优点,但受背景、人体运动目标等的干扰较大[10].该研究采用摄像机对人体行为进行采集,基于OpenCV库对人体行为进行特征提取,在Camurri等研究的基础上,拓展所采集的低层运动特征;引入高效度的PAD情绪量表对个体情绪进行评估,达到情绪评估和行为特征采集的高效度,更具有应用价值.

机器学习是利用给定有限的训练数据,实现特征之间依赖关系的估计,并根据这种关系对未知数据进行准确的预测[11].常见的机器学习算法有多种:k-临近算法、朴素贝叶斯算法、决策树、支持向量机等[12].所列的前3种方法要求训练样本数趋于无穷大,然而解决实际问题时,样本数通常有限[13].支持向量机(SVM)被部分学者认为是最好的“现成”分类器,对于小样本量的统计和预测学习具有较高的有效性,被国内外学者广泛接受和使用[12].目前,支持向量机在人脸检测[14]、步态识别[15]、签名识别[16]等领域的成果优于传统方法.

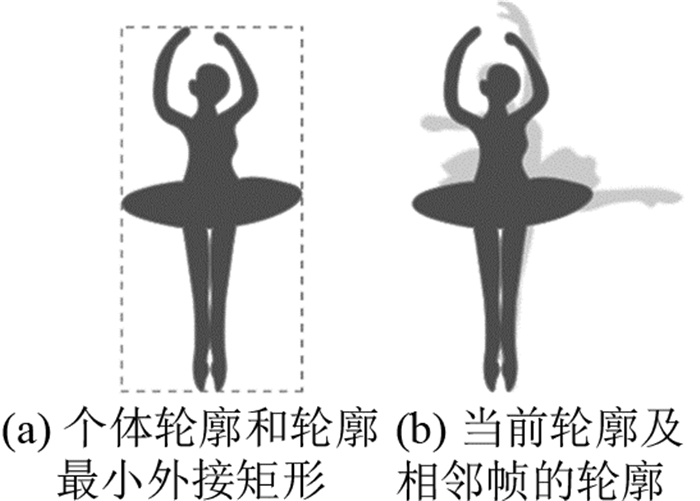

1 算法实现 1.1 体态特征提取和分析Camurri等[4]的研究以Laban运动分析(Laban movement analysis, LMA)理论为基础,提出轮廓运动图像(Silhouette motion image, SMI)概念:在最后相邻几帧中反映轮廓和位置多样性信息的图像;运动数量(quantity of motion, QoM)概念:表示检测到的大致运动数量,QoM等于SMI的面积;舒张指数(contraction index, CI)概念:描述人体的扩张或收缩状态.

采用计算机视觉OpenCV技术,对视频图像中的人体轮廓特征进行提取.视频提取的人体轮廓存在以下2个问题[4]:1)SMI受个体到摄像机的距离、角度的影响;2)SMI与QoM受个体的影响较大.为了解决该类问题,结合Camurri和Castellano的理论,对参数进行归一化处理,定义的参数包括轮廓面积的变化率(rate of Silhouette change, RoSC)、轮廓舒张状态CI.RoSC定义为包含当前帧(表示为t)在内的后几帧相对于前几帧的轮廓面积的变化率,如下:

| $ \begin{array}{l} \left[{t, n} \right]{\rm{ }} = \\ \left[{\left( {\sum\limits_{i = t}^{t + n} {{\rm{Silhouette}}\left[i \right]} } \right) - \left( {\sum\limits_{i = t - n}^t {{\rm{Silhouette}}\left[i \right]} } \right)} \right]{\rm{ /}}\\ \left( {\sum\limits_{i = t - n}^t {{\rm{Silhouette}}\left[i \right]} } \right). \end{array} $ | (1) |

式中:n为常数.定义RoSC在时间/帧(Δt=50 ms)上的变化率A,如下:

| $ A = \frac{{{\rm{RoSC}}\left[{t, n} \right] - {\rm{RoSC}}[t-\Delta t, n]}}{{\Delta t}}. $ | (2) |

CI定义为当前帧的轮廓面积与轮廓最小外接矩形面积的比值,如下:

| $ {\rm{CI}}\left( {t} \right) = \frac{{{\rm{Area}}\left( {{\rm{silhouette}}\left[t \right]} \right)}}{{{\rm{Area }}\left( {{\rm{MinRect}}\left[t \right]} \right)}}. $ | (3) |

为了得到个体运动的RoSC和CI,该研究提取的参数包括目标轮廓的面积Area(Silhouette[t])、目标最小外接矩形的面积Area(MinRect[t]),如图 1所示.

|

图 1 个体轮廓特征 Fig. 1 Silhouette features of individual |

个体的运动速度是衡量运动特征的重要参数.提取视频图像上个体轮廓的重心坐标x(t)和y(t),个体运动速度v可以通过相邻帧的重心距离来计算.其中,

| $ \left. \begin{array}{l} \begin{array}{*{20}{l}} {{v_x}\left( t \right) = \frac{{x\left( t \right) - x\left( {t - \Delta t} \right)}}{{\Delta t}}, } \end{array}\\ {v_y}\left( t \right) = \frac{{y\left( t \right) - y(t - \Delta t)}}{{\Delta t}}, \Delta t = 50{\rm{ms}}, \\ v = \sqrt {v_x^2 + v_y^2} . \end{array} \right\} $ | (4) |

利用支持向量机(support vector machine,SVM)建立体态情绪模型.支持向量机是具有相关学习算法的监督学习模型,支持向量机分析适用于分类和回归分析的数据;通过寻找满足分类要求的最优化分类面来实现,确保分类的精度及分类间隔最大化[11].

LibSVM是林智仁等[17]开发的SVM模式识别与回归软件.采用LibSVM进行计算的步骤(见图 2),与其他机器学习算法步骤类似.

|

图 2 分类学习和预测 Fig. 2 Classified training and prediction |

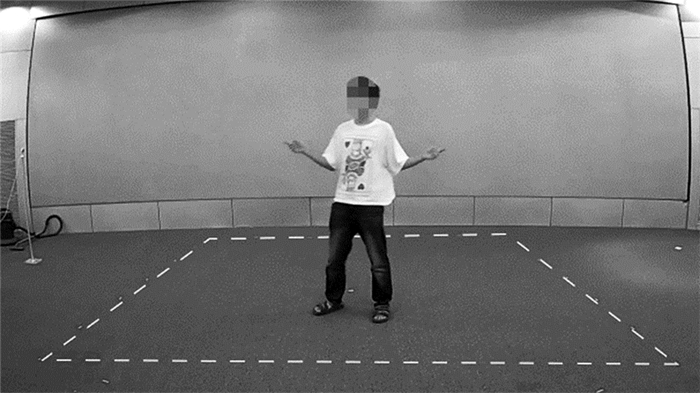

1) 长、宽、高为4 m×4 m×2.4 m的实验场地(见图 3),场地为浅色背景.

|

图 3 行为情绪诱发实验场地及受试者 Fig. 3 Site and subjects of behavioral emotion induction experiment |

2) 笔记本2台(ThinkPad T440P):用于主试播放音乐及受试者填写量表.

3) 摄像头1台(360智能摄像机夜视版).

4) 音响1套(Harman/Kardon SoundSticks Ⅲ).

共采集10名受试者的有效数据,年龄为18 ~ 30岁的在校大学生,身体健康,无心血管、内分泌紊乱等疾病,不考虑性别因素的影响.志愿者在实验之前,签署知情同意书.

2.2 情绪诱发素材实验室采用情绪诱发手段,可以产生特定、有效的情绪[2].该研究采用中国民族音乐作为情绪诱发素材,具有沉浸感最好、持续性长、信效度最高的特点[18],且与受试者的民俗、情感表达相符[19].选取笔者前期研究中建立的“中国民乐情绪乐库”中的正性、中性和负性音乐各5段,并在3类音乐中各随机抽取2段复制后混入原音乐库(考察受试者实验数据的重测信度),实验音乐共21段.音乐的采样频率为44.1 KHz,声道为立体声,采样位数为32位,时间长度为30~60 s.

2.3 PAD情绪量表主观评估是情绪评估的主要方法.PAD情感量表(简称PAD量表)是中科院心理所对Mehrabian提出的简化版PAD情感量表进行的中国化修订版[20].PAD量表是以PAD情感模型为理论基础,共12个项目,包括3个维度:愉悦度、激活度、优势度,每个维度通过4个项目进行测量[5].PAD量表能够有效地对人类情感进行评估与分类,因研究需要,采用PAD量表的情感评估方法.受试者听完每段音乐后,根据自身此刻的实际情绪状态对量表打分,自身状态与量表描述越符合,则评分越接近9;反之,评分越接近0.

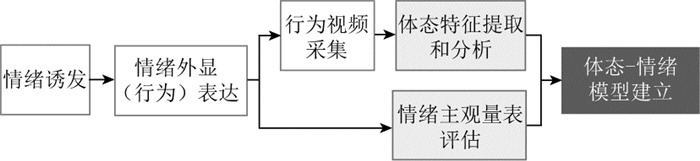

2.4 实验程序首先,采用中国民族音乐(简称民乐)作为情绪诱发素材,对10名受试者进行正、中、负性情绪诱发,受试者通过外显行为将自身情绪自然表达出来;其次,通过PAD情绪量表来评估每段诱发素材的情绪状态,同时视频采集该情绪状态下受试者的行为;然后,采用轮廓法提取视频中个体行为的体态特征,主要包括个体轮廓相对面积及变化特征;最后,结合情绪量表的评估结果,采用支持向量机方法对个体体态特征所蕴含的情绪进行分类学习,实现体态特征的情绪预测,如图 4所示.

|

图 4 行为情绪诱发实验流程 Fig. 4 Process of behavioral emotion induction experiment |

采用SPSS 18.0软件对情绪量表数据进行统计和数据分析.

1) 信度.PAD情绪量表的内部一致性信度α=0.888,信度较高;检验重测信度,重复诱发材料的独立样本T检验P=0.104,不存在显著性差异,说明实验中受试者对音乐情绪的感受及评价是统一的.

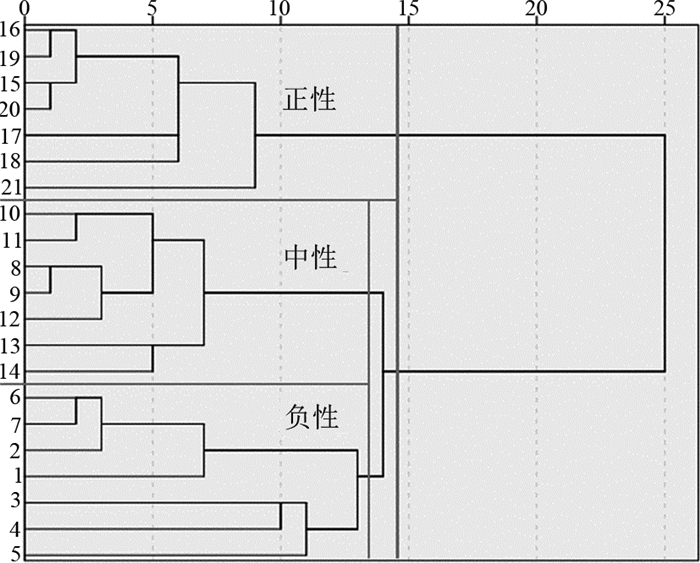

2) 量表与情绪.以PAD情绪量表为变量,采用系统聚类法(组间、平方Euclidean距离)对音乐的情绪进行聚类分析.将音乐情绪分成2大类(见图 5),细分可以得到3类,与实验前诱发音乐的情绪假设一致:分别蕴含正、中、负性情绪.

|

图 5 PAD量表聚类结果 Fig. 5 Clustering results of PAD scales |

1) 特征提取.采用OpenCV库对10位受试者各自的21段视频进行特征提取,提取本文方法中提出的参数,依次为:时间/帧t、目标轮廓面积Area(Silhouette[t])、目标最小外接矩形面积Area(MinRect[t])、目标轮廓的重心坐标x(t)、y(t).根据提取的原始参数计算特征参数:RoSC、CI、v和A,用于描述目标的体态特征.

2) 数据清洗.视频特征提取时,由于目标与背景的差值、目标的运动幅度等因素,造成原始参数提取上的误差,如缺失帧.为了减少该误差,删除缺失帧较多的2组数据(共210组,误差率为0.95%).

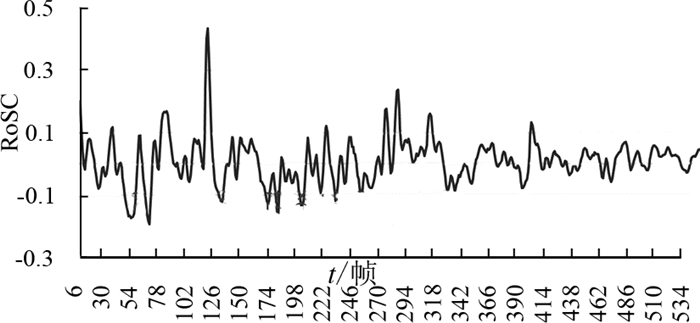

3) 归一化处理.由于提取的每段视频时长不一,得到的特征参数(RoSC、CI、v和A,如图 6所示为受试者1第一段视频的RoSC参数可视化表示)为离散时序数据.采用统计学方法对特征参数进行归一化处理,提取特征参数序列的均值、中位数、方差、极大值、极小值、极值的个数,共得到有效数据208组.

|

图 6 受试者1视频1的RoSC参数 Fig. 6 RoSC of subject 1 in video 1 |

PAD量表中聚类得到2大类:负性情绪和非负性情绪;聚类细分3类为:正、中、负性情绪.采用LibSVM分别对这两种情况进行分类学习和预测,预测准确率=识别正确的样本数/总测试样本数×100%.输入LibSVM的数据包括训练数据和测试数据,将实验中重复的音乐作为测试数据(共6段×10人,详见3.3节),将其余音乐作为训练数据.

1) 2大类.当输入LibSVM时,将音乐1~14的情绪类型均标注为1,将15~21的类型标注为2进行学习.测试数据的预测准确率为67.80%.

2) 细分3类.当输入LibSVM时,将音乐1~7的情绪类型均标注为1,将8~14的类型标注为2,将15~21的类型标注为3进行学习.测试数据的预测准确率为50.85%.将3小类每2类进行分类学习和预测,准确率如表 1所示.当以正性与负性时进行分类时,模型的预测准确率最高,为76.92%.

| 表 1 3小类的预测准确率 Table 1 Prediction accuracy of three categories |

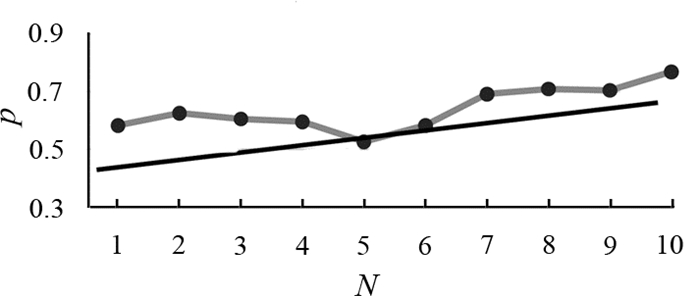

在研究中,由于受试者自身的差异,对体态特征的分类模型和预测结果产生影响.另外,受试者的人数是分类模型和预测准确率的影响因素之一.依次采用不同的人数对1-正性和3-负性情绪进行分类和预测,为了结果可靠且方便计算,均随机抽取3次取平均,如当分析人数为4时,随机抽取4名受试者3次,计算识别率的平均值,如图 7所示.图中,N为人数,p为准确率.可知,随着人数的增多,分类学习后的识别准确率提升;由于受试者的个体因素,识别率有小范围的波动.

|

图 7 预测准确率与人数的关系 Fig. 7 Relation between prediction accuracy and number of subjects |

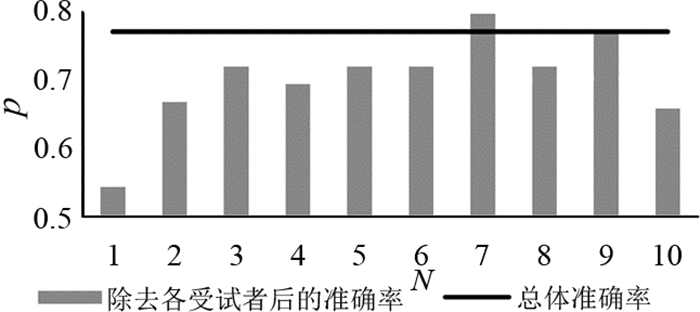

探究受试者个体对识别准确率的影响,分别除去每名受试者的样本,图 8绘制了其余受试者的识别准确率.当除去7号受试者的数据时,识别准确率升高;当除去其余受试者的数据时,识别准确率降低或持平.

|

图 8 除去各受试者后的准确率 Fig. 8 Accuracy excluding each subject |

本文实现了对视频中行为体态特征的情绪分类,验证了如下结论.1)被试的行为特征能够有效地表现情绪的假设;2)该研究的行为特征提取方法是有效的.当输入正性与负性时,模型的预测准确率最高,为76.92%.研究发现,负性与中性情绪的表达差异小于负性与正性;随着人数的增多,分类学习后的识别准确率提升.在后续研究中,通过增加受试者人数、细化情绪种类等方法,建立更加精准的情绪分类预测库.

| [1] |

胡馨月. 情感计算研究综述[J]. 中国校外教育:理论, 2011(增3): 34-36. HU Xin-yue. A survey of emotional computing[J]. Education for Chinese After-school (Theory), 2011(supple.3): 34-36. |

| [2] |

傅小兰. 情绪心理学[M]. 上海: 华东师范大学出版社, 2016.

|

| [3] |

CASTELLANO G, VOLPE G. Automatedanalysis of body movement in emotionally expressive piano performances[J]. Music Perception, 2008, 26(2): 103-119. DOI:10.1525/mp.2008.26.2.103 |

| [4] |

CAMURRI A, LAGERLÖF I, VOLPE G. Recognizing emotion from dance movement:comparison of spectator recognition and automated techniques[J]. International Journal of Human-Computer Studies, 2003, 59(1/2): 213-225. |

| [5] |

MEHRABIAN A. Pleasure-arousal-dominance:a general framework for describing and measuring individual differences in temperament[J]. Current Psychology, 1996, 14(4): 261-292. DOI:10.1007/BF02686918 |

| [6] |

MEHRABIAN A. Comparison of the PAD and PANAS as models for describing emotions and for differentiating anxiety from depression[J]. Journal of Psychopathology and Behavioral Assessment, 1997(19): 331-357. |

| [7] |

SCHERER K R, EKMAN P. Handbook of methods in nonverbal behavior research[M]. Cambridge: Cambridge University Press, 1982, 286-287.

|

| [8] |

MCDUFF D, KALIOUBY R, SENECHAL T, et al. Affectiva-MIT facial expression dataset (AM-FED):naturalistic and spontaneous facial expressions collected[J]. Computer Vision and Pattern Recognition Workshops, 2013, 13(4): 881-888. |

| [9] |

KESSOUS L, CASTELLANO G, CARIDAKIS G. Multimodalemotion recognition in speech-based interaction using facial expression, body gesture and acoustic analysis[J]. Journal on Multimodal User Interfaces, 2009, 3(1): 33-48. |

| [10] |

郭萍. 基于视频的人体行为分析[D]. 北京: 北京交通大学, 2012. GUO Ping. Humanactivity analysis in videos[D]. Beijing:Beijing Jiaotong University, 2012. http://cdmd.cnki.com.cn/Article/CDMD-10004-1012357180.htm |

| [11] |

白鹏. 支持向量机理论及工程应用实例[M]. 西安: 西安电子科技大学出版社, 2008.

|

| [12] |

(美)哈林顿(Harrington P). 机器学习实战[M]. 北京: 人民邮电出版社, 2013.

|

| [13] |

张学工. 关于统计学习理论与支持向量机[J]. 自动化学报, 2000, 26(1): 32-42. ZHANG Xue-gong. Introduction to statistical learning theory and support vector machines[J]. ACTA AUTOM ATICA SINICA, 2000, 26(1): 32-42. |

| [14] |

PAPAGEORGIOU C P, OREN M, POGGIO T. A general framework for object detection[C]//International Conference on Computer Vision.[S. l.]:IEEE, 2002:555-562.

|

| [15] |

薛召军, 李佳, 明东, 等. 基于支持向量机的步态识别新方法[J]. 天津大学学报:自然科学与工程技术版, 2007, 40(1): 78-82. XUE Zhao-jun, LI Jia, MING Dong, et al. SVM-based gait recognition[J]. Journal of Tianjin University:Science and Technology, 2007, 40(1): 78-82. |

| [16] |

VAPNIK V N. Statisticallearning theory[J]. Encyclopedia of the Sciences of Learning, 2010, 41(4): 3185. |

| [17] |

CHANG C C, LIN C J. LIBSVM:a library for support vector machines[J]. ACM Transactions on Intelligent Systems and Technology, 2011, 2(3): 389-396. |

| [18] |

蒋军, 陈雪飞, 陈安涛. 情绪诱发方法及其新进展[J]. 西南师范大学学报:自然科学版, 2011, 36(1): 209-214. JIANG Jun, CHEN Xue-fei, CHEN An-tao, et al. Mood induction procedures and the recent advancement[J]. Journal of Southwest China Normal University:Natural Science Edition, 2011, 36(1): 209-214. |

| [19] |

石骏. 中国民族音乐的情绪结构分析[D]. 上海: 华东师范大学, 2015. SHI Jun. The emotional model of Chinese folk music[D]. Shanghai:East China Normal University, 2015. http://cdmd.cnki.com.cn/Article/CDMD-10269-1015351443.htm |

| [20] |

LI X M, ZHOU H T. The reliability and validity of the Chinese version of abbreviated PAD emotion scales[J]. Affective Computing and Intelligent Interaction, 2005, 3784(1): 513-518. |